本文内容非商业用途可无需授权转载,请务必注明作者及本微信公众号、微博 @唐僧\_huangliang,以便更好地与读者互动。

NVIDIA高价收购Mellanox已经是前两天的新闻,我不太会蹭热点:)相信InfiniBand技术还会继续发扬光大,那就姑且将未来称之为“后IB时代”——这对于GPU设计特别是高密度GPU服务器肯定会带来影响,但似乎和48V供电、液冷散热之间的关系不大?

其实我也是同样的看法,只是在这个时间点恰好一同讨论下2个技术方向。

符合NVIDIA DGX-1 WithTesla V100系统架构的2U 8x GPU服务器,这张照片我在以前的《_PCIExpress 4.0规范全文下载_》中曾经列出过。

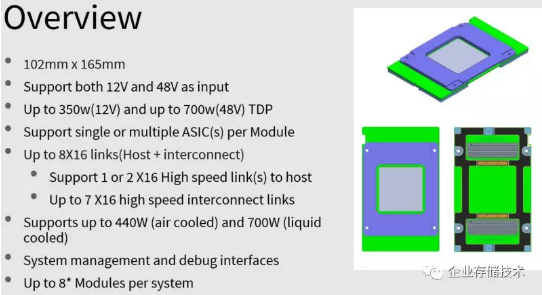

目前的高密度GPU服务器能做到2U放进8个300W功耗模块,那么将来呢?不久前,我看到一份来自Open Compute Project(Facebook发起)的文档《_OCP Accelerator ModuleDesign Spec Review_》,里面就提到相关内容。

48V支持700W GPU供电,440W以上要液冷解决

据了解,Intel即将更新的Xeon Scalable最高TDP应该还保持在205W,但再下一代的“胶水48核”估计会有提高——服务器厂商的一些产品已经做好了预留设计(比如我之前写过的Dell PowerEdge MX7000)。

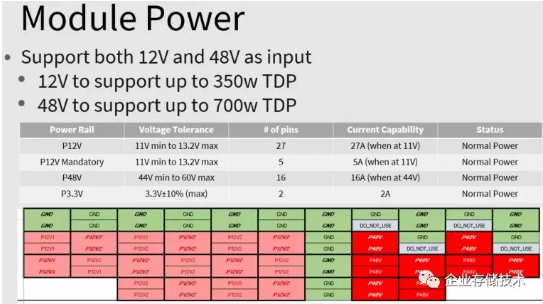

至于早已达到250-300W功耗的GPU/显卡,预计还会向更高标准迈进。而在12V直流供电下350W以上有难度了,其实PCIe spec就到300W。如上图,目前提出的是用48V来支撑最高700W TDP的加速卡(也可以是GPU以外的ASIC)。

这里同时还指出,风冷散热最高支持440W,估计这时对散热器和风速等要求已经比较苛刻了。那么700W的目标只能靠液冷解决。

注:大家不妨注意下支持300W GPU多卡的服务器,许多都有进风温度30℃的限制。标准PC服务器通常不低于35℃环境温度支持,可见风冷之瓶颈。

提高GPU供电电压原理上并不复杂。比如在P12V下,用GPU的27个pin供应27A电流,按照电压下限11V计算就是324W。这时每个针脚要承担1A的电流。

而换用P48V之后,只用16个pin承担16A电流(每个针脚仍然是1A),但按照电压下限44V计算就已经有704W功率了。无非就是减少电阻损耗,同时保证安全(UL安规)。

扩展阅读:《_460W电源能否带动GeForceRTX 2080 Ti显卡?_》

NVLINK从6条增加到7条的意义

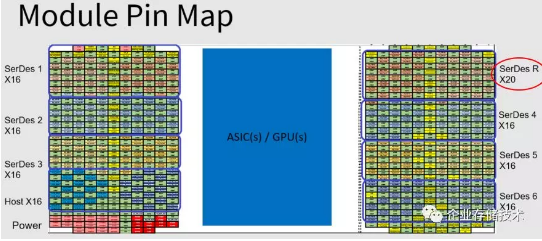

接着看下一个问题。比如像今天SXM规格的GPU模块,与主板连接的针脚除了左下方的供电之外,还有连接主机(CPU)的Host X16,也就是PCIe;另有6个SerDes X16可以给NVLINK用,NVIDIA Tesla V100正好支持6条。右上角还有个SerDes R X20,这个又可以来干啥呢?

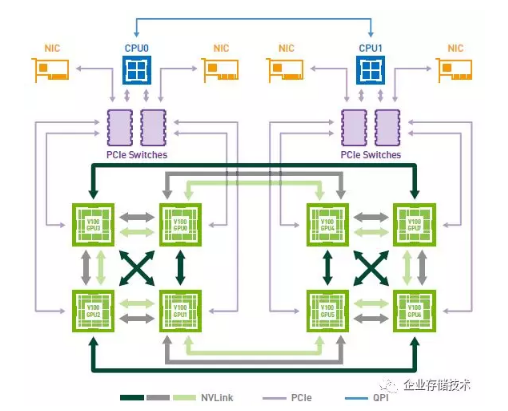

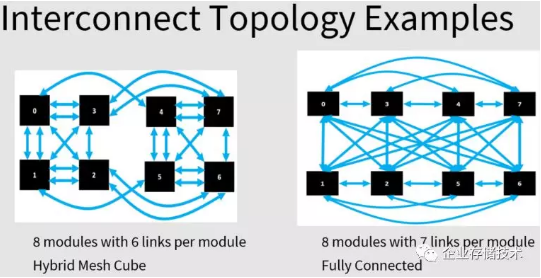

我们先来看一下当前DGX-1的架构,8个V100 GPU还不能做到点对点连接,正好就差1条NVLINK哈。

上图左边就是DGX-1的NVLINK互连形式,而如果下一代GPU提供不少于7个NVLINK,就可以做到右边每模块全连接——也就都是1跳的拓扑,效率更高。

最后一点就和收购Mellanox相关了:未来NVIDIA GPU与IB卡之间还要走PCIe连接吗?

个人猜测InfiniBand HCA会不会也将提供NVLINK版本呢?毕竟从NVLINK出现的第一天起,就能看出NV对PCIe的不满了。

在DGX-2中使用的NVSWITCH芯片(注:其实DGX-2中已经引入了450W GPU)

在16个Tesla V100的DGX-2系统中,NVIDIA为了扩大单机规模,不得不增加了12颗NVSWITCH用于互连。预计将来的大规模GPU集群,还是应该会使用Mellanox的技术。

而今天PCIe 3.0 x16(接近16GB/s带宽)应付1个100Gb/s网络接口刚好够,而InfiniBand已经发展到200Gb/s。记得我在《_从Power9互连技术看Intel与IBM的生存之道_》中曾介绍过 “每个x8 lane NVLink/OpenCAPI的带宽为25GB/s”,V100上面6个50GB/s NVLINK应该是16 lane。另外,Intel似乎还要让大家再等一年PCIe 4.0。

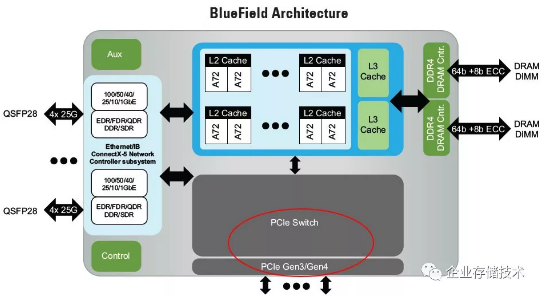

这个架构图,就是我在2016年《_IB反攻CPU:ARM SoC能否逆袭NVMe闪存阵列?_》中介绍过的Mellanox BlueField。本次NVIDIA收购Mellanox,就看到国内外同行朋友们提到这个Smart NIC。如果想让这样的芯片改用NVLINK似乎比普通InfiniBand HCA麻烦点,因为当前里面的PCIe Switch还要连接ARM CPU核。要是换用CCIX/Gen-Z呢?这方面我还不太熟,就不再班门弄斧了。

拉上ARM,应该就能摆脱对x86 CPU的依赖更多一点,NV的这盘棋已经筹划好久了。

就先到这里吧,晚上写点粗浅的认识。不知前面我猜的是否准确,哪位朋友如有高见欢迎在下面指导:)

推荐阅读

本文转载自企业存储技术微信公众号,[原文链接点这里]。

注:本文只代表作者个人观点,与任何组织机构无关,如有错误和不足之处欢迎在留言中批评指正。 进一步交流技术可以加我的微信/QQ:490834312。

尊重知识,转载时请保留全文,并包括本行及如下二维码。感谢您的阅读和支持!《企业存储技术》微信公众号:HL_Storage,也欢迎关注企业存储技术极术专栏,定期更新。