今天晚上最初没打算看网上的直播,也没计划写什么。只是看到Ampere的性能参数有点惊人,顺手先分享给大家,同时简单聊几句。

目前NVIDIA官网上好像还看不到PCIe显卡形态的A100 GPU,Quadro、GeForce啥的可能要晚些宣布吧,下面主要来看这个SXM模块的规格。

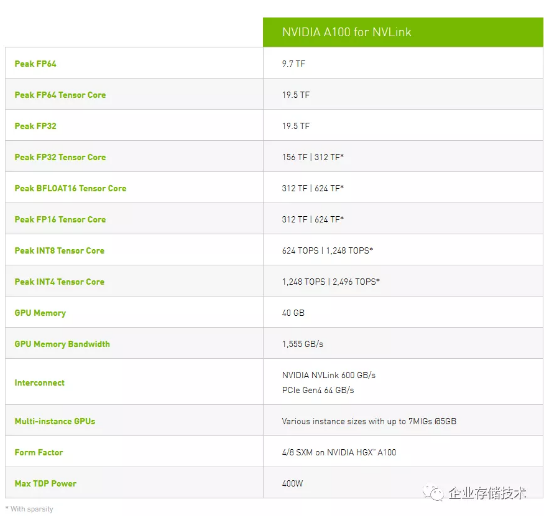

按顺序从上面往下看:

1、峰值FP64浮点9.7TF,只算是常规升级吧;

2、看来是安培的Tensor Core能用来加速FP64了(之前的P100、V100以及RTX最多加速到FP16),这个峰值19.5TF比常规双精度高了一倍;

3、常规FP32是常规FP64的2倍,没啥可说的;

4、Peak FP32 Tensor Core:156TF | 312TF(With sparsity,应该是稀疏矩阵,更多的我不懂了),这个有点NB了,就像之前TensorCore对FP16加速的效果那样。应用(编程)上需要注意什么我暂时还不了解;

5、峰值BFLOAT16和FP16 Tensor Core:312TF| 624TF(Withsparsity),是上面一项的2倍;

6、峰值INT8 Tensor Core:624TOPS | 1248TOPS,又比上一项翻倍了;

7、峰值INT4 Tensor Core:1248TOPS | 2496TOPS,继续翻倍…

8、GPU内存:40GB;

9、GPU内存带宽:1,555GB/s(也上TB了);

10、互连:NVLINK600GB/s、PCIe Gen4 64GB/s;

11、Multi-instance GPUs(多实例):可变的实例大小,最大7个5GB。这个是不是类似于分配给容器的vGPU?7个5GB显存用去了35GB,剩下5GB总要留点做基础管理;

12、尺寸:4/8SXM用于HGX A100;

13、最大TDP功耗400W,上一代Tesla V100S都350W了,增加点也正常。

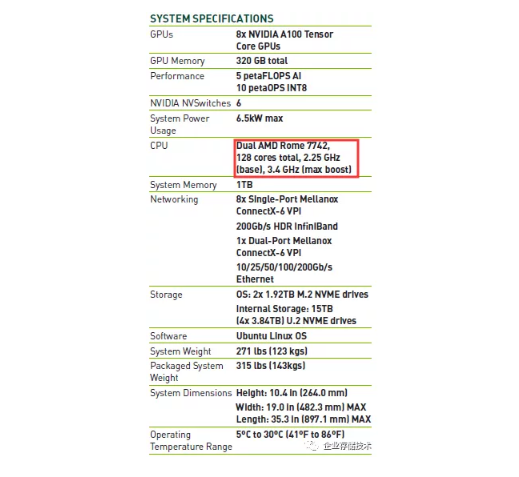

下图来自我唯一下载到的新datasheet——NVIDIA DGX A100,8 SXM模块的。

这里的AI性能直接代指FP16,主要是训练用途吧。值得一提的还有几点:

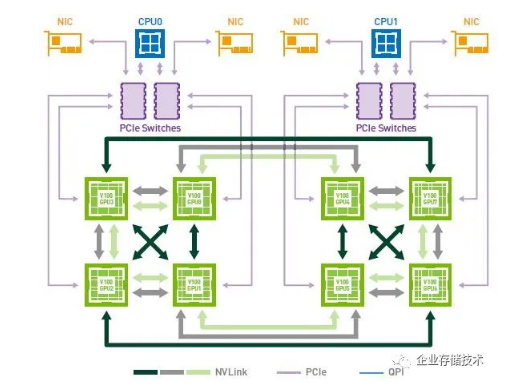

1、DGXA100用了6个NVSwitch互连,之前8模块的DGX-1(如下图)可是没有,估计是为了提高I/O效率并做到模块间对等。

DGX-1这个图许多朋友应该都不陌生了

2、CPU使用AMD Rome平台,这个非常好解释,因为Intel的PCIe 4.0还没出来。

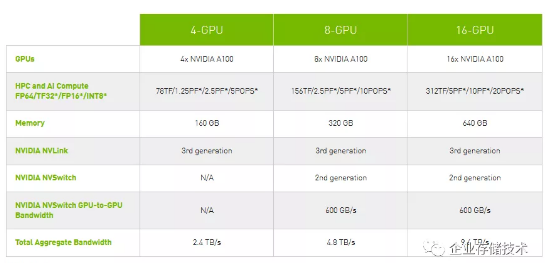

下面我们再看看最多16模块的HGX A100:

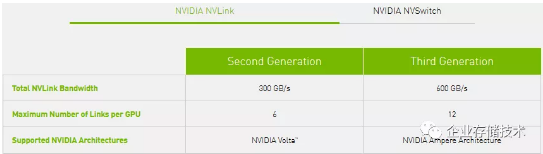

这里再次证实,NVIDIA安培4个SXM模块不用NVSwitch,从8 GPU互连开始增加交换芯片。下面我们再看看新的第3代NVLink:

安培架构每GPU的NVLink连接数翻倍到12个,这样600GB/s总带宽,每个NVLink还是50GB/s。

今天简单分享到这里,参考信息来自:https://www.nvidia.cn/gtc/key...

推荐阅读

本文转载自企业存储技术微信公众号,[原文链接点这里]。

注:本文只代表作者个人观点,与任何组织机构无关,如有错误和不足之处欢迎在留言中批评指正。 进一步交流技术可以加我的微信/QQ:490834312。

尊重知识,转载时请保留全文,并包括本行及如下二维码。感谢您的阅读和支持!《企业存储技术》微信公众号:HL_Storage,也欢迎关注企业存储技术极术专栏,定期更新。