9月中旬的早晨已经有点凉,一行人在北京CBD集合后,乘车赶往位于天津滨海新区的腾讯数据中心。虽因起个大早而颇为困倦,却不影响与腾讯数据中心架构师李典林聊得热火朝天,话题主要围绕前一天下午的腾讯数据中心分享日展开…

京津高速路况不错,正行进间典林突然掐断话头,指向路右手边一片泥地上的两个刚搭好框架的疑似仓储式建筑说:“快看,就像那个!”

车速不算很慢,权衡了一下我没有掏出手机拍照。不过呢,除了天空的颜色及能见度,真的很像这个:

或者这个:

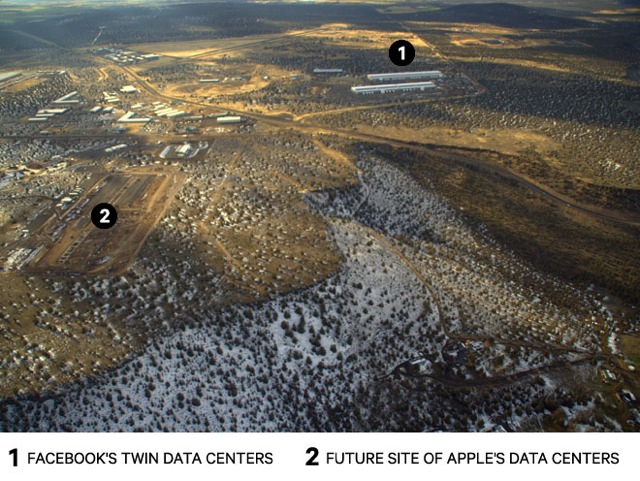

上面两幅图都是建造中的Facebook Prineville数据中心(2010年),早已投入使用。当然,我们知道数据中心通常不会就这么建在高速公路边上,真正的大环境更像下面那个样子:

Prineville的数据中心们,远处(①)是Facebook已经建成的两个数据中心(建筑),近处(②)是苹果(2012年)规划的数据中心

关键在于,不论典林手指的工地是不是在建中的仓库,他说的确实是数据中心的事儿。

如果我有条件好好的拍下典林所指的画面,就可以“一张图说明”腾讯为何要大力发展微模块数据中心(Tencent Modular Data Center,TMDC)了。

有一个耳熟能详的词,叫“国情不同”(或“中国特色”);接地气点的说法,主要受三大因素限制:土地、空气、产业环境——简而言之,就是“环境”。

腾讯天津数据中心在国内处于先进行列

用腾讯公司副总裁别洪涛在腾讯数据中心分享日上的话说,腾讯在数据中心领域起步比较早,在2006年就应业务发展需要,在深圳租了第一个工业楼宇开始尝试数据中心的建设和创新,2007年便开始第一个20万台服务器规模数据中心的设计与建设,也就是我们此行参观的天津数据中心。天津数据中心的建设从2008年启动,2010年1月封顶,2010年12月建成,一期(1号楼)是腾讯的第二代数据中心,负载已达9MW(兆瓦)。我们参观的3号楼属于腾讯的第三代数据中心,“用现在制冷的方法做到极致,冬天在天津也只能做到1.2左右的PUE…”

腾讯天津滨海数据中心3号楼供电容量60MW(30×2),号称亚洲单体供电能力最强的数据中心,单机柜平均容量8KW,高可到10KW。由于投入生产只有半年多时间(见安全运营天数),进驻服务器较少,当前负载才1MW多

大洋彼岸的另一个社交巨头Facebook,在自建数据中心上起步比腾讯晚,起点却很高:2010年1月,Facebook宣布在俄勒冈(Oregon)州的Prineville建设属于自己的第一个数据中心,同年7月决定扩建,12月完工,PUE低于1.1。

这可不是什么“后发优势”的案例,很大程度上是“美国国情”的体现。首先,美国地广人稀,看看Prineville两大巨头数据中心坐落的照片就知道了,可以毫无负担的采用仓储式大开间的设计,“单体一层大开间容量就可达到十万台服务器量级。”与楼房相比,框架简单,强度要求不高,不用考虑楼板承重问题,建设速度快,建好后直接进驻机架、微模块、集装箱无压力,部署速度也快;

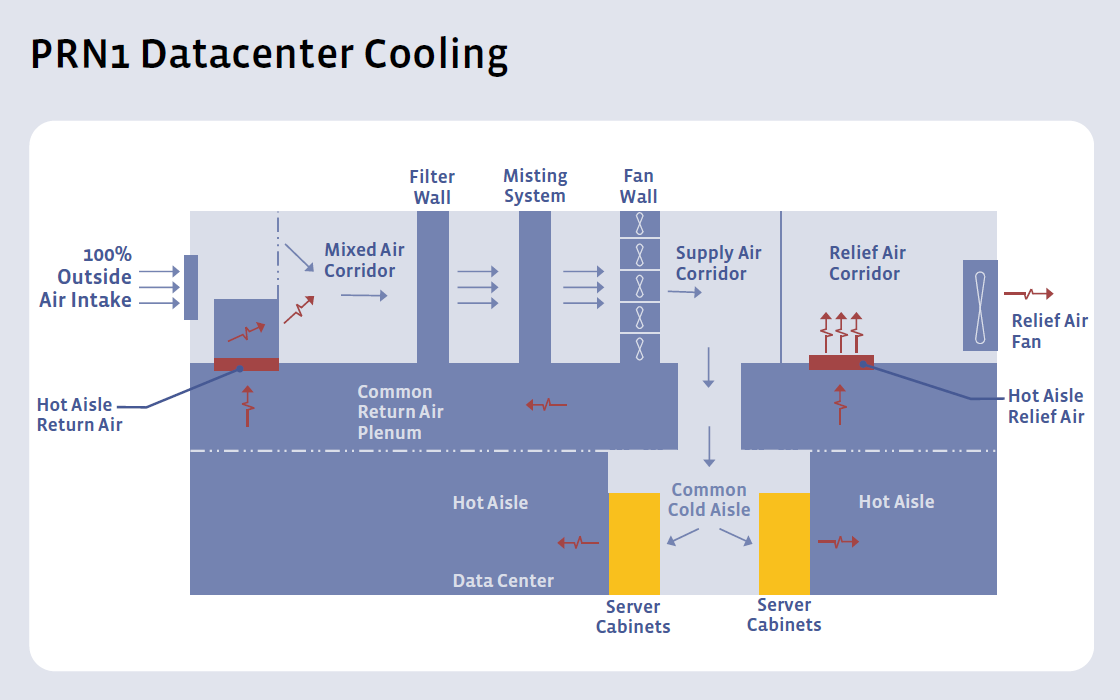

Facebook在Prineville第一个数据中心的冷却系统示意图

其次,空气质量好,可以直接采用外部空气冷却(新风自然冷),像Facebook就是顶棚进风和出风,外部空气进入后与适当比例的热通道(hot aisle)回风混合(必要时喷水雾),送入服务器机架之间的冷通道。100%自然空气冷却,没有空调水冷那么复杂的管线,也降低了对数据中心建筑的要求,同时提高能效和建设速度,可谓一举两得。

反观我国,由于全国网络建设的不均衡,像BAT(百度、阿里、腾讯)这样的互联网巨头,建设数据中心要首选靠近用户的地方,通常在人口密集的一二线城市附近,不说寸土寸金,起码仓储式大开间是不敢奢望的。即使是在相对偏远的地区,如融科智地建于大庆市东部的大庆联想科技城云计算数据中心,也因为政府对建设用地容积率的规定,必须建成三层楼房。

腾讯天津数据中心3号楼是典型的三层建筑,其中第二层还未启用

另一个有目共睹的问题就是空气质量,特别是京津地区,近几年的状况堪忧。据别洪涛介绍,腾讯在天津数据中心部分尝试过自然空气冷却,由于空气含硫量比较高,腐蚀了许多硬盘的电路板,导致硬盘故障率上升,项目被迫放弃。因此,空调和水循环冷却系统必不可少。典型的做法是一层接市电、装柴油发电机,以及制冷设备和复杂的水循环管路,二、三层布置服务器机架等IT设备及电、冷支持系统(如腾讯天津数据中心3号楼)。这样的话,基建工作复杂、要求高,IT系统的部署则受限于电梯等中间环节,总体周期长,PUE(Power Usage Effectiveness,电源使用效率)也无法与Facebook、Google等相比。

腾讯数据中心的微信公众号还提供参观自家数据中心的电子门票功能,可谓“互相服务”

不过,在各种新业务层出不穷、快速发展的互联网时代,数据中心建设速度只有更快,没有够快。美国和中国的互联网巨头都将模块化数据中心作为发展方向,即数据中心建设尽量由传统的工程项目变成工厂生产、现场组装的方式,标准化、快速、降低成本。从这一点来说,腾讯的微模块数据中心与Facebook的RDDC(Rapid Deployment Data Center,快速部署数据中心)基于同样的思想,只是由于国情不同而在技术路线上各有侧重。

腾讯天津数据中心3号楼一层的管道,这是典型的工程,很难模块化

在整个应用堆栈中,数据中心属于基础设施,而就数据中心本身而言,建筑、供变电、冷却系统等“风火水电”(金木水火土?)的部分,又是数据中心里(相对IT设施)的基础设施。在传统数据中心里,基础设施和IT设施是分开考虑的,而为了提高效率、简化运维等考虑,现代超大规模数据中心更强调整体性,将基础设施和IT设施统筹考虑。如李典林在今年的Datacenter Dynamics Converged会议深圳站上所说:腾讯的模块化数据中心设计遵循“从小到大”的原则,即从机柜、IT微模块、机房模块、建筑单体和园区逐层设计;而模块化数据中心建设遵循“从大到小”的原则,即从园区、建筑单体、机房模块、IT微模块到机柜逐层实施。“如果把服务器看成标准砖头,机柜看成厨房/阳台/洗手间,微模块就是小户型套房。通过微模块,我们可以不断复制堆叠,形成机房楼,乃至整个园区。”

在大环境允许的情况下,像Facebook这样的公司,已经在尝试包括基础设施在内的整个数据中心的模块化。中国则不同,单凭水循环管道的存在,就很难实现基础设施的模块化。所以,虽然BAT都有自建数据中心,与运营商合作的数据中心仍是主流,复杂的土木工程(而不是相对简单的模块化搭建)终非他们所长,何况运营商还可以解决网络建设和接入带宽的问题。

在这种情况下,围绕IT设施的模块化工作就成了BAT的重点。以机柜为单元的天蝎项目(Project Scorpio,BAT发起)是一例,而将多个机柜连同冷通道组件等作为一个整体是更大范围上的模块化,如百度的预模块、腾讯的微模块,Facebook的RDDC也包括相应的部分。

腾讯微模块数据中心(TMDC),可以看到近处的两个都采用了整合供电与散热的(类)天蝎整机柜服务器

腾讯对微模块数据中心的定义是,以若干机柜为基本单位,包含制冷模块、供配电模块以及网络、布线、监控在内的独立的运行单元。换句话说,微模块数据中心就是IT设施(服务器、网络、存储、机柜)加上部分基础设施,如高压直流UPS、末端精密空调、末端配电等,是一个对外部有部分依赖的微型数据中心。工信部2013年11月中对腾讯宝安数据中心的实测表明,TMDC 2.0内部(不含外部空调系统,市电+高压直流)的PUE达到1.066——当然,这不能代表整个数据中心的PUE水平。

微模块数据中心具有模块化数据中心标准化、部署灵活快速的优点,对使用第三方数据中心格外有帮助。腾讯力推微模块还有自身业务的考虑,因为腾讯产品很多(大家懂的),如负责天津数据中心的腾讯华北数据中心经理闫昆所说,一个业务上线初期很难估计其使用量,微模块颗粒度相对较细,小量部署也更具经济性。

腾讯天津数据中心外景,再看一眼午后的天空…

在标准化方面,别洪涛表示,腾讯现在做的一件事情是把微模块北向和南向接口进行标准化。南向接口是面向微模块内部的控制单元接口,北向接口是到运营管理平面的接口,腾讯希望把这两个软件接口标准化,这样就可以用运营管理系统把海量的数据中心智能、有效地运营管理起来,化解运营方面日益严峻的挑战。

别洪涛认为,微模块再怎么发展,以腾讯一家的努力,投入的资源终归有限,腾讯希望能够和大家一起建立开放的标准,通过开放,可以做得更好。在8月底举行的开放数据中心大会上,BAT携手中国移动和中国电信成立了“开放数据中心委员会”数据中心工作组,腾讯IDC平台部技术发展中心副总监朱华任组长,第一次举办的腾讯数据中心分享日和开放日活动也邀请了大量百度和阿里巴巴的同仁们参加,充分体现了腾讯开放数据中心技术、推动数据中心生态系统演进的决心。