作者:Derrick Mwiti

编译:ronghuaiyang

首发:AI公园公众号

导读

最近的CVPR 2020在推动物体检测前进方面有相当多的贡献。在这篇文章中,我们将看到几篇特别令人印象深刻的论文。

A Hierarchical Graph Network for 3D Object Detection on Point Clouds

这篇文章提出了一种基于图卷积(GConv)的层次图网络(HGNet)用于三维目标检测。它直接处理原始点云来预测3D边界框。HGNet能够捕获点之间的关系,并使用多级语义进行物体检测。

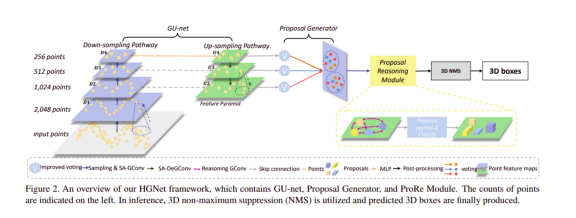

HGNet由三个主要部分组成:

- 基于GConv的U形网络(GU-net)

- Proposal生成器

- Proposal推理模块(ProRe模块) — 使用全连通图对proposals进行推理

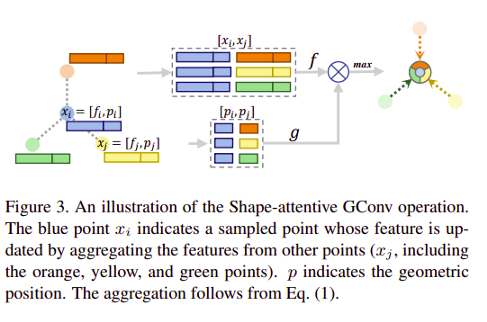

作者提出了一种形状注意力的GConv (SA-GConv)来捕获局部形状特征。通过建模相对的几何位置来描述物体的形状。

基于SA-GConv的U形网络捕获了多层特征。然后,投票模块将它们映射到一个相同的特征空间,并用于生成proposals。在下一步中,基于GConv的proposals 推理模块使用proposals 来预测边框。

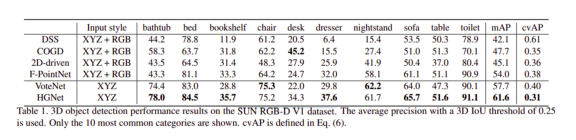

下面是在SUN RGB-D V1数据集上获得的一些性能结果。

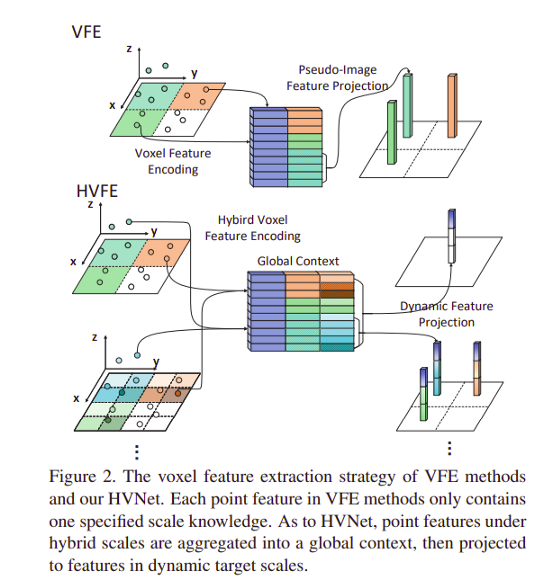

HVNet: Hybrid Voxel Network for LiDAR Based 3D Object Detection

在本文中,作者提出了Hybrid Voxel网络(HVNet),一种用于自动驾驶的基于点云的三维物体检测的一阶段的网络。

本文使用的voxel特征编码(VFE)方法包括三个步骤:

- Voxelization —— 分配一个点云到一个2D voxel 网格

- Voxel 特征提取 —— 计算一个网格依赖的point-wise特征,它被送给一个PointNet风格的特征编码器

- 投影 —— 将point-wise特征聚合到voxel-level的特征并将其投影到原始网格中。这就形成了一个伪图像特征图。

voxel的大小在VFE方法中是非常重要的。更小的voxel 尺寸捕获更精细的几何特征。它们也更擅长于物体的定位,但需要更长的推理时间。使用更粗的voxel 可以获得更快的推理速度,因为它会导致更小的特征图。然而,它的性能较差。

作者提出使用混合voxel网络(HVNet)来利用细粒度的voxel 特征。它由三个步骤组成:

- 多尺度体Voxelization — 创建一组特征voxel 尺度,并将其分配给多个voxel 。

- 混合voxel 特征提取 — 计算每个尺度的voxel依赖特征,并将其送入注意力特征编码器(AVFE)。每个voxel尺度的特征进行point-wise连接。

- 动态特征投影 — 通过创建一组多尺度物体voxels将特征投影回伪图像。

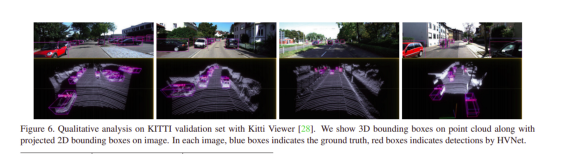

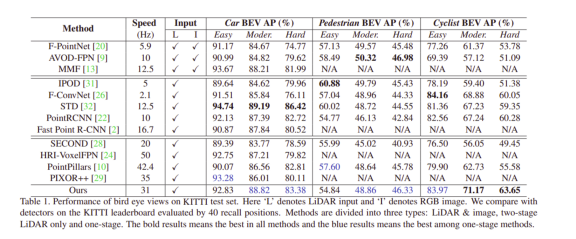

以下是在KITTI数据集上获得的结果。

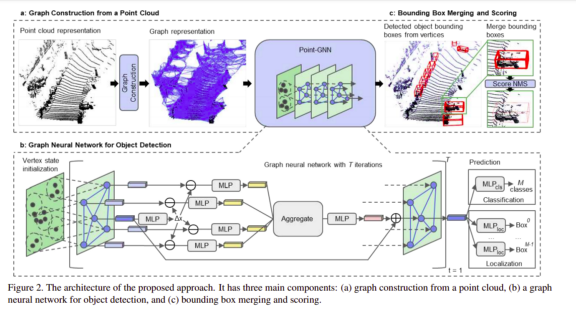

Point-GNN: Graph Neural Network for 3D Object Detection in a Point Cloud

本文的作者提出了一个图神经网络 — Point-GNN — 来从LiDAR点云检测物体。该网络预测了图中每个顶点所属物体的类别和形状。Point-GNN有一个自回归机制,可以在一个点云中检测多个物体。

提出的方法有三个组成部分:

- 图构造:使用voxel下采样点云进行图构造

- 一个_T_迭代的图神经网络

- 包围框合并以及打分

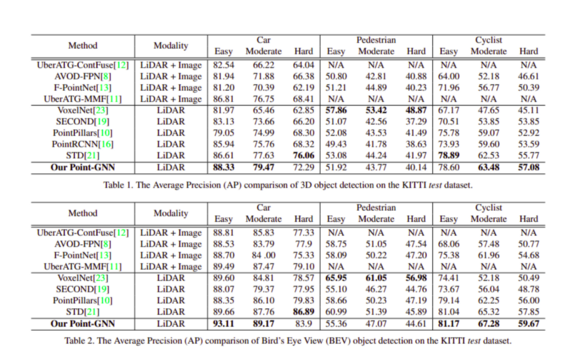

以下是在KITTI数据集上得到的结果:

代码:https://github.com/WeijingShi/Point-GNN

Camouflaged Object Detection

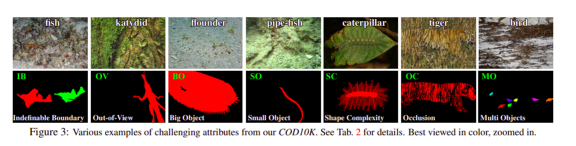

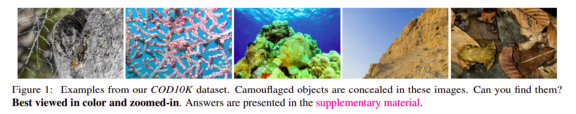

本文提出了检测嵌入在周围环境中的物体的挑战 —— 伪装物体检测(COD)。作者还提供了一个名为COD10K的新数据集。它包含10,000张图片,覆盖了许多自然场景中伪装的物体。它有78个物体类别。这些图像使用类别标签、边框、实例级和抠图级标签进行标注。

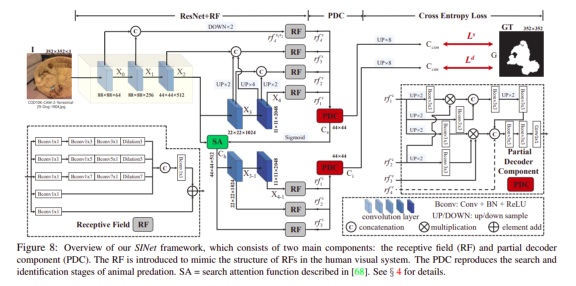

作者开发了一个称为搜索识别网络(SINet)的COD框架。

代码:https://github.com/DengPingFa...

该网络有两个主要模块:

- 用于搜索伪装物体的搜索模块(SM)

- 检测目标的识别模块(IM)

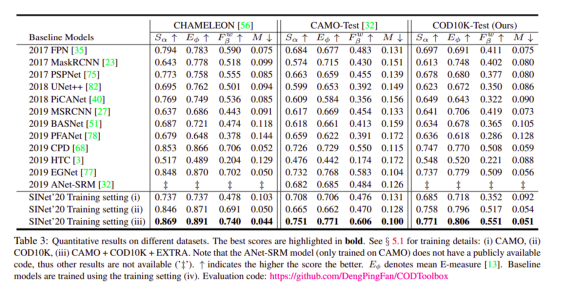

以下是各数据集的结果:

Few-Shot Object Detection with Attention-RPN and Multi-Relation Detector

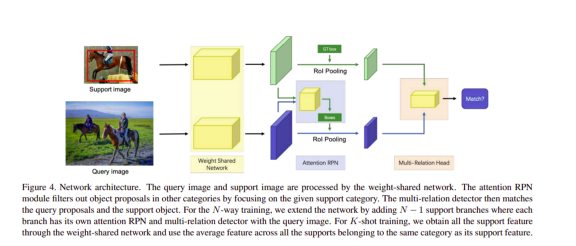

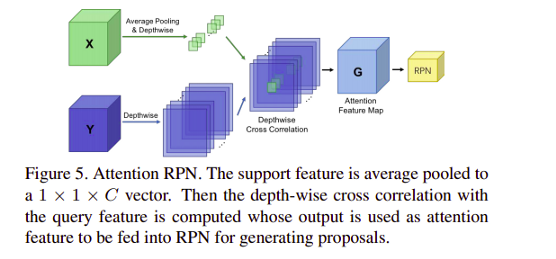

本文提出了一种few-shot目标检测网络,其目标是检测只含有少量标注样本的没见过的类别的物体。

他们的方法包括attention-RPN、多关系检测器和对比训练策略。该方法利用few-shot支持集和查询集之间的相似性来识别新物体,同时减少了误识别。作者还提供了一个包含1000个类别的新数据集,其中的物体具有高质量的标注。

该网络体系结构由一个多分支的权值共享框架组成,一个分支是查询集,其他分支是支持集,权值共享框架的查询分支是一个Faster R-CNN网络。

作者介绍了一种带有多关系模块和attention-RPN的检测器,用于在支持和查询中可能出现的框之间进行精确解析。

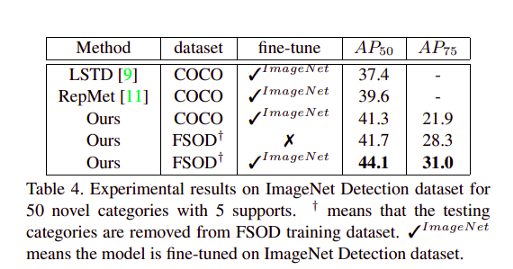

下面是在ImageNet数据集上获得的一些结果。

以下是在一些数据集上获得的观察结果。

D2Det: Towards High-Quality Object Detection and Instance Segmentation

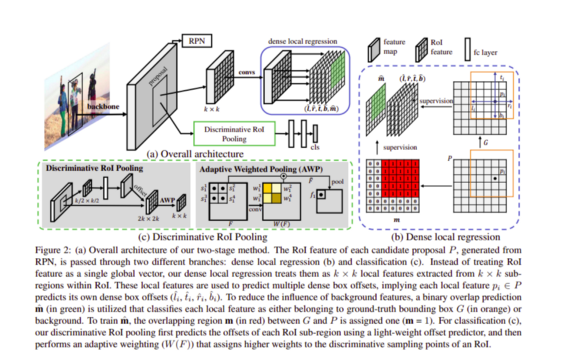

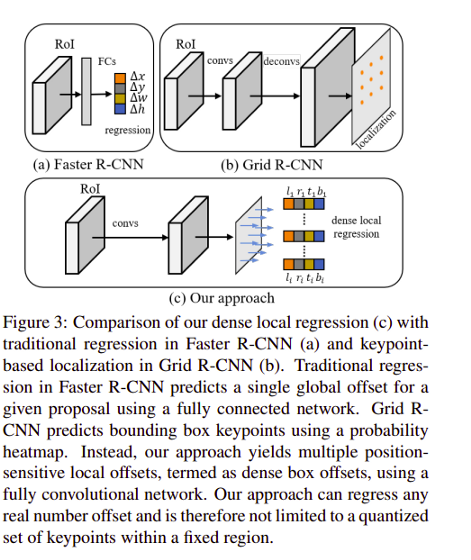

本文作者提出了D2Det,一种既能精确定位又能精确分类的方法。他们引入了一个稠密的局部回归来预测一个物体的proposal的多个稠密box偏移量。这使他们能够实现精确的定位。

为了实现准确的分类,本文还引入了一种有区分性的RoI pooling方案。pooling方案从该方案的多个子区域中抽取样本,并进行自适应加权以获得有区分性的特征。

代码:https://github.com/JialeCao001/D2Det

该方法基于标准的Faster R-CNN框架。在该方法中,传统的Faster R-CNN的盒偏置回归被提出的密集局部回归所代替。在该方法中,通过有区分性的RoI pooling来增强分类能力。

在两阶段方法中,第一阶段采用区域建议网络(RPN),第二阶段采用单独的分类和回归分支。分类分支是基于可区分性池化的。本地回归分支的目标是物体的精确定位。

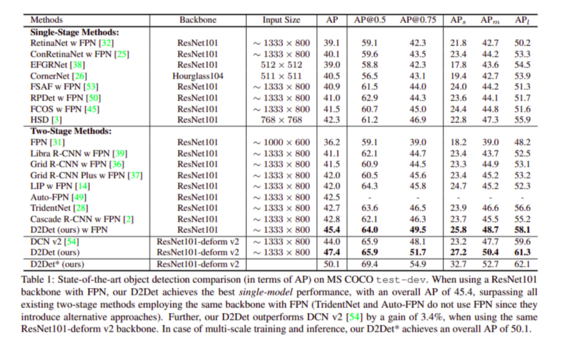

MS COCO数据集的结果如下:

—END—

英文原文:https://heartbeat.fritz.ai/cvpr-2020-the-top-object-detection-papers-f920a6e41233

推荐阅读

关注图像处理,自然语言处理,机器学习等人工智能领域,请点击关注AI公园专栏。

欢迎关注微信公众号