首发:AIWalker

标题&作者团队

【Happy导语】该文是EDVR作者在视频超分领域的又一深入思考,它将变形对齐与光流对齐进行了“桥接”,分析了变形对齐在视频超分领域成功的内机理“Offset Diversity”,并在变形对齐和光流对齐两类方法中进行了验证;与此同时,基于所得到的发现提出了一种新颖的"Offset-fidelity Loss"用于缓解变形卷积训练过程中的不稳定因素,同时还有助于提升模型的性能。

Abstract

变形卷积最初旨在对目标的几何形变提供更好的自适应能力,后来发现它非常适合于处理多帧对齐问题并被应用到视频超分中。尽管,变形卷积有助于提升视频超分的性能,但其潜在对齐的机理尚不明确。该文对变形对齐与光流对齐之间的相关性进行了精细分析,同时表明:变形卷积可以分解为空域仿射变换与卷积的组合。这种分解特性揭示了变形对齐与光流对齐之间的相关性,它们的关键区别在于:变形对齐具有偏移灵活性。

作者通过实验进一步证实:提升形变对齐的灵活性有助于生成对齐性更好的特征,进而提升视频超分的性能。基于前述发现,作者提出了一种offset-fidelity损失用于指引偏移学习。实验表明:该损失有助于避免避免偏移溢出问题,同时可以缓解变形对齐的不稳定问题。除了变形对齐外,该文还提出了一种更灵活的思路:将偏移灵活性引入到光流对齐并提升其性能。

该文的贡献主要有以下几点:

- 首次在变形对齐与光流对齐之间构建了相关性;

- 系统的探索了偏移灵活性的优势,它是提升对齐精度与超分性能关键因素;

- 提出一种

offset-fidelity损失以稳定训练,同时保持偏移灵活性; - 引申出一种更灵活的方法用于提升光流对齐方法的偏移灵活性。

Method

目前,在视频超分领域有这么两大类主流方案:(1) 基于光流的显示对齐;(2) 基于变形卷积的隐式对齐。这两大类方法往往被独立进行研究与改进,作者认为很有必要去探索一下:(1)隐式对齐与显示对齐的相关性;(2) 隐式建模性能提升的根因所在。研究两者之间的相关性不仅有助于我们更好的理解变形对齐的内在机制,同时还引申出一种广义的视频超分方案。

接下来,我们将从四个方面展开本文的发现与创新点介绍。

Deformable Convolution Revisited

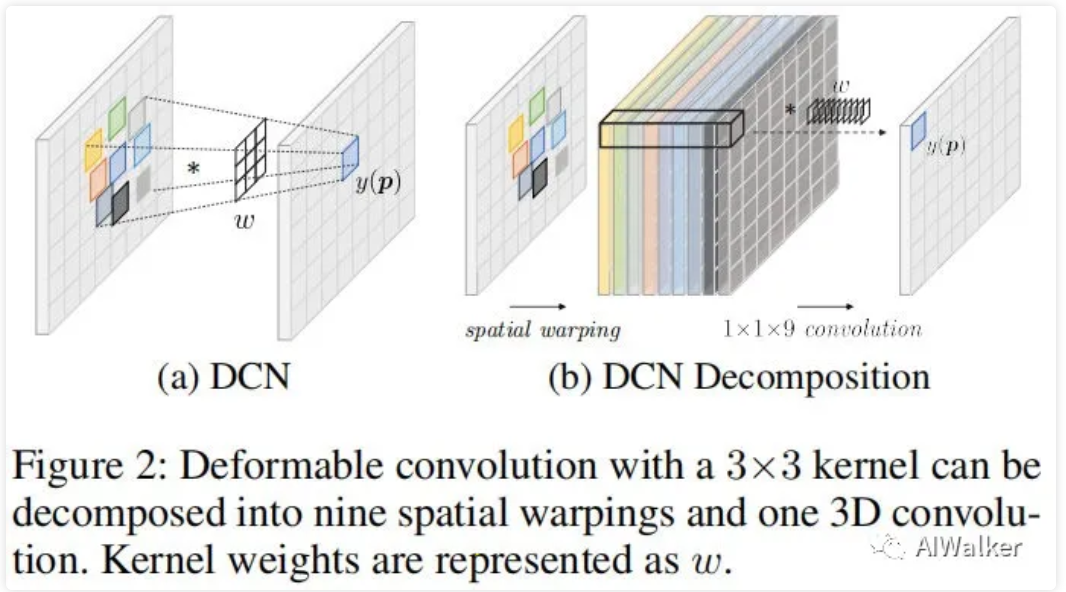

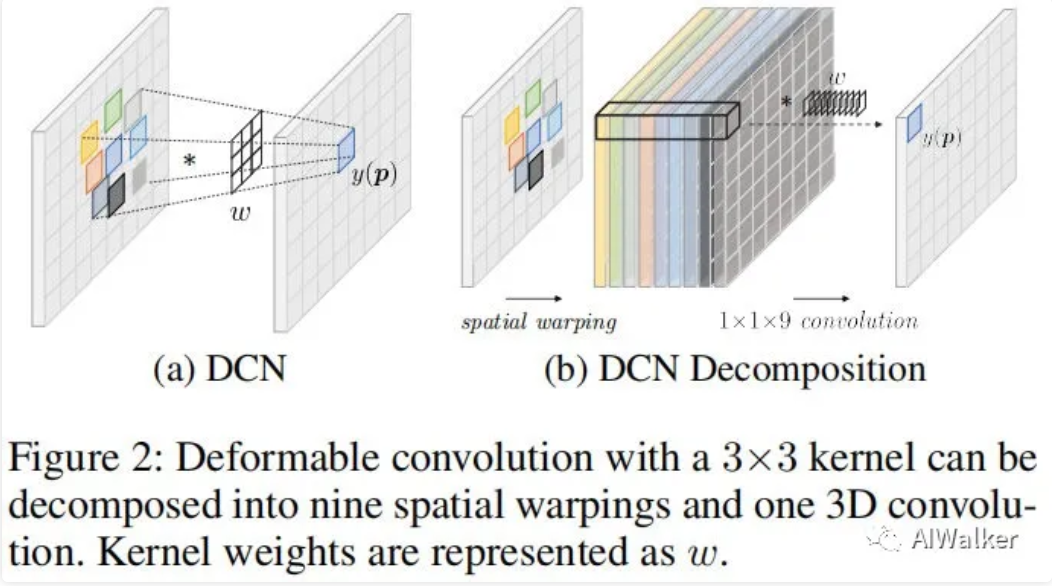

变形卷积最早被提出用于目标检测与图像分割,假设表示标准卷积的第k个采样偏移,当时,,我们采用表示位置处额外学习的偏移,那么变形卷积可以描述如下:

其中,表示输入与输出特征以及卷积核,变形卷积的图示见下图a。相比标准卷积,形变卷积具有更灵活的采样策略。

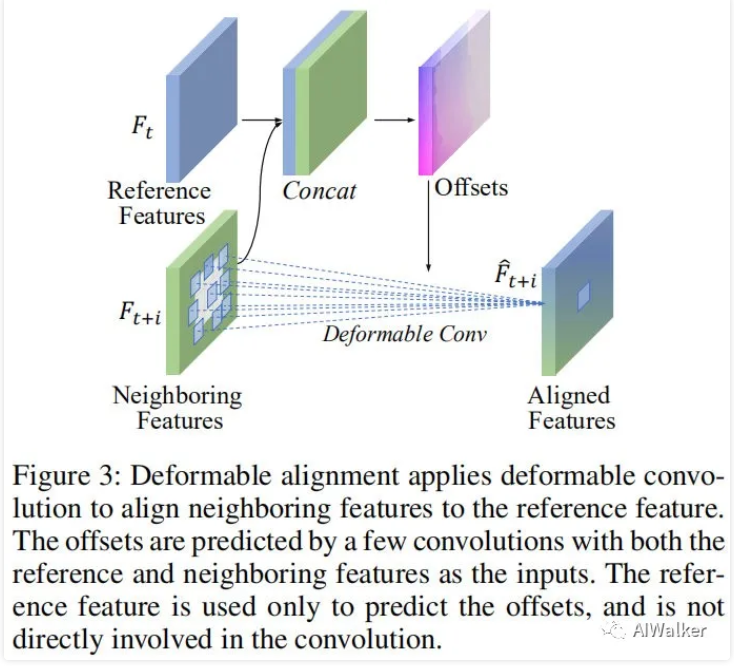

Deformable Alignment

在视频差分领域,如何建立相邻帧之间的相关性并用于细节提取与融合是非常关键的。TDAN是首个将变形卷积纳入到视频超分中用于对齐的方案,见下图。

我们假设表示参考帧与近邻帧,在变形对齐过程中,变形卷积将用于将向对齐。此时有:

其中,分别表示对齐后特征与预测偏移。注:参考帧仅用于预测偏移,并不直接参与形变卷积计算。

Relation between Deformable Alignment and Flow based Alignment

截止目前,尚未看到变形对齐与光流对齐之间的直观联系,已有研究中也鲜少对此进行探索。接下来,我们将看到变形卷积是如何与光流对齐想关系的。

假设表示输入特征,表示位置p处的偏移。我们采用表示仿射特征,将其嵌入到变形卷积公式后有:

很明显,该公式等价于标准的3D卷积。此时,我们可以看到:变形卷积被分解成了个独立的空间仿射变换,后接一个标准3D卷积,图示过程见下图b。

注1:对进行广义形式化,即采用替换,那么空间仿射阶段就不再有偏移数目约束;

注2:通过在通道维度堆叠N个仿射特征,上述3D卷积可以转换成2D卷积,也就是说DCN等价于N个独立的空间仿射后接一个形式的2D卷积。

注3:当n=1时,从运动补偿角度来看,变形对齐具有光流对齐相似的功能。也就是说,变形对齐具有与光流对齐相似的功能,但具有更强的偏移灵活性。

从前面的分析可以得出这样几个有意思的探索方向:

- Where does deformable alignment gain the extra performance in comparison to flow-based alignment?

- Is higher offset diversity always better?

- Can we increase the offset diversity of flow-based alignment?

Offset-fidelity Loss

受启发于上述变形卷积的分解,我们将证实:光流是如何通过所提offset-fidelity损失中受益。

由于不清晰的偏移解释性,变形对齐通常采用随机初始化方式从头开始训练,随着网络的容量提升,变形对齐的训练变得不再稳定,偏移溢出严重影响模型性能。相反,在光流对齐中,有各种不同的策略被提出用于改进对齐精度与收敛速度,比如flow guidance loss, flow pretraining。

考虑到变形卷积与空间仿射之间的相关性,作者提出采用光流引导偏移的训练,进而提出一种offset-fidelity损失用于约束偏移,以确保其不会偏移光流过多;更进一步,为促进优化学习与便宜多样性,作者引入了Heaviside step函数,此时所提损失函数定义如下:

总体损失函数定义如下:

其中为超参数,用于控制偏移灵活性。

Analysis

接下来又是“填坑”时间了,我们需要通过实验来验证前面的几点发现以及创新点。我们以EDVR-M为基准进行实验(网络结果相对简单,效果还好),DCN则采用的是V1版本而非V2版本哦。

训练数据则采用了REDS与Vimeo-90K两个,优化器为Adam,学习率机制为Cosine Annealing with restarts,初始学习率为,Batch=16,LR输入块大小为,总计训练次迭代。训练过程分为两个阶段:(1) 无TSA模块;(2) 有TSA模块。损失函数为Charbonnier,硬件平台为4个Tesla V100GPU。

Deformable Alignment vs. Optical Flow

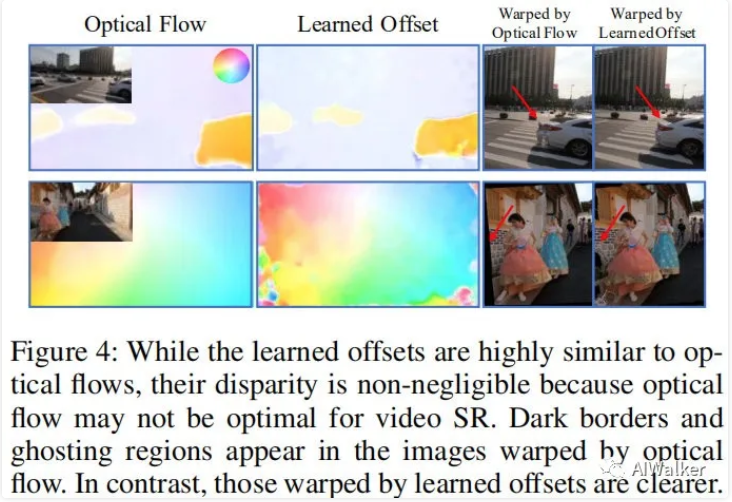

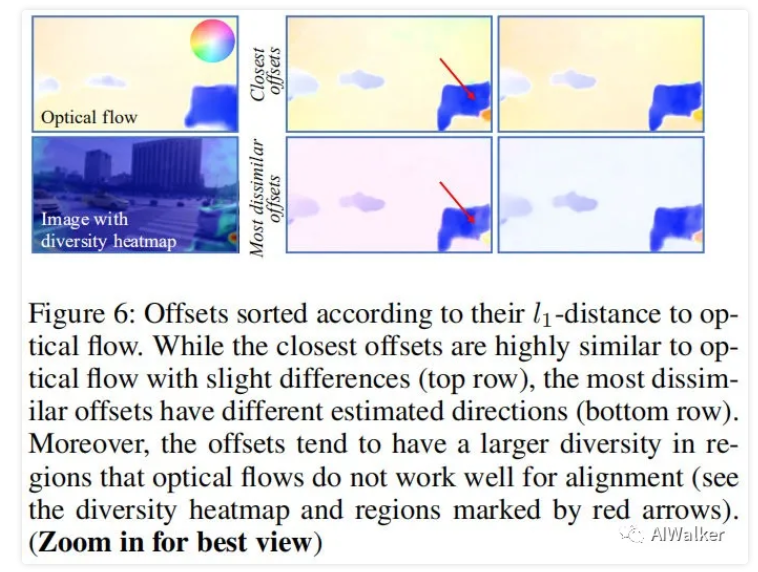

如前面所述,当时,变形对齐与光流对齐具有相随的功能,也就是说两者所学习到的偏移应当具有相似的表现形式。那么是不是如此呢?见下图。很明显,通过变形卷积学习到的偏移与光流PWCNet所学习到的光流具有高度相似性。

由于任务特性的差异,两者所学习到的信息差异是不可忽视的。PWCNet用于描述帧间运动,而变形卷积则用于视频超分(在这个任务中,光流可能并非最优帧间相关性表达)。从上图可以看到:通过形变卷积所学习到的偏移仿射得到的图像保留有更多的场景内容;相反,通过光流仿射的图像存在暗区和伪影问题(见上图红色箭头区域)。

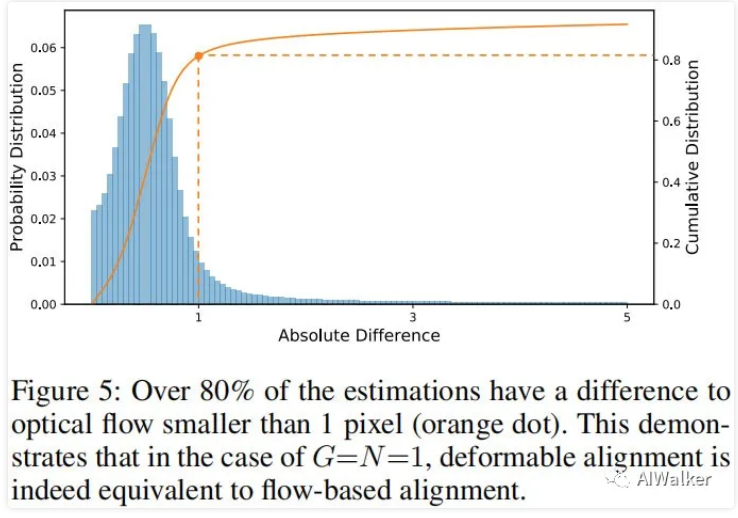

与此同时,作者还通过计算两者间的像素差异性定量分析了两者之间的相关性,见上图。可以看到:超过80%的像素具有非常小的差异(不高于1个像素)。这意味着两者之间确实存在高度等价性。

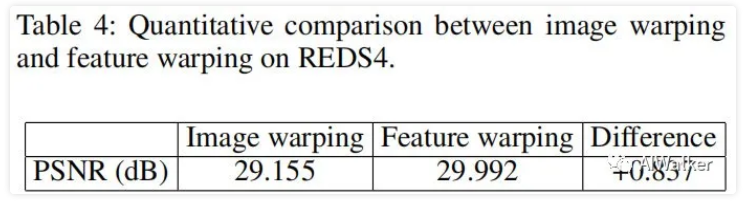

变形对齐与光流对齐的另一个关键区别在于:作用对象不同,即光流在Image层面进行对齐,而变形对齐则是在特征层面对齐。鉴于此,作者进行了这样一组实验:采用特征层面的光流对齐替换图像层面的光流对齐,结果见下表。这意味着:特征层面的仿射同样有益于光流对齐。

Offset Diversity

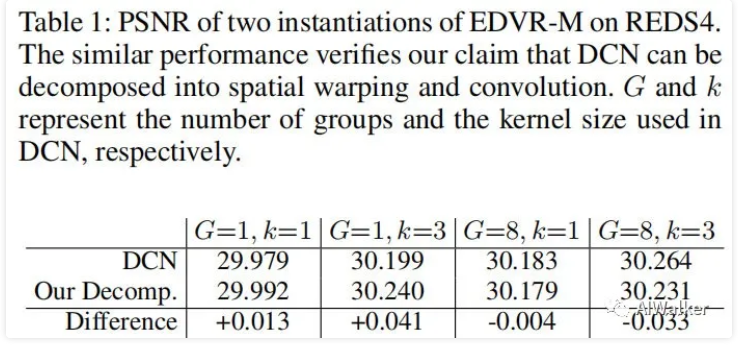

正如前面所述的,DCN可以进行分解,并具有等价性。那么是否真的这样呢?作者进行了一组对比性实验,见下表。可以看到:两种形式具有非常相似的性能,证实前述假设。

接下来进入“问答”环节,请听题:"The roles and characteristics of the additional offsets in deformable alignment"。

为回答上述问题,作者固定,并调节N分别为1和15。对所得15组偏移与光流按照距离进行排序,结果见下图。可以看到:一方面存在于光流非常相似的偏移;另一方面也存在于光流不同方向的偏移。尽管这些偏移可以类似光流区分不同目标的运动,但是它们的方向却与真实方向无相关性。

作者进一步分析了偏移的灵活性,可以看到:在光流表现不好的区域(比如边缘)偏移具有更大的灵活性(见上图红色箭头)。同时需要注:尽管变形卷积学习了更灵活的偏移,但其整体形状仍与光流具有强相关性。这也就意味着:帧间运动对于变形对齐仍是非常重要的因素。

算你回答正确,接下来是第二题,请听题:“Whether the diverse flow-like offsets are beneficial to video SR”。

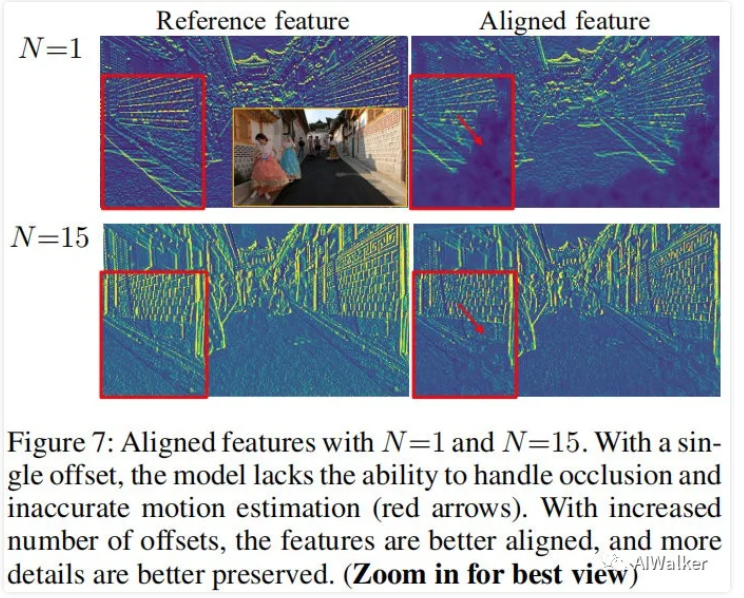

为回答上述问题,作者对对齐特征及其性能进行了分析,见下图。可以看到:当N=1,即具有仅有单个偏移时,对齐特征存在明显的仿射误差问题(见图中红色箭头区域),这种不精确的对齐特征会影响后续复原任务;当N=15时,即具有多个偏移时,多个对齐特征具有互补特性,可以提供更好的对齐特征,进而提升后续复原任务的性能。

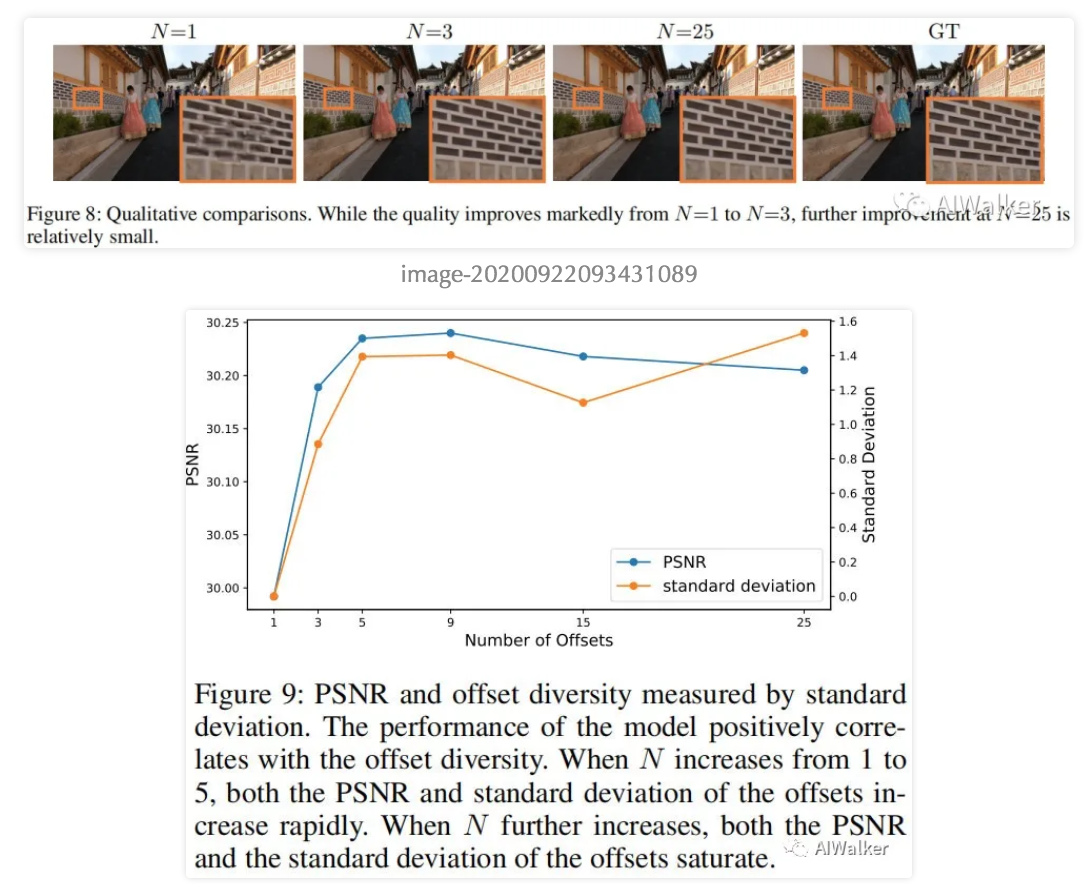

最后一个问题:"If more offsets will always lead to a better performance."。

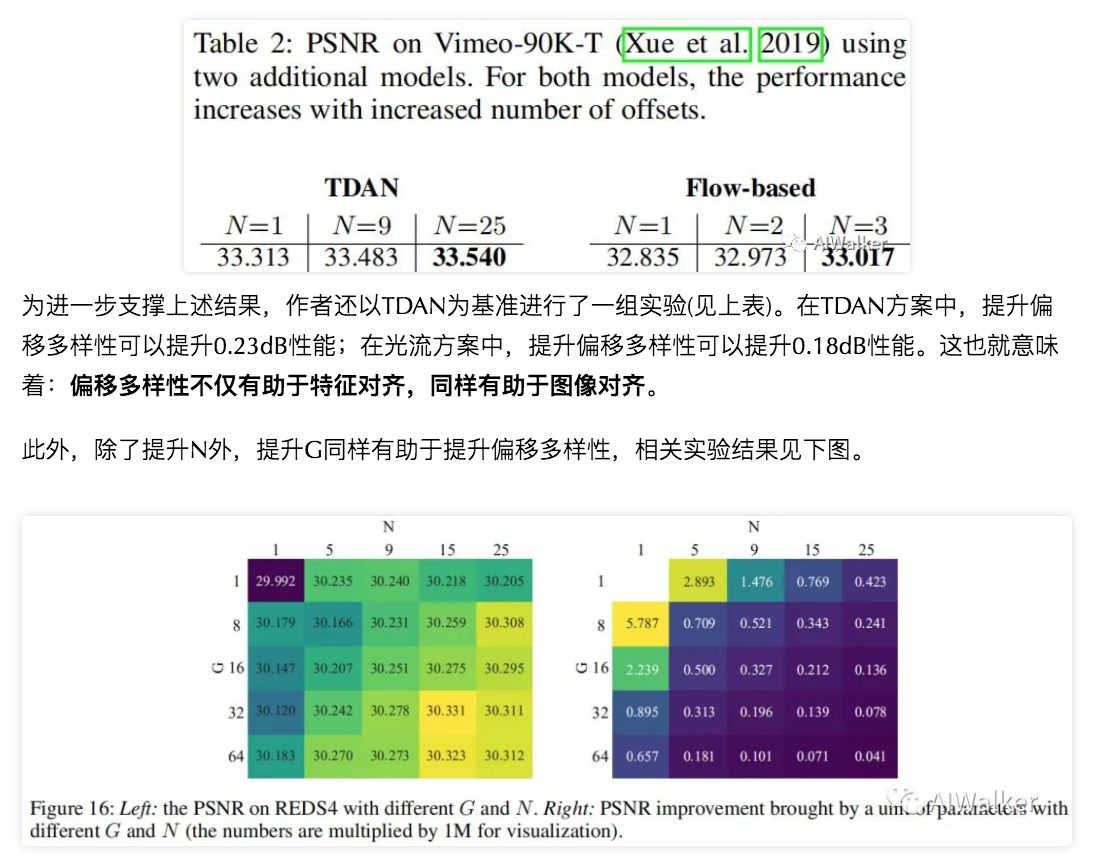

为回答该问题,作者进行了一组实验,结果见下面两个图。可以看到:随着N的增加,模型的性能在提升,但很快达到饱和(30.23dB)。这也就是说:单单提升偏移数量会降低计算效率且不会显著提升性能,而计算效率与模型性能之间的均衡同样需要考虑。与此同时需要注意:在变形对齐中是难以对上述问题进行均衡的,因为变形对齐的偏移数量与卷积核尺寸的平方相关。而作者所设计的方案则可以提供一种更灵活的均衡方案。

作者同时还对偏移与PSNR的相关性进行了统计,见上图。可以看到:模型的性能正比于偏移灵活性,PCC=0.9418。这也就意味着:偏移多样性确实有助于提升模型性能。

Offset-fidelity Loss

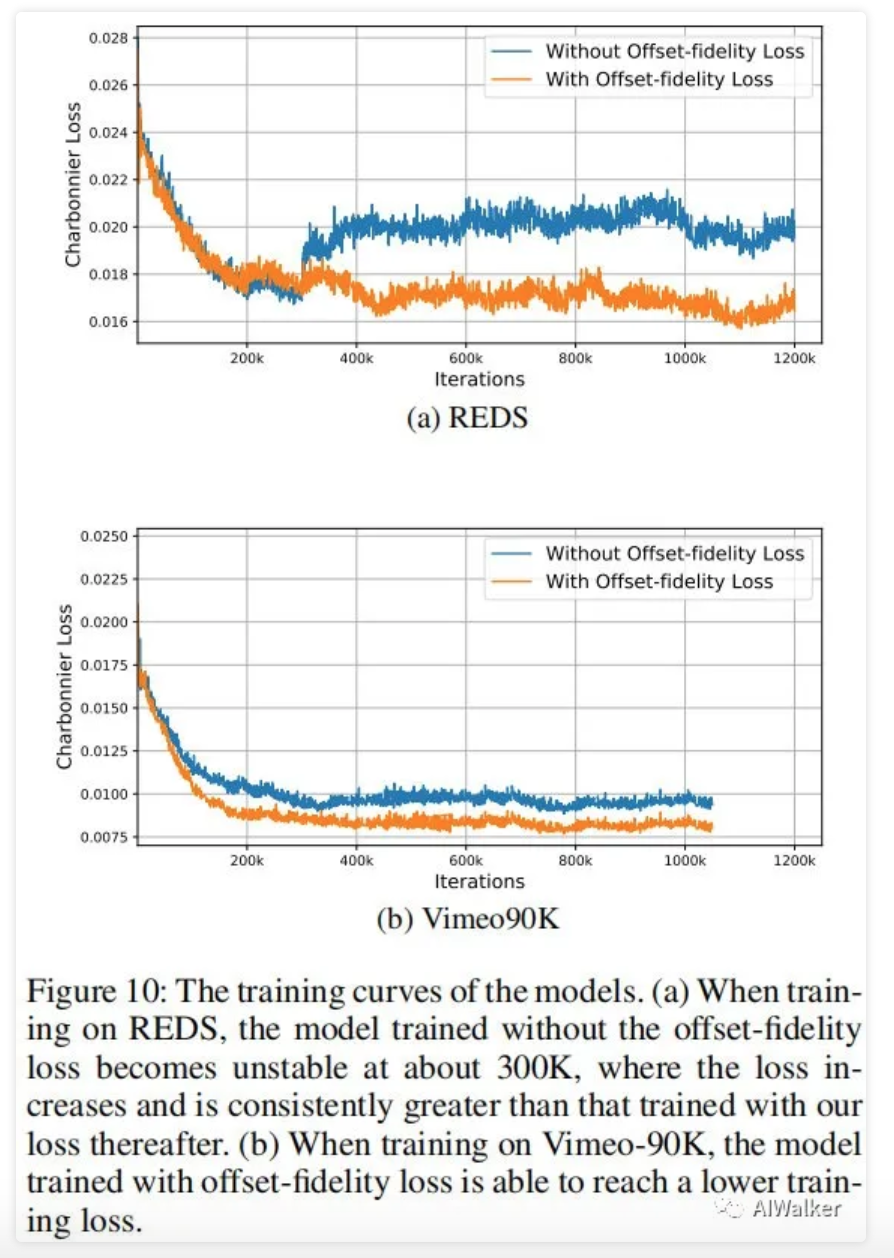

作者还按照EDVR一文训练机制训练EDVR-L,由于网络容量的提升,变形对齐的训练变得不稳定。而且偏移的溢出会进一步导致变形对齐输出一个零特征图,进而导致EDVR退化成单帧图像超分,这无疑严重影响了模型的性能。

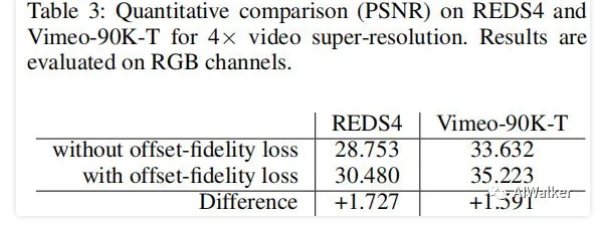

相反,采用作者所提Offset-fidelity损失辅助训练会后,偏移将不再偏离光流过多,产生了更具解释性的偏移与更好的性能。在REDS与Vimeo90K两个数据集上的损失函数下降曲线见上图。可以看到:所提损失函数有助于模型的训练收敛。与此同时,下表给出了所提损失函数所带来的性能提升(约1.73dB)以及视觉效果对比。

全文到此也就结束,到该文感兴趣的同学建议去看一下原文的Appendix部分内容。

Conclusion

该文对变形对齐在VSR中的成功应用机理进行了分析,从概念和表现形式上将其与光流对齐进行了紧密连接。

对于光流对齐而言,所提方法对形变卷积关于偏移数量的约束进行了松弛,提供了一种更灵活的方式提升偏移灵活性并用于提升光流方法对齐的性能与质量;

对于形变对齐而言,文中发现促使我们进一步理解的形变对齐的迁移机制,潜在的启发了新的对齐方案,提出了一种Offset-fidelity损失缓解形变对齐训练过程中的不稳定问题。

推荐阅读

本文章著作权归作者所有,任何形式的转载都请注明出处。更多动态滤波,图像质量,超分辨相关请关注我的专栏深度学习从入门到精通。