作者:唐僧 huangliang

来源:企业存储技术

最近因为工作上的项目,我从周末到前天晚上算是连续加了点班。昨天下午,在搬砖的同时线上听了一段阿里云主办的《方升架构年度峰会》,想就服务器散热这块简单扯几句。在各位业内专家老师面前班门弄斧了,如有我写的不对之处,欢迎拍砖指正:)

*1U风冷2x 350W CPU*的取舍(代价)

**

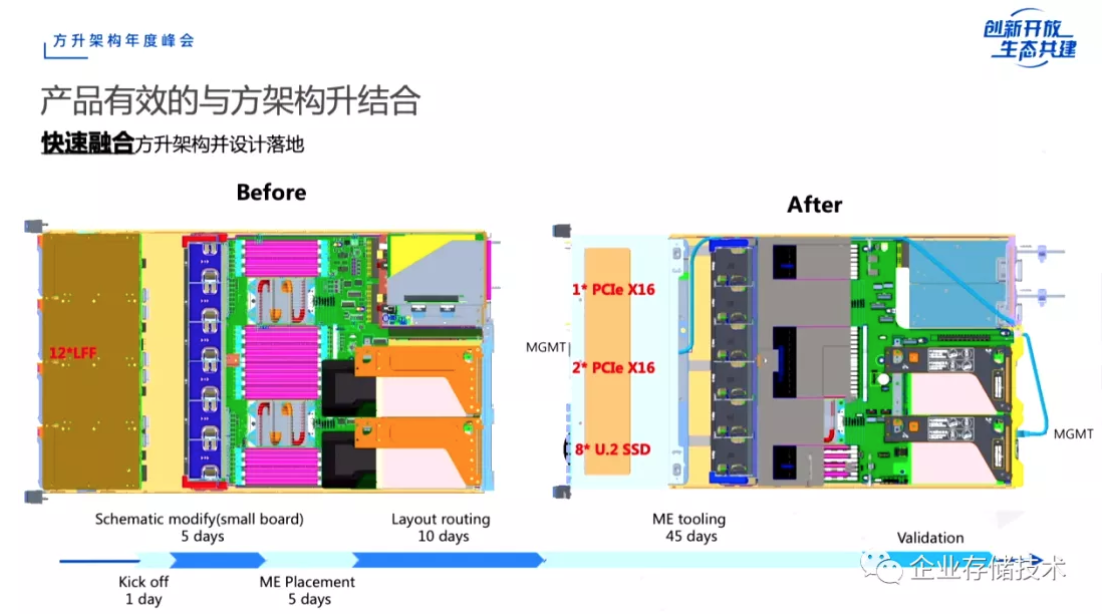

上面这张ppt__来自阿里云服务器高级硬件架构师曹洪浩的演讲《方升架构技术介绍》。

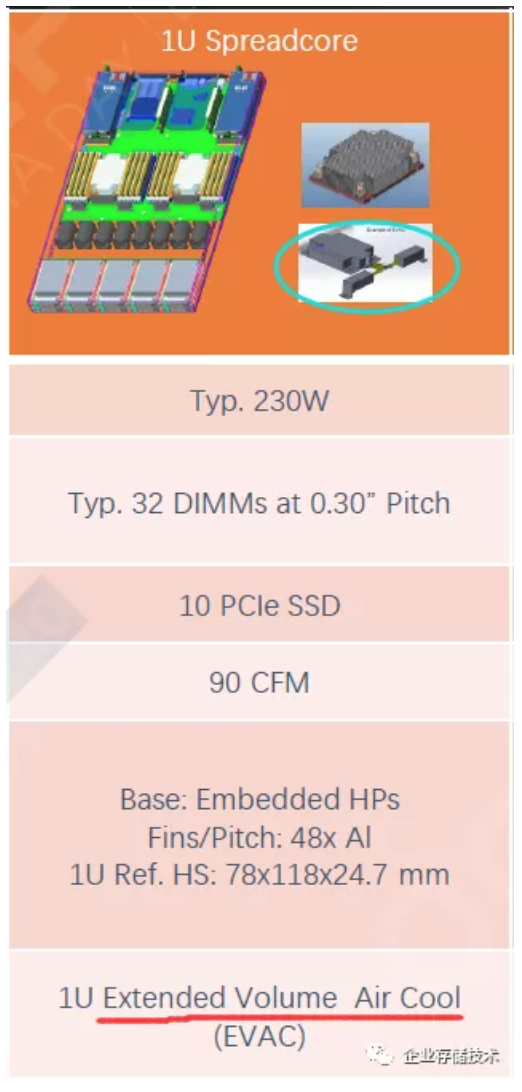

不知大家是否还记得,我在《_下一代Xeon服务器:Ice Lake-SP通用云平台设计预览_》中曾经列出过一张Intel朋友的资料,里面写的1U Spreadcore传统布局双路服务器,典型风冷限制CPU TDP为230W(应该是针对35℃环境温度),对应的PCIe(2.5英寸NVMe)SSD数量10个,系统散热风量90 CFM,散热器也是T型的。如下图:

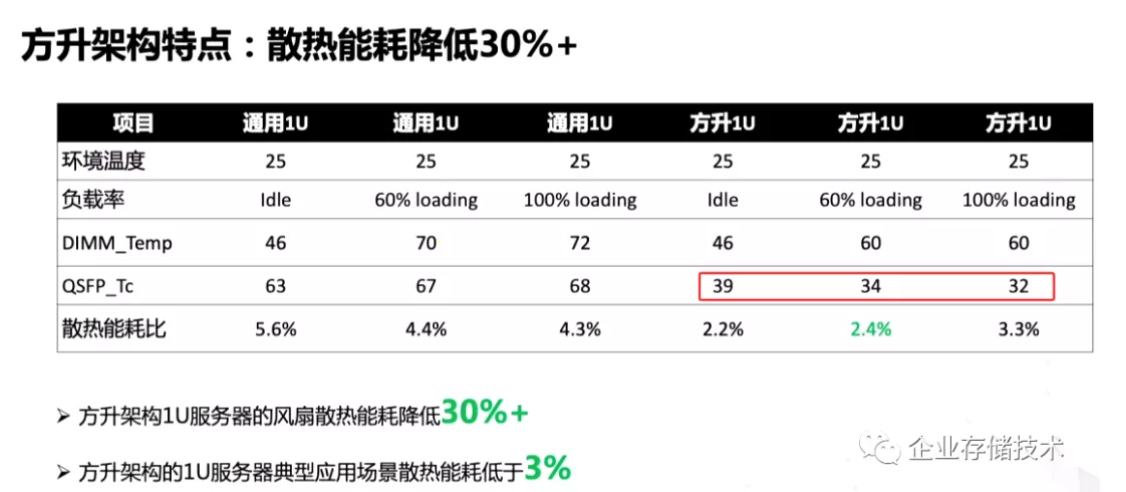

相比之下,阿里列出的通用1U和方升1U的系统最大流量(150 CFM)明显更高。提高风量的办法可以有2个,一个是加快风扇转速,这个4056风扇已经很高了不能无限增加;另一个就是降低流阻。

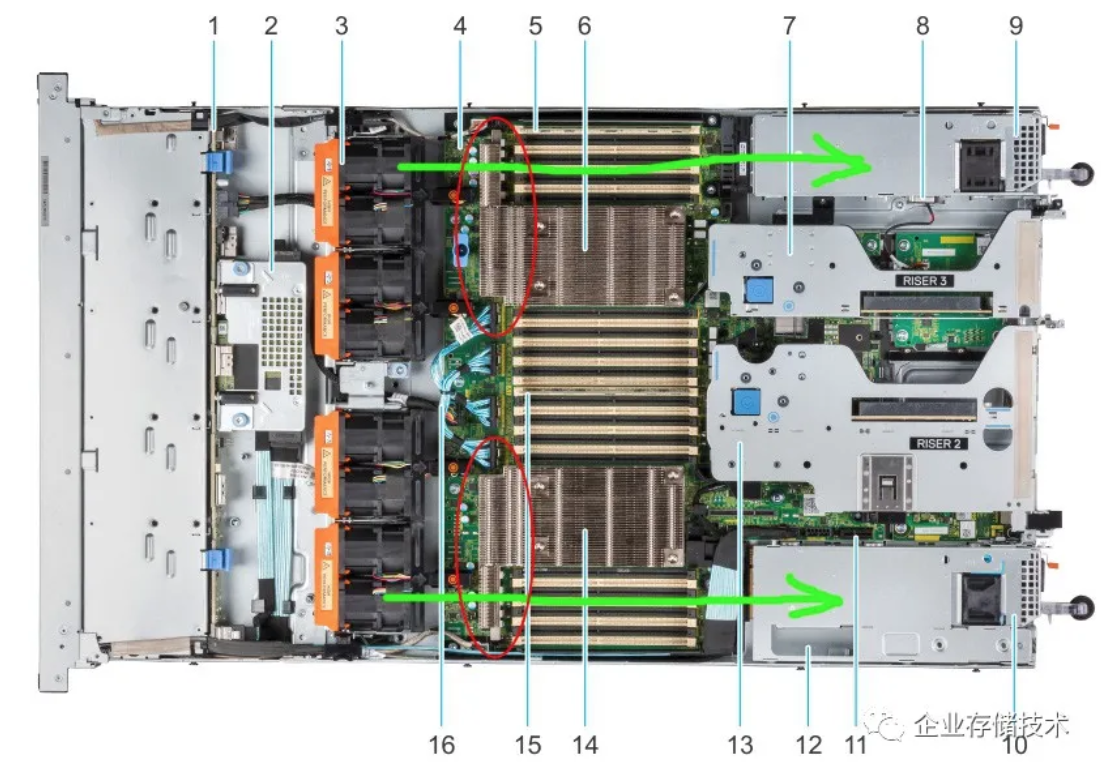

流阻怎么降低呢?下面图片,我拿一款目前支持比较高TDP CPU(280W AMDEPYC)的Dell PowerEdge R6525图片为例。在服务器前部进风口和风扇排之间,可能影响到CPU散热效率的几乎只有HDD/SSD驱动器,方升就是在这块下的文章(后面我在介绍英业达做的2U系统时,也是一样的原理)。

试想一下,如果互联网用户的某款1U机型,只需要2-4个2.5寸或者M.2SSD,然后把PCIe I/O卡挪到传统通用型服务器前端放盘的位置。前面板的开孔率和进风效率提高,这时流阻降低25%应该说是合理的。

根据我的理解,某款机型设计在功耗(发热)一定的情况下,风流量越大,进出风口的温差应该越小。为什么方升的进出风口温差15.5℃反而比通用1U提高了?这应该是因为CPU功耗支持更大吧,在机箱内进行的热交换相应增加了。

提到热交换面积,PowerEdgeR6525可以配置L型CPU散热片,也就是我上图中用红圈标出的。大家不难理解T型的总表面积可以做到更大,为什么R6525不用T型呢?

我用绿色箭头标了2个通过L型散热器臂的气流路径——通过内存之后就是电源,别忘了电源尾部还有自己的风扇。

而在2颗CPU之间的内存区域,其下风方向还有PCIe I/O板卡,比如支持个70W的Tesla T4什么的。如果用了T型CPU散热器,这部分的温度上升也是要考虑的哦。

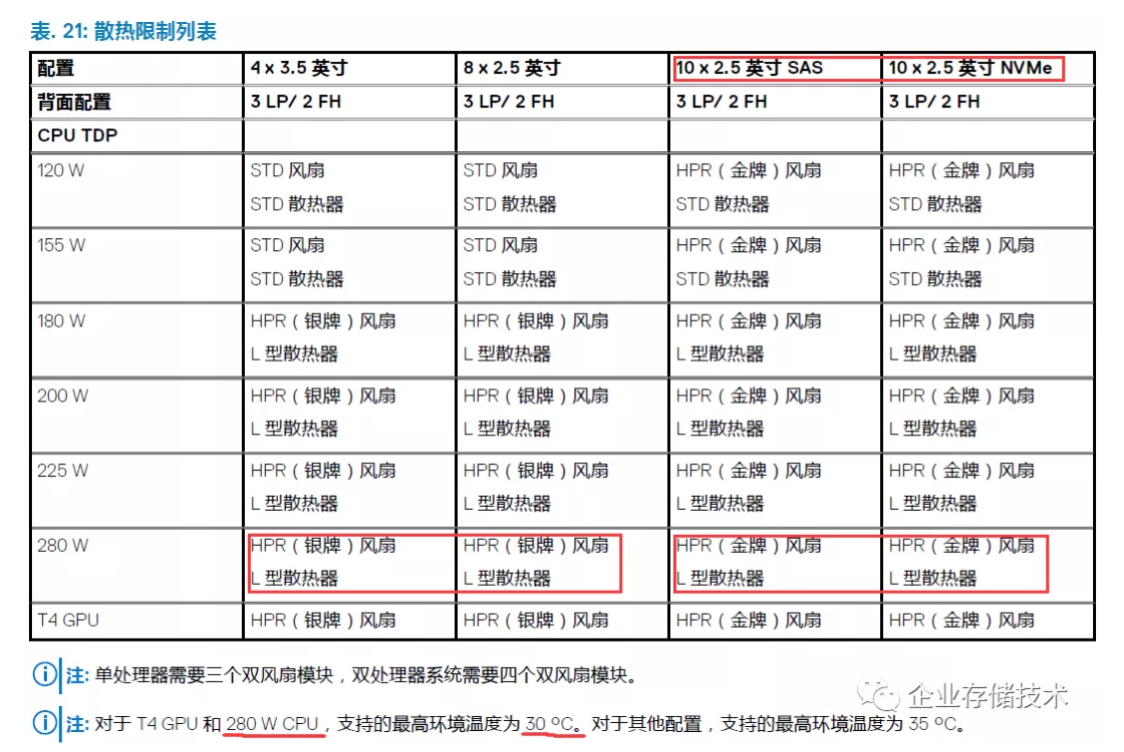

上表引用自_《__Dell EMC PowerEdge R6525__技术规格_》文档,里面很细致的写了限制条件(仅截取部分,背后是大量测试验证和设计工作),我们重点参考下对280WCPU的支持。

当1U服务器支持4个3.5寸/8个2.5寸盘,与10个2.5英寸SAS/NVMe盘时搭配的4056系统风扇要求也不同——后者要最高的“金牌”风扇,可见流阻的影响。

这里还写了R6525 280W CPU支持的最高环境温度为30℃。我粗略按照阿里方升“系统散热能力10%+”来推算,在加上L型与T型CPU散热器的一点差距,感觉支持到320W左右的TDP正常,只是我没找到R6525的系统流量LFM值作为参考。

方升有可能在35℃进风温度下支持350W CPU长期运行吗?阿里的朋友似乎没讲到这一点,不过我还是觉得有点悬,如有知道的朋友可以在下面留言。

这里对比的环境温度为25℃。按照我以往的经验,通用型服务器只有高密度GPU节点、2U 4节点这些才会在有些条件下限制到不高于25℃的进风温度。当然如果数据中心条件可控(特别是自建),服务器啥的都按照25℃来设计也没啥不行的,只是空调的要求——PUE数字可能就不那么好看了。

至于散热能耗降低,我觉得还是因为流阻,DIMM也是同样的道理。其实对于通用1U服务器来说,内存能支持的温度还有一定空间。QSFP网卡模块的温度降低较多——因为从机箱后端移到了前端,只不过QSFP能容忍的温度更高(后面我会列出一张图),降到30多摄氏度的意义大吗?

ODM(英业达)分享:智能网卡,又一个服务器新热源

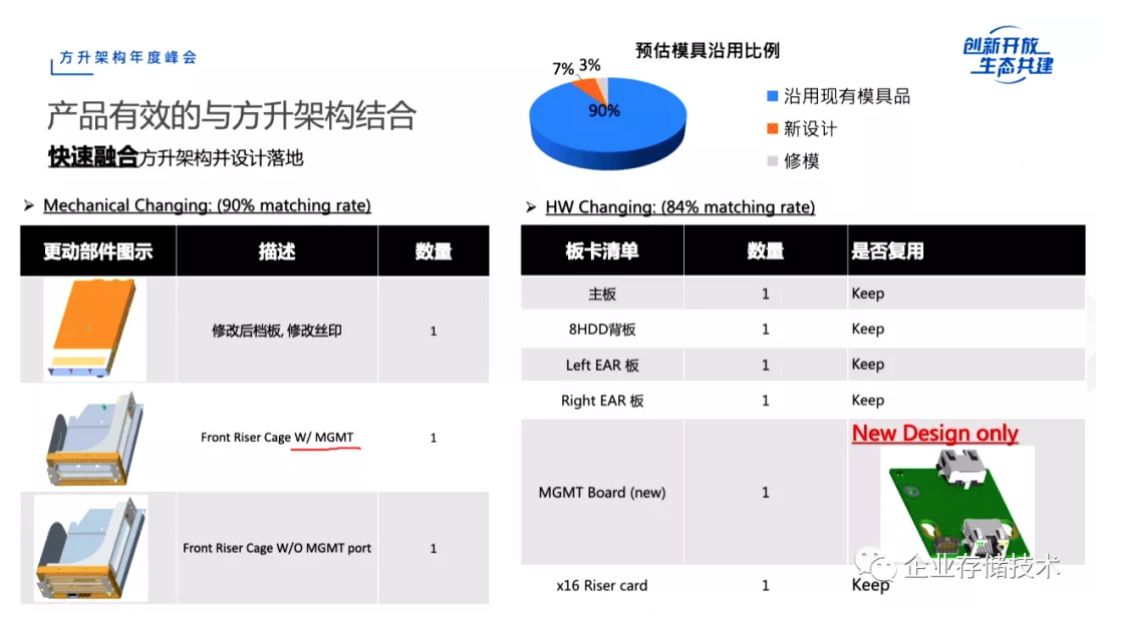

这个和后面几张ppt,来自英业达SDQC技术总监邱国书的分享《英业达Horsea与方升架构结合》。作为参与方升服务器项目的ODM之一,真正设计和制造者讲的往往干货更多些。上面这个机型修改的时间轴线,对从事设计、产品规划相关工作的朋友可能有参考价值。

90%的部件沿用现有模具,包括主板、8HDD背板等;由于管理网口也要改到机箱前端,所以新开了一个MGMT Board。

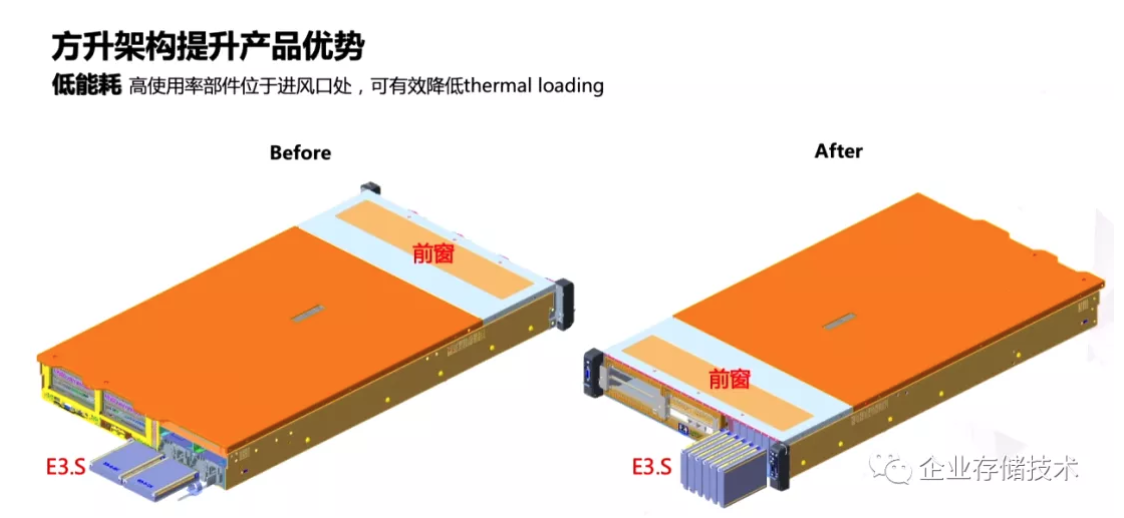

这里的通用2U/方升2U对比很直观吧。在把Front Storage部分改为Front I/O之后,进风的流阻同样降低了。不过我们试想一下,通用2U服务器如果经过一些调整,前面只插8块2.5寸盘的话,是不是流阻和散热情况也能同样改善?

这张图吸引我的一点是:SSD__固态盘用的不是传统U.2__,而是还不太常见的E3.S__。扩展阅读《_EDSFF 3英寸企业级SSD会成为下一代标准吗?_》

一开始我是这样理解的:与其强调把I/O板卡移到前端进风口处,不如说现在SSD单盘性能较高,在计算/存储分离架构下,只要不是大容量存储服务器,8块SSD对于互联网的计算节点多数情况够用了。至于thermal loading,最应该关注的不是CPU、GPU吗?

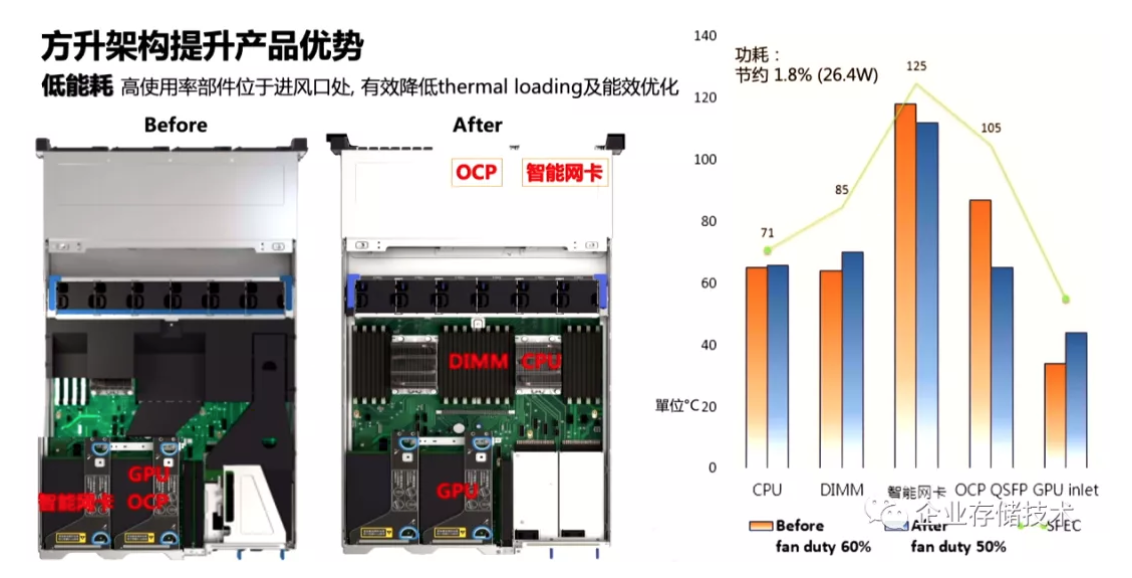

看了这张图,我才发现自己上面的观点不够全面。虽然对于OCP QSFP(网卡部分)的spec温度上限105℃,通用服务器还有不少裕量;但智能网卡(DPU)没这么乐观,我们以阿里神龙服务器的MOC卡为例,使用FPGA的话功耗接近75W或者更高都有可能。如果智能网卡温度已经距离125℃不太远,它需要像GPU那样散热“被照顾”就正常了。

最早这款神龙MOC__卡功耗看上去高一些,现在的应该早就从双宽改单宽卡了。

按照上图中列出的数字,方升2U机型在较低(50%)fan duty cycle的情况下,对QSFP和智能网卡的散热都比通用服务器有改善,但内存和GPU进风温度就不同了。谈到GPU支持,本文里面写的这2款1U/2U方升,又回到和通用服务器差不多同一起跑线,显然这不属于它们擅长的领域(方升还有别的对应机型)。

350W CPU何时出现?方升开源在哪里?

我们知道,AMD EPYC3和Intel IceLake-SP新一代Xeon的TDP还达不到350W,不过看大家这个研究节奏,下一代再堆点核心进去就差不多了?

依照以往的惯例(参见《_2019 OCP Global Summit会议资料下载 -Part 1_》),最后我再吐槽点技术以外的东西:

我记得这次会议提到了方升开源BMC软件,个人觉得与OCP的OpenBMC相比,可能还是后者参考价值更大一些吧。那么硬件方面的设计资料/规范呢?

上图截自opendatacenter开放数据中心委员会网站,COCI那些方升相关的文档仍然需要认证会员才能下载,什么时候能跟人家OCP学学?

表面上看方升的设计创新是由互联网公司主导的,实际上背后往往有着默默无闻的ODM/OEM工程师,乃至于上游(Intel等)的努力。互联网真正让人垂涎的是规模,当每年达到数万台或者更多的服务器采购量,可以做的事情就多一些了。

扩展阅读:《_企业存储技术》文章分类索引(微信公众号专辑)_》

推荐阅读

注:本文只代表作者个人观点,与任何组织机构无关,如有错误和不足之处欢迎在留言中批评指正。 进一步交流技术可以加我的微信/QQ:490834312。

尊重知识,转载时请保留全文,并包括本行及如下二维码。感谢您的阅读和支持!《企业存储技术》微信公众号:HL_Storage,也欢迎关注企业存储技术极术专栏,定期更新。