(作者:曾智强 王海峰)

今年的GTC大会,NVIDIA CEO黄仁勋将会从烤箱里拿出什么?在北京时间4月13日凌晨,NVIDIA给出了答案。

黄仁勋介绍了NVIDIA在AI、汽车、机器人、5G、实时图形、协作和数据中心等领域的最新进展,除了对已有的硬件、解决方案和算法模型进行更新升级之外,还发布了其首个面向数据中心的CPU——NVIDIA Grace处理器,构建AI超级计算机的DGX SuperPOD,以及交互对话式AI框架Jarvis。

Grace:打破内存与GPU瓶颈 性能提升30倍

Grace是NVIDIA自宣布收购ARM以来,发布的首个基于ARM架构、面向数据中心市场的处理器,可以改善CPU与GPU之间的访问带宽,让GPU更好地利用DRAM内存,达到提升整体系统性能的目的。

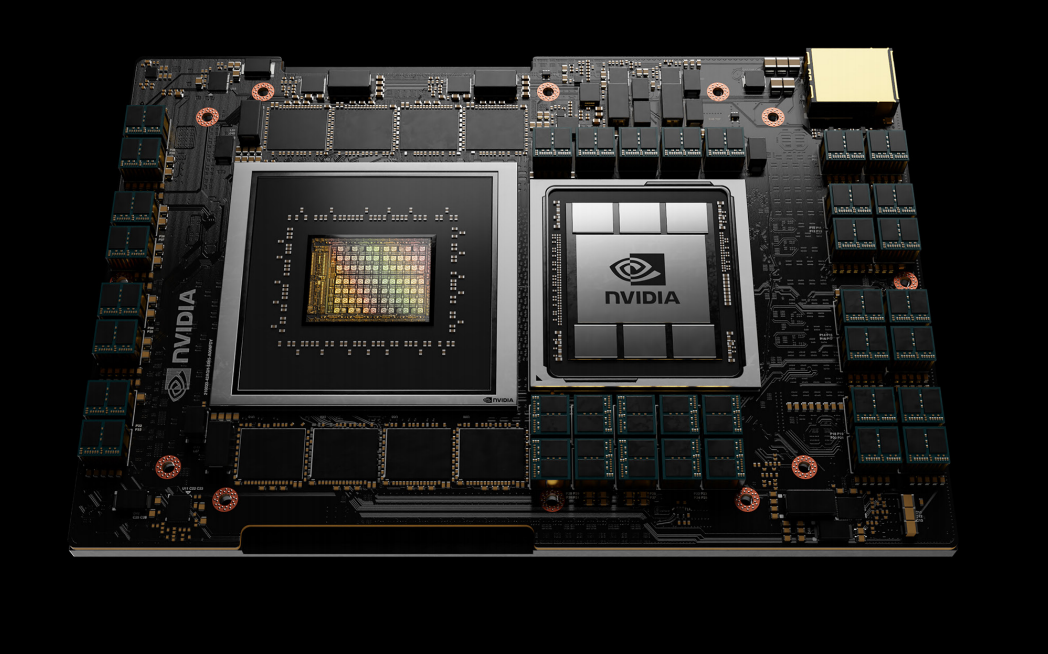

图注:NVIDIA CEO黄仁勋在GTC上展示的面向数据中心市场的NVIDIA Grace处理器(图左)。名称“Grace”用以纪念发明了世界上第一个编译器的Grace Hopper(已故)

NVIDIA Grace处理器的推出是为了解决日益增长的算法模型规模与底层算力发展不匹配的问题。随着算法模型的不断发布,模型参数量越来越大,对AI算力的需求也就愈加旺盛。比如Google在2017年提出的Transformer就包含了6500万个参数,而OpenAI发布的GPT-3模型则达到了1750亿个参数,三年时间参数量增加了3000多倍……这意味着模型规模正在呈指数级增长,几乎每2.5个月就翻一倍。即使摩尔定律(18个月翻一番)还没失效,算力也很难匹配模型的发展。

黄仁勋认为“明年(2022年)就会有数万亿参数的模型,到2023年就会有超过100万亿参数的模型”,他还特别提到“人脑中约有125万亿个突触”,这也许暗示着AI即将超越人类……但要训练拥有上百万亿个参数的模型,这不仅意味着需要更高的性能,同时还需要更大的存储,尤其是类似DRAM的高速存储。

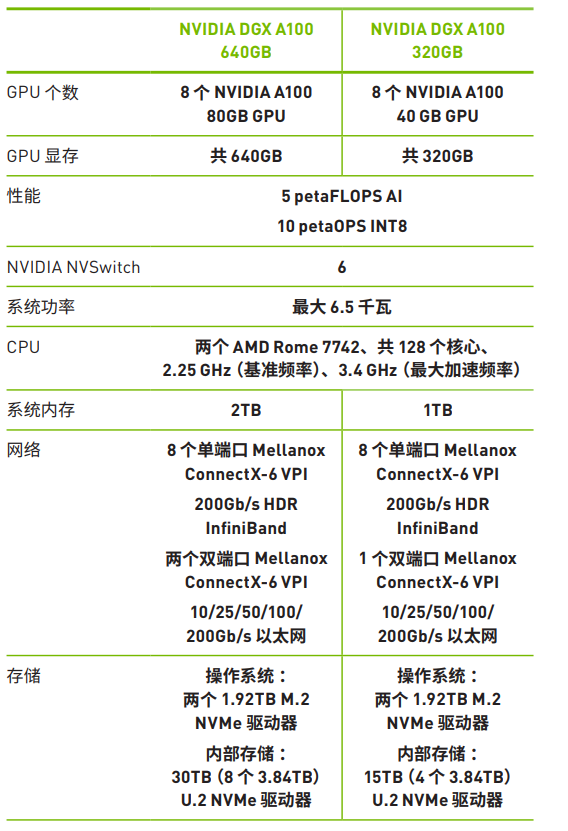

目前NVIDIA A100 Tensor Core GPU产品中显存最大为80GB,多块A100同时使用也仅有数百GB的显存(比如8 GPU配置的DGX A100总计640G显存),而服务器中内存容量最高则可达到数TB。如果能合理利用更大容量的服务器内存,则是另一个提升性能的有效路径。

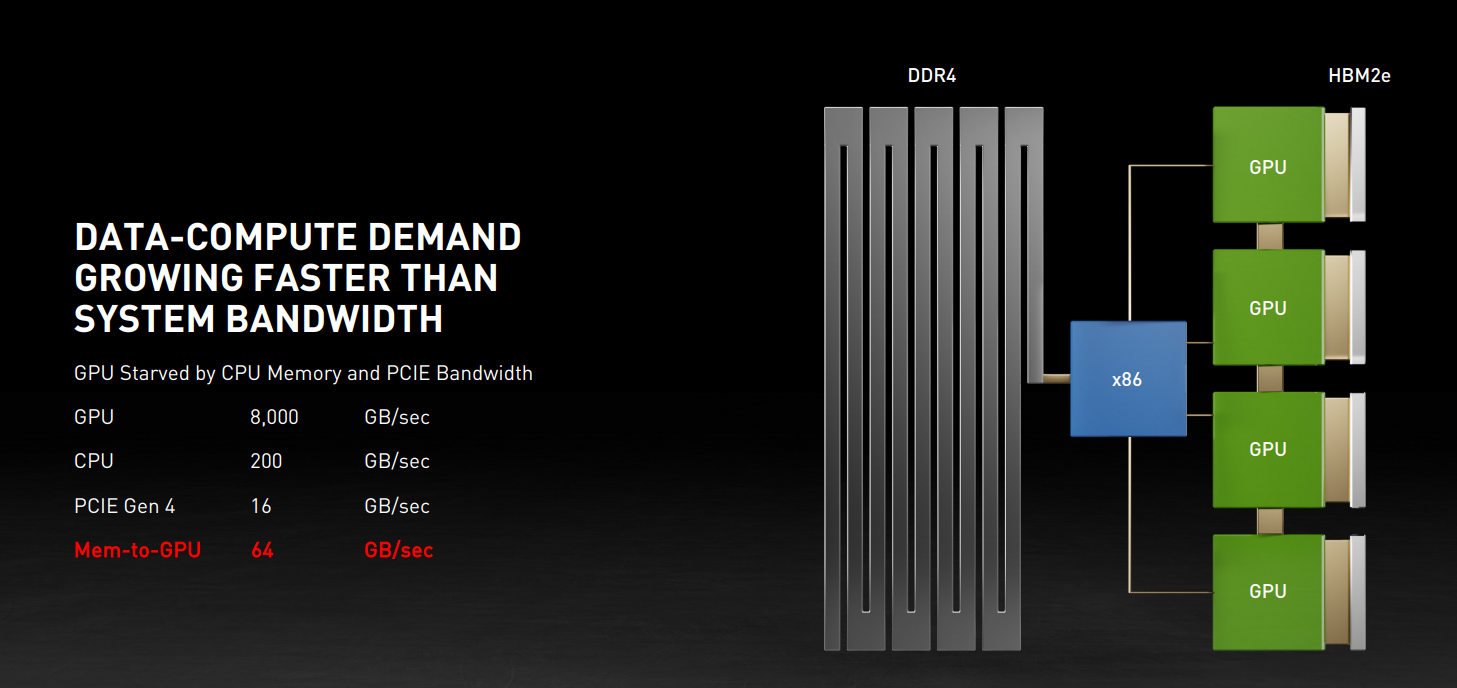

但现在的问题在于,目前服务器中主流使用的是x86处理器,即使DRAM到x86处理器的性能非常高,但GPU到CPU之间的连接使用的是PCIe,哪怕是最新的PCIe 4.0,其带宽也是有限的。尽管NVIDIA在几年前就推出了NVLINK技术来提升带宽,但这一技术很难使用在x86处理器之上。

图注:在目前的AI服务器架构设计中,GPU与显存(上图中的HBM2e)可达到2TB/s的数据传输速度,4 GPU配置总计可达到8TB/s。但GPU与CPU之间哪怕使用PCIe 4.0,4通道PCIe 4.0的理论速度也仅为64GB/s,性能相差两个数量级

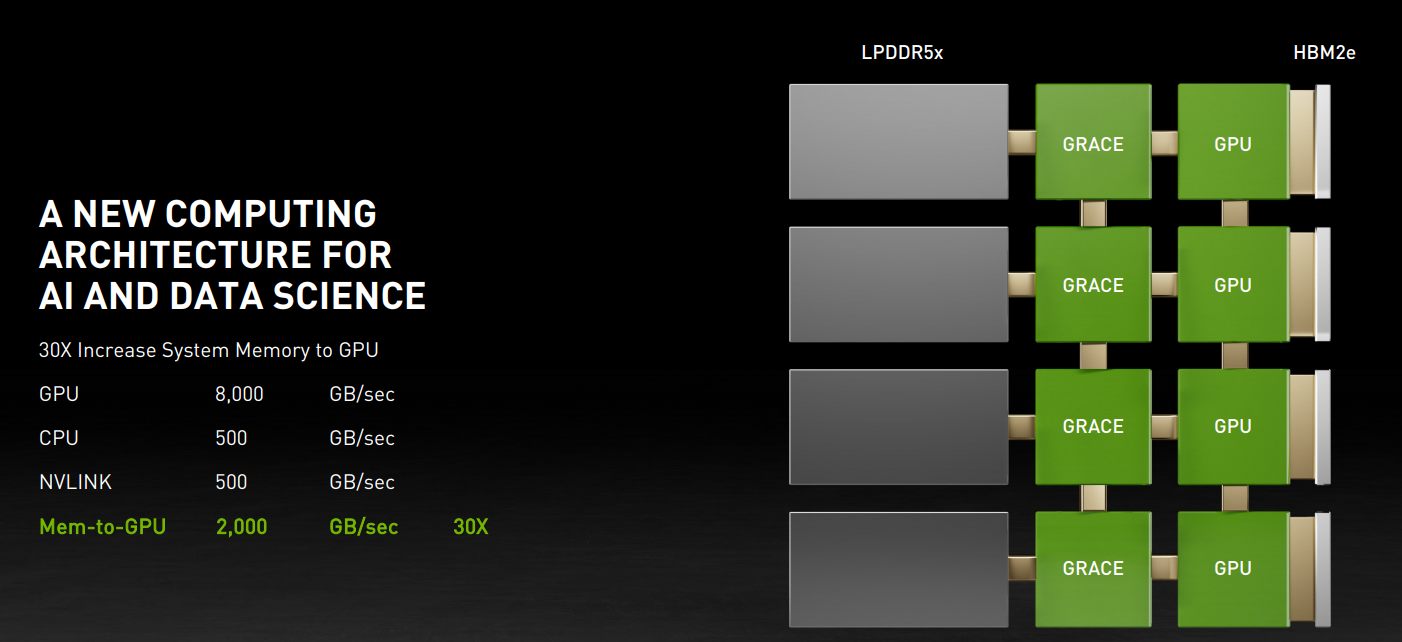

NVIDIA Grace处理器正是为了解决这一瓶颈,其通过支持NVLINK和LPDDR5x内存,为每块GPU与内存之间构建一个高速专用通道,使其数据传输性能提升到500GB/s,这意味着在4块A100 GPU配置的DGX中,GPU与内存之间的数据传输性能达到了2TB/s。同时,据NVIDIA提供的另一组数据显示,采用第四代NVLINK互联技术的Grace处理器与NVIDIA GPU之间实现了900GB/s的连接速度,使总带宽比当今领先的服务器高出30倍。

图注:使用Grace处理器替代x86处理器之后,内存到GPU之间的性能提升可达30倍,达到2TB/s,同时使得整个DGX的性能得到了巨大的提升。据NVIDIA公布的数字显示,单颗Grace处理器的SPECint-rate(SPEC组织推出的一个用于衡量处理器性能的测试项目)的分数达到了300分以上,这意味着8 GPU配置的DGX系统中,CPU的SPECint-rate分数将超过2400分,而当前世界上性能最高的DGX在SPECint-rate方面的分数仅为450,有一个数量级的差距

NVIDIA GPU加速计算与Mellanox高性能网络,再加上专为TB级加速计算而设计的Grace处理器,意味着NVIDIA终于完成了最后一片拼图,从此不再受限于其他供应商技术的瓶颈,能为AI打造出更高性能的解决方案。

据称,瑞士国家超级计算机中心(CSCS)将利用NVIDIA Grace处理器和下一代NVIDIA GPU打造新型的超级计算机(名为Alps),Alps将具有20 Exaflops的AI计算性能,比目前运算速度最快的超级计算机还要快10倍,并计划于2023年上线。

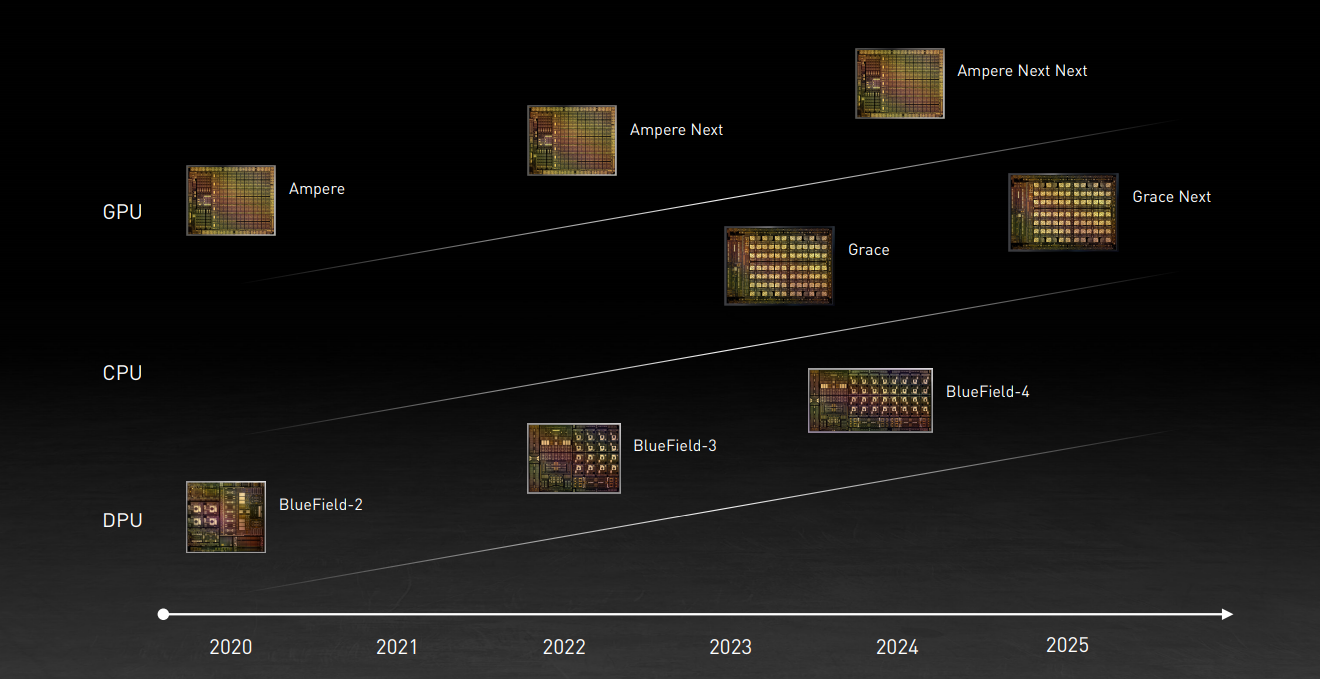

同时,黄仁勋还在GTC上公布了CPU(基于ARM的Grace处理器)、GPU以及DPU( BlueField)三种芯片的的发展路线图:

图注:据黄仁勋介绍,包括GPU、CPU和DPU在内的每种芯片架构都将历经两年的打磨周期:一年专注于x86平台,另一年则专注于ARM平台。这意味着每年都会有新品出现,而NVIDIA架构和平台同时支持x86和ARM,能够满足绝大部分用户的需求

DGX SuperPOD升级:构建云原生AI超级计算机

AI是当今人们对NVIDIA最主流的印象,在一年一度的GTC会上发布新的AI解决方案也就理所当然。在今年的GTC上,NVIDIA CEO黄仁勋发布了新款的DGX SuperPOD——一个高集成的、完全网络优化的“AI数据中心及产品”的一体化系统/解决方案,主要面向密集型AI研究与开发等市场。

NVIDIA DGX SuperPOD系统采用类似模块化的设计理念,其最小模块单元可以理解为NVIDIA DGX A100产品,单台DGX A100采用6U双路服务器设计,配备8张A100 80GB GPU,拥有5 PetaFlops的AI性能。20台这样的DGX A100,再加上NVIDIA InfiniBand HDR网络方案,就形成了DGX SuperPOD系统。

图注:NVIDIA官网公布的DGX A100的两种配置规格,尽管标称的算力指标相同,但配置的存储(比如显存、内存以及内部存储)容量刚好相差一倍,拥有更大的显存以及内存容量的DGX A100在实际AI模型训练中将更加高效。据称,大型训练作业的性能提升将高达三倍,并将MIG实例的大小翻倍,不仅能够处理极为复杂的大型作业,同时也能轻松应对简单、小型的任务

目前在世界Top 500中速度排名第五的超级计算机,也是排名第一的工业超级计算机Selene(NVIDIA打造的新型超级计算机),就相当于4个DGX SuperPOD。一个或多个DGX SuperPOD组合能够帮助用户轻松构建用于AI研究或开发的超级计算机。

新款DGX SuperPOD除了使用新的80G显存容量的A100 GPU之外(共计90TB的HBM2显存,以及2.2EB/s的总带宽),还深度整合了NVIDIA BlueField-2系列DPU,以分流、加速和隔离用户数据的方式,为用户提供与其AI基础设施之间的安全连接,构建适用于云原生、多租户的AI超级计算机。

同时,DGX SuperPOD中还集成了Base Command,这是NVIDIA内部使用的DGX管理和编排工具,可以让多个用户和团队安全地访问、共享和操作DGX SuperPOD基础设施。Base Command负责协调DGX SuperPOD上的AI训练和操作,让分散在世界各地的数据科学家和开发者团队能够顺利地开展工作。

据悉,包括索尼、NAVER(韩国版的Google)、Recursion、MTS(俄罗斯最大电信公司)以及VinAI 都已经开始部署和使用NVIDIA DGX SuperPOD系统。黄仁勋在2021 GTC上透露,DGX SuperPOD的价格从700万美元起步,六千万美元就可扩展至一套完整的系统。

Jarvis:让语言不再是障碍

如果说DGX SuperPOD相当于云计算中的IaaS,那么Jarvis就相当于SaaS。

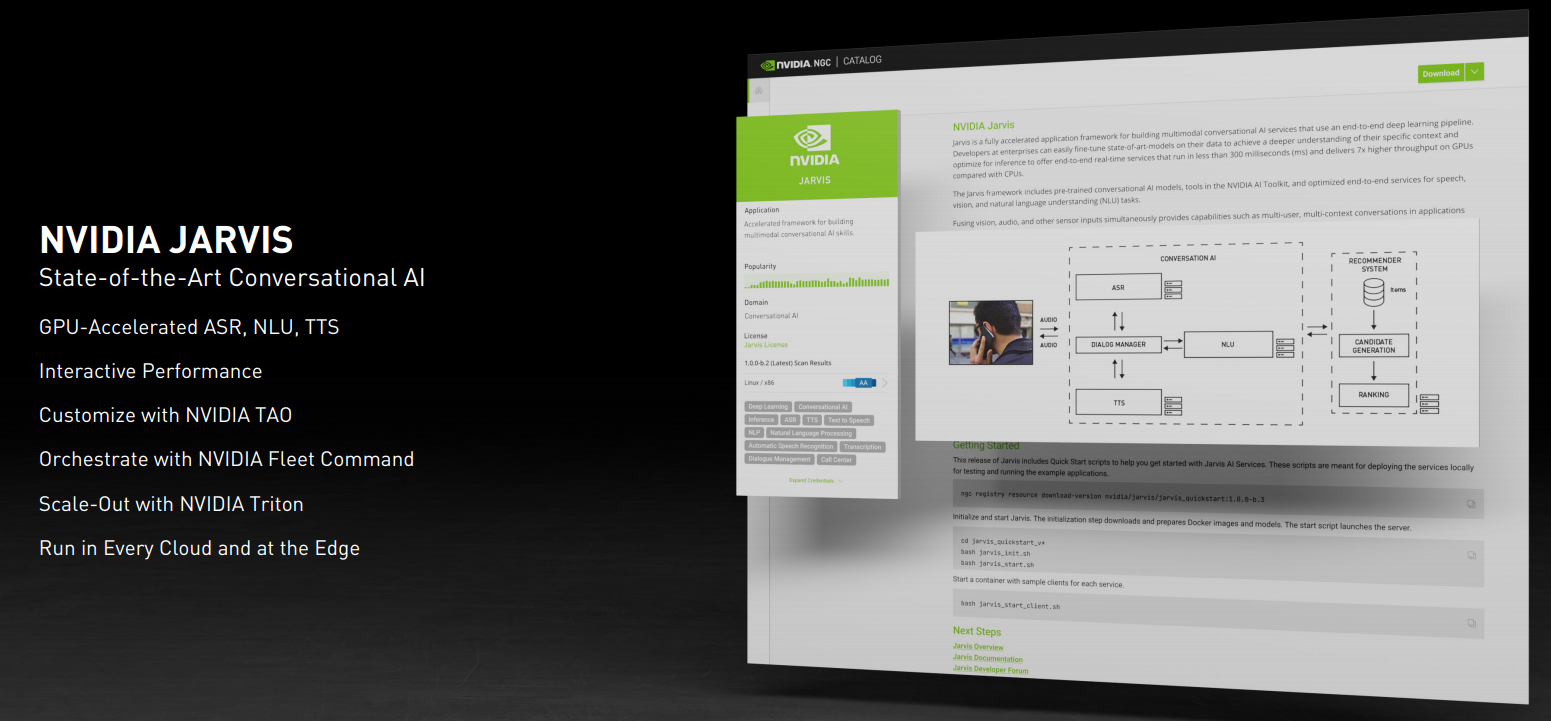

Jarvis是NVIDIA在GTC上发布的一个经过预先训练的深度学习模型和软件工具,可以为最终用户提供交互对话式AI服务。说得通俗一点就是,能够识别语音,并转成文字,然后翻译成其他语言。同时Jarvis也具有语音合成功能,并可按需添加感情色彩,让机器语音不再冰冷。

借助 GPU 加速,端到端的语音流程运行时间之快可达到 100 毫秒内(包括聆听、理解和生成响应过程都在内的速度,比人眨眼的速度还要快),并部署在云端、数据中心或边缘,可立即将规模扩展为数百万用户。

图注:在GTC上,NVIDIA CEO黄仁勋现场展示Jarvis。目前Jarvis支持英语、日语、西班牙语、德语、法语以及俄语等六种语言。据称,在Bilingual Evaluation Understudy基准测试中,Jarvis的英译日得分为40分,英译西得分为50分。根据得分,40分代表高质量、较高水平,而50分则可以视为流畅翻译

Jarvis 使用经过训练的模型构建而成,这些模型在十亿多页的文本、六万小时的语音数据以及不同的语言、口音、环境和术语方面接受了数百万个GPU小时的训练,达到世界一流的准确性。开发者首次可使用 NVIDIA TAO 框架,针对任何任务、任何行业和任何系统,对模型轻松进行训练、适配和优化。

并且,开发者可以从 NVIDIA 的 NGC目录中选择 Jarvis NVIDIA 预训练模型,使用迁移学习工具包,并利用自己的数据对模型进行微调,优化此模型,使其在实时语音服务中实现最大吞吐量和最低延迟,然后只需几行代码即可轻松部署模型,无需深度 AI 专业知识。

自从 Jarvis 于去年 5 月启动早期参与计划以来,已有成千上万家公司要求加入该计划。早期用户包括美国电信巨头 T-Mobile,T-Mobile 希望 AI 能够使用自然语言处理,进一步扩展其机器学习产品,从而提供实时见解和建议。

同时,NVIDIA 还与 Mozilla Common Voice 合作。Mozilla Common Voice 是一个语音数据开源集合,供初创公司、研究人员和开发者调整支持语音的应用程序、服务和设备。Common Voice 是全球最大的多语言公开语音数据集,拥有 60 种不同语言、9000多小时的语音数据。NVIDIA 使用 Jarvis 并利用该语音数据集开发预训练模型,然后将其回馈给社区免费使用。

结语

2021GTC上,NVIDIA展示并发布的多款全新产品中,除了上文提到的基于ARM架构的Grace处理器之外,还包括拥有2207亿晶体管的BlueField-3 DPU,相比于目前的BlueField-2,3将实现10倍的计算性能提升;另外,还有用于自动驾驶的NVIDIA DRIVE Atlan片上系统。

在解决方案层面,在升级了DGX SuperPOD和便携式AI数据中心DGX Station以外,还推出了整合5G+AI的Aerial A100边缘计算平台。

在AI应用层面,NVIDIA升级发布了多个面向不同科学领域的数据库,同时也面向开发者升级或推出了多个模型工具;并与全球各行业的大型公司进行合作,让AI应用在各行业全面开花。

从最底层的Grace处理器,到DGX SuperPOD超算模块,再到Jarvis交互对话式框架,NVIDIA构建的AI帝国版图正在浮出水面,值得期待。