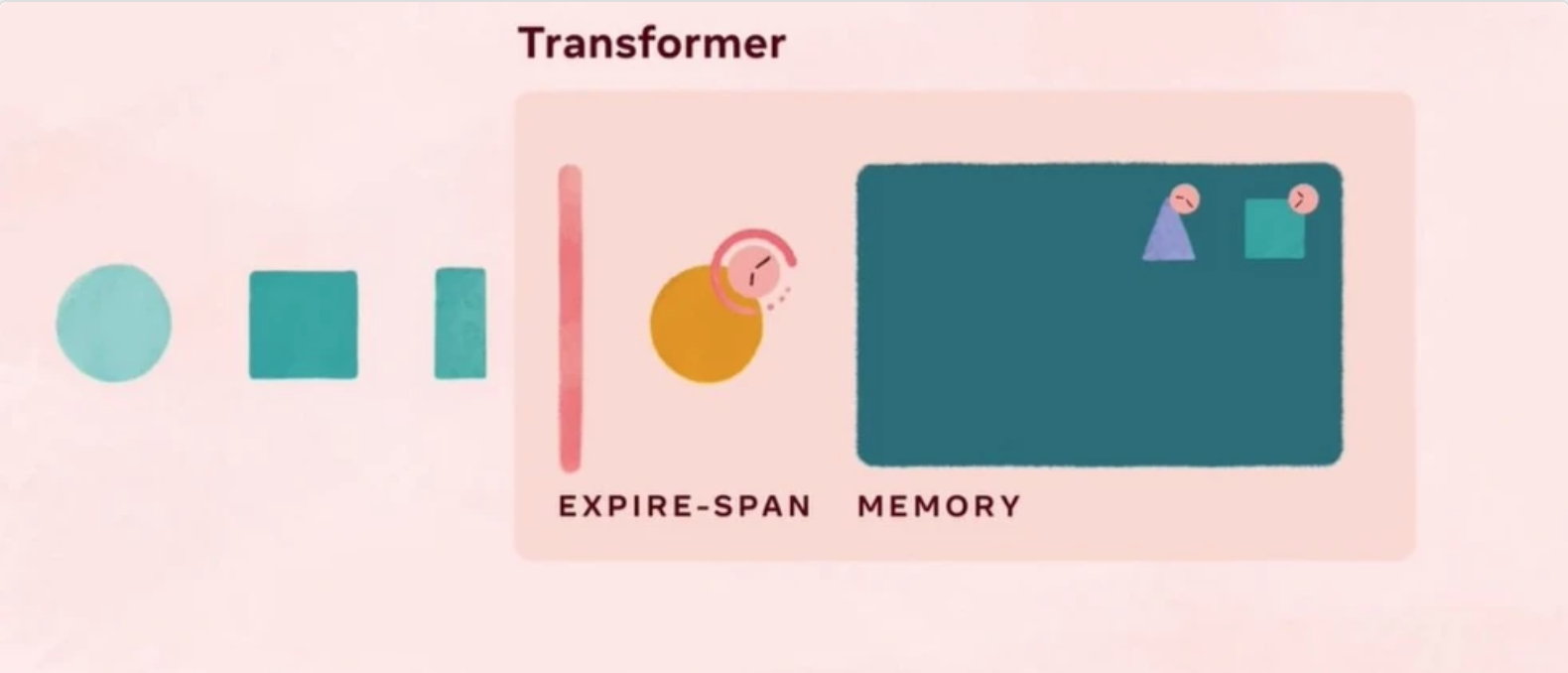

Facebook AI Research(FAIR)开源了 Expire-Span,这是一种深度学习技术,可以学习输入序列中哪些项目应该被记住,从而降低 AI 的内存和计算要求。FAIR 表明,纳入 Expire-Span 的 Transformer 模型可以扩展到数万个项目的序列,与以前的模型相比,性能有所提高。

该研究小组在即将举行的国际机器学习会议(ICML)上发表的一篇论文中描述了该技术和几个实验。Expire-Span 允许顺序人工智能模型 "忘记 "那些不再相关的事件。当纳入自我关注模型,如 Transformer,Expire-Span 减少了所需的内存量,使模型能够处理更长的序列,这是提高许多任务性能的关键,如自然语言处理(NLP)。使用 Expire-Span,该团队训练的模型可以处理高达 128k 的序列,比以前的模型多了一个数量级,与基线相比,准确性和效率都有所提高。研究科学家和论文合著者 Angela Fan 和 Sainbayar Sukhbaatar 在 FAIR 的博客上写道。

Facebook 表示:作为我们研究更像人类的人工智能系统的下一步,我们正在研究如何将不同类型的记忆融入神经网络。因此,从长远来看,我们可以使人工智能更接近人类的记忆,具有比当前系统更快的学习能力。我们相信 Expire-Span 是一个重要的、令人兴奋的进步,朝着这种未来的人工智能驱动的创新迈进。

为了评估 Expire-Span 的性能,该团队选择了三种基线 Transformer 模型--Transformer-XL、Compressive Transformer 和 Adaptive-Span--并比较了模型的准确性以及 GPU 内存和训练速度。这些模型被用于几个强化学习(RL)和 NLP 任务。Expire-Span 在大多数实验中的表现优于基线;例如,在序列复制任务中,Expire-Span 扩展到 128k 的序列长度,达到 52.1%的准确率,而 Transform-XL 在 2k 的序列长度上只有 26.7%的准确率。

Expire-Span 项目 GitHub 地址:https://github.com/facebookre...

扩展阅读:

程序员面临 35 岁危机?网友:我 70 了,依然在写程序