本教程详细介绍了在全志 R329 板子上跑 mobilenetv2 的流程,能达到 20 fps。

关于周易 AIPU 的模型的交叉编译方法可以参考《【嵌入式AI】周易 AIPU 算法部署仿真测试》、全志 R329 板子镜像烧录方法可以参考《【嵌入式AI】全志 R329 开箱与开发环境搭建》,这篇就默认板子已经配置好了 runtime 环境。

1、opencv 交叉编译

R329 是 aarch64 的,所以用到的 opencv 也需要交叉编译,opencv aarch64 的交叉编译方法可以参考我的这篇 《【经验分享】华为atlas500系列aarch64交叉编译opencv》。完了把头和库拷到板子上,板子上的文件传输可以采用 scp,scp 的使用方法类似这样:

# 板子上执行

# 从服务器拷贝文件到板子

scp username@ip:/path/to/your/file /path/to/your/R329

# 从服务器拷贝文件夹到板子上

scp -r username@ip:/path/to/your/dir /path/to/your/R3292、板子跑 opencv 抓图

写这个模块,主要目的是用简单的 opencv 工程验证下板子的摄像头是否正常。

2.1 工程目录结构

搭建cmake工程,结构如下:

├── build

├── CMakeLists.txt

├── main.cpp

└── toolchains

└── aarch64-linux-gnu.toolchain.cmake2.2 CMakeLists.txt

cmake_minimum_required(VERSION 3.10.2)

project(OpencvTest)

set(OpenCV_DIR /your/opencv/path)

find_package(OpenCV REQUIRED)

include_directories(${OpenCV_INCLUDE_DIRS})

macro(add_example name)

add_executable(${name} ${name}.cpp)

target_link_libraries(${name} ${OpenCV_LIBS})

endmacro()

add_example(main)2.3 main.cpp

#include "opencv2/opencv.hpp"

#include <iostream>

int main(void){

cv::Mat frame;

cv::VideoCapture cap;

cap.open("/dev/video0");

if (!cap.isOpened())

{

fprintf(stderr, "Failed to open");

return -1;

}

cap >> frame;

cv::imwrite("test.png", frame);

return 0;

}2.4 aarch64-linux-gnu.toolchain.cmake

set(CMAKE_SYSTEM_NAME Linux)

set(CMAKE_SYSTEM_PROCESSOR aarch64)

set(CMAKE_C_COMPILER "aarch64-linux-gnu-gcc")

set(CMAKE_CXX_COMPILER "aarch64-linux-gnu-g++")

set(CMAKE_FIND_ROOT_PATH_MODE_PROGRAM NEVER)

set(CMAKE_FIND_ROOT_PATH_MODE_LIBRARY ONLY)

set(CMAKE_FIND_ROOT_PATH_MODE_INCLUDE ONLY)

set(CMAKE_C_FLAGS "-march=armv8-a")

set(CMAKE_CXX_FLAGS "-march=armv8-a")

# cache flags

set(CMAKE_C_FLAGS "${CMAKE_C_FLAGS}" CACHE STRING "c flags")

set(CMAKE_CXX_FLAGS "${CMAKE_CXX_FLAGS}" CACHE STRING "c++ flags")2.5 编译

mkdir build

cd build

cmake -DCMAKE_TOOLCHAIN_FILE=../toochains/aarch64-linux-gnu.toolchain.cmake -DCMAKE_PREFIX_PATH=/your/opencv/lib ..

make完了把编译生成的可执行程序用 scp 拷贝到 板子上

在开发板上运行程序:

cd root

# 执行 ./main正常会生成一张 test.png 的图片,这是你板子摄像头现拍的图像。

3、板子跑 mobilenetv2 检测

3.1 转换 mobilenetv2 模型

此步骤是为了将深度学习训练框架(前端)产生的模型(支持 tensorflow pb、tflite、caffemodel、onnx),选择还是挺多的,我这里用的是 tflite 来转换板子可支持运行的模型格式。

转换方法还是可参考这篇 《【嵌入式AI】周易 AIPU 算法部署仿真测试》,这篇里写的前端是来自 tensorflow 的,相比 from_tensorflow,from_tflite 的过程少了模型 export 和 freeze 的过程,所以相对简单一些。

模型转换的关键是 model_build.cfg 配置文件,这里给出 modilenetv2 的 mobilenetv2_build.config。

[Common]

mode = build

[Parser]

model_type = tflite

model_name = mobilenet_v2

detection_postprocess =

model_domain = image_classification

input_model = ./model/model.tflite

input = input

input_shape = [1, 224, 224, 3]

output = MobilenetV2/Predictions/Softmax

output_dir = ./

[AutoQuantizationTool]

quantize_method = SYMMETRIC

quant_precision = int8

ops_per_channel = DepthwiseConv

reverse_rgb = False

label_id_offset =

dataset_name =

detection_postprocess =

anchor_generator =

log = False

calibration_data = ./dataset/dataset.npy

calibration_label = ./dataset/label.npy

[GBuilder]

outputs = aipu.bin

target = Z1_0701然后执行:

aipubuild config/mobilenetv2_build.config正常情况会生成 aipu.bin 模型文件,这个文件是后面板子上执行的时候调用的。多说一句,个人理解这个 aipu.bin 里面应该是记录了模型的推理执行 flow,就像 tensorrt 的 engine 一样,不知道理解是否有问题。

3.2 zhouyi_cam 交叉编译

交叉编译 zhouyi_cam,工程代码在这里 ,工具链在这里,提取码都是:6666。

把 工程 和 工具链 下载下来后,交叉编译很简单。

需要改 CMakeList.txt 里的几个地方:

set(CMAKE_COMPILER "/path/to/your/toolchain/bin/aarch64-openwrt-linux-gcc")

set(CMAKE_CXX_COMPILER "/path/to/your/toolchain/bin/aarch64-openwrt-linux-g++")

set(ROOTS_root /path/to/your/rootfs)开始编译吧

cd zhouyi_cam

mkdir build

cd build

cmake ..

make大功告成后会生成 zhouyi_demo,将其和 3.1 生成的 aipu.bin 拷贝到板子上。

3.3 mobilenetv2 跑起来

目光转到板子上。

cd /root/maix_sense

insmod aipu.ko

## 让我们跑起来吧

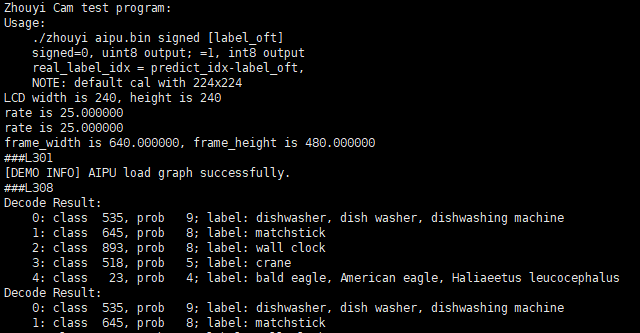

./zhouyi_demo ./aipu.bin 1 看看效果~ 能看清吗,差不多可以跑 20 帧,接近实时了~

收工了~