Rethinking and Improving the Robustness of Image Style Transfer

图像风格化鲁棒性的再思考和提升

Paper Link:https://arxiv.org/pdf/2104.05623.pdf

Paper Author: Pei Wang;Yijun Li;Nuno Vasconcelos

知乎/github:Owen718

总结写在前面

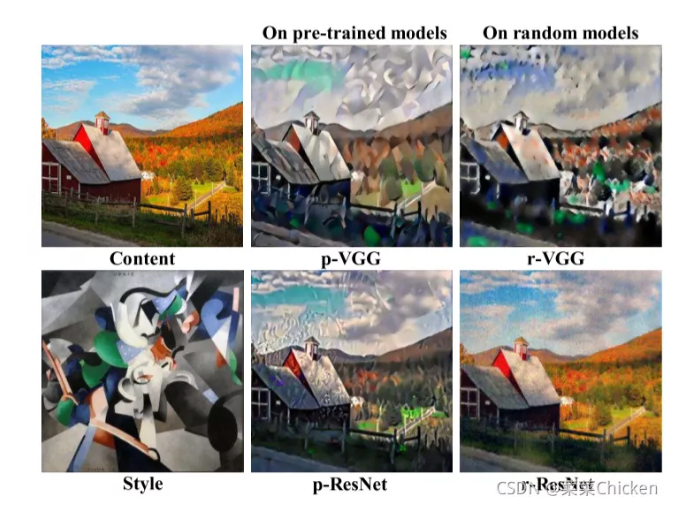

我们知道风格迁移模型中常用预训练VGG模型作为风格迁移损失的提取器,不知道大家有没有想过为什么是VGG?VGG已经很“老”了,和今天大量的新backbone,如我们常用的ResNet相比,VGG实在不算出众。但大量的实验证明,VGG在风格迁移任务上表现的非常出色,并且,随机权重的VGG,也可以有着不错的迁移效果。关于随机权重VGG应用于风格迁移任务,已经有人研究过了。我们反观更热门的ResNet,其效果对比图如下图所示(表示预训练,表示随机权重),ResNet的效果非常的差。

风格迁移效果对比图,图片来自论文

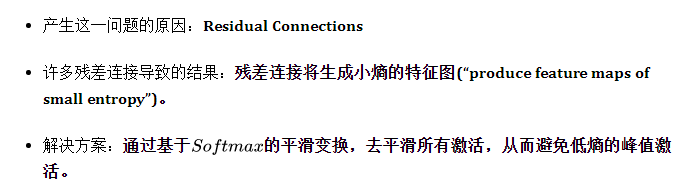

知乎上也有曾探讨这个问题的帖子,但并没有提到问题的本质,大多是猜测和推理。这篇CVPR21 Oral的论文则深入探究了这一问题,并给出了问题的答案和一个简单而有效的解决方案:

以下具体解读论文的重点部分内容。

为什么残差连接反而引起了迁移任务上性能的退化?

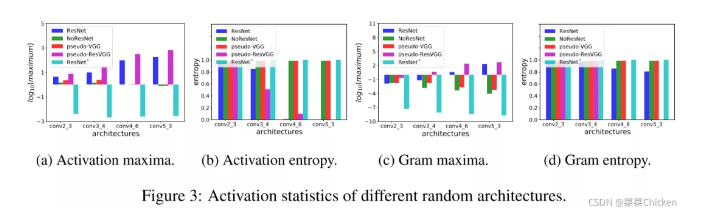

统计对比实验的结果图,图片来自论文

- Peaky maximum:图(a)中可以看到,图中带残差连接的模型,随着网络层数的加深,maximum值也在不断加大,而反观不带残差的普通VGG等,其值不断减小。

- Small entropy:图(b)中可以看到,不使用SWAG的话,带残差的模型,随着网络层数的加深,熵值急剧减小。

- 对Gram maxima和Gram entropy而言,也有类似的结论。可参考图c和d。针对这一现象,作者给出了两种可能的解释。

两种可能的解释

L2 loss的离群值敏感性

知识蒸馏角度理解——成对的高熵更易学习

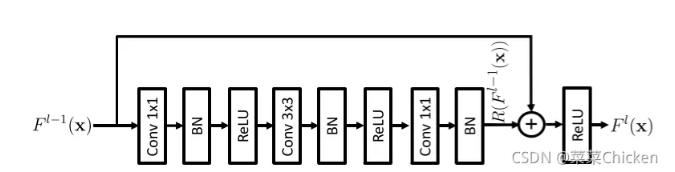

那么,为什么残差连接会导致 Peaky maximum?

让我们看一下paper中给出的结构图:

带残差的结构示意图,图片来自原论文

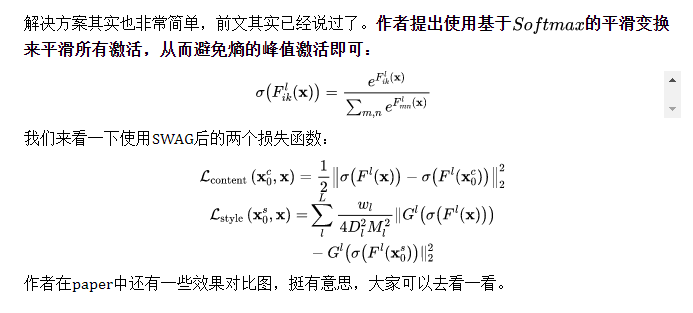

Stylization With Activation smoothinG(SWAG)

总结

这篇Paper其实挺好理解的,给出的解决方案也非常简单,但作者对于实验现象的逐步归纳和分析与扎实的领域功底,非常值得学习,也消除了我之前的一些困惑。

原文:GiantPandaCV

作者:Owen

推荐阅读