如果让你穿越成为一名诗人,你会选择谁?

喜欢豪迈的可能会选择辛弃疾、喜欢婉约的没准会选择秦观,但在众多著名诗人中,李白可能是呼声最高的,毕竟无论是名气、才气还是仙气来说,李白都是首屈一指。不过也正因为“诗仙”的级别太高,千百年来我们都是高山仰止,可望而不可及。如果给你一个能够成为“诗仙”的机会,你心动不心动?

没错,今天它来了——在10月26日举办的2021人工智能计算大会(AICC 2021)上,浪潮信息宣布对全球最大中文AI巨量模型“源1.0”进行开放开源,这样每个人都有机会成为自己心目中的那个“李白”。

**神奇的AI诗词背后,是巨量模型在加持

**

“自然语言处理”这个问题一直是人工智能领域的热门,而这次开源的全球最大中文AI巨量模型“源1.0”也正是基于此。说到这里,可能不少人都会想起IBM曾经的Waston智能计算机,早在10年前的2011年,Waston就在一档名为《危险边缘》(Jeopardy)的答题比赛中击败人类获得了冠军;随后在2018年,IBM Project Debater计算机更是对垒人类冠军Noa Ovadia和辩论专家Dan Zafri,并取得了一胜一败的成绩,双方打成平手。

但这毕竟是外语,准确的说是英语。许多人都说汉语博大精深,的确在表意能力上含义更丰富一些,特别是谈到古诗、对联等韵律形式的时候,对于汉语的运用要更高一些。因此汉语的“自然语言处理”应用起来也更为复杂,也就需要更庞大的数据库支持智能训练。

这也正是全球最大中文AI巨量模型“源1.0”的价值所在。“为了训练源1.0,我们研发了容量为5TB的、业界最大规模的中文高质量数据集。为了这个数据级的获取,我们清洗了接近860TB的互联网数据,也经过一系列的粗滤、精滤,专家评审等过程”,在谈到为“源1.0”模型进行数据准备的时候,浪潮人工智能研究院首席研究员吴韶华感慨万千。

当然海量数据只是“源1.0”实现的必要条件之一,结合这些数据浪潮信息还需要基于强大的AI平台进行计算。为此,“源1.0”大模型总共用了2457亿的参数,使用了具备2128块GPU的高性能算力集群,计算量达到了4095 PD(PetaFlop/s-day)的规模,实现了业界最高。在大会现场,香港中文大学(深圳)校长讲座教授黄恺也将“源1.0”与业界著名的英文语言模型GPT-3进行对比,并给出了自己的判断。

在他看来,作为后起之秀的“源1.0”无论在参数量还是在性能、无论在覆盖范围还是应用生态上都要高于后者——“源1.0”的参数量比GPT-3多出40%,语料库总体积达到 5TB,是GPT-3 的近10倍;浪潮信息推出了深度学习并行计算框架Caffe-MPI、TensorFlow-Opt等多种应用,针对大型服务器进行优化,减少多GPU场景下性能损失。

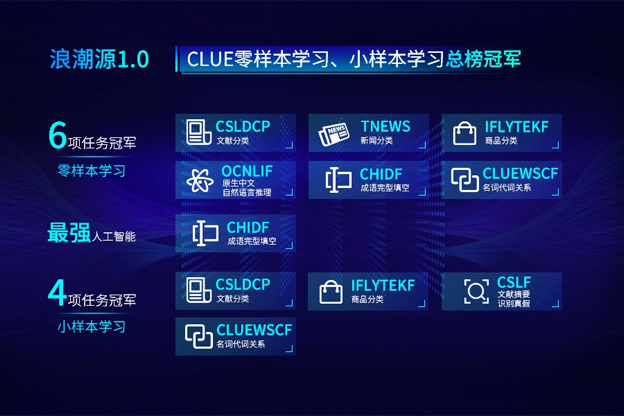

正如我们在使用翻译软件的时候需要考虑准确度一样,在“自然语言处理”中精度也是大家关注的焦点。据悉,“源1.0”实现了中文权威的自然语言处理任务CLUE零样本学习和小样本学习的榜单上分别排名第一。在零样本学习榜单中,“源1.0”超越业界最佳成绩18.3%,在文献分类、新闻分类,商品分类、原生中文推理、成语阅读理解填空、名词代词关系6项任务中获得冠军;在小样本学习的文献分类、商品分类、文献摘要识别、名词代词关系等4项任务获得冠军。在成语阅读理解填空项目中,源1.0的表现已超越人类得分。

“比人类的表现更好”,这对于人工智能来说已经是非常积极的评价了,上一次获得这个公开评价的还是在围棋界大杀四方的谷歌AlphaGo。很显然,对于“吟诗作赋”、“奋笔疾书”这类文字工作来说,“源1.0”也同样具备类似的地位和能力,也成为了文化领域的“AlphaGo”。

水到渠成,以“智算”迎接行业发展挑战

相对于获得多项应用的“第一”,“源1.0”的价值还在于其象征意义。

对于“源1.0”的拥有者浪潮信息来说,以往许多人提到这个名字的第一印象就是计算力的提供者,这种印象也得益于浪潮信息多年来获得的种种成就,比如蝉联中国服务器市场占有率第一名,比如提出了“计算力就是生产力”的行业论断。正因为如此,大众对于浪潮信息的定义更多是一家“偏硬”的厂商,这也就让“源1.0”的开源变得让人出乎意料,也让我对未来浪潮信息的发展方向产生了好奇。

“源1.0”的开源是否意味着软件及应用在浪潮信息的比重会增加呢?对此,浪潮信息副总裁、浪潮信息AI&HPC产品线总经理刘军从两个方面给出了回答。“为什么是浪潮做,为什么浪潮能做好,为什么浪潮会选择来做这个?因为浪潮已经站在了这个制高点,从产业发展的策略以及我们自身竞争优势和能力储备来说,浪潮信息已经实现了对于算力、算法、数据三驾马车协同的创新,也有更多的产业的用户、研究者与合作伙伴,大家可以携手进行巨量模型的开发,使得人工智能产业更加迅速、更加健康的发展”。

这是一个水到渠成的过程。在中国市场,浪潮信息是最早在AI领域进行重度投入的企业,也是AI服务器出货量的第一名。而正如刘军所说,浪潮信息看到了算力、算法的价值,也通过技术研发与生态建设打造了属于自己的AI生态圈。这次“源1.0”的开源同样可以视为是对生态系统的新一轮建设,可以让更多的开发者与用户加入到“源1.0”社区当中,而这也正是刘军口中说的“责任感与使命感”。

或许这也是AI领域的“时势造英雄”。说到时势,如今的AI发展已经不再是只考虑硬件研发的初级阶段,伴随着开发者队伍的壮大,如何为开发者提供有价值的、有发挥空间的平台,如何在双方的互动中实现良性增长,这也是众多AI公司都在考虑的问题。

行业变革在即,计算系统创新刻不容缓

如果你参加的行业会议足够多,那么你可能在多种场合都听到过“摩尔定律终结”之类的论调。尽管连当年提出这一观点的摩尔本人都认为“摩尔定律”不应该有这么长的生命力,但至少在目前看来整个行业的确已经不再像当初预想的那样发展,因为人工智能带来了“多元化、巨量化、生态化”的三大趋势,这也将开创未来行业发展的新格局。

多元化表现得最为明显。如果倒数5年,整个算力中心市场还都是在x86架构统治下,我们还在考虑如何让CPU和GPU协同发挥最大的效能。但是伴随着多元算力的发展,如今包括x86、ARM、RISC-V、FPGA、GPU等一众算力都可以承担AI计算的重任,比如最近热门的苹果笔记本就是ARM应用的最佳体现。

而为了应对多元化算力的挑战,浪潮信息不仅要解决x86架构的应用问题,更需要为AI服务器进行稳定性、可靠性等应用的全面适配,还要保障算法框架与应用优化、大规模算力部署时的能效控制等多种问题。尤其是对于AI专用芯片的出现也让原有的算力架构进行了转变。

“我们能造出性能强大的火箭发动机,但要想造出安全、高性能的运载火箭,还要在循环、控制、结构等很多领域做大量的工作。芯片到计算系统同样如此,需要完成体系结构、信号完整性、散热、可靠性等大量系统性设计工作。”中国工程院院士、浪潮首席科学家王恩东给出了生动的比喻。

巨量化同样是未来行业的一大特性,这也是由人工智能数据应用的特性来决定的。正如我们刚刚谈到的全球最大中文AI巨量模型“源1.0”那样,出色的人工智能应用必然需要海量的数据进行训练,就比如在如今的互联网平台每天都承载着数万亿次的调用量,数百万小时的语音识别,超过百亿张图像识别,超过万亿句自然语言理解等等。如此巨量的算力调用对算力中心的应用支撑能力带来了极大的挑战,也需要算力提供商与时俱进的提供解决方案。

生态离散化则是AI应用的第三个重点,如果从最终效果来考量,它也是决定企业AI战略成败的关键。目前,AI芯片架构五花八门,指令集不同,无法兼容,而面向芯片的编程库又跟芯片绑定,灵活性差;小公司只做了其中一个环节,这造成生态的纵向不通;大公司希望构建封闭的系统,这造成了生态的横向不通……因此对于产业来说,生态离散化已成为制约人工智能技术上水平、应用上规模、产业上台阶的瓶颈所在。

当然对于这些问题,王恩东院士也给出了专业性的建议,他表示一方面要“重视智算系统的创新,加大人工智能新型基础设施建设,把从技术到应用的链条设计好,从体系结构、芯片设计、系统设计、系统软件、开发环境等各个领域形成既分工明确又协同创新的局面”,而另一方面则是要“开放标准建设,通过统一的、规范的标准,将多元化算力转变为可调度的资源,让算力好用、易用。”

应该说,“源1.0”的开源已经为浪潮信息乃至整个AI产业的生态应用开了一个好头,我们也有了属于中国人自己的、最大的巨量模型。未来在“多元化、巨量化、生态化”的态势下,AI产业需要的也是越来越多的相关模型,通过前沿的AI芯片创新技术分享,推动开放合作、共享共赢的产业AI应用落地,推动整个社会AI应用的普惠化和全覆盖。

那些曾经只能在影视作品中看到的AI场景,应该不会太远了吧。