在国际神经信息处理系统大会 NeurIPS 2021( Conference and Workshop on Neural Information Processing Systems )公布的最终接收论文决定中,旷视研究院共有 5 篇论文(含 1 篇 Spotlight)被成功收录。

作为机器学习领域顶级会议之一的 NeurIPS,是一个关于机器学习和计算神经科学的国际会议,主题包括深度学习、计算机视觉、大规模机器学习、学习理论、优化、稀疏理论等众多细分领域。在中国计算机学会的国际学术会议排名中,NeurIPS 也同样作为人工智能领域的A类会议 ,每次都会吸引众多 AI 研究人员参会。

今年 NeurIPS 收到有效论文投稿 9122 篇,接收率为 26%,只有 3% 论文被接收为 Spotlight。

下面是旷视入选论文的亮点解读,Enjoy~

1. 论文题目:Spatial Ensemble: a Novel Model Smoothing Mechanism for Student-Teacher Framework

中文题目:Spatial Ensemble:一种新颖的用于学生-老师框架的模型平滑机制

论文链接:https://arxiv.org/abs/2110.01253

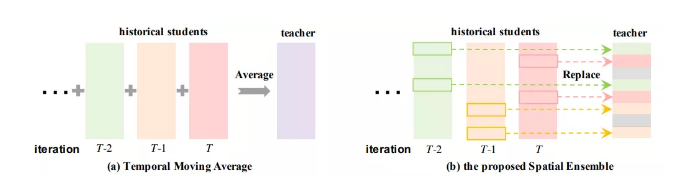

模型平滑技术广泛应用于基于学生-老师框架的自监督和半监督框架中。时序平滑是当前主流的模型平滑技术,其通过加权平均的方式不断用最新的学生网络的参数来更新老师网络的参数。

本文中我们提出了一种新颖的空间平滑技术 Spatial Ensemble,其随机地从学生网络挑选一部分子结构来直接替换老师网络中对应子结构的参数。以这种方式,老师网络”缝合“了历史学生模型的不同子结构,形成”空间集成“效应。

实验表明,Spatial Ensemble 能够取得与时序平滑技术相似的平滑效应。且两者具有良好的互补性,其联合形式”时空平滑“在自监督和半监督任务上带来了一致的性能提升。

所属领域:自监督/半监督学习

关键词:SSL(自监督/self supervised learning), 模型平滑(model smoothing), Spatial emsemble, student-teacher framework

2. 论文题目:SOLQ: Segmenting Objects by Learning Queries

中文题目:SOLQ:基于学习查询的物体分割

论文链接:https://arxiv.org/abs/2106.02351

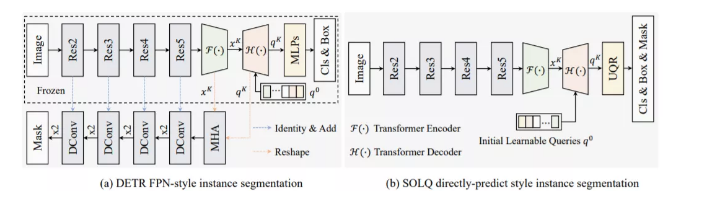

DETR 通过引入 Transformer 和匈牙利匹配,实现了端到端的目标检测。然而,将其拓展至实例分割任务时,会引入过大的计算量,导致无法进行端到端训练,且性能无法满足真实需求。

为解决这一问题,我们结合 DETR 和压缩编码技术,提出端到端的实例分割框架 SOLQ。SOLQ 提出统一的查询(query)表征方式,使用压缩编码方法如DCT等,将二维高分辨率掩码压缩为低维向量,使得三项子任务(分类、定位和分割)能够并行预测。

实验结果表明,SOLQ 能够实现先进的实例分割性能,超越大多数现有方法。此外,我们发现统一的查询(query)表征可以大大提高 DETR 的检测性能。我们希望 SOLQ 可以作为基于 Transformer 的实例分割框架的强大基线。

所属领域:目标实例分割

关键词:实例分割,Transformer,压缩编码

3.论文题目:Instance-Conditional Knowledge Distillation for Object Detection

中文题目:用于物体检测的实例条件知识蒸馏

论文链接:https://arxiv.org/abs/2110.12724

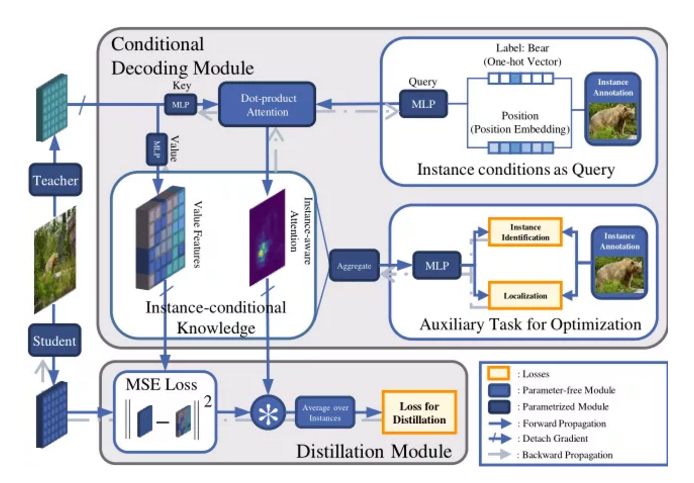

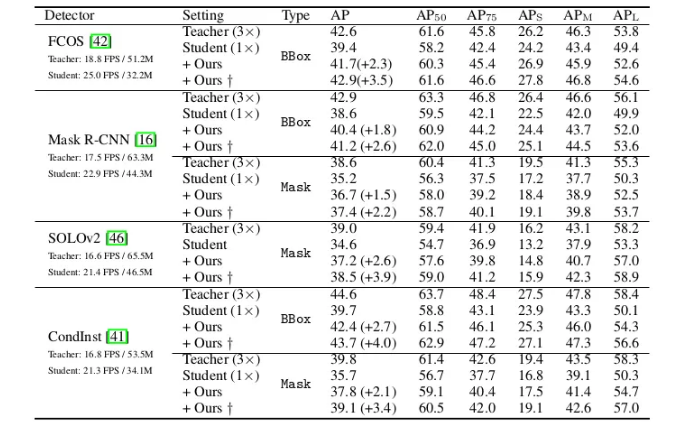

与分类不同, 检测图片散布着各式目标, 而有效的蒸馏区域与实例位置相关又不完全等同. 本文提出实例条件知识蒸馏:

a. 将实例标注编码的查询 (query) 表征与教师网络提取的关键 (key) 表征计算关联系数, 期望高系数处为空间中有效蒸馏区域;

b. 为学习靠谱关联系数, 引入含定位和识别的辅助任务进行监督;

c. 关联系数将以掩膜的型态, 在学生和教师网络的特征蒸馏时使用

实验表明, 我们的方法能显著提升学生检测器的效果, 有时甚至青出于蓝 (超越教师)。

所属领域:目标检测, 知识蒸馏

关键词:目标检测, 知识蒸馏, Transformer

4. Spotlight

论文题目:Spherical Motion Dynamics: Learning Dynamics of Normalized Neural Network using SGD and Weight Decay

中文题目:球面运动动力学:使用SGD和权重衰减学习正则神经网络动力学

论文链接:https://arxiv.org/abs/2006.08419

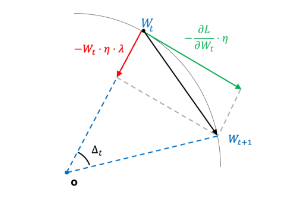

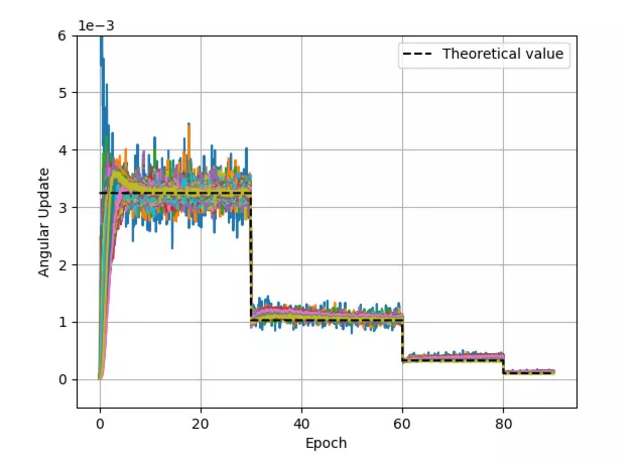

深度神经网络的成功离不开合适的训练策略,然而神经网络的训练机制在理论上仍不明晰,研究进展极其缓慢。虽然已有大量工作提出理论上更优越的训练方法,然而实践中往往最基本的 SGD 优化器仍然是最优选择。

本文从迥异于传统优化理论的角度出发,探究带归一化结构的神经网络在 SGD 优化器训练下的动力学。从中我们发现一种特殊的动力学机制,球面运动。基于球面运动机制推导出的理论,可以完全解析归一化权重的范数和 SGD 优化器的学习率、weight decay 系数、momentum 参数的定量关系。

进一步,我们基于球面优化动力学策略,定性分析了学习率、weight decay系数和 momentum 系数在网络训练时所扮演的角色,同时探究了常用的多阶段学习率衰减策略(mulit-stage learning rate decay schedule)对模型训练的影响。我们的研究结果必会深化人们对深度神经网络训练的理解与认知。

所属领域:神经网络理论

关键词:神经网络优化,BN,SGD,weight decay

5. 论文题目:Dynamic Grained Encoder for Vision Transformers

中文题目:面向视觉自注意力网络的动态粒度编码器

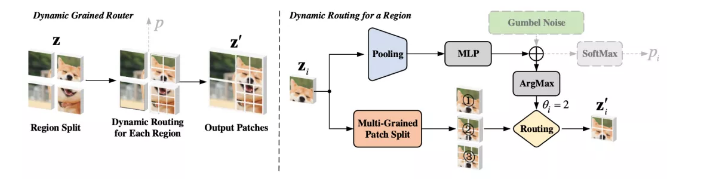

Transformers 作为自然语言处理中的经典模型,最近被应用在了大量的视觉任务中。本文将稀疏查询(Queries)技术引入到 Vision Transformers 中,从而挖掘自然图像中固有的空间冗余并且降低计算消耗。

具体而言,本文提出了一个动态粒度编码器,其可以自适应地为每个空间区域赋予合适数量的查询。从而使模型能够在复杂区域内获取细粒度的表征,同时保持相似的计算复杂度。

另外,动态粒度编码器可以适应大多数 Vision Transformers 框架。在没有额外技巧加持下,本文的方法可以应用在图像分类、检测和分割等任务。其中对于图像分类,动态粒度编码器可以降低模型 40%-60% 的计算复杂度,并保持相似的性能。

所属领域:图像分类

关键词:计算机视觉;动态网络;Transformers

首发:旷视研究院

作者:R

专栏文章推荐