云计算的灵活、安全与超算的极致性能,能否完美融合到一起?

对于很多企业用户来说,由于技术架构方面的壁垒,长期以来,云和超级计算两种服务往往只能二选一,不能兼得。但近日,NVIDIA打破了这一说法。

NVIDIA网络事业部宋庆春表示:“通过NVIDIA云原生超级计算(Cloud Native Supercomputing)技术,可以让数据中心拥有了超算技术的高性能,同时把云数据中心的灵活性和安全性带进了超算平台。”

NVIDIA网络事业部宋庆春

那么,NVIDIA如何将超算中心与云更好的结合在一起的呢?

会计算的网络,让数据在哪计算就在那

如何把各种云原生的设备高效的连接起来,是让超级算力走入千万数据中心首要解决的挑战。

NVIDIA提供了一个崭新的解决思路:“数据在哪,计算就在那”。

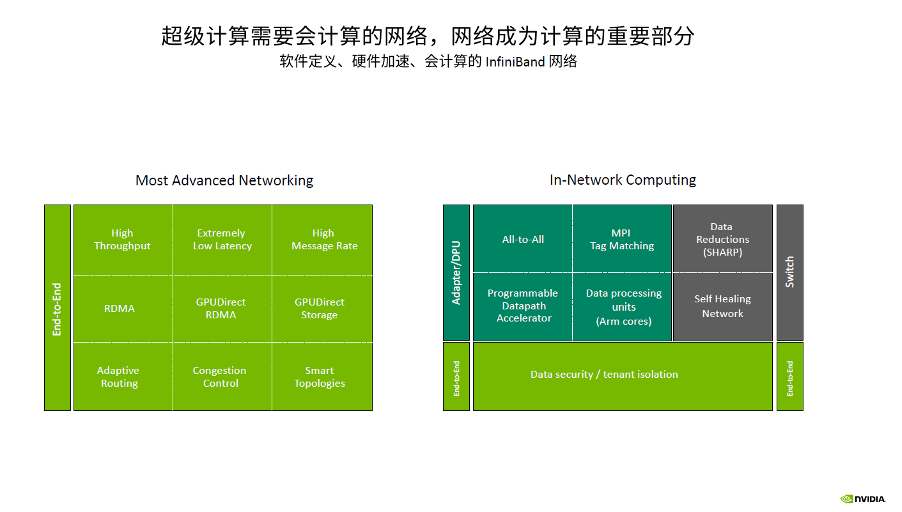

要实现这一解题思路,就需要借助InfiniBand网络来实现。InfiniBand是会计算的网络,不管是在InfiniBand的网卡上、DPU上还是交换机上,都赋予更强劲的针对不同业务的引擎,这样可以把不同的业务模型和通信模型的计算放到卡上或者交换机上。

同时,InfiniBand网络可以很容易扩展到几万、几十万、上百万的节点,可以采用不同的拓扑方案而不需要担心拓扑中出现死锁和网络风暴的问题,而且InfiniBand的动态路由可以让网络的利用效率变得非常高。

并且InfiniBand网络可以即插即用。在InfiniBand网络中,你不用对交换机或网卡做任何特殊设置,不需要做IP设置等。可以说,InfiniBand网络天生就是非常适合云原生架构的网络。

为了给企业客户提供更好的应用InfiniBand网络支撑, NVIDIA推出了Quantum-2平台,宋庆春表示:“Quantum-2是一个会计算的网络,真正契合了超级计算和云原生对网络的需求,我们的目标是实现数据在哪里,计算就在那里。”

据介绍,NVIDIA Quantum-2平台有三个非常重要的产品,分别是Quantum-2交换机、CONNECTX-7 InfiniBand网卡和基于BlueField-3的InfiniBand DPU,这三款产品拥有多租户、性能隔离、拥塞控制、超高精度计时器等关键功能。

Quantum-2平台不但能够实现GPU Direct RDMA对AI业务至关重要的技术,增加了PDA (Programmable Datapath Acclerator)来对特定流量进行编程和加速,而且还对各种通信模型进行了专门优化,提高了Allreduce 和 All-to-All等通信时的通信效率。

在微软Azure公有云上的测试显示,因为采用了InfiniBand动态路由和拥塞控制技术,实现了云上性能的保障。同时,成功的将不同的业务之间进行性能隔离,让一个业务不会影响到其他的业务,实现了真正的完全的Bare-metal的性能。

3U一体,给云原生架构赋予无限算力资源

未来,随着数据中心的发展,需要将计算移至接近数据的位置。

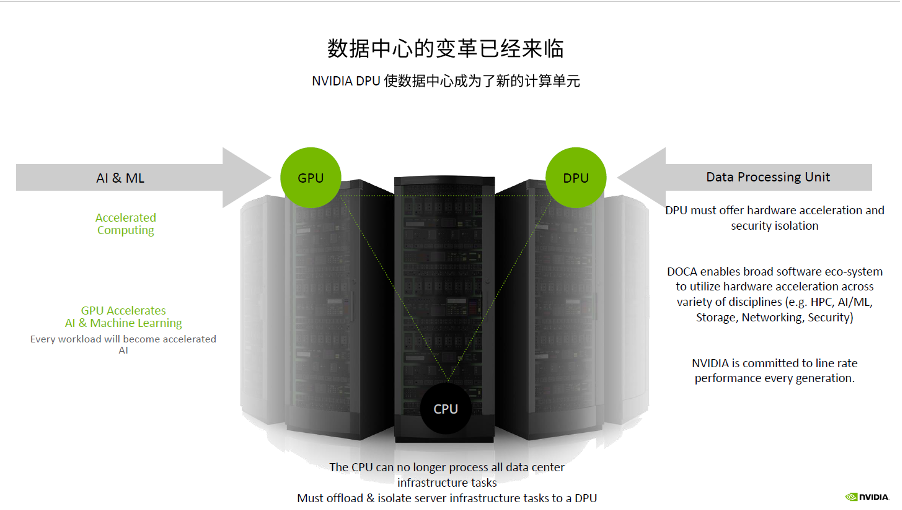

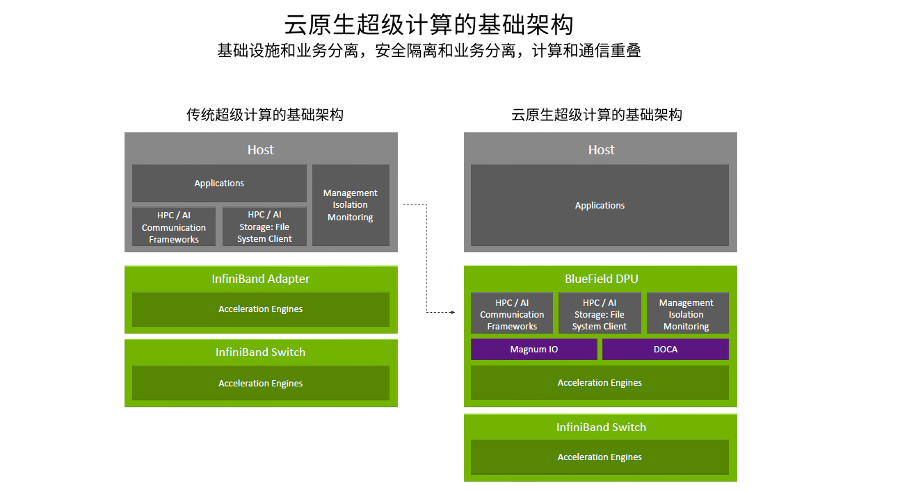

DPU的出现,为用户提供了另外一个对业务性能进行优化的思路。通过更明细的分工来实现效率的提升、实现总体系统的成本最优化,DPU来运行通信框架,CPU和GPU执行浮点计算,通过DPU加速HPC业务中的通信,实现了计算和通信的重叠。

DPU是集数据中心基础架构于芯片的通用处理器。从DPU概念的提出者NVIDIA的现有技术发展趋势来看,未来的技术发展趋势将会是高度集成化的片上数据中心的模式(Data Center Infrastructure on a chip),即一个GPU、CPU、DPU共存的时代。

NVIDIA布局的数据中心从核心到边缘(Edge)都采用了统一的一个计算架构——CPU、GPU、DPU,如图所示,形成了“3U”一体架构。3U一体的统一计算单元架构将会让管理程序、调度程序都会变得非常容易。

宋庆春解释说,在这种新的3U一体的数据中心架构之下,将传统Infrastructure的操作都放到了BlueField DPU上,由DPU执行通信框架、存储框架、安全框架和业务隔离等,将Host里面的CPU和GPU资源统统释放给应用,通过这一架构可以让业务性能得到更优的发挥,甚至比在Bare-metal状况下它的性能还会有更好的提升。

比如iAlltoall是在HPC应用、AI做推荐时的经常会用到的通信模型。通过用DPU和CPU实现计算和通信的重叠,让iAlltoall性能得到44%的提升。iAllgather是做大规模模型训练时用到的一个通信模型,通过DPU和CPU计算通信的Overlap,能够让iAllgather性能提升36%。

宋庆春表示,DPU的出现弥补了数据中心Infrastructure加速能力不足的问题,让数据中心成为新的计算单元,给数据中心算力优化提供了全新的资源。因此,3U一体已经成为数据中心的一个必然的架构,而且,在这样一个必然的架构中通过DPU、CPU和GPU的分工合作实现一个数据中心中最优的性能。

云原生软件定义安全为零信任提供安全保障

随着数据的传输越来越快,越来越复杂,传统的方式或者工具已经没有办法满足现在数据中心的安全需求。

在传统的数据中心,发现一个漏洞,可能需要超半年的时间,而要修复这个漏洞需要超过两个多月的时间,这个对于基于零信任(Zero-trust)的前提下是绝对不可接受的,这说明整个数据中心是非常不安全的。

如何解决这个问题?

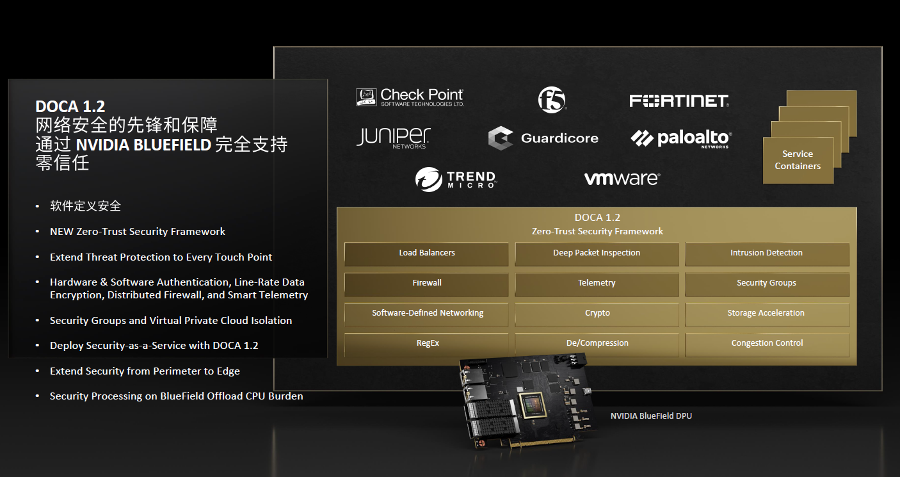

在今年秋季GTC上,NVIDIA发布了 DOCA 1.2。DOCA 1.2是专门面向零信任(Zero-trust)的安全框架,提供了Load Balancers、DPI、 IPS、IDS、下一代防火墙,设计安全软件的用户或者安全软件的供应商,可以直接通过DOCA API调用在GPU里的硬件加速引擎,让数据中心更安全。

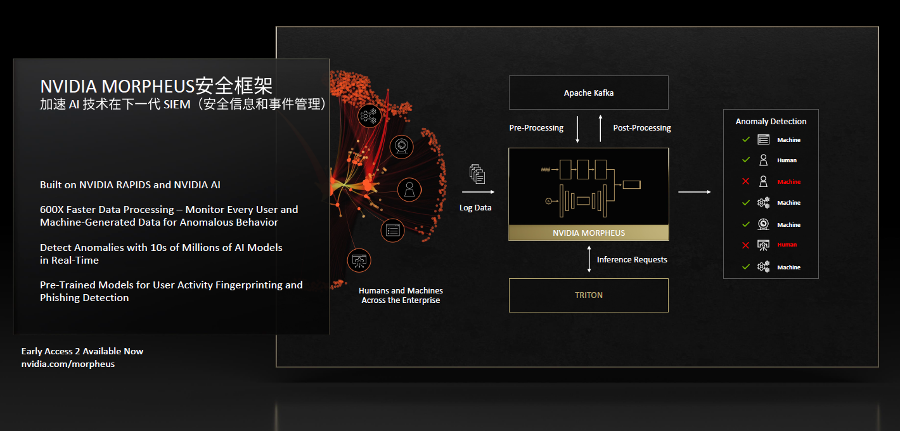

黄仁勋专门针对Morpheus安全框架进行了讲解。他表示,Morpheus是对未来的数据中心提供了一个更新的思路,通过Morpheus可以利用AI的方式进行安全防御,而不必根据传统的安全顾问对于恶意攻击或者是其他安全特定模型的识别来进行有限的安全防御,利用AI深度学习的方式可以让数据中心得到全方的保护。

通过Morpheus、通过AI对于安全的保障,可以实现600倍快的数据处理的速度,Morpheus可以通过DPU抓取到的数据特征生成百万、千万级别的模型数量,然后在数据中心里面去进行匹配,实现数据中心的异常情况全面监控。

而且用Morpheus时,不用去定义这个行为是恶意还是善意的,只看你这个行为是正常的还是异常的,只要是异常行为这时候就会去监控和识别,判断它到底是一个合理还是不合理的行为。

宋庆春表示,在跟Morpheus的整合上,不管是NVIDIA 的以太网还是InfiniBand网络都实现了和Morpheus的整合,特别在InfiniBand网络的UFM Cyber-AI和Morpheus的联合,不但实现了对网络中异常行为的识别处理,同时也实现了对于未来网络中有可能出现的异常情况进行推测,做一些预防性的保护。

NVIDIA 让超级算力飞入“寻常百姓家”

随着Transformers模型的出现,现在的数据中心对算力的需求变得越来越大,要运行大的模型就需要更多的GPU,数据并行和模型并行在未来工作训练中同时使用将成为一个趋势。如何既保持很高的算力,又保证业务的安全性,云原生技术对这样一个趋势是必不可少的。

同时从Inference角度看, Inference依然需要很高的算力。因为随着现在模型越来越大,这时候需要跨服务器、跨Node做Inference。为了让Inference效率更高,Inference走向分布式也慢慢出现了,这也需要更高算力和更高的通信能力。

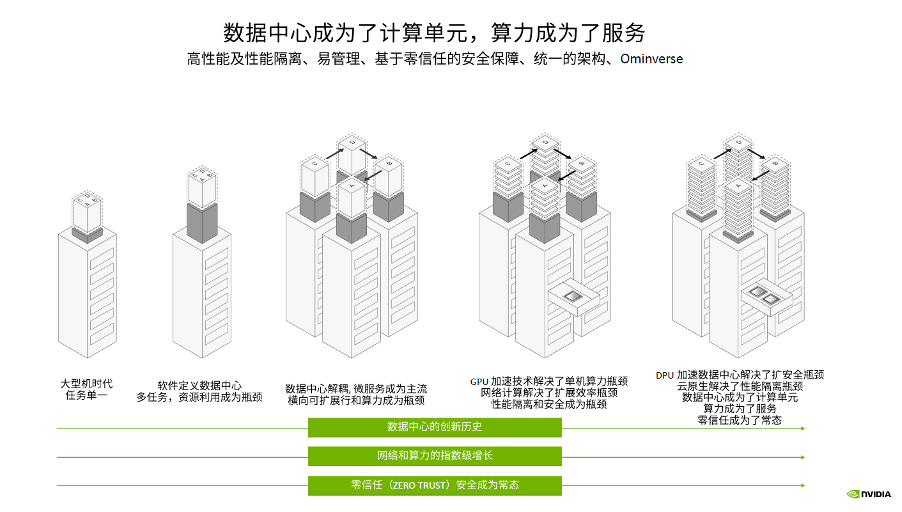

随着training和Inference技术的发展,AI将成为数据中心里最主流的应用之一,现在数据中心逐渐成为了计算单元,算力成为了服务。

超级计算中心要像一般的数据中心一样为大量的用户提供服务,就需要解决数据中心提供商所要解决的问题,如在零信任的环境下为租户提供服务、同时对大量的用户提供服务、确保每个租户之间的安全隔离等。

云原生超级计算(Cloud Native Supercomputing)技术的出现,为解决超算中心面临的挑战提供了解决方案。通过NVIDIA GPU可以解决超算中心的算力瓶颈,通过InfiniBand网络可以解决扩展效率的瓶颈,通过NVIDIA DPU可以解决性能隔离和数据安全的瓶颈。

未来,数据中心中CPU、GPU、DPU,3U一体缺一不可,这是数据中心成为计算单元的基础,也是算力成为服务的基础,真正让超级算力飞入云数据中心。