接前文:《Dell PERC12 (H965i):带风扇的RAID卡重现江湖》

本来我没想连续两天晚上写东西,然而有2个原因又导致我不得不写:

1、昨天引用的资料,有个别配置信息不准确之处;

2、我找到了PERC 12的那一份完整测试报告。

这份RAID卡性能测试报告来自www.tolly.com,文末我会把下载链接分享出来。

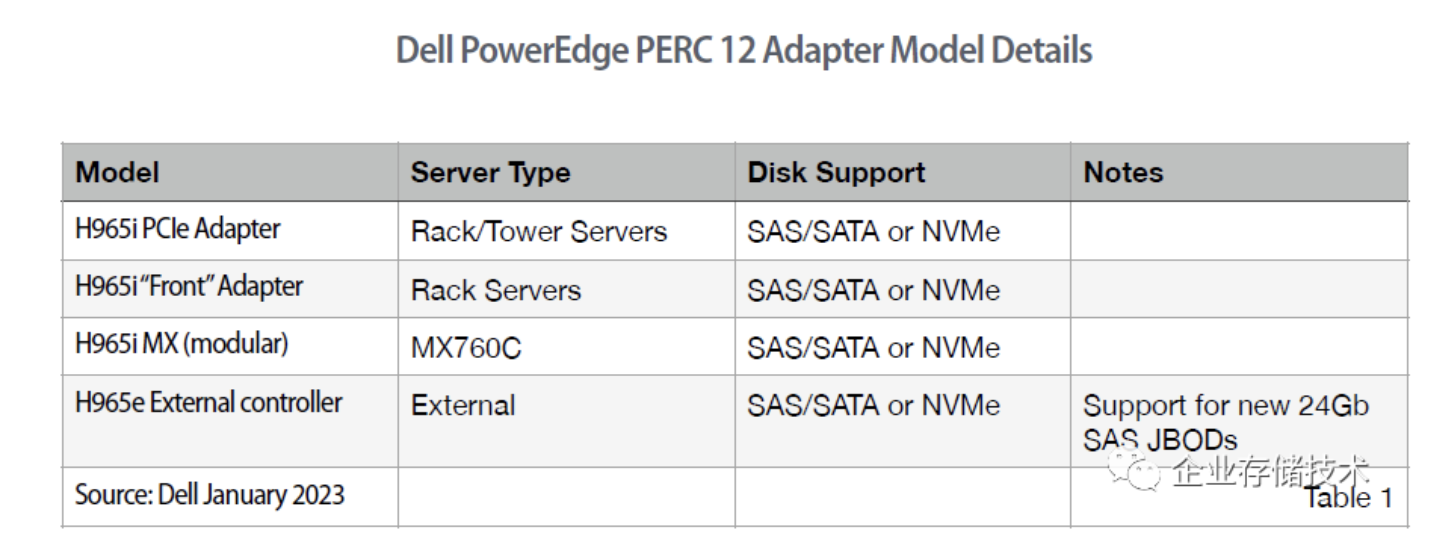

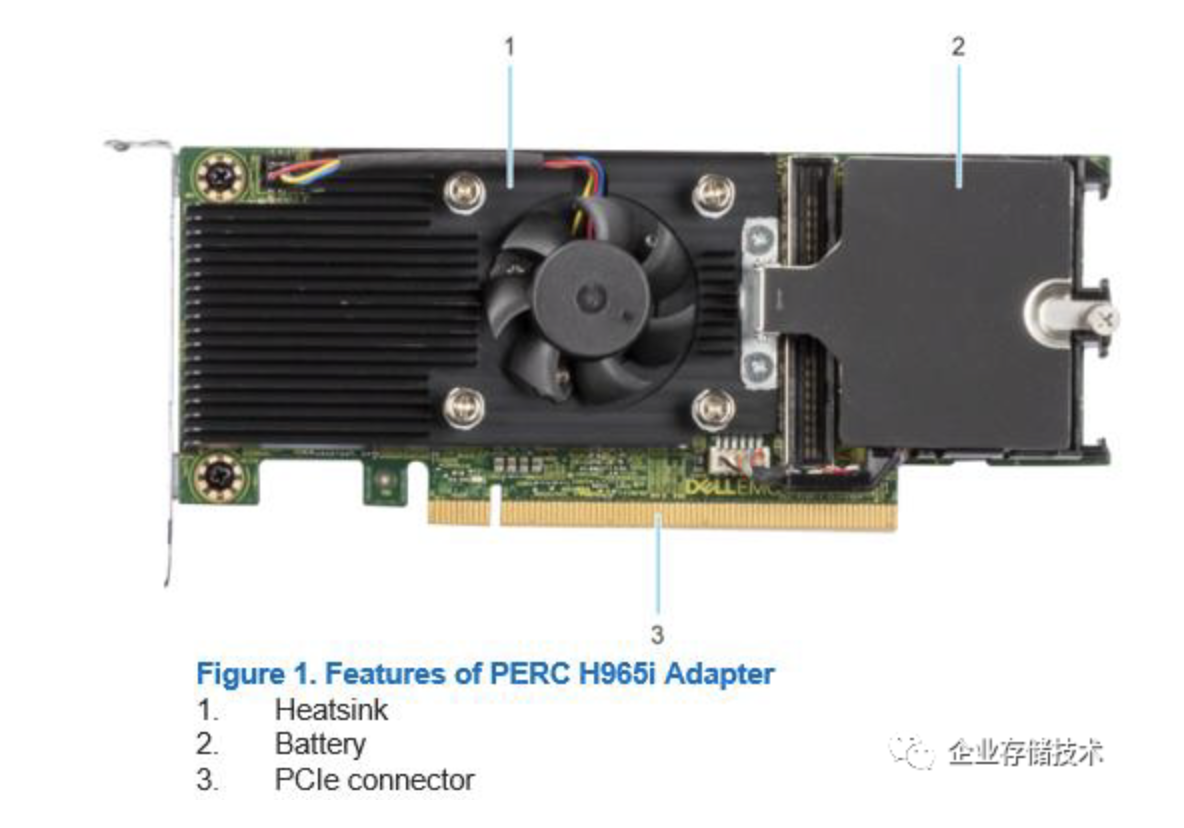

如上表,H965i PCIe Adapter就是昨天提到带风扇的标准尺寸RAID卡,可用于机架和塔式服务器。特别是在塔式机箱中,风扇转速和气流量相对较低一些,这时RAID卡主动散热的意义更大。

昨天我没注意到PERC 12系列还有一款外部接口的H965e RAID卡,尽管也是兼容SAS/SATA或者NVMe驱动器,但我觉得它的主要用途,应该还是外接JBOD——支持新款的24Gb SAS扩展柜。毕竟PCIe信号跨机箱拓扑的应用不太多,并且有点容易成为瓶颈,未来外部扩展NVMe SSD的趋势应该还是通过以太网NVMe-oF。

扩展阅读:《NVMe-oF存储扩展:EBOF、FBOF、EBOD生态详解》

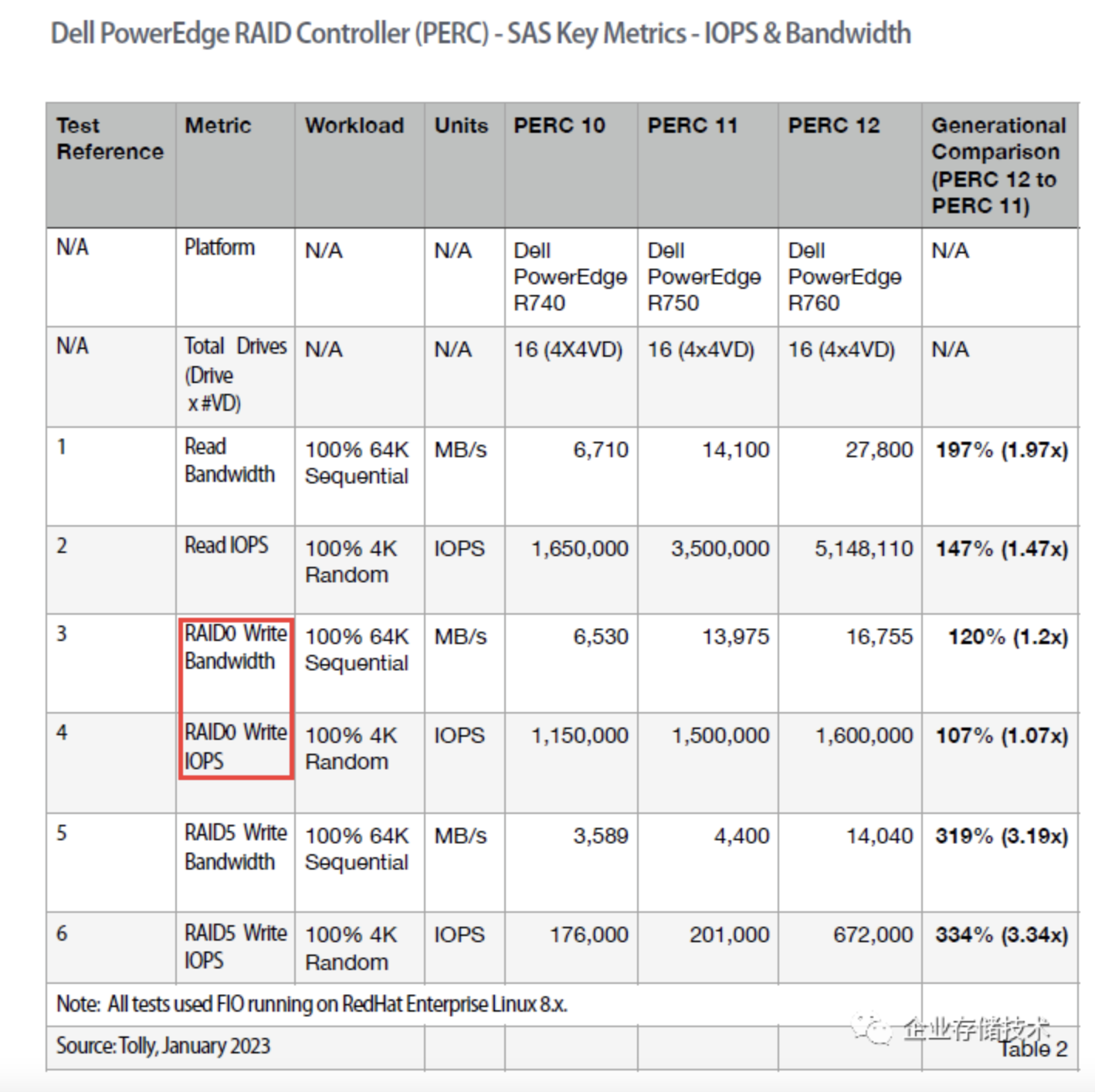

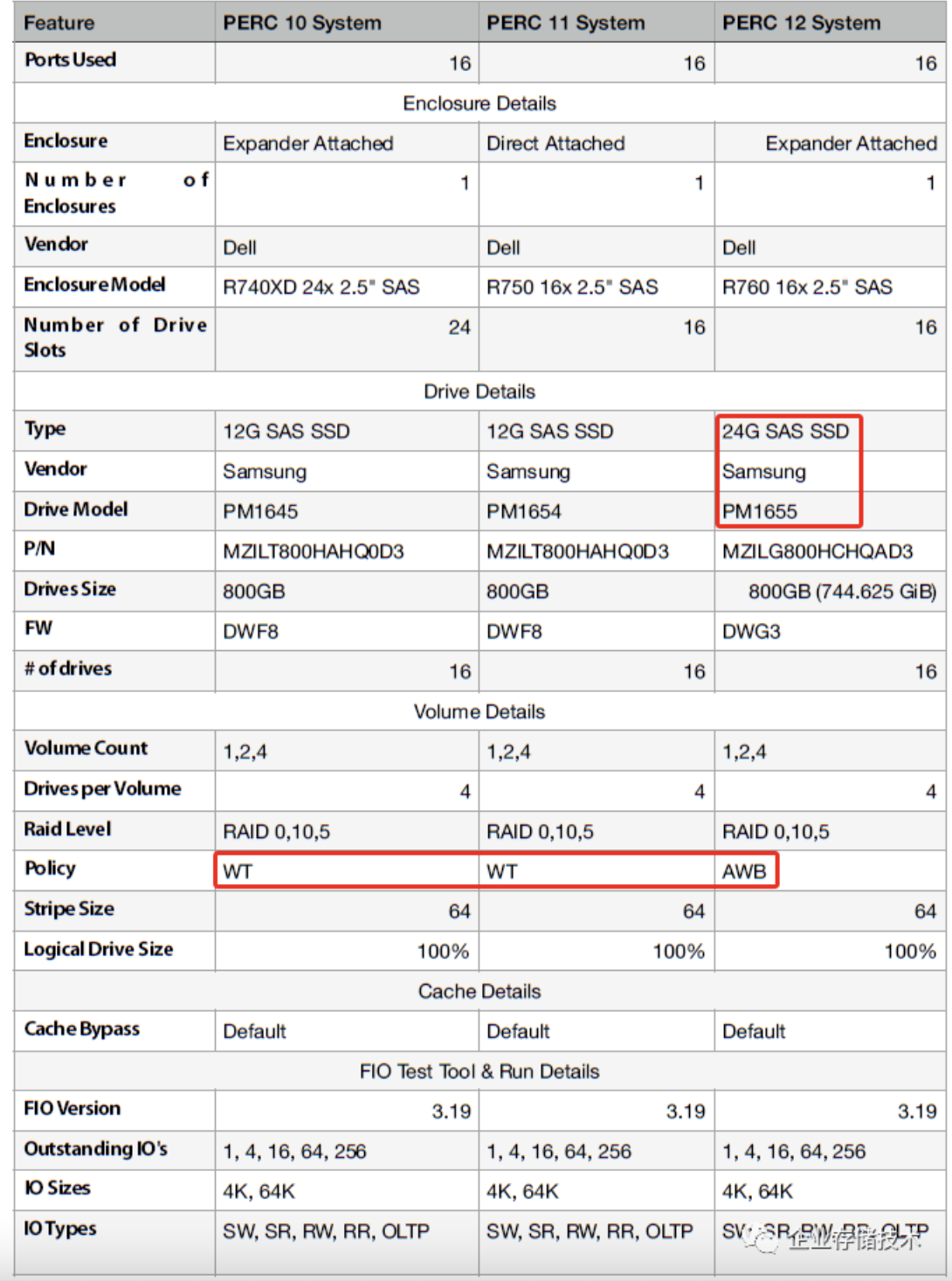

三代PERC RAID卡SAS SSD阵列性能

上面这个图表并没有要更正的部分,只是补充下RAID 0的性能——顺序写并没有比RAID 5高太多;而160万的4K随机写IOPS也只是比上一代PERC 11高了一点。好在RAID 0用的相对不多。

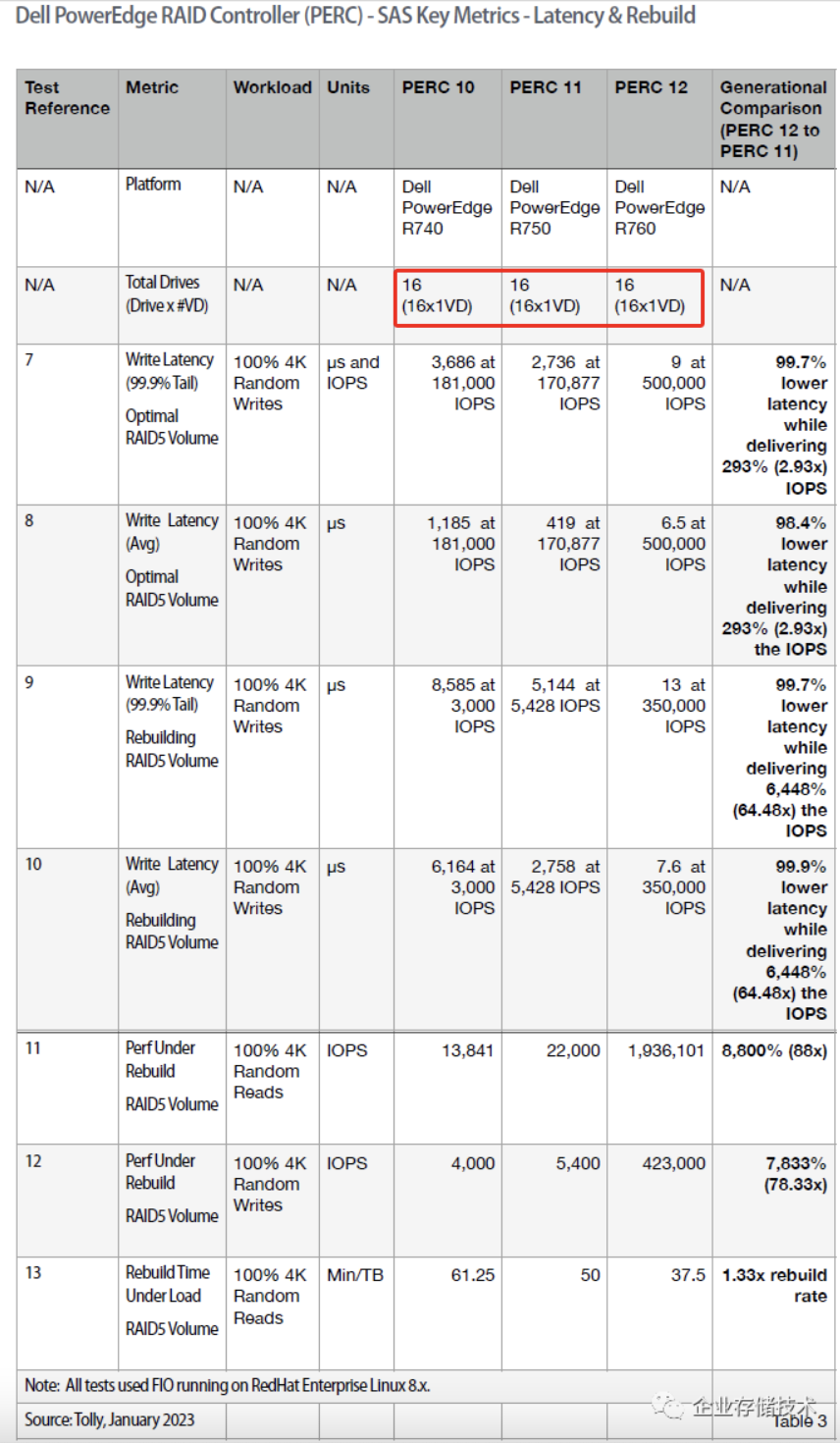

SAS SSD延时和重构性能:单组16盘RAID 5测试

如上表,在昨天文章中我引用的截图里,写的是4组4块盘的RAID 5。而原始报告本身,还是用1组16盘的RAID 5 VD来验证SAS SSD的延时和Rebuild性能。

完整延时的对比我就不细讲了。1x 16 RAID5的性能还是比4x 4 RAID5要低一些——随机写跑到50万IOPS(实际能力还要再高一点吧?),Rebuild时按照75%左右来计算大约就是35万。

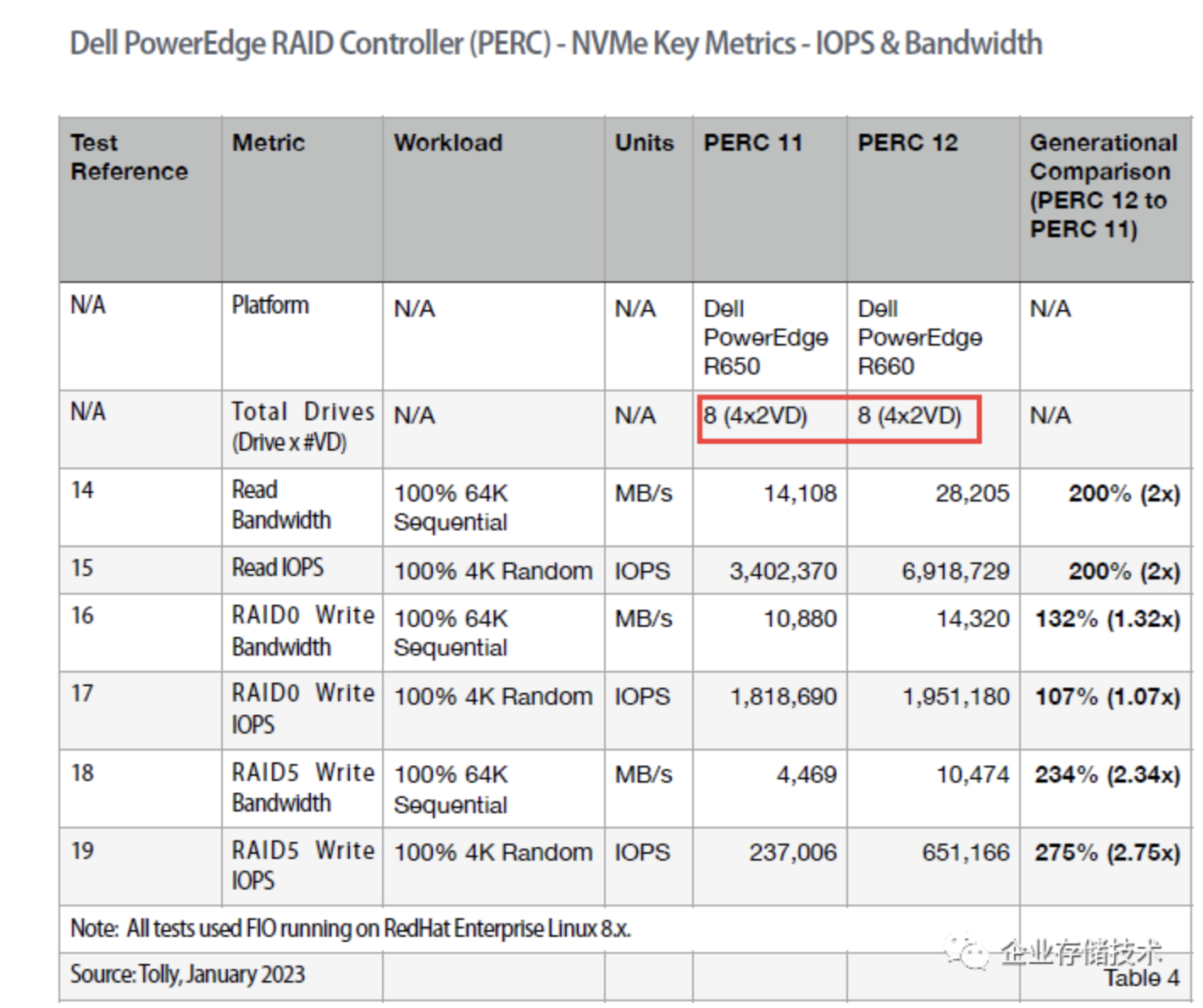

NVMe SSD性能测试:使用2x 4盘RAID 5

有了详细测试配置,性能数字就好解释了。大家都知道RAID 5的写惩罚\=4(特别是随机写),这样8块SSD一共2组VD跑出65万4K随机写IOPS,就相当于单盘发挥出了32-33万IOPS的水平(当然SSD还有读比写快的特点)。PERC 12的效率着实不低了。

结合下面列出的平台配置信息,我们还能发现更多东西:)

测试平台配置:SSD RAID写缓存策略AWB

首先是SAS SSD测试平台——H965i RAID卡用在PowerEdge R760 2U服务器上。24G SAS SSD使用了三星最新的PM1655,应该是DWPD=3的读写混合用途(更适合跑性能测试)。

在RAID写缓存策略上,包括PERC 11 H755在内的传统RAID卡,一般都建议设为WT(写通)以避免影响SSD性能发挥;而最新的PERC 12不同了,AWB应该是Always Write-back(总是写回)的缩写。估计这就是Broadcom新一代RAID控制芯片算法改进的一个表现。

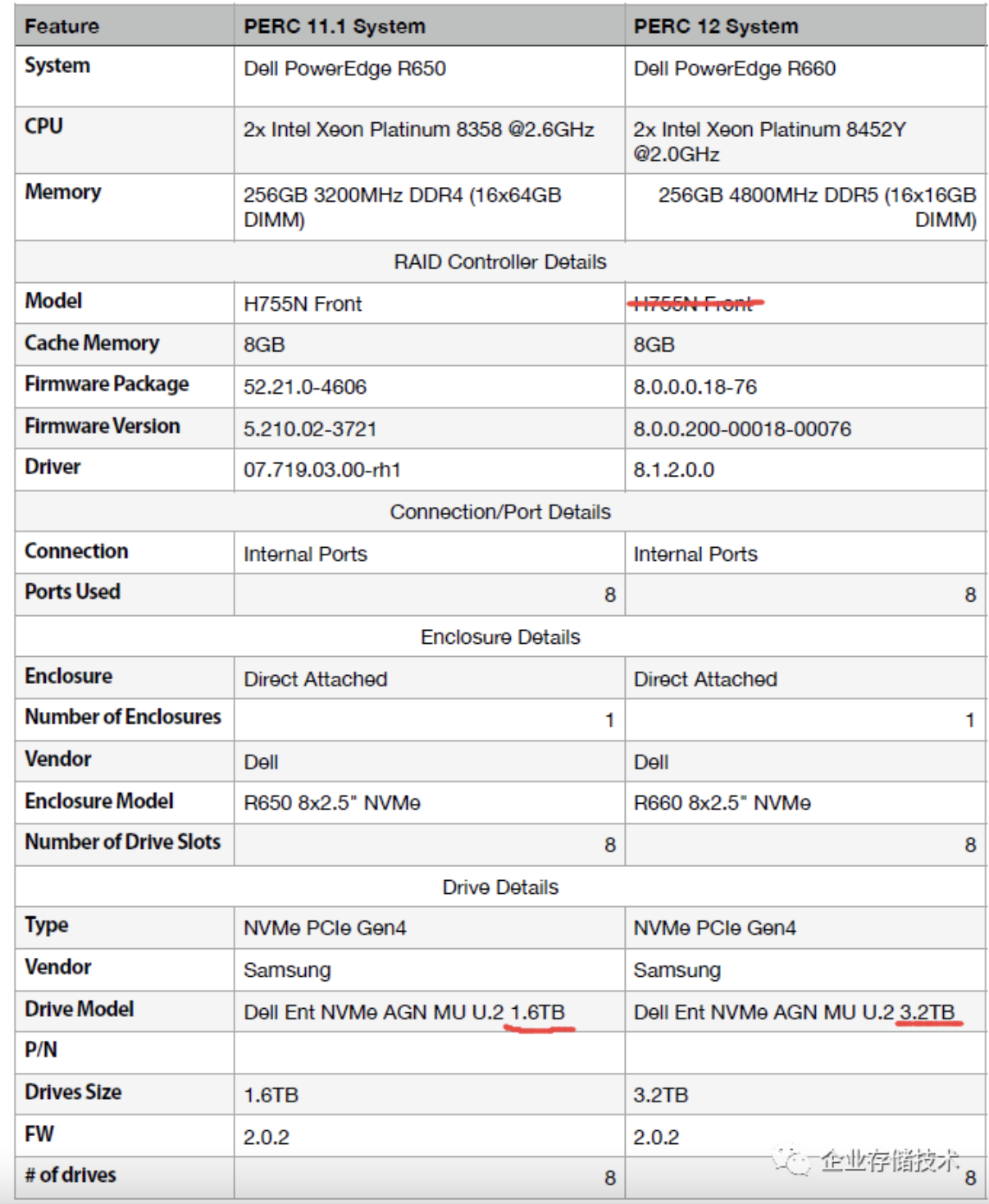

再来看看NVMe SSD测试平台——这里在1U R660服务器上用的RAID卡型号应该是写错了(大家看资料时也宽容一点吧)。

H965i RAID卡是直连8个PCIe Gen4 NVMe SSD(仍然是三星MU读写混合用途),总共16 lane分配到每个SSD就是PCIe 4.0 x2的带宽(相当于PCIe 3.0 x4)。这并没有影响PERC 12读性能的发挥;而我估计Broadcom MegaRAID 96xx公布的90-110万RAID 5随机写IOPS,应该要连接更多数量的NVMe SSD(或者更快的盘?),并且中间加了PCIe Switch。

虽然PERC 12这最新一代RAID卡性能提高很多,但还是受限于PCIe 4.0接口速率。面对接下来的PCIe 5.0 NVMe SSD(估计是EDSFF E3.S形态居多),当前的硬RAID卡还是面临接口带宽和处理能力的瓶颈,这些就留给未来的PCIe 5.0 RAID卡来缓解吧:)

作者:企业存储技术

原文:企业存储技术

推荐阅读

欢迎关注企业存储技术极术专栏, 欢迎添加极术小姐姐微信(id:aijishu20)加入技术交流群,请备注研究方向。