在最近结束的 NTIRE 2023 比赛中,旷视研究院在 Efficient Super-Resolution 赛道脱颖而出,击败 40 余支队伍,夺得全球冠军。这也是旷视连续第三年在 NTIRE 的图像超分辨率赛道上夺冠。

NTIRE 比赛是国际级别的学术竞赛,聚焦于图像恢复和增强领域的最新趋势和技术。今年的比赛开设了多个赛道,吸引了来自全球各地的顶尖研究团队和公司参与,希望通过创新的方法和算法来解决前沿的、实际的图像处理问题。

Efficient Super-Resolution 赛道赛题介绍

今年 NTIRE 2023 比赛的 Efficient SR 赛道主要进行的是 4x 超分任务,评价指标是在 DIV2K 验证集上 PSNR 达到 29.00dB 的基础上,比较运行时间、参数量、Flops、激活数量及深度等。

其中 Efficient SR 评价指标需要注意的点在于,一个比较低的 parameters 和 flops 并不直接等于比较快的运行时间,举个例子,我们实际操作中借鉴的 ghost SR 的对部分特征进行 shift 的操作,参数量和 flops 下降了一半左右,但是实际运行时间和原来基本不变,这些额外的时间通常来自于一些乘法、加法操作。

此外,官方放出来一个超大数据集LSDIR,包含 8W 多张高质量图片,对于后续的图像复原和增强任务也是一大助力。

旷视夺冠算法介绍

我们的方法出发点相对简单,首先是找一个好的 baseline,去年的冠军 RLFN 就是一个不错的选择,接下来是两个方向,第一是刷点,第二是刷速度。我们的方法总体分为三步:

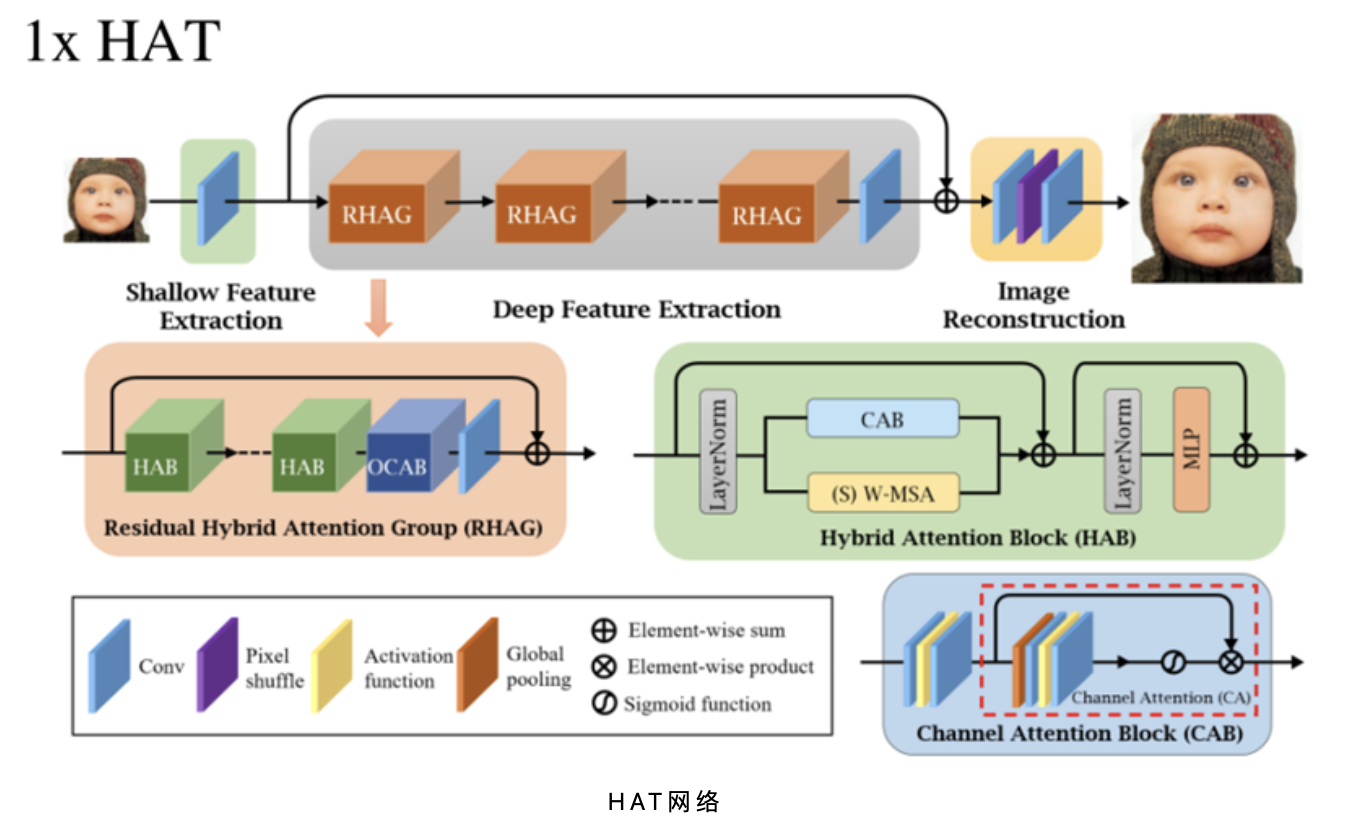

第一步是对 GT 进行增强操作,这个方法思想借鉴于最近的一篇 CVPR 2023 的论文 HGGT,他们在对 GT 进行增强的过程中引入了人类的指导筛选,我们在实践过程中发现,仅仅使用模型进行增强的 GT 就使小模型更好的学习纹理和细节,具体来说,就是对原始的 GT 过一个 1x 超分的网络进行增强,这个 1x 超分网络我们选用当前超分的 SOTA 网络 HAT,基于此结构重新训练了一个 1x 模型。

增强 GT 效果如下,在相当一部分图上,我们发现会比原始 GT 有丰富的纹理和细节。

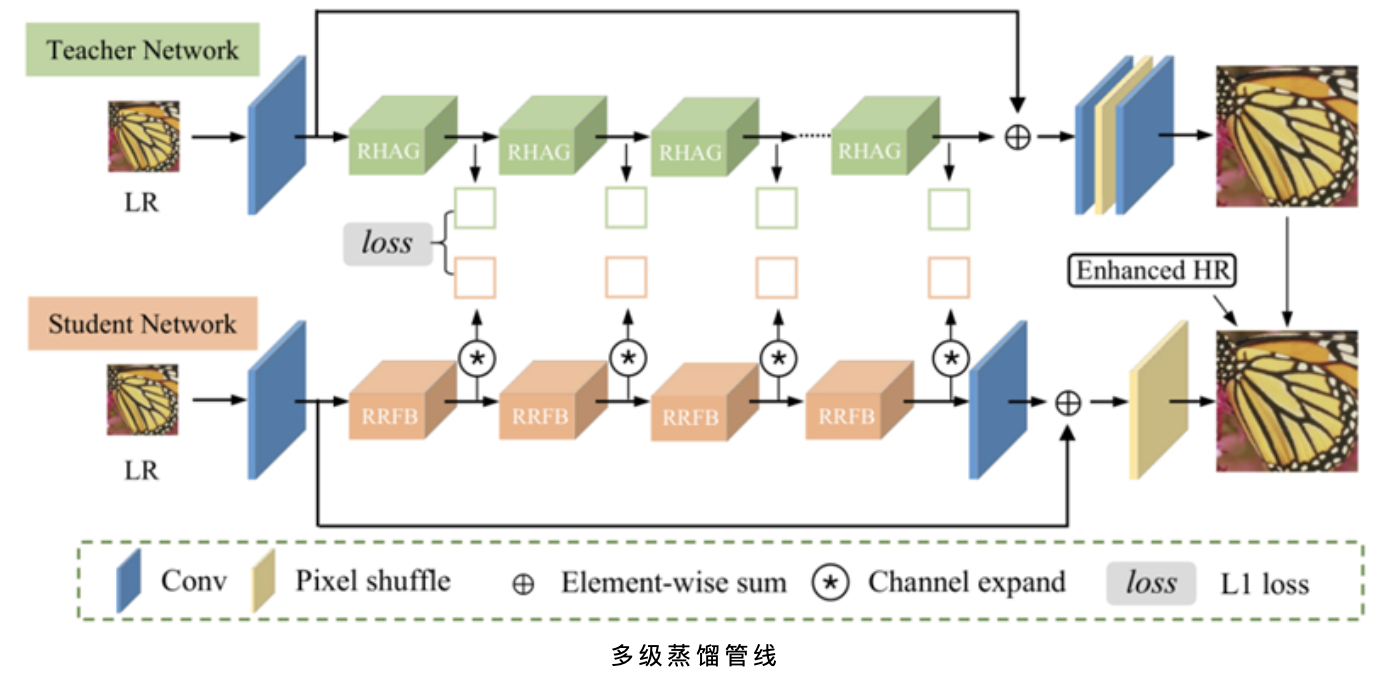

第二步为了继续提高小模型精度,我们从结构和训练方法两方面同时入手,具体来说,我们采用一个多层级蒸馏方法,首先利用增强的 GT 训练一个比较大的 Teacher Net,然后用 Teacher Net 对 Student Net (也就是我们的小模型)进行特征层面和图像层面的蒸馏。

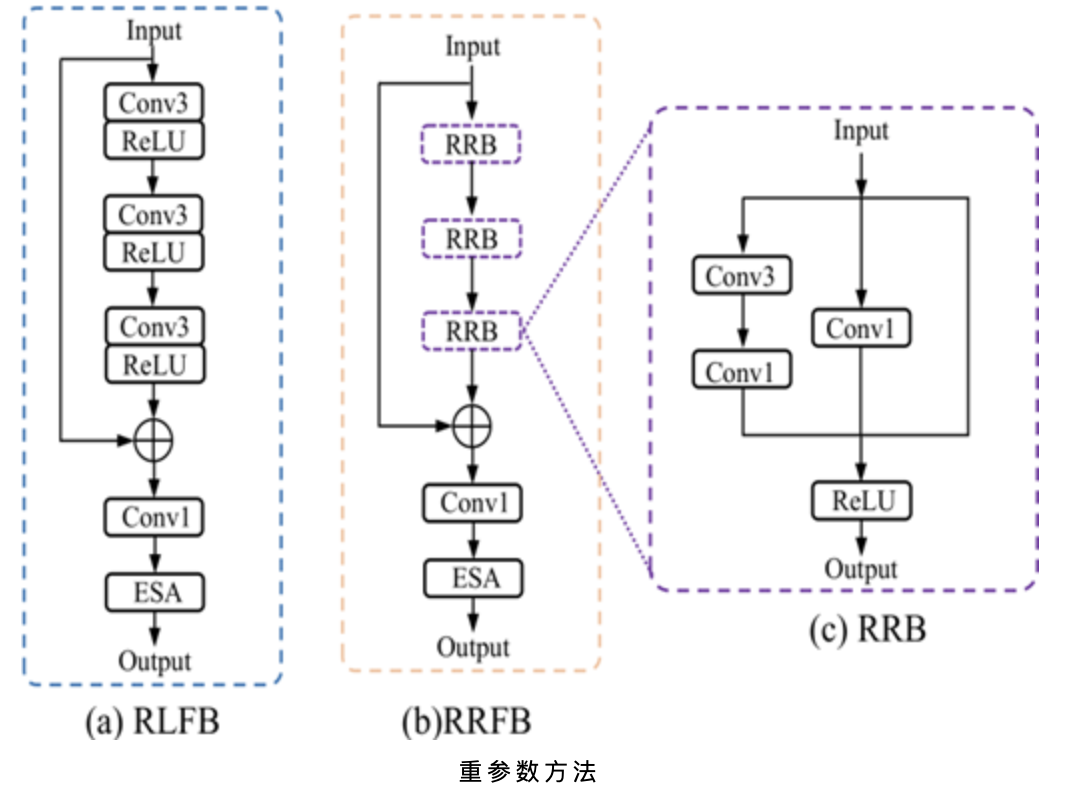

在第二步的过程中,我们在 RLFB 的 block 基础上增加了重参数化的技巧,包括串行的卷积重参数化和并行的重参数化,这种方法为我们带来的无损的精度提升,在 loss 上除了特征层面的蒸馏监督外,对最后输出图像也进行了大模型输出图像监督以及增强 GT 的监督。除此以外,我们在训练好的小模型基础上也采用了比赛提点的 trick,在 L1 loss 训练收敛后使用 L2 loss 进行 finetune、渐进式增大 patch 训练等。

最后一步是一个迭代式的剪枝过程,我们对第二步的结果进行重参数化后对模型进行剪枝,每次剪枝完成后进行 finetune 操作,直至收敛才会进行下一轮剪枝,剪枝方法我们使用的是 L2 剪枝,我们队友也尝试过引入 weight normlization 的方法,对 WN 的 weight 进行排序剪枝操作,最终和迭代式的 L2 剪枝效果持平,我们最终选用了简单一些的 L2 剪枝。

与以往 SOTA 结果的对比

我们比较了我们的方法和最近几年的一些 SOTA Efficient SR 方法的客观指标,可以看到,我们方法的时间比去年的冠军快了将近 1/4,参数量、Gflops 以及激活等都会优于去年的冠军。

客观指标对比

更多的结果和细节可以参考:

- 论文:DIPNet: Efficiency Distillation and Iterative Pruning for Image Super-Resolution(https://openaccess.thecvf.com/content/CVPR2023W/NTIRE/papers/Yu_DIPNet_Efficiency_Distillation_and_Iterative_Pruning_for_Image_Super-Resolution_CVPRW_2023_paper.pdf)

- 代码:https://github.com/xiumu00/DIPNet

来源:旷视研究院

作者:旷视研究院

专栏文章推荐

欢迎关注旷视研究院极术社区专栏,定期更新最新旷视研究院成果。欢迎添加极术小姐姐微信(id:aijishu20)加入技术交流群,请备注研究方向。

加入旷视:career@megvii.com