今天要介绍的是 lmdeploy,一个服务端场景下、transformer 结构 LLM 部署工具。

https://github.com/InternLM/lmdeploy

你可能要问,现在 LLM 周边工具这么多,为什么要用 lmdeploy 呢?

专注场景

lmdeploy 实现了 GPU 服务端部署,它有如下特点:

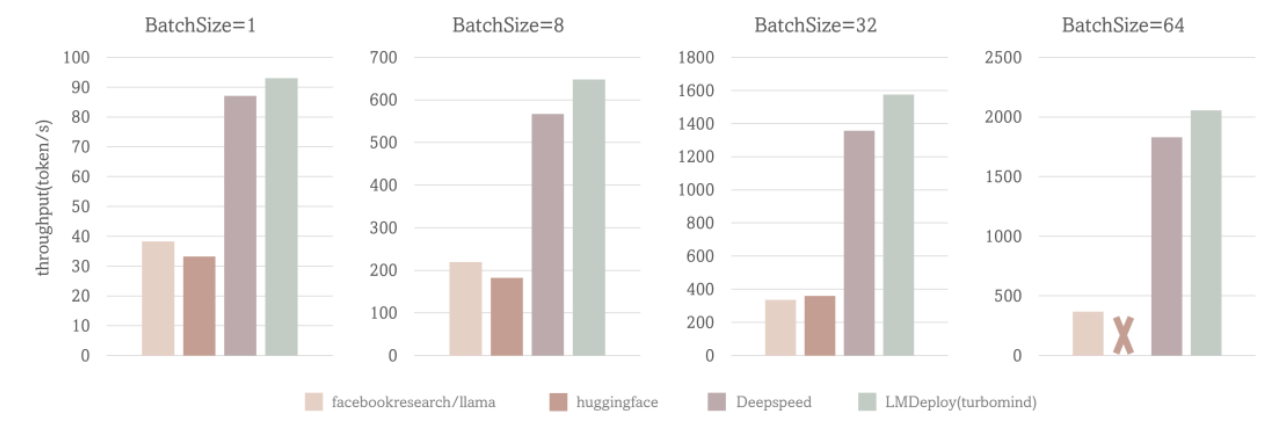

- 速度有保障:这是 lmdeploy 吞吐量测试结果,已经超过一些常见框架。

- 支持 Tensor Parallel:眼下 7B 精度是“按下葫芦起了瓢”,终究要运行更大模型。买不到 A100 不用怕,可以把 65B 或更大的模型,切分到多个 3090 上运行。

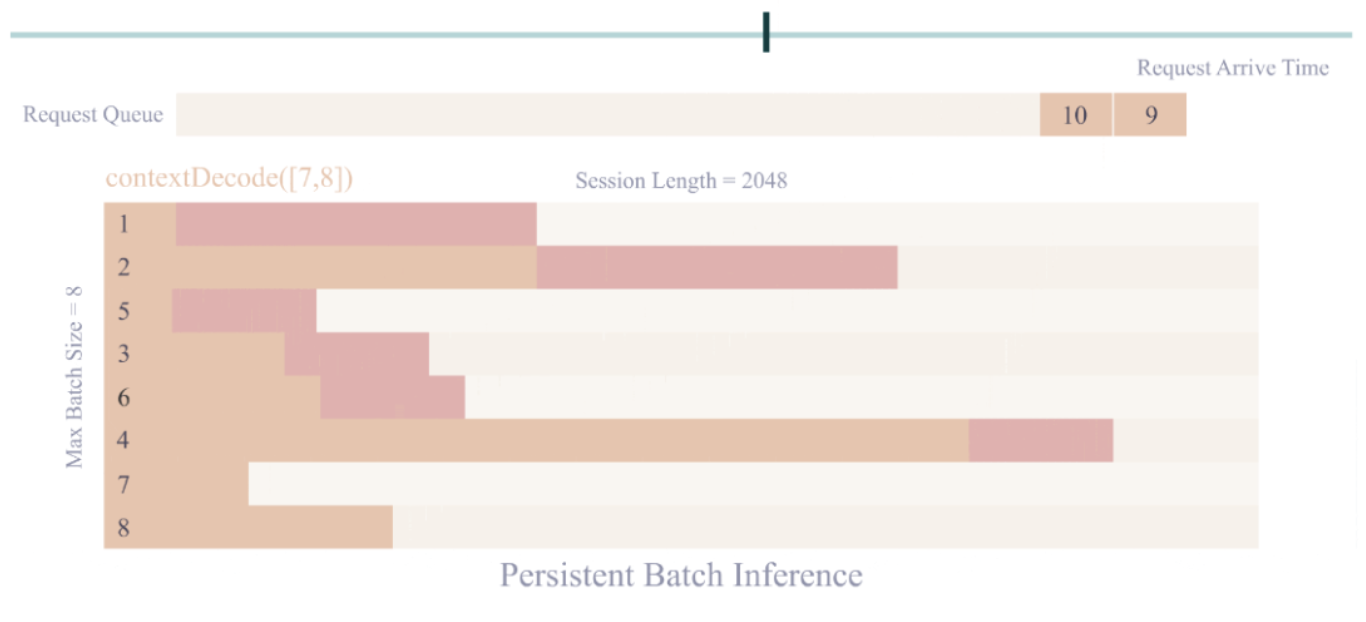

- 多并发优化:后端服务必然考虑部署成本,lmdeploy 不止实现了多 batch,更完成了 kv cache 量化,有效降低单用户成本。

功能全面

不止是推理量化工具,lmdeploy 在服务化方面有更多特性:

- 模型转换:只要是 transformer 结构(InternLM/LLaMa/Vicuna),无论 HuggingFace 或 Meta 格式,都可以转成需要的 bin

- 交互推理:缓存历史会话的 cache feature,避免重复计算

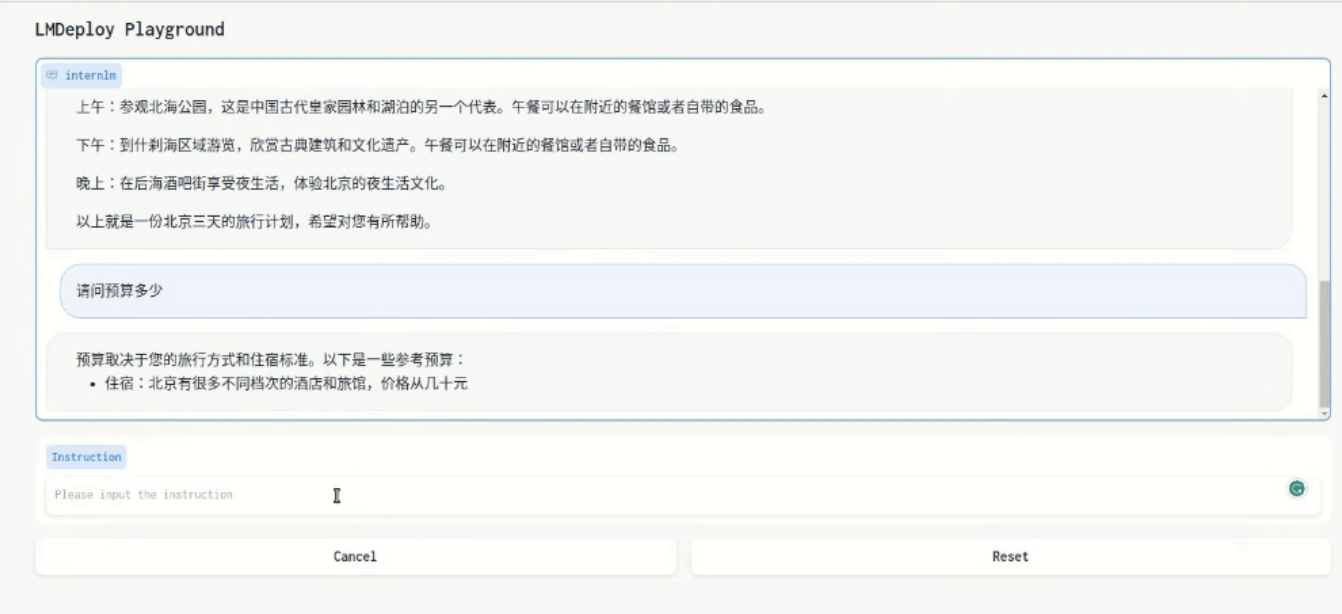

- 接入方式:lmdeploy 内部是统一的 API 接口,对外提供了 WebUI、命令行和 gRPC 客户端接入

质量保障

lmdeploy 和队友 OpenCompass(大模型评测一站式平台)合作良好,使得 lmdeploy 的浮点、定点版本,都能高并发执行大量数据集验证, 而非单一的 ppl 结果。只有充分测试,才能保障出优秀且稳定的对话体验。

欢迎使用 lmdeploy !

lmdeploy:

https://github.com/InternLM/lmdeploy

OpenCompass:

https://github.com/InternLM/opencompass

作者:白牛

文章来源:OpenMMLab

推荐阅读

- 冠绝榜单 | 百度联合上海AI实验室提出 CityTrack: 刷新城市规模多目标跟踪纪录!

- 华为诺亚实验室 | AIGC时代的ImageNet,百万生成图片助力AI生成图片检测器研发

- ICRA2023 | 通用、自动和无标定目标的Lidar-Camera外参标定工具箱

- 全新AFPN出现 | 完胜PAFPN,堪称YOLO系列的最佳搭档

- 最强DETR+YOLO | 三阶段的端到端目标检测器的DEYOv2正式来啦,性能炸裂!!!

更多嵌入式AI干货请关注嵌入式AI专栏。欢迎添加极术小姐姐微信(id:aijishu20)加入技术交流群,请备注研究方向。