与iSCSI相比,NVMe/TCP还受网络MTU 巨型帧(9000byte)设置的影响吗?

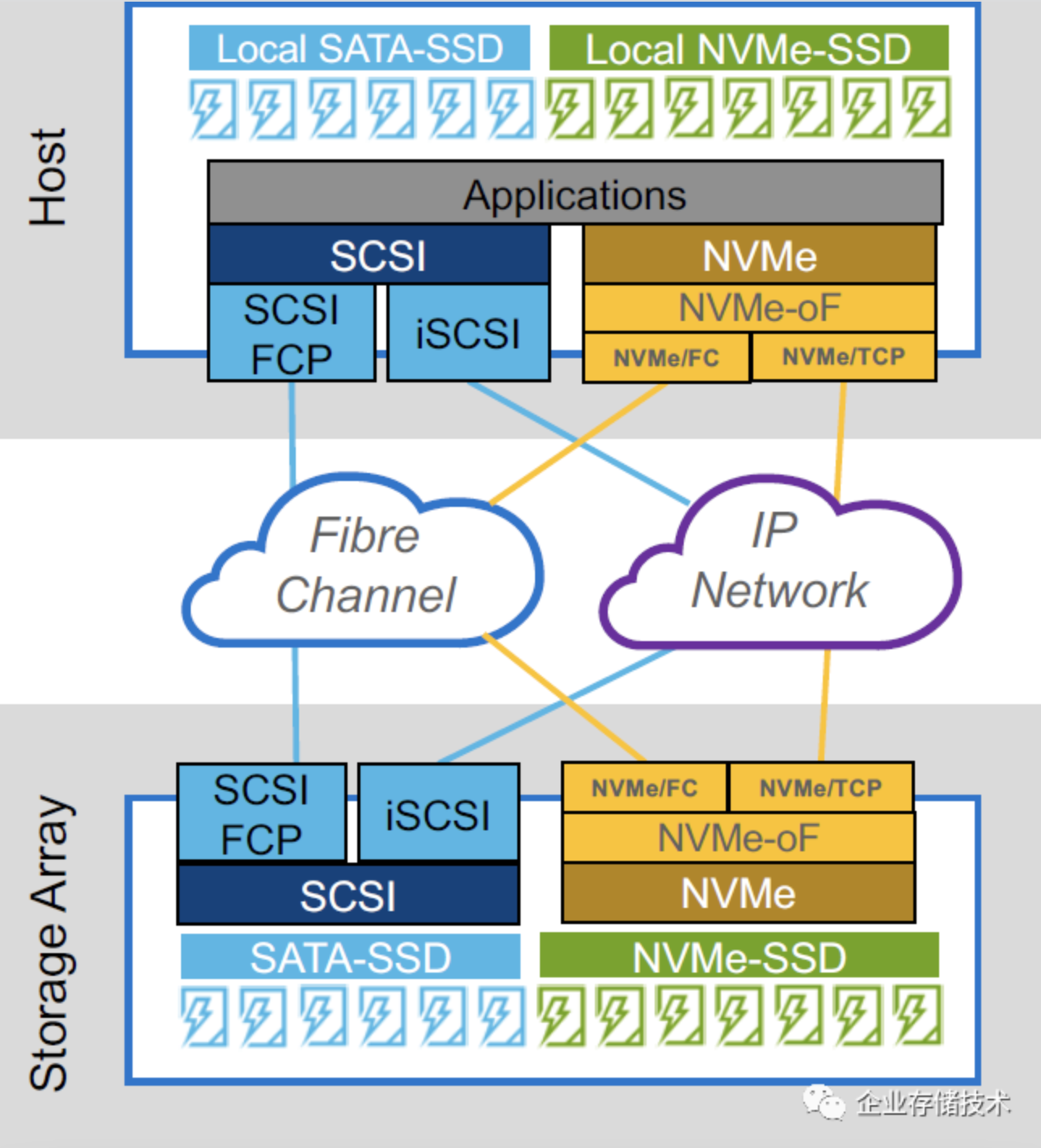

正好前几天有朋友问过NVMe-oF(over Fabric)与FC光纤通道存储网络之间的性能对比,然后就看到这份来自SNIA的Webinar资料《NVMe/TCP: Performance, Deployment, and Automation》,觉得有价值就分享给大家。

2位分享/演示人包括Dell Technologies的卓越工程师Erik Smith,以及Intel超融合市场总监Christine McMonigal。

前年我曾写过一篇《NVMe-oF:基于IP的NVMe SAN自动化发现存储网络》,当时主要讨论NVMe/TCP协议存储阵列的管理,今天的资料中也有管理相关内容,而在下文中我重点展示性能部分,更多东西读者朋友可以访问文末链接下载参考文档。

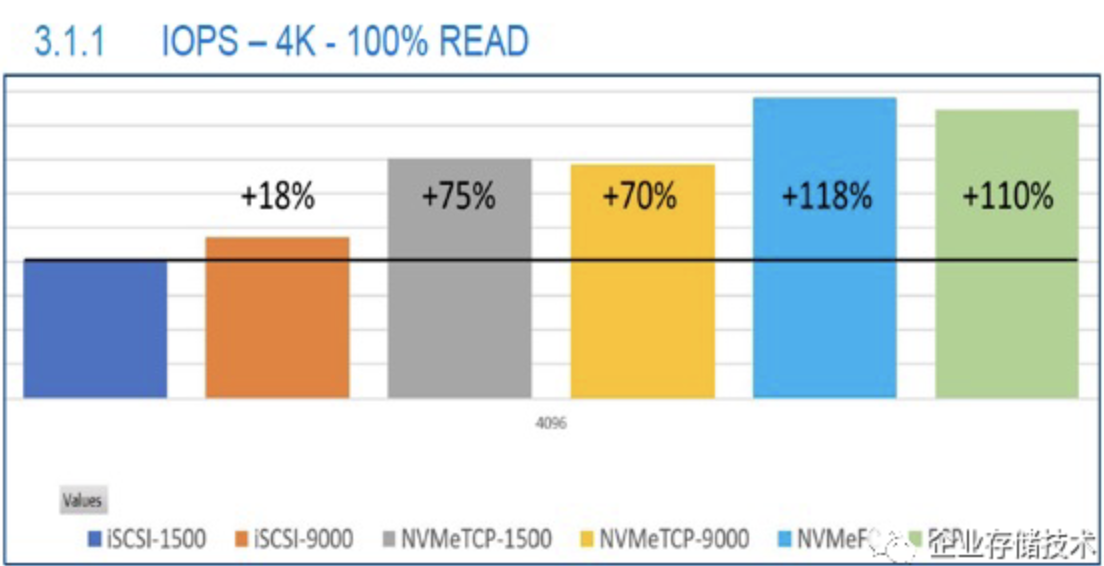

IOPS读写性能

首先是4KB 100%读IOPS。iSCSI 1500byte MTU(帧大小)的性能最低;iSCSI设置9000 MTU巨型帧能提升18%;NVMe/TCP受网络MTU的影响不大,两种设置都能比基准值提高70%以上;估计由于TCP/IP协议本身的封包效率等限制,在这里还是传统FCP(SCSI)和NVMeFC性能最高,其中后者比基准值高出了118%。

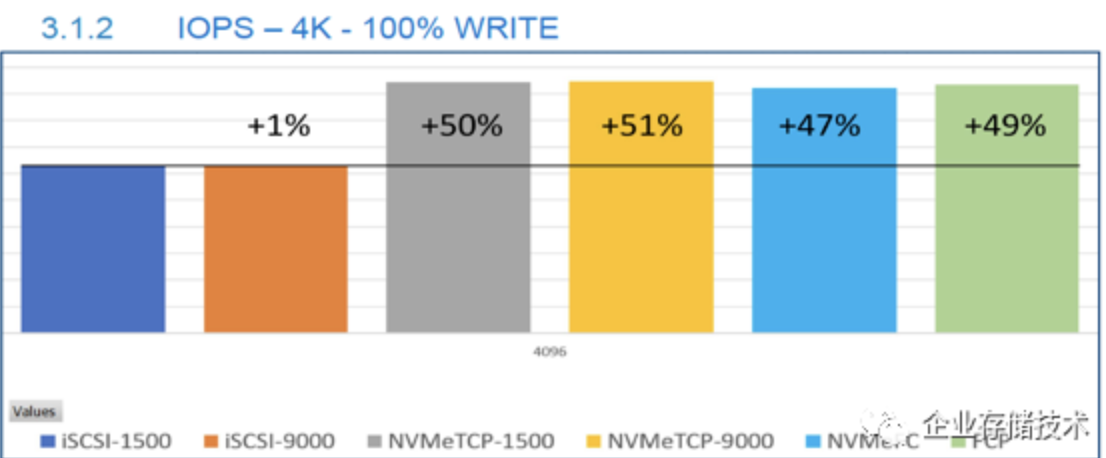

接着看4KB 100%写IOPS。MTU设置1500还是9000字节没明显影响。iSCSI性能还是最低;余下4者都能提升50%左右,NVMe/TCP的表现甚至比FC还要略好点。

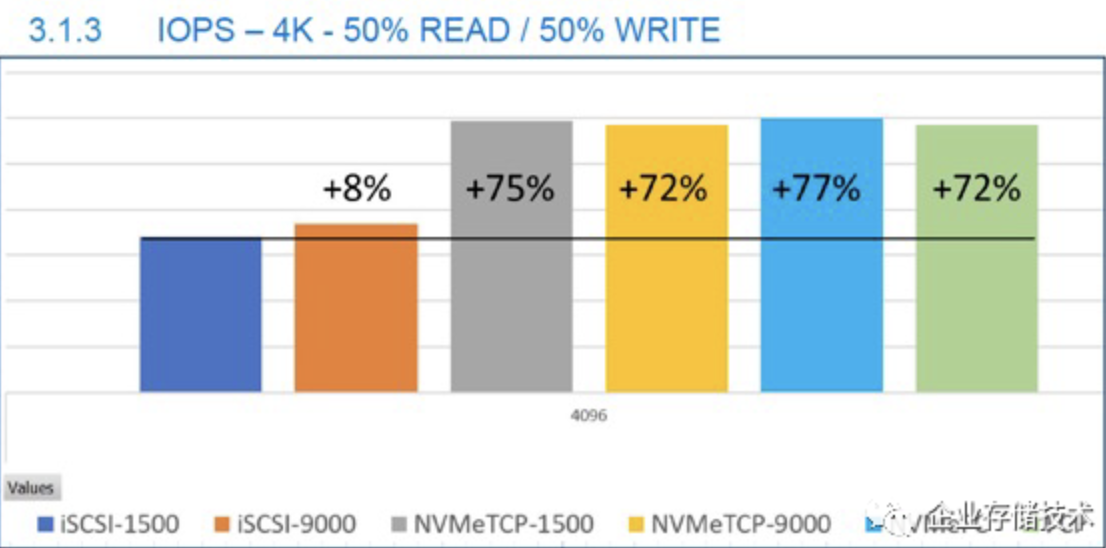

4KB 50%读 / 50%写IOPS

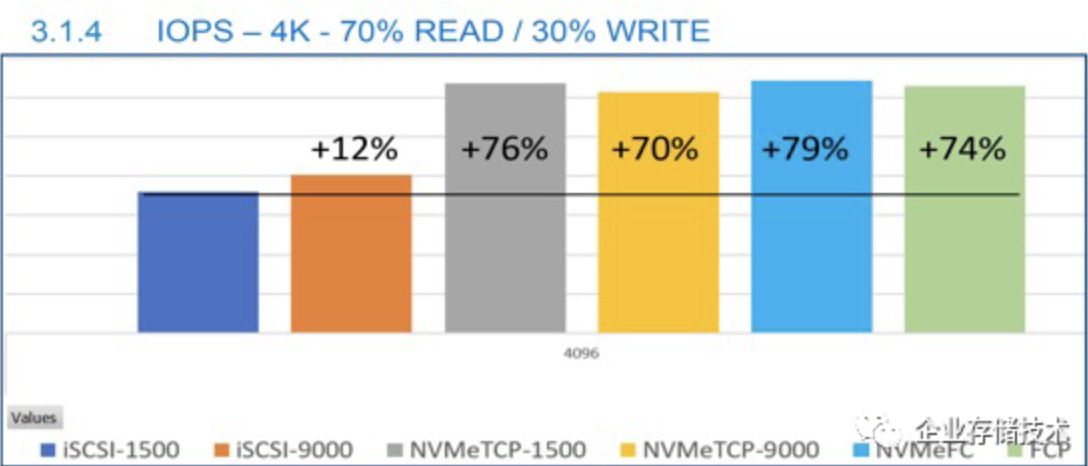

4KB 70%读 / 30%写IOPS

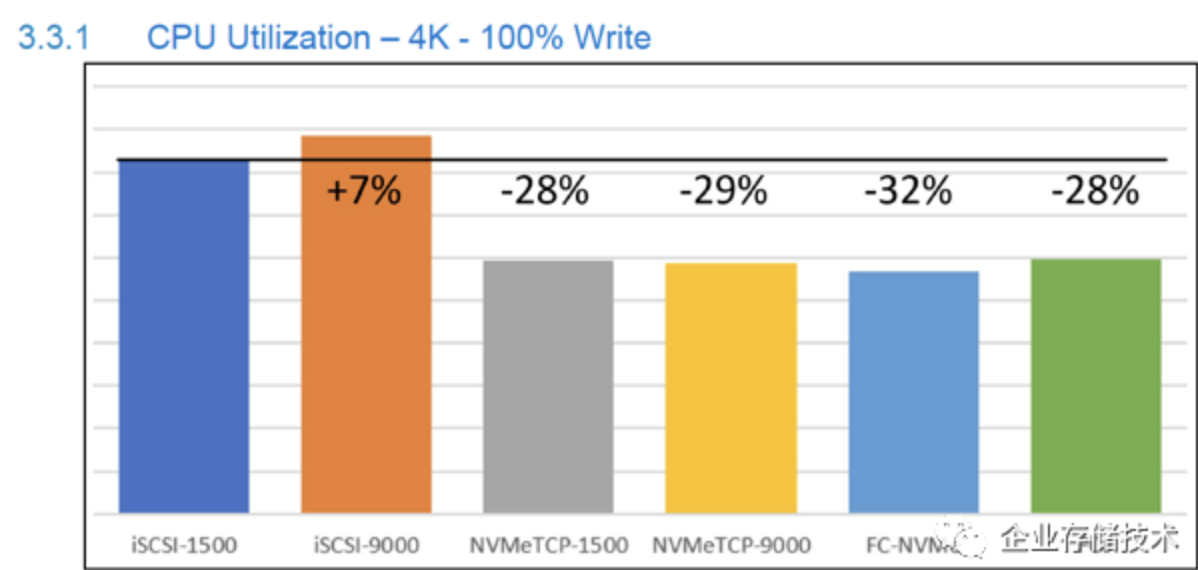

4K I/O CPU占用率

接着看CPU占用率——这部分是先看写入。仍然以iSCSI 1500 MTU为基准,设置9000字节jumbo frame后CPU会多占7%;余下的NVMe/TCP和FC等,CPU占用率都能降低30%左右。

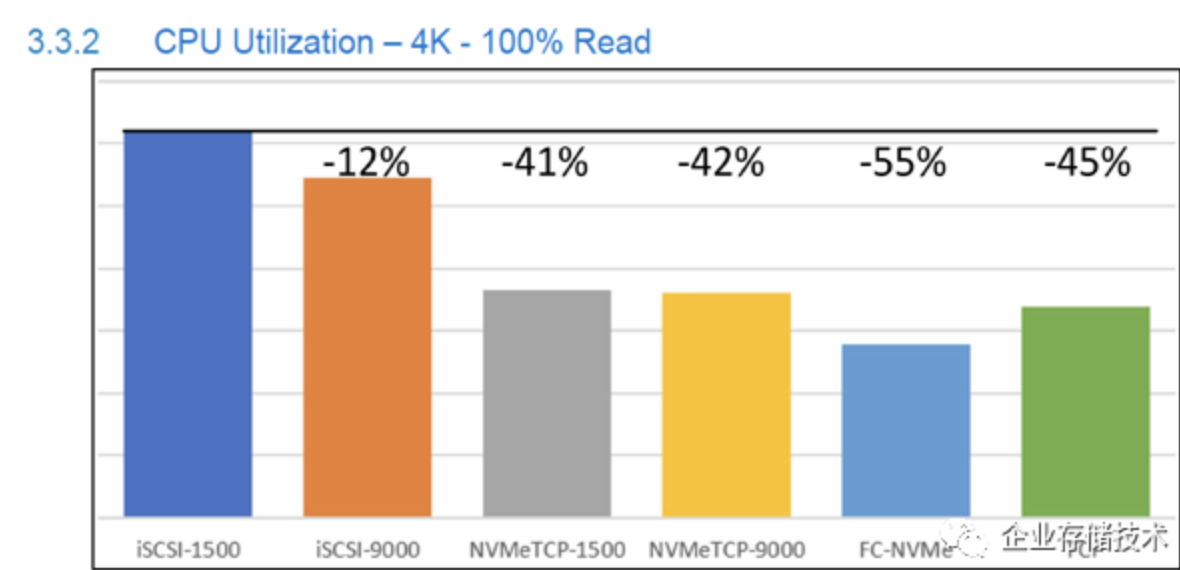

iSCSI-1500在4K 100%读测试中CPU占用率最高,这样与NVMe/TCP和FC等的差距就拉大到40-55%。

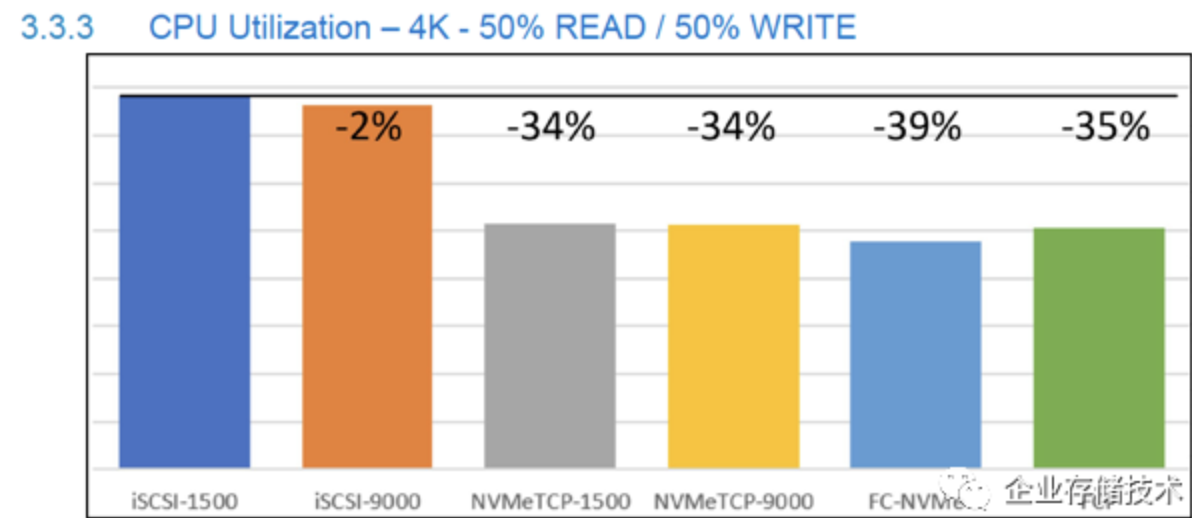

4KB 50%读 / 50%写CPU占用率

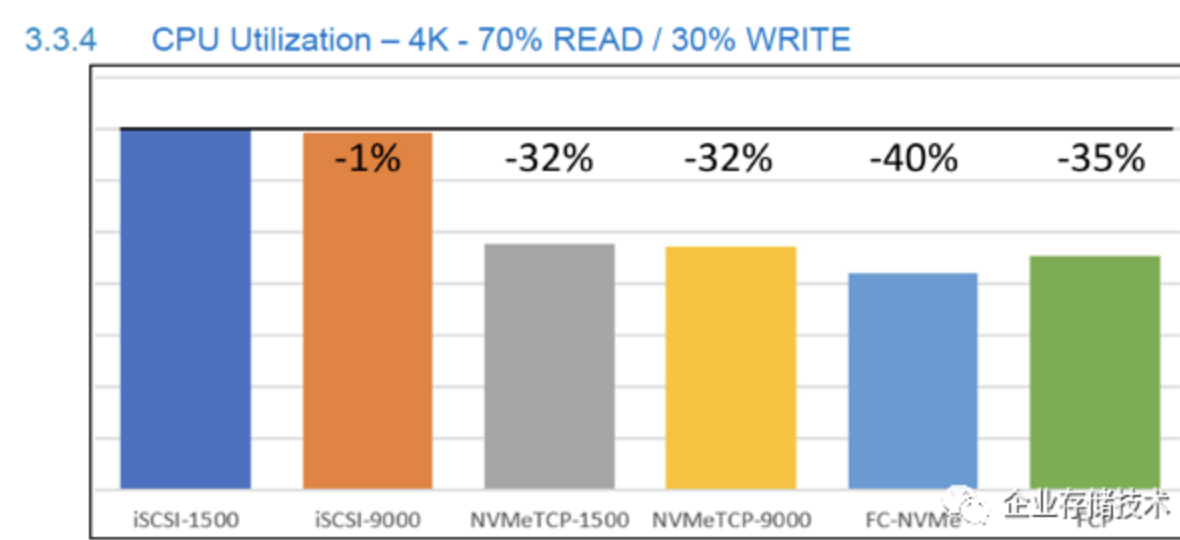

4KB 70%读 / 30%写CPU占用率

混合读写部分表现,基本上相当于把读、写测试结果“中和”一下。

最后看一点NVMe/TCP集中管理的部分,SFSS是SmartFabric Storage Software的缩写,即Dell的CDC(集中控制发现器)实现。我看到了Ansible、RESTful API和命令行的支持。

以上相关资源链接,大家下载以下链接的文档,就可以找到并访问。

参考资料 https://www.snia.org/sites/default/files/ESF/NVMeTCP-Performance-Deployment-and-Automation.pdf

原文:企业存储技术

推荐阅读

- SmartNICs/DPU Summit 2023会议资料分享(共28份ppt+pdf)

- Xeon w9-3495X 56核工作站测试(2):CPU与GPU渲染之争结束了吗?

- Xeon w9-3495X 56核工作站测试(1):BenchMark解读与性能优化参考

欢迎关注企业存储技术极术专栏,欢迎添加极术小姐姐微信(id:aijishu20)加入技术交流群,请备注研究方向。