前言:制造、媒体娱乐、BIM行业的渲染需求

在工作站面向的用户群中,第一大行业是制造业(包括CAD/CAE),第二大是媒体和娱乐(DCC,数字内容创作)。这2大行业都会有渲染的需求,但应该说影视特效制作和动漫产生的渲染需求量更大,想想视频一秒钟多少帧就可以了。

就像互联网公司更愿意尝试“开源”等新技术那样,在我看来,媒体和娱乐业在工作站上运行的软件(ISV),普遍对GPU等新硬件特性的支持相对积极;而传统制造业似乎显得有些保守?但也不是绝对的,比如同属Dassault旗下的两大CAD软件中就有一个较为“激进”——不是CATIA而是收购来的,参考《SolidWorks渲染测试:CPU & GPU光线追踪性能、画质对比》。

工作站还有一个不容忽视的市场——AEC(建筑、工程、施工),Autodesk Revit、Bentley等在BIM软件领域占有重要地位。回想起早年那些用3ds Max渲染建筑效果图的设计师,如今客户的需求往往不只是效果图了,像家装设计都经常会有三维实景预览(漫游)。实时渲染可能有点像游戏场景的处理吧,比效果图允许适当降低质量,一般会比较依赖GPU。当然,工作站的硬件性能也早已今非昔比。

回到今天我讨论和测试的主题,工作站用户在做最终(离线,相对于实时而言)图像/视频渲染时,一般有2个选择:一个是设计软件集成的渲染器;或者导出模型到外挂渲染器/第三方插件来处理,前者比如SolidWorks内置的PhotoView 360(CPU渲染),后者则包括我之前测试比较多的SolidWorks Visualize组件(对GPU优化良好)。

当然也不是有了高效的GPU渲染器就没人用CPU了,这里面不完全是技术原因(还有一个软件License是否包含的问题);另外在前几年我还听专门做云计算的朋友讲,有些V-Ray渲染用户的模型还是依赖CPU不好改,不知现在这部分的比例是否缩小了?

目录

Blender 3.6:CPU vs. GPU渲染效率多余之谈?

V-Ray 5.0渲染器测试

CINEBENCH R20、R23验证

Autodesk Revit BIM模型渲染:Intel 56核vs. AMD 64核

在上一篇《Xeon w9-3495X 56核工作站测试(1):BenchMark解读与性能优化参考》发布之后,收到了不少读者朋友有价值的反馈。其中不止一位提到了与AMD对比;也有下面这位老哥留言所指——如今CPU在工作站上的地位,是不是被GPU反超了呢?

Intel Xeon W 56核 vs. AMD线程撕裂者64核,在本文中我就会进行对比,虽然只是测试中的一项。GPU显卡当然也是不应回避的讨论——特别是本文的“渲染”应用方向。既然把这些写出来,能否做到不吹不黑的立场,请读者朋友们自辨:)

本文测试的主角,仍然包括在Dell Precision 7960 Tower!工作站LGA-4677插座上的这颗CPU。

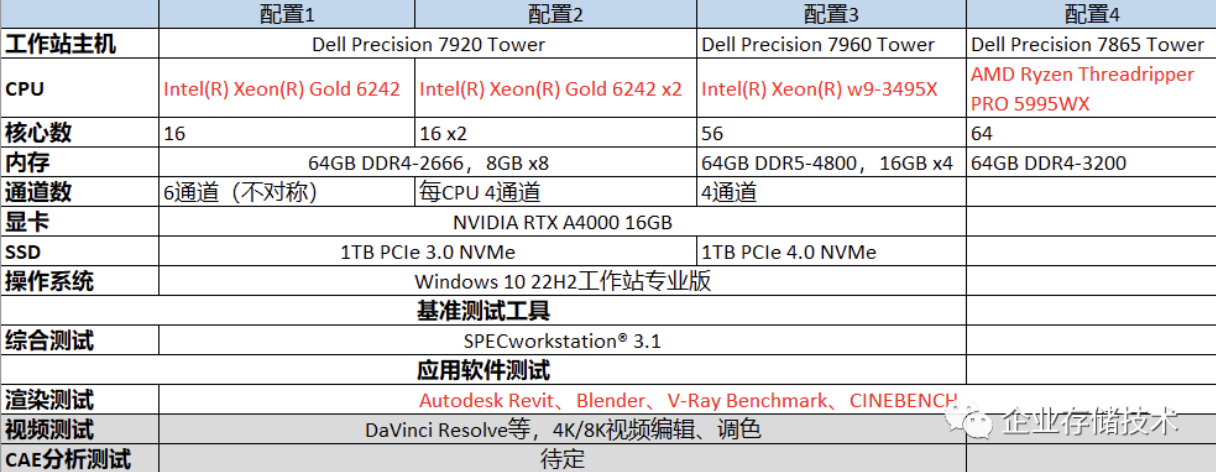

测试平台

上面这个测试配置/项目表,与之前一篇的区别主要是加入了AMD平台。当您看到本文最后,还会发现“隐藏”的第5款CPU配置。

Blender 3.6测试:CPU vs. GPU渲染效率多余之谈?

免费、开源是Blender的标签,而这次我选择用它测试,更多则是因为对上一篇中SPECworkstation 3.1测试集同一软件的部分结果不够满意,没能充分反映出多核、双CPU在渲染应用中的差别。所以才要进一步验证。

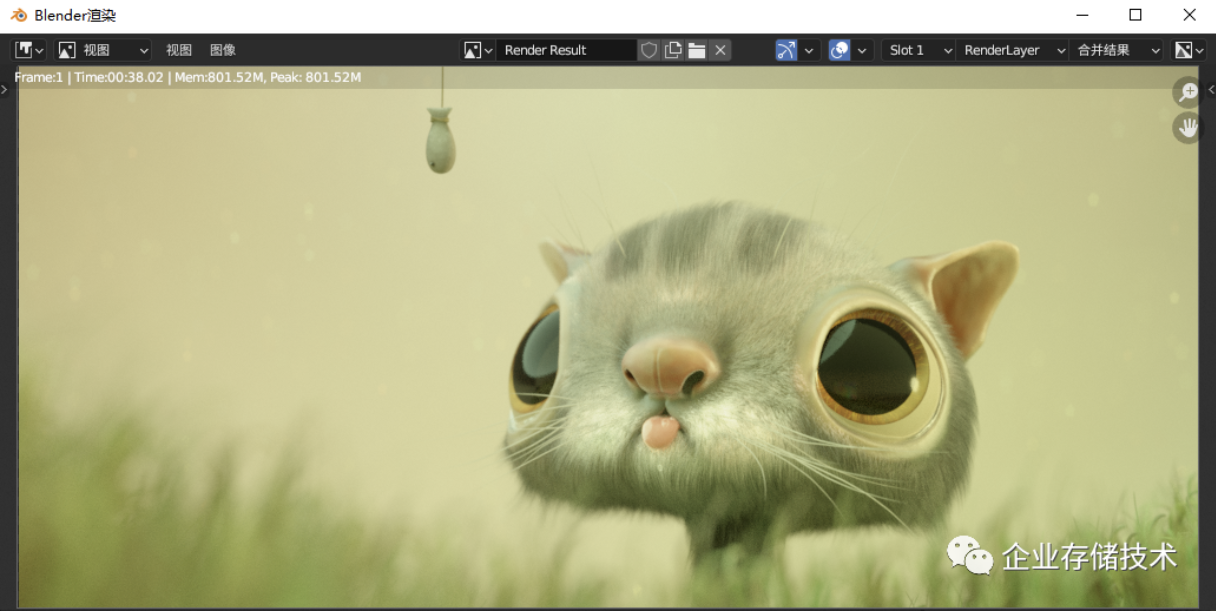

上图这个Fishy cat场景,在Intel Xeon w9-3495X 64核CPU上渲染只用了38.02秒;我以前在Dell移动工作站上,跑到75W功耗的Core i7-10875H 8核CPU渲染需要5分39秒。

扩展阅读:《让45W TDP CPU稳跑75W的秘密:Blender渲染测试(含Optix去噪点)》

GPU渲染时也能选择让CPU一起干活,这种支持较为普遍。

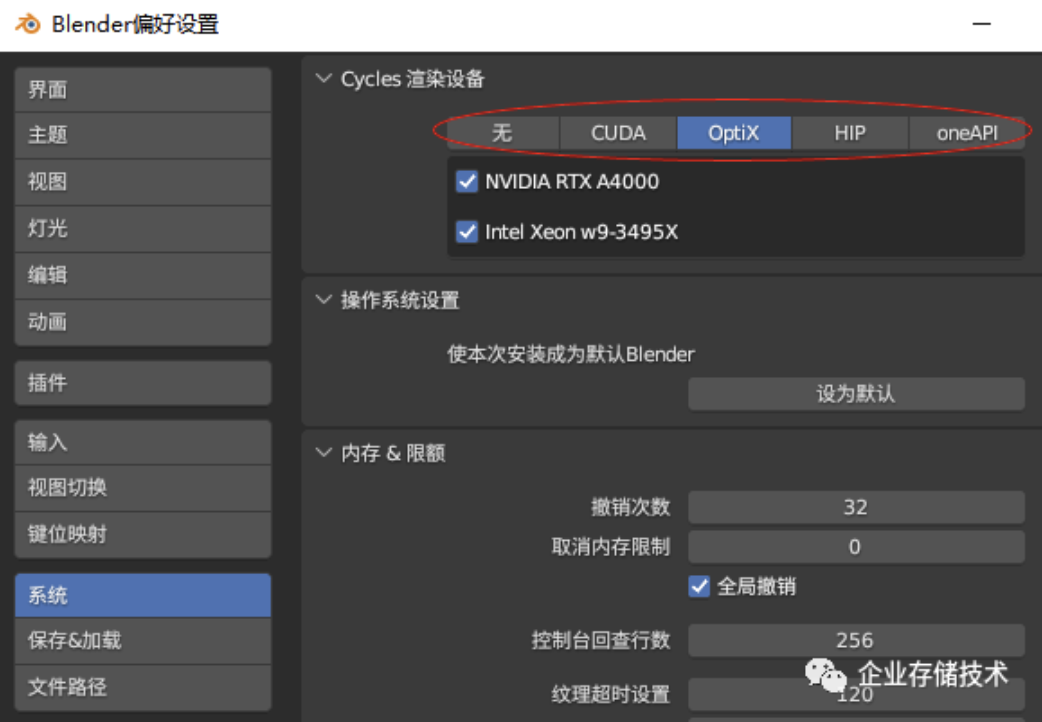

在Blender渲染设备的选择中,最左边的“无”代表单纯CPU渲染,CUDA和OptiX针对NVIDIA GPU,右边的HIP、oneAPI则分别对应AMD和Intel显卡。由于我本次搭配测试的RTX A4000显卡可以良好支持光线追踪,所以GPU部分的参考对比性能,统一选择在Blender中效率更高的“Optix”选项。

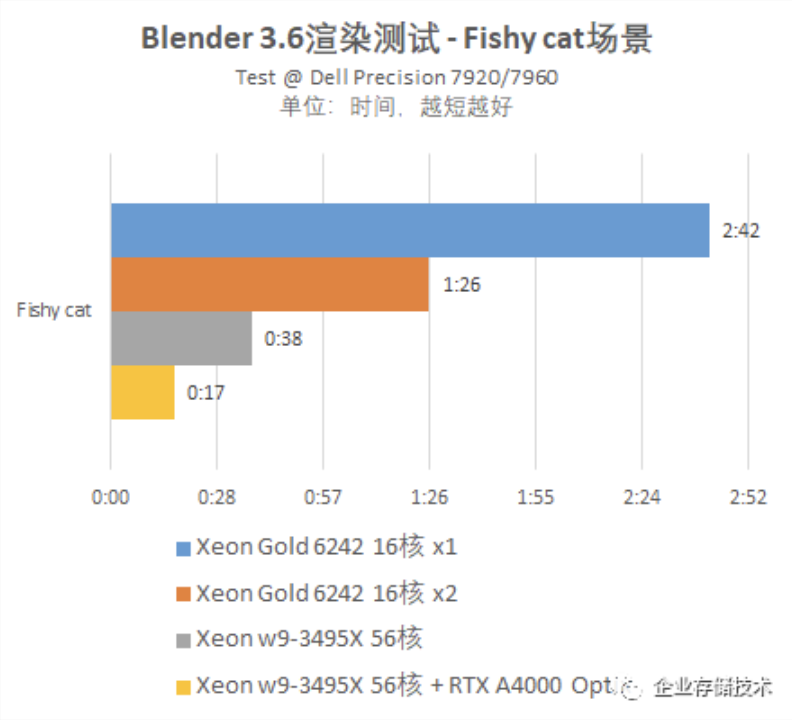

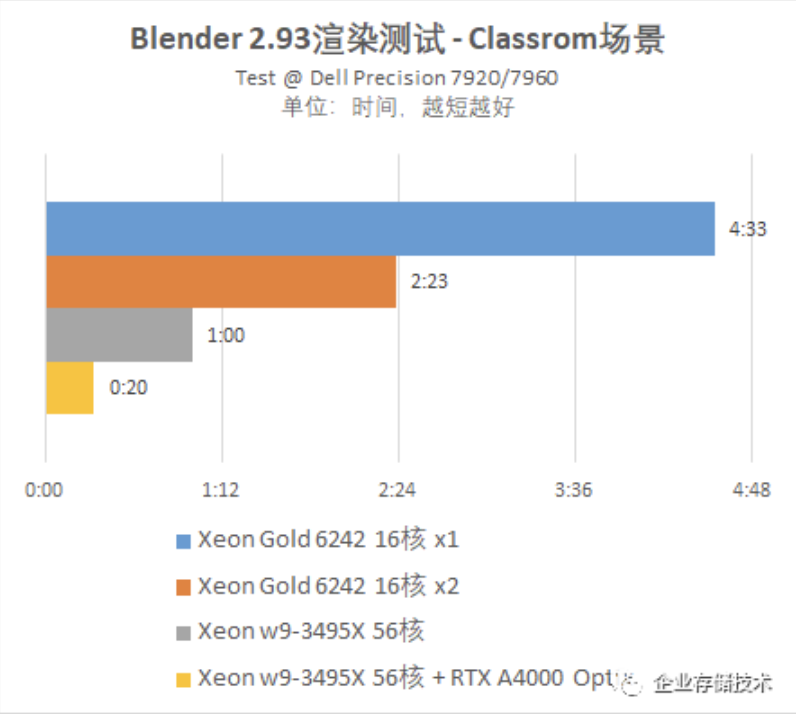

如上面图表,首先我看到在优化较好的渲染应用中,2颗Xeon Gold 6242 CPU比1颗有着理想的提升;56核Xeon w9-3495X的性能则达到了2颗16核的2.26倍,可见即使换成2颗上一代的28核Xeon 6258R,也是新品的单路Xeon W工作站完胜。

但实话讲,在Blender测试中CPU还是无法与GPU相比。在过去的《GPU渲染/光线追踪测试:NVIDIA RTX A4000 vs. GeForce 3070》中,我单纯用RTX A4000显卡渲染这个Fishy cat需要59秒——Core i7-11700K CPU能帮这个数字再缩短9秒。而本次A4000 GPU加上Xeon w9-3495X只需要17秒,看来新版本Blender 3.6的软件效率也提高了。

从时间对比来看,在Optix渲染时GPU的贡献比CPU还是要多一些。RTX A4000显卡比Xeon w9-3495X CPU要便宜多了吧?并且它只是140W设计功耗,而CPU的TDP已经达到350W了。与A4000大致同等算力的RTX 3070,性价比更高些,但能耗比不如专业显卡。最新一代NVIDIA Ada GPU的能耗比还会提升。

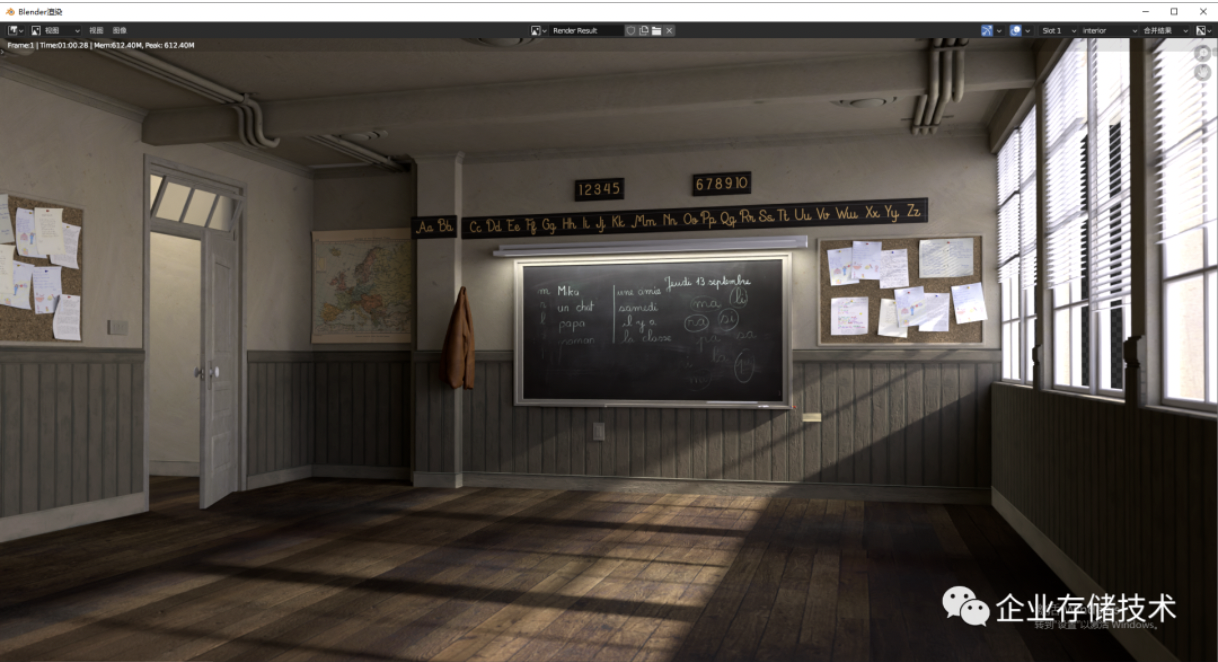

第二个Classrom场景,在Intel Xeon w9-3495X 64核CPU上渲染用了1分00秒;以前我在低版本Blender上用A4000显卡渲染用时1分14秒。

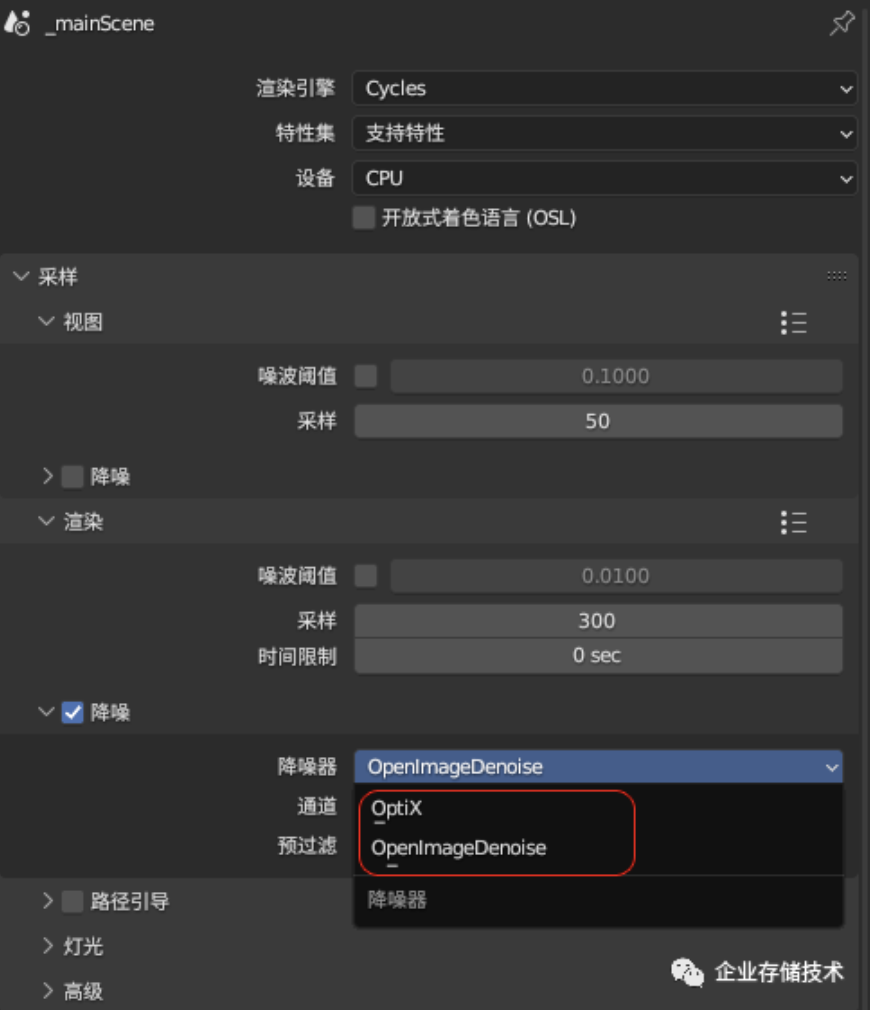

Blender这个Classrom场景的渲染,需要勾选降噪器来去除噪点。上面的Optix和OpenImageDenoise分别为运行在GPU和CPU上的算法,经我观察图像效果差别不大。

打开OpenImageDenoise降噪器之后,对CPU渲染性能的影响微乎其微,甚至我们在GPU+CPU渲染时,让降噪跑在CPU上有时效率还能更高一点。

三款CPU配置在上图中的对比,与前面一个Blender渲染场景差不多;本次测试还是RTX A4000 Optix + 56核CPU跑得最快。

再多透露一点,我参考过AMD 64核CPU的Blender Benchmark测试结果,与Intel 56核差距不大。不过如果只看这一应用场景的话,预算充足的用户可以侧重考虑投资在GPU上,把显卡提升到GeForce 3090或者4080/4090如何?

V-Ray 5.0渲染器测试

V-Ray的CPU渲染测试,我选择使用Chaos发布的BenchMark工具。

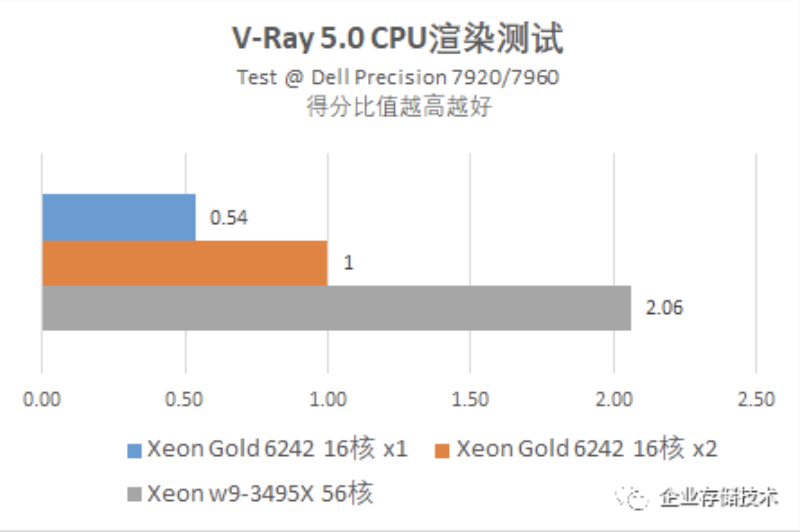

我按照2颗Xeon Gold 16核CPU得分比值为“1”来计算,Xeon w9-3495X再次跑出了两倍以上的性能。

CINEBENCH R20、R23验证测试

CINEBENCH测试在发烧友中流行度较高,而Cinema4D软件的实际用户群体似乎不是太大,至少国内这样吧。

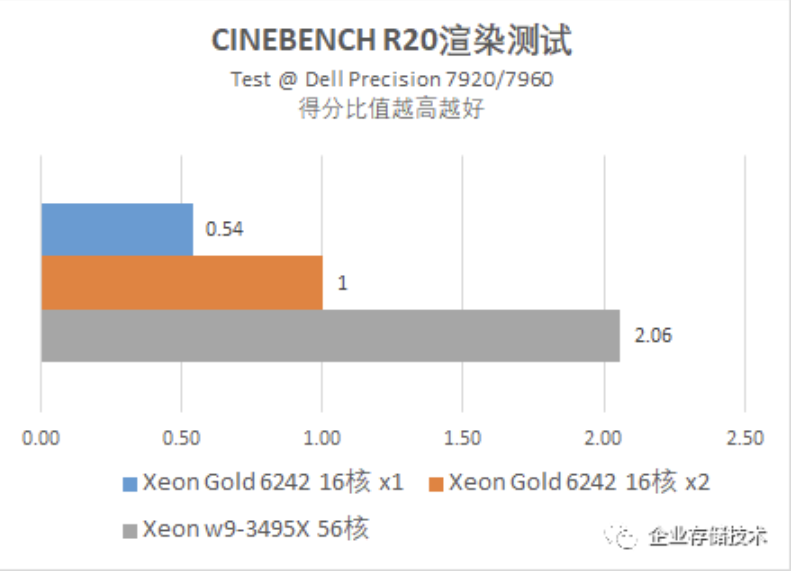

CINEBENCH R20的默认测试,放在今天的高端CPU上很快就能跑完。上面这结果是保留2位小数的比值,与前面的V-Ray测试如出一辙。

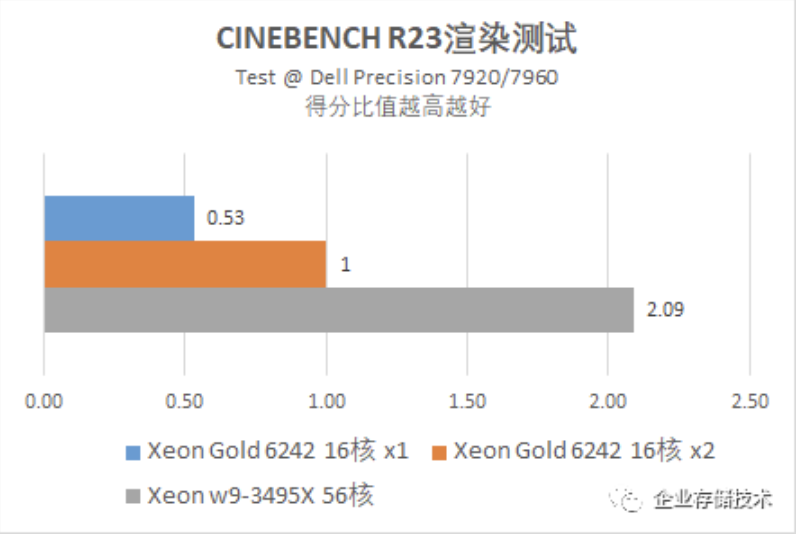

CINEBENCH R23渲染的还是同一张图,但默认测试时间达到10分钟,也就是说对CPU频率的稳定性要求更高了。

在10分钟的测试中,Xeon w9-3495X的优势更大了一点。我不确定这是否与CPU的新指令集有关?但从性能稳定性来看,Xeon W-3400和W-2400系列也都是脱胎于服务器CPU的。

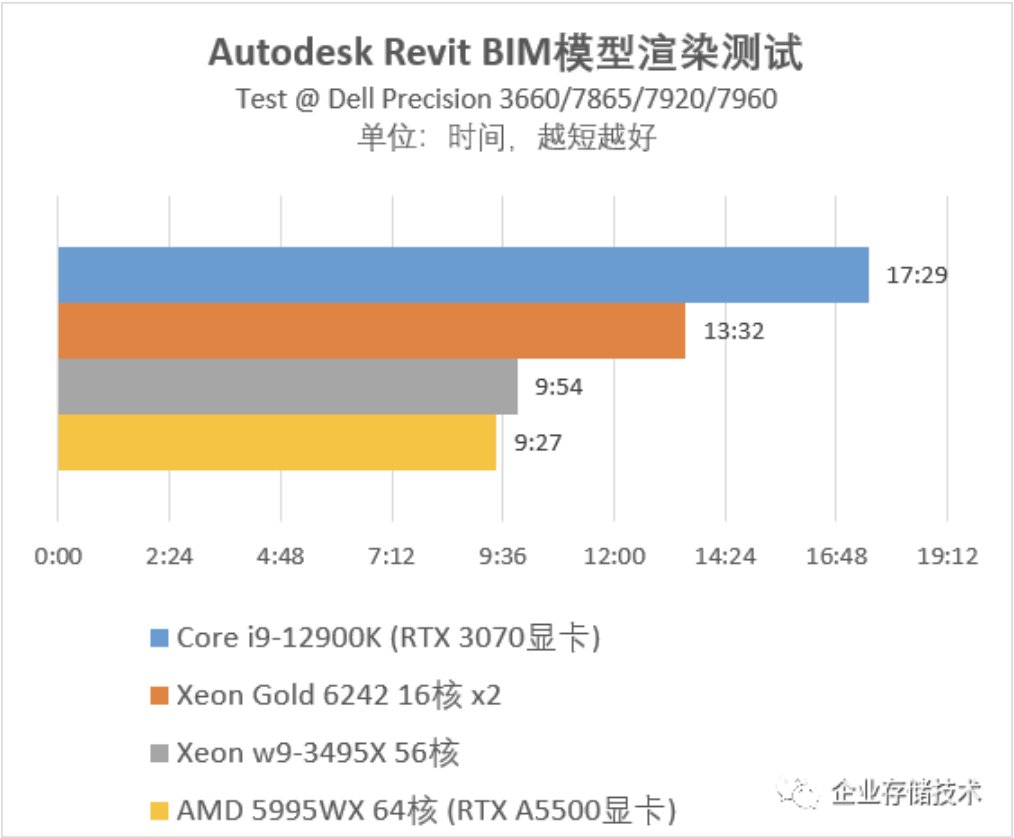

Autodesk Revit BIM模型渲染:Intel 56核vs. AMD 64核

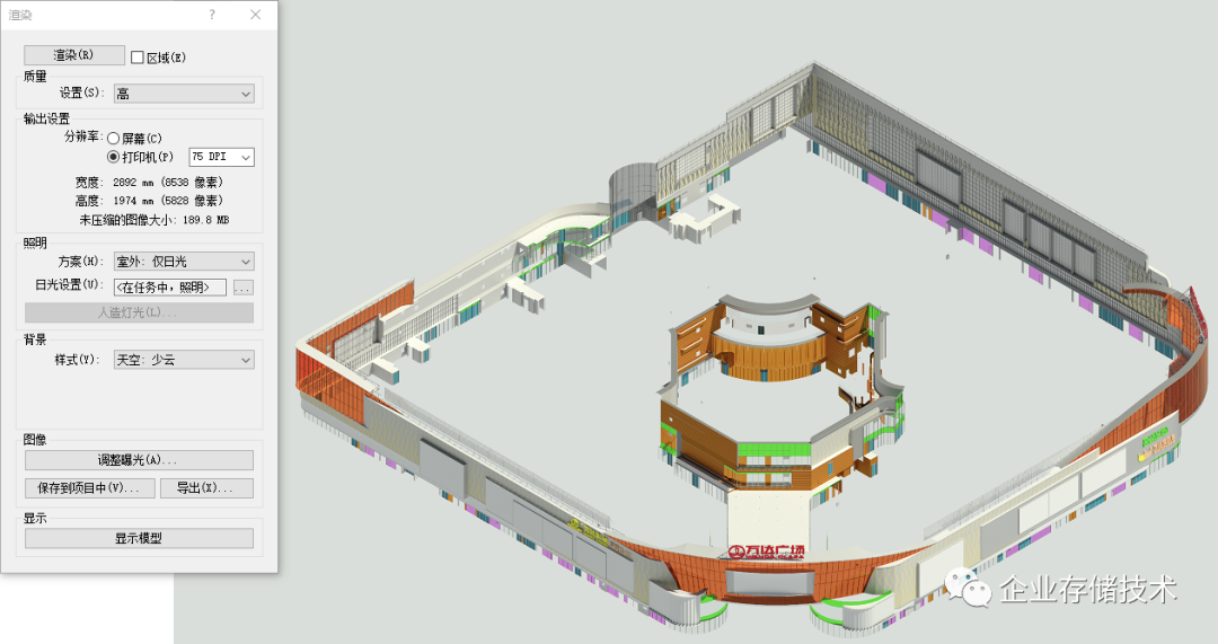

最后一项测试,我认为反而是本文中比较有“特点”的。该建筑模型来源于一次真实的PoC选型测试。

Revit渲染测试模型描述:本次测试使用的是施工图阶段的商业综合体(10万平米)幕墙模型,建筑设置内外庭院,幕墙为双面幕墙,模型精度为LOD350,模型信息达到算量精度,可以BIM算量。

参与这部分对比的,除了我在前面使用的Precison 7920和7960 Tower工作站之外,还有12/13代Intel Core平台的Dell 3660,以及同样为顶配CPU——AMD Ryzen Threadripper PRO 5995WX 64核的7865机型。

注:在Revit渲染测试的方法探索,以及部分机型的测试成绩上,有我同事颜飞的贡献。

与Blender和专门的渲染器V-Ray相比,我对Revit自带渲染模块的性能评价是偏弱的。一方面对CPU多核支持不够好,特别是超过16核之后看不到线性提升了;另一方面,虽然看到GPU参与其中,但主要还是CPU干活。

上面图表并不能证明AMD 64核CPU在这个测试中就一定强于Intel 56核,因为当初配置的显卡不一样——以前我们对比过这方面是有些影响的。我也标注了:Core i9-12900K测试搭配的GeForce 3070与我本次使用的RTX A4000在Revit中大致相当;但线程撕裂者5995WX测试时搭配的A5500显卡性能较高,当前并不在我手里,所以只能给大家一个粗略的参考。

初步来看,如果跑Revit建筑应用,在Precision 3660 Tower这一等级工作站上的Core CPU性价比更高。

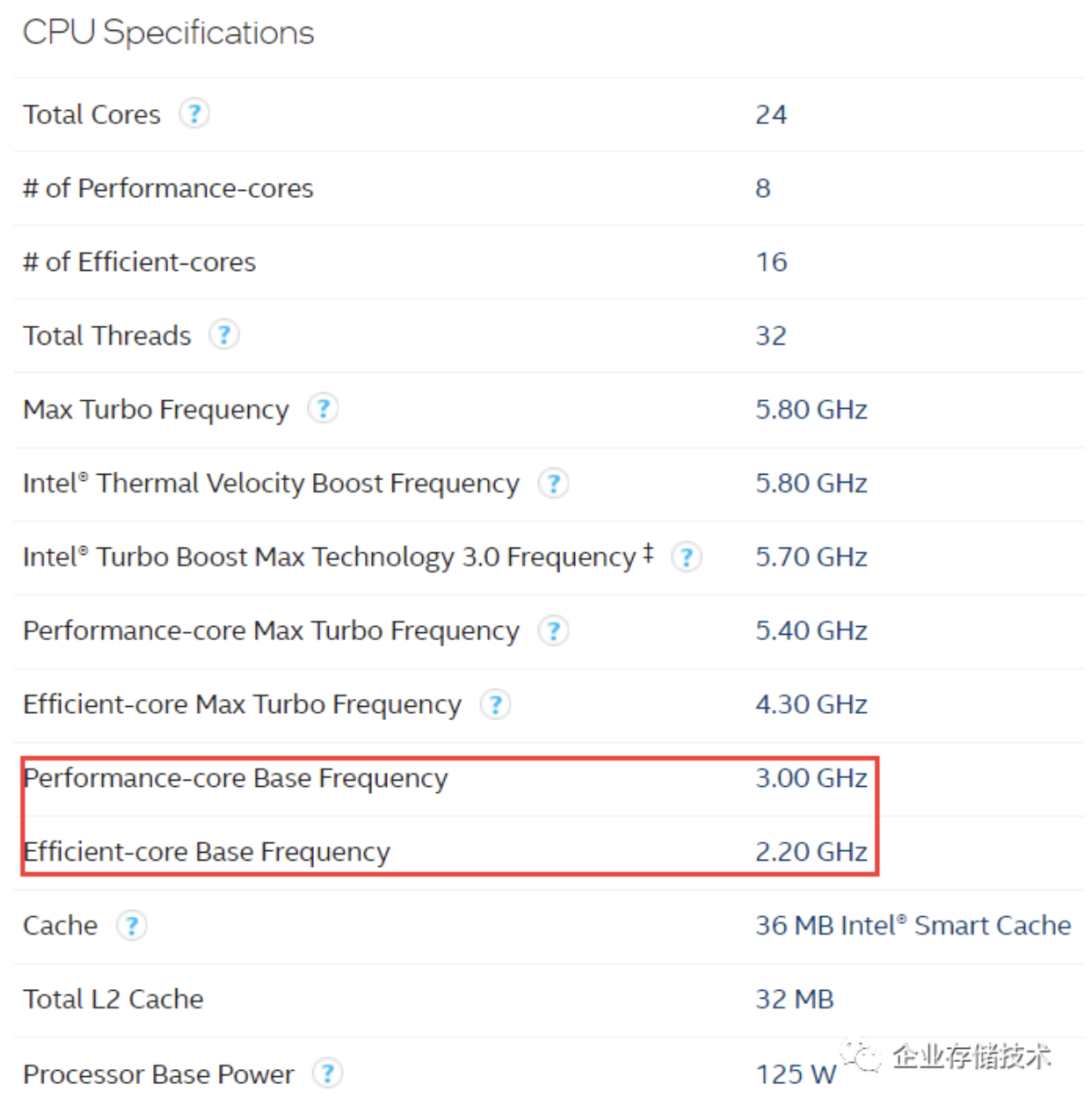

上图源自https://ark.intel.com/网站的Intel® Core™ i9-13900K Processor规格。尽管它的大/小核在125W TDP下基础频率只有3.0和2.2GHz,但别忘了这可是8个P-Core+16个E-Core同时运行的状态。

我感觉,对Revit渲染效率要求较高的用户,多半会安装第三方渲染器/插件,或者导出到3ds Max、NVIDIA Omniverse等软件中。而只需要一张高质量效果图的人估计也还有,早在20多年前我就看到有的同行朋友分享:“如果下班后晚上渲染,赛扬CPU也可以慢慢跑,只要第二天上班前完成就行。”

注:多台主机(包括服务器)参与的集群渲染,也是提高输出速度的一种有效方式。

小结与展望

本文的测试结果看似平淡,却反映了一部分工作站应用的实际情况。

一方面,像渲染这样的多线程并发计算任务,传统上对多核CPU支持较好,但如今已逐渐转向GPU,特别是NVIDIA CUDA、RTX/Optix;

另一方面,有些“优化欠佳”的单进程多线程应用,在CPU核心超过一定数量后,难以再获得理想的提升;甚至我遇到过个别的计算程序,分布在较多核心时反而出现性能下降的情况(不代表普遍性)。

我们看到一些工作站的代表机型,比如Dell高端的Precision 7960 Tower,在Intel CPU从上一代28核翻倍到56核之后,就只在主板上设计了1个CPU插座。而这依然保证了扩展性——可支持16条DDR5大容量内存,以及4块PCIe x16双宽GPU显卡(其中有2个可以是3-Slot宽度)。包括Intel在这一市场中策略的变化,也是工作站应用发展所引发的吧。

那么超多核CPU的意义又在哪里呢?大家可以参考我在前面一篇综合测试中介绍的CAE等计算应用;而在许多3D设计软件的图形交互操作界面,有时显卡资源过剩而CPU单线程性能依然是瓶颈——工作站用户&业内人士总是在翘首期盼Intel/AMD CPU的主频再提高。

本文后续还将有1-2篇应用评测,带读者朋友们看看还有哪些CPU的计算处理是GPU无法替代的。下面一篇先聊聊Davinci 4K/8K视频编辑、调色,敬请关注:)

原文:企业存储技术

推荐阅读

欢迎关注企业存储技术极术专栏,欢迎添加极术小姐姐微信(id:aijishu20)加入技术交流群,请备注研究方向。