在传统的QAT中,训练的只有权重,而量化参数是根据权重的分布所确定的。有研究者就想,为什么不把量化参数也作为训练对象呢?既然量化参数是可训练的,那么它能被求导,也就是可微的,所以我们可以称这类方法为“可微量化参数”。

Quantize Aware Training(QAT)通过在训练过程中融入量化和反量化过程,来实现量化模型的精度恢复,但考虑一下量化过程显然取整的求导的时候处处为零,是无法训练的。因此QAT需要引入Straight-Through Estimator(STE)来得到一个近似的梯度,也即令,相当于用去近似或来进行求导。通常,如果比特数比较高的时候,这里带来...

Data-free指的是不需要数据,它可以是完全不依赖数据也不利用生成数据,也可以是利用某些手段来生成数据。在量化上,Data-free既可以用于后训练量化,也可以用于重训练量化。Data-free量化的研究主要是希望在真实数据未知的情况下,对输入进行离线量化操作,通常都是借助BN层的统计信息(均值、方差)来直接确定输入的量...

按照是否需要训练划分,量化通常可以分为从头训练(train from scratch)、重训练(retrain)、后训练(post-training)三种,本文主要介绍几种后训练量化的方案,并以线性均匀分布的定点量化为例。后训练量化指的是,对预训练后的网络选择合适的量化操作和校准操作,以实现量化损失的最小化,该过程不需要训练,通常不...

位于互联网边缘的智能、互联和互动设备的成本和功耗不断下降,为我们的城市、工厂、农场和环境创造了巨大的机会,以提高效率、安全性和生产力。作为SMARTER(安全城市、农业、农村和电信边缘研究)项目的一部分,Arm一直在探索在边缘环境中使用云原生技术和方法,以评估其在大规模解决这些问题方面的有效性。

集微网(文/Kelven)时间的巨轮来到9月15日,宽限期已到,华为供应链正式遭遇断供。在今年5月15日和8月17日美国对华为实施第二轮与第三轮的制裁禁令,所有包含美国技术、软件、材料的产品均不准许卖给华为及其相关公司。

非易失性存储器(NVM)是一种计算机即使关闭电源也能够保存已保存数据的存储器。与易失性存储器不同,NVM 不需要定期刷新其存储器数据。它通常用于二级存储或长期一致的存储。

随着科技与经济社会的进步与发展,我国对集成电路的需求在不断提升,发展“芯”技术的机遇已经来临。对于集成电路设计与集成系统,微电子、电子信息工程等相关专业的学生,集成电路相关内容是专业基础课。

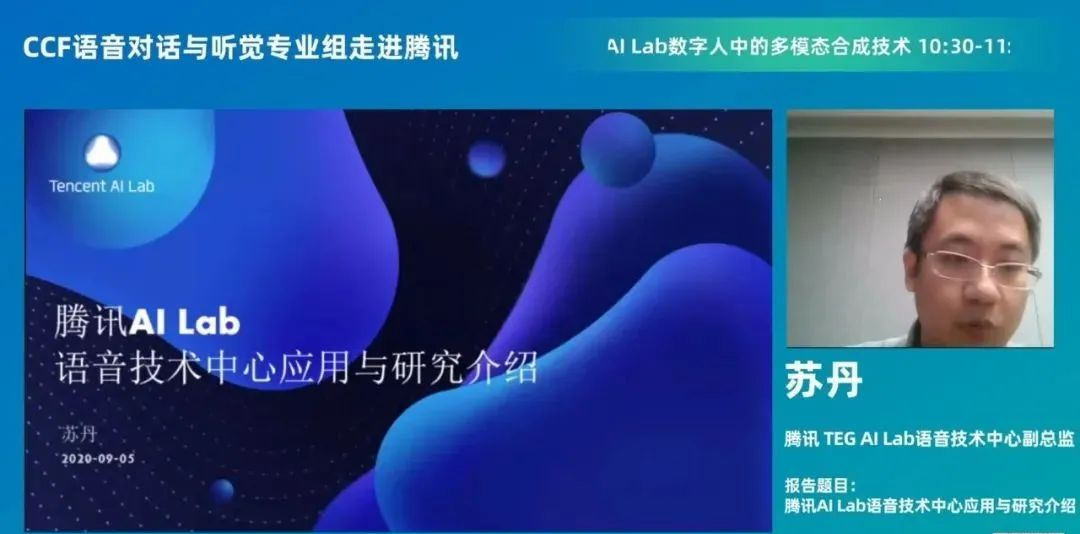

“CCF语音对话与听觉专业组走进企业系列活动”第十期之“走进腾讯”研讨会于上周六圆满闭幕,本次研讨会由上海交通大学钱彦旻副教授主持,并邀请到四位专家介绍腾讯语音及对话领域的最新成果,分别是:

订阅极术公开课,即时获取最新技术公开课信息

嵌入式端AI,包括AI算法在推理框架Tengine,MNN,NCNN,PaddlePaddle及相关芯片上的实现。欢迎加入微信交流群,微信号:aijishu20(备注:嵌入式)

Arm相关的技术博客,提供最新Arm技术干货,欢迎关注

MegEngine「训练推理一体化」的独特范式,通过静态图优化保证模型精度与训练时一致,无缝导入推理侧,再借助工业验证的高效卷积优化技术,打造深度学习推理侧极致加速方案,实现当前业界最快运行速度。本文从推理侧的数据排布(Inference Layout)讲起,接着介绍MegEngine的Im2col+MatMul、Winograd、Fast-Run工程优化实...

深度模型压缩、加速、自动搜索。

目标检测中最经典的损失函数就是Faster RCNN所用的“softmax交叉熵分类损失 + SmoothL1回归损失”的形式,后来有很多改进的目标检测网络、方案也陆续提出了一些损失函数上的改进。

论文:《Squeeze-and-Excitation Networks (CVPR2018)》提出了SE模块,是注意力机制的一种应用,学习特征图上通道间的相关性,作为权重ReScale各个通道;SE模块相当于一个轻量级的插件,可以方便地插入到已有的网络中去。SE模块深受研究者们的喜爱,可以看到后来的新网络都热衷于使用SE模块。但实际应用中,带有SE模块的...

原文链接:[链接]参考:《Hands-On Machine Learning with Scikit-Learn and TensorFlow(2017)》Chap13《卷积神经网络——深度学习实践手册(2017.05)》CNN的典型组合方式是,以 卷积层+激活函数(比如relu)+池化层 作为一组操作;一张图片经过若干组这样的操作的stack之后,变得越来越小,同时越来越深(feature maps越来...

原文链接:[链接]参考:《Hands-On Machine Learning with Scikit-Learn and TensorFlow(2017)》Chap11torch.optim常见的加速训练技术:恰当的的权重初始化策略:打破初始值的对称性,初始值也不能太小恰当的激活函数:选用导数数值范围稍大的函数批量归一化:平滑损失平面复用部分预训练网络:复用预训练结果使用恰当的...