OPEN AI LAB发布MCU级AI推理框架Tengine-Lite,搭配开源关键词识别算法“小智”,吹响万物智联的冲锋号,引发嵌入式AI应用开发的新革命。

智能从云到端,MCU助力万物智联

2017年OPEN AI LAB发布了嵌入式推理框架Tengine与计算库HCL,让原本桌面级CPU/GPU才玩得动的高级AI应用在Arm处理器上也能流畅运行,大大加速了AI应用的普及。目前,Tengine已经在人脸门禁、智能家居、智慧零售等几十种场景及数百万台设备中被部署和使用。

随着IoT设备的不断增加和AI技术的逐渐成熟,人们追求更加智慧便捷的生活,这就要求更多的设备具备智慧的能力,比如各种家用电器、门锁、灯具、甚至小到一个用锂电池供电的环境传感器。覆盖这些设备和场景需要极低的硬件成本及功耗,并且要求极高的稳定性和可靠性。传统的服务器方案和应用处理器方案完全不能满足需求,因此只有MCU方案才是最理想的选择。

在MCU上开发AI应用,在两年前听起来还是天方夜谭,因为MCU缺乏成熟的开发工具,无论是模型转换还是应用部署都十分复杂。同时由于MCU硬件计算资源有限且只支持量化计算,因此运行速度低且计算精度没有保证 。但如今,这些难题被OPEN AI LAB一一攻克了,OPEN AI LAB发布能够引爆行业的跨时代产品Tengine-Lite —— 一个可以在MCU上运行的AI推理框架!

Tengine-Lite定义MCU AI应用开发

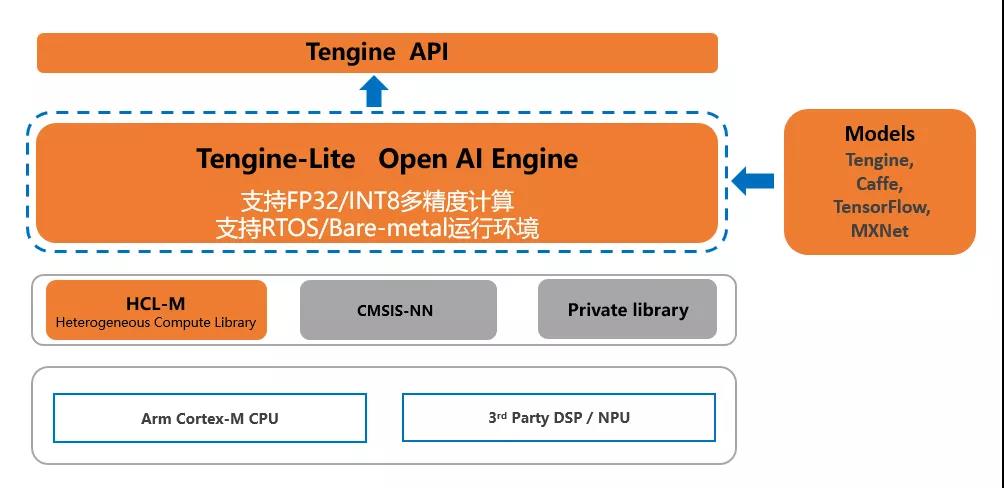

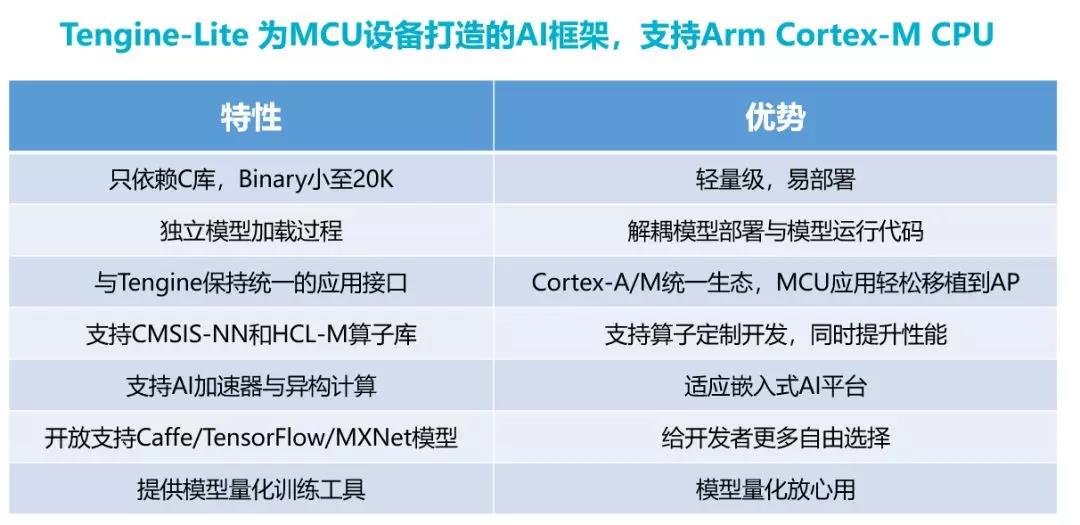

Tengine-Lite是专为MCU设计的超轻量级AI推理框架,采用应用程序与模型分离的开发流程,纯C语言开发,支持裸板开发、也支持RTOS操作系统,程序体积最小可至20KB,能够适用于极端苛刻的MCU嵌入式开发环境。

为了解决计算资源与精度问题,Tengine-Lite针对在MCU广泛使用的Arm Cortex-M CPU上提供了HCL-M计算库,兼容CMSIS-NN,支持FP32与INT8等多种计算精度,除了提供常见NN算子,还提供FFT等常用的前处理算子。搭配Tengine-Lite的量化训练工具能完美解决量化计算带来的精度损失问题。

Tengine-Lite的发布不仅提供了一整套便捷的MCU AI开发工具,还为嵌入式AI软件产业建立了开放的开发生态平台。值得关注的是Tengine-Lite向上兼容Arm中国周易的Tengine应用接口,因此在Tengine-Lite上开发的应用都可以在广泛部署的周易平台运行。Tengine-Lite开放支持TensorFlow/MXNet/Caffe等模型,给予开发者自由选择的权利。Tengine-Lite还会支持第三方DSP及AI硬件加速器,赋能MCU+AI芯片。

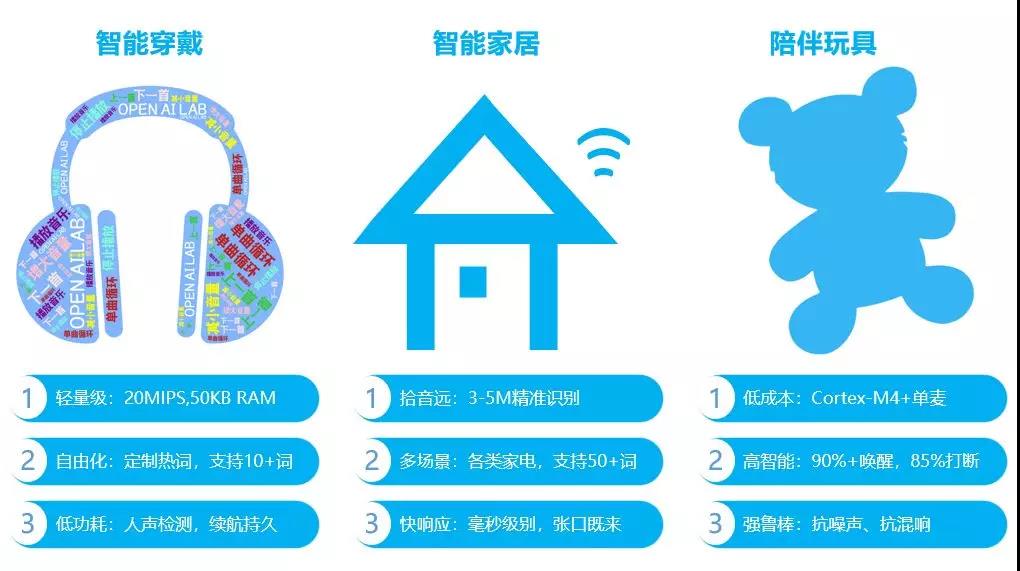

MCU中文语音关键词识别算法——AID.Speech

与Tengine-Lite同时发布的还有MCU中文语音关键词识别算法。OPEN AI LAB作为嵌入式AI行业的领导者,2018年率先在业界推出了单MCU单麦语音中文关键词识别方案“小智小智”,该方案基于Cortex-M4内核,能在Tengine-Lite上流畅运行,将智能语音识别方案成本大降了50%以上。目前,该方案已被广泛应用于儿童故事机、智能家居、蓝牙耳机等产品中。

现在OPEN AI LAB开源了运行于Cortex-M7 的“小智小智”语音识别算法和开发工具,开发者可以根据自己的需求定制关键词。 “小智小智”的模型大小只有66KB, 但识别准确率达95%以上,远超其他同类中英文关键词识别模型,且运行时仅占用13KB RAM,运算量只有1.2Mop,耗时仅18ms,可在MCU上完美运行。

更多关于AID.Speech的介绍请戳>>>能在MCU上运行的语音算法方案介绍及Demo