- 论文题目:Imagination-Augmented Agents for Deep Reinforcement Learning

所解决的问题?

背景

最近也是有很多文章聚焦于基于模型的强化学习算法,一种常见的做法就是学一个model,然后用轨迹优化的方法求解一下,而这种方法并没有考虑与真实环境的差异,导致你求解的只是在你所学model上的求解。解决这种问题就是Dyna架构通过切换world model和real model来实现在real model上具有好的泛化能力。

模型的学习准确精度也很大程度决定了最终算法的性能。并且模型很多时候本身就具有不确定性,那神经网络这种确定性的输出去拟合不确定性的标签是不合适的。因此有了另外一个分支基于概率的。

所采用的方法?

主要就是在model-free的框架下增加了一个想象的过程,预想未来将会发生什么,然后将这个想象信息作为辅助决策变量。既然有想象部分,那就一定会有对未来的预测,因为预测就是想象,而换一个名词再引用几篇神经学科的文章,就能瞬间提高文章档次。

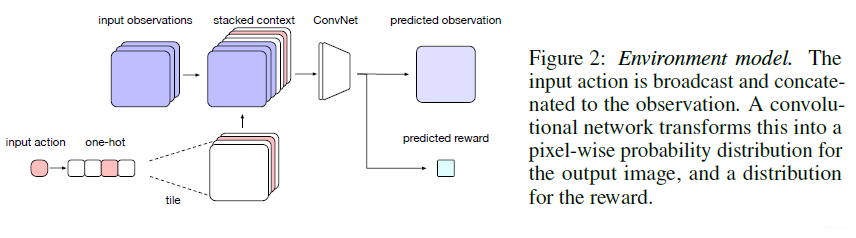

Enviorment Model

基于动作条件的模型预测结构如下图所示。

接收当前观测和动作,预测下一帧观测和奖励。动作的选取来自rollout policy,这个policy通过模仿智能体与真实环境得到的轨迹所得到,这种非完美的近似对平衡探索和利用也具有潜力。

整体框架

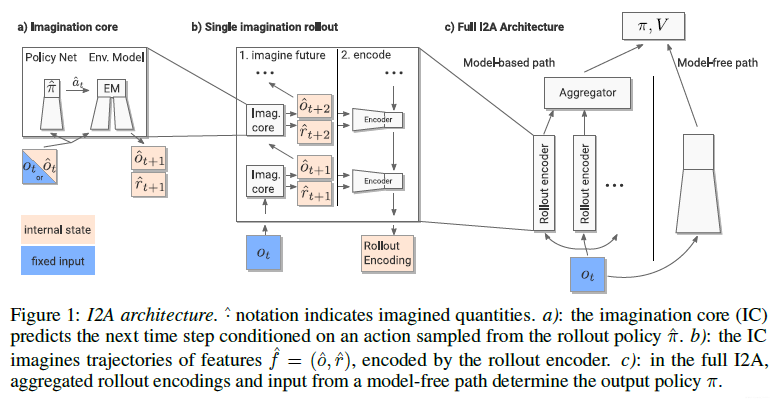

动作的选择来自rollout policy $\widehat{\pi}$ ,基于这个策略预测下一个时候的观测和奖励,组成Imagination core模块(下图中左图部分)。基于这个模块预测$n$ 条轨迹 $\hat{\mathcal{T}}_{1}, \ldots, \hat{\mathcal{T}}_{n}$,每条trajectory都由一系列特征组成$\left(\hat{f}_{t+1}, \ldots, \hat{f}_{t+\tau}\right)$ ,其中$t$ 表示的是当前时刻,$\tau$表示rollout的长度,$\hat{f}_{t+i}$表示环境模型的输出(下一帧观测/奖励)。

尽管有很多很好的训练环境模型的方法,但是一个很关键的问题就是不可能得到与真实环境模型一样的完美预测模型。因此作者这里这里使用的是trajectories进行编码,这是因为一个轨迹中所包含的信息比单步决策所得到的信息要更多。每条轨迹编码可表示为:$e_{i}=\mathcal{E}\left(\tilde{\mathcal{T}}_{i}\right)$,最终将其集成,得到:$c_{\mathrm{ia}}=\mathcal{A}\left(e_{1}, \ldots, e_{n}\right)$。

基于当前的观测和model-based的对于未来的预测信息,输出策略向量$\pi$和评估值函数$V$。如果没有model-based这条路径的话,I2A就是一个标准的model-free框架。

取得的效果?

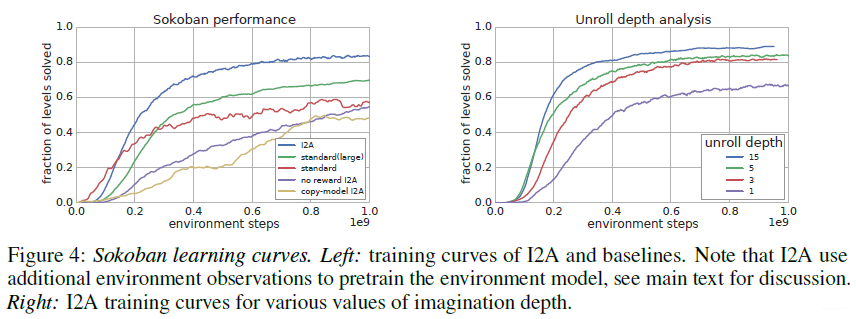

在经典规划问题Sokoban上的实验结果。

上图中standard表示standard model-free agent。I2A能够解决85%的问题,而标准的智能体不到60%。右图表示的是rollout的深度对性能的影响。

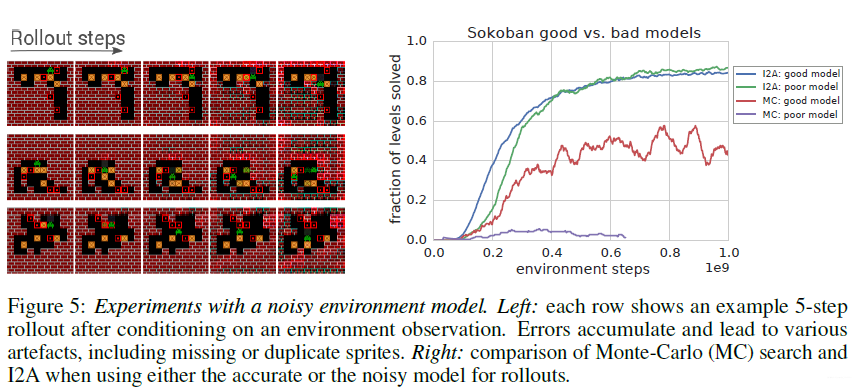

预测模型性能对整体性能影响结果。

所出版信息?作者信息?

文章来自DeepMind团队2017年的论文。已被NIPS2017接收。作者Théophane Weber,DeepMind资深研究科学家,博士就读于MIT。研究方向为机器学习和人工智能,深度学习,强化学习和基于模型的RL,概率建模(和概率编程)以及可变推理方法等。