DCNN在low-level计算机视觉领域取得越来越多的关注,研究者往往采用非常深的CNN提升其性能。然而,随着深度的提升,浅层的特征影响逐渐被弱化。受此启发,作者提出了注意力引导的去噪CNN:ADNet,它包含稀疏模块、特征增强模块、注意力模块以及重建模块。特别的,(1)稀疏模块通过采用扩张卷积与常规卷积移除噪声在性能与有效性方面取得均衡;(2)特征增强模块通过长路径集成全局与局部特征信息增强去噪模型的表达能力;(3)注意力模块用于提取隐藏在复杂背景下的噪声信息,它对于复杂噪声图像(尤其是真实噪声图像与盲噪声)极为有效;(4)特征增强模块与注意力模块相集成提升的去噪模型的有效性并降低计算复杂度;(5)最后,重建模块通过所得噪声图与输入噪声图像生成清晰图像。作者通过充分的实验验证了所提方法在三个任务(合成噪声图像,真实噪声图像,盲噪声)下的有效性(从定性与定量方面评估)。 首发知乎: https://zhuanlan.zhihu.com/p/107230809

文章作者: Happy

Method

如上图所示,本文所提ADNet包含17层,四个模块:SB,FEB,AB以及RB。这里假设

FEB包含4层,以SB的输出作为输入,它充分利用了全局与局部特征增强去噪模型的表达能力。该模块可以描述为:

FEB后接AB,它包含1层,用于从复杂背景中提取噪声信息。该模块可以描述为:

RB以前述结果作为输入,联合输入噪声图像生成清晰图像。该过程可以描述为:

Loss

损失函数选用MSE进行参数优化,可以描述为:

Experiments

训练数据:BSD400+Waterloo(合成数据);RealNoise(真实数据);

测试数据:BSD68,Set12,CBSD68,Kodak24,McMaster,cc。

训练过程中,BatchSize=120,Epoch-70,Adam, lr=1e-3,MultiStone=[30, 70]

下面仅给出了所提ADNet与其他方法的性能对比与视觉效果对比,更多消融实验分析详见原文。下表给出了BSD68数据集上的性能对比。

下表给出了Set12数据集上的性能对比。

下图给出了Kodak数据集上的视觉效果对比。

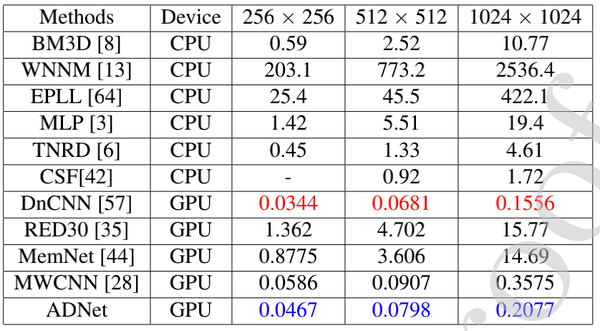

下表给出了不同去噪方法的耗时对比分析。

Conclusion

本文的主要贡献总结如下:

- 稀疏模块(SB)采用扩张卷积与常规卷积提升去噪性能、降低计算复杂度;

- 特征增强模块(FEB)采用长路径集成全局与局部特征用于增强去噪模型的表达能力;

- 注意力模块(AB)用于在复杂背景中提取更精确的噪声信息;

- FEB+AB组合改进了去噪模型的有效行,同时降低了计算复杂度;

- ADNet在合成噪声与真实噪声以及盲噪声数据上均取得了SOTA性能。

推荐阅读:

本文章著作权归作者所有,任何形式的转载都请注明出处。更多动态滤波,图像质量,超分辨相关请关注我的专栏深度学习从入门到精通。