GAN 论文阅读笔记!共六篇,本文为第二篇。

来源:https://zhuanlan.zhihu.com/p/58184683

作者:林小北上文《GAN论文阅读笔记2:不懂W距离也能理解WGAN》从两个角度解释了WGAN的原理。WGAN对原始GAN梯度消失的原因从数学上给出了比较漂亮的解释,并且基于W距离的思想给出了改造方案。然而这套改造方案并不尽人意。

- Lipschitz,WGAN的阿喀琉斯之踵

WGAN通过把判别器的每一层神经网络的参数clip到[-1, 1]区间,来保证判别器的Lipschitz性质。但是这种简单粗暴的方式会导致判别器的大部分参数都会变成-1或者1,这大大限制了判别器的拟合能力。我们之前提到,GAN及WGAN的理论前提是存在“完美的D”。现在WGAN的这种处理方式,对D的限制条件太强,D未必能及时地变成一个最优的判别器D*,也就破坏了这个前提条件。此外,多数的参数被局限在-1或1,也可能导致D对于G的变化不再敏感,进而导致模型坍塌。更多的分析可以去参阅WGAN-GP一文。

针对WGAN的这个弱点,各路学者们展开了广泛的讨论研究,力图找到一个更好地实现Lipschitz的方式。

2. WGAN-GP

WGAN-GP把Lipschitz条件 替换为 梯度惩罚项(gradient penalty) 。虽然梯度惩罚是一个比Lipschitz更强的条件,但是不会像clip那样导致判别器的参数过于极端。比起clip,梯度惩罚是一个更加柔性的限制条件。

具体而言,在WGAN-GP中,判别器D的损失函数为:

其中, 是真实分布 和生成分布 之间进行插值得到的分布,保证了梯度惩罚对两种分布均有覆盖。

相关链接:

Improved Training of Wasserstein GANsarxiv.org

PaperWeekly 第41期 | 互怼的艺术:从零直达 WGAN-GP

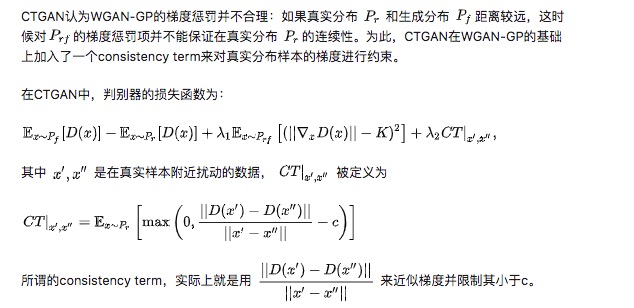

3. CTGAN

相关链接:

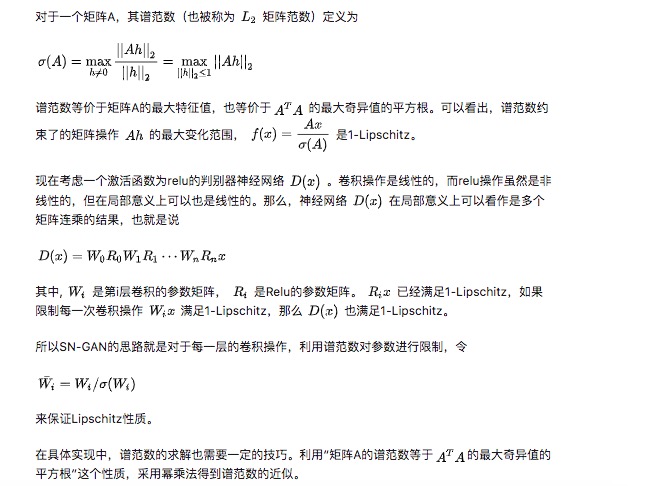

4. SN-GAN

相关链接:

Spectral Normalization for Generative Adversarial Networksarxiv.org

尹相楠:Spectral Normalization 谱归一化

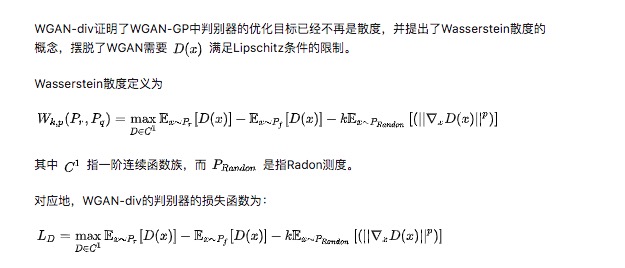

5. WGAN-div

相关链接:

[Wasserstein Divergence for GANsarxiv.org]

张俊:WGAN-div:默默无闻的WGAN填坑者(附开源代码)zhuanlan.zhihu.com

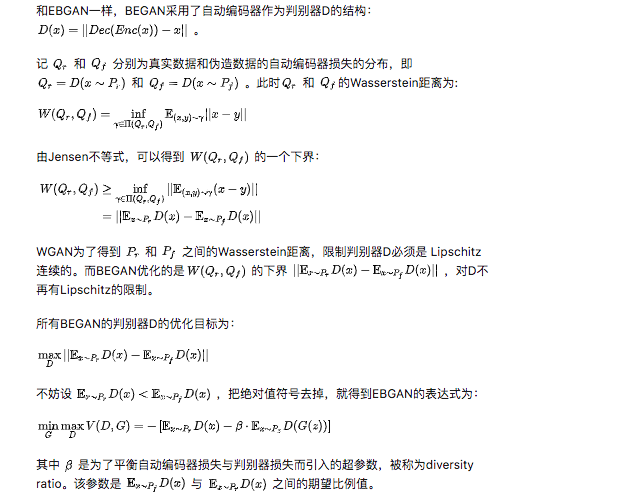

6.Boundary Equilibrium GAN

受EBGAN的启发(后面的笔记会介绍EBGAN),BEGAN提出了一种新的方式来移除WGAN的Lipschitz约束。

7. 总结

WGAN保证Lipschitz的形式太粗暴了,为此便有了本文提到的各种改进形式。个人认为最优雅的改进方式是SNGAN的改进方式,数学上最完备的应该是WGAN-div。

本系列阅读笔记:

更多深度学习,GAN相关论文阅读笔记请关注深度学习论文阅读笔记专栏。

关于作者林小北:毕业于清华大学自动化系,京东算法工程师。

欢迎关注知乎专栏:https://zhuanlan.zhihu.com/c_1080771046889623552