作者: 若晨

首发:3D视觉工坊微信公众号

在自动驾驶领域,场景理解至关重要。本文介绍用于三维场景理解的数据集,数据集分为室内和室外。

1、三维场景理解数据集

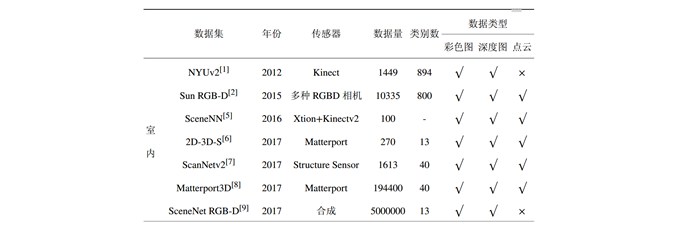

随着深度学习的发展,数据集的意义愈发重要,本节将介绍三维场景理解领域常用的数据集。依据场景类型不同,可划分为室内场景数据集和室外场景数据集,数据集汇总见表1与表2。

1.1室内场景数据集

室内场景数据集多由 RGBD 相机采集,可得到 RGB 图像和深度图像。根据深度图像可以计算得到空间中的三维点云,对基于数据驱动的三维点云算法研究有较大促进意义。这里介绍常用的室内场景数据集:

• NYUv2[1]:数据集地址:https://cs.nyu.edu/~silberman...\_depth\_v2.html。该数据集提供了 1449 张 RGBD 图像,并对图像进行了像素级标注,可用于语义分割和实例分割。根据 RGB 图和深度图,可以自行计算得到对应的三维点云,进行三维点云数据的语义分割和实例分割。提供的数据中, 795 张用于训练, 654 张用于测试。

• Sun RGB-D[2]:数据集地址:http://rgbd.cs.princeton.edu/。该数据提供了 10335 张 RGBD 图像,来源于 NYUv2 数据集[1]、 Berkeley B3DO 数据集[3] 和 SUN3D 数据集[4]。其提供了图像语义分割、 2D 边界框、 3D 边界框、物体朝向、场景类别、房间布局等多种标注,可用于语义分割、目标检测、场景识别等多种任务。其提供了通过 RGB 图和深度图生成的点云数据,可进行三维点云的分割、检测。提供的数据中,一半用于训练,一半用于测试。

• SceneNN[5]: 数据集地址:http://www.scenenn.net/。该数据集提供了 100 个标注的室内点云建图场景,以三角网格的形式提供,并对每个图像像素和每个网格节点均进行了语义标注,同时标注了边界框和物体姿态信息,可用于图像和点云的分割、检测等任务。

• 2D-3D-S[6]: 数据集地址:http://buildingparser.stanfor...。该数据集提供了 270 个标注的室内点云建图场景,分布在 6 个不同的区域。其对图像和点云进行了实例级别的语义标注,可用于语义分割和实例分割。该数据集同时提供了表面法向量的真值。官方建议的训练集和测试集的划分为 3-fold 交叉验证。

• ScanNetv2[7]: 数据集地址:http://www.scan-net.org/。该数据集提供了 1613 个标注的室内点云建图场景,进行了语义和实例级别的标注,可用于图像和点云的语义分割、实例分割,也可以在此数据集上进行场景识别任务。1201 个场景用于训练, 312 个场景用于验证,另外有 100 个场景用于官方在线测试。

• Matterport3D[8]: 数据集地址:https://niessner.github.io/Ma...。该数据集使用了三组彩色相机和深度相机,通过旋转360 度、并进行拼接得到全景图片。其共采集来自于 90 个教学楼场景下的 194400 张 RGBD 图片,拼接得到 10800 张三维全景图片和对应的三维场景。每个场景均进行了实例级别的语义标注,可用于图像和点云的语义分割、实例分割、表面法向量估计。提供的标注数据中, 61 个教学楼场景用于训练, 11 个用于验证, 18 个用于测试。

• SceneNet RGB-D[9]: 数据集地址:https://robotvault.bitbucket....。不同于前述数据集,该数据集不是真实场景采集的数据,而是合成数据集。其提供了约 5000000 张 RGBD 图片用作训练,以及300000 张作为验证和测试。该数据集可用作语义分割、实例分割和目标检测等任务。和NYUv2 数据集类似,虽然该数据集未直接提供三维点云,但可以通过 RGB 图和深度图间接计算获得。

表1 室内数据集

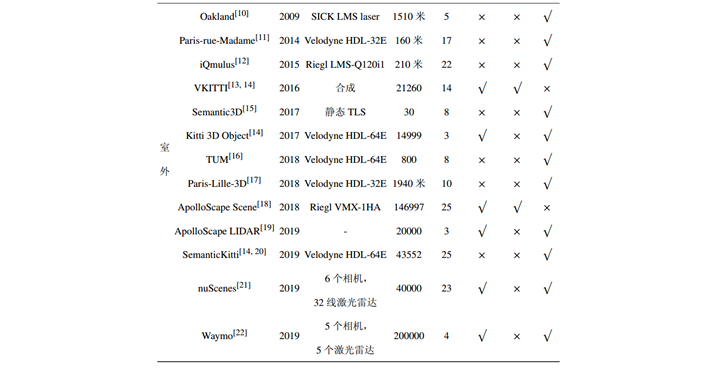

表2 室外数据集

1.2 室外场景数据集

近年来,自动驾驶在国内外都受到广泛关注与大量研究[23-25],许多针对室外场景的数据集也陆续开源。开源者中不乏一些自动驾驶明星公司,体现了行业内对三维场景数据集的重视程度。这里介绍常用的室外场景数据集:

• Oakland[10]: 数据集地址:https://www.cs.cmu.edu/ ~vmr/ datasets/oakland\_3d/ cvpr09 /doc/。该数据集提供了坐落于奥克兰的卡耐基梅隆大学的校园点云场景,其使用 SICK 单线激光雷达采集。场景全长为 1510 米,对每个点进行了语义类别标注,包含 44 个类别,可用于三维点云数据的语义分割。实际使用时,该 44 个类别数被重新映射为 5 个类别。该数据集的训练集包含36932 个点,验证集包含 91579 个点,测试集包含 1300000 个点。

• Paris-rue-Madame[11]: 数据集地址:http://www.cmm.mines-paristec...。该数据集提供了巴黎街道场景的点云地图,长度约为160 米,使用 Velodyne HDL-32E 激光雷达采集,标注了 17 个类别,可用于三维点云数据的语义分割。该数据集提供了两段点云场景文件,共包含两百万个点。

• iQmulus[12]: 数据集地址:http://data.ign.fr/benchmarks...。该数据集采集了巴黎城市环境下的三维点云地图,全长 210米,包含约 3 亿个点。其使用Riegl LMS-Q120i 激光雷达进行采集,该雷达相比 Velodyne 激光雷达,所产生的点更加稠密。每个点标注了一个语义类别和实例标签,可用于三维点云的语义分割和实例分割。

• VKITTI[13, 14]: 数据集地址:https://europe.naverlabs.com/...。该数据集为合成数据集,模拟了城市场景下的道路环境。其提供了 50 段视频,共计 21260 帧RGB 图和深度图,可用于图像的语义分割、实例分割、目标检测等任务。根据深度图和内外参矩阵,可生成对应的三维点云数据,进行点云上的语义理解。

• Semantic3D[15]: 数据集地址:http://www.semantic3d.net/。该数据集提供了 30 个无重叠的室外点云建图场景, 15 个场景用于训练, 15 个用于测试,使用静态地基激光雷达 (Terrestrial Laser Scanner, TLS) 采集。对每个点进行标注,包含 8 个类别,可用于三维点云数据的语义分割。30 个场景涵盖城市、郊区和乡村场景。由于采集设备的特性,该数据集点云数量巨大,达到 40 亿个点。除了三维坐标,该数据集同时提供了每个点对应的 RGB 值和强度值。

• Kitti 3D Object[14]: 数据集地址:http://www.cvlibs.net/dataset...\_object.php ?obj\_benchmark=3d。该数据集提供了 14999 帧数据,同时包含图像和对应的点云,是专用于自动驾驶的数据集。其中,训练集包含 7481 帧,测试集包含 7518 帧。该数据集对前视范围内的点云进行了约 20 万个 3D 边界框的标注,类别有三种,分别为车辆、行人、自行车,可用作三维点云的目标检测。

• TUM[16]: 数据集地址:https://www.iosb.fraunhofer.d...。该数据集提供了德国慕尼黑城市道路场景下的三维点云数据,共计 17756 帧数据,数据采集时间约 15 分钟,由两个 Velodyne HDL-64E 激光雷达共同采集。其中部分数据标注了点的语义类别,标注的数据量为每个雷达 800 帧,这部分数据可用于三维点云数据的语义分割。

• Paris-Lille-3D[17]: 数据集地址:http://npm3d.fr/。该数据集提供了法国巴黎和里尔两个地区的点云地图,使用一个倾斜安装的 Velodyne HDL-32E 激光雷达采集,总长度共计 1940米。训练集包含三段场景,标注了 50 个类别,测试集包含三段场景,标注了 10 个类别,可用于三维点云数据的语义分割。实际使用时,需要将训练集的 50 个类别重映射为测试的 10 个类别。

• ApolloScape Scene[18]:数据集地址:http://apolloscape.auto/scene...。该数据集提供了城市道路场景下 146997 帧 RGB 图和深度图,并提供了语义级别和实例级别的标注。根据深度图和内外参矩阵,可生成三维点云数据。值得注意的是,该数据集提供的深度图只包含静态物体,动态物体已被事先滤除。

• ApolloScape LIDAR[19]:数据集地址:http://apolloscape.auto/track...。该数据集为 ApolloScape 提供的另一类数据,用于三维点云的检测与跟踪任务。其提供了约20000 帧点云数据,标注了 3D边界框及跟踪信息。

• SemanticKitti[14, 20]:数据集地址:http://semantic-kitti.org/。该数据来源于 KITTI[14] 里程计数据集,使用 VelodyneHDL-64E 激光雷达采集,后由 [20] 标注了每个点的语义类别。其共包含 22段连续序列,前 11 段为训练集,后 11 段为测试集,共计 43552 帧点云,可用作三维点云数据的语义分割以及基于语义信息的建图与定位。

• nuScenes[21]: 数据集地址:https://www.nuscenes.org/。该数据集提供了 1000 段连续采集数据,每段持续 20 秒、包含 40 帧图像和点云的边界框信息,共计 40000 帧标注数据。其使用 6 个相机和 1 个 32 线激光雷达进行数据采集,同时提供毫米波雷达的信息。

• Waymo[22]: 数据集地址:https://waymo.com/open/。该数据集提供了用于自动驾驶的三维点云数据集,包含 1000段连续采集数据,每段长度 20 秒,共计 20 万帧图像和点云数据。使用 5 个相机和 5 个激光雷达进行数据采集,其中 1 个为中距离激光雷达, 4 个为短距离激光雷达。其为点云标注了 3D 边界框,可用于三维点云的目标检测。

参考文献

[1] SILBERMAN N, HOIEM D,KOHLI P, et al. Indoor segmentation and support inference from rgbdimages[C]//European Conference on Computer Vision. Berlin, Heidelberg:Springer, 2012: 746-760.

[2] SONG S, LICHTENBERG S P,XIAO J. Sun rgb-d: A rgb-d scene understanding benchmark suite[C]//Proceedingsof the IEEE conference on computer vision and pattern recognition. Boston, MA, USA:IEEE, 2015: 567-576.

[3] JANOCH A, KARAYEV S, JIAY, et al. A category-level 3d object dataset: Putting the kinect towork[G]//Consumer depth cameras for computer vision. [S.l.]: Springer, 2013:141-165.

[4] XIAO J, OWENS A, TORRALBAA. Sun3d: A database of big spaces reconstructed using sfm and objectlabels[C]//Proceedings of the IEEE International Conference on Computer Vision.Sydney, NSW, Australia: IEEE, 2013: 1625-1632.

[5] HUA B S, PHAM Q H, NGUYEND T, et al. Scenenn: A scene meshes dataset with annotations[C]//2016 FourthInternational Conference on 3D Vision (3DV). Stanford, CA, USA: IEEE, 2016:92-101.

[6] ARMENI I, SAX S, ZAMIR AR, et al. Joint 2d-3d-semantic data for indoor scene understanding[J]. ArXivpreprint arXiv:1702.01105, 2017.

[7] DAI A, CHANG A X, SAVVA M,et al. Scannet: Richly-annotated 3d reconstructions of indoorscenes[C]//Proceedings of the IEEE Conference on Computer Vision and PatternRecognition. Honolulu, HI, USA: IEEE, 2017: 5828-5839.

[8] CHANG A, DAI A, FUNKHOUSERT, et al. Matterport3d: Learning from rgb-d data in indoor environments[J].ArXiv preprint arXiv:1709.06158, 2017.

[9] MCCORMAC J, HANDA A,LEUTENEGGER S, et al. Scenenet rgb-d: Can 5m synthetic images beat genericimagenet pre-training on indoor segmentation?[C]//Proceedings of the IEEEInternational Conference on Computer Vision. Venice, Italy: IEEE, 2017:2678-2687.

[10] MUNOZ D, BAGNELL J A,VANDAPEL N, et al. Contextual classification with functional max-margin markovnetworks[C]//2009 IEEE Conference on Computer Vision and Pattern Recognition.Miami, FL, USA: IEEE, 2009: 975-982.

[11] SERNA A, MARCOTEGUI B,GOULETTE F, et al. Paris-rue-Madame database: a 3D mobile laser scanner datasetfor benchmarking urban detection, segmentation and classification methods[C]//.[S.l. : s.n.], 2014.

[12] VALLET B, BRÉDIF M, SERNAA, et al. TerraMobilita/iQmulus urban point cloud analysis benchmark[J].Computers & Graphics, 2015, 49: 126-133.

[13] GAIDON A, WANG Q, CABONY, et al. Virtual worlds as proxy for multi-object trackinganalysis[C]//Proceedings of the IEEE conference on computer vision and patternrecognition. Las Vegas, NV, USA: IEEE, 2016: 4340-4349.

[14] GEIGER A, LENZ P, URTASUNR. Are we ready for Autonomous Driving? The KITTI Vision Benchmark Suite[C]//Proc.of the IEEE Conf. on Computer Vision and Pattern Recognition (CVPR).Providence, RI, USA: IEEE, 2012: 3354-3361.

[15] HACKEL T, SAVINOV N,LADICKY L, et al. Semantic3d. net: A new largescale point cloud classificationbenchmark[J]. ArXiv preprint arXiv:1704.03847, 2017.

[16] XU Y, SUN Z, BOERNER R,et al. Generation of Ground Truth Datasets for the Analysis of 3d Point Cloudsin Urban Scenes Acquired via Different Sensors[J]. ISPRS-International Archivesof the Photogrammetry, Remote Sensing and Spatial Information Sciences, 2018:2009-2015.

[17] ROYNARD X, DESCHAUD J E,GOULETTE F. Paris-Lille-3D: A large and high-quality ground-truth urban pointcloud dataset for automatic segmentation and classification[J]. TheInternational Journal of Robotics Research, 2018, 37(6): 545-557.

[18] HUANG X, CHENG X, GENG Q,et al. The apolloscape dataset for autonomous driving[C]//Proceedings of theIEEE Conference on Computer Vision and Pattern Recognition Workshops. Salt LakeCity, UT, USA: IEEE, 2018: 954-960.

[19] MA Y, ZHU X, ZHANG S, etal. Trafficpredict: Trajectory prediction for heterogeneoustraffic-agents[C]//Proceedings of the AAAI Conference on ArtificialIntelligence. Honolulu, Hawaii, USA: AAAI Press, 2019: 6120-6127.

[20] BEHLEY J, GARBADE M,MILIOTO A, et al. SemanticKITTI: A Dataset for Semantic Scene Understanding ofLiDAR Sequences[C]//Proc. of the IEEE/CVF International Conf. on ComputerVision (ICCV). Long Beach, CA, USA: IEEE, 2019.

[21] CAESAR H, BANKITI V, LANGA H, et al. NuScenes: A multimodal dataset for autonomous driving[J]. ArXivpreprint arXiv:1903.11027, 2019.

[22] Waymo Open Dataset: Anautonomous driving dataset[Z]. 2019. [23] 杨明. 无人自动驾驶车辆研究综述与展望[J]. 哈尔滨工业大学学报, 2006, 38(8): 1259-1262.

[24] 李德毅, 郑思仪. 大数据时代的创新思维[J]. 北京联合大学学报: 自然科学版, 2014, 28(4): 1-6.

[25] 李力, 王飞跃. 地面交通控制的百年回顾和未来展望[J]. 自动化学报, 2018, 44(4): 577-583.

本文仅做学术分享,如有侵权,请联系删文。

推荐阅读

重点介绍:1、3D视觉算法;2、vslam算法;3、图像处理;4、深度学习;5、自动驾驶;6、技术干货。博主及合伙人分别来国内自知名大厂、海康研究院,深研3D视觉、深度学习、图像处理、自动驾驶、目标检测、VSLAM算法等领域。

欢迎关注微信公众号