深度强化学习被成堆的炒作包围着,并且都有足够好的理由!强化学习是一种难以置信的通用范式,原则上,一个鲁棒而高性能的强化学习系统可以处理任何任务,而且将这种范式和深度学习的经验学习能力相结合是很自然的。深度强化学习是最接近于通用人工智能(AGI)的范式之一。不幸的是,它目前还不能真正地奏效。实际上这并不是任何人的错,它更像是一个系统问题。讲述积极结果的故事是很容易的,但实现起来很难的,所以需要某些思想或者原则进行指导,本文将列举AlphaGo代表人David Sliver关于强化学习提出的十大原则。报道:深度强化学习实验室

资料来源:deeplearningindaba

编辑:DeepRL

客观、量化的评估方法是强化学习进展的重要驱动力:

- 评估指标的选择决定了研究进展的方向;

- 这可以说是强化学习项目中最重要的一个决定。

排行榜驱动的研究

- 确保评估指标紧密对应最终目标;

- 避免主观评估(如人类评估)。

假设驱动的研究

- 形成一个假设:Double-Q 学习优于 Q 学习,因为前者减少了向上偏误(upward bias);

- 在宽泛的条件下验证该假设;

- 对比同类方法,而不是只与当前最优方法进行对比;

- 寻求理解,而不是排行榜表现。

- 算法的可伸缩性是其相对于资源的性能梯度,给定更多资源,性能如何提高?

- 资源可以是计算,内存或数据

- 算法的可扩展性最终决定了它的成功

- 可伸缩性始终(最终)比起点更重要

- 给定无限资源,一个好的算法(最终)是最优的

- 一个算法的一般性是它在不同RL环境中的性能

- 避免过度拟合当前任务

- 寻求可以推广到未知未来环境的算法

- 我们无法预测未来,但是:

(1)未来的任务可能至少与当前任务一样复杂

(2)当前任务遇到的困难很可能会增加 - 结论:针对多样但实际的RL环境进行测试

- 经验(观察,行动,奖励)是RL的数据

(1)

(2)代理在环境中的生命周期中积累的经验流 - 相信经验是唯一的知识来源

(1)总是有诱惑力来利用我们的人类专业知识(人类数据,功能,

启发式,约束,抽象,域操作) - 从经验中学习似乎是不可能的

(1)接受RL的核心问题很难

(2)这是人工智能的核心问题

(3)值得努力 - 从长远来看,从经验中学习总能获胜

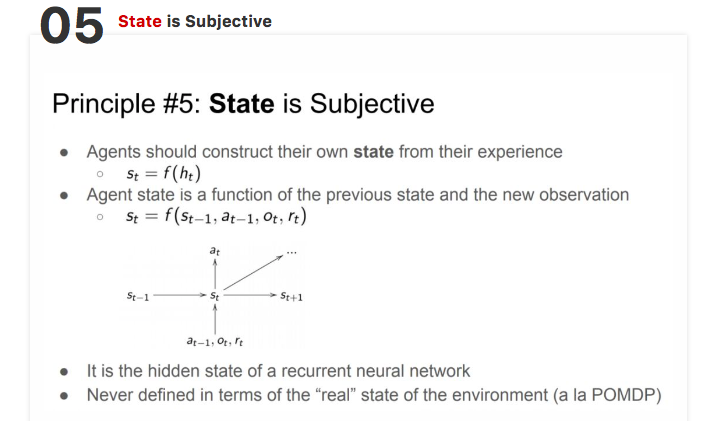

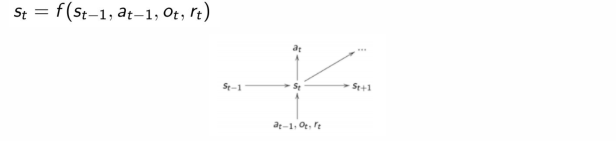

- 智能体应根据自己的经验构建自己的状态

- 智能体状态是前一个状态和新观察的函数

- 它是循环神经网络的隐藏状态。

- 永远不要根据环境的「真实」状态来定义状态(智能体应该是一个部分可观察马尔可夫链模型)。

- 智能体存在于丰富的感觉运动(sensorimotor)数据流中:

(1)观测结果的数据流输入到智能体中;

(2)智能体输出动作流。 - 智能体的动作会影响数据流:

- 特征控制 => 数据流控制

- 数据流控制 => 控制未来

- 控制未来 => 可以最大化任意奖励

为什么要使用值函数?

- 价值功能有效地总结/缓存未来

- 将计划减少到恒定时间查找,而不是指数前瞻

- 可以独立于其跨度进行计算和学习

学习多种价值功能:

- 有效地模拟世界的许多方面(控制流),包括后续状态变量

- 多个时间尺度

避免在原始时间步骤对世界进行建模

一种有效的规划方法

- 想象一下接下来会发生什么,模型中状态的样本轨迹

- 从想象的经验中学习,使用我们应用于实际体验的相同RL算法

现在关注值函数逼近

- 不同的网络架构是强大的工具,可以促进:

(1)丰富的状态代表

(2)可分辨的记忆

(3)不同的计划

(4)分层控制 - 将算法复杂性推入网络架构

(1)降低算法的复杂性(如何更新参数)

(2)提高架构的表现力(参数的作用)

第一代:良好的老式人工智能

○手工预测

○什么都不学

第二代:浅学习

○手工功能

○学习预测

第3代:深度学习

○手工算法(优化器,目标,架构……)

○端到端地学习功能和预测

第4代:元学习

○手工制作

○端到端学习算法和功能以及预测)

原则来源:

http://www.deeplearningindaba...\_of\_deep\_rl.pdf

注:本文所使用的人物图片为介绍其事迹或列举其贡献,均为非商业用途。

推荐阅读

专注深度强化学习前沿技术干货,论文,框架,学习路线等,欢迎关注微信公众号。

更多深度强化学习精选知识请关注深度强化学习实验室专栏,投稿请联系微信 1946738842.