报道:深度强化学习实验室

来源:https://arxiv.org/abs/2011.12...

编辑:DeepRL

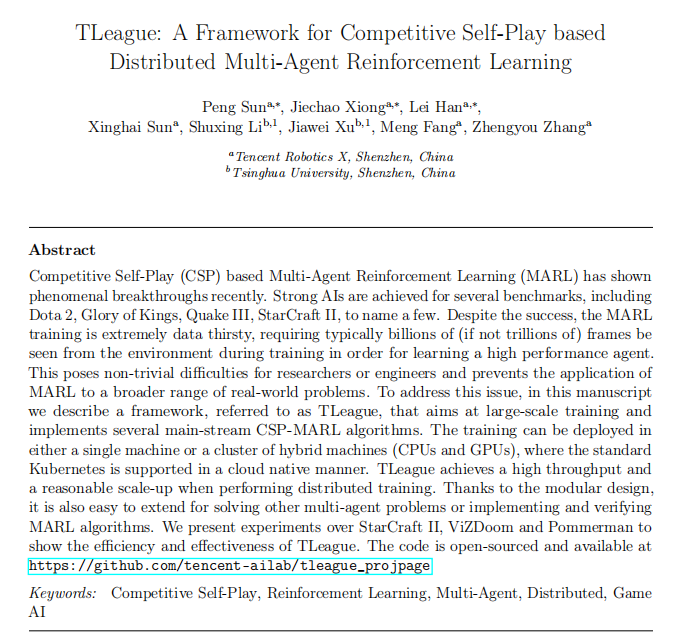

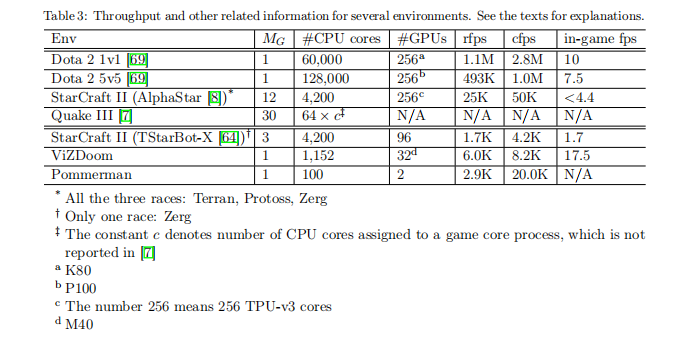

基于竞争性自学(CSP)的多智能体强化学习(MARL)最近表现出了出惊人的突破。包括Dota2、《王者荣耀》《雷神之锤III》《星际争霸II》等。尽管取得了成功,但MARL训练特别需要数据,在训练过程中通常需要从环境中看到数十亿个帧,这给研究人员、工程师带来了不小的困难。为了解决这个问题,腾讯团队开发了TLeague的框架,其旨在进行大规模训练并实现几种主流的CSP-MARL算法。训练可在单台机器上或混合机器(CPU和GPU)环境集群中部署,在进行分布式训练时,TLeague可以实现高吞吐量和合理的放大。由于采用了模块化设计,因此也很容易扩展,其可以解决其他多智能体问题或实现和验证MARL算法。

框架的整体结构如下图所示:

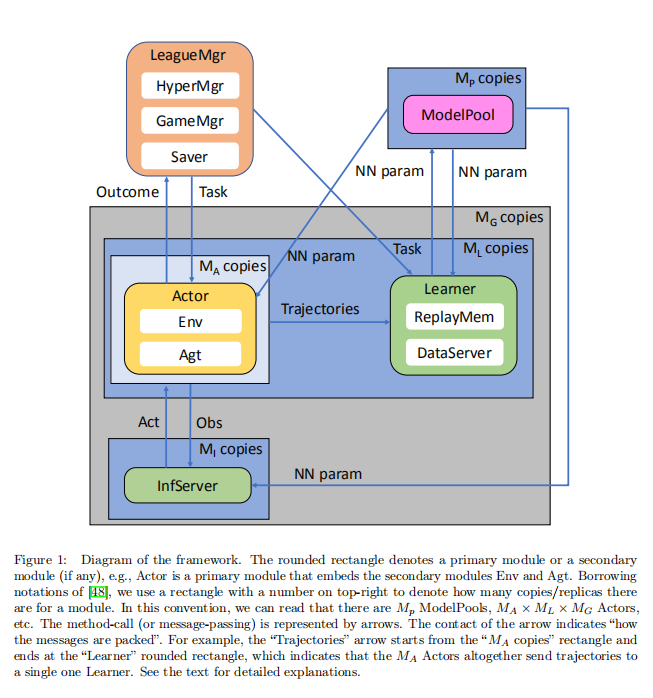

训练程序的运行方式如下:

# startpython render_template . py foobar . yml . jinja2 | kubectl apply -f -# stoppython render_template . py foobar . yml . jinja2 | kubectl delete -f -同样,TLeague与IMPALA和SEED最相似,即也采用Actor-Learner-InferenceServer体系结构。也就是解耦RL组件与IMPALA和SEED最相似。下面是TLeague的工作流过程。

其中使用TLeague框架时需要的包环境

- TLeague: the main logic of Competitive SelfPlay MultiAgent Reinforcement Learning.

- TPolicies: a lib for building Neural Net used in RL and IL.

- Arena: a lib of environments and env-agent interfaces. See the docs therein for how to install.

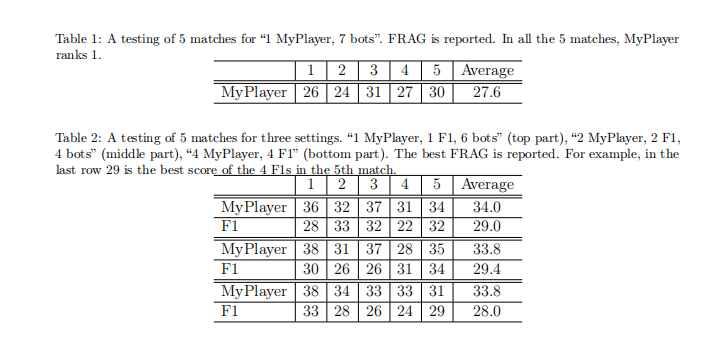

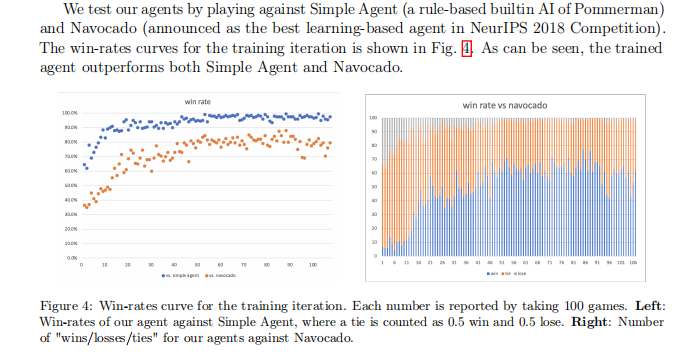

实现效果如下:

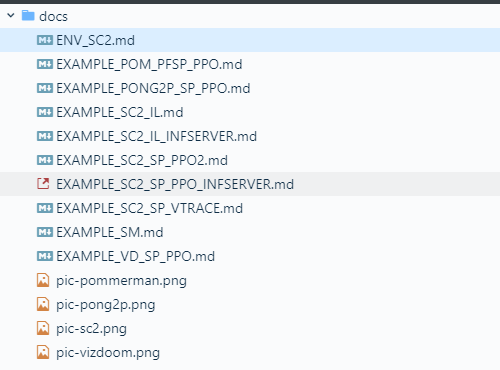

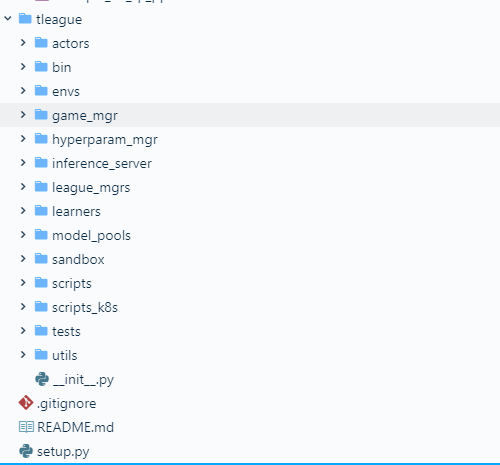

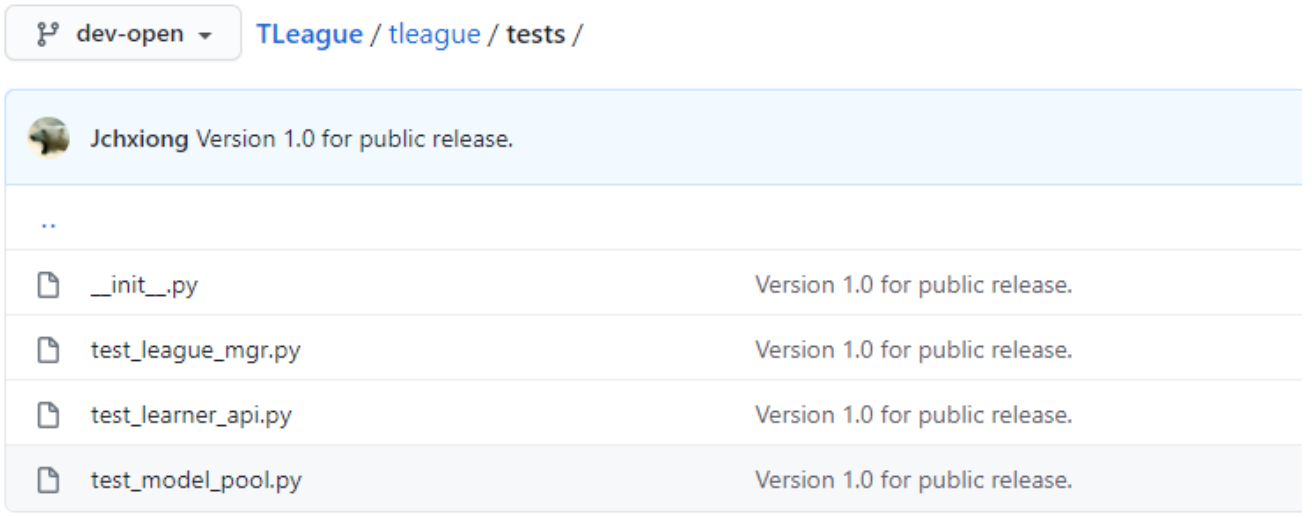

代码结构

安装依赖环境

'gym','joblib','numpy','scipy','pyzmq','paramiko','libtmux','abslpy','xlrd','pyyaml','psutil','namedlist',

安装过程

pip install -e .代码测试执行过程:

论文链接:https://arxiv.org/abs/2011.12...

https://github.com/tencent-ai...

推荐阅读

专注深度强化学习前沿技术干货,论文,框架,学习路线等,欢迎关注微信公众号。

更多深度强化学习精选知识请关注深度强化学习实验室专栏,投稿请联系微信 1946738842.