作者:唐僧 huangliang

来源:企业存储技术

GTC 2021已经不是新闻了吧:)虽然我有点羡慕能熬夜看直播,或者白天写东西的朋友;不过稍晚一点沉下心来,整体看看NVIDIA数据中心GPU产品线全貌,以及几款新卡在其中的定位,感觉也不错。

现学现卖哈,本文暂不讨论太深入的技术细节。

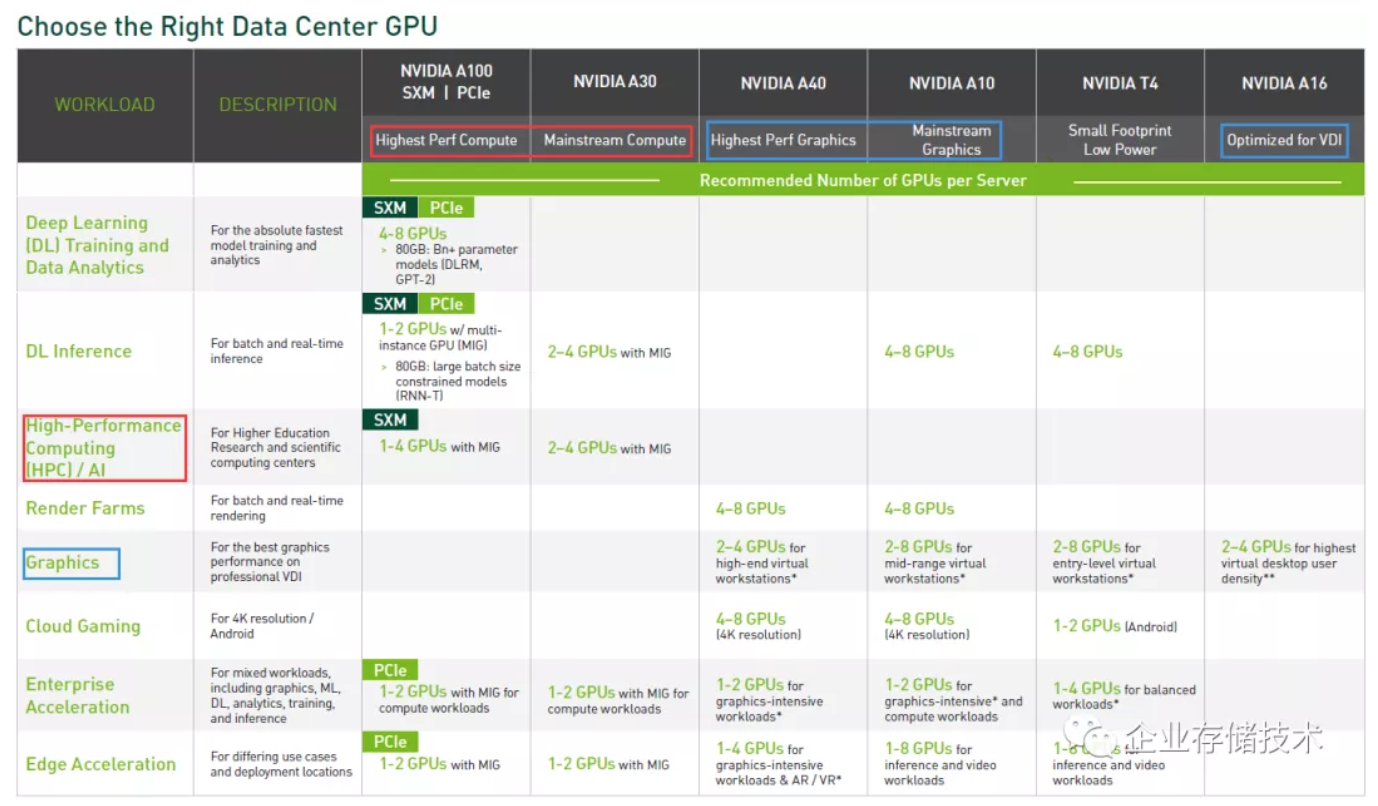

图片点击后可放大,以下同。__我用红框标出的专注于计算,而蓝框则针对图形应用,当然A10__和T4__也兼顾机器学习多面手。

在本次新品发布之前,NVIDIA T4(Tesla T4)是上一代Turing核心产品;A100是安培这一代的顶级GPU;A40相当于专用于服务器的(Quadro)RTX A6000,同时支持vGPU虚拟化。

先讲下左边一列的应用领域:除了最上面的Deep Learning(DL) Training and Data Analytics分类中只有A100之外;接下来的DL Inference(推理)又多出了T4、新品A10和A30,其中单宽卡可以部署4-8块;

HPC(高性能计算)/AI除了A100之外还有A30。按照NV的传统,双精度浮点FP64性能每代卡几乎都只有最高的一款放开,所以下文中我会带大家重点看A30的资料。

Render Farms(渲染农场)这一项只有A40和A10,大概上一代T4的性能还是偏弱所以没列进来吧;而这3款卡都在图形(VDI)和云游戏的分类里,相对最特别的A16专门针对虚拟桌面(vGPU)。

NVIDIA A10 :A40 架构的瘦身版本

NVIDIA A10__(单宽全高)

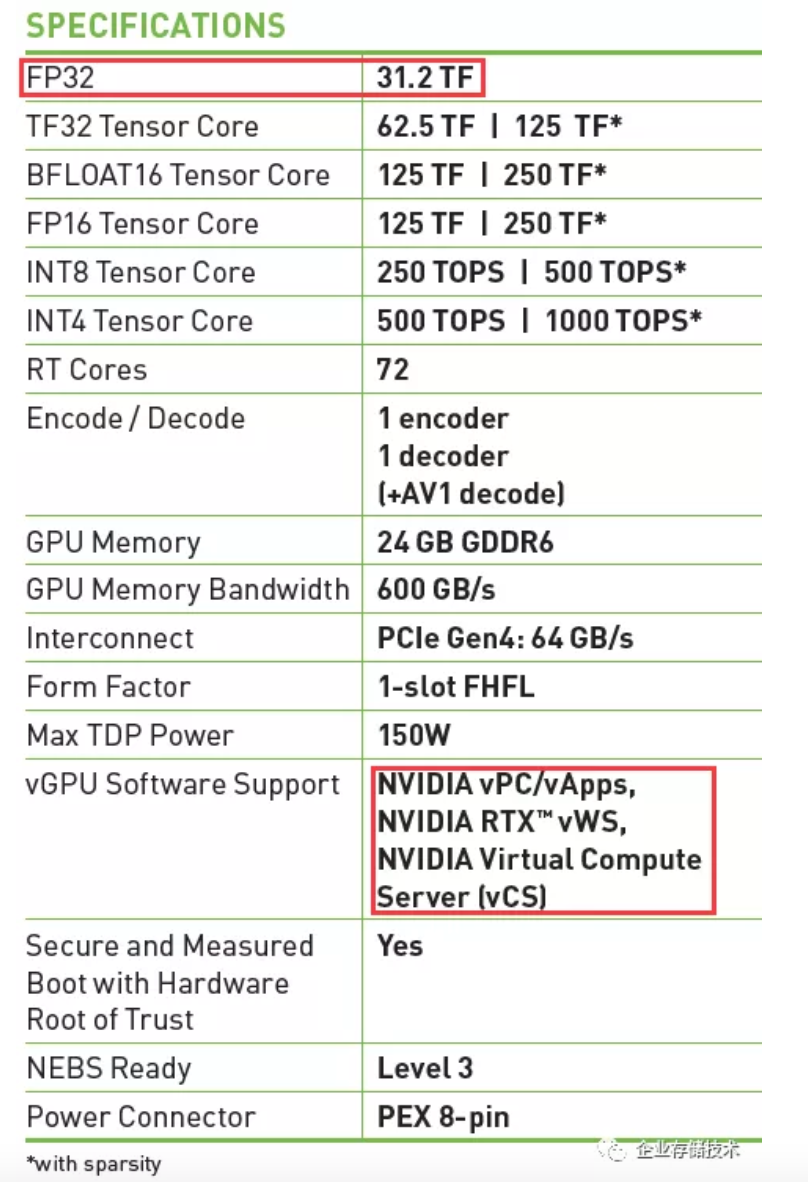

如上表,NVIDIA A10的架构特点接近A40,虽然24GB显存只有后者的一半,但计算性能没有差太多,同时150W功耗只有A40 300W的一半。较高的能耗比使它像T4那样适合高密度部署。

FP32单精度浮点性能高,是A10、A40、A6000以及高端GeForce RTX 3000系列共同的特点,我理解这些单元应该也是3D图形处理所需要的。

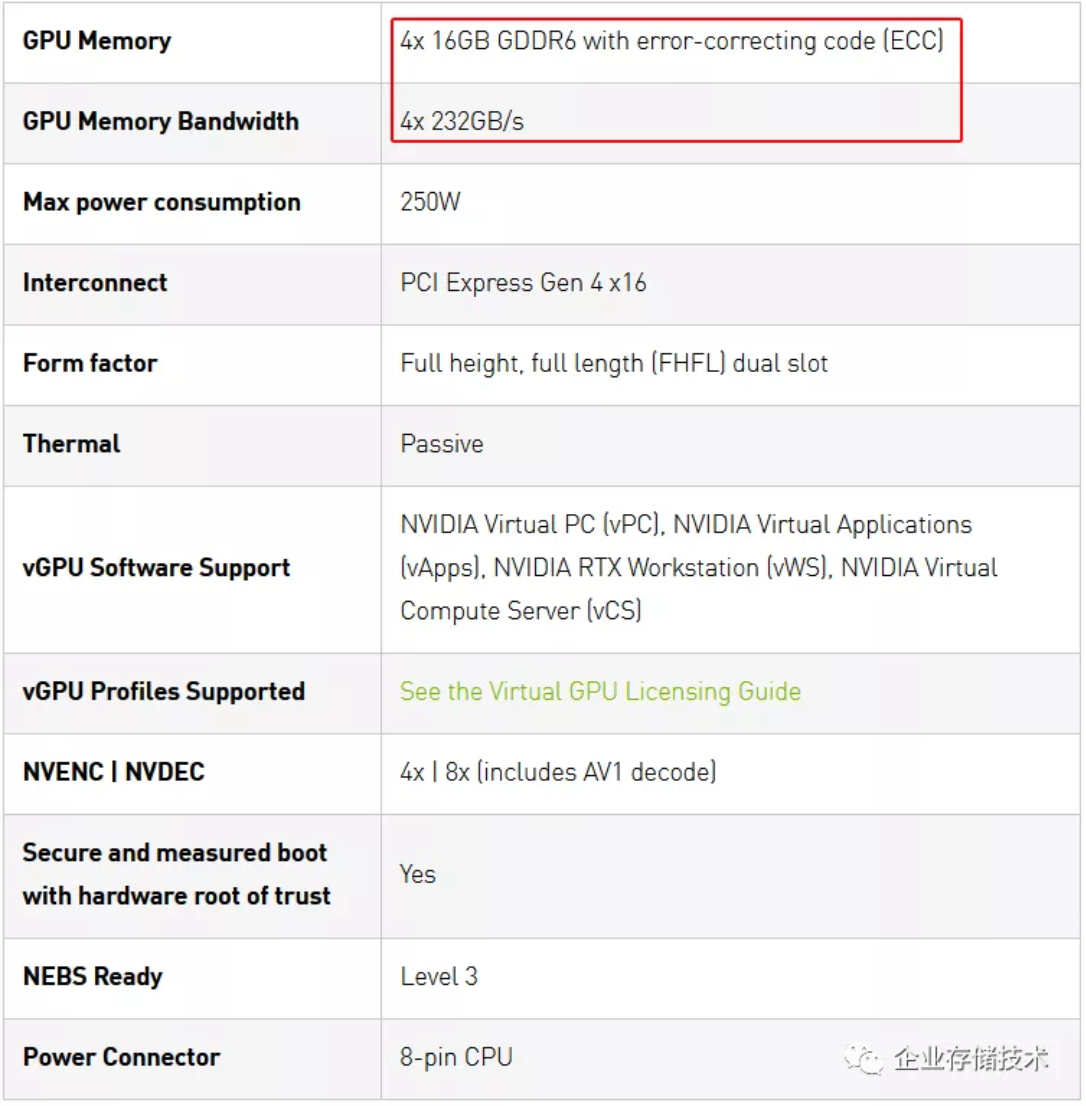

A10另一个要点就是全面的vGPU软件支持,包括图形的NVIDIA vPC/vApp、RTXvWS(虚拟Quadro),以及计算的Virtual Compute和Server(vCS)。它的辅助供电接口是PCIe 8-pin。

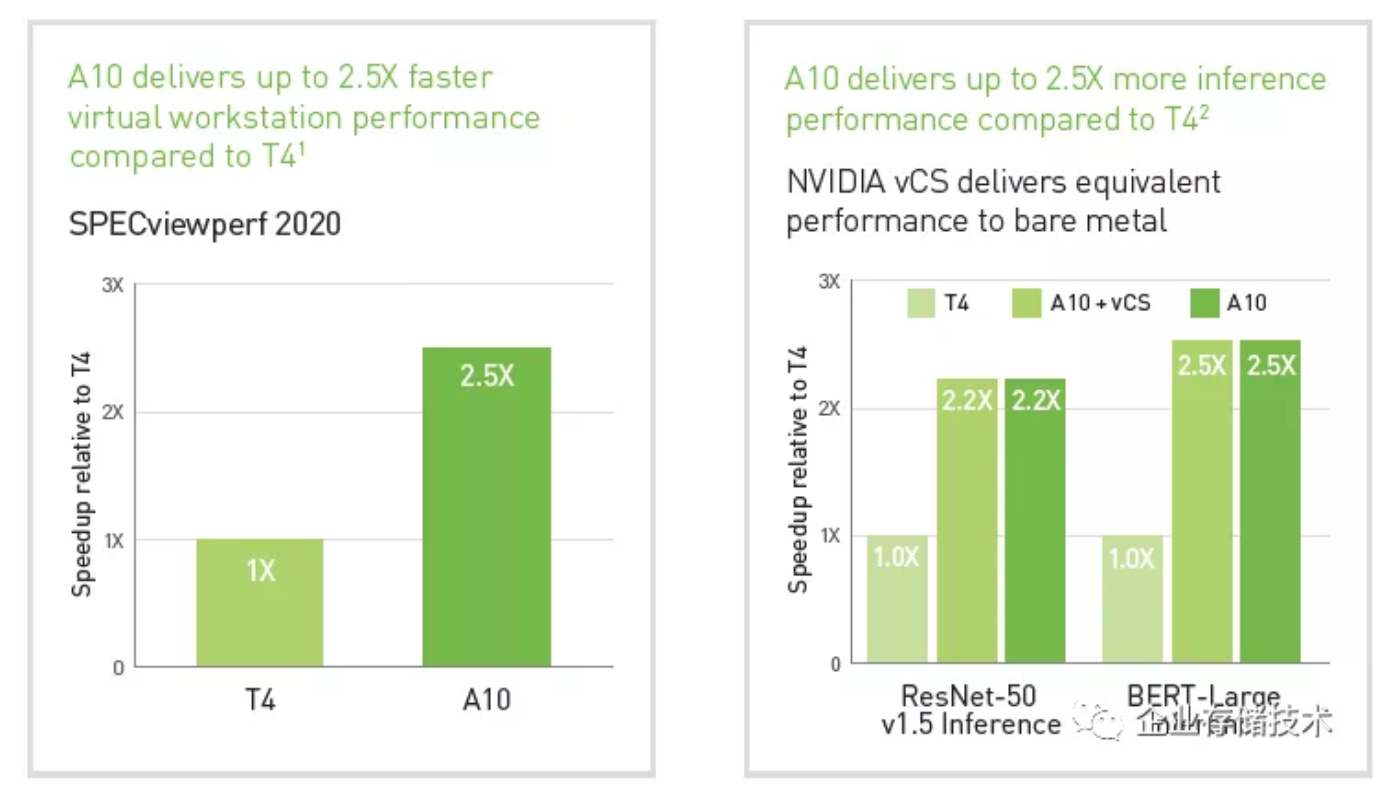

看一下图形和深度学习性能,A10大约是T4的2.2-2.5倍,这与新的Ampere架构以及高一倍的功耗比较相称吧。

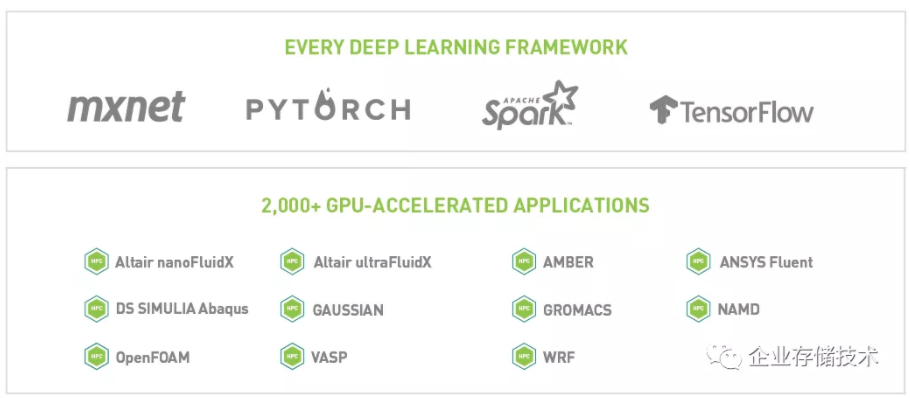

A10的应用领域:左边4个Deep Learning框架大家都认识;右边则是传统图形工作站干那些活:像制造业使用的Dassault(达索)、西门子(NX)、PTCCreo,AEC建筑领域的Autodesk Revit,以及著名的Rhinoceros(犀牛)等。

NVIDIA A16 :新一代4GPU 虚拟化 图形专用卡

NVIDIA A16__(双宽全尺寸)

从4x 16GB的显存就能看出A16这款卡是4颗GPU,说白了还是有些时候GPU虚拟化用一颗大芯片“切割”使用的效果不太理想,反而是多芯片架构更直接高效些。

虽然PCIe 4.0是新一代卡的标配,但在这里由4颗GPU分享更显价值一些。

NVIDIA仍然把这块卡的功耗控制在250W,为了避免连接多个辅助供电的复杂性,A16像A6000和A40那样使用一个8-pin CPU供电插头。

NVIDIA A30 :一半的A100 双精度& 深度学习性能

NVIDIA A30__(双宽全尺寸)

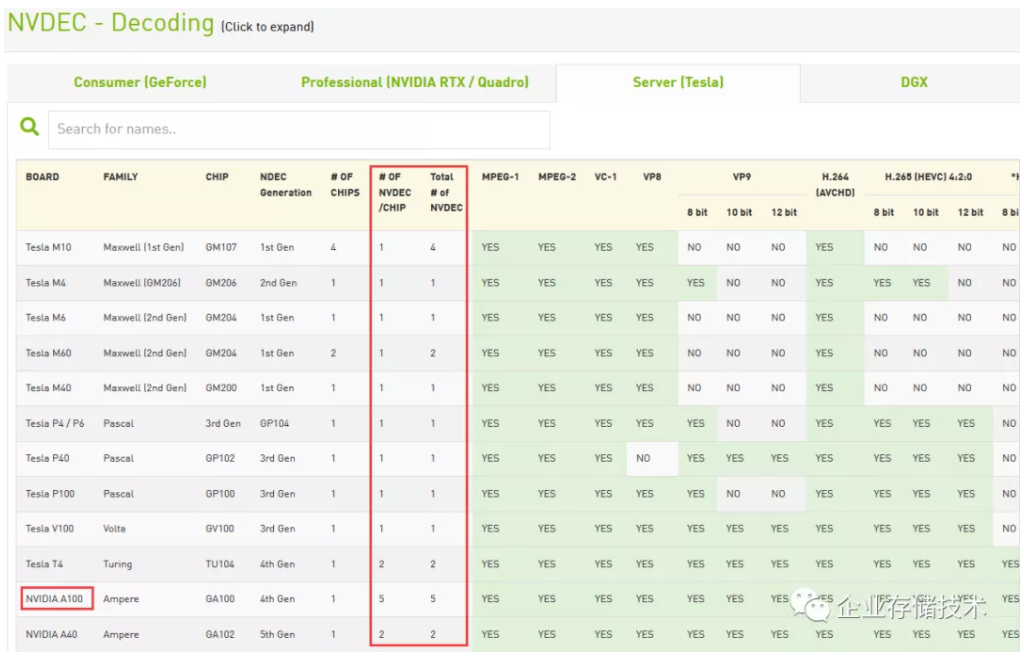

我发现NVIDIA__的设计方向应该是发展NVDEC__专用视频解码电路,编码(Encode)则可以同时由CUDA__单元来处理,这样应该能较好地兼顾转码效率和画质。

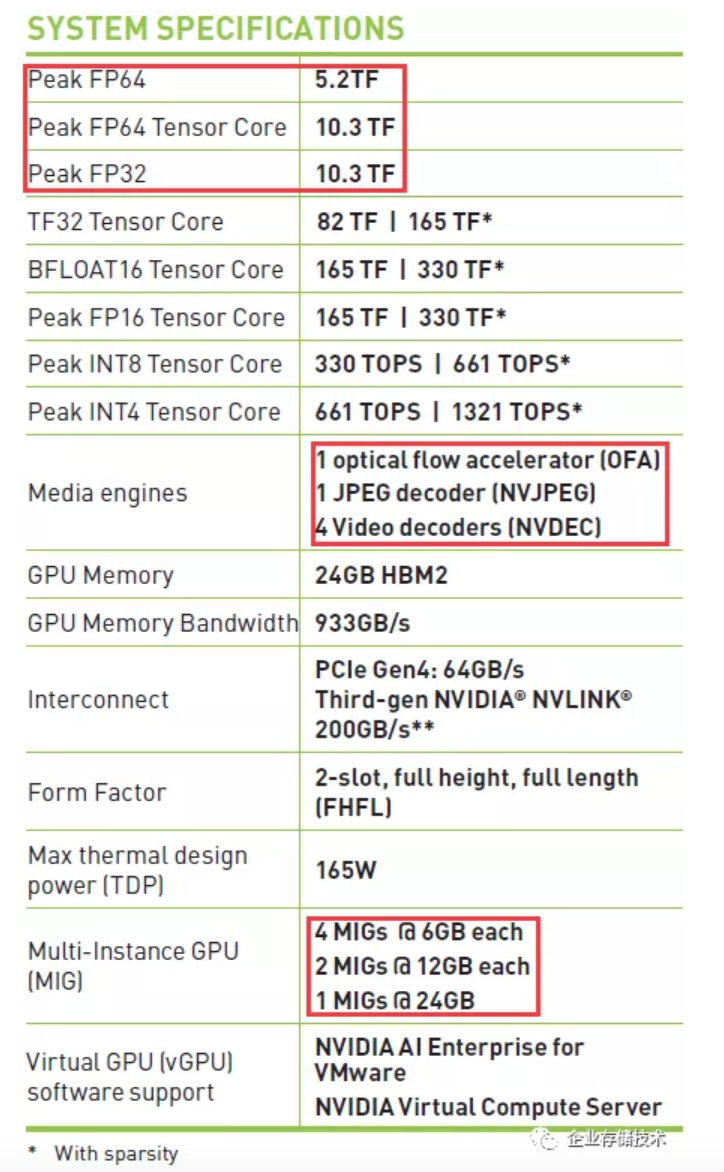

A30的架构特点则接近A100。峰值原生FP32性能看似并不突出,但双精度浮点FP64 5.2TFlops为单精度的一半,兼具优秀的Tensor Core加速计算性能,同时功耗降低至165W。

它的24GB内存比A100 40GB的一半多点,但保持使用HBM2,带宽仍高达933GB/s。同时提供PCIe Gen4和NVLINK 200GB/s互连接口。

A100支持7个MIG(多实例GPU)硬件切分,A30则可选切分成4个6GB、2个12GB或者1个24GB。

vGPU这块,NVIDIA A30的定位只需要支持计算,本身就没有图形。

媒体加速引擎部分,A30配置4个视频解码器(NVDEC,A100是5个)、1个JPEG解码器和optical flow accelerator(OFA,光流加速器)A100也都是具备的。

关于OFA光流加速器以前我了解不多,上面列出一张截图供大家参考。

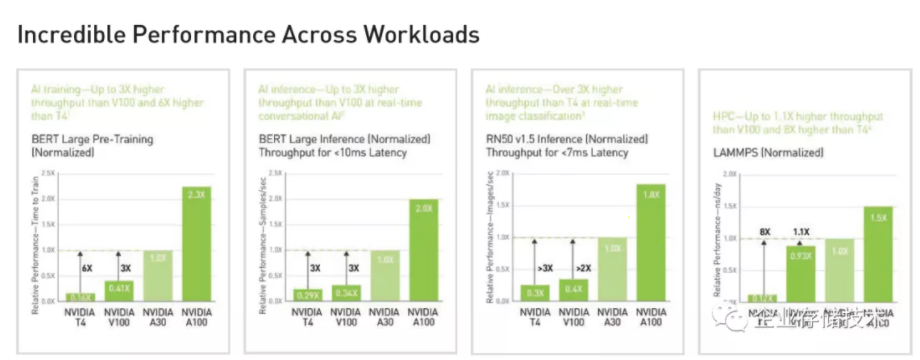

NVIDIA A30的训练和推理性能介于V100和A100之间。

A30的应用领域其实和A100类似,除了深度学习就是HPC。比如Altair、ANSYS这些经典的有限元分析、流体力学计算等。

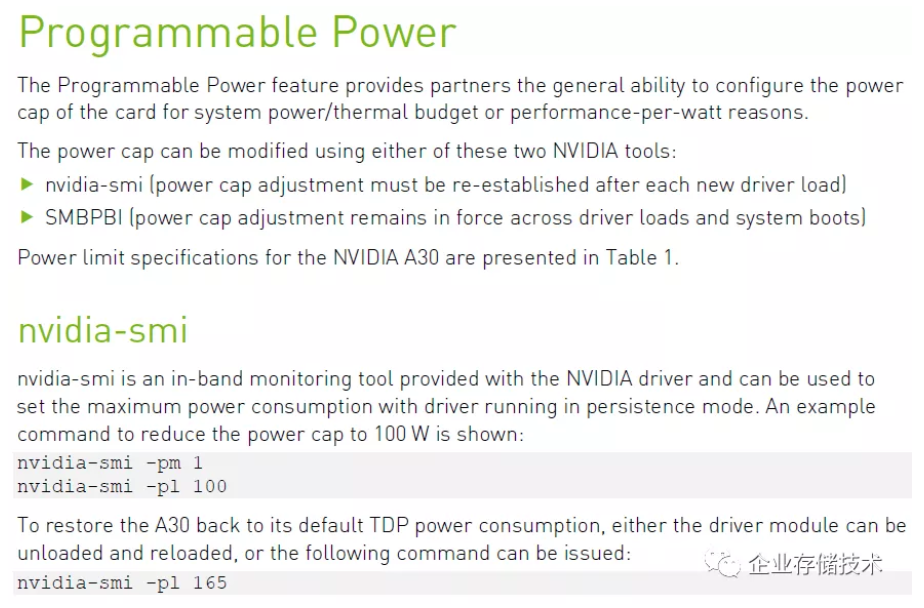

我还在A30资料中注意到的可编程功率,可以使用nvidia-smi-pm XX(数值:W)来限制功耗,细分到每一瓦。

记得之前我测过一款国产AI计算卡,在散热不好温度超标之后会降频,而温度恢复后频率和性能却不能自动恢复。希望大家都能越做越好吧。

移动工作站RTX A 系列:功耗提升、万年不变的显存容量

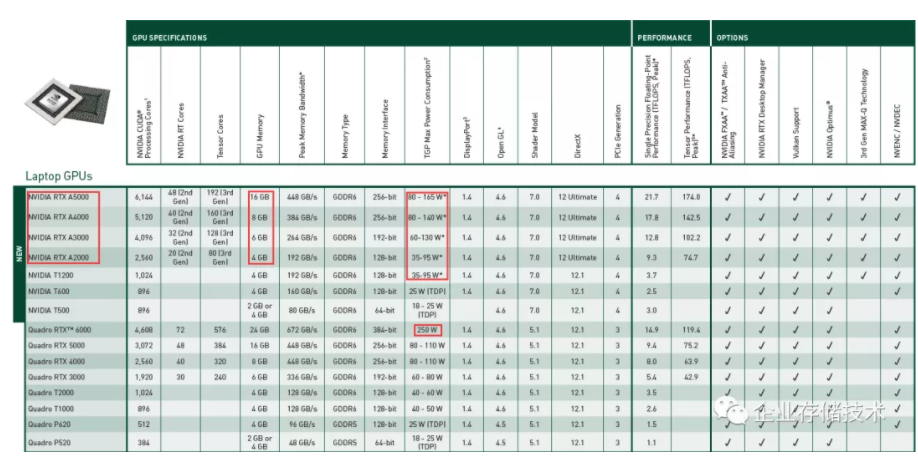

仍然是__点击放大查看__,其中250W__功耗的RTX6000__我还没在哪款移动工作站上看到有支持。

移动GPU(Quadro)也是我熟悉的,最后简单看一下。我注意到,从新款的NVIDIA T1200,到RTX A2000、A3000、A4000和A5000,MAX-Q支持的TGP功耗上限都比当前一代RTX提高了不少。按道理设计上可以更灵活,不过主流移动工作站的机身尺寸,还有电源适配器也不能无限大啊。

我本来还想吐槽一下显存,A2000-A6000仍然是4GB到16GB,这在有些情况下应该会限制性能的发挥。不过还是那句话,“笔记本”里空间有限,更多的显存颗粒可能不太好放;另外一个理由就是——您有更高需求选台式工作站啊:)

推荐阅读

注:本文只代表作者个人观点,与任何组织机构无关,如有错误和不足之处欢迎在留言中批评指正。 进一步交流技术可以加我的微信/QQ:490834312。

尊重知识,转载时请保留全文,并包括本行及如下二维码。感谢您的阅读和支持!《企业存储技术》微信公众号:HL_Storage,也欢迎关注企业存储技术极术专栏,定期更新。