作者:唐僧 huangliang

来源:企业存储技术

Q:EDSFF中E1.S、E1.L、E3都是怎么划分定位的?

Q:EDSFF的发展与PCIe规范演进之间的关系是?

Q:为什么服务器厂商还在用U.2SSD,这背后的始作俑者是?

Q:如果EDSFF设备不只有SSD,还能支持啥?

这两天看到一份很不错的技术资料,上面那几条都有答案,赶紧写点东西分享给大家。

关于下一代数据中心SSD规格形态,无论E1.S、E1.L还是E3(EDSFF 3英寸),我以前都曾讨论过:

《_下一代数据中心SSD形态之争:来自Azure架构师的观点_》

今天要给大家分享的内容,基本上可以把EDSFF比较全面、系统地呈现了。我的参考资料来自OCP(Open Compute Project)的一场Webinar,下面可以看到其演讲阵容的强大:

其中Hyperscale超大规模数据中心用户和(服务器)OEM厂商,包括:微软、Facebook、HPE、Dell和联想;SSD存储厂商包括:Intel、Kioxia(前东芝)、WD、三星、Micron、SK hynix等。

与其说SNIA(存储网络工业协会)是EDSFF的规范制定者,不如说是Intel一直在背后推动。看看下图的配色风格吧:)

Intel**分享:EDSFF Overview

**

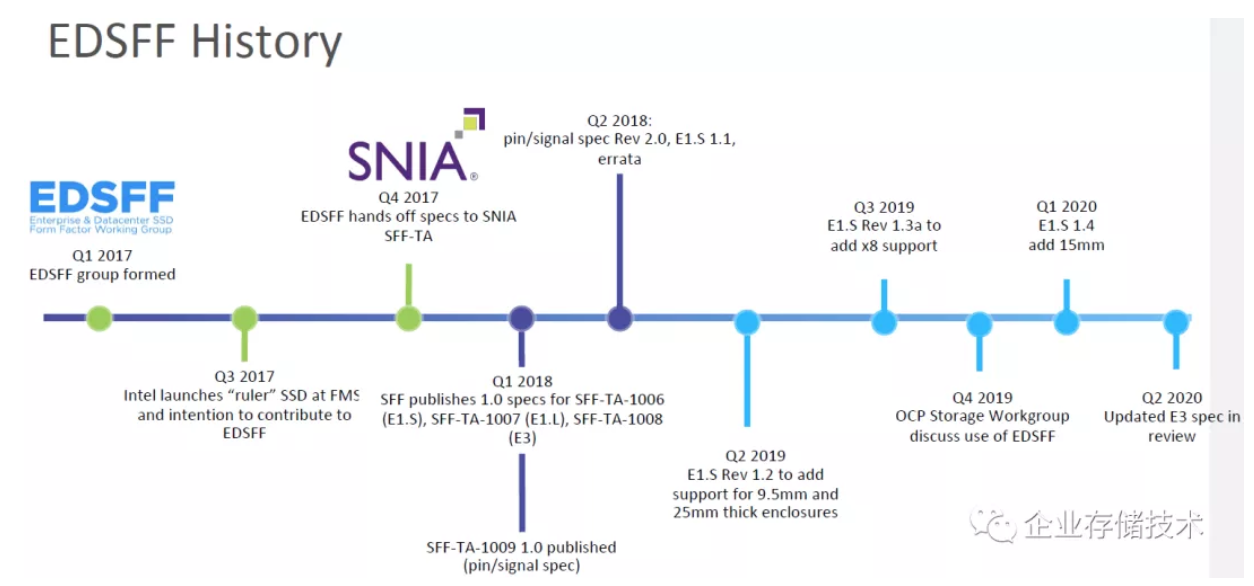

根据这个时间轴,E1.S(SFF-TA-1006)、E1.L(SFF-TA-1007)和E3(SFF-TA-1008)早在2018年Q1就发布了1.0规范,3年后的今天,也到了该成熟和大规模应用的时候了。

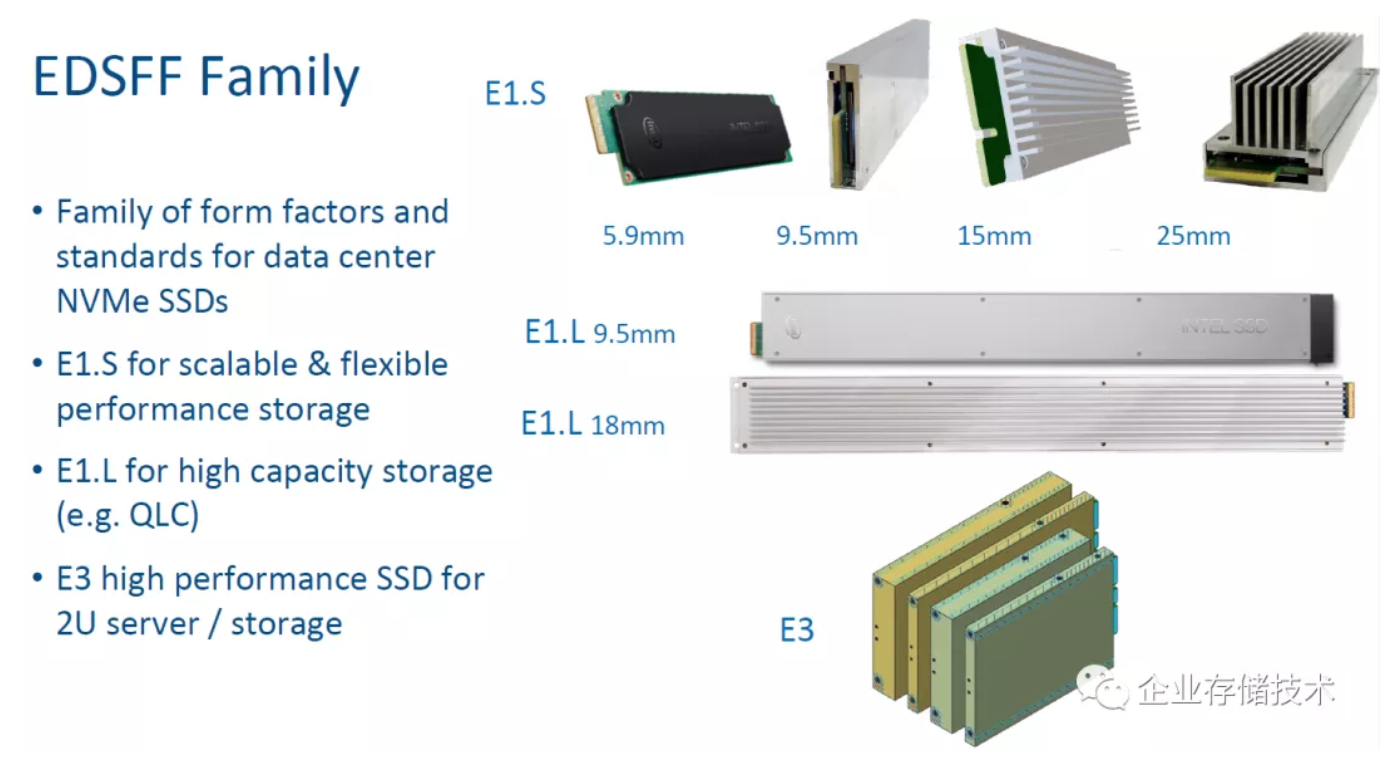

对于上述3类新的数据中心NVMe SSD尺寸和标准,E1.S定位是可扩展和灵活的性能型存储,E1.L针对高容量存储(如:QLC),E3则是用于2U服务器/存储中的高性能SSD。

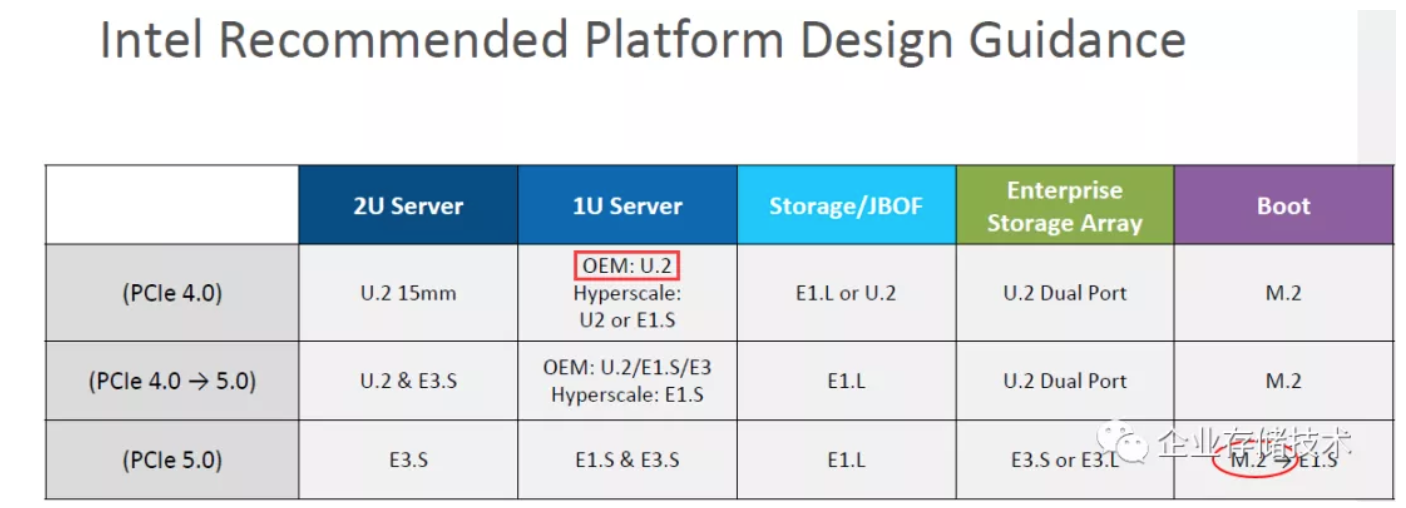

可能有的朋友会问,OEM大厂的服务器新品中有些还清一色沿用U.2,比如Dell PowerEdge 15G。从上面这个“Intel推荐平台设计指导”不难找到答案。

在PCIe 4.0阶段之所以OEM仍青睐U.2,主要就是机箱的驱动器槽位、连接器部分能够与2.5英寸SATA、SAS乃至HDD机械盘通用。Hyperscale大型互联网和云服务提供商相对没有这个包袱,针对应用划分出的全闪存服务器机型可以更早试水E1.S。

而最终过渡到PCIe5.0的时候,U.2和M.2应该是电气上达不到要求了。到时2U服务器可能会普遍采用E3.S;用于服务器扩展的存储/JBOF使用E1.L;企业级存储阵列用E3.S和E3.L都能实现双端口。

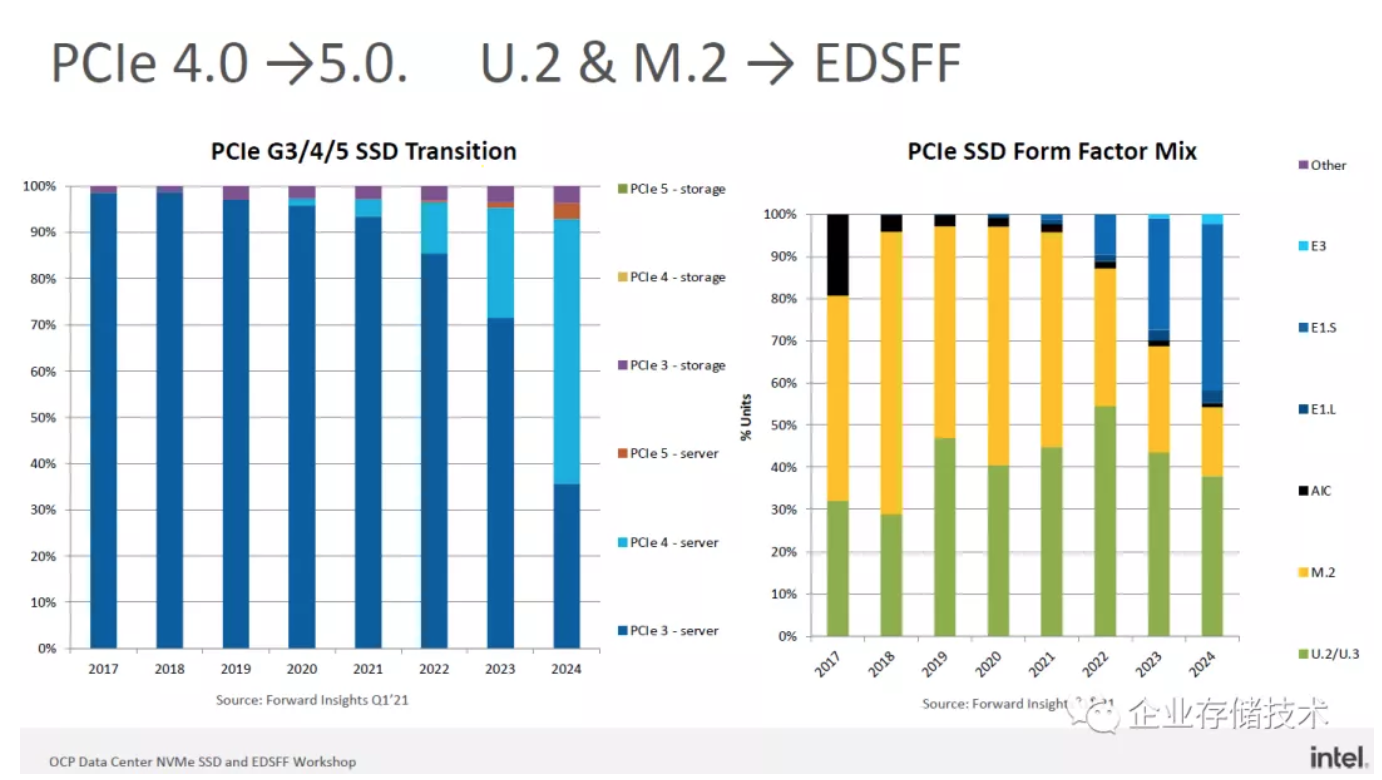

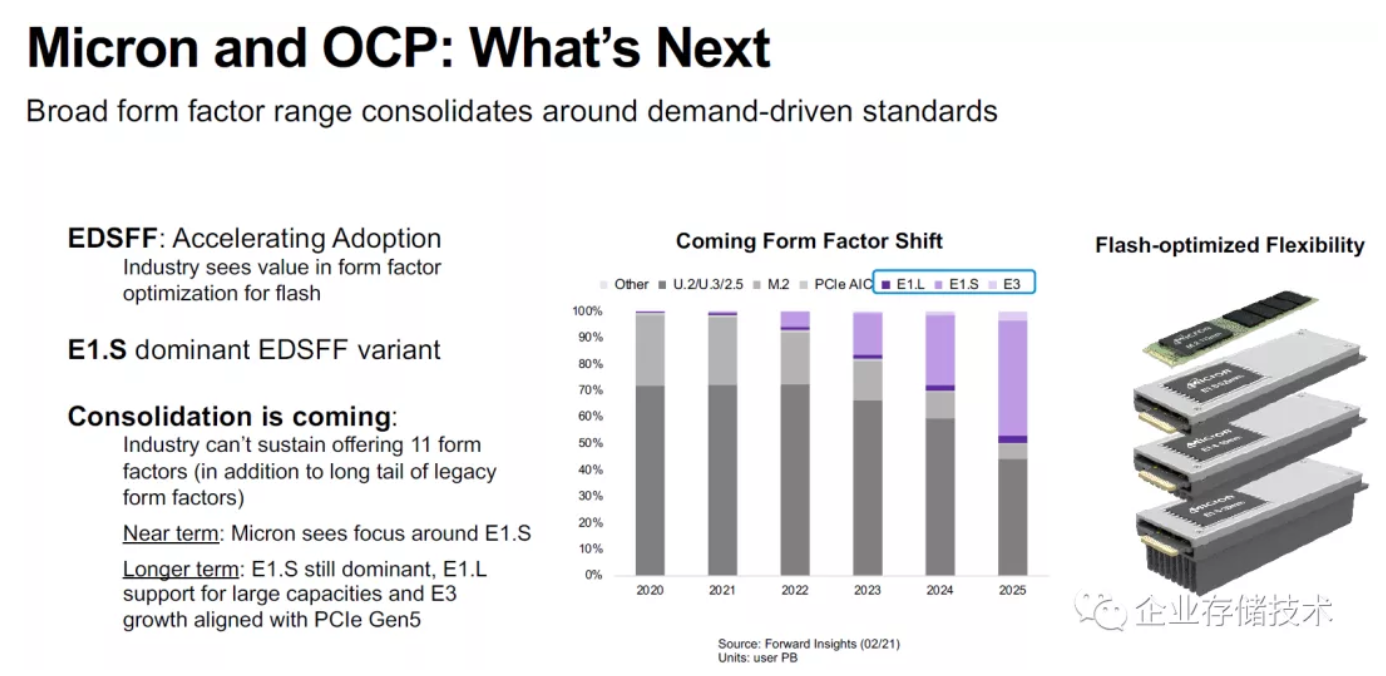

PCIe Gen4和Gen5作为SSD接口的普及速度可能不算快,毕竟Gen3 x4对于许多应用来说也不慢了。上图右侧应该是数据中心SSD的出货Unit数量,M.2的占比似乎偏大?不过可以看出从2022年往后U.2/U.3的占比开始下降,E1.S和E1.L逐渐成为主流,而E.3还会晚一些。

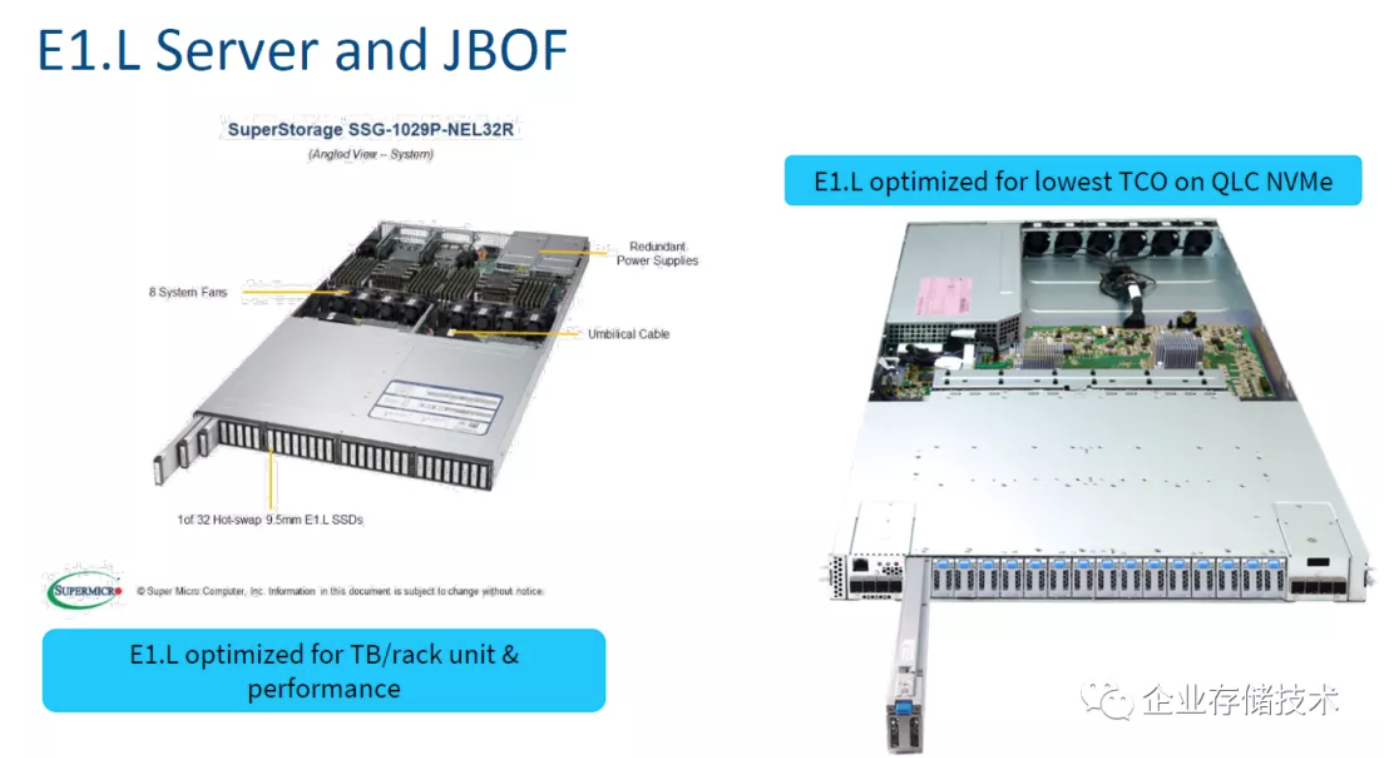

上图是E1.L的应用场景,这个我想已经不用太多介绍,9.5mm厚度的E1.L SSD在1U标准机箱中可以放32个。

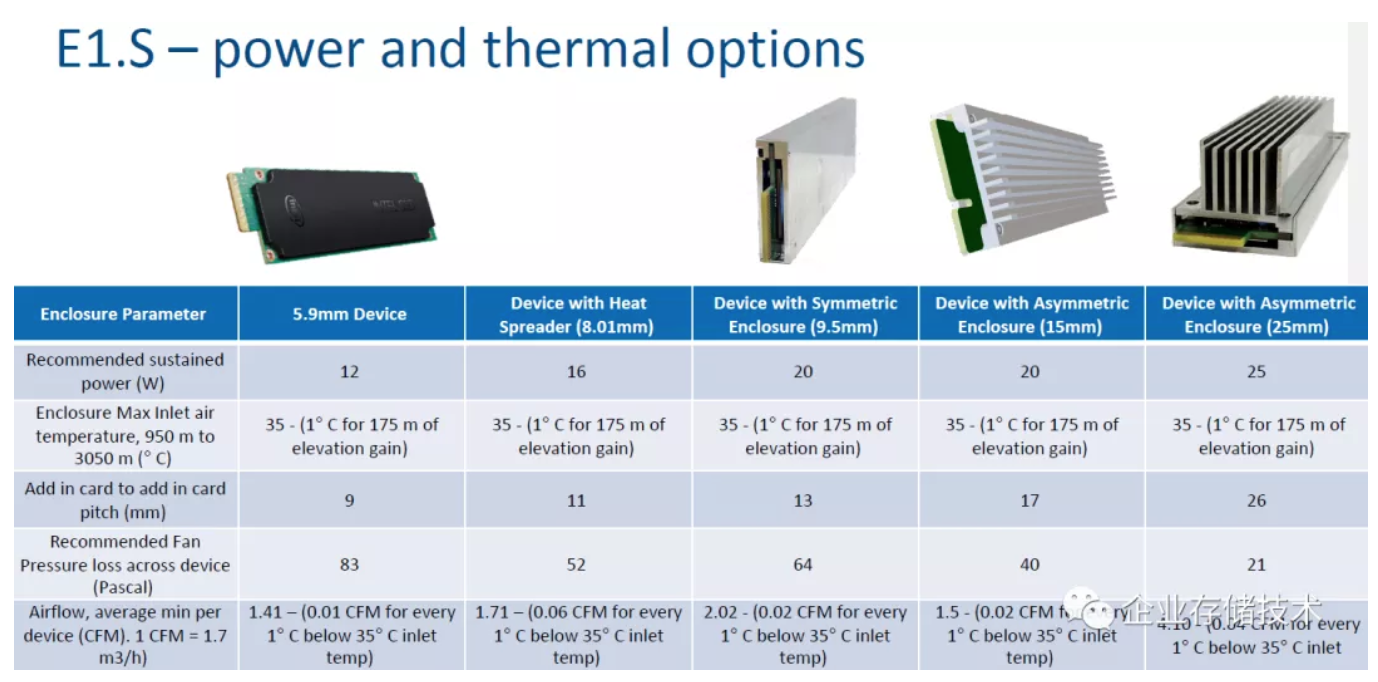

E1.S SSD的功耗和散热选项。上面这个图表,其实去掉那几张SSD图片我在去年就给大家列出过,这里也不想再细讲了。

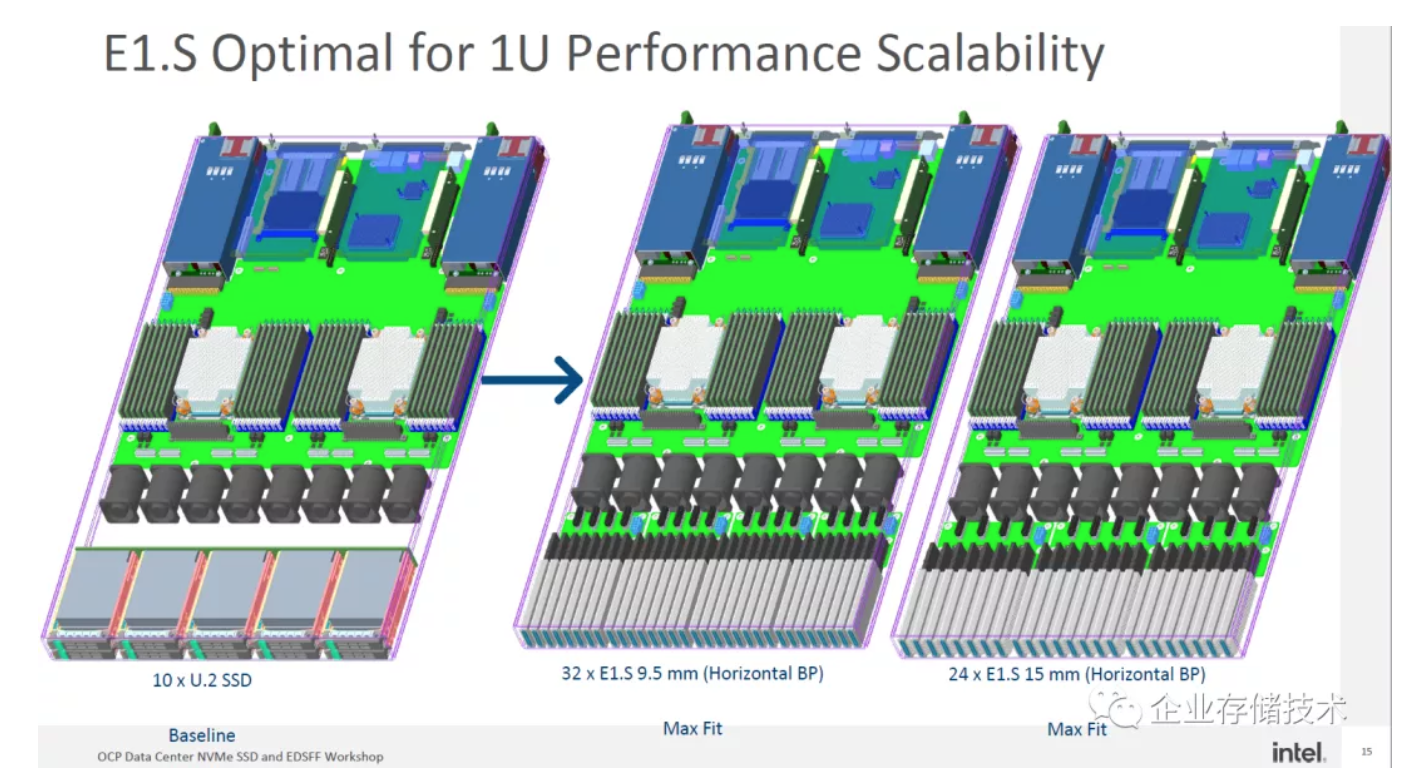

E1.S针对1U(存储)性能扩展型服务器优化。对比当前机箱前部10个U.2热插拔NVMe SSD的Baseline设计,32个E1.S 9.5mm或者24个E1.S 15mm的密度提升显而易见。

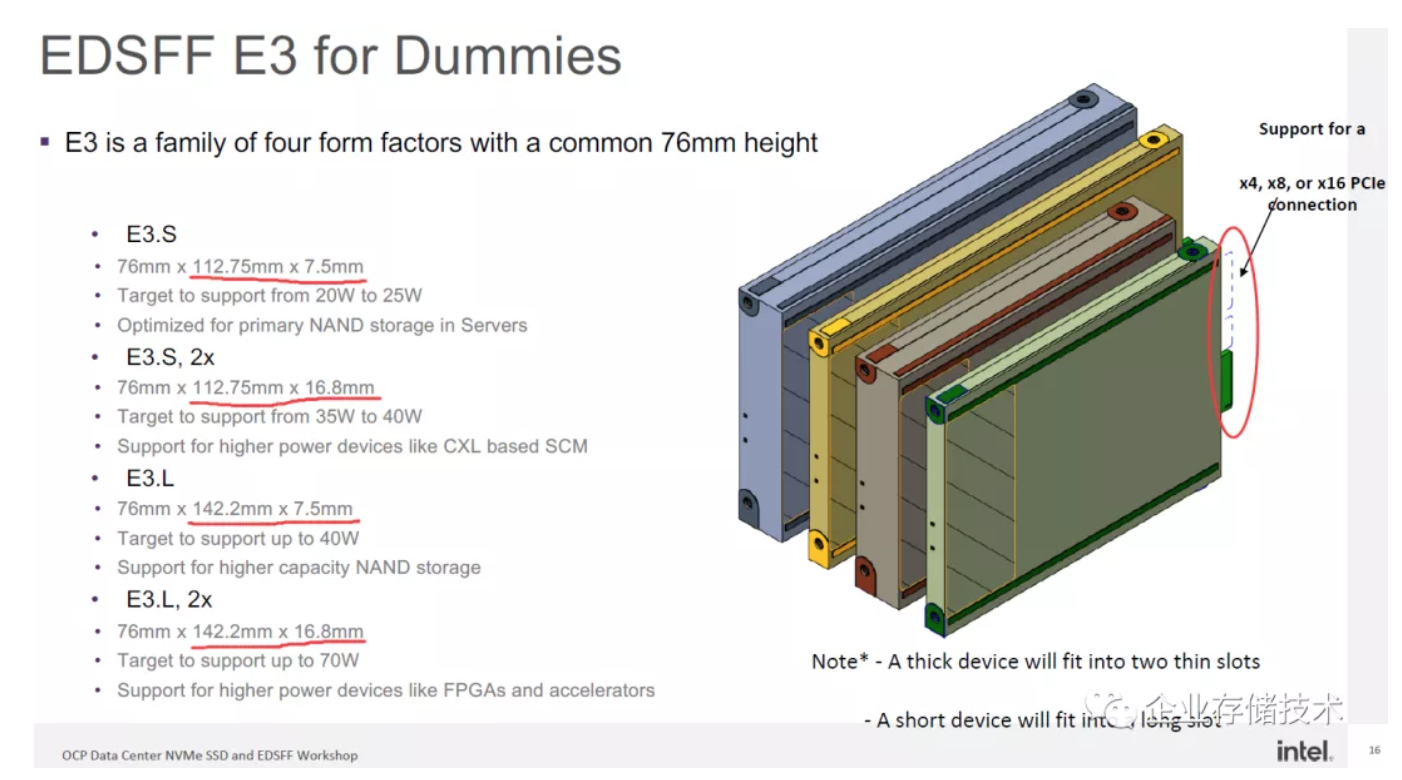

如上图右侧红圈:EDSFF E3__的连接器具备从PCIex4__扩展到x8__或者x16__的空间

EDSFF E3 SSD如果按照上图中的放置方向,其高度都是76mm,E3.S和E3.L的深度分别为112.75mm、142.2mm,而宽度(厚度)都有标准(7.5mm)和2x(16.8mm)两种。4款规格的功耗覆盖了20-25W到70W的范围。目标用途如下:

-E3.S__:为NANDSSD__主存储服务器优化;

-E3.S, 2x__:支持高功耗设备,如基于SCM__的CXL__(未来的Optane SSD__,其实叫持久化内存盘更合适);

-E3.L__:支持高容量NAND__存储;

-E3.L, 2x__:支持像FPGA__和加速器那样的高功耗设备(PCIe__卡前置)。

注:关于在PCIe底层上面跑CXL等不同协议,我打算在下一篇中再跟大家讨论。

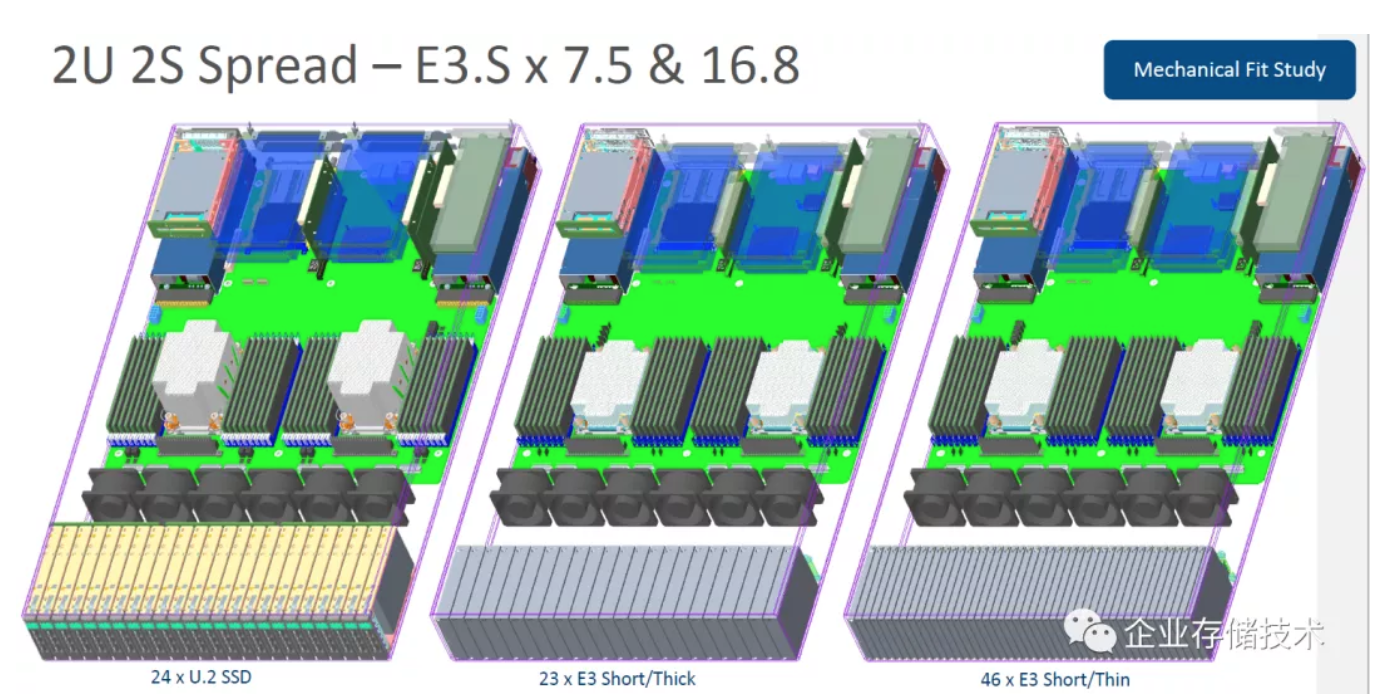

传统2U服务器,前置U.2 SSD数量最多24个,换成E3.S, 2x/Thick(厚盘)之后可以放23个;而E3.S/Thin(薄盘)则最多可以做到46个热插拔位。

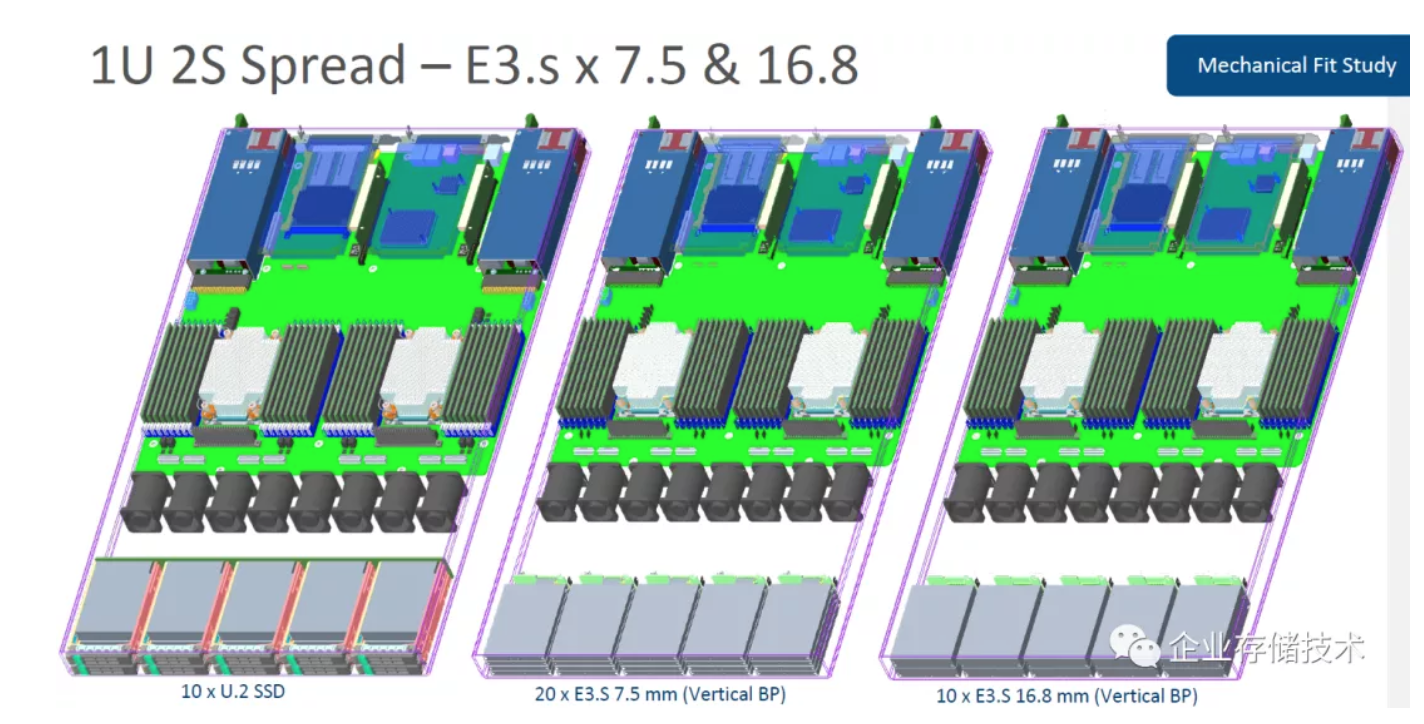

E3 SSD在1U机箱中需要横过来放,16.8mm的厚盘可以放10个(与U.2数量相同),7.5mm薄盘则可以放20个。

注:Intel__分享的内容就先讲这么多,下面将按照厂商在Webinar__资料中的出现顺序来写,当然我会挑重点的东西。

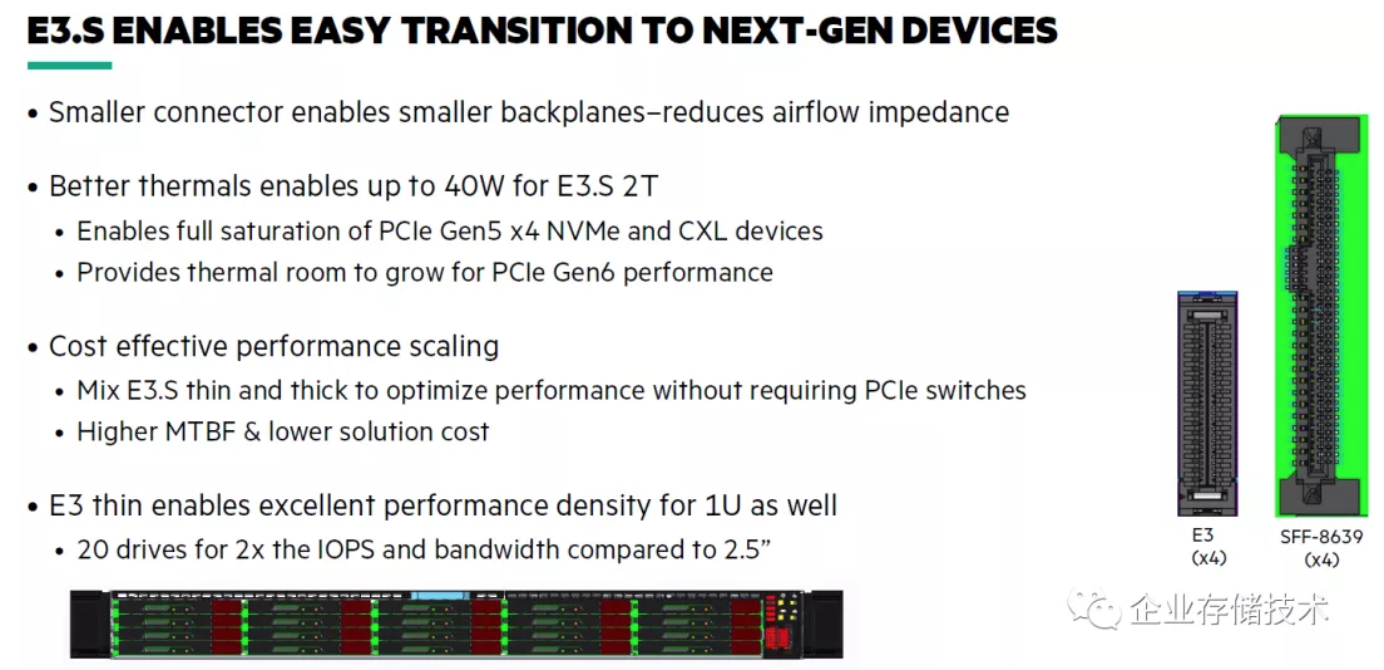

HPE分享:E3.S ENABLES NEXT-GEN DEVICES AND OPEN NVME SSD SPECS

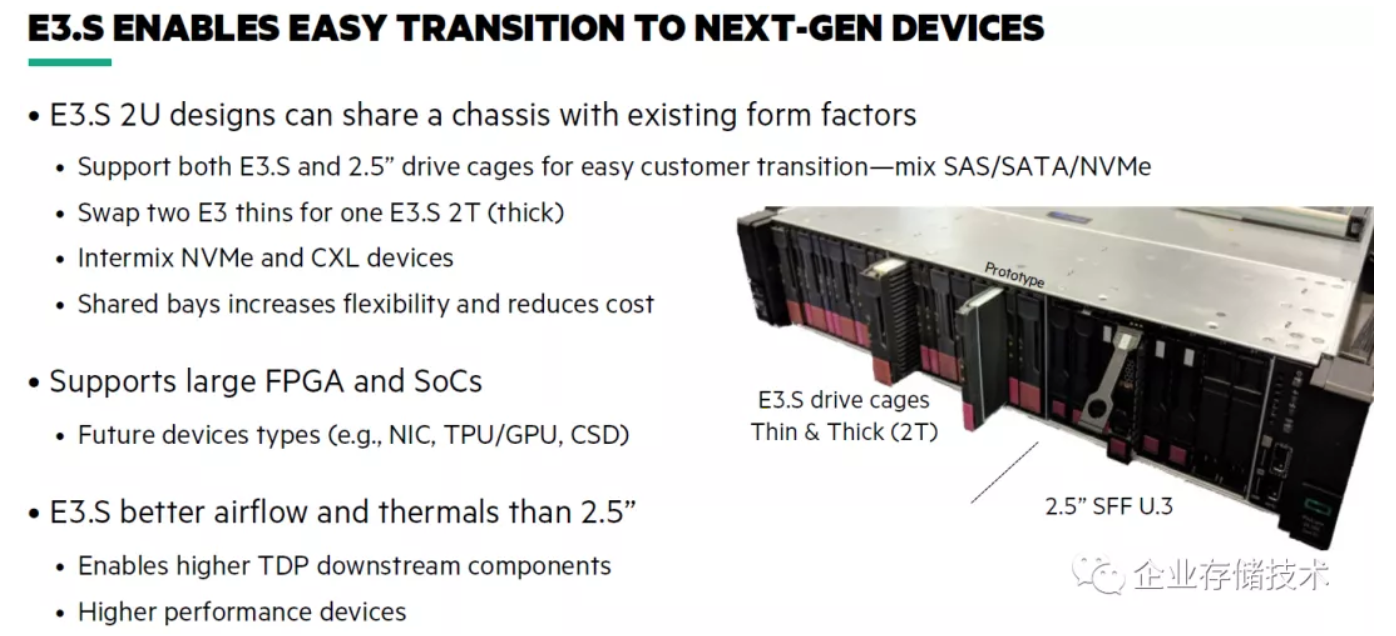

根据HP在这里的原型机和介绍,E3.S 2U设计可以和已有的2.5英寸驱动器共享机箱——即混用SAS/SATA/NVMe(注意背板的连接器不通用),同时还能够:

-切换2__个E3 thins__薄盘为1__个E3.S 2T__(thick__)厚盘;

-混用NVMe__和CXL__设备;

-共享仓位提升灵活性和降低成本。

E3.S可以支持较大的FPGA和SoC(不过前文中只有E3.LThick才有70W功耗),未来的设备类型如:NIC网卡、TPU/GPU、ComputerStorage计算型存储设备。

还有一点,就是E3.S的空气流动和散热比2.5寸驱动器更好,这样可以支持较高性能/TDP的设备。

同样是PCIe x4,E3设备的连接器尺寸比SFF-8639(同时还要提供向下兼容的2个SAS/SATA端口)明显小了许多,这样可以把背板做的更小——降低散热的流阻。

更好的散热,使E3.S双倍厚度支持到40W,从而适配PCIe Gen5和未来的Gen6性能。

Dell EMC分享:EDSFF E3 Form Facror,不只是SSD

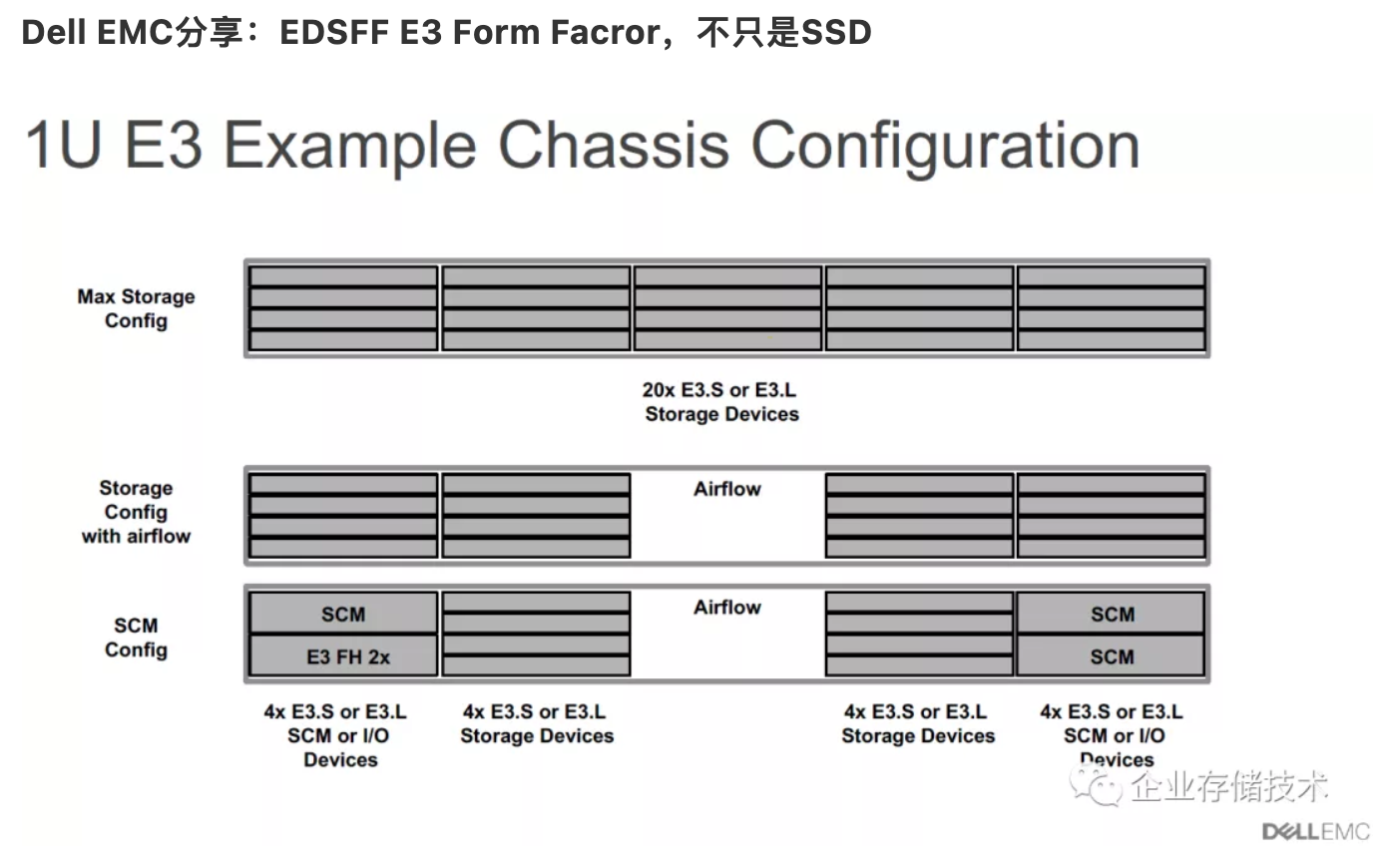

记得我在《1U__双路风冷350W__?点评方升服务器散热设计》中讨论过流阻对服务器中后部CPU等组件的影响。上图就是一种设计参考,比如在1U机箱配置E3.S/E3.L SSD时空出中间一列用于空气流动,还能保持16个SSD的密度。

在SCM(存储级内存)配置中,2个E3薄盘位置可以替换成1个E3 FH 2x厚盘,除了支持SCM之外还可以是I/O设备(我看了第一反应就是OCP网卡,稍后会讲到)。

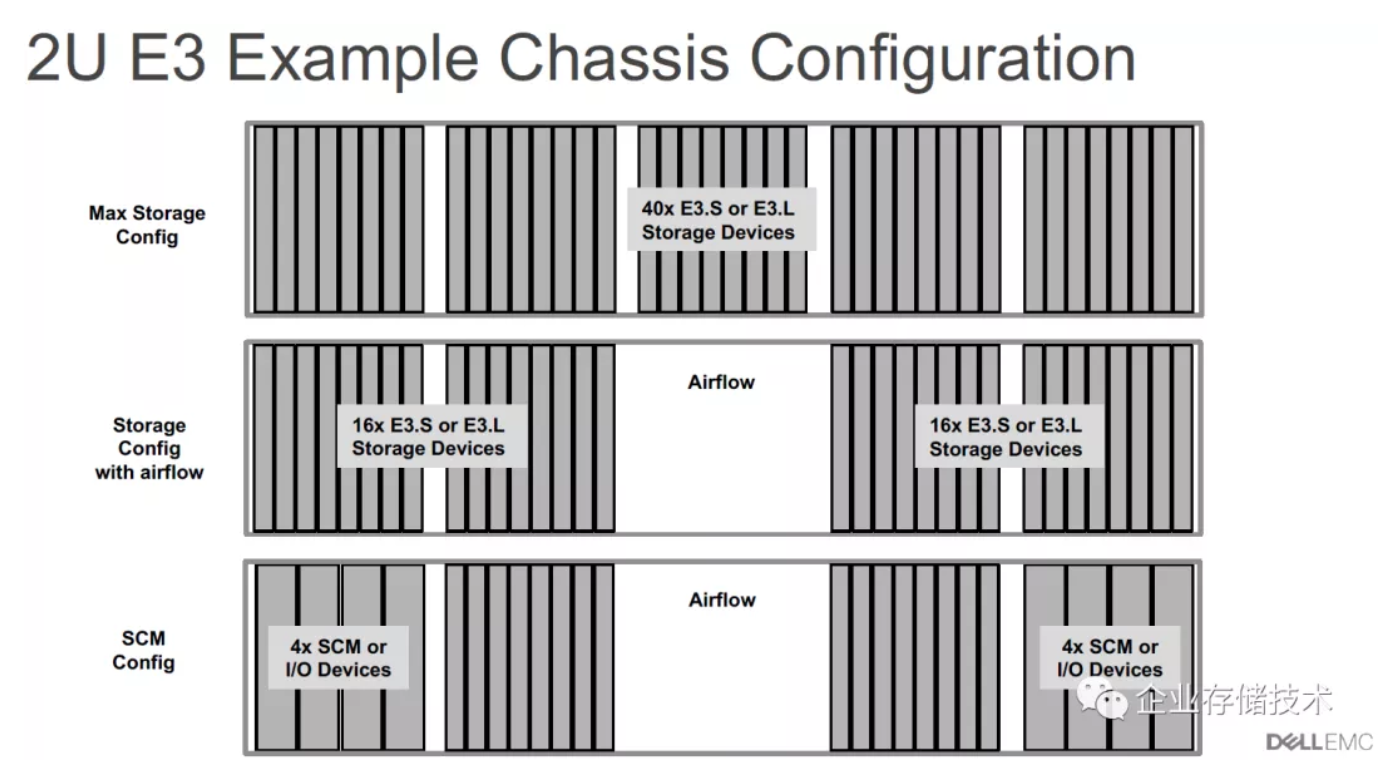

2U E3机箱的情况类似,如果觉得放40个E3.S或者E3.L SSD对服务器进风流阻影响大,可以考虑空出中间,两边各保留16个仍有32盘的密度。SCM配置与前面的1U机箱同理。

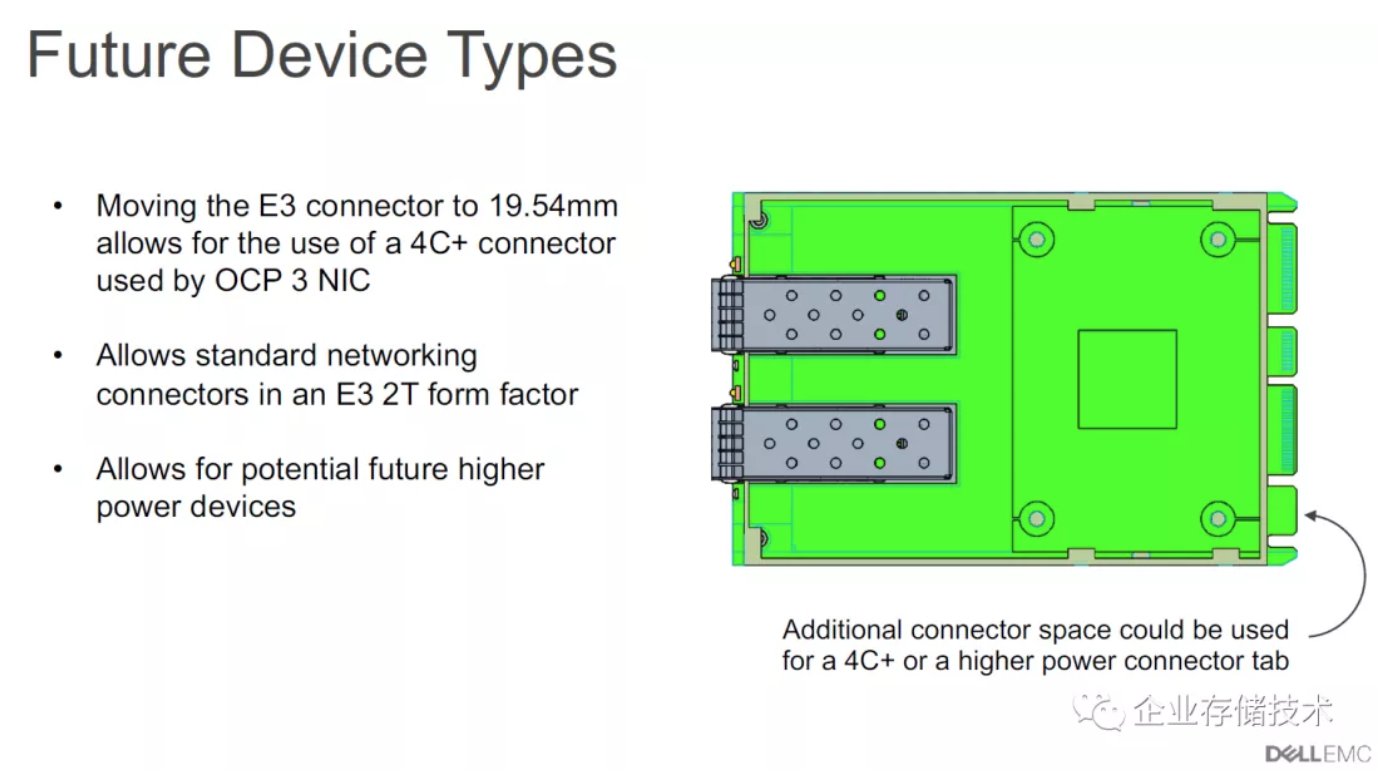

如上图,我理解这里应该是把E3(2T厚度)的连接器部分增加19.54mm(4C+),就能允许使用OCP3网卡了,也可以支持未来的高功耗设备。

我在《_下一代Xeon服务器:Ice Lake-SP通用云平台设计预览_》介绍过“2种中板、(前置)OCP网卡/U.2/EDSSF SSD灵活设计”。期待未来将网卡等统一到EDSFF E3,那时服务器设计将更通用模块化。

*Samsung、Micron、SK hynix和FADU*的PCIe Gen5 SSD

**

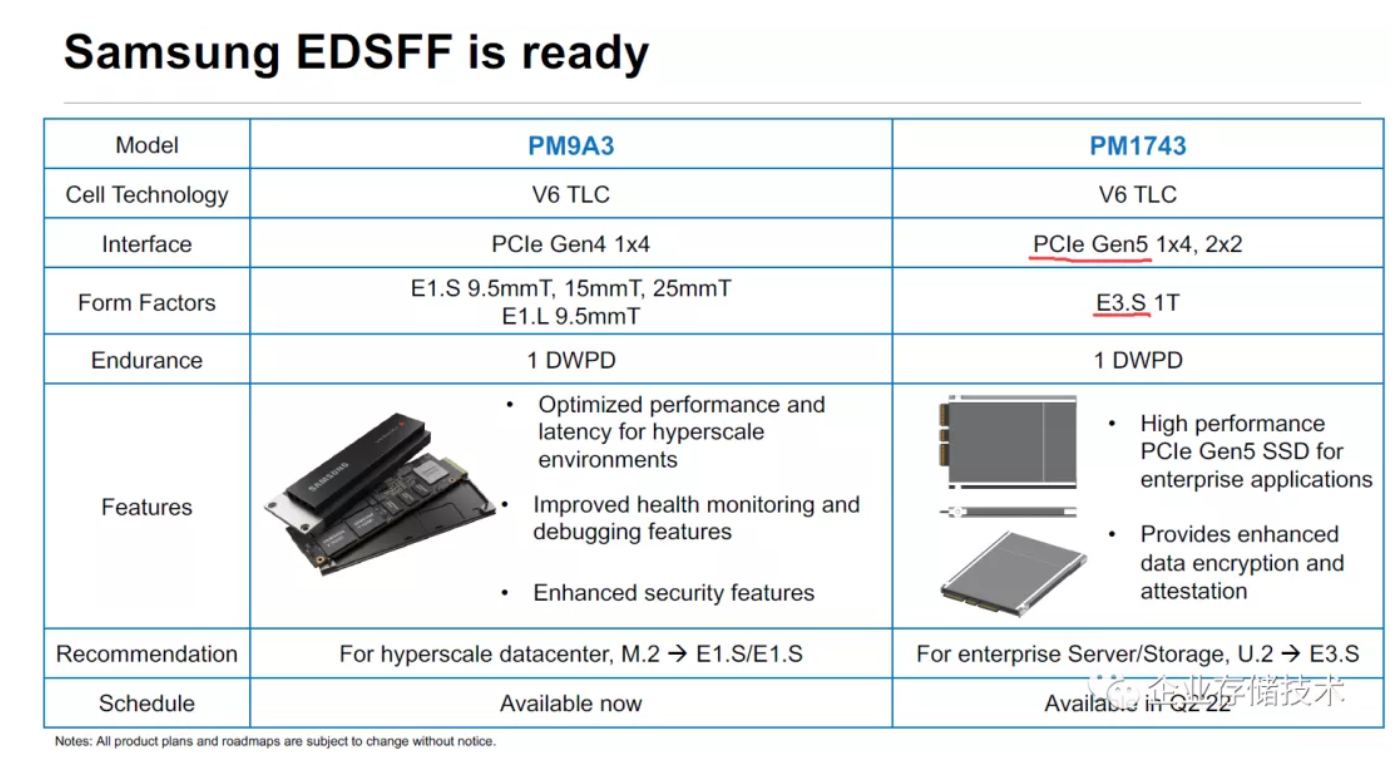

根据三星的介绍,其PM1743 PCIe Gen5 SSD将采用E3.S 1T尺寸,预计2022年Q2上市。

在美光的介绍中,M.2在数据中心的占比没有前文里那么高(这个统计应该是PB容量)。正如E1/E3在2022年之后逐渐替代U.2/U.3/2.5的趋势那样,“行业不能维持11种Form Factor,近期的焦点在E1.S,而长期还会有E1.L支持大容量、E3伴随PCIe Gen5增长。”

扩展阅读:《OCP__曝光NVMe/SAS RAID__卡、U.3__混合背板》

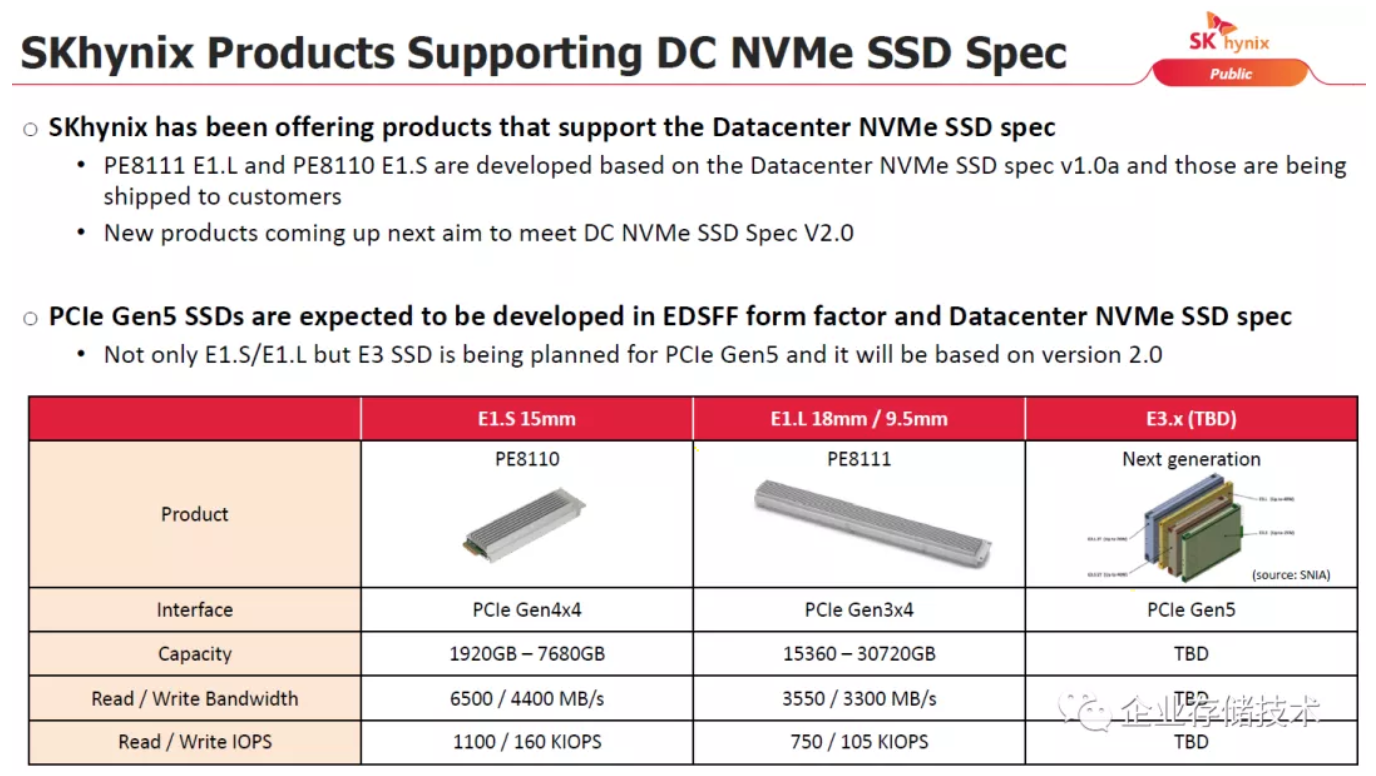

SK hynix也提到了下一代E3.xPCIe Gen5 SSD,不过我觉得随着对IntelSSD的收购,海力士自己原有的数据中心产品线存在不确定性。

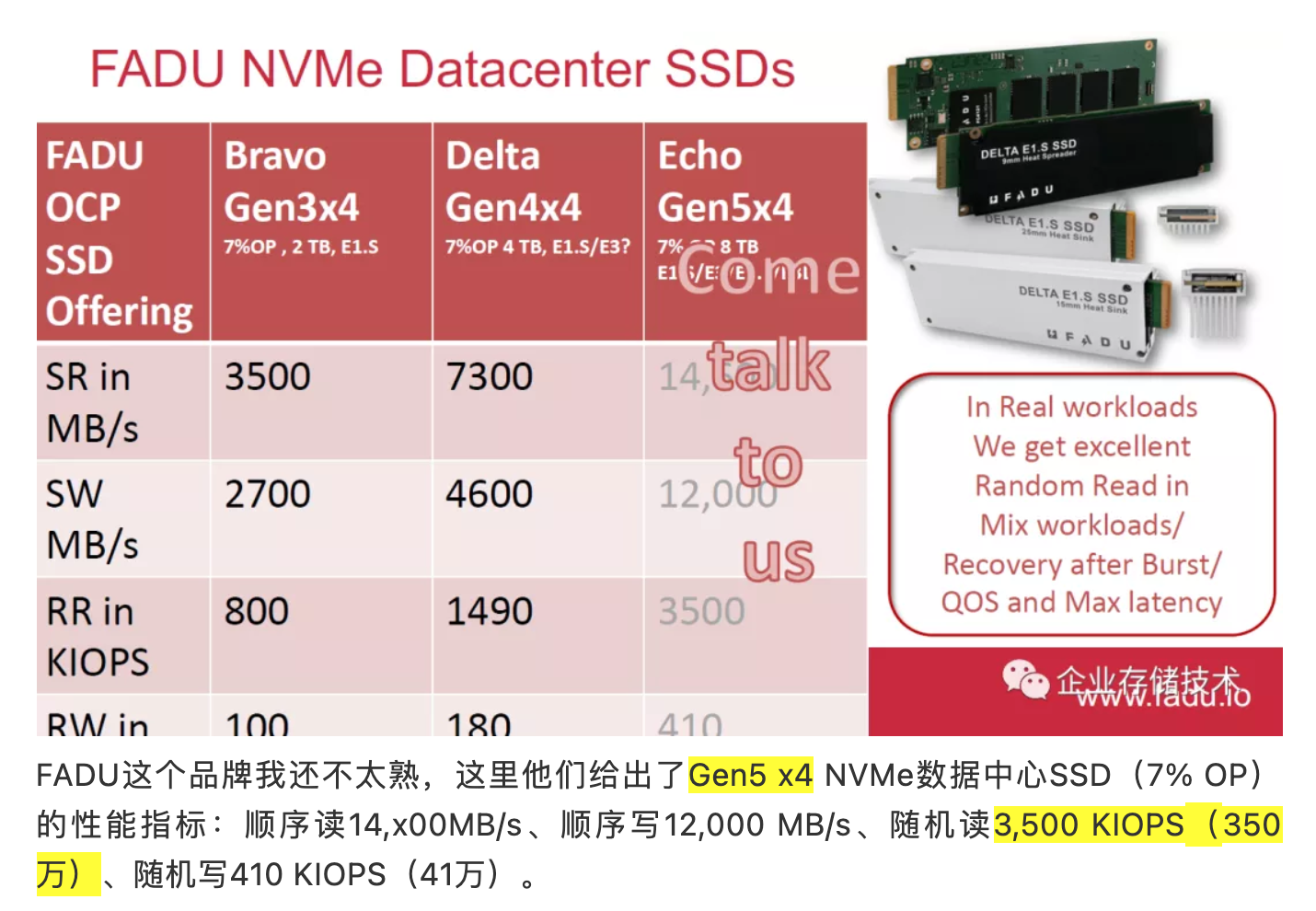

FADU这个品牌我还不太熟,这里他们给出了Gen5 x4 NVMe数据中心SSD(7% OP)的性能指标:顺序读14,x00MB/s、顺序写12,000 MB/s、随机读3,500 KIOPS(350万)、随机写410 KIOPS(41万)。

更多资料

未来EDSFF__规格的设备将不只是SSD

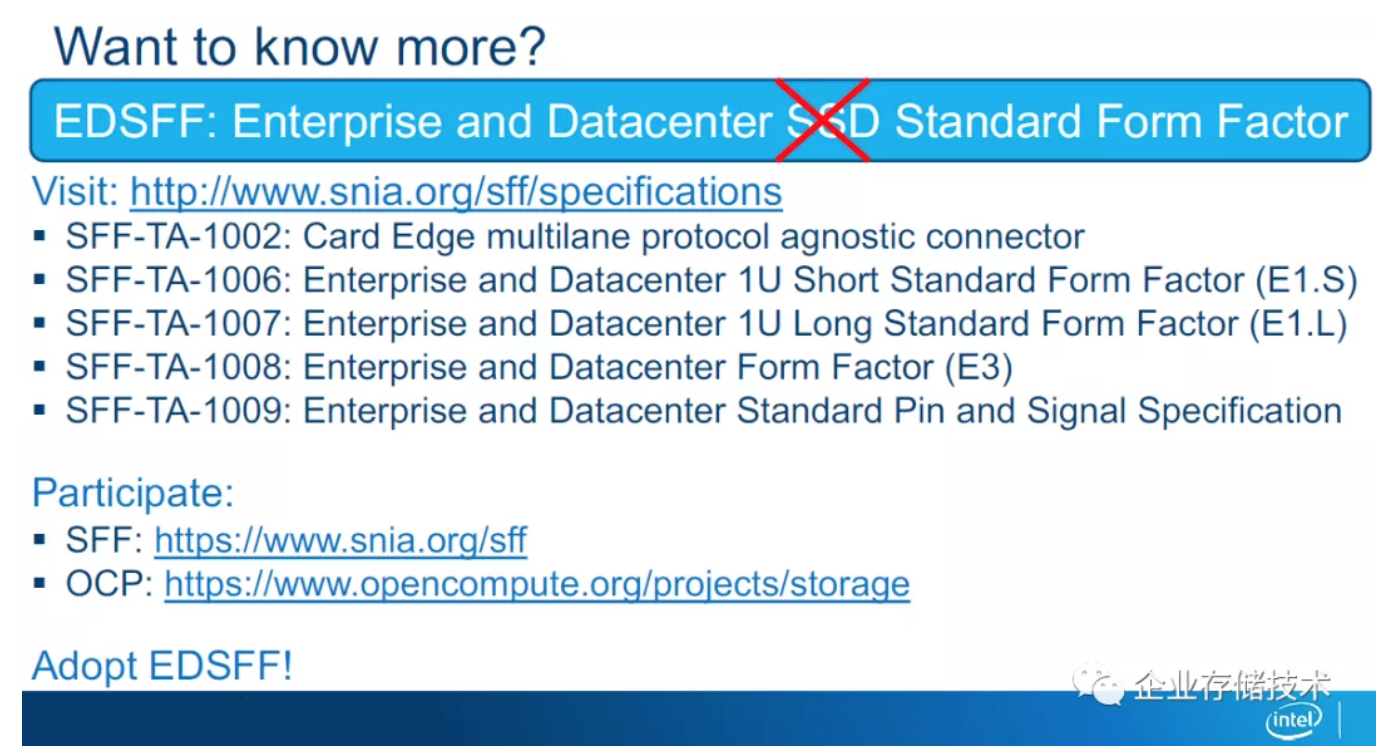

EDSFF规范的文档大家可以从SNIA网站下载。最后还是老规矩,我把这份OCP的参考资料也共享出来:

链接:https://pan.baidu.com/s/1LLbu...

提取码:k2x4

推荐阅读

注:本文只代表作者个人观点,与任何组织机构无关,如有错误和不足之处欢迎在留言中批评指正。 进一步交流技术可以加我的微信/QQ:490834312。

尊重知识,转载时请保留全文,并包括本行及如下二维码。感谢您的阅读和支持!《企业存储技术》微信公众号:HL_Storage,也欢迎关注企业存储技术极术专栏,定期更新。