首发:AIWalker

作者:HappyAIWalker

大家好,我是Happy。

NTIRE的各大竞赛已经落下帷幕,冠亚军排名也相继确定,笔者近期会逐步将相关领域的竞赛结果进行一下简单总结,同时也将对这其中的冠军军及优秀方案进行一番解读,感兴趣的朋友可以关注一波...

今天要介绍的NTIRE2021的压缩视频增强竞赛。

Background

由于网络带宽限制,视频压缩在降低比特率、促进高质量与高分辨率视频传输方面起着非常重要的作用。然而,视频压缩往往会导致保真度与视觉感知质量的损失。因此,压缩视频的画质增强很有必要:它有助于改善解码端的视频质量。

然而,学术界现有的视频数据量比较少。比如,目前压缩视频增强常用三个数据集:(1) Vimeo90K:尽管具有大量的序列,但每个序列只有7帧。这对于长视频序列的增强研究不够充分;(2) Vid70:只有70个视频序列;(3) JCT-VC:只有18个视频序列。也就是说,现有方案训练数据要么少于150视频序列,或者视频序列过短。因此,构建一个具有大尺度、场景多样性的训练数据对于视频增强的下一步研究非常重要。

Dataset

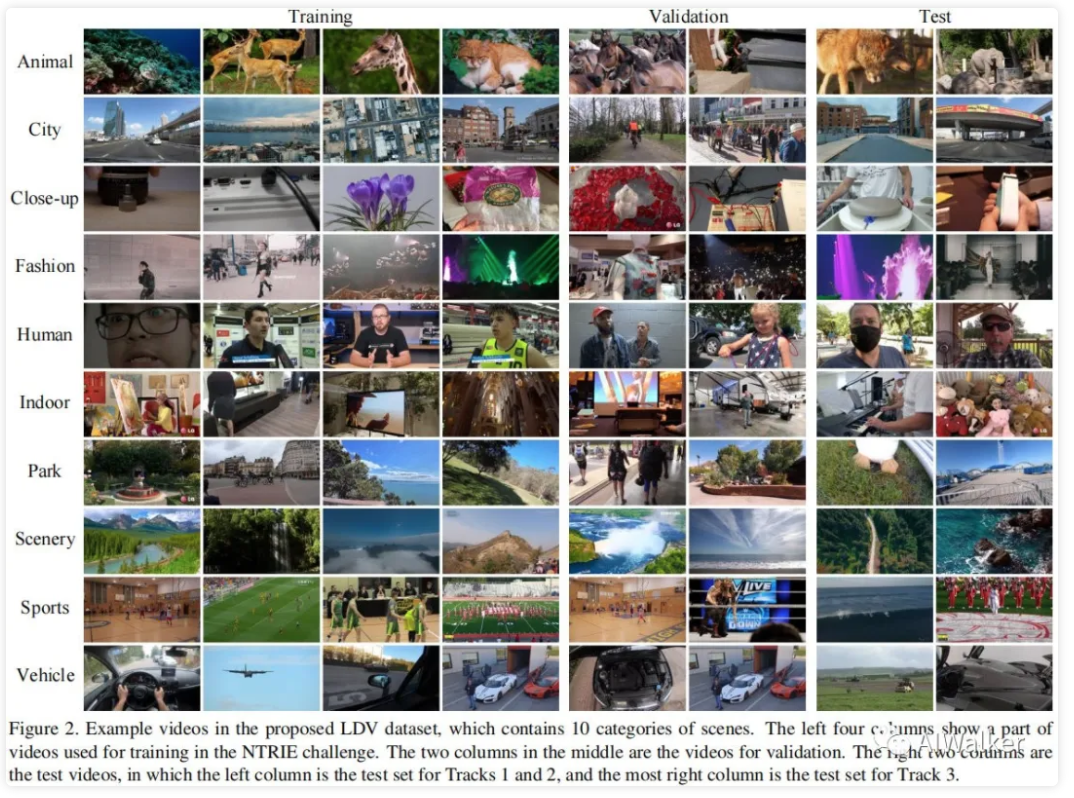

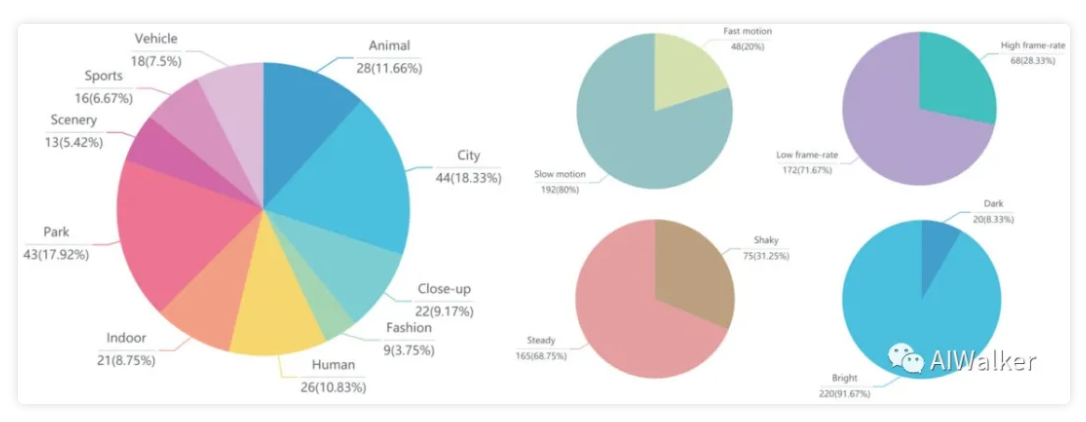

我们收集了一个新的数据集LDV(Large-scale Diverse Video),它包含240个分辨率为的高质量视频。LDV包含多样性的场景内容、不同的运动、不同的帧率。

Collecting LDV视频从YouTube上收集得到,为确保视频质量,我们仅仅收集4K分辨率视频且无明显压缩伪影。

Diversity 主要从场景类别、运动以及帧率三个角度考虑LDV视频的多样性。从上图Figure2可以看到,LDV包含10个场景;在240个视频中,48个视频具有快速运动;LDV视频的帧率从24到60不等,其中172个视频具有低帧率(即),68个视频具有高帧率(即);LDV中的75个视频存在相机轻微抖动,这会导致不规则的局部运动,更符合实际场景;LDV中的20个视频为暗场景。

Downscaling 为移除原始视频的压缩伪影,我们采用Lanczos filter进行x4下采样,然后每个视频进行crop以确保视频的宽高是8的倍数;最后将视频转为YUV420p格式。

Partition 在NTIRE2021竞赛中,我们将LDV数据分为三部分:训练集(200)、验证集(20)以及测试集(20)。20个测试集进一步拆分为两个分别包含10个室内的数据集,一个用于Track1与Track2,一个用于Track3。最后,附上关于LDV多样性分析图。

NTIRE 2021 video enhancement challenge

该竞赛包含三个赛道,Track1与Track2旨在对HM 16.20在固定QP=37压缩下的视频进行增强;Track3旨在对x265在固定比特率(200kbps)压缩下的视频进行增强。关于三个赛道数据的制作方案可参考相关竞赛链接:

Track1:https://competitions.codalab....

Track2:https://competitions.codalab....

Track3:https://competitions.codalab....

Challenge Results

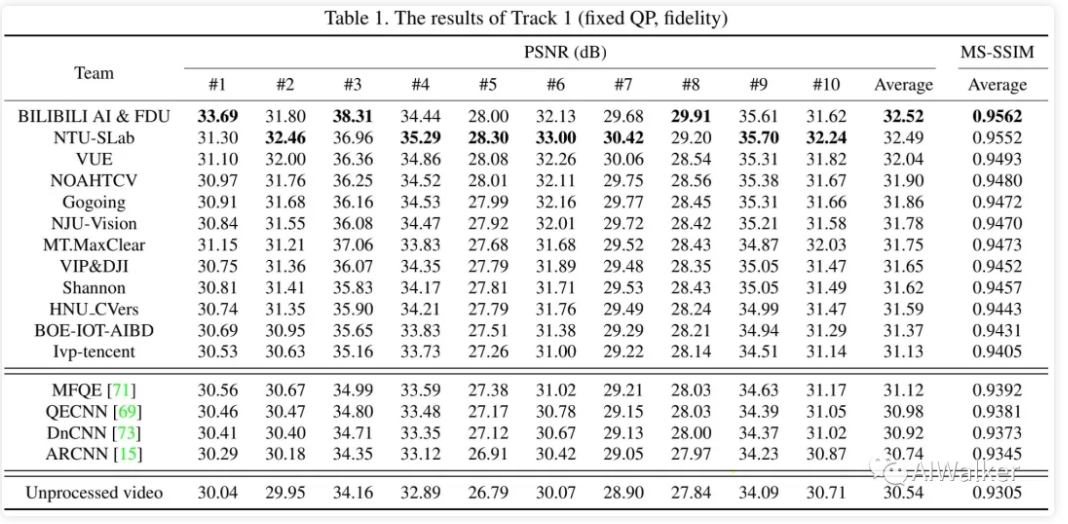

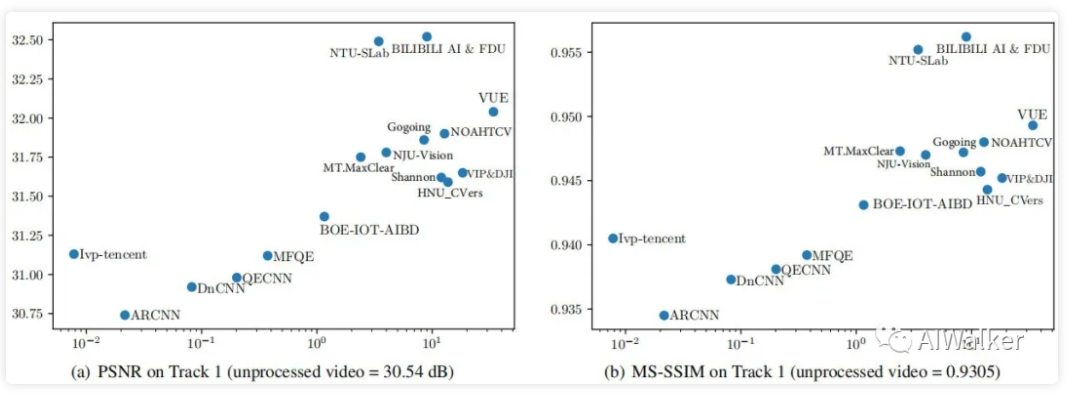

Track1: Fixed QP, Fidelity

上表给出了Track1竞赛的数值结果,总计有12个方案。unprocessed表示未增强的压缩视频。我们同时还在LDV对现有方案(如MFQE、QECNN、DnCNN、ARCNN)进行了训练,见上表。从表中结果可以看到:

- 12个方案的PSNR指标提升从0.59dB到1.98dB不等;在MS-SSIM指标的提升从0.0100到0.0257不等。

- BILIBILI AI&FDU团队取得了最佳PSNR指标与MS-SSIM指标,该方案将PSNR指标提升了1.98dB,MS-SSIM指标提升0.0257;

- NTU-SLab团队位列第二,其PSNR指标要比第一低0.03dB

- VUE团队第三,其PSNR指标要比第一低0.48dB;

- 在全部10个视频中,NTU-SLab有7个视频的指标比BILIBILI AI&FDU更高,说明其具有更好的泛化性能。

- 考虑到平均PSNR与泛化性,BILIBILI AI&FDU与NTU-SLab均为该赛道的冠军。

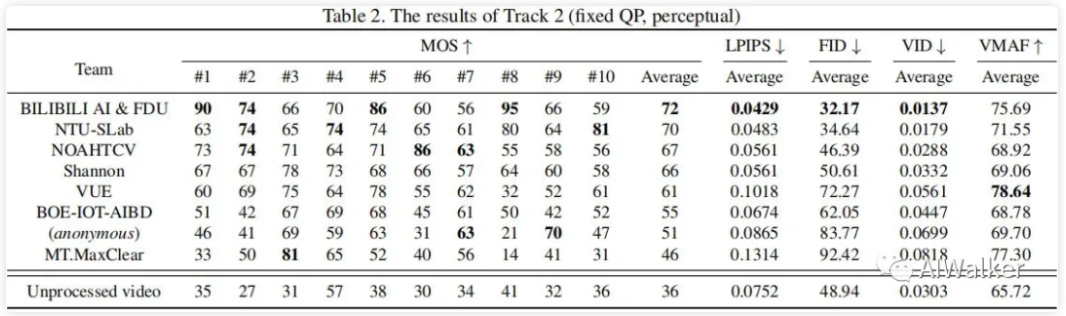

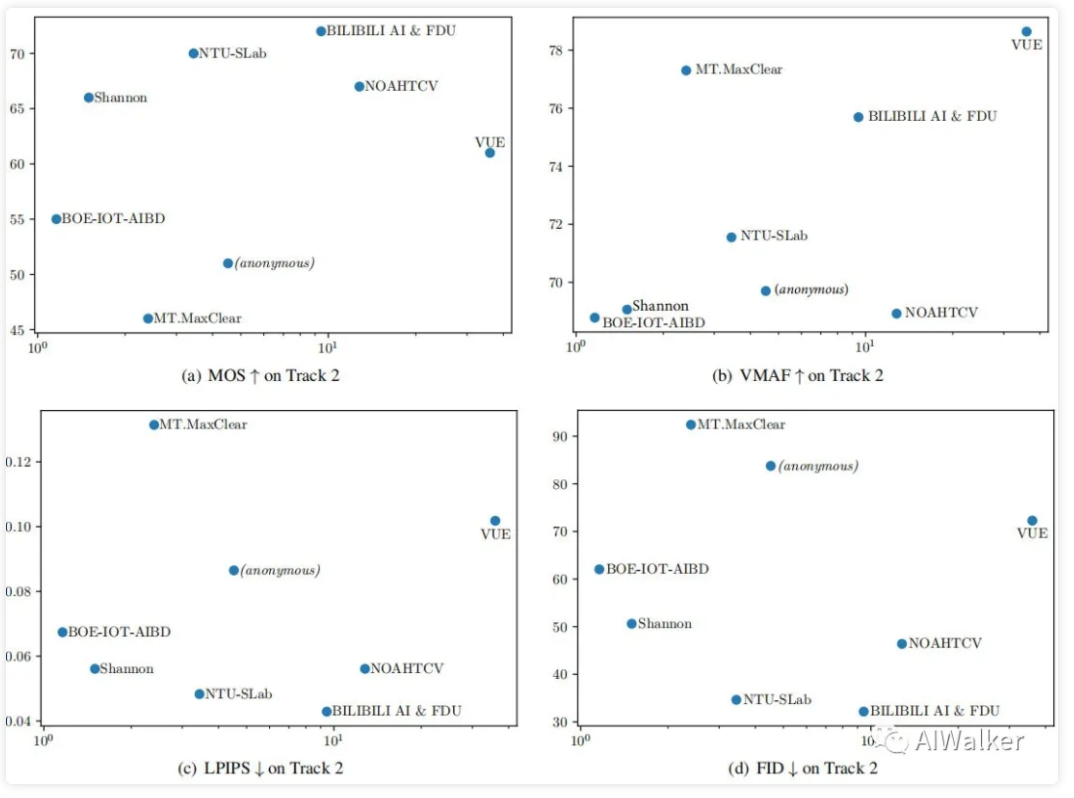

Track2:Fixed QP,Perceptual

上表给出了Track2竞赛的结果对比,从中可以看到:

- BILIBILI AI&FDU团队在10个视频中有4个取得了最佳MOS指标,且具有最佳平均MOS指标;

- NTU-SLab在10个视频中有3个取得了最佳MOS指标,其平均MOS指标第二;

- NOAHTCH在平均MOS方面排第三;

- 在LPIPS、FID、VID指标方面,BILIBILI AI&FDU、NTU-SLab以及NOAHTCH排名仍未冠亚季排序;这意味着几个指标在主观质量度量方面还是很有效的。

- 然而,VMAF指标则表现出了与MOS不同的结果。

- 此外,某些队伍在LPIPS、FID以及VID的指标要弱于未处理视频,而在MOS指标上要高于未处理视频。这意味着:感知度量并不总是可信赖,LPIPS、FID、VID是针对图像评价设计,可能不适用于视频质量评价。

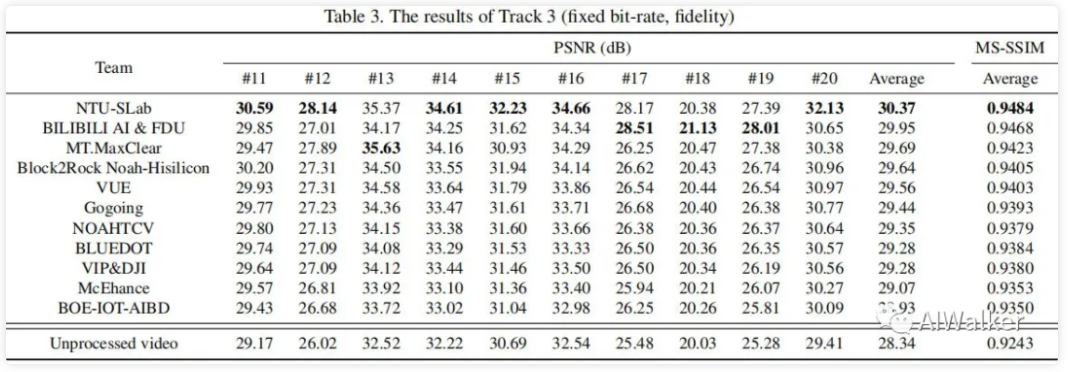

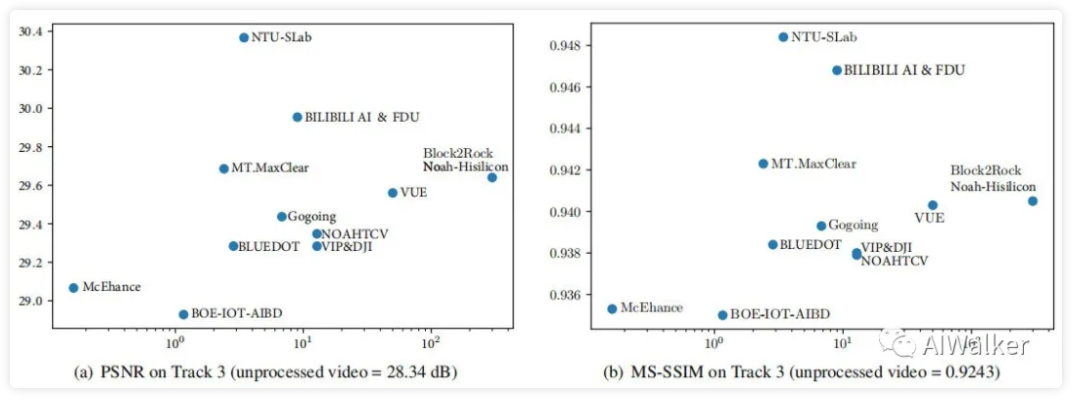

Track3:

上表给出了Track3竞赛的结果对比,从中可以看到:

- NTU-SLab在10个视频中有6个具有最佳指标,且平均PSNR排名第一,相比未处理视频,PSNR指标提升2.03dB;

- BILIBILI AI&FDU团队取得了第二的成绩,PSNR指标提升1.61dB;

- MT.MaxClear排名第三,PSNR指标提升1.35dB。

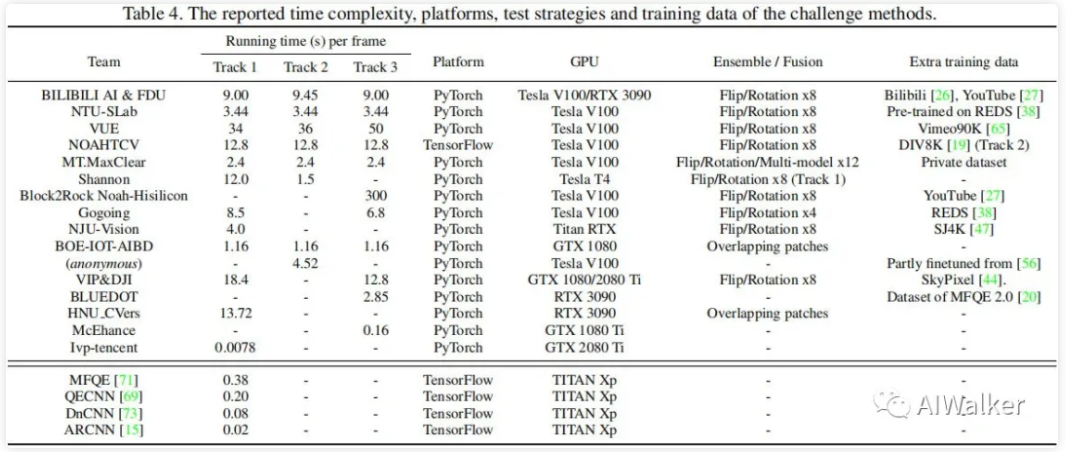

Efficiency

上表列出了所提方案的耗时对比,可以看到:

- 尽管NTU-SLab与BILIBI AI&FDU在三个赛道均具有最佳、次佳性能,但NTU-SLab具有最快的推理速度。也就是说,NTU-SLab取得了最佳的性能-耗时均衡。

- 在Track3的top3方案中,MT.MaxClear具有最快的推理速度;

- Ivp-tencent方案具有最快的推理速度,甚至可以每秒处理120帧;

- 大部分团队都采用了额外的训练数据,也就是说训练数据的尺度对于模型性能有明显影响;

- 大部分团队都采用了emsemble策略提升模型性能。

Challenge Method and teams

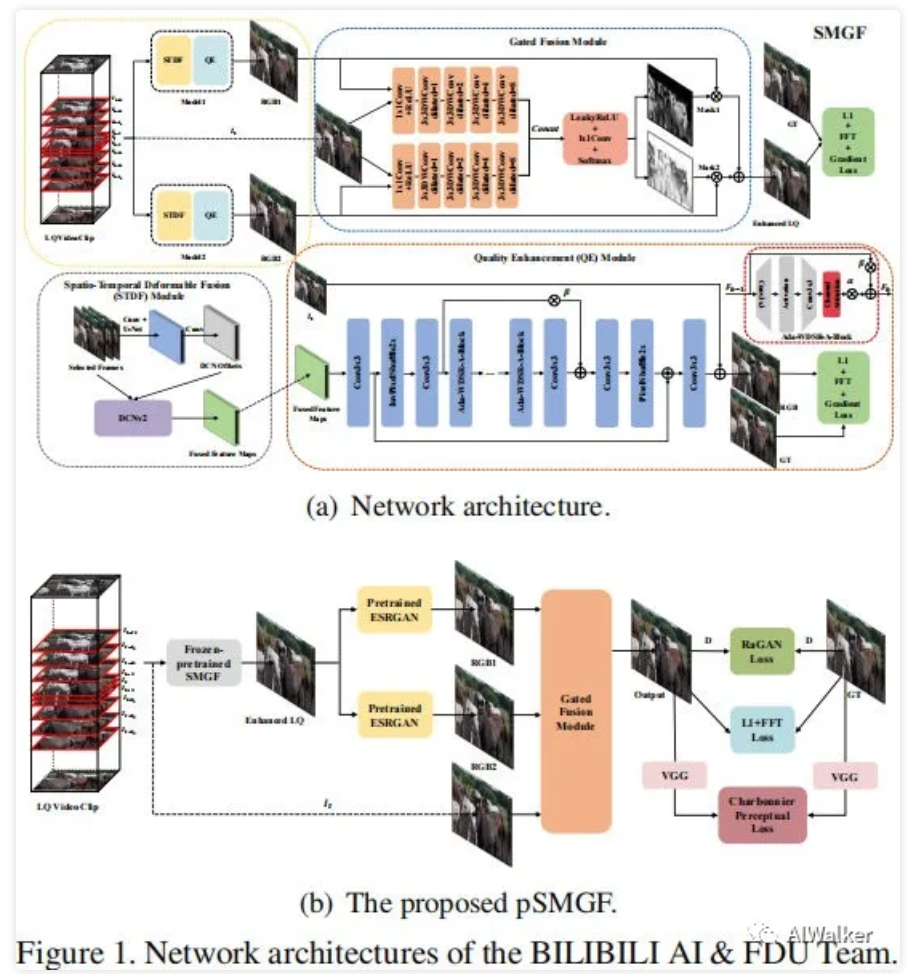

BILIBILI AI&FDU

Track1 在该赛道,他们提出了SMGF(Spatiotemporal Model with Gated Fusion)用于压缩视频增强,见下图。在初始阶段,首先从数据流中提取每帧的QP信息;然后,基于QP值选择前后近邻4帧(合计9帧)送入STDF模型中以捕获空时信息;STDF的输出将被送入QE(Quality Enhancement)模块,它采用C2CNet中的自适应WDSR-A-Block作为QE模块,同时还引入了通道注意力。

- Track2:他们复用了Track1的模型并冻结,然后在尾部添加ESRGAN以提升感知质量,见上图b。

- Track3:他们采用Track1的模型作为预训练模型,并在Track3的数据上进行微调。另外一个区别在于:采用了近邻帧而非PQF帧。

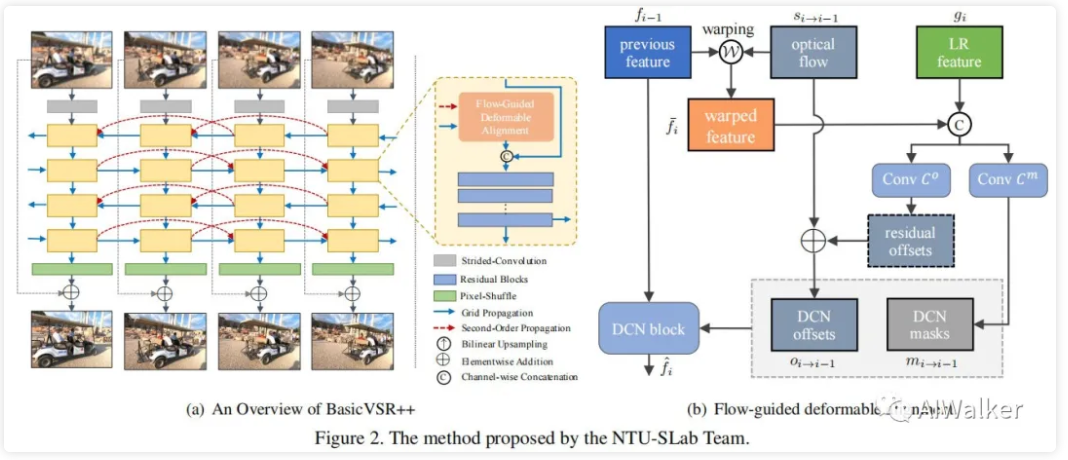

NTU-SLab

下图给出了NTU-SLab团队采用的BasicVSR++方案的结构示意图,它是在BasicVSR的基础上改进而来。针对BasicVSR的局限性:特征仅进行一次传播,提出了二阶网格传播机制促进特性的多次提炼。通过多次双向投影,不同时间补偿的特征可以倍访问多次进而在不同传播阶段提取不同的信息。

针对BasicVSR中的光流对齐存在问题,借鉴形变对齐的优势,提出一种光流引导形变对齐模块,见上图。更详细的解读请移步:CVPR2021 | NTIRE2021竞赛"三冠一亚"方案BasicVSR++,Vid4新巅峰29.04dB。

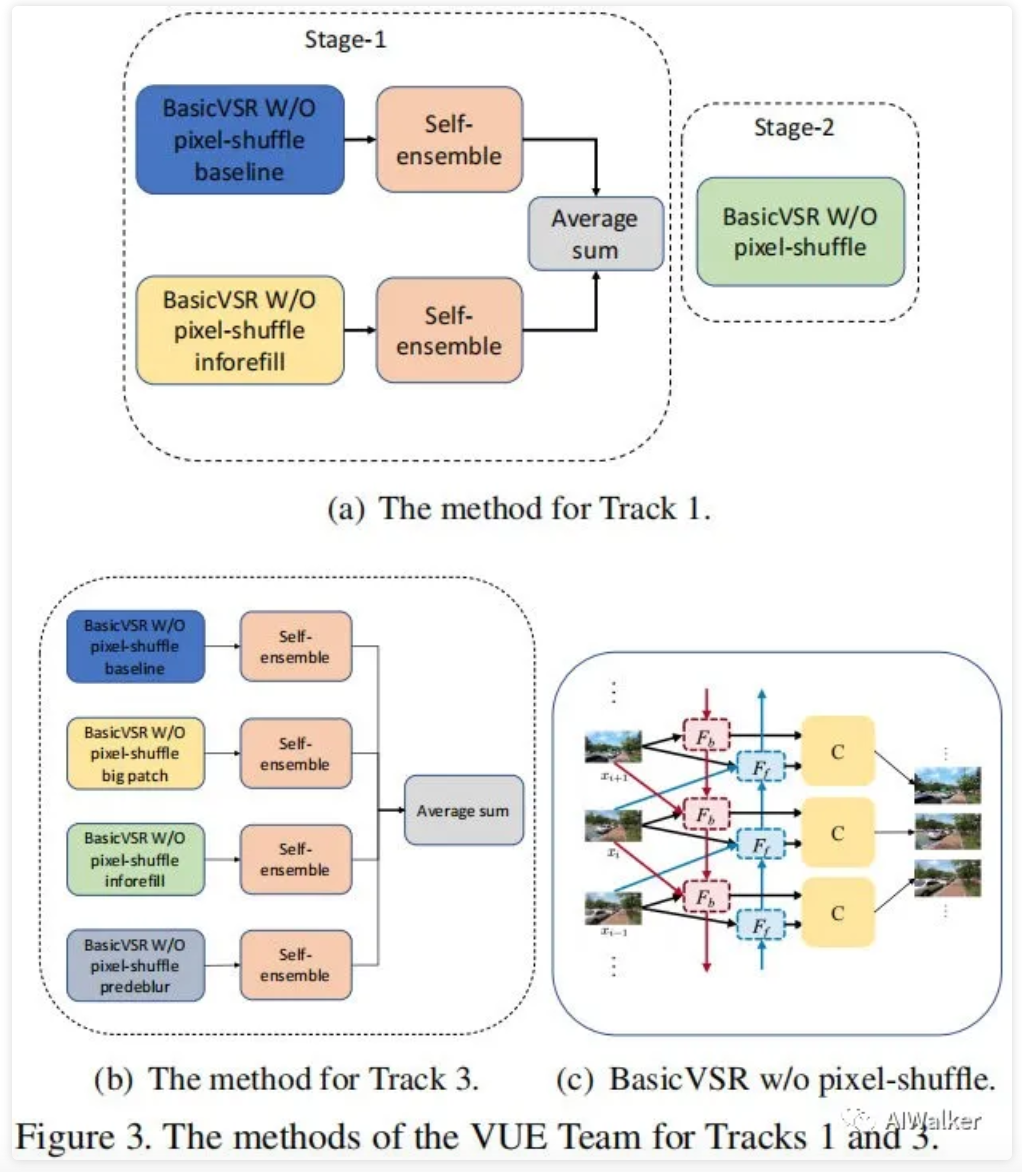

VUE

上图为VUE团队在Track1与Track3上的结构示意图,它是在BasicVSR基础上改进而来。在Track1,他们提出了一个两阶段:

- 训练两个不同参数的BasicVSR后接自集成策略;然后通过平均集成两个分支结果。

- 训练另一个BasicVSR模型。

在Track3,采用了无上采样层的BasicVSR模型,训练了四个不同参数的BasicVSR,后接自集成策略,最后将四个输出平均作为最终的结果。

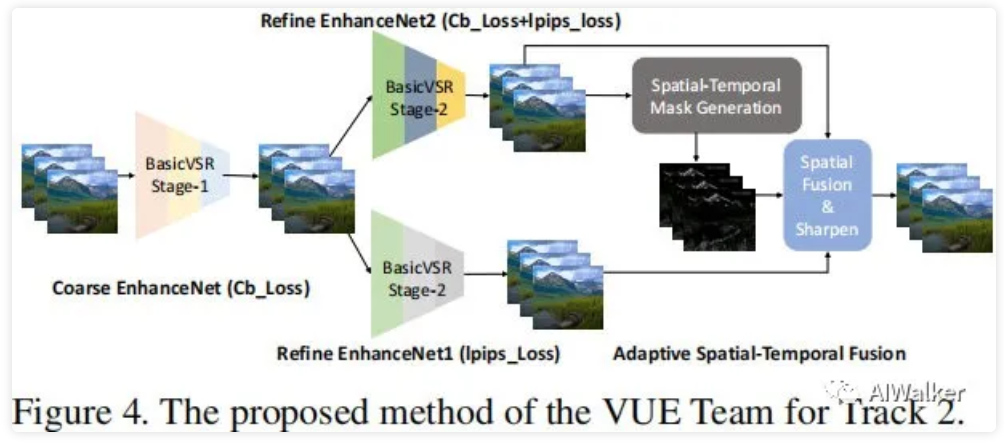

上图为Track2竞赛的网络架构示意图,他们提出了自适应融合不同损失增强结果。在stage1阶段,训练一个具有高保真度的BasicVSR模型(损失函数为Charbonnier);在stage2阶段,训练两个具有不同损失的BasicVSR,两个损失分别为:

NOAHTCV

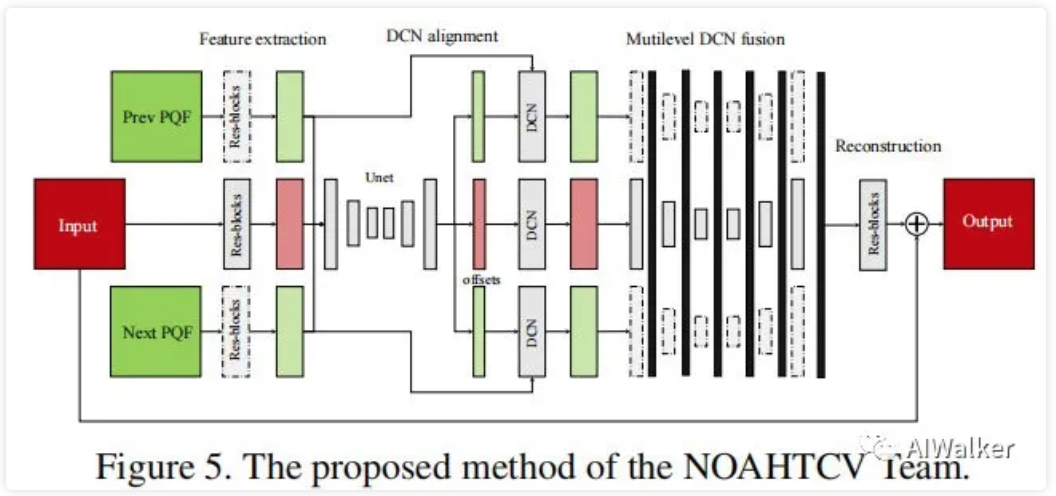

上图为NOAHTCV团队的解决方案,它的输入帧为三帧。采用共享 特征提取器提取特征,然后采用UNet提取每个输入的offset并被用于显示对齐、特征融合。在完成初始特征对齐与融合后,采用多头UNet处理每个输入特征;最后将多头UNet的输出特征进行融合得到最终的输出。

其他方案

- MT.MaxClear团队基于EDVR设计,在EDVR基础上添加了两个offset损失(offsets Total Variation Loss, offsets Variation Loss)以稳定训练。

- Gogoing团队同样是在EDVR基础上演变而来;

- NJU-Vision团队同样是在EDVR基础上演变而来;

- BOE-IOT-AIBD团队则是在MGBP基础上演变而来;

- Anonymous同样是在EDVR基础上演变而来;

- VIP&DJI是在EDVR、FastDVDNet、DRN基础上演变而来;

- BLUEDOT团队是在EDVR、TTSR基础上演变而来;

- HNU-CVers团队是在RCAN基础上演变而来;

- McEnhance团队是EDVR基础上演变而来;

- Ivp-tencent团队是在EDSR、FFDNet基础上演变而来

推荐阅读

本文章著作权归作者所有,任何形式的转载都请注明出处。更多动态滤波,图像质量,超分辨相关请关注我的专栏深度学习从入门到精通。