Aurora最近上市,市值超过一百亿美金。其自动驾驶工程师团队超过1400人;曾收购一个激光雷达公司Blackmore,采用的FMCW而不是TOF技术,还收购一个激光雷达芯片公司Ours,也是基于FMCW技术的芯片设计(Lidar on-chip);当然,最著名的收购是Uber ATG团队(被称“蛇吞象”)。

2017年成立的Aurora,其创始人来自Google、Uber和Tesla,背景算是“根正苗红”。刚开始是面向无人出租车应用,但近一年已经把商用大卡车业务作为自己的主业。

除了激光雷达技术和激光雷达芯片技术,Aurora的自动驾驶算法很少公开,最近上市前的融资材料公布了一些信息:

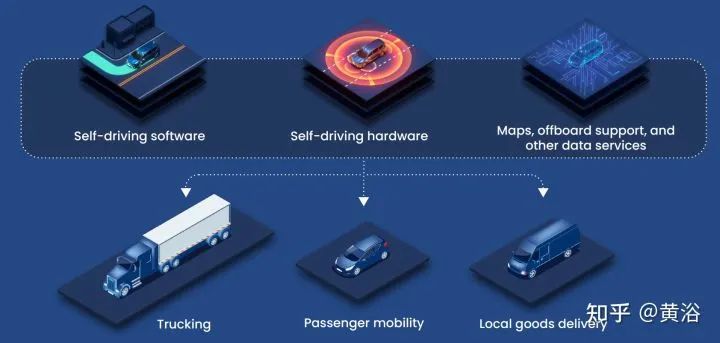

这是Aurora Driver平台概览:软件、硬件、地图、数据服务、车辆

这是其全栈自动驾驶技术一览:传感器、定位、地图、感知、规划、控制、仿真、线控

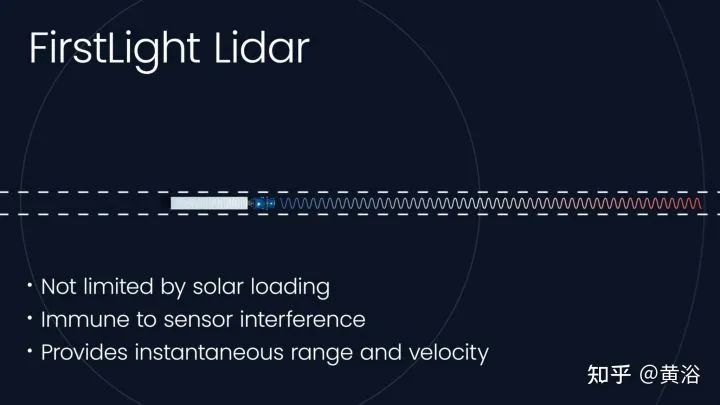

这是其激光雷达的优点介绍:长距离感知、抗干扰,能同时测速和距离

提供仿真测试和数据回放的示意图:减少路测、其运动规划仿真比路测成本减少2500+倍,1小时仿真测试相当于5万个车辆路测,其中可以模拟2百25万次无保护左拐弯。

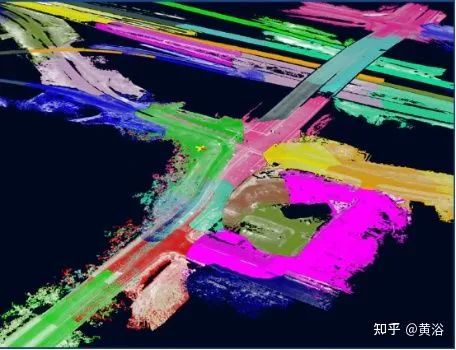

高清地图制作Aurora Atlas:几乎实时更新、制图过程大规模并行

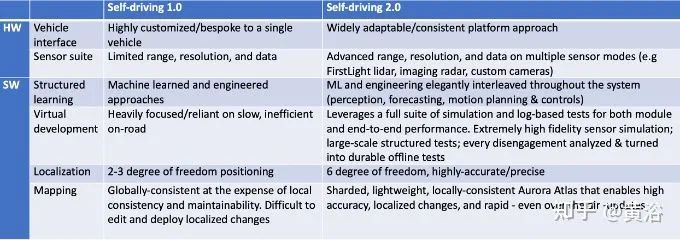

最后正在开发的自动驾驶2.0系统,和自动驾驶1.0系统比较如下:

之前曾在CVPR'21的workshop特邀报告中介绍过Aurora的两个工作:

其中一个工作题目是“Bridging Perception to motion planning“

另一个工作题目是”The value proposition of forecasting for motion planning“

其实这两个报告都提到Aurora收购的Uber ATG团队已发表一些文章,从中可以探究其技术的细节 (注:原来Uber ATG在多伦多的分部并没有归属Aurora,其首席科学家已经创业成立了自动驾驶公司Waabi,而且其主要应用场景也是选的商业卡车!),下面介绍相关的论文如下:

1 “LaserFlow: Efficient and Probabilistic Object Detection and Motion Forecasting”

原来Uber ATG匹兹堡团队在2020年10月15日上传arXiv。

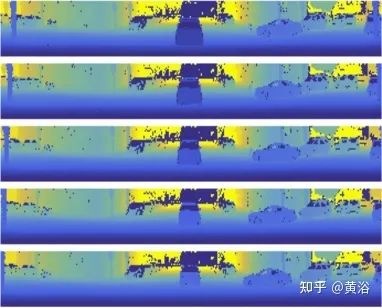

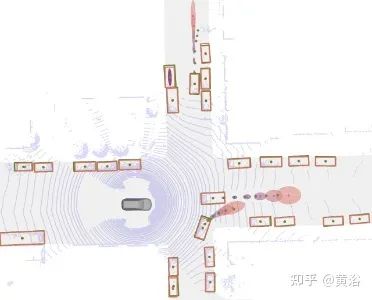

提出的一个方法,LaserFlow,基于激光雷达的三维目标检测和运动预测。该方法利用激光雷达的距离视图(RV)表示 ,在传感器的全距离实时操作,没有BEV的体素化或数据压缩。提出的多扫描(multi- sweep)融合架构,直接从距离图像提取和合并时域特征。此外,受课程学习启发提出一种技术,学习未来的轨迹的概率分布。

如图是激光雷达输入距离数据序列和不确定性的轨迹输出的例子:a)输入的激光雷达距离(RV)数据序列,输出不确定性的轨迹(BEV)

(a)

(b)

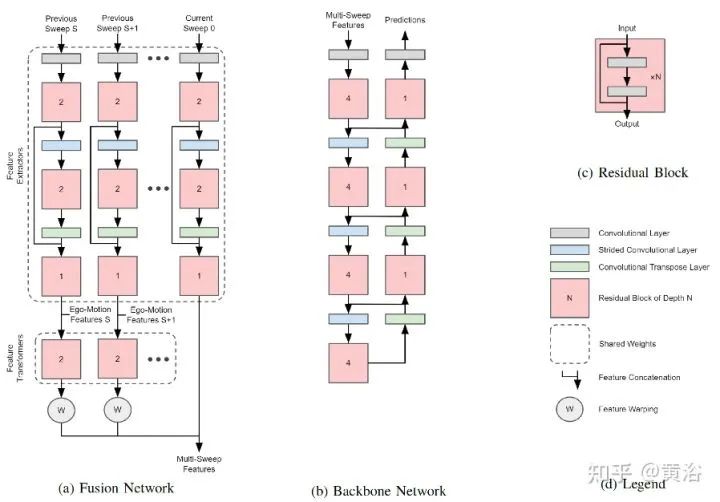

如图所示,提出的网络架构:提取multi-sweep特征,检测和预测运动目标。

在multi-sweep体系结构,特征提取独立于每个激光雷达在其原始视图的sweep。每个sweep的特征通过一个特征转换器,学习从原始坐标系到全局坐标系的特征转换。以前的sweep,warp到当前sweep的图像,并连接在一起,这个作为transformer network;这个multi- sweep的特征图输入到一个骨干网络检测目标和估计其运动。

给定multi-sweep激光雷达数据,模型的目标(goal)是,预测所有轨迹的概率。对于距离图像的每个点,预测一组类别概率,即确定点落在哪个目标上,输出3-D目标框的维度,同时输出目标的位移向量、旋转角和不确定性得分。激光雷达点云预测的轨迹最后通过近似mean-shift算法聚类成目标(object)。

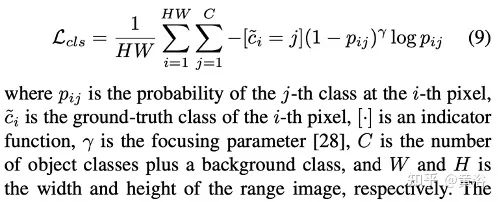

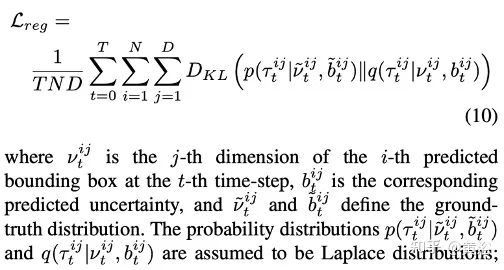

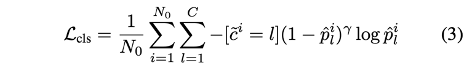

端到端训练的损失项包括focal loss的分类和K-L发散的回归:

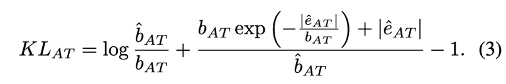

其中KL发散定义为

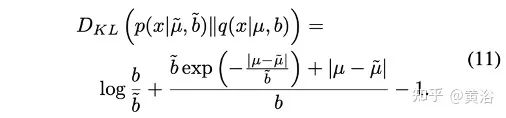

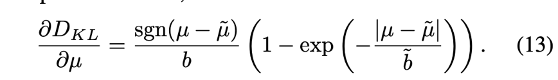

KL发散的梯度计算,是为了重新加权损失,估计不确定性:

通过不确定性的课程学习,可以确保早期预测在后期得到修正。

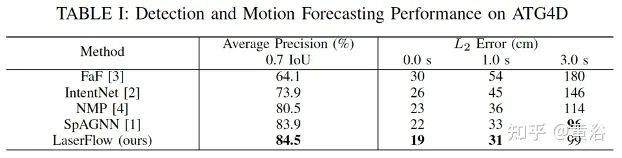

实验结果如下:基准方法包括

- 1. FaF(“Fast and furious: Real time end-to-end 3D detection, tracking and motion forecasting with a single convolutional net,” ,CVPR,2018)

- 2. IntentNet (“IntentNet: Learning to predict intention from raw sensor data,” CoRL, 2018)

- 3. NMP (“End-to-end interpretable neural motion planner,” CVPR,2019)

- 4. SpAGNN (“Spatially-aware graph neural networks for relational behavior forecasting from sensor data,” _arXiv:1910.08233_, 2019 )

2 ”Map-Adaptive Goal-Based Trajectory Prediction”

原来Uber ATG匹兹堡团队在2020年11月13日上传arXiv。

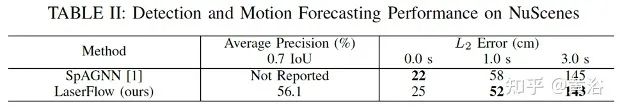

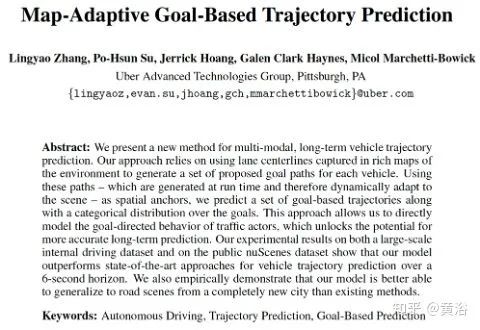

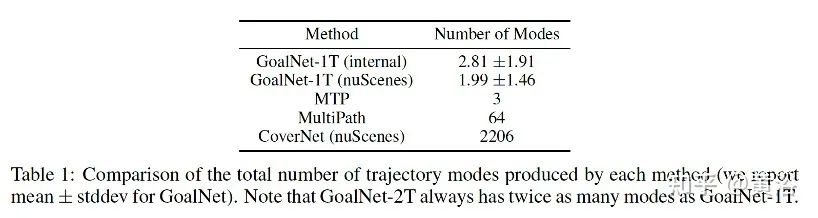

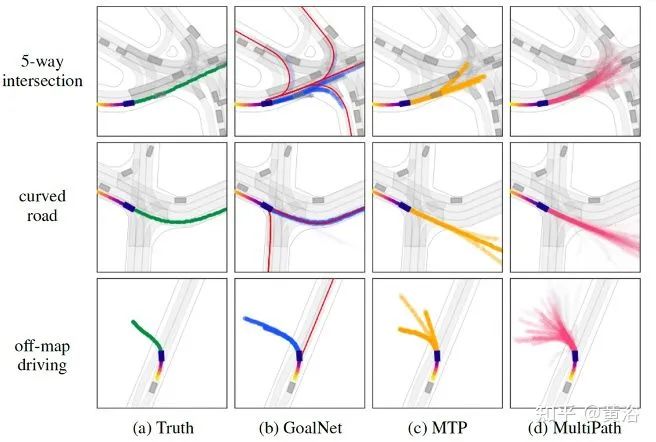

提出一种多模态、长时车辆轨迹预测方法,GoalNet。该方法依赖于在丰富的环境地图中捕获的车道中心线为每辆车生成一组建议的目标路径(goal paths)。用这些运行时生成、动态适应场景的路径作为空域锚,预测一组基于目标(goal-based)的轨迹以及这些目标上的类别分布。这种方法能够直接模拟交通参与者的目标导向(goal- directed)行为,释放更准确长时预测的潜力。在大规模内部驾驶数据集和公共数据集nuScenes上的实验结果表明,该模型能够更好地推广到一个完全新出现城市的道路场景。

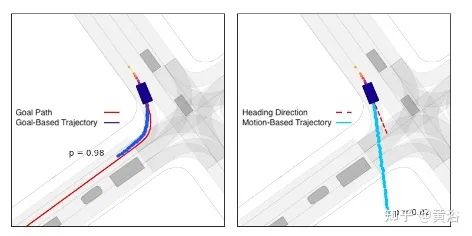

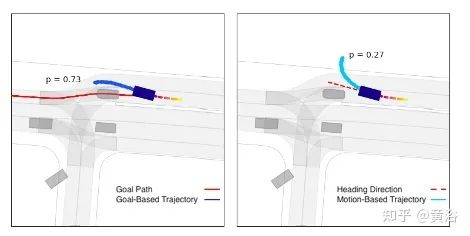

如下图显示基于目标(goal-based)和基于运动(motion-based)的轨迹双重性。两个不同的场景,每个场景都有一个感兴趣的参与者。图( a )中,基于目标的轨迹得到高概率( 98 %),因为目标为参与者的运动提供了一个很好的解释。图( b )中,由于候选目标路径不能完全解释参与者的当前运动,比图( a )( 2 %)更高的概率( 27 %)分配到基于运动的轨迹。

(a)

(b)

在这两种情况下,只为每个参与者提供一条建议的目标路径(goal path),这意味着模型的最简单变型会生成两条轨迹预测:一条基于目标的轨迹用目标路径作为空域锚,另一条基于运动的轨迹用参与者的前向作为参考方向。这些示例说明,模型能够在目标路径有意义时使用,但在没有目标能够充分解释参与者当前运动时,也可以学习退回到基于运动的预测。

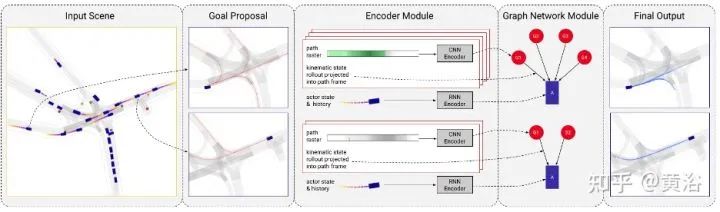

该模型GoalNet,其框架概览如图所示:包括3个组件,即 ( 1 )目标提议(goal proposal):基于局部地图几何,为每个参与者提出一组目标;(2)编码器模块:参与者状态和场景上下文在这个模块中进行编码;(3)图网络模块:用图网络基于编码特征进行预测。

在图网络中,每个图包含两种类型的节点:单个参与者节点 A 和多个目标节点Gj;图的有向边 Ej ,起源于每个目标节点,并终止于参与者节点。给定得到的节点和边缘表示,从参与者-目标边缘可预测基于目标的轨迹和概率,并从参与者节点预测无目标(goal-free)轨迹和概率。

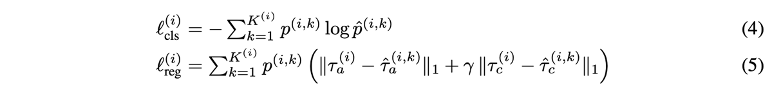

模型训练的分类项和回归损失项分别是:

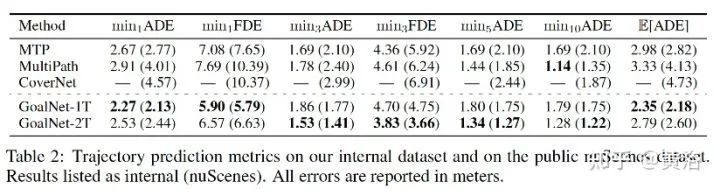

实验结果如下:其中基准算法是

- 1. MTP(“Multimodal trajectory predictions for autonomous driving using deep convolutional networks”,ICRA,2019 )

- 2. MultiPath(“MultiPath: Multiple probabilistic anchor trajectory hypotheses for behavior prediction”,ICRL,2020)

- 3. CoverNet(“CoverNet: Multi- modal behavior prediction using trajectory sets”,CVPR 2020)。

如图左栏显示感兴趣参与者的真实未来轨迹(绿色),随后列显示来自 Goal Net (蓝色)、 MTP (黄色)和MultiPath(粉色)的预测轨迹。对所有方法,轨迹概率编码成α不透明值。对 于Goal Net,用红色显示目标路径。

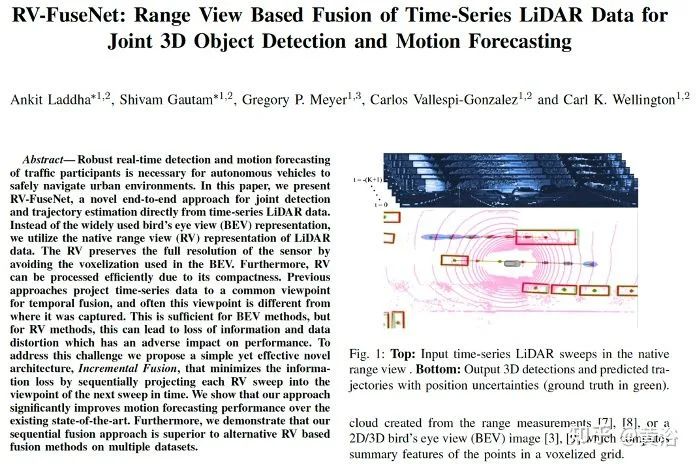

3 “RV-FuseNet: Range View Based Fusion of Time-Series LiDAR Data for Joint 3D Object Detection and Motion Forecasting”

原Uber ATG匹兹堡团队、Aurora和Motional匹兹堡团队等公司成员在2021年3月23日上传arXiv。

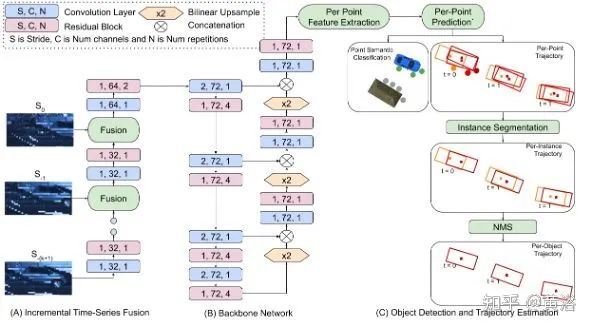

提出一种从时间序列激光雷达数据直接做联合检测和轨迹估计的方法,RV-FuseNet。用激光雷达数据的距离视图(RV)表征。以前方法将时间序列数据投影到一个时域融合的公共视角,与位置不同。对BEV方法来说已经足够,但对RV方法,会导致信息丢失和数据失真,对性能产生不利影响。为此提出一种简单而有效的新架构,步进融合(Incremental Fusion),将每个RV扫描依次投影到下一个扫描视角,将信息损失降到最低。

如图展示RV-FuseNet的概览图:当激光雷达传感器旋转时,不断产生测量值。这些数据被分割成“sweeps”切片,每个切片包含一个完整的360◦旋转测量值;用sweeps时间序列提取每点的时-空特征。用距离视图(RV)表征,基于骨干网络进行特征学习;为解决RV时域融合的挑战,提出了一种串行组合时间序列数据的方案;用每点特征生成最终的类别检测及其轨迹,其中每个点被分割成实例,而实例轨迹来自于其点轨迹的平均,最后采用NMS消除重复的检测和轨迹。

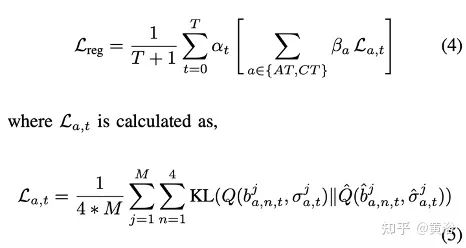

用概率损失函数对模型进行端到端的训练,这里损失函数定义为分类项和回归项:

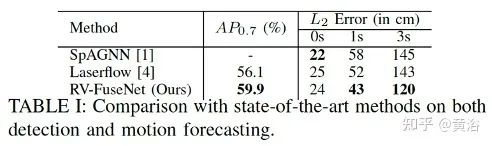

实验结果如下:基准方法是前面提到的SpAGNN和前面分析过的Laserflow。

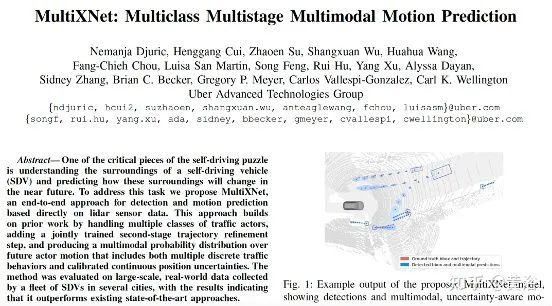

4 “MultiXNet: Multiclass Multistage Multimodal Motion Prediction”

原来Uber ATG匹兹堡团队在2021年5月24日上传arXiv。

提出 MultiXNet ,一个直接基于激光雷达传感器数据的端到端目标检测和运动预测方法。该方法处理多个类的交通行为者,添加一个联合训练的第二阶段轨迹细化步骤,并产生一个未来参与者运动的多模态概率分布,其中包括多个离散交通行为和标定连续位置的不确定性。

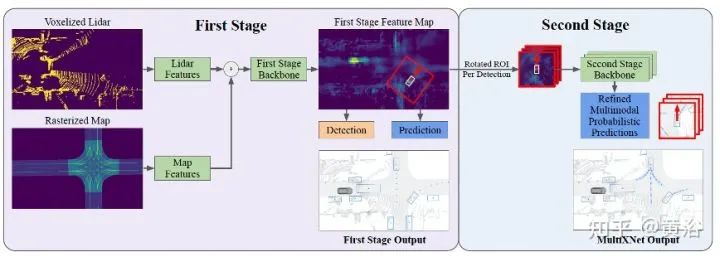

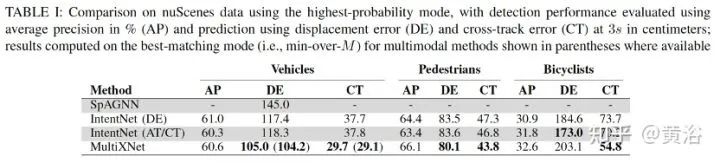

该方法基于以前SOA的工作IntentNet,如图是MultiXNet架构的一览图:其中第一阶段对应的是IntentNet,即参与者检测及其单模态运动预测,而第二阶段对应的是多模态和不确定性-觉察的预测细化。

模型输入的是激光雷达和地图的表征,其中地图的静态部分有驾驶路径、人行道、车道线和道路边界、交叉路口、私家车道和停车位等。

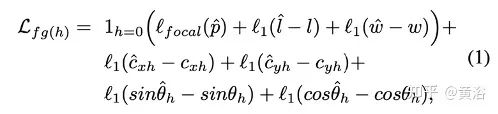

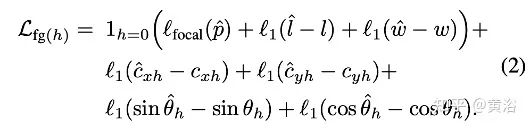

这里训练损失函数如下定义:

位置不确定性分解为along-track (AT) 和 cross-track (CT) 方向,这里以AT为例,给出其训练损失项:

KLCT的损失项定义类似。

在第二阶段的预测细化中,在最终未来轨迹和不确定性预测进行之前,RROI (rotated ROI)特征图要通过一个轻量级 CNN 网络。第一和第二阶段网络联合训练,第一阶段使用全部损失 L 和第二个阶段只有未来的预测损失,第二阶段预测被用作最终输出轨迹。第二阶段是完全可微分的,因此训练时,梯度流过第二阶段进入第一阶段。

多模态预测输出有一个选项,可以通过EM算法或者通过混合密度网络进行学习。多模态预测的损失函数包括一个轨迹损失项和一个轨迹模式概率的cross entropy,这里第一阶段只有单模式预测。

多参与者包括车辆、行人和自行车。在主干网计算共享特征之后,输出分成三组,一类是一组。实验中发现,行人和自行车,并不需要采用第二阶段的多模态预测,第一阶段的单模态预测结果就很好。

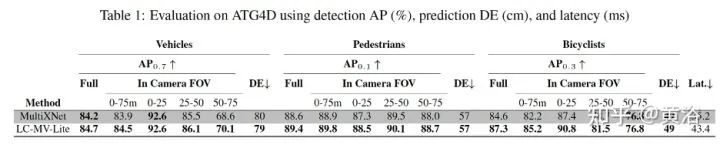

实验结果如下:基准方法是以前提到的IntentNet和SpAGNN 。

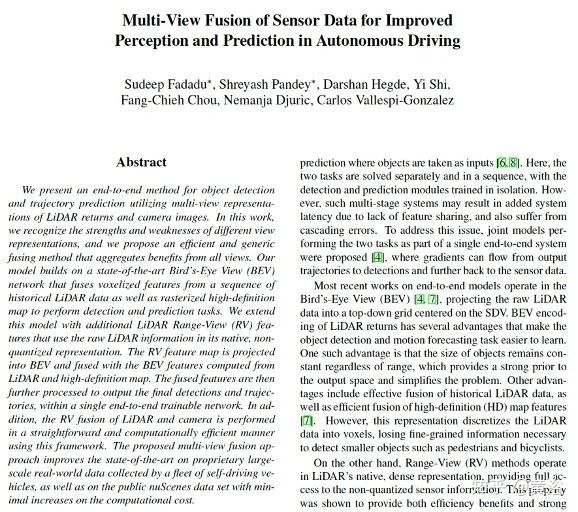

5 “Multi-View Fusion of Sensor Data for Improved Perception and Prediction in Autonomous Driving”

原来Uber ATG匹兹堡团队在2020年10月27日上传arXiv。

提出一种端到端目标检测和轨迹预测的方法,利用激光雷达返回信号和相机图像的多视图表征。这项工作提出一个有效通用融合方法,其模型建立在一个BEV网络,融合从一个序列历史 激光雷达数据的体素化特征以及光栅化高清地图,执行检测和预测任务。作者扩展这个模型,用原始激光雷达信息的原生非量化表征构建激光雷达距离视图( RV )特征。RV 特征图投影到 BEV ,融合从激光雷达和高清地图计算的 BEV 特征。融合的特征,在一个单一端到端可训练网络中进一步处理,输出最终检测和轨迹。此外,该框架以一个简单和计算有效的方式在 RV 融合激光雷达和相机。

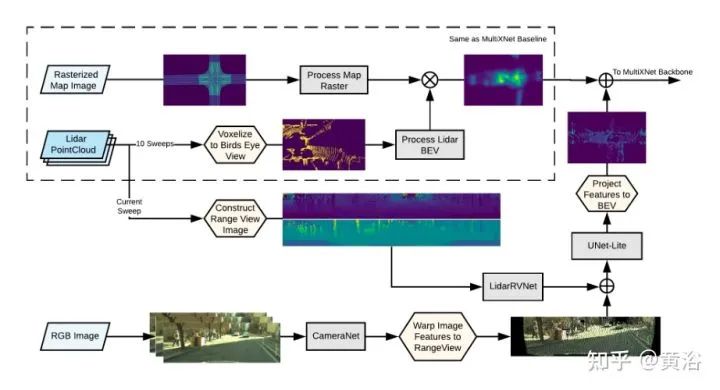

如图是多视角融合的架构图:由两个主要部分组成,特征提取器和特征投影器;输入包括摄像头图像、激光雷达点云和高清地图的光栅化图像;多视角模型考虑激光雷达输入的两个分支,一个是BEV,另一个是RV;而摄像头图像和激光雷达融合在RV分支进行。

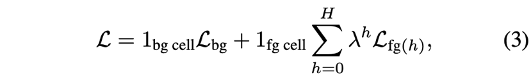

训练的损失函数如下:

实验结果如下:基准算法包括

- Continuous fusion 即ContFuse(“Deep continuous fusion for multi-sensor 3d object detection”,ECCV‘18

- 前面分析的MultiXNet

实验中多视角融合MV方法记做:LC-MV(LiDAR + camera)和L-MV (LiDAR only)两种。

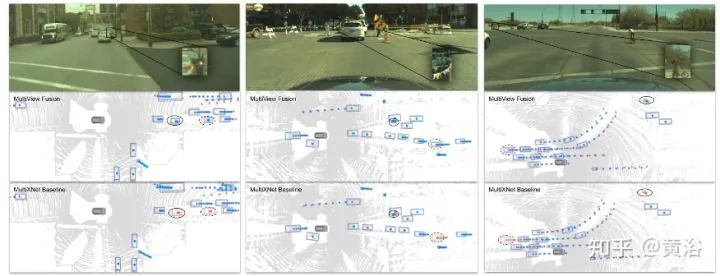

如图是LC-MV (中间) 和MultiXNet (底部)的比较:三个实例,包括遮挡车辆、遮挡行人和遮挡自行车,结果分别显示为预测(蓝色)、真值(红色)。

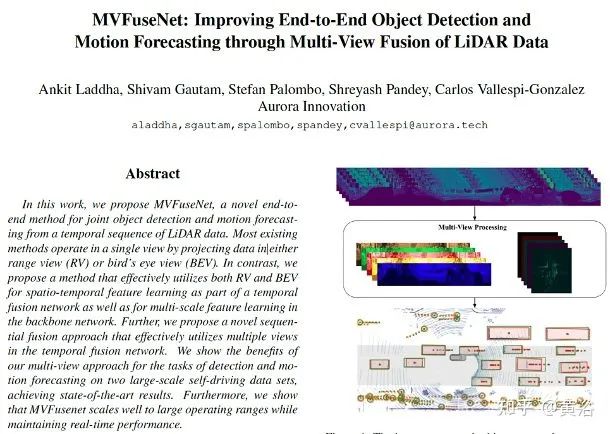

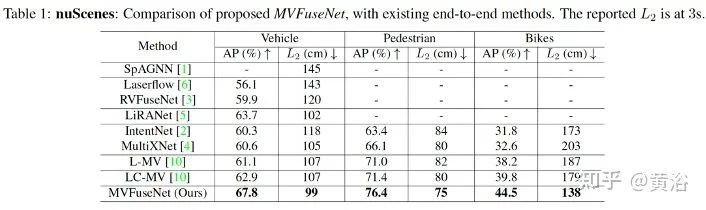

6 “MVFuseNet: Improving End-to-End Object Detection and Motion Forecasting through Multi-View Fusion of LiDAR Data“

Aurora公司(收购的原Uber ATG团队)在2021年4月21日上传arXiv。

这项工作 MVFuseNet ,一种端到端的方法,从时间序列的激光雷达数据联合进行目标检测和运动预测。大多数方法在一个单一视图操作,即投影数据到距离视图( RV )或鸟瞰图( BEV )。相比之下,这个方法有效利用 RV 和 BEV 做时-空特征学习,是时域融合网络的一部分,也是在一个骨干网络做多尺度特征学习。此外,提出一种序贯融合方法,有效地利用时域融合网络的多个视图。

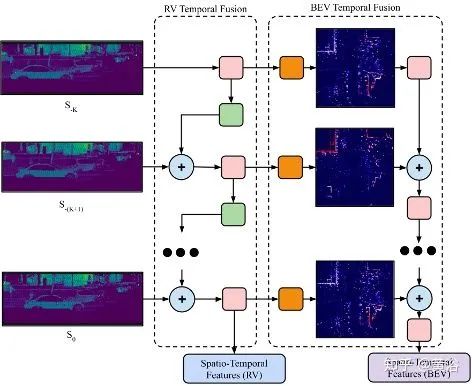

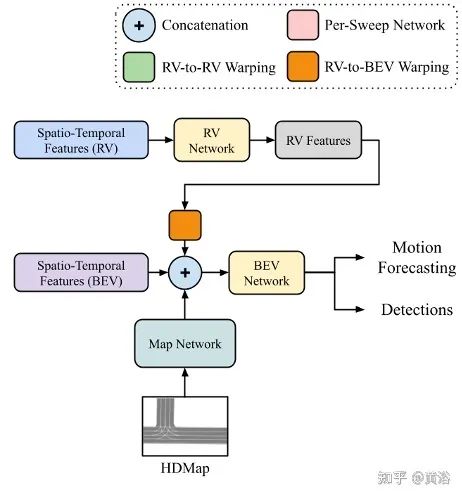

如图是MVFuseNet 的一览图:(a)在RV和BEV的激光雷达数据多视图时域融合学习时-空特征;将数据从一次sweep投影到时间序列中的下一个sweep,从而按顺序聚合这些sweeps;(b)这些多视图的时-空特征,结合地图特征在多视图骨干进一步处理,学习多尺度特征,最终做检测和运动预测。

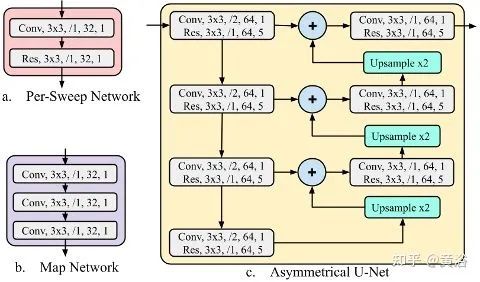

如下图是网络组件的概览:(a) 用所描述的per-sweep网络在两个视图时域融合中处理每个sweep。注意,在时域融合,沿着时间和视图不共享权重。(b) HD Map是和网络一起处理的,学习与激光雷达特征相结合的本地地图特征。(c) 非对称U-网络对BEV的多尺度特征进行提取。

在RV,只有宽度维是下采样,而第一个卷积层跨度为零。网络的每一层都表示为B,k×k,/s,C,N,其中B是block名,k是核大小,s是步长,C是通道数,N是block的重复次数。Conv表示一个卷积层,然后是批处理归一化和ReLU。RES表示残差block。最后提示,用双线性插值法对样本进行采样。

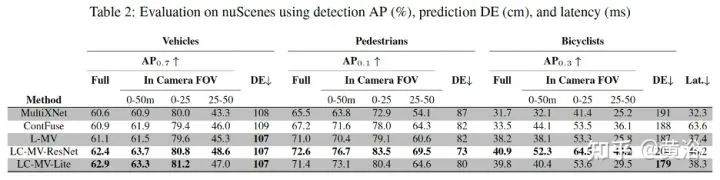

实验结果如下:其中基准方法有

- 前面提到的SpAGNN;

- 前面提到的IntentNet;

- 前面分析的Laserflow;

- 前面分析的RVFuseNet;

- 前面分析的MultiXNet;

- 前面分析的多视角融合L-MV和LC-MV;

- LiRANet(“Liranet: End-to-end trajectory prediction using spatio-temporal radar fusion“. _arXiv:2010.00731_, 2020)

总结一下:

基于Uber ATG的工作,可以看出Aurora的感知-预测-决策规划是一体化设计的,而且考虑了模仿学习的数据驱动模式开发,采用不确定性-觉察、多模态、多智体(车辆、行人和自行车)形式,感知的融合基本实现端到端时空融合(包括定位地图特征);激光雷达感知方面基于收购的公司实现FMCW技术的几个优点,而且自研传感器及其芯片设计可以控制成本和保证系统最优化,另外自研还开发了高清地图数据服务,和模拟仿真及可视化技术。

作者:黄浴

来源:https://mp.weixin.qq.com/s/spD_aghAKIC7jqTuahvJLQ

微信公众号:

推荐阅读:

更多汽车电子干货请关注汽车电子与软件专栏。