如今的 AI 领域出现了一波新趋势——文本到图像生成器。只要把文本描述输入这些程序,它们自动生成与描述内容高度匹配的精准图片。这些程序还支持各种风格,从油画、CGI 渲染再到实景照片无所不包。总之,只有你想不到,没有它画不出。

此前,该领域的领导者一直是 DALL-E——由商业 AI 实验室 OpenAI 开发的程序(今年 4 月刚刚完成更新)。但就在昨天,谷歌也拿出了自己的王牌:Imagen,并在输出质量上一举压倒了 DALL-E。

以下图片均由 Imagen 生成:

一张戴着宇航员头盔的浣熊在晚上看着窗外的照片

乘坐火箭飞船前往月球的大脑

一只狗好奇地照镜子,看到一只猫。

一对机器人夫妇在埃菲尔铁塔的背景下享用美食。

撒哈拉沙漠中戴着草帽和霓虹墨镜的小仙人掌

头戴王冠的浣熊

一只戴着墨镜和沙滩帽的柯基犬在时代广场骑自行车

要了解这些模型有什么本事,当然是先从它们生成的作品开始。(感兴趣的朋友可以访问 Imagen 登陆页面查看更多示例)。

可以看到,图像下方的文本就是输入给程序的提示,图像则是输出结果。就这么简单,告诉程序自己想看什么,Imagen 就能自行创作。这可太棒了!

虽然这些照片的连续性和准确性都给人留下了深刻印象,但我们旁观者也至少要保持住清醒的头脑。毕竟像 Google Brain 这类研究团队公布新的 AI 模型时,往往会挑选出质量最高的结果。所以虽然图片看起来非常完美,但恐怕无法代表这套图像系统的平均输出水平。

请记住:谷歌只会让你看到最好的图片

以往,文本到图像模型生成的图片看起来都不大完整,而且画面是相当模糊。OpenAI 的 DALL-E 生成的图片就有这些问题。

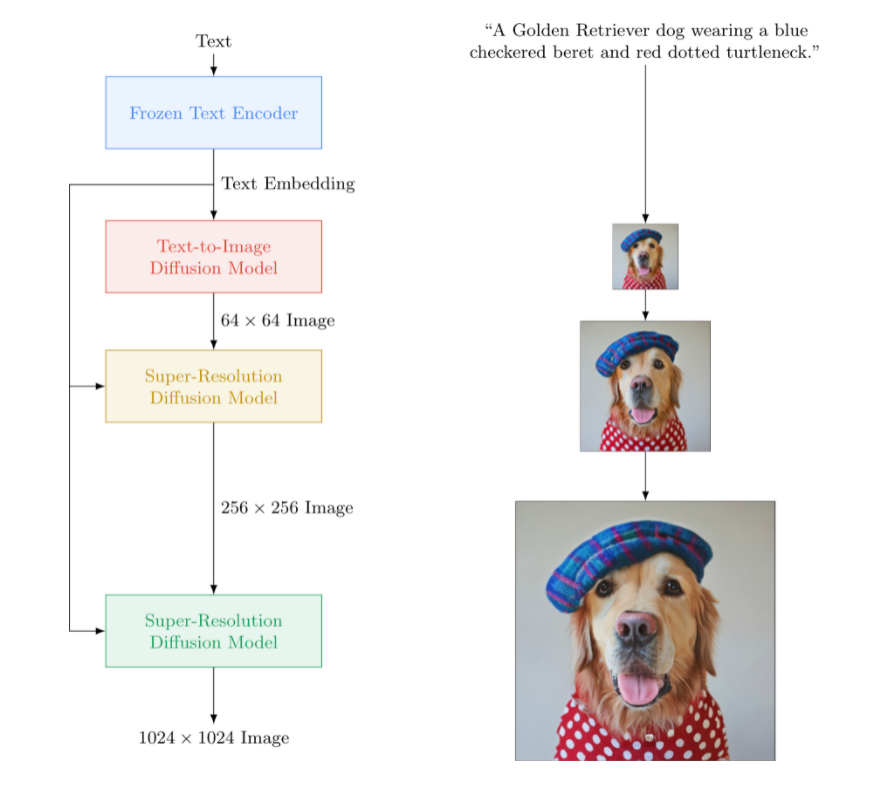

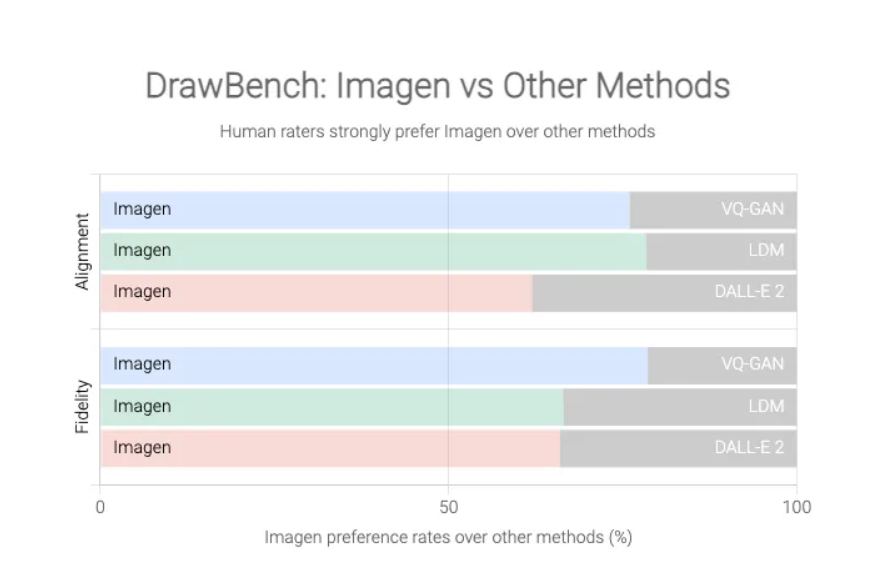

但谷歌表示不服,宣称 Imagen 生成的图像已经全线超越了 DALL-E 2,原因就是 Imagen 拥有一套量身打造的测试新基准 DrawBench。

DrawBench 的测试指标并不是特别复杂:本质上,它就是一份包含约 200 条文本提示的列表,谷歌团队把这些提示输入到 Imagen 及其他文本到图像生成器里,再由人工评分员判断各程序的输出质量。如下图所示,谷歌发现人类往往更喜欢 Imagen 的输出,对其他竞争模型的作品评价相对较低。

谷歌 DrawBench 基准将 Imagen 的输出,与 OpenAI 的 DALL-E 2 等文本到图像竞争对手进行比较。

但这都是谷歌说的,而且他们还没有全面开放 Imagen 模型,所以我们也不知道是真是假。不开放也有不开放的理由,毕竟文本到图像模型虽然具有巨大的创造潜力,但在恶意使用之下也有可能引发严重后果。想象一下,如果这样一套系统能够生成我们想要的任何图像,那假新闻、恶作剧或者骚扰性素材还不满天飞?谷歌方面也强调,这些系统在训练过程中也不可避免接触到了社会偏见,所以输出结果中也会包含种族主义、性别歧视或其他一些有毒内容。

老话说得好:垃圾进、垃圾出,AI 也不例外

这主要源自此类系统的编程方式。从本质上讲,它们依靠大量数据进行训练(对 Imagen 来说,使用的就是图像加文本组合), 从数据中发现模式并尝试重现。但要想得出可靠的结论,模型就得接触巨量数据。即使是谷歌这样资金雄厚的科技巨头,也很难在研究团队之内把所有输入信息都全部过滤一遍。因此,他们只能从网络上直接抓取内容,所以网上那些有毒言论和信息也就不免要渗透到 AI 模型当中。

谷歌研究人员在他们的论文中也做出总结:“文本到图像模型往往需要大规模数据作为支持……因此研究人员高度依赖于大型、通常未经梳理、直接从网络上抓取到的数据集……数据集审计结果显示,这类数据内容往往会反映社会上的刻板印象、压迫性观点、对边缘化身份群体的贬损等有害关联内容。”

换句话说,计算机科学家们的那句老话说得好:垃圾进、垃圾出,AI 也不例外。

谷歌并没有具体解释 Imagen 到底生成了哪些令人不安的内容,但强调这套模型“编码了几种社会偏见和刻板印象,例如总体更倾向于生成肤色较浅的人像,也更倾向于生成符合西方世界刻板印象的职业与性别组合。”

同样的问题在 DALL-E 身上也有出现。例如,在让 DALL-E 生成“空乘人员”图像时,给出的几乎全是女性形象。而如果要求生成“CEO”图片,得到的就基本都是“老白男”。

面对这个问题,OpenAI 也决定不公开发布 DALL-E,只面向一部分特定人员开放 beta 测试。他们还过滤了某些文本输入,希望阻止模型生成种族主义、暴力或色情图像。这些举措确实在一定程度上限制了技术的潜在有害应用,但 AI 技术的发展史告诉我们,这种文本到图像模型早晚会被公之于众,到那时候一切令人不安的影响都将如洪水般倾泄而出。

谷歌自己的结论是,Imagen“目前尚不适合公众使用”,并表示计划开发一种新方法来衡量“未来工作中的社会与文化偏见”,希望借此测试模型的后续迭代。但就目前来看,谷歌展示的图片确实质量颇高——头戴王冠的浣熊和墨镜下的柯基犬都相当带感。不过这还只是冰山一角,如果要想展现全部真容,Imagen 先得搞定技术研究可能引发的意外后果。

本文转自 公众号:AI前线 ,作者James Vincent,点击阅读原文