图1 CLIFF单目视频人体姿态估计结果(原始视频来自公开数据集3DPW)

随着AR/VR、数字人等技术及应用的崛起,人体动作捕捉相关的研究越来越受到学术界和工业界的关注,尤其是基于单目视觉的方案,因其便携易用而引起更多的关注。近日,华为诺亚方舟实验室计算机视觉团队提出了新的动作捕捉算法CLIFF,基于HMR网络结构,在网络输入和监督信号中引入裁剪框的全局位置,同时使用新的方法构造人体动作捕捉伪标注,可以降低估计误差40%以上,实验结果在AGORA榜单上排第一名(截止至2022年6月)。其在网络中引入全局位置的思想及开放的伪标注数据可应用在其他单目视觉估计3D模型任务上,相关论文已被计算机视觉顶级会议ECCV 2022接收为Oral报告(录用率2.7%)。

论文:CLIFF: Carrying Location Information in Full Frames into Human Pose and Shape Estimation

Arxiv链接:https://arxiv.org/abs/2208.00571

MindSpore实现代码:https://gitee.com/mindspore/models/tree/master/research/cv/CLIFF

一、引 言

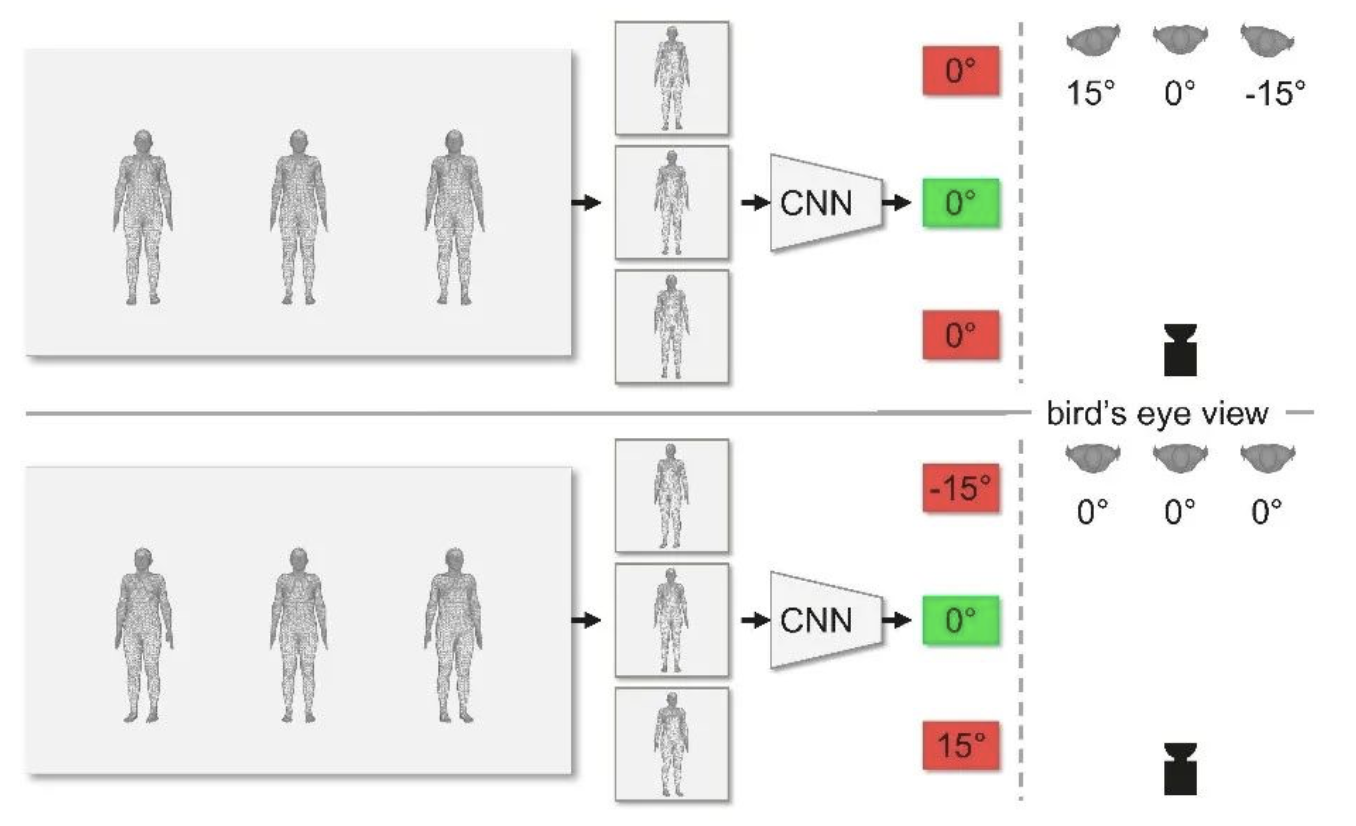

单目人体3D姿态和形态估计(3D human pose and shape estimation)是对于给定单视角下的图片或视频,基于人体参数化模型,估计出其中人体的3D形状与姿态的任务。目前主流的方案是自顶向下(Top-down)的,先检测人体框,再裁剪出其中的人体图片逐个处理。然而,一开始的裁剪操作会丢弃人体框在全图中的位置信息,从而导致算法无法准确地估计人体的全局旋转,各关节的旋转角估计也会相应地有所偏差。如图2所示,图中上方的三个人在裁剪图中看上去相差不大,算法对于这些相似的输入就会给予相近的输出,认为他们的全局旋转都是0度。但事实上,我们可以从最右边的俯视图中看出,他们的全局旋转是有明显差异的。图中下方的情形也暴露出同样的问题,看似迥异的裁剪图,却有着相同的全局旋转。而这一切的关键都取决于这些裁剪图在原始全图中的位置。不仅网络输入如此,网络监督信号的重投影误差也是如此。裁剪图中的2D重投影误差不足以引导网络给出关于全局旋转的准确预测,更为糟糕的是,这些有所偏差的全局旋转还会让各关节的局部旋转为此做出“补偿”而跟着犯错。总而言之,丢失裁剪框在全图中的位置信息,会引入更大的歧义性,从而降低算法的预测精度。

图2 自顶向下方案中的裁剪操作会导致算法无法准确估计全局旋转

为了解决这个问题,本文提出了CLIFF算法(Carrying Location Information in Full Frames into Human Pose and Shape Estimation),重新引入了裁剪框的位置信息。具体来说,我们在输入中加入了关于裁剪框在全图中的位置编码信息,并把这个位置信息与原来的裁剪图特征拼接起来,一并输入到网络的回归器中。这样可以为模型提供足够的信息,使之可以准确地估计全局旋转。

此外,我们在原始全图中利用接近实际情况的透视投影(Perspective Projection)来计算重投影误差,而不像之前的方法那样在裁剪图中利用弱透视投影(Weak-perspective Projection)计算误差。贴近图像拍照时的投影方式,使得2D重投影误差可以正确地引导网络给出合理的预测结果。

另一方面,高精度的标注信息对于神经网络来说至关重要,而给2D图像标注3D信息是非常困难且耗时耗力的。本文基于CLIFF还提出了一种新型的伪标注方案,可以利用神经网络给自然场景下的2D图像完成高质量的3D人体姿态标注。这些伪标注信息也可以助力其他动作捕捉算法大大提升他们的精度。

二、方 法

2.1 CLIFF模型

我们选用SMPL作为参数化模型,HMR作为基线算法。

SMPL用24x3的旋转角来描述人体的3D姿态,用10维的变量来描述人体高矮胖瘦等形态。

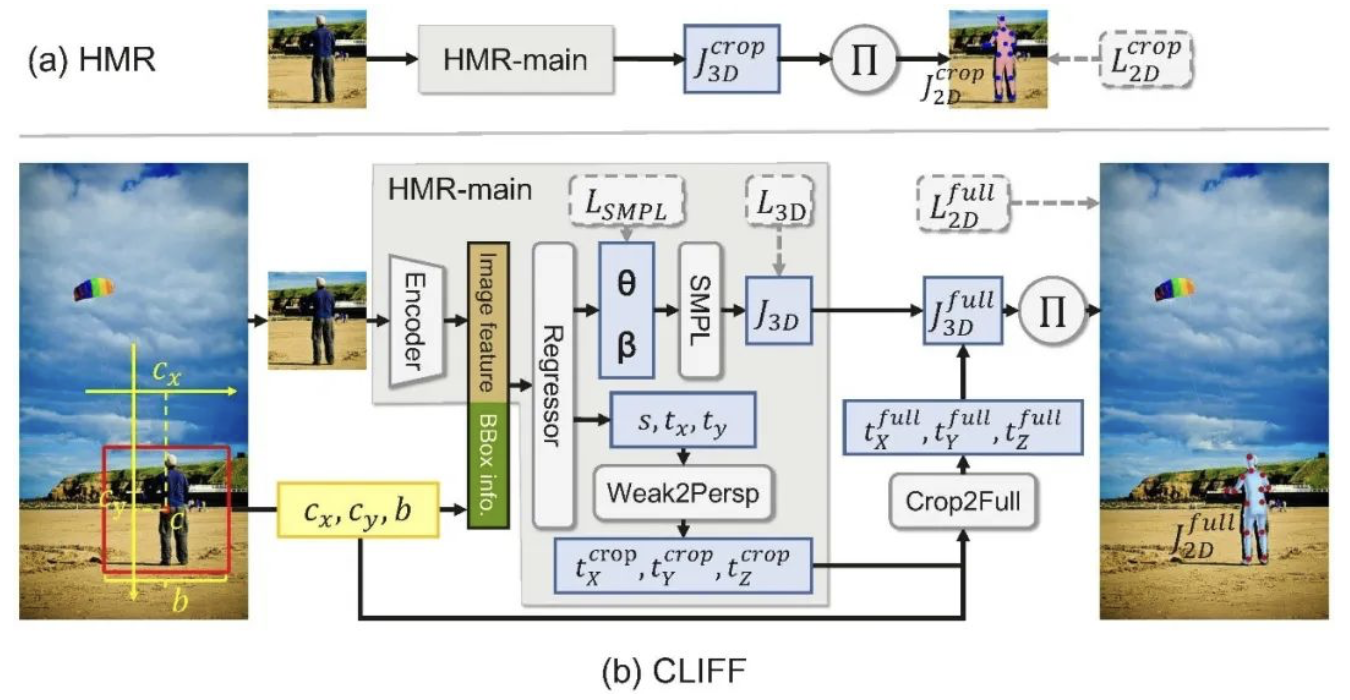

HMR是一种非常简单优雅的自顶向下的方案。输入是224x224的裁剪图,经由卷积网络得到图像特征,再通过几个全连接层得到SMPL的参数和弱透视投影参数{s, t_x, t_y}。训练时,HMR将预测的3D关键点投影到裁剪图中计算重投影误差,作为监督信号。

CLIFF在HMR基础上做了两处改动,分别是网络输入和重投影误差的监督信号。

图3 CLIFF网络结构

网络输入:

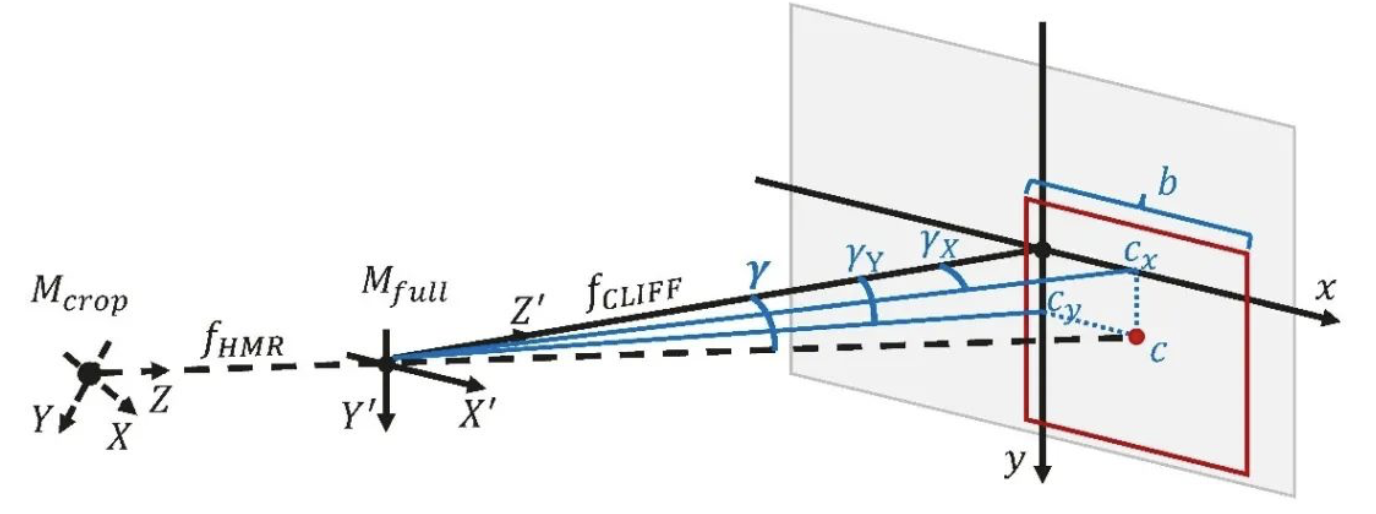

图4 裁剪图对应的相机坐标系与全图对应的相机坐标系的几何关系

2.2 CLIFF标注方案

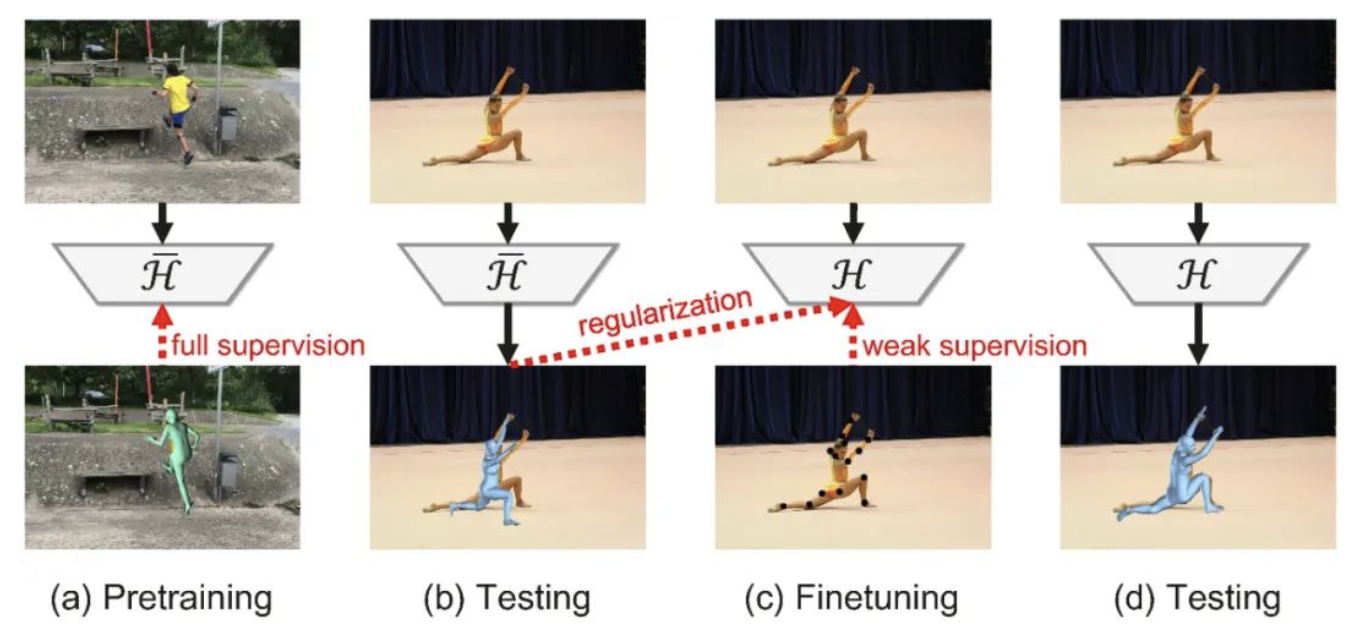

图5 CLIFF标注流程

近来涌现了一些基于神经网络的优化方案来给2D图像生成3D人体姿态伪标注,但这些算法都是基于裁剪图的,因此得到的3D标注质量欠佳。本文基于CLIFF提出了一种新型的3D伪标注方案,因其引入了裁剪框在全图中的位置信息,所得的3D标注更为准确,且其中的先验知识也使得标注信息更加真实合理。该标注方案共有4步:

- 1.预训练:在已有的3D数据集上预训练一个基础模型,其中预训练得到的网络权重可作为后面优化过程中的隐式先验知识。

- 2.先验推理:将上述基础模型应用在待标注的2D数据上,得到SMPL预测结果。该预测结果未必准确,但它们可以作为很好的显式先验知识,约束后面的优化过程不至于产生奇怪的结果。

- 3.精调优化:使用2D全图重投影误差作为弱监督信号,先验推理得到的SMPL参数作为正则项,在待标注的2D数据上精调上述基础模型,得到最终的标注模型。

- 4.最终估计:将上述标注模型应用到待标注的2D数据上,所得的SMPL预测结果即可作为最终的人体3D姿态伪标注。

上述方案不需要依赖多视角的昂贵设备,也不需要过于繁琐的人工参与,所得到的3D伪标注较为精准,且真实合理,可以作为高质量的网络训练监督信号。

三、实 验

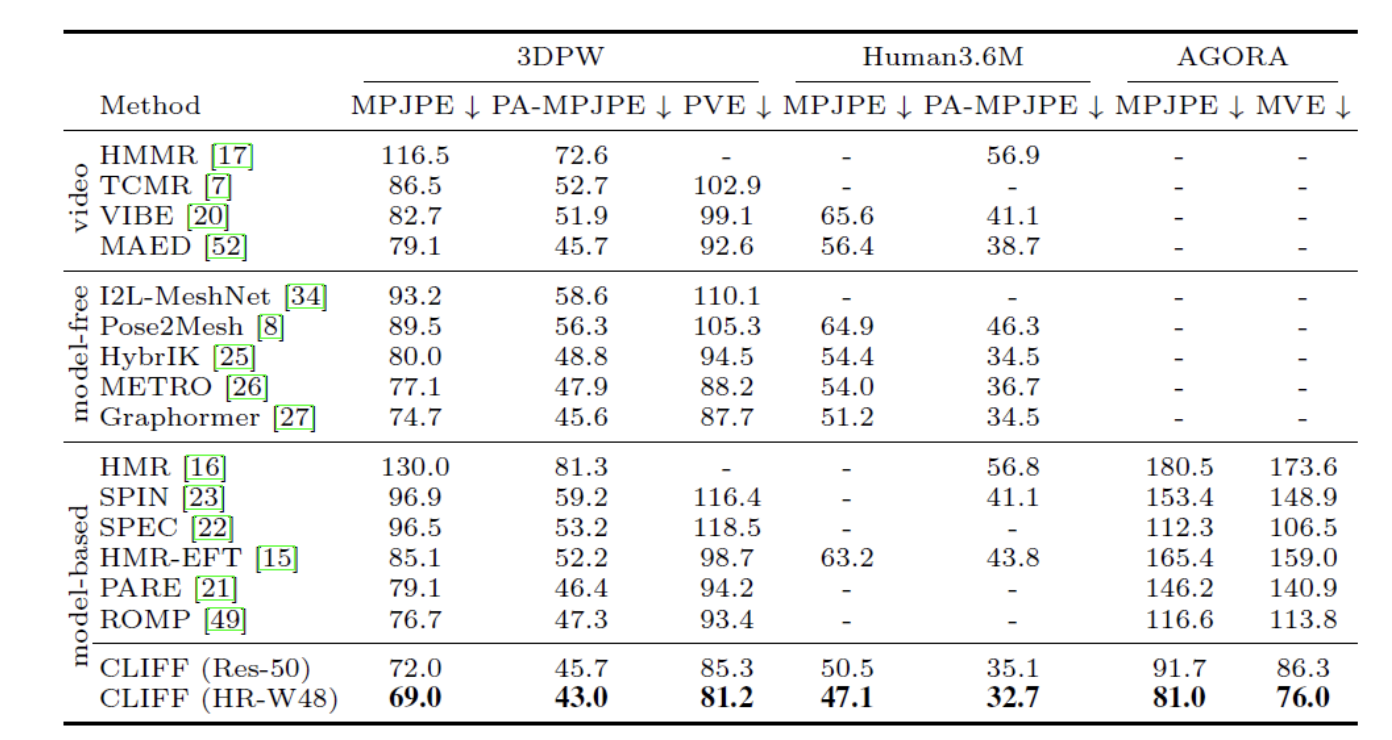

表1 CLIFF在多个公开数据集上与SOTA算法的比较

3.1 CLIFF实验结果

本文在多个公开数据集上验证,均超越了现有SOTA算法,如表1所示。具体来说,相比基线方案,CLIFF降低误差接近50%,且几乎不增加计算量。相比基于Transformer的SOTA算法(METRO和Graphormer),CLIFF也取得了较大的领先优势。同时,CLIFF在AGORA上刷榜第一(截止至2022年6月)。

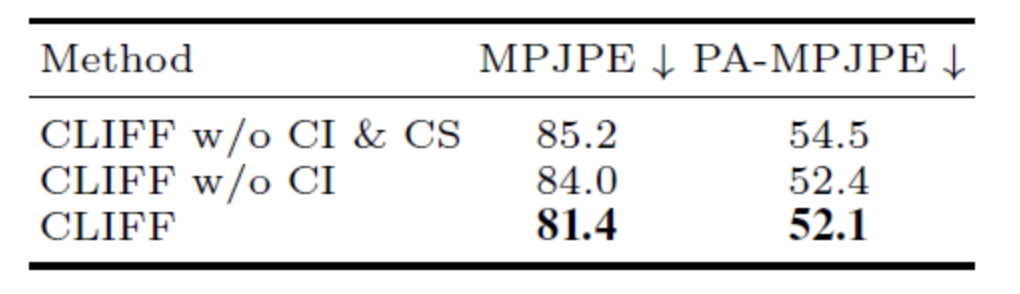

表2的消融实验也表明,在输入(CI, CLIFF input)和监督(CS, CLIFF supervision)上引入位置信息均可带来精度提升。

表2 CLIFF的消融实验

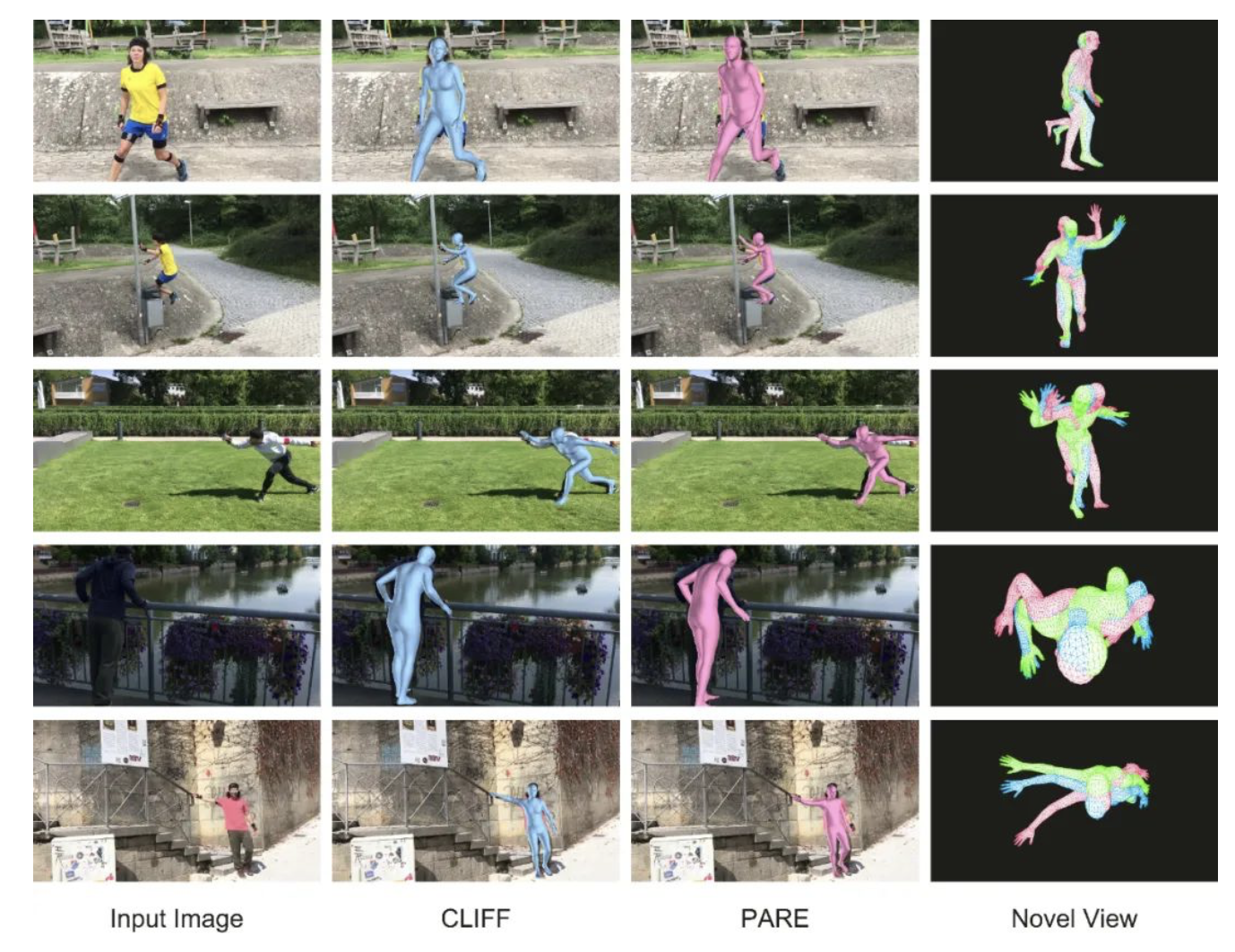

图6展示了一些CLIFF的可视化结果,可见CLIFF预测的全局旋转更为准确,且各关节的局部旋转也更佳。

图6 CLIFF与SOTA算法PARE的可视化对比

3.2 CLIFF标注方案实验结果

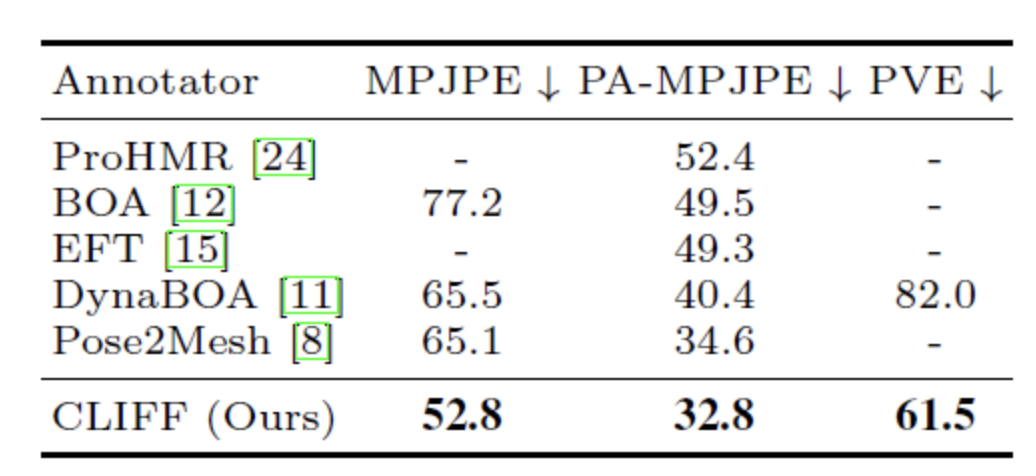

本文在3DPW数据集上验证CLIFF标注方案的结果。如表3所示,相比其他标注方案,本方案所得的3D标注误差更低。

表3 CLIFF生成的标注在3DPW上的实验结果

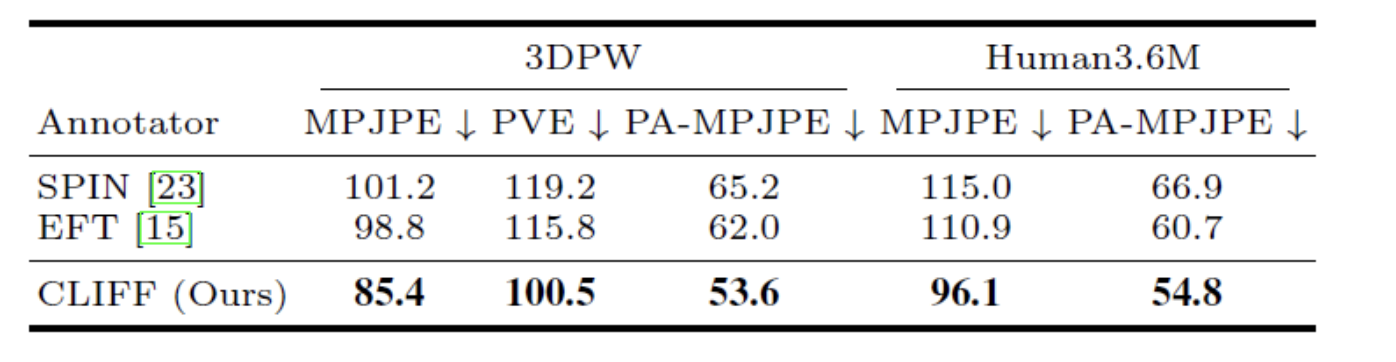

利用CLIFF生成的标注所训练的模型也有更低的误差,如表4所示。

表4 CLIFF标注作为监督信号的实验结果

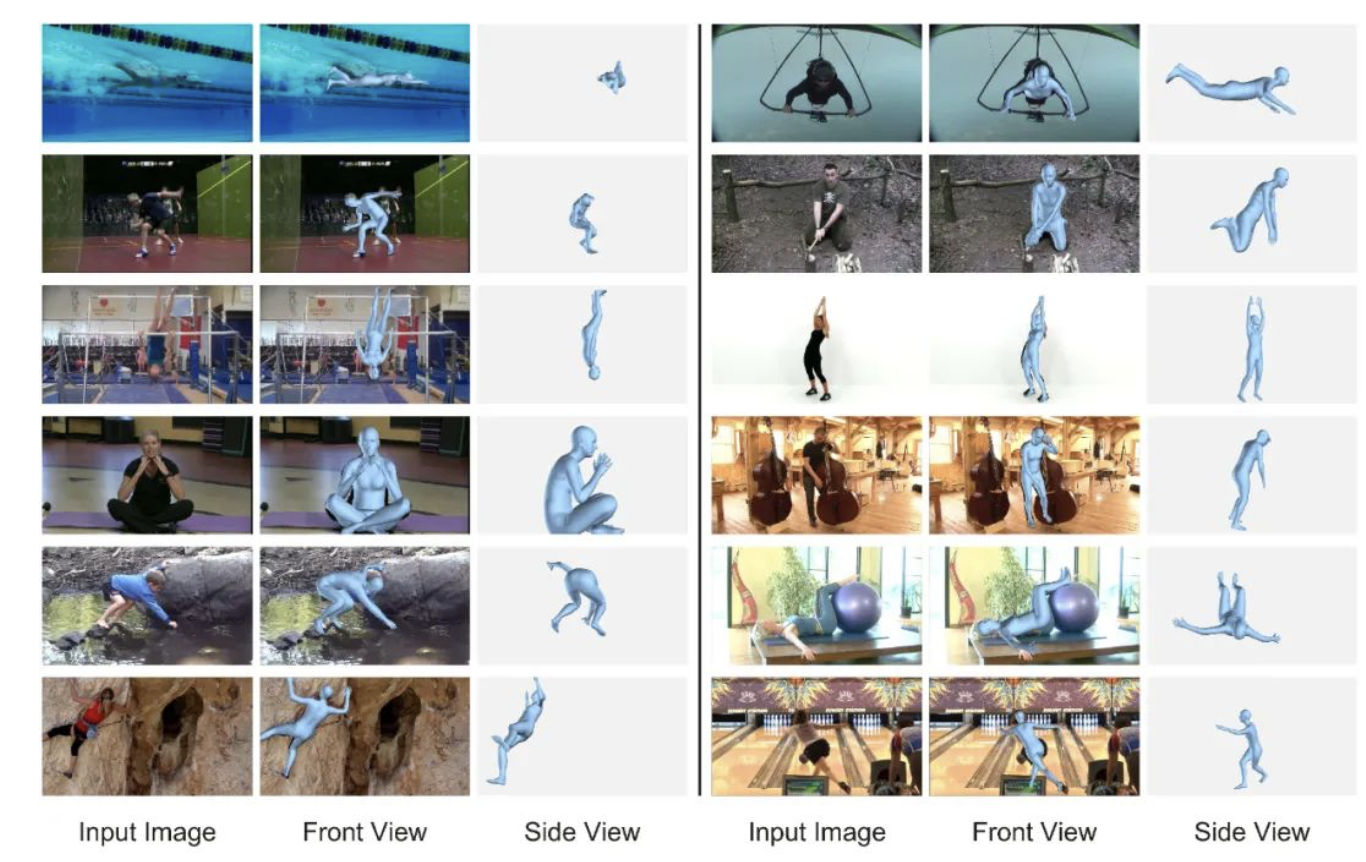

图7展示了一些CLIFF标注的可视化结果。

图7 CLIFF在MPII数据集上所得标注的可视化结果

四、总 结

本文提出了人体动作捕捉新算法CLIFF,通过在网络输入和监督中引入裁剪框在全图的位置信息,更为准确地估计了人体3D姿态和形态。基于CLIFF的标注方案能给2D图像生成了更好的3D标注。CLIFF的思想不仅可以应用在自顶向下的方案中,也可以应用在自底向上的方案中,如引入带位置编码的特征图。此外,CLIFF的思想还可以应用到其他涉及到全局旋转的3D任务中,如3D物体检测,6-DOF姿态估计。

【免责声明】

华为在本公众号所载的材料和信息,包括但不限于文本、图片、数据、观点、建议、网页或链接,虽然华为力图在网站平台上提供准确的材料和信息,但华为并不保证这些材料和内容的准确、完整、充分和可靠性,并且明确声明不对这些材料和内容的错误或遗漏承担责任,也不对这些材料和内容作出任何明示或默示的、包括但不限于有关所有权担保、没有侵犯第三方权利、质量和没有计算机病毒的保证。

华为可以在没有任何通知或提示的情况下随时对网站上的内容进行修改,为了得到最新版本的信息,请您定时访问本网站。华为(含其关联公司)在本网站上所提及的非华为产品或服务仅仅是为了提供相关信息,并不构成对这些产品、服务的认可或推荐。华为并不就网址上提供的任何产品、服务或信息做出任何声明、保证或认可,所有销售的产品和服务应受华为的销售合同和条款的约束。

— 完 —

作者:诺亚方舟实验室

文章来源:诺亚实验室

推荐阅读

FreeTransfer-X:零标注成本?巧用大模型无缝迁移AI应用至各种语言

华为诺亚AI4EDA团队刷新EPFL逻辑综合榜单25/40个世界记录,连续两年排名最前列

【盘古Coder】:高性能函数级程序语言生成模型

更多嵌入式AI相关技术干货请关注深度学习压缩模型论文专栏。欢迎添加极术小姐姐微信(id:aijishu20)加入技术交流群,请备注研究方向。