关于AMD EPYC 9004的几点讨论

如题,本文主要是想根据有限的信息,先简单聊一下Dell首款PowerEdge 16G服务器,然而既然讨论R7625又离不开AMD新发布的EPYC 9004系列CPU。如上图,不难看出最左边的EPYC 9654比上一代EPYC 7773X处理器封装尺寸大了不少。

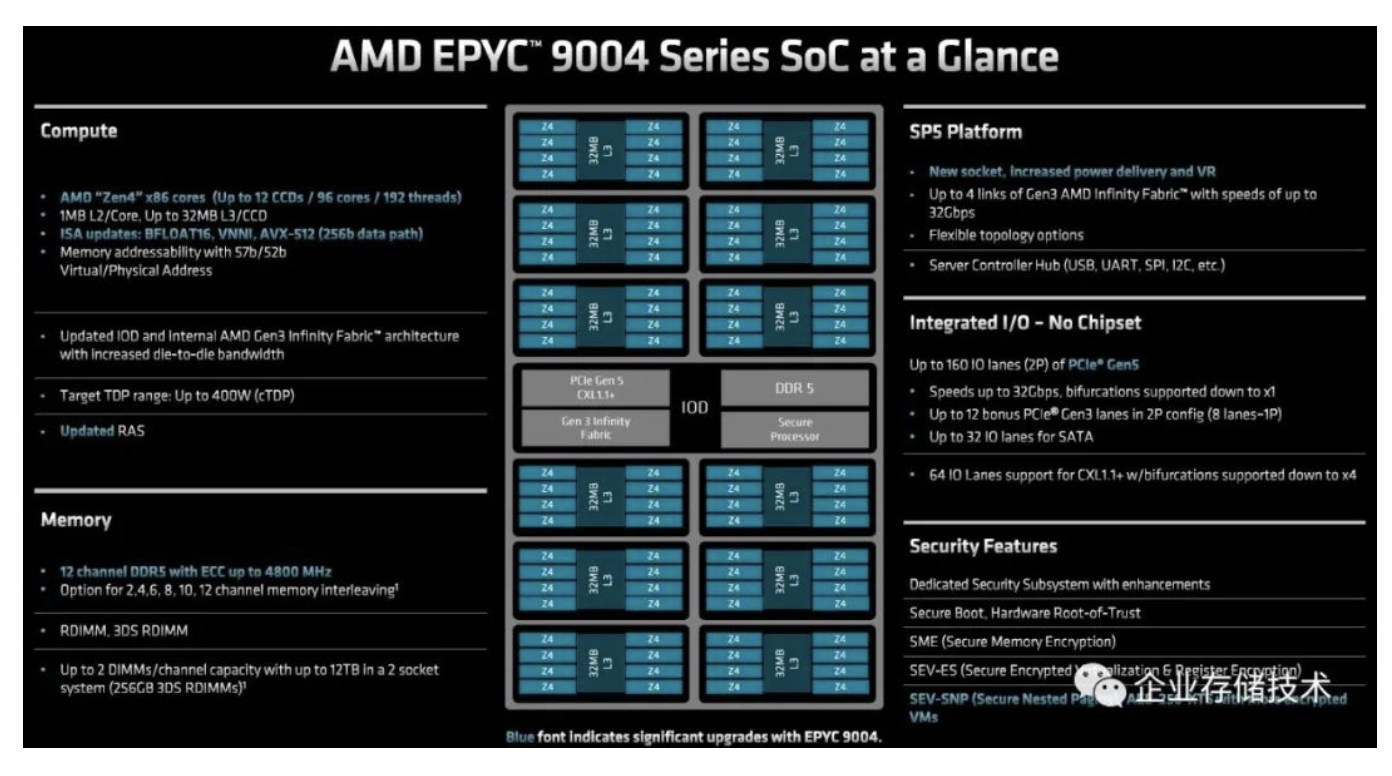

我比较喜欢这张EPYC 9004的特点综述,大家可以点开查看,就不在此详细写了。AMD本次升级是将拥有8个核心的CPU Die从最多8组增加到12组,从而达到96核心,中间的IO Die内存控制器为12通道DDR5,PCIe Gen5 I/O同时兼容CXL 1.1。

扩展阅读《_FMS闪存峰会资料分享、CXL之我见_》

《_CXL、GenZ、CCIX架构以及未来的PM、内存和SSD形态_》

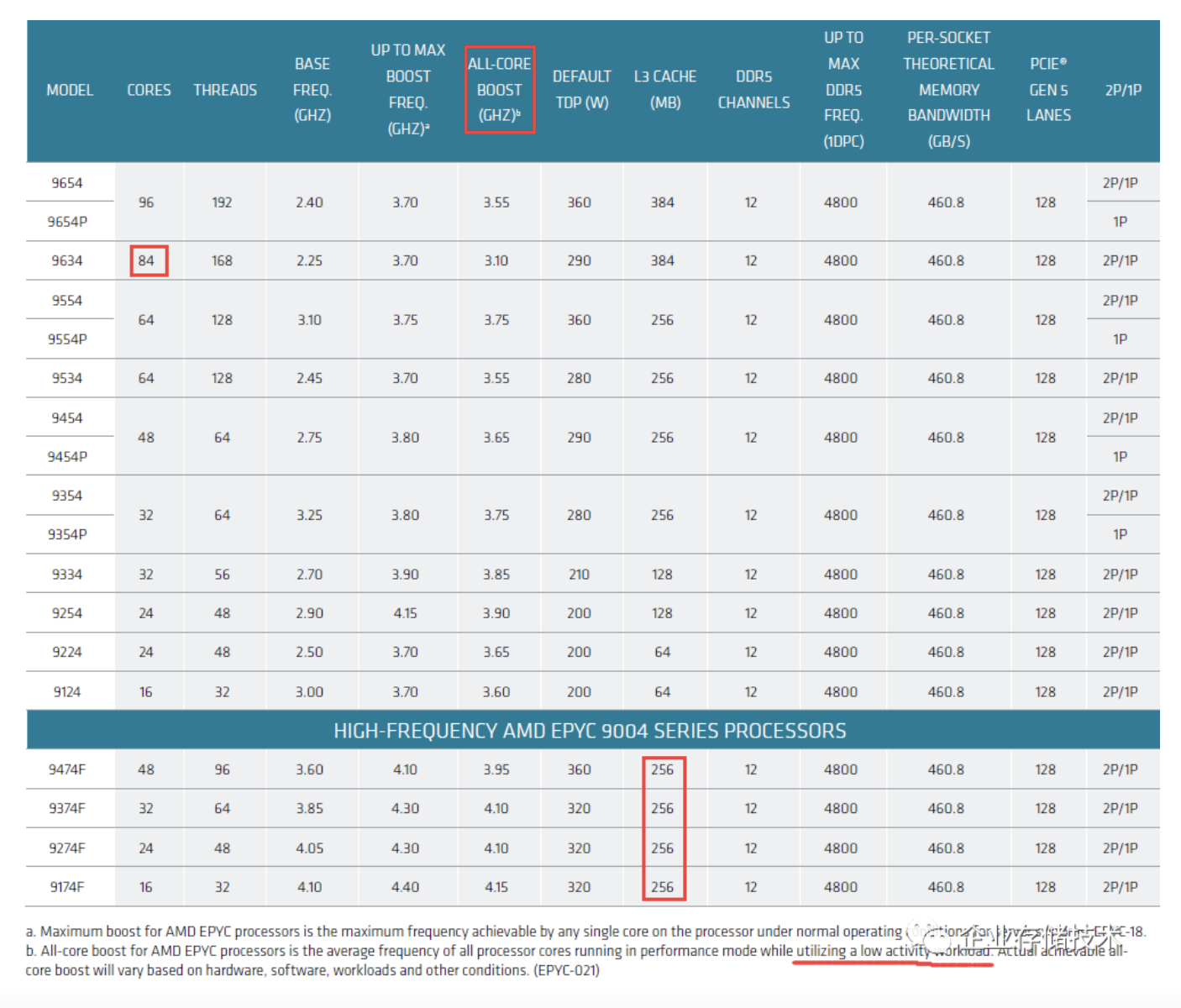

上面图表是EPYC 9004的完整型号规格,我也是挑重点讨论下:

1、本次AMD服务器CPU新品的核心数,从16、24、32、48、64到96都是8的倍数,而为什么EPYC 9634的核心数是84而不是80呢?其实换个角度思考,12(Die数量)乘以7不就是84么,别忘了还有一个名词叫良品率:)9634明显应该就是每个CPU Die激活7个核心。

2、从不同型号的L3 Cache容量,也可以看出使用了几个CPU Die。比如同为24核的9224为64MB而9254为128MB,前者最少只需要3个Die,而后者则需要使用6个Die。

同理,都是32核的3款CPU,9334的L3 Cache为128MB,而9354和9354P则是256MB,前者从设计角度可以用6-8个CPU Die满足,而后两者则应该要配满12个Die。

最底下4款F结尾的高频EPYC 9004,Cache都是256MB。我理解将同等数量的CPU核心分布到更多的Die上面(即每个Die都只激活一部分核心),应该有利于散热以提高主频。

3、AMD这次给出了全核Boost频率,看上去与单核最高Boost频率比较接近。AMD也指出这个是用于low activity工作负载时才能达到的。通俗类比下,大家还记得Intel CPU的Turbo频率一般分几个等级吧,比如整数/non-AVX浮点计算可以跑到最高,然后是AVX 2、AVX-512计算时的频率最低。

Dell PowerEdge R7625:500W GPU是否为液冷散热?

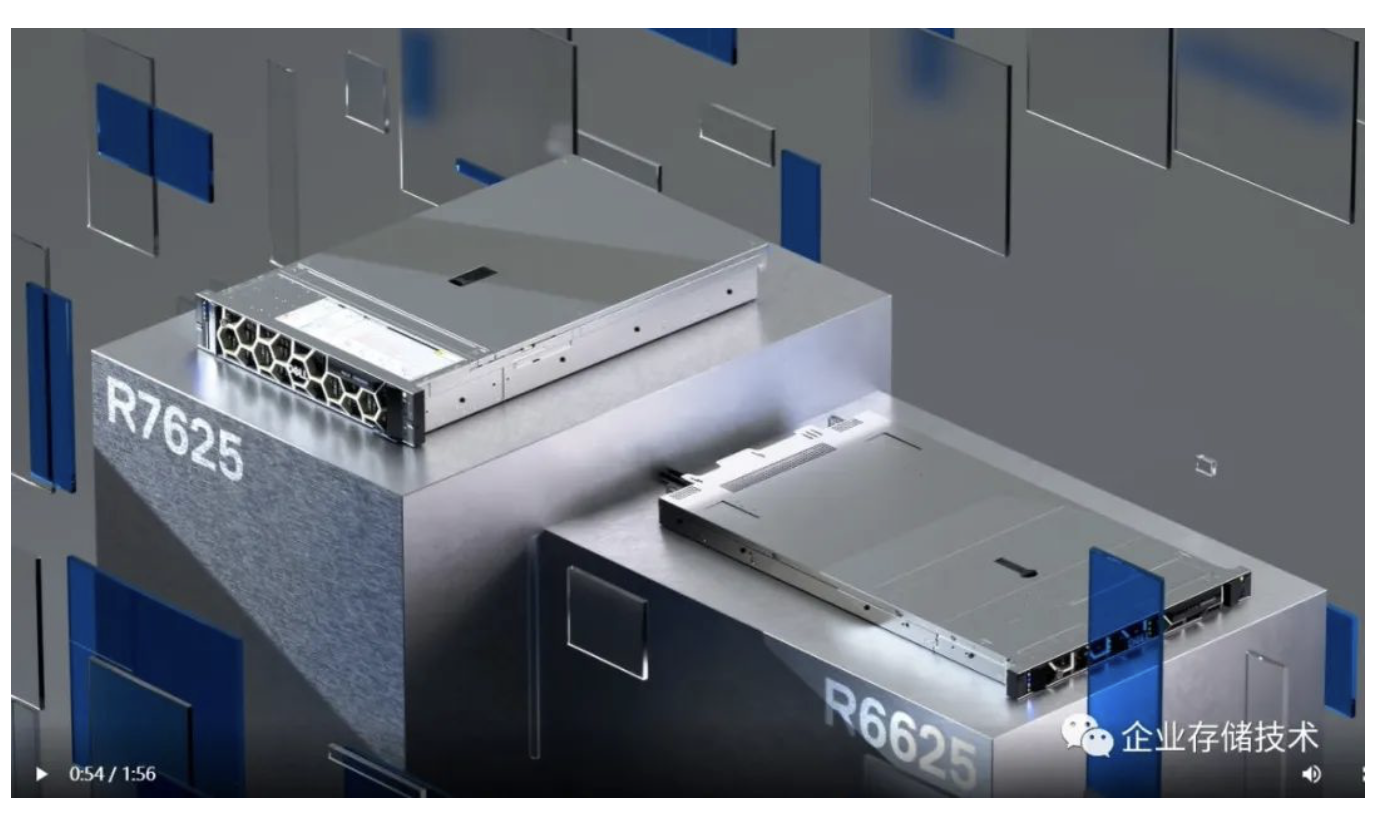

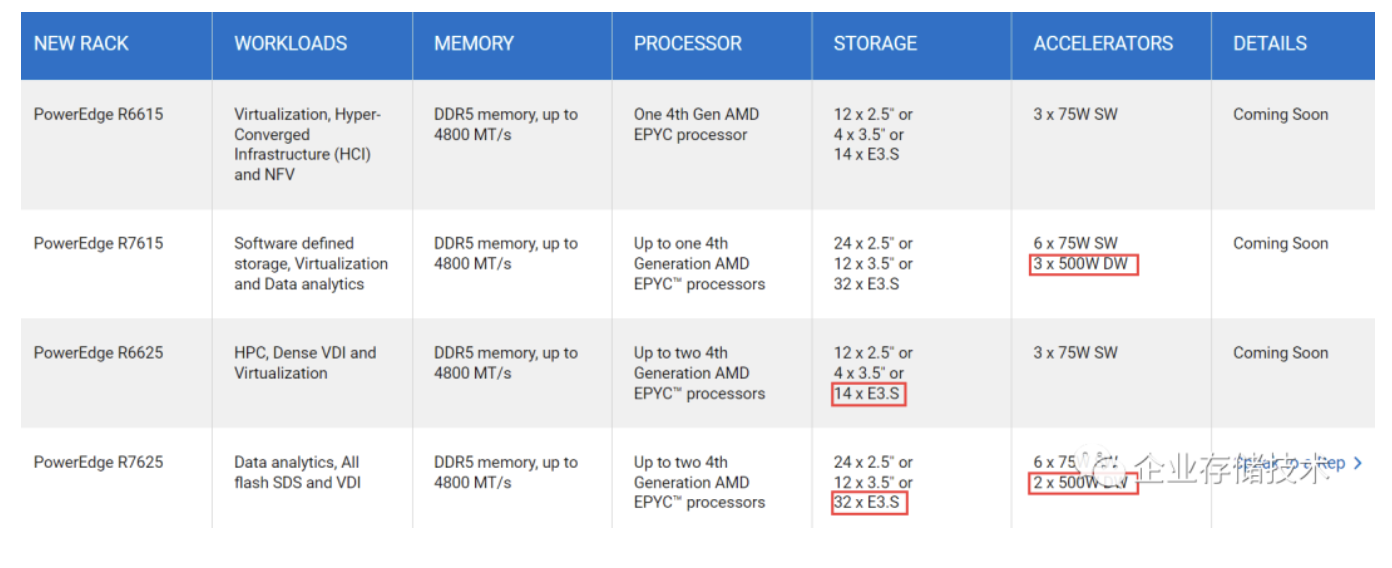

本次在Dell网站公布的服务器新机型,有双路的R7625、R6625,以及单路的R7615和R6615。当前除了下面的图表,几乎没给出更多的规格参数。

对于这4款适配AMD EPYC 9004处理器的PowerEdge 16G服务器,存储盘位多出了E3.S(EDSFF 3英寸)选项比较容易发现,而我则是看了好几次后才留意到加速器(GPU卡等)的功耗支持到了500W。具体来说,就是R7625支持2块500W双宽卡;CPU散热压力小的R7615支持到3块500W双宽卡。

按照Dell服务器的命名习惯,经典的PowerEdge R系列机架服务器应该都是配标准PCIe插卡形态GPU,而像XE8545这样的机型适配NVIDIA SMX GPU模块。在15G系列中,R750xa是一款2U 4x300W卡的高密度GPU服务器(实物照片参见《PowerEdge 15G服务器的风冷散热“新花样”》)

在PCIe规范5.0之前,带有辅助供电的GPU等卡严格说不应该超过300W,像RTX 3090、4090那样的毕竟是游戏显卡,基本上无法在双宽尺寸内做到被动散热(扩展阅读《RTX 3090初测:双宽涡轮风扇设计,诀窍与“烦恼”》)。以前我只是看到NVIDIA H100PCIe Gen5做到了350W。本次在16G服务器中将双宽卡的支持能力提高到500W,是为什么卡做准备呢?

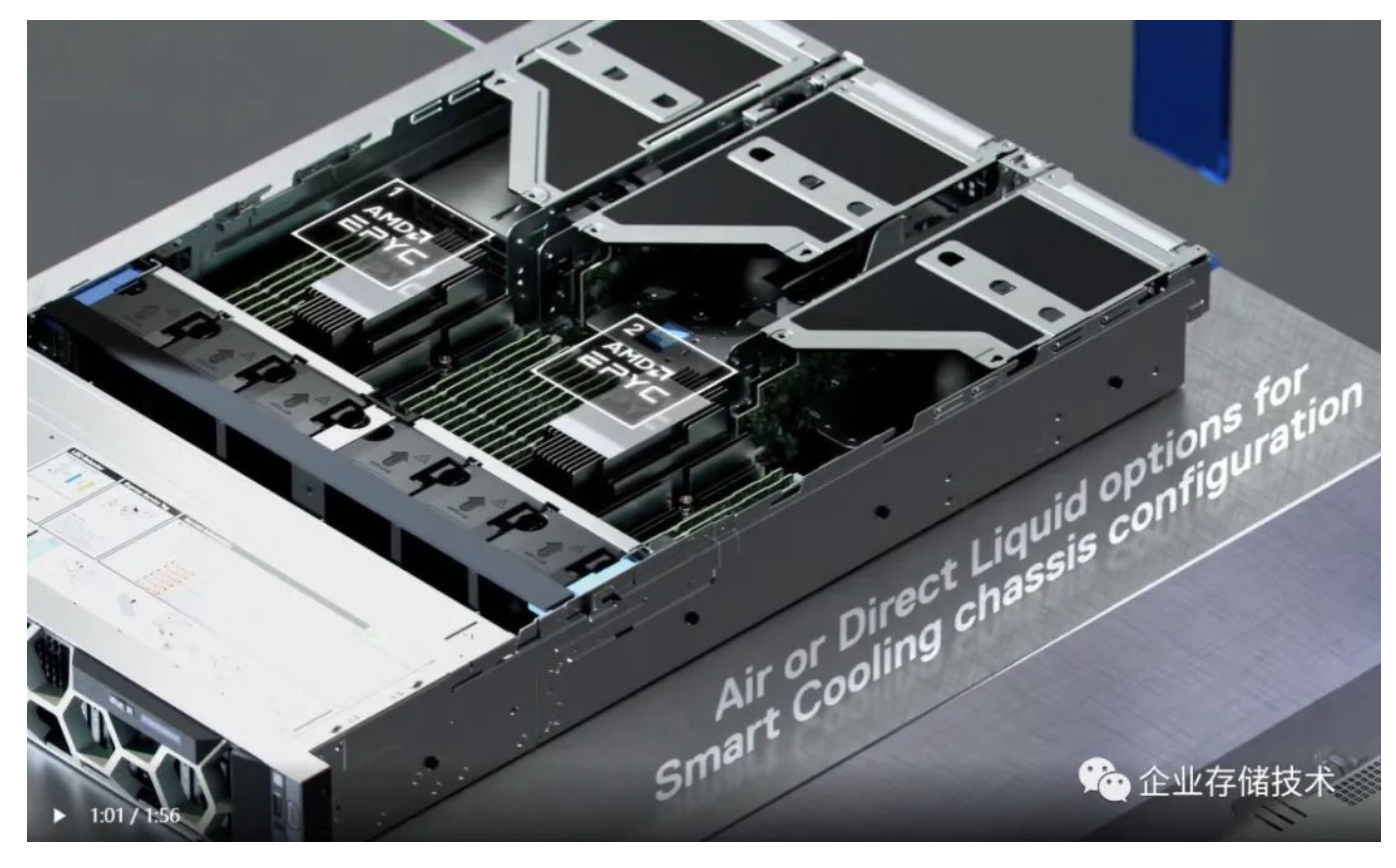

前不久我刚写过《350W+ CPU、700W+ GPU功耗:冷板和浸没式液冷哪个更有前途?》,如上图,Dell R7625将支持风冷和Direct Liquid(冷板式液冷)选项。我以前不只一次提到过,双宽500W的PCIe卡用风冷显然无法满足,估计这个功率密度也要上冷板式液冷了。

来自两家机构的EDSFF SSD市场预测

关于新的企业级SSD物理规范EDSFF,我之前写过几篇讨论,大家可以参考下:

《数据中心NVMe SSD和EDSFF前瞻:来自Intel、HPE、Dell & SNIA等》

《下一代数据中心SSD形态之争:来自Azure架构师的观点》

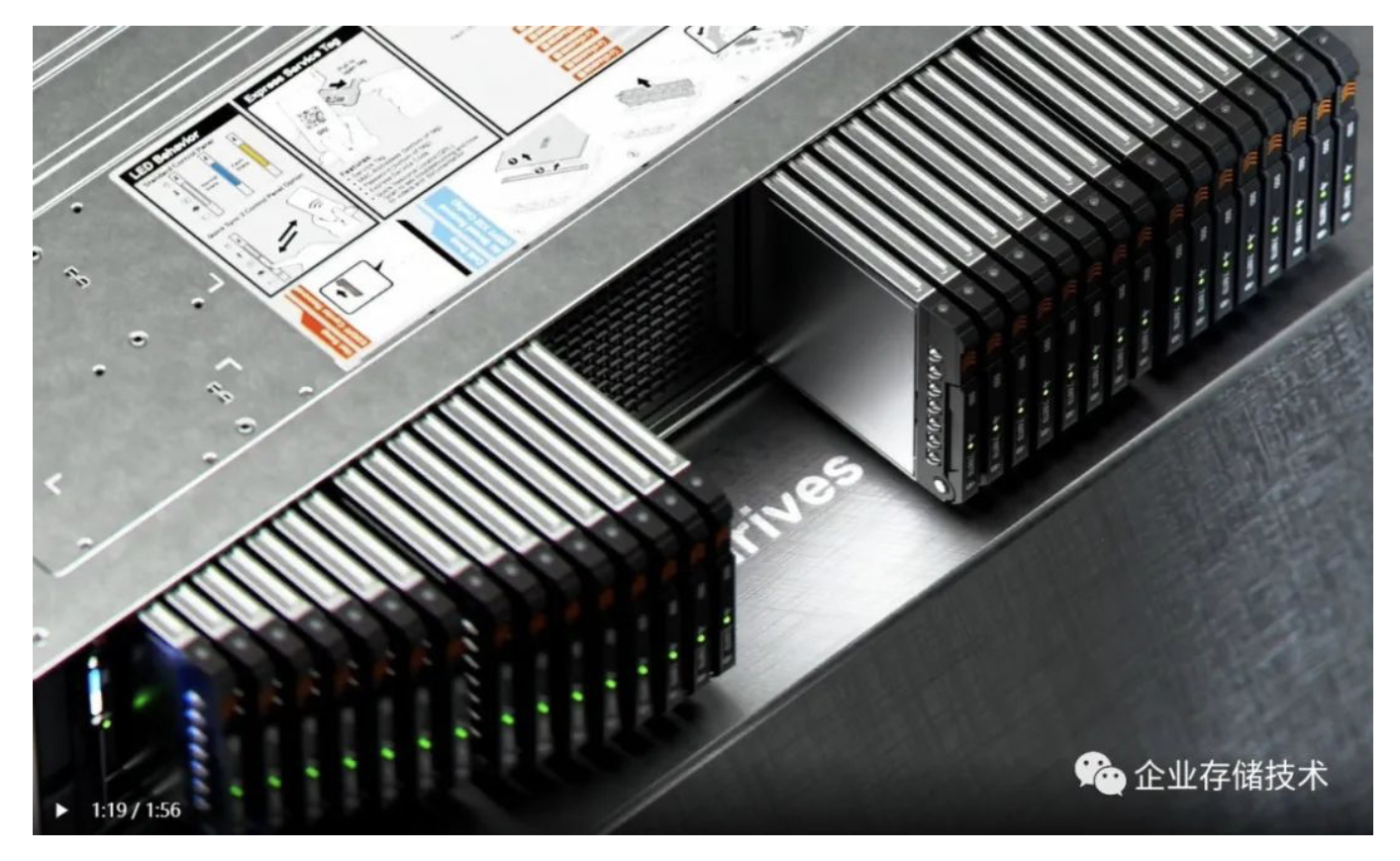

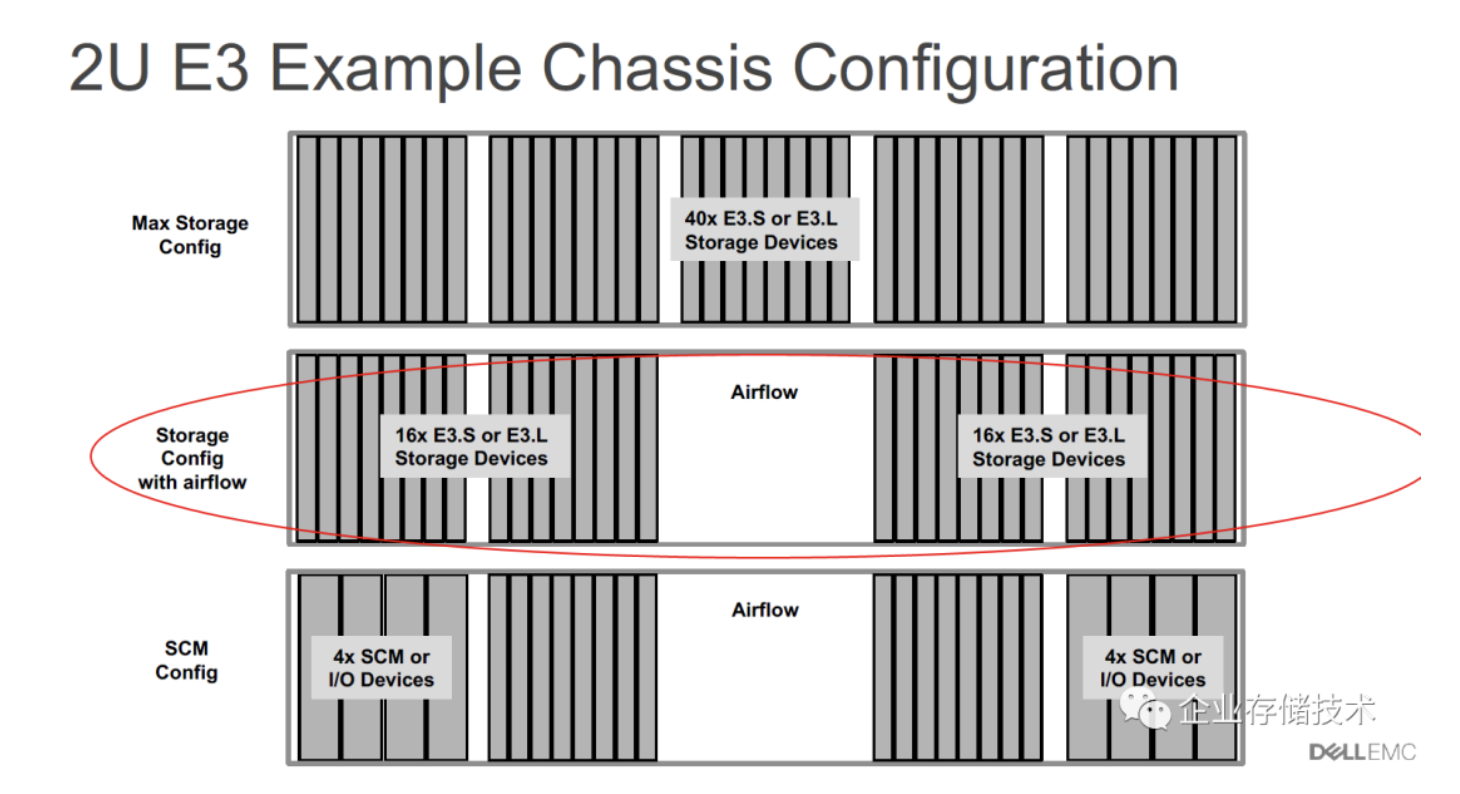

如上图,2U机箱的PowerEdge R7625将提供32个E3.S SSD前置热插拔盘位的机箱选项,比以前24块U.2驱动器的密度有所提高。机箱中间并没有完全插满,而是留了一块进风口,应该是为系统散热考虑。

正好我看到一份SNIA Webcast的资料《EDSFF Taking Center Stage in the Data Center》,顺便从里面引用几张图分享给大家。

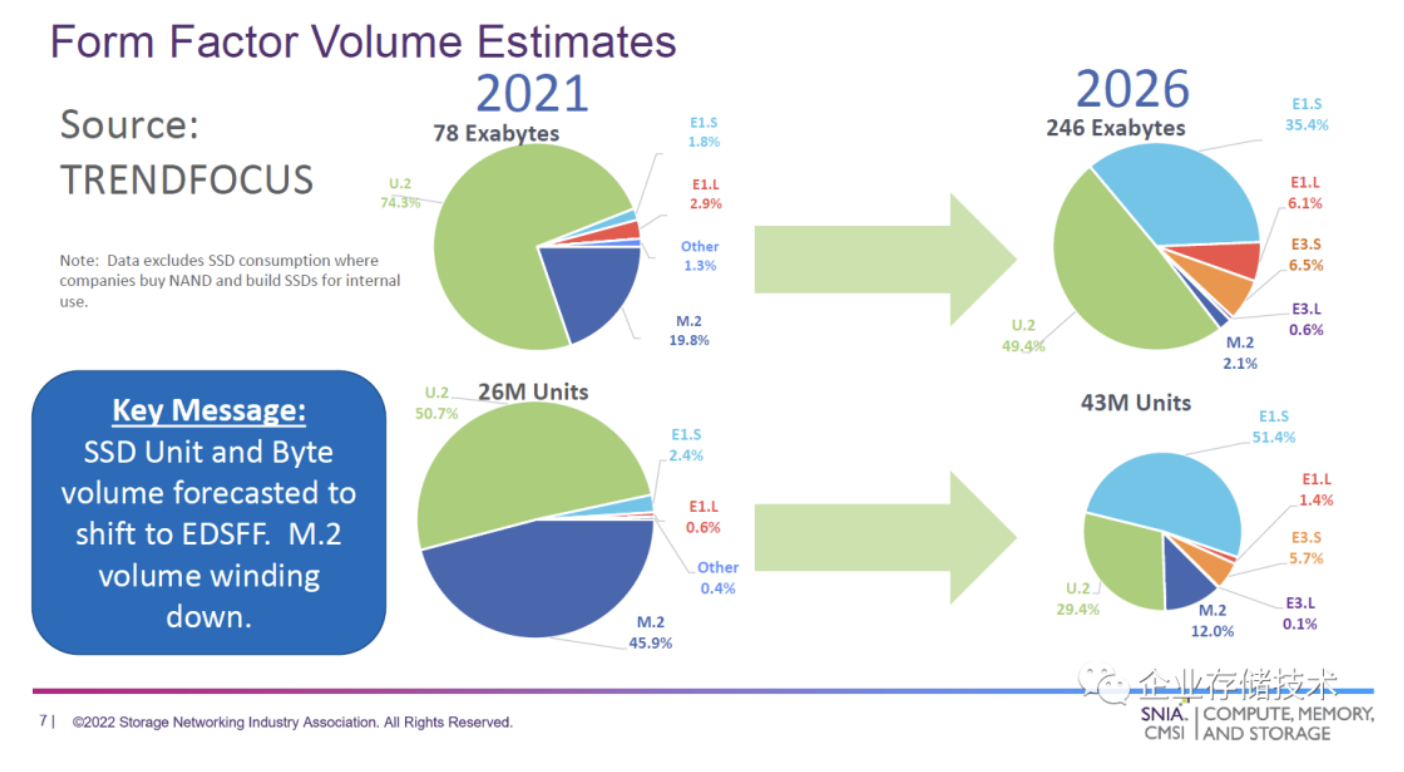

上面的预测来自TrendFocus。在2021年,数据中心SSD的2600万片出货数量中U.2占了一半,剩下一半基本是M.2,而78EB的容量中U.2占了3/4。它们预测到2026年,E1.S规格将占据一半的出货量(包括替代M.2),而在出货容量上U.2(含U.3?)仍拥有一半份额,E3.S的存在感不是太强。

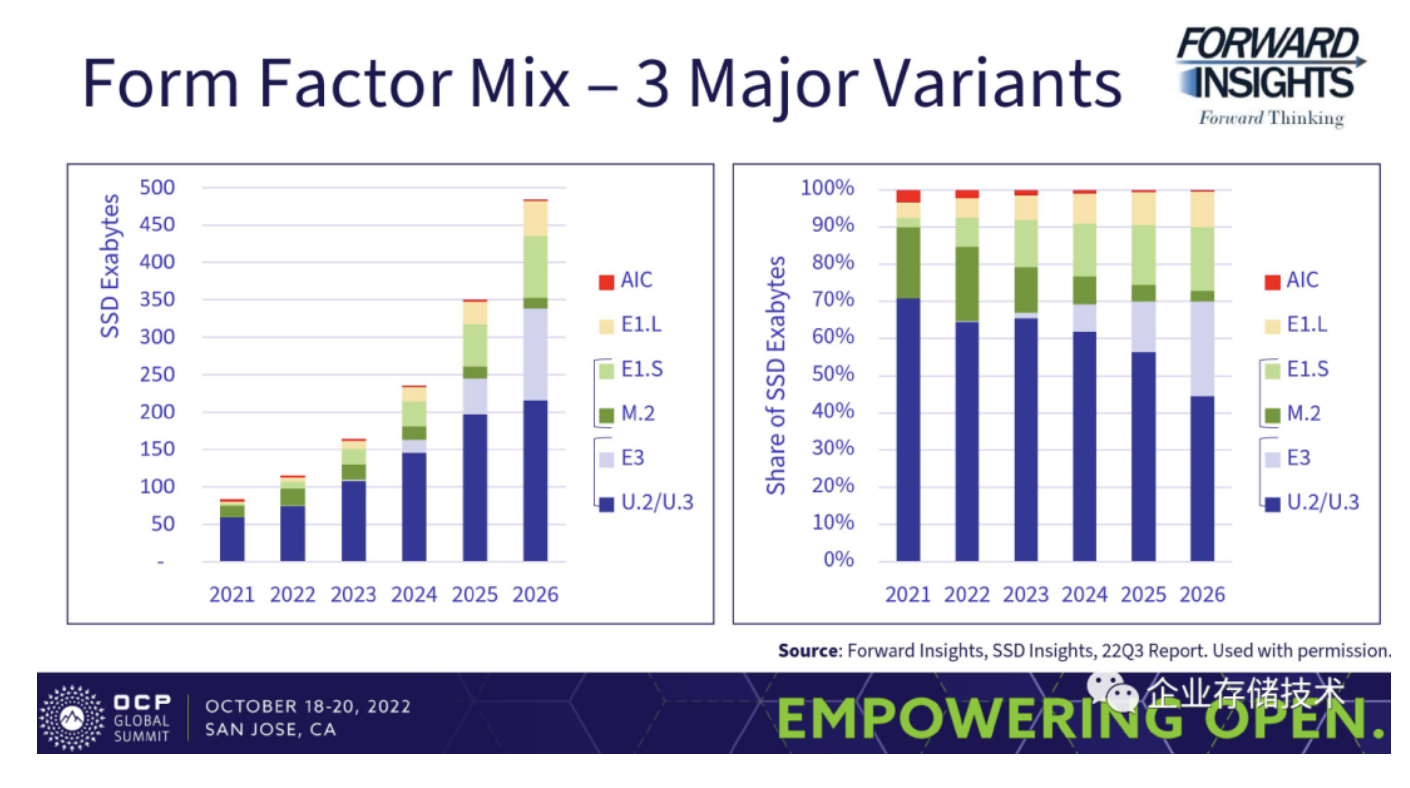

再来看2022 OCP Global Summit上面的另一份数字(全部会议资料链接点这里),Forward Insights预测到2026年,E3(E3.S短尺寸+ E3.L长尺寸)将占出货容量的20%以上;E1.S不到20%、E1.L大约10%。这些数据仅供参考。

E3.S:盘位做更多一定更好吗?

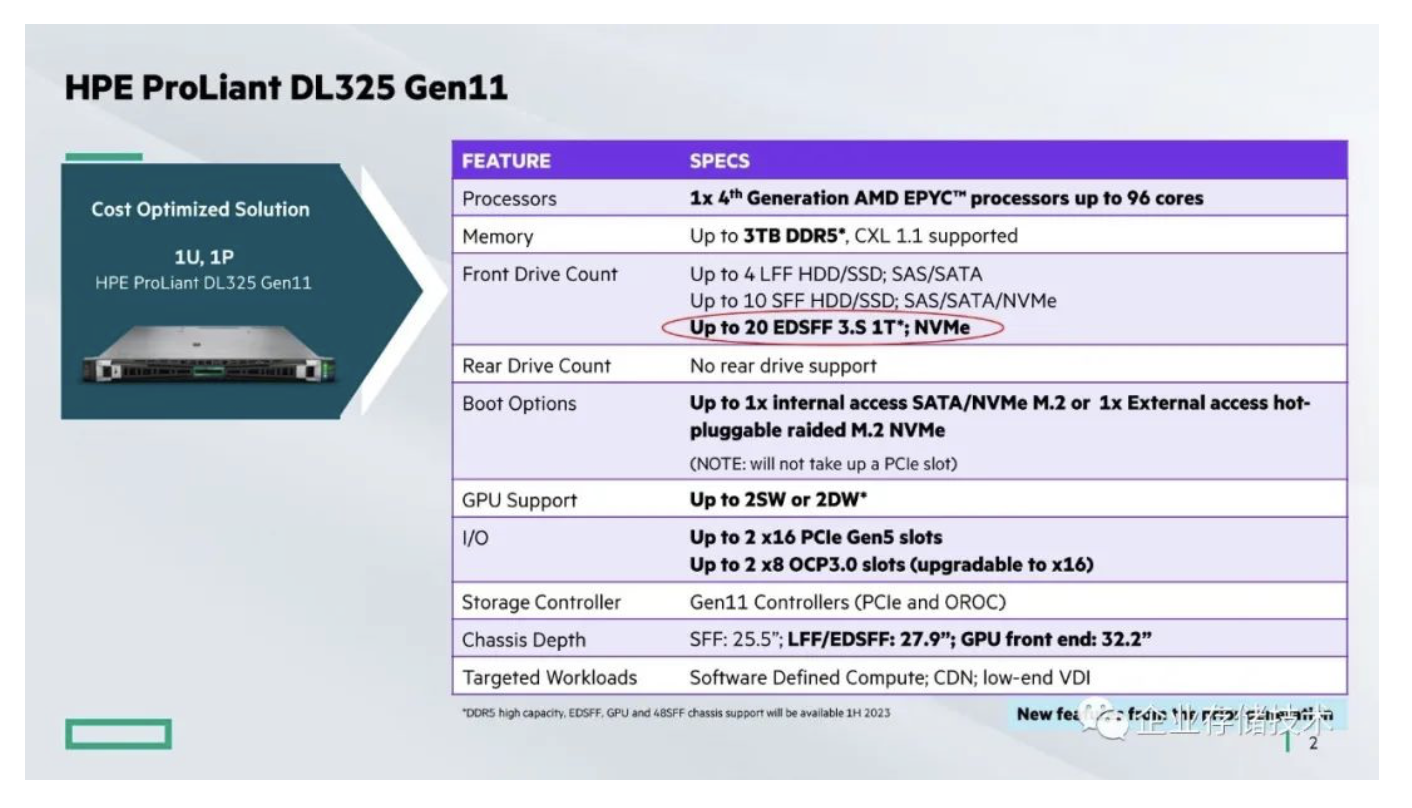

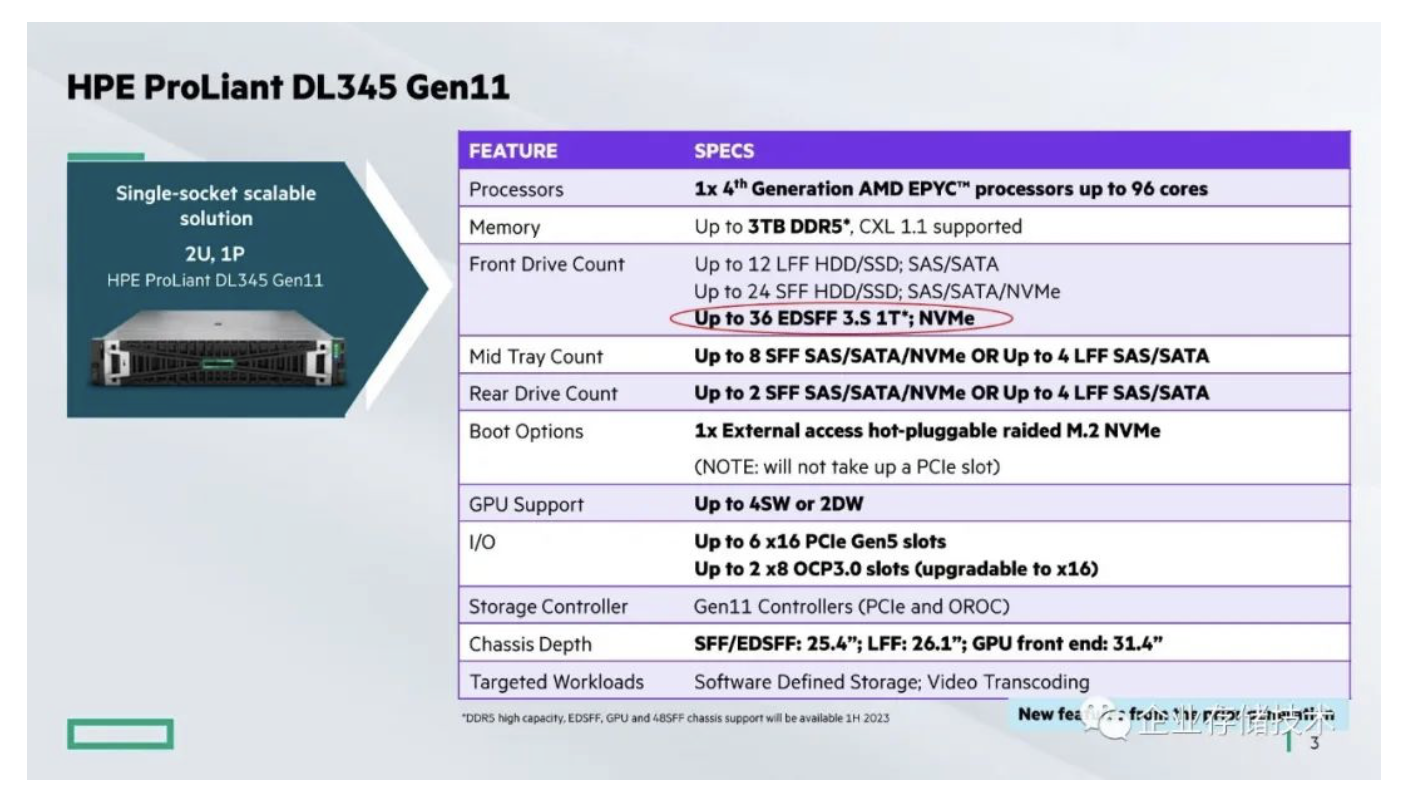

通常我是不习惯写可能存在竞品相关的讨论,最近这些年我也不怎么关注HPE服务器,这里只是顺便列出供大家参考。ProLiant DL345 Gen11正好是2U单路AMD EPYC4服务器新品,并标明了最多支持36个EDSFF 3.S NVMe SSD。

ProLiant DL325 Gen11则是1U单路AMD EPYC4服务器新品,最多支持20个EDSFF 3.S NVMe SSD。

看上去HPE在EDSFF支持上做的更激进?但仔细再看下DL385和DL365双路EPYC4服务器机型,SFF驱动器都是只写了相对保守的U.3规格而没有E3.S。是不是因为单路机型散热压力相对小,所以把SSD做成高密度呢?

注:这一段如果我哪里写的不对,请大家在留言中不吝指出。

其实在一年多以前,我就写过Dell做的原型E3.S系统,以及上图等相关讨论。E3.S Thin薄盘在1U/2U上的最高密度可以做到20和46个,但我们不能不考虑服务器系统的散热进风。密度太高,还会影响到背板的成本,包括上面的连接器和PCIe Switch等。比如用E1.S设计的性能密度可能做到比E3.S更高,但全配满了SSD成本也感人,并且PCIe lane够不够也是个问题。

每家服务器厂商在设计时都会考虑各种因素权衡和取舍,每一代做成什么样的规格,可以说没有绝对的好坏之分,只有对用户合适不合适。

除了SSD模块密度、对PCIe 5.0+高速率支持更好之外,E3前置存储机箱的另一个用法是,除了SSD还可以支持SCM等设备(包括现在比较热的CXL接口DDR5内存)。如上图,有些SCM或者I/O设备的厚度可能是双宽,这样我理解后面的背板需要换一下,比如把2个PCIe 5.0 x4合并成一个x8使用。

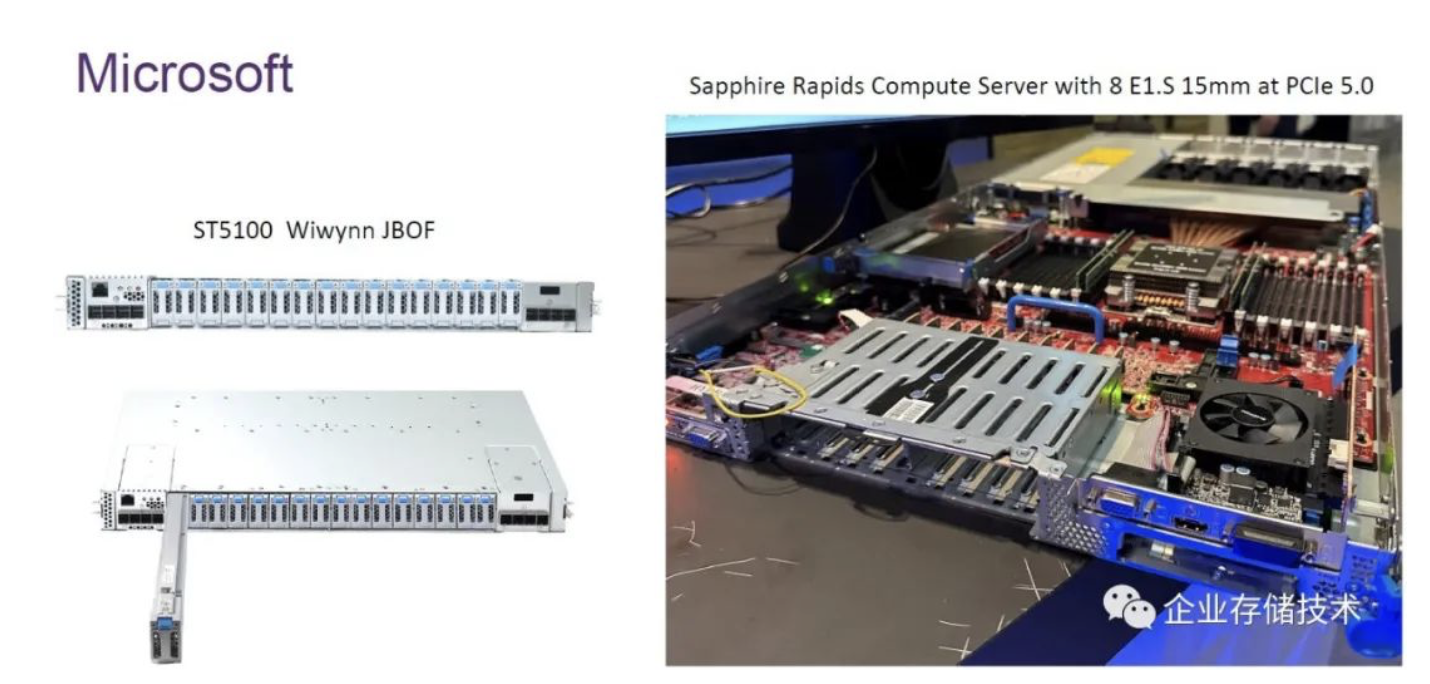

最后再给大家看一款微软用的Intel下代Xeon平台(Sapphire Rapids)服务器。右边照片中的1U计算节点上设计了8个E1.S 15mm PCIe 5.0存储盘位,而左边的ST5100 JBOF来自Wiwynn(纬颖),其E1.S的密度也只是设计了16槽位。

就先写到这里吧,等服务器新品上市了更多资料会出来。

作者: 唐僧 huangliang

原文:企业存储技术

推荐阅读

- 从DirectX到工作站测试:当Intel GPU再次面对NVIDIA、AMD

- 2022 OCP Global Summit会议资料分享

- 350W+ CPU、700W+ GPU功耗:冷板和浸没式液冷哪个更有前途?

欢迎关注企业存储技术极术专栏, 欢迎添加极术小姐姐微信(id:aijishu20)加入技术交流群,请备注研究方向。