Title: Transformer for Single Image Super-Resolution

PDF: https://arxiv.org/pdf/2108.11084

Code: https://github.com/luissen/ESRT

导读

基于深度学习的单张图像超分辨率(Single image super-resolution,SISR)近年来得到飞速发展。然而,以往的研究大都集中在构建更复杂的网络以提升超分性能。随着 ViT 的崛起,Transformer 在计算机视觉各个子领域遍地开花,其中便包括了图像超分。众所周知,视觉 Transformer 的一大核心痛点便是高计算成本和昂贵的显存开销。因此,本文提出了一种新颖的高效超分辨率 Transformer 模型——ESRT,其有机地结合了轻量级 CNN 和 Transformer 骨干(Lightweight CNN Backbone, LCB & Lightweight Transformer Backbone,LTB)。其中:

LCB可以动态调整特征图的大小,以低计算成本提取深层特征;LTB则由一系列高效 Transformer 模块组成并结合高效多头注意力来进一步降低显存占用;

最后,与基于原始的 ViT 网络相比,所提方法仅需占用少量内存(4,191M vs. 16,057M),但能够获得更优的性能。代码已开源,欢迎大家尝试!

动机

相比于传统方法,深度卷积神经网络在SISR领域取得了突破性的进展,尽管这类方法已经取得了出色的性能,但由于高计算成本和内存占用使其应用于实际生产应用中变得困难。为了解决这个问题,许多循环网络和轻量级网络被提出,如DRCN,SRRFN,IMDN,IDN,CARN,ASSLN,MAFFSRN和RFDN。这些模型都致力于构建更高效更轻量的网络结构,但这类方法减少了网络容量势必导致性能不佳。

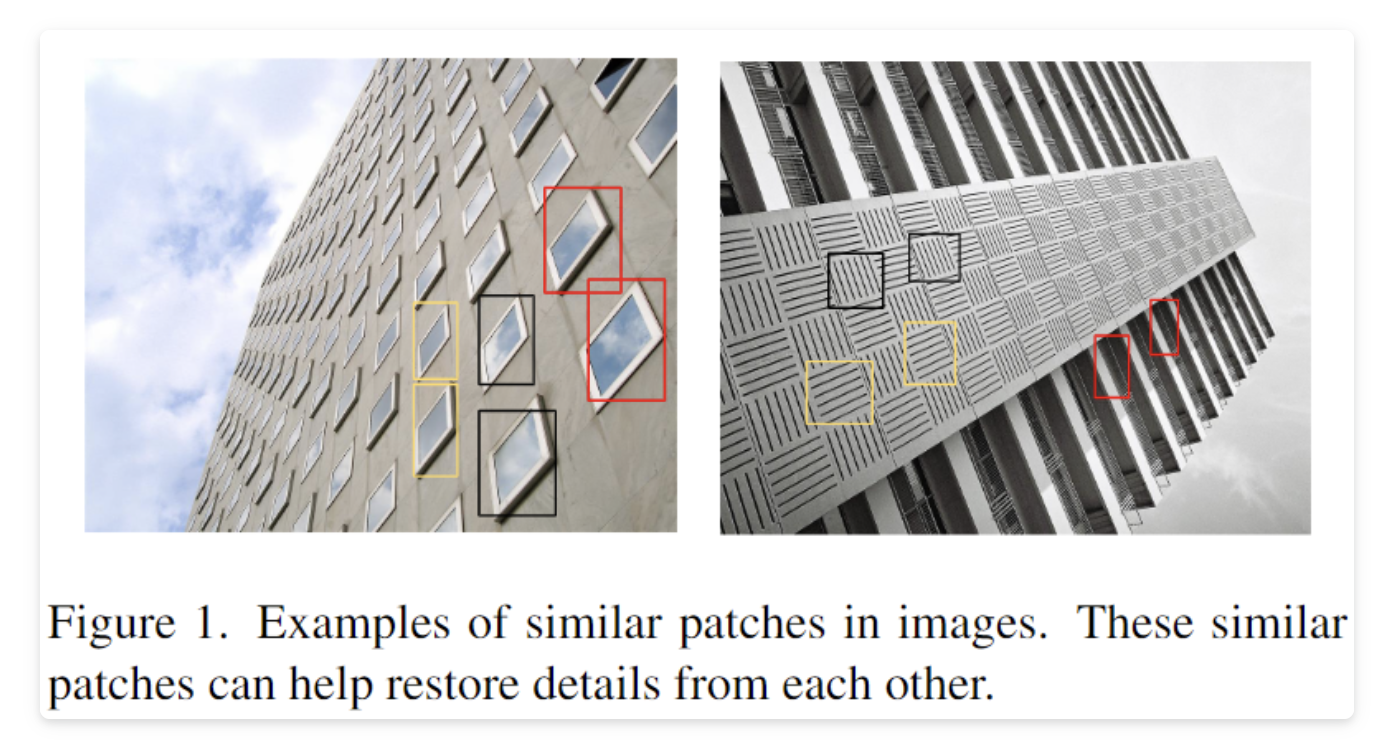

为了解决这个问题,作者引入了Transformer架构以捕获图像的长远距离依赖(如上图1所示,相似的 patch 有助于其它 patch 的图像恢复),来模拟 SISR 任务中的纹理结构等详细信息。如前所述,Transformer 模型在计算机视觉任务中已经有了一些应用,不过这些方法通常占用大量 GPU 内存,这极大地限制了它们的灵活性和应用场景。此外这些方法不能直接应用于 SISR,因为图像恢复任务通常将较大分辨率的图像作为输入,这对显存占用是一个极大的挑战。下面我们具体介绍下这个方法。

方法

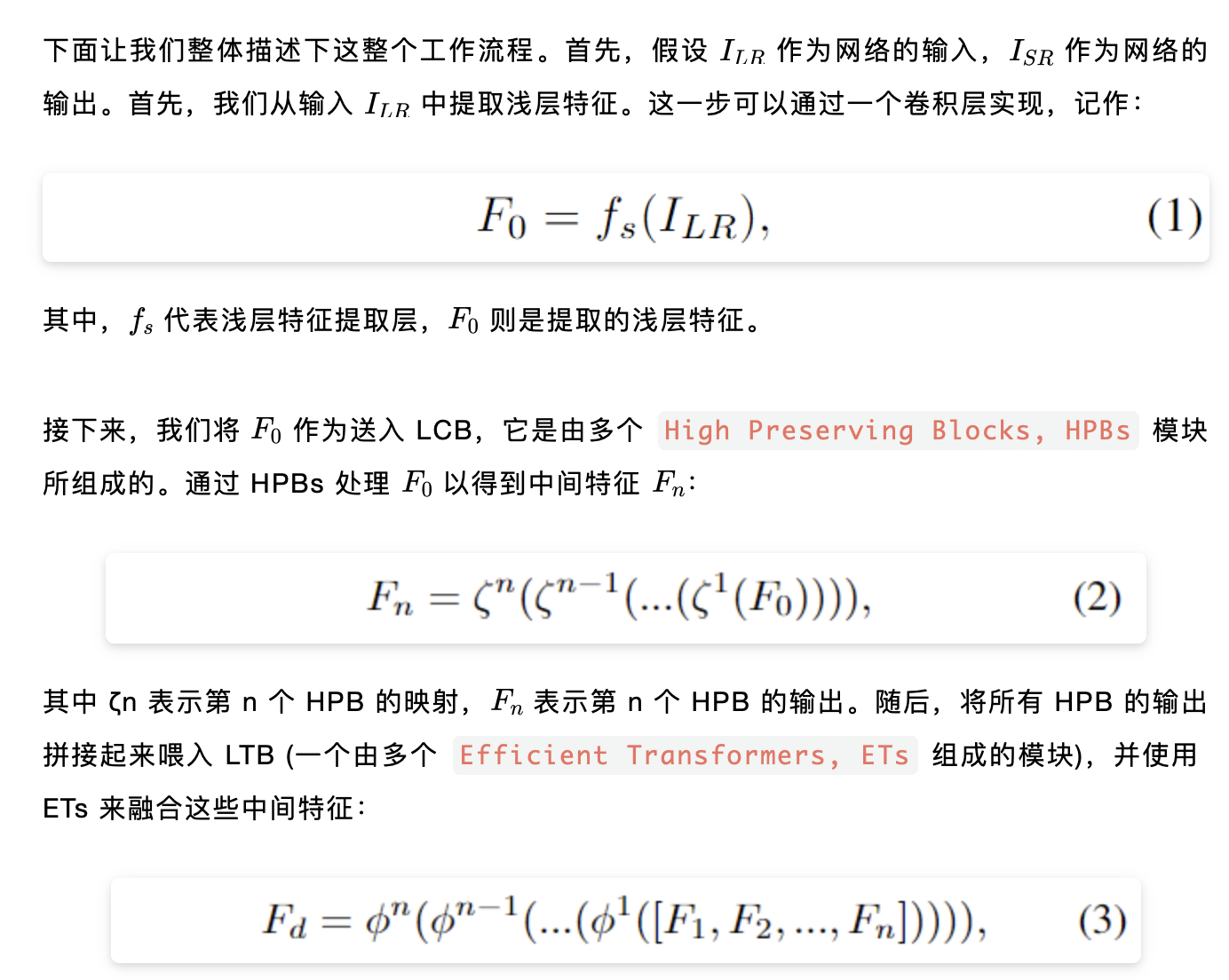

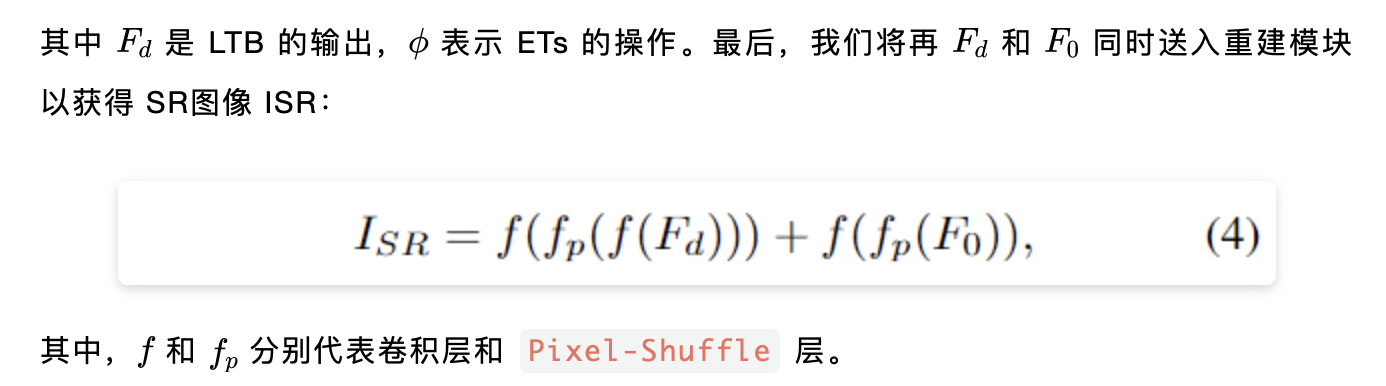

Framework

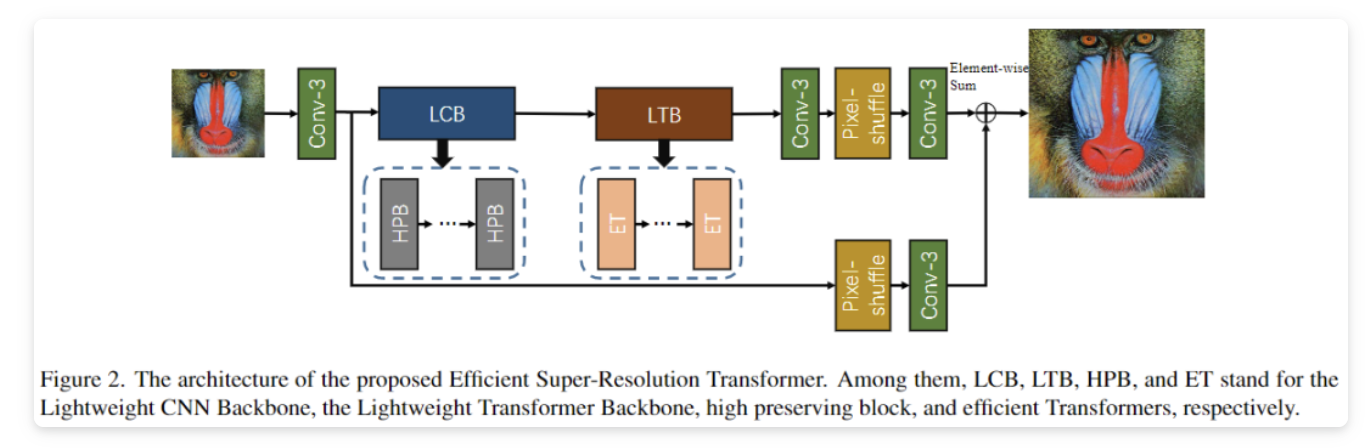

上图展示了 ESRT 的网络架构图,其主要包含四个部分:

- Shallow Feature Extraction (SFE)

- Lightweight CNN Backbone (LCB)

- Lightweight Transformer Backbone (LTB)

- Image Reconstruction (IR)

Lightweight CNN Backbone

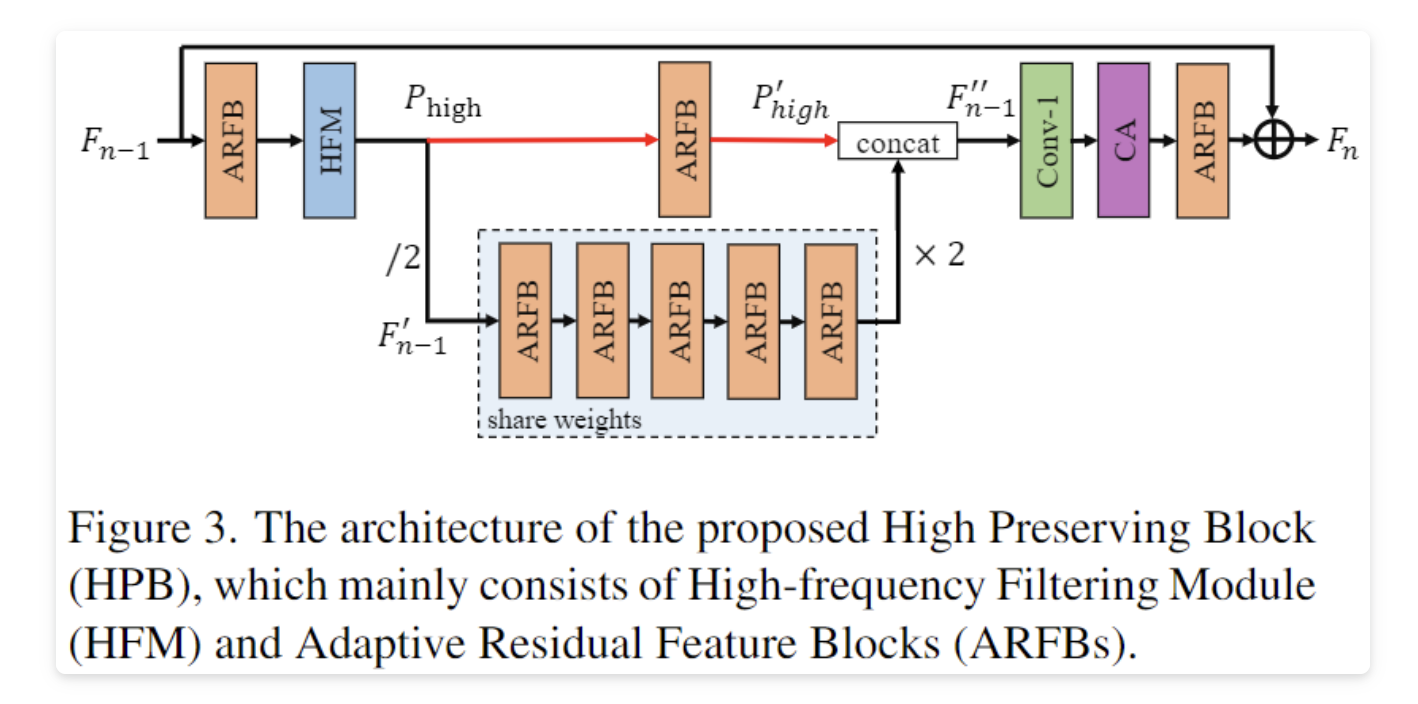

LCB 提出的主要动机是提前从输入低分辨率图像中提取出潜在的超分辨率特征,从而使得模型具备超分辨率的初始能力。从主框架图可以看出,LCB 主要由一系列高保真块(HPB)构成,通过降低特征映射的分辨率来减少计算成本,并利用自适应残差特征块和高频过滤模块来保留初始的细节信息。通过这种方式,可以在减少计算成本的同时提高超分辨率模型的性能。下面是 HPB 模块的具体结构设计:

可以看出,其包含两个主要的组件即保留高频滤波模块(HFM)和自适应残差特征块 (ARFB)。

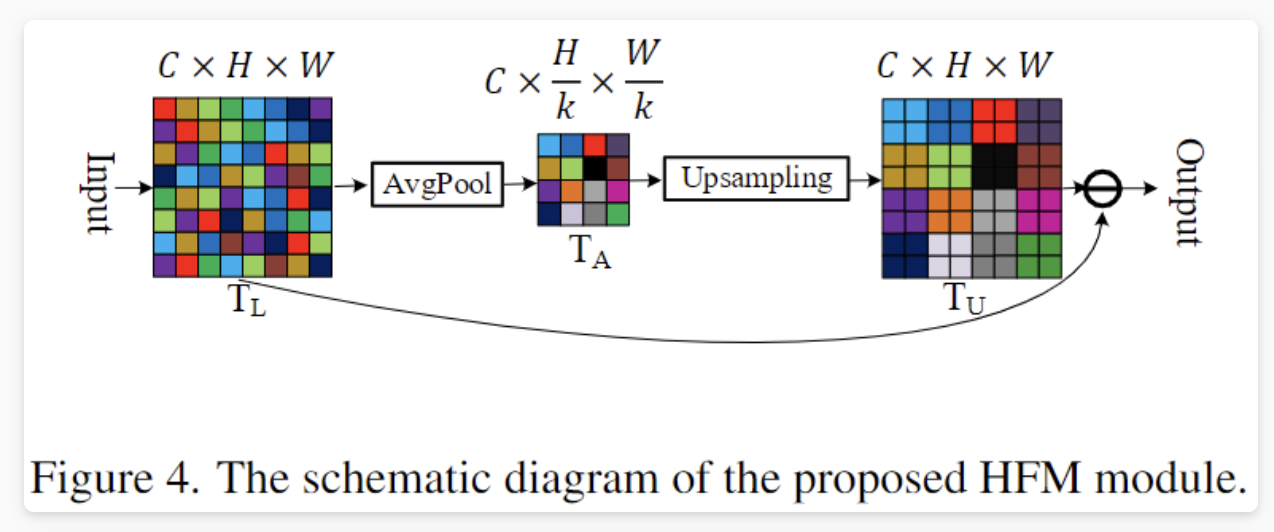

High-frequency Filtering Module

HFM是一种新的可微分高频信息估计方法,其很好的规避了传统傅里叶变换难以嵌入卷积神经网络中的问题,以实现从低分辨率图像中估计高频信息。Adaptive Residual Feature Block

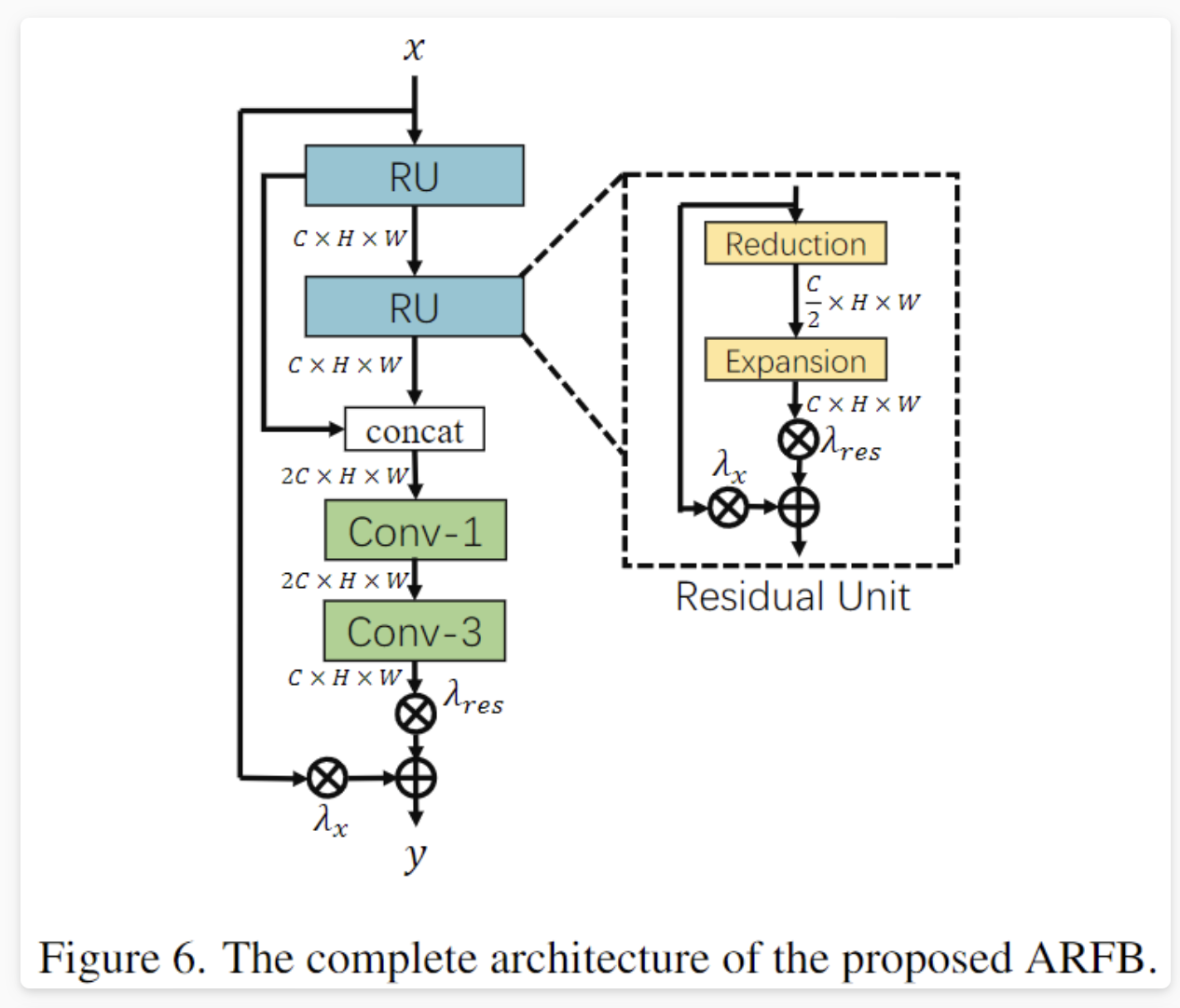

受ResNet和VDSR启发,作者提出了一种基于残差映射的基础特征提取块ARFB,它由两个残差单元和卷积层组成,用于减少和恢复特征图的通道数,并使用自适应权重的残差比例(RSA)来动态调整残差路径和Identify路径的重要性。相比于固定的残差比例,RSA可以改善梯度流,并自动调整输入特征图的残差特征映射的内容。

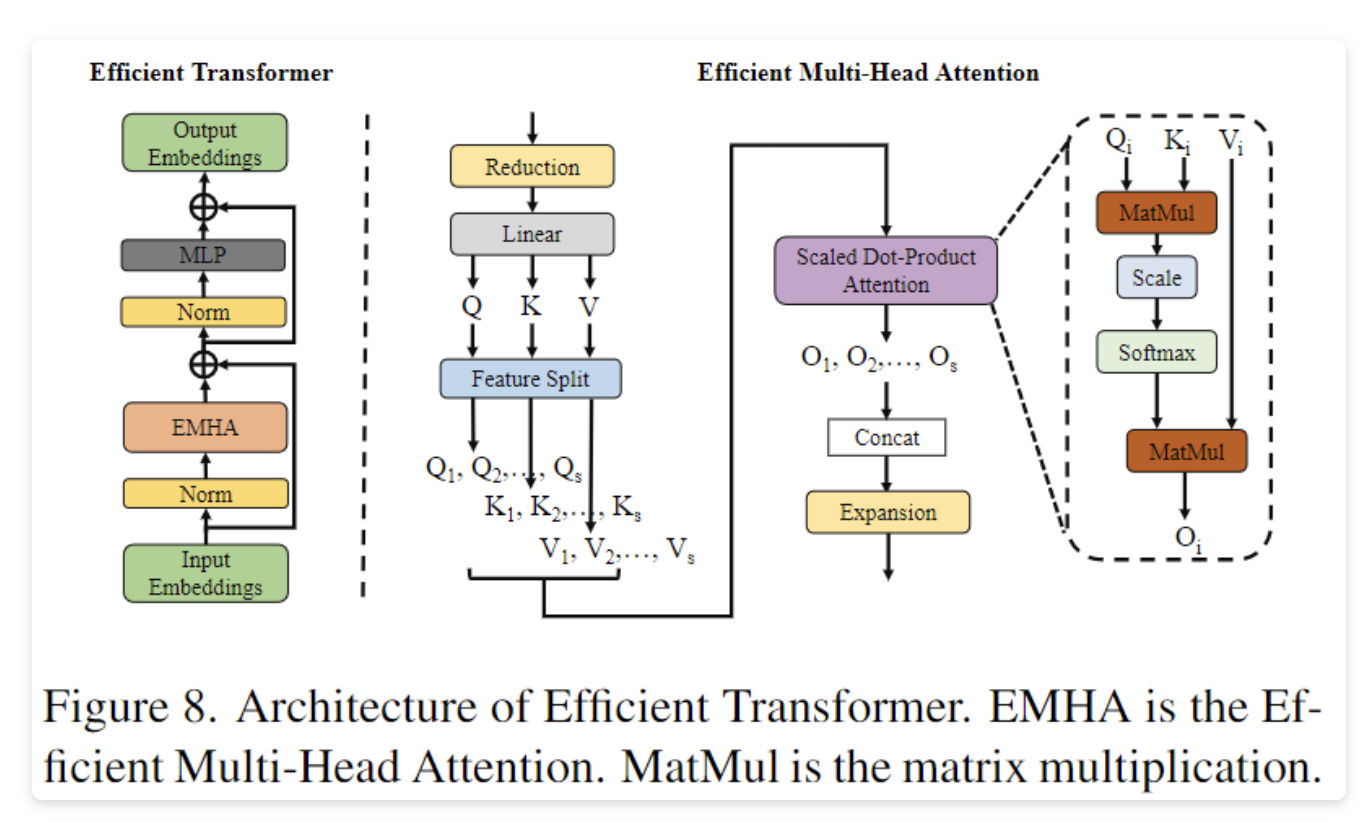

Lightweight Transformer Backbone

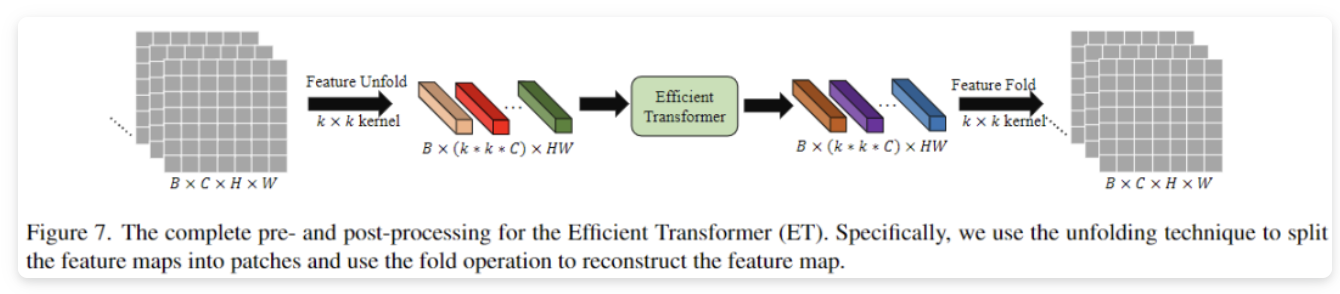

在超分辨率图像重建任务中,相似的图像块可以被用作参考图像,从而恢复当前图像块的纹理细节,因此Transformer很适合干这个工作。然而,高昂的计算成本和显存要求进一步限制了它的应用。LTB的设计理念便是希望能够以较低的计算成本捕捉图像中类似局部区域的长期依赖性,其主要由一系列的高效 Transformer 模块组成。

与ViT类似,ETs 也只使用了 Transformer 中的 encoder 结构,其主要工作是对原始 Transformer 结构的多头注意力组件进行了高效化的设计,如下所示:

总的来说,ETs可以很好地提高网络效率和降低对显存的占用。

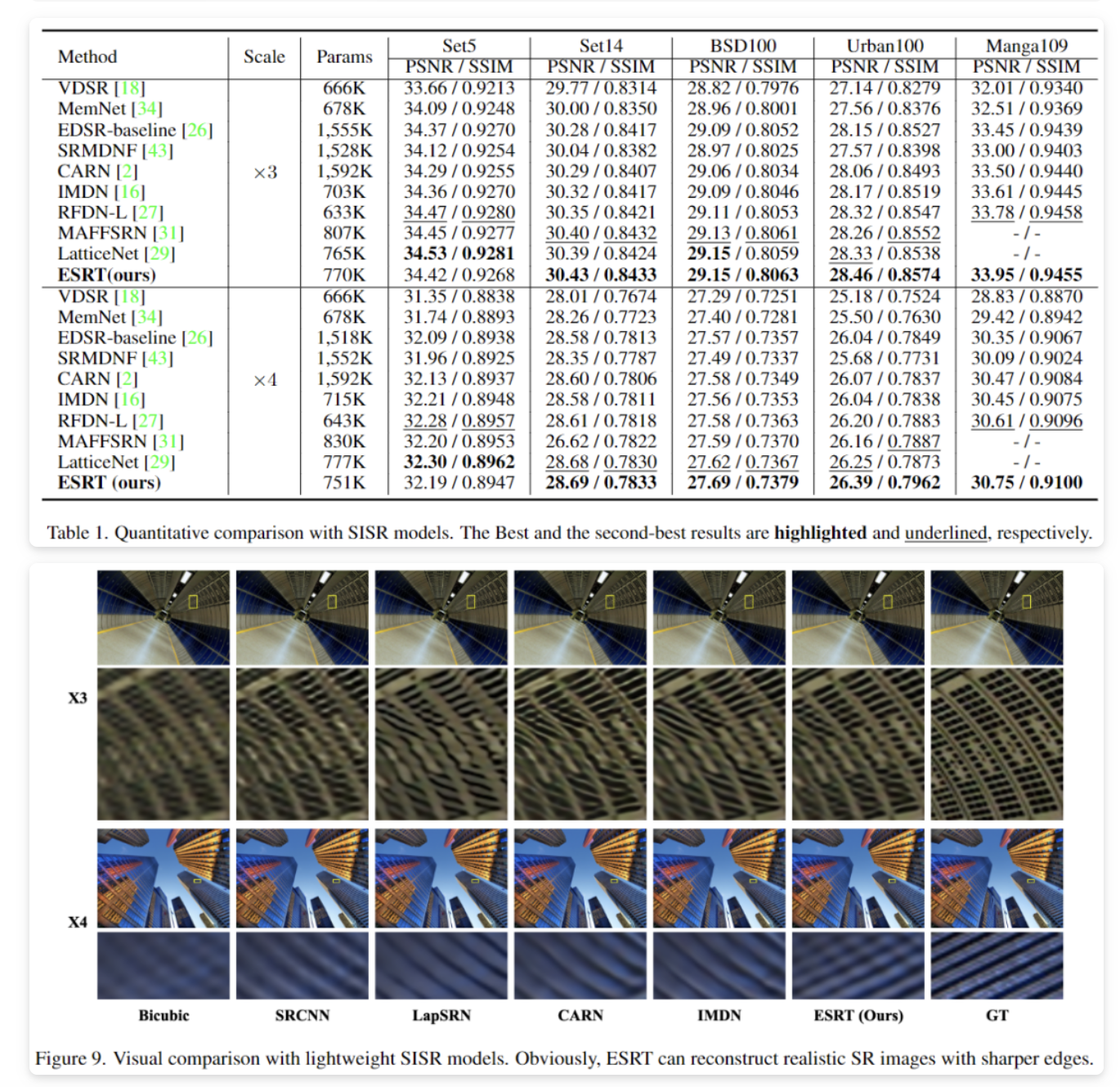

实验

结论

本文结合 Transformer 和 CNN 建模长、短距离依赖的优势,提出了一种新颖的用于单图超分的高效超分网络——ESRT,其基于轻量级 CNN 骨干提取深层特征并利用 Transformer 骨干对图像中相似局部区域之间的长远依赖性进行建模。大量实验表明,ESRT 在模型性能和计算成本之间取得了最佳平衡,表现优异!

往期回顾

作者: 派派星

文章来源:CVHub

推荐阅读

欢迎大家点赞留言,更多Arm技术文章动态请关注极术社区嵌入式AI专栏欢迎添加极术小姐姐微信(id:aijishu20)加入技术交流群,请备注研究方向。