Network-on-SOC

芝能智芯出品

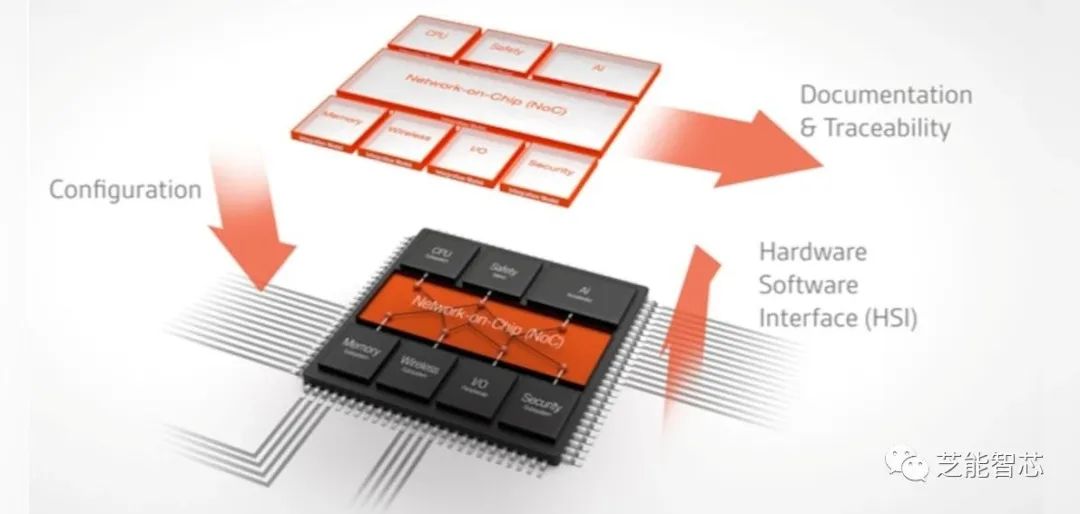

人工智能(AI)和机器学习(ML)在现代科技领域中的广泛应用,特别关注了它们在传感器、边缘设备、边缘计算、数据中心和云端的角色,在这些不同领域中,Net-on-chip(NoC)技术的关键作用。

在圣克拉拉举行的人工智能硬件峰会和在布鲁塞尔举行的 Autosens 峰会,很多内容都在交汇。

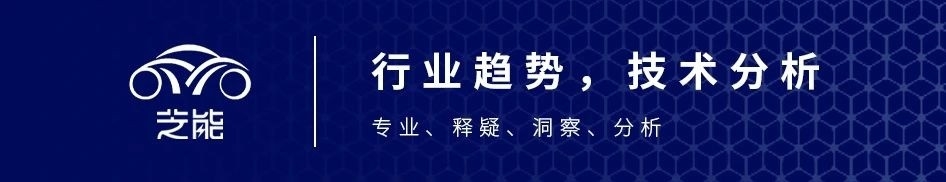

网络片上网络(Network-on-Chip,NoC)是集成电上的一种基于网络的通信子系统,用于SoC中的模块之间。IC上的模块用于模拟计算机系统的各种功能,并且在网络科学的意义上被设计成模块化的。网络片上网络是一个基于路由器的分组交换网络,连接了SoC模块。

从传感器到数据中心,人工智能和机器学习无处不在。

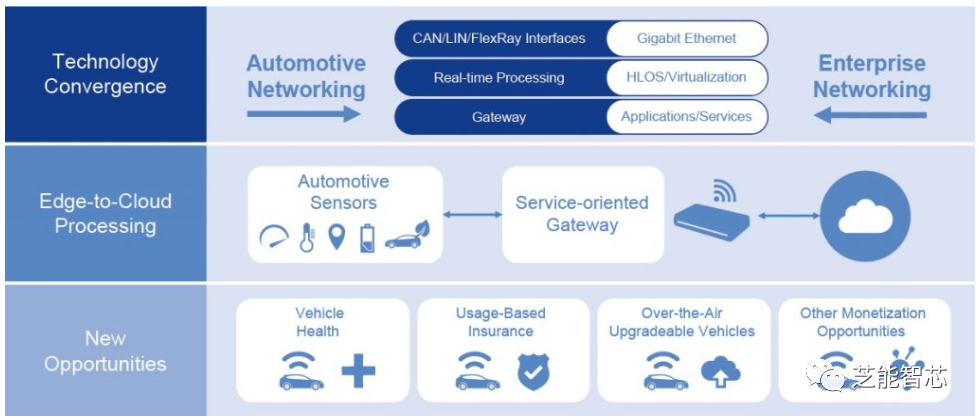

1)传感器是人工智能和机器学习应用的起点,负责从环境中收集各种原始数据,涵盖了从温度读数到图像的各种信息。传感器内部集成了SoC人工智能处理,这是一个新兴的概念,主要用于基本数据的预处理。例如,物联网传感器使用轻量级机器学习模型对数据进行过滤或处理,从而减少了传输负担和原始数据量。这种本地处理不仅有助于减少延迟,还能保持带宽的稳定。随着汽车电子架构的不断发展,EE架构需要权衡在计算发生的位置以及如何在区域计算和中央计算之间分配任务方面做出决策。

2)边缘设备通常包括移动电话、平板电脑或其他靠近数据源的便携式设备。汽车也可以看作是一种边缘设备,但有着独特的“轮上的传感器到数据中心”的计算分布方式。在边缘设备上执行人工智能和机器学习模型对于需要实时处理和低延迟的应用程序至关重要,例如增强现实(AR)和自动驾驶汽车等无法依赖“始终在线”连接的应用。这些设备上部署的模型经过优化,以在设备上实现更快的响应速度,并增强数据隐私性,因为数据不总是必须传输到中央服务器。

3)边缘计算是人工智能和机器学习可能在用户察觉之外发生的领域。远端计算指的是距离云数据中心最远但距离用户最近的基础设施。这种计算模式适用于需要比边缘设备更多计算资源和功率,但又需要比云解决方案更低延迟的应用程序。高级分析模型或推理模型,这些模型对边缘设备至关重要,但对延迟非常敏感。“边缘人工智能”来描述在这个层面进行的计算,包括了自动辅助驾驶汽车、联网设备以及智能手机上的面部识别和实时交通更新等应用。

4)数据中心和云则成为计算资源的中心,提供卓越的处理能力和存储,非常适合用于训练复杂且资源密集型的人工智能和机器学习模型,并管理大规模的数据集。数据中心内的高性能计算集群可以处理复杂任务,比如训练深度神经网络或进行广泛的模拟。但由于资源限制,这些任务在边缘设备上无法实现。最初,生成式人工智能主要驻留在这些中心地带,通常需要特殊的加速设备,这种生成式人工智能逐渐向“设备上的生成式人工智能”发展,这就是高通等公司所展示的趋势。

在整个人工智能和机器学习生态系统中,各层之间相互连接,形成了无缝的工作流程。传感器可能会收集数据并进行初始处理,然后将数据发送到边缘设备进行实时推理。在数据传输到数据中心进行深入分析和(重新)训练模型之前,可能需要在远端或近端边缘计算资源上进行更详细的分析,以获得更精细的结果。

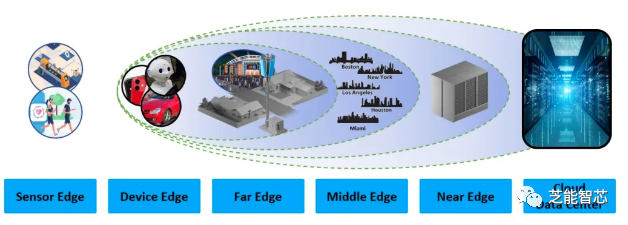

NoC(片上网络)是人工智能和机器学习领域的关键推动者,在以下三个方面发挥重要作用:

1)连接各种常规的人工智能/机器学习子系统,快速传输数据是关键,因此需要宽位宽、广播能力和虚拟通道功能的支持;

2)降低芯片上所有模块集成的风险,NoC确保各部件之间高效的通信,解决了集成问题;

3)在小芯片场景中连接各种硅芯片(D2D)或芯片到芯片(C2C)环境中的各种芯片,这需要适当的协议支持。为了实现这些功能,NoC必须支持各种协议。

Arteris的FlexNoC和Ncore技术受到了市场的关注,解决了片上网络的问题,帮助客户降低了集成风险,使他们能够专注于构建下一代AI和RISC-V CPU产品。关于小芯片之间的连接问题,行业内正就物理接口(如XSR、BOW、OHBI、AIB和UCIe)及其数字控制器进行激烈讨论。NoC和“SuperNoC”等技术必须支持适当的协议,行业内正在探讨Arm的CHI C2C和其他提案。为了实现理想的开放式小芯片生态系统,需要各家公司共同努力。

AI/ML的快速发展将推动半导体领域的发展,而NoC技术将在AI/ML集群中发挥关键作用,连接各个部分,促使技术不断创新,实现更高效的数据处理和传输。