Numenta的处理方法

芝能智芯出品

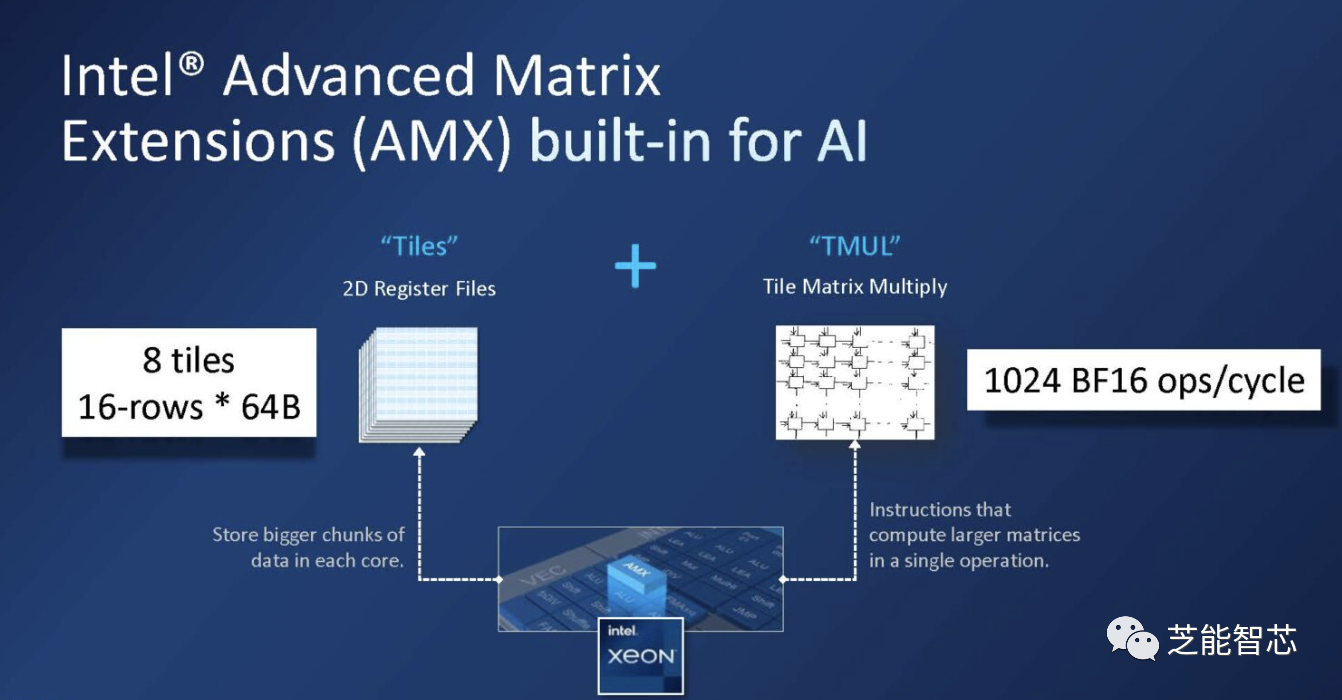

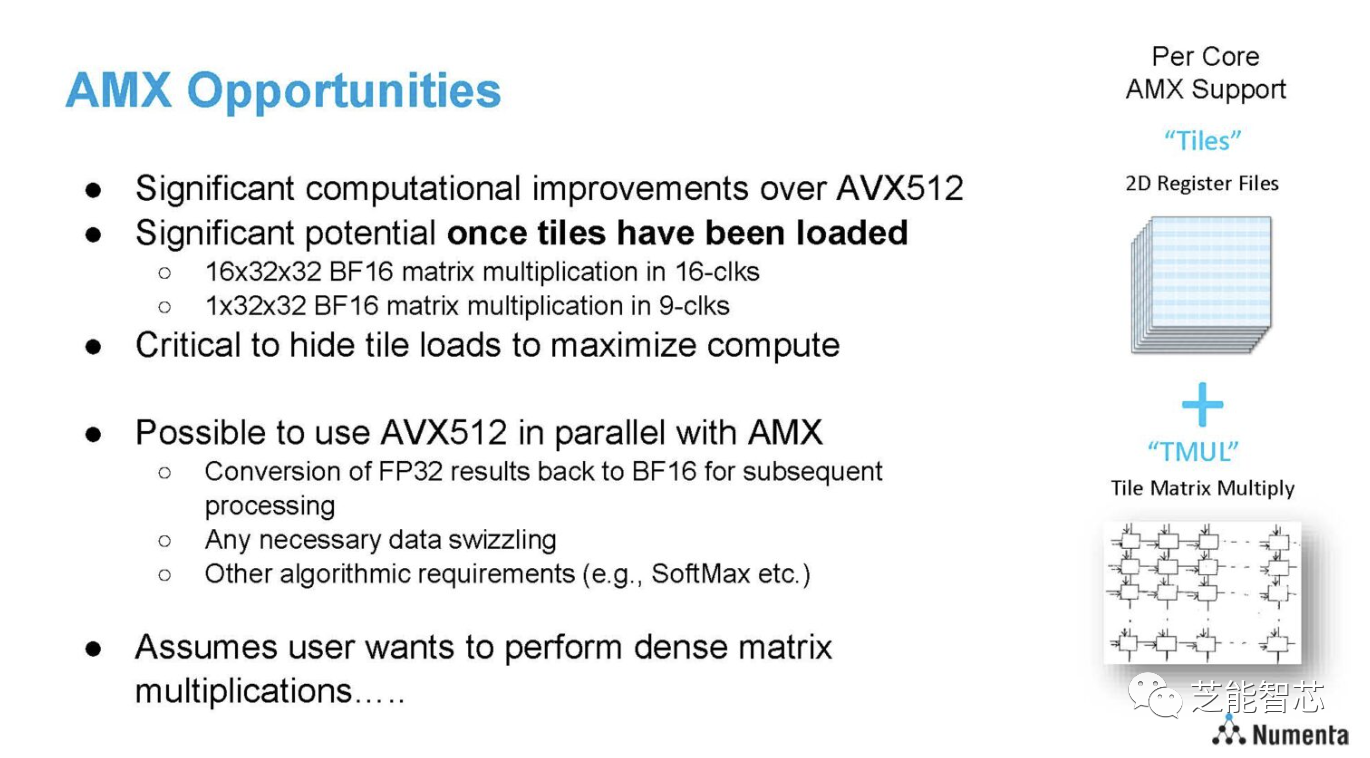

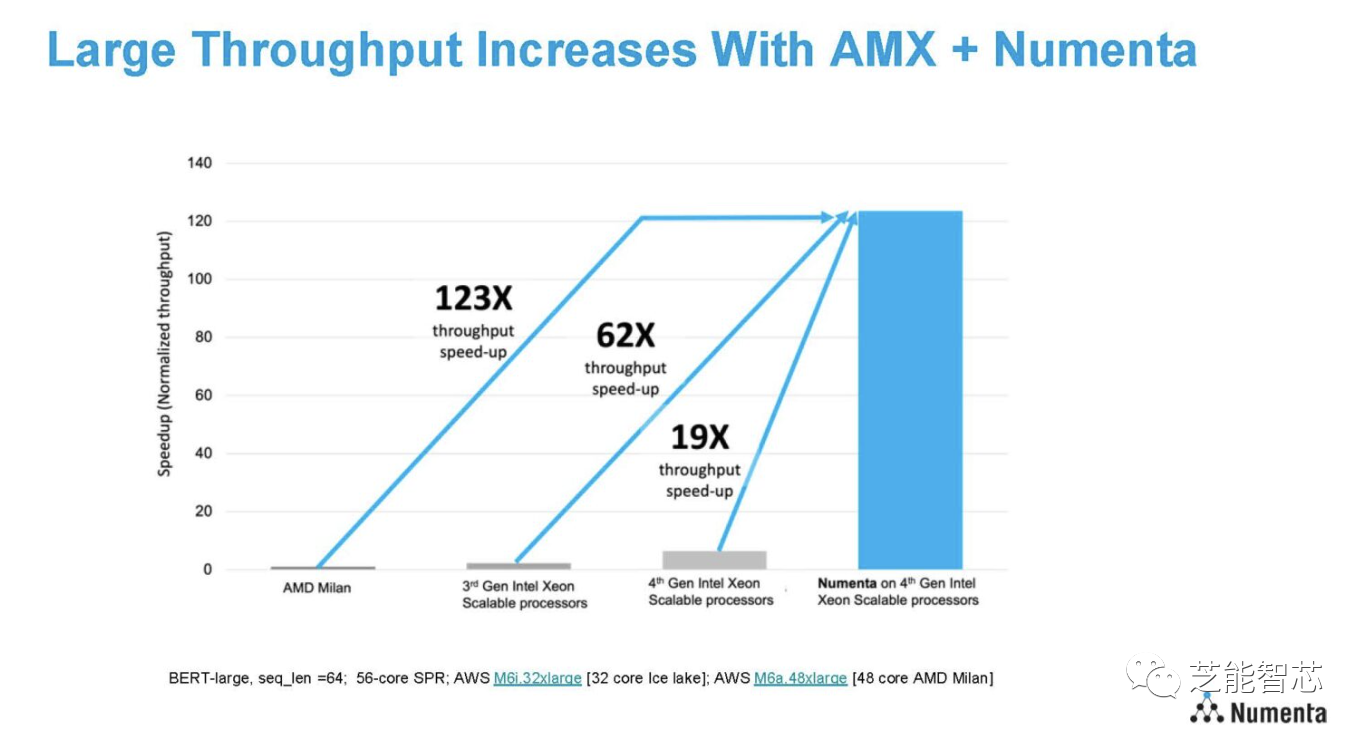

Numenta近期引起了广泛关注,声称可以有效地管理CPU上的数据,实现了惊人的性能数据。与其他人工智能推理数据不同的是,Numenta并不需要大量的资源。Numenta采用了Intel AMX和AVX-512等功能,结合管理稀疏性的软件,以加速AI推理的过程。

英特尔总结了这一解决方案,Numenta在使用其定制指令进行人工智能推理。 Numenta成立于2005年,由Jeff Hawkins和Donna Dubinsky创立,公司的目标是将更多的大脑工作方式应用于人工智能问题。提出的方法受到了神经科学的启发,尤其是大脑中稀疏计算的特性。

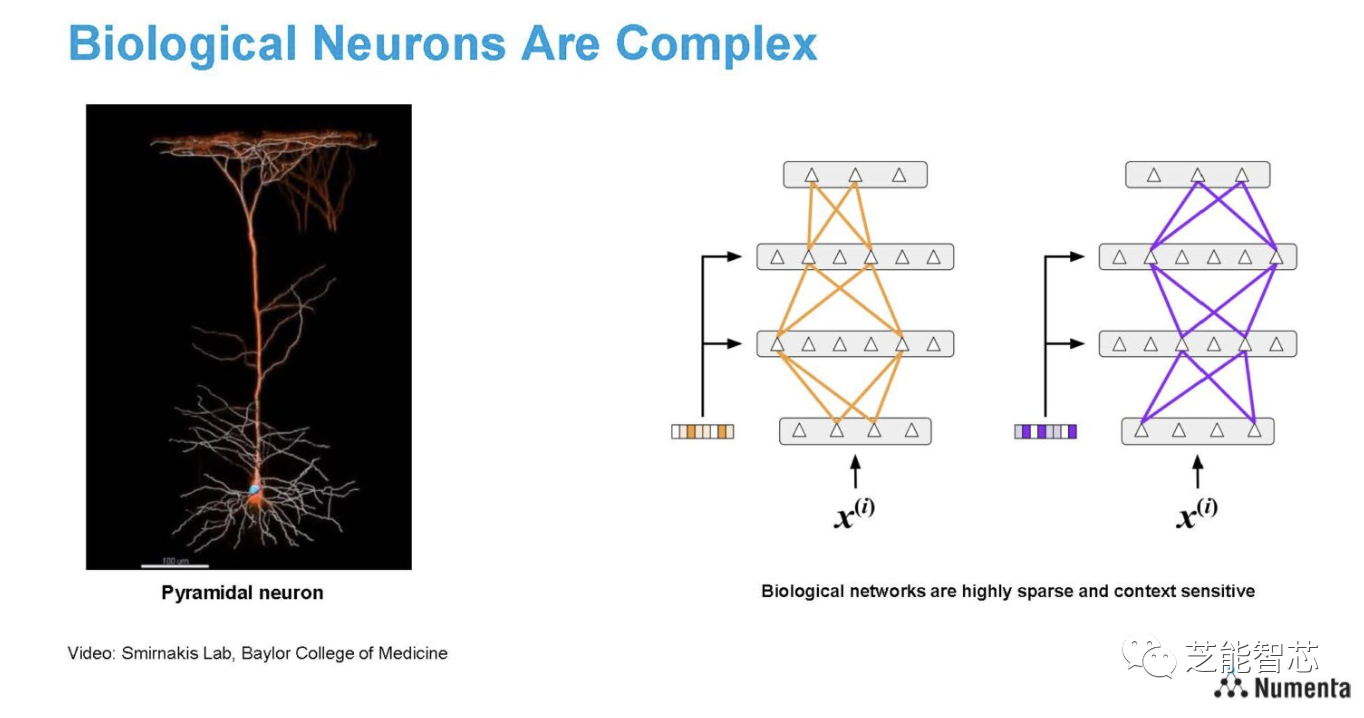

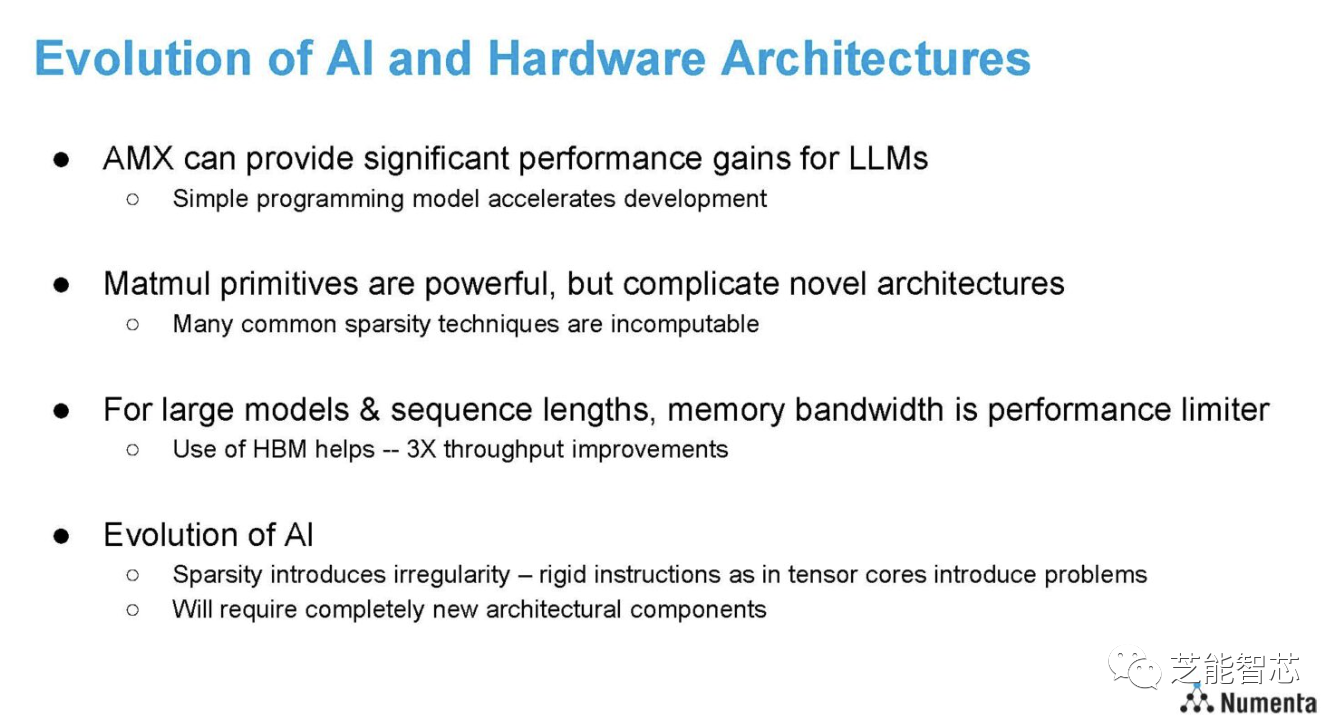

神经元的结构异常复杂,大脑的工作方式却处于极度稀疏的状态。生物大脑的学习过程是动态而稀疏的,其中神经元之间的连接是稀疏的,激活和信号传递也是稀疏的。大脑还善于利用上下文信息进行路由。当外部输入信号进入大脑时,大脑会智能地识别相关的高度稀疏的神经元部分,并根据输入信号和周围环境进行信息传递。在当前的人工智能领域,大多数组织更倾向于使用高度密集的计算方法。CPU 和 GPU 专为密集矩阵乘法计算而设计,具有相对深的管道、高时钟速度和大矢量引擎,需要暂存数据来填充这些计算资源。稀疏性旨在提供相反的、更少的计算数据。

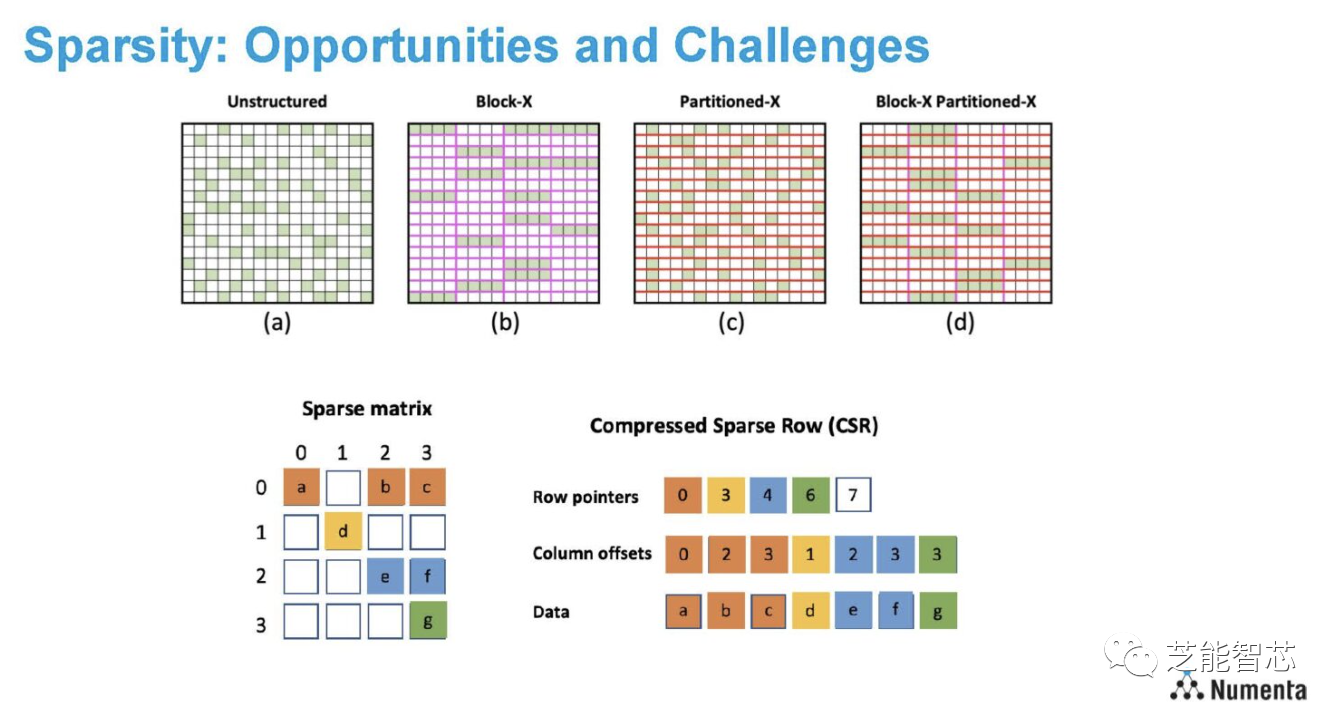

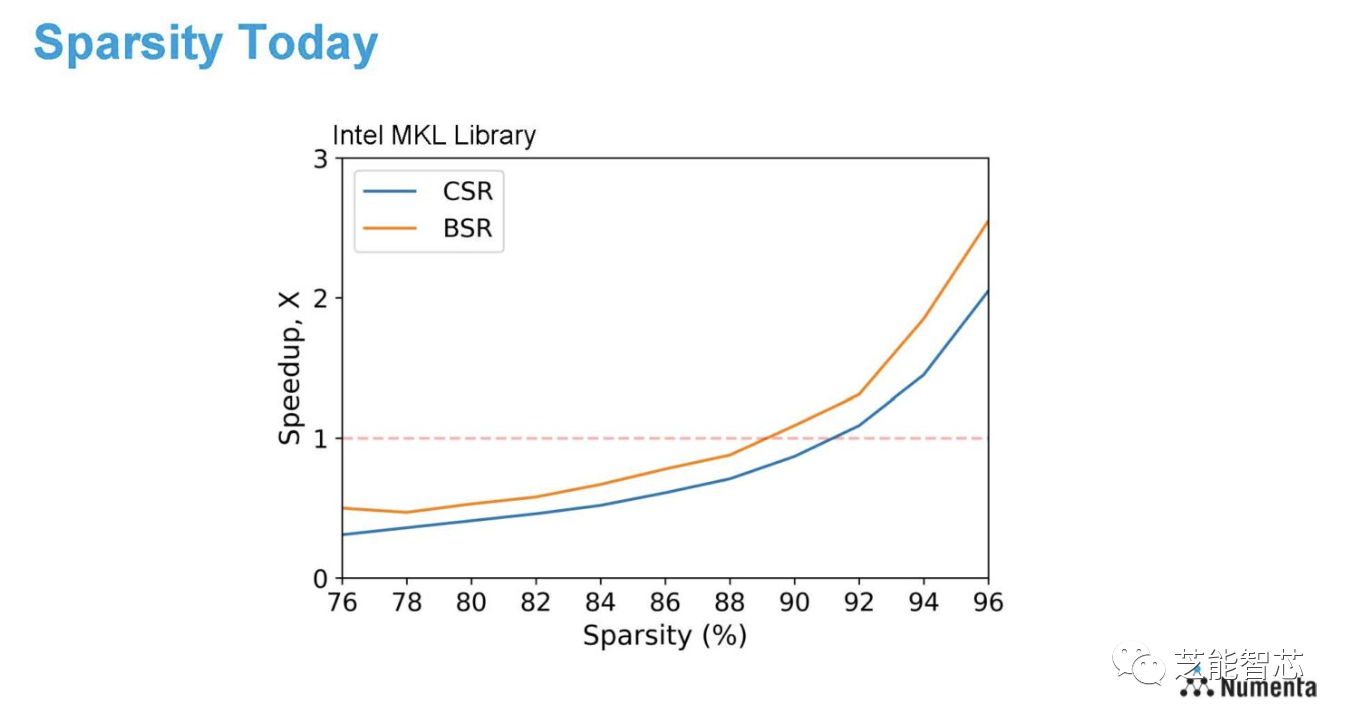

几年前,Numenta与Xilinx进行了合作,展示了在吞吐量、延迟和电源效率方面实现了两个数量级的提高,同时保持了相似的精度。正将其算法应用到新的CPU硬件中。Numenta的研究表明,可以实现超高稀疏性,去除了90%的权重,同时保持了相似的精度水平。Numenta 分享了使用 AVX-512 和 1024×1024 数据矩阵优化的英特尔数学内核库 (MKL)。这里CSR(压缩稀疏行)是非结构化稀疏性,BSR是块结构稀疏性。

将AVX-512和AMX结合使用,实现硬件几乎全速运行,避免了需要高度稀疏性才能获得加速的情况。已经在Intel Xeon MAX CPU上得到了应用,并且在内存带宽受限的大型模型上,实现了高达3倍的吞吐量改进。

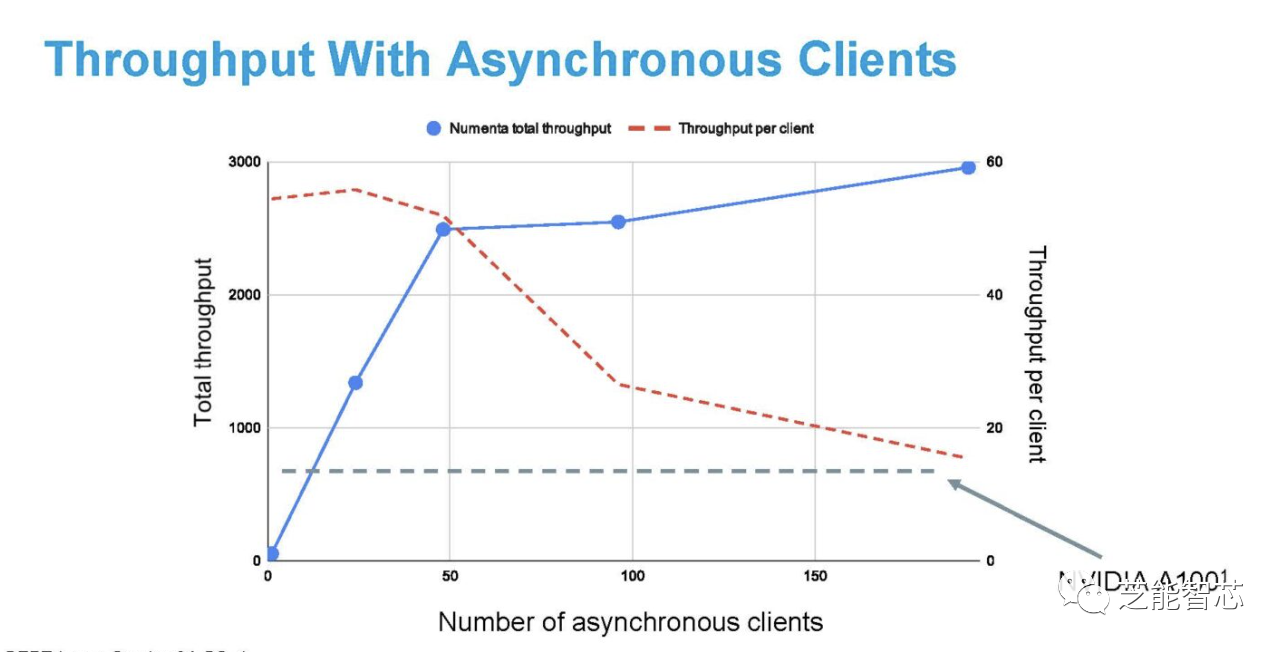

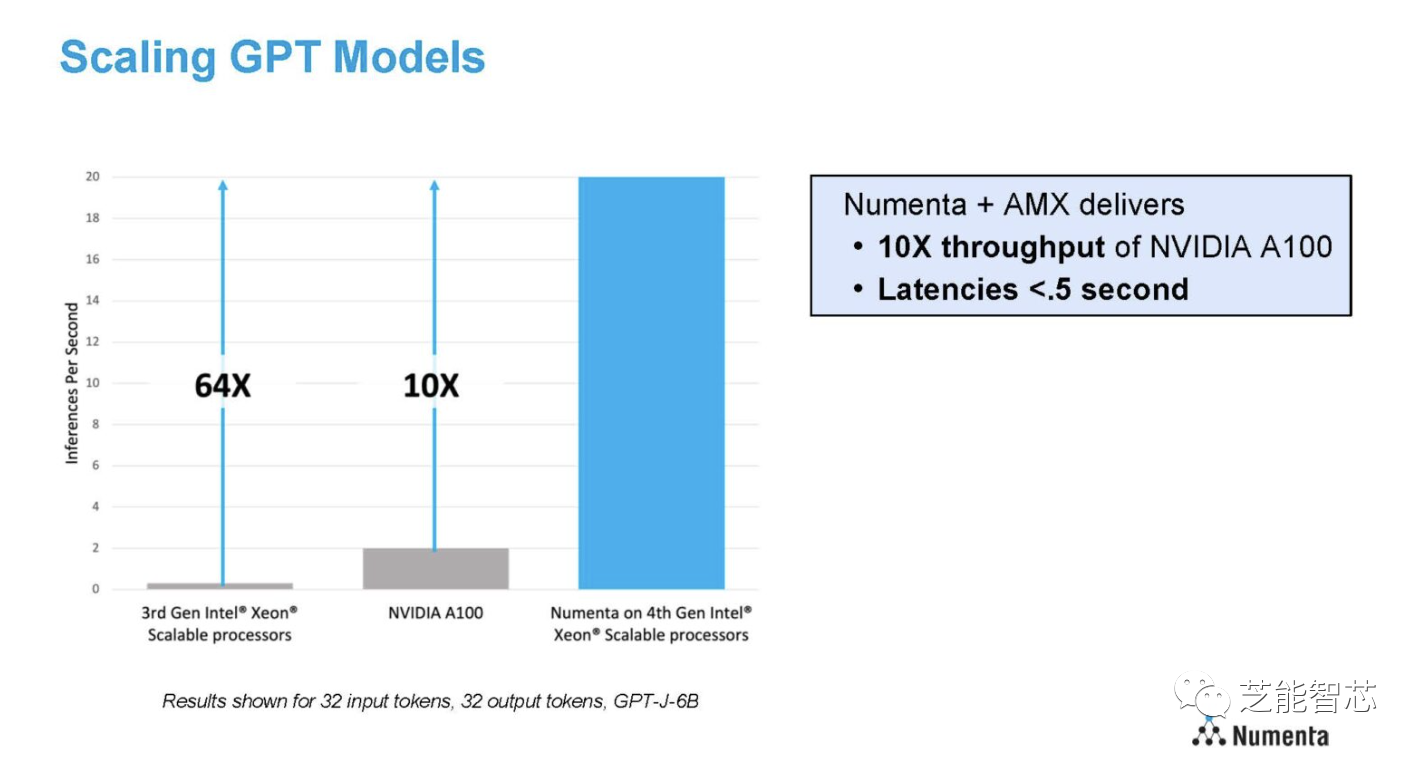

Numenta 采用了 NVIDIA 报告的 A100 性能数据的工作负载,并在 AWS 上的双插槽 48 核 Sapphire Rapids 服务器上运行。可以线性扩展至 48 个核心,客户端都运行自己的 BERT-Large 实例,因此会给缓存和内存子系统带来压力。

Numenta的方法突破了现代CPU和GPU面临的稀疏性挑战。与使用有限资源的NVIDIA GPU、尚未发布的AMD GPU、Intel Gaudi2等加速器不同,Numenta的解决方案在标准服务器上运行,这在业界引起了极大的兴奋。

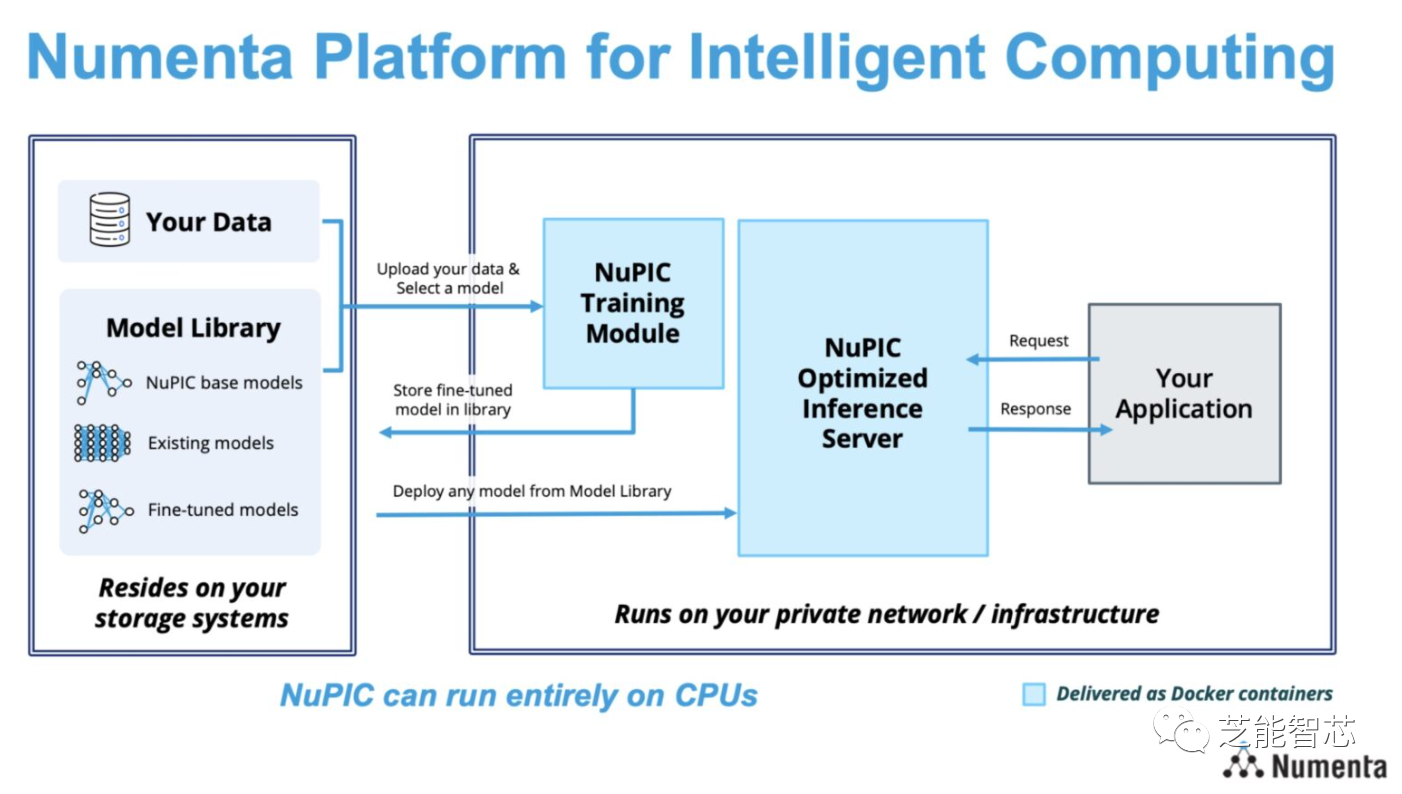

Numenta 通过可扩展且安全的 LLM 服务将该解决方案产品化,用于情感分析、摘要、问答、文档分类、内容创建和代码生成等( NuPIC 或 Numenta 智能计算平台)。人工智能领域实现准确性的同时,降低了成本,可能是一条可行的路径。