HBM3内存

芝能智芯出品

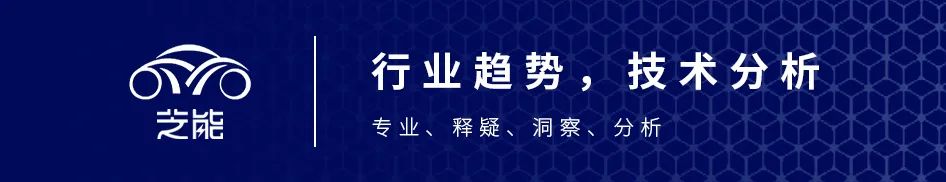

在人工智能(AI)和高性能计算(HPC)领域,英伟达一直是业内的佼佼者。为了保持其在处理器市场上的领先地位,该公司不仅预购了台积电的晶圆和封装产能,还着重确保了高带宽内存(HBM3)的供应。根据外媒报道,Nvidia已从美光和SK海力士预购了总值超过13亿美元的HBM3内存,为此支付了7000亿至1万亿韩元的预付款。

一)2024年AI继续火下去

英伟达的这一举措旨在保障其即将推出的2024年人工智能处理器产品的内存供应,包括采用HBM3E内存的H200 AI和HPC GPU,以及GH200平台,搭载Grace CPU并配备141GB HBM3E内存的H200 GPU。这两款产品在市场上将迎来高需求,因为它们需要大量内存以应对复杂的AI和HPC任务。

通常情况下,GPU制造商预购昂贵的内存产品,这在行业中并不罕见,尤其是在向规模较小的显卡制造商销售时。对于英伟达而言,其倾向于销售成品PCIe卡和SXM模块,而非仅仅是GPU芯片,因此提前购买HBM3E内存是一个合理而明智的决策。英伟达的AI和HPC GPU在未来几个季度已经实现了售罄,因此公司迫切需要确保其产品系列,如H100、H200和GH200,以及其他采用HBM3或HBM3E内存的产品,有稳定的内存供应。

当然还需要关注美光、SK海力士和三星是否有足够的产能向其他AI和HPC解决方案开发商供应HBM3和HBM3E内存。如果无法满足市场需求,英伟达将有望在2024年进一步巩固其在不断增长的人工智能硬件市场的领导地位。这对于整个AI产业生态系统来说,都是一个备受关注的战略动向。

二)H3BM的神奇之处

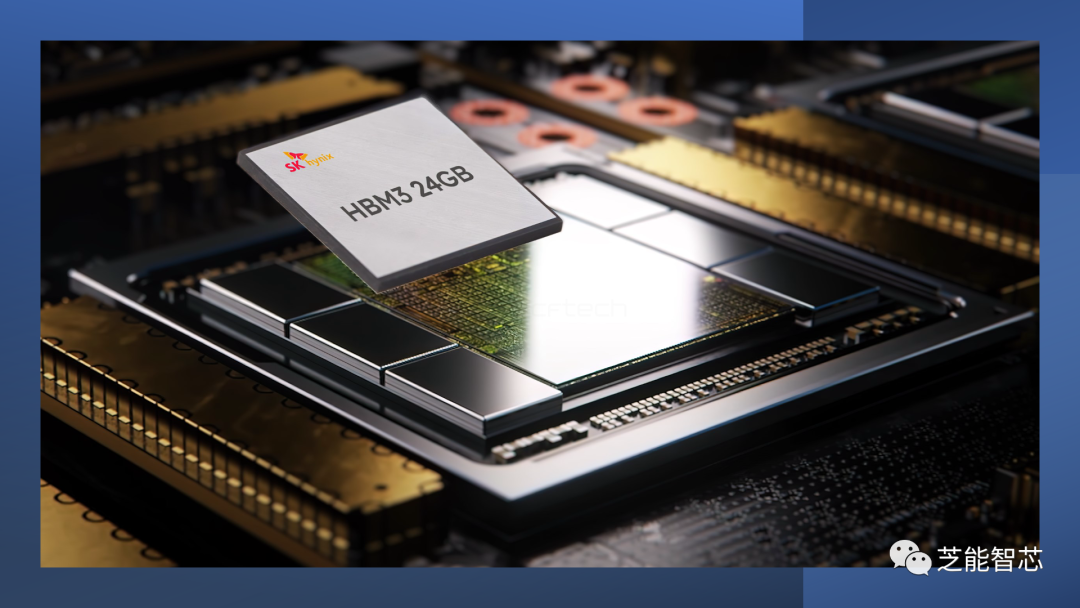

SK海力士向客户提供了24GB HBM3内存堆栈的样品,在2021年底首次公布其HBM3内存产品组合时,SK海力士就表明了推动技术创新的决心。该公司计划推出两种内存堆栈,包括8-Hi 16GB和更复杂的12-Hi 24GB内存堆栈。经过近18个月的努力,SK海力士终于向市场展示了其24GB HBM3内存堆栈的样品。

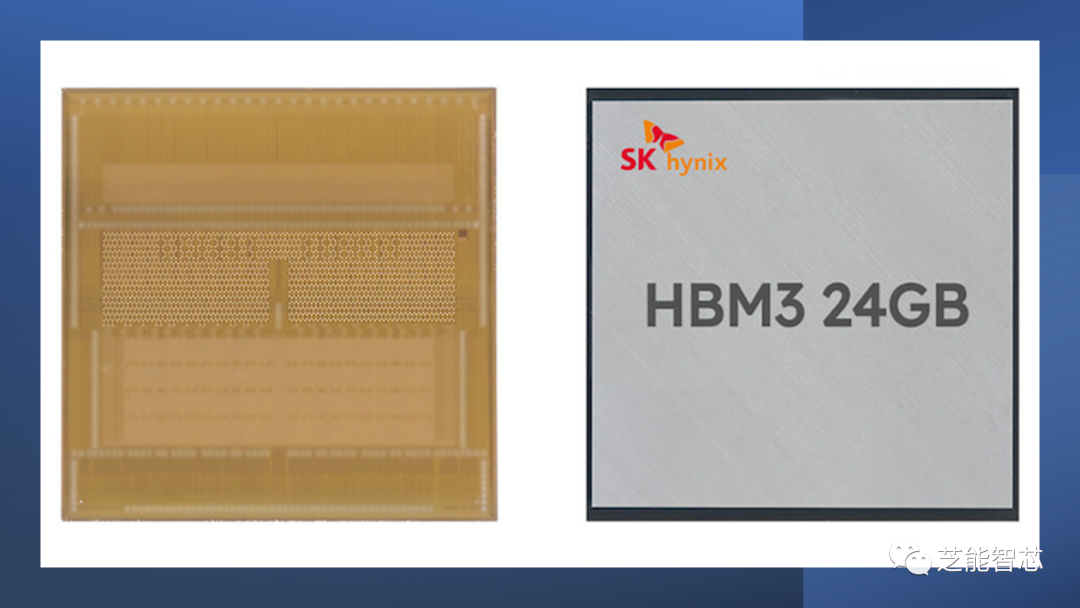

SK海力士采用了技术更为复杂的12-Hi结构,将DRAM层数从8层增加到12层,以提高整个HBM3内存模块的密度。通过这种方式,内存容量实现了50%的增加,为处理大型语言模型和其他高端计算任务提供更强大的支持。HBM DRAM封装的高度通常在700至800微米之间。为确保新的内存堆栈与现有产品设计兼容,同时尽量避免与处理器配对时产生高度差异,内存制造商必须在不降低性能或产量的前提下,通过减小每个DRAM层的厚度、减少层间空间、最小化基础层等方式,将12个内存器件封装到标准KGSD中。

SK海力士通过改进的底部填充材料,成功减薄了DRAM芯片及其之间的空间。该公司先前表示,已经将DRAM芯片的厚度减至30微米。作为其新的大规模回流模塑底部填充技术的一部分,SK海力士为12-Hi堆栈提供了改进的底流材料,即“液体环氧模塑料”或“液体EMC”。这种新材料的导热系数是之前使用的非导电薄膜(NCF)的两倍,标志着SK海力士在填充材料领域的重大进步。提高导热性能有助于更好地从埋藏在下层芯片中散热,这对于使12-Hi堆栈更加可行至关重要。24GB HBM3堆栈的性能规格与其16GB堆栈相当。在1024位接口上运行的最大数据传输速度为6.4Gbps/pin,每个堆栈提供819.2GB/s的总带宽。

创新将提供更大的内存容量和性能提升。在当前大型语言模型的时代,内存容量已成为模型训练的瓶颈因素,为GPU和其他形式的AI加速器等产品带来显著的好处,推动整个高性能计算领域的发展。