Range-View 视图表示在紧凑性和信息完整性方面具有优势,但它很少成为三维感知任务的首选。在这项工作中,作者通过一种新颖的多任务框架进一步推动了范围视图表示的发展,实现了前所未有的3D检测性能。作者提出的小型、多功能且强大的(SVM)网络采用纯卷积架构,充分释放了范围视图表示的效率和多任务潜力。为了提升检测性能,作者首先提出了一个特定于范围视图的以视角为中心的标签分配(PCLA)策略,以及一个新颖的视图自适应回归(VAR)模块,以进一步细化难以预测的边界框属性。此外,作者的框架无需额外模块,就能无缝整合激光雷达点云的语义分割和全景分割任务。在基于范围视图的方法中,作者的模型在Waymo开放数据集上取得了新的最先进检测性能。特别是,在车辆类别上,比卷积对应方法可以获得超过10 mAP的提升。作者展示的其他任务结果进一步揭示了所提出的小型但强大的框架的多任务能力。

1 Introduction

激光雷达测距传感器在安全关键型应用中(例如,自动驾驶中的目标检测和全景分割)发挥着至关重要的作用,它可以在不考虑光照条件的情况下提供精确的3D环境测量。然而,激光雷达点云本质上是非均匀的、无序的且稀疏的,这禁止了高度优化算子(如卷积)的直接应用。解决此问题的一种方法是在点云中首先建立一个邻域结构,通过昂贵的半径搜索或最近邻搜索,然后在局部邻域中应用性能卷积算子[5, 23, 27, 36]。另一种方法是通过对输入点进行量化创建规则的 Voxel 栅格[8, 35, 41, 42, 43]或 Voxel 柱[15, 16, 26, 39, 43],这不可避免地会导致信息丢失。尽管这些算法取得了巨大成功,但利用点集和 Voxel 栅格的算法通常需要繁重的计算,这给在实时自主系统中扩展它们带来了挑战。相比之下,距离图像以无损的方式将3D数据组织成结构化的2D视觉表示。因此,距离图像无疑是所有激光雷达点云数据表示中最为紧凑和高效的。

除了效率优势之外,人们常常低估了范围视图表示在多任务方面潜在的益处。与主流的网格表示相比,范围视图在分割和检测任务之间具有显著更高的连贯性。作者认为以下方面减少了这种差异: (1) 分辨率要求:当前的基于 Voxel 网格的多任务框架[34、38、44]为不同的任务预测独立的 Heatmap 。值得注意的是,分割的 Heatmap 分辨率大大高于目标检测所需的分辨率。相反,基于范围视图的检测器[11、19、30、32]通常产生的 Heatmap 分辨率与输入的范围图像相似,本质上满足了分割的分辨率要求。

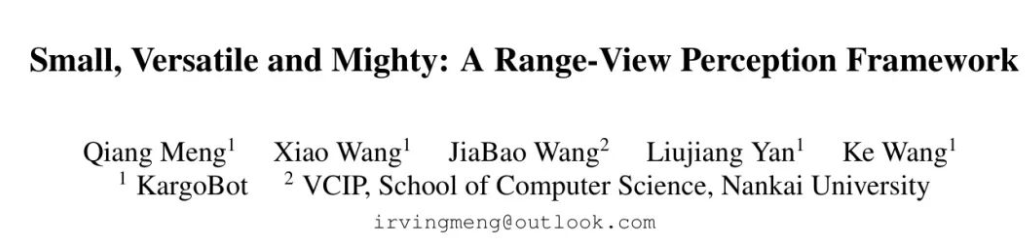

(2) 前景定义:大多数基于范围视图的检测器[11, 19, 30, 32]将边界框内的所有点视为前景。与相机图像不同,由于所有点和框的已知3D坐标,框内点定义的前景可以在点云中排除背景像素。这一特性自然导致前景点形成语义标签,如图1(a)所示。

(3) 表征密度:LiDAR点云本质上是稀疏的,量化的 Voxel 网格包含大量空单元格。对于像分割这样的密集预测任务,输入表征中的这种空虚及其相应的特征图导致感受野减小,这使得对高级语义的推理变得更加困难。

这项工作旨在通过提出一种具有简单全卷积架构的新颖多任务框架,来凸显范围视图表示的优势。先前的研究主要通过开发定制化核[4, 11],使用多个专用的检测Head[11, 32],或者运行复杂的后处理[19]来主要提升检测性能。尽管这些方法实现了性能提升,但它们牺牲了范围视图表示的效率。相比之下,作者旨在通过有洞察力的模块设计和仔细的训练策略,在简单架构上提升任务性能。对于分类,作者提出了透视中心标签分配(PCLA)模块,以预测语义类别和透视中心性,如图1(a)和(b)所示。如前所述,语义类别可以促进分割任务,而中心性将通过过滤错误预测来有益于目标检测。

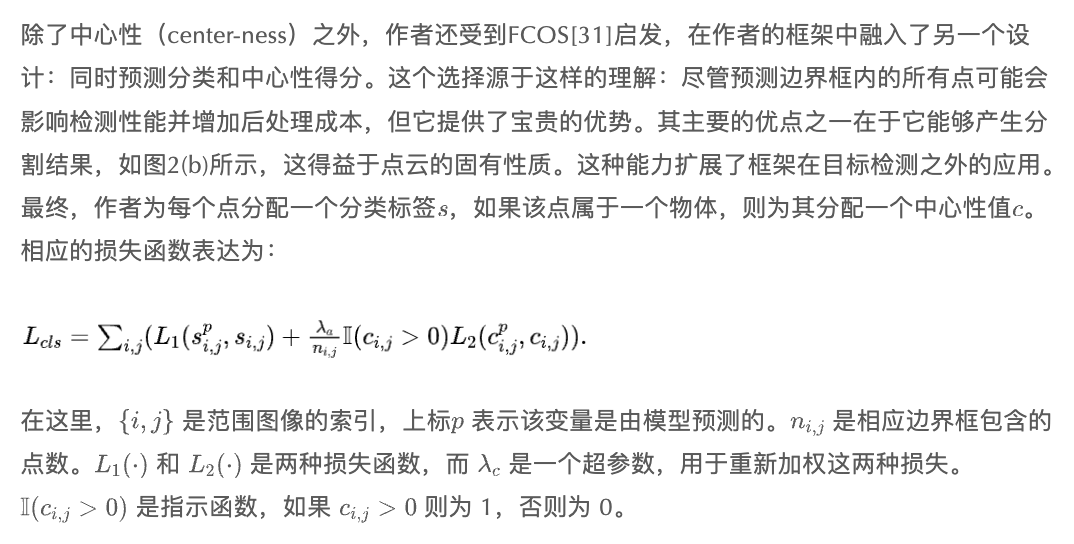

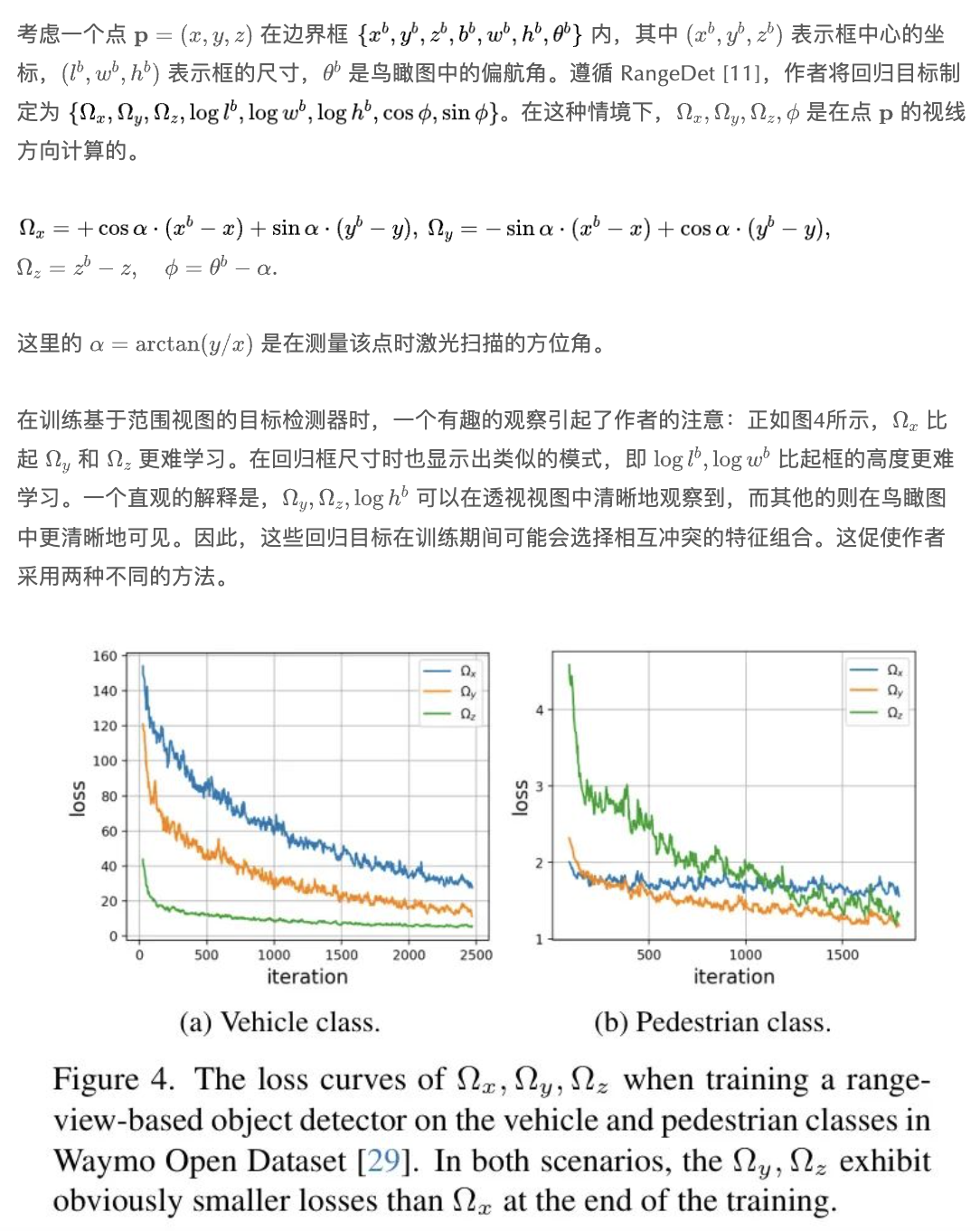

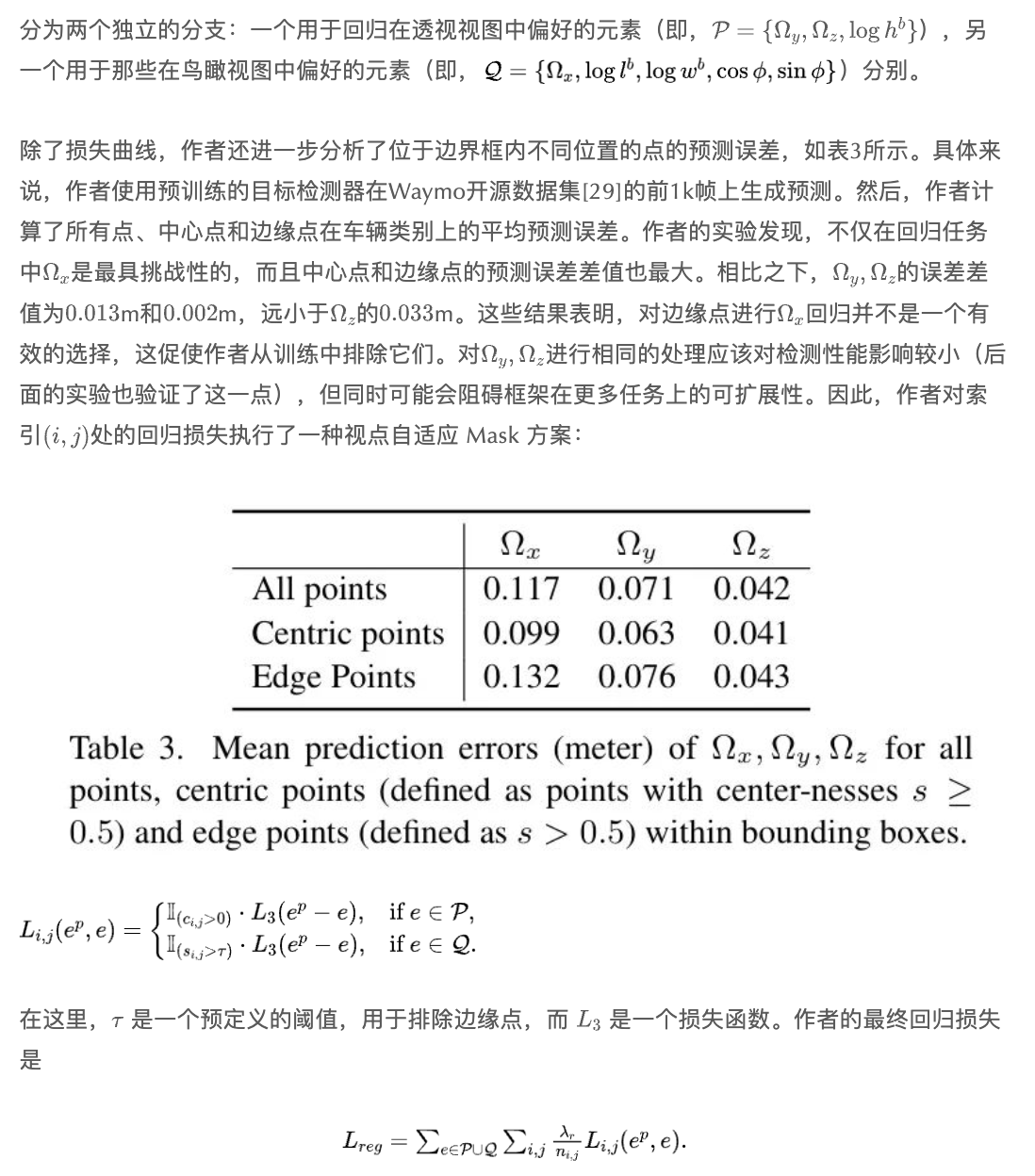

在回归方面,作者从分析图1(c)中的偏移量和图1(d)中的的学习难度开始。作者发现前两个元素显然更容易学习,这可能是因为范围图像在保留其他方向邻近关系的同时压缩了视线方向的维度。这一发现激励作者提出了一种视图自适应回归(View Adaptive Regression,VAR)方法,以区别处理范围视图中的元素。具体来说,VAR将回归元素分为两类:一类是透视视图偏好的(即偏移量和 Box 高度),另一类在鸟瞰图中清晰可见的(即偏移量, Box 长度,宽度以及鸟瞰图中定义的偏航角),并采用两个分支进行单独的回归。此外,VAR对图1(c,e)中所示的所有目标点进行的回归,这结合语义类别和中心性,有助于全景分割的执行。相反,其余元素是对透视中心点进行预测,因此通过忽略容易出错的边缘点来提高检测精度。

最终,作者的框架在基于距离视图的方法中实现了最先进的检测性能。此外,作者的框架可以无需额外的模块,无缝地应用于分割任务,这一点已通过作者的实验得到了验证。作者总结作者的贡献如下:

作者提出了一种完全卷积式、单阶段框架,该框架突出了范围视图表示的两个重要优势(即:效率和潜在的多任务能力)。无需任何花哨的修饰,该框架能够执行3D目标检测、语义分割和全景分割。

作者 Proposal 通过PCLA模块和VAR模块分别优化分类和回归过程。这些适合于距离视图的方案在检测方面带来了显著的性能提升,超过了卷积对应方案超过10个mAP。

2 Related Works

Point Cloud Representation

激光雷达传感器可以收集精确和高保真的三维结构信息,这些信息可以用多种格式表示,例如,原始点云[5, 22, 23, 24, 25, 27, 36, 37, 45], Voxel 网格[8, 9, 12, 15, 16, 26, 35, 39, 42, 43]和距离图像[3, 19]。为了从原始点中提取特征,必须通过半径搜索或最近邻搜索为每个点建立一个邻域。这种昂贵的几何邻域索引过程禁止在实时应用中使用原始点云格式。通过将点云量化为固定网格的 Voxel [42]或 Voxel 柱[15],规则网格表示允许高效处理,但代价是量化误差和信息丢失。这种表示在当前文献中已获得突出地位[8, 15, 26, 35, 39, 42],特别是在3D目标检测方面。相比之下,距离图像直接反映了激光雷达采样过程,并且提供了对点云紧凑而完整的表示。这种紧凑的特性使得距离图像的处理速度变得更快,使得这种表现形式在所有数据表示中效率最高。

Range-view-based Solutions

得益于相机图像与范围图像之间的相似数据格式,许多成熟的概念和技术可以为基于范围视图的方法提供宝贵的参考。这导致了范围视图在3D语义分割中的广泛应用,研究重点集中在网络架构[2, 7],定制 Kernel [13, 33],后处理步骤[20]等。最近,无监督学习和大型视觉模型的快速发展进一步推动了基于范围视图的语义分割[1, 14]达到最先进的表现。

尽管基于范围视图的解决方案在语义分割方面取得了显著的成就,它们在3D目标检测[3, 4, 11, 19, 30, 32]和全景分割领域仍然占据少数地位。

Multi-task Perception

为了在降低计算成本的同时提高性能,自动驾驶研究的最新进展引入了多种多任务框架[34, 38, 44]。这些方法都利用 Voxel 网格数据表示来将关键任务(即目标检测、语义分割和全景分割)统一到一个框架中。然而,这些任务需要各种 Voxel 类型和网格分辨率,这就需要如表格1所示的任务特定 Head 。此外,它们的检测 Head 专注于目标的中心区域,而分割需要预测所有点。相比之下,距离视图表示受任务差异的影响较小,因此更适合多任务。

3 Methodology

本节详细阐述了所提出的框架,介绍了为了效率和检测性能而专门设计的内容,并强调了其固有的多功能性,能够无缝地执行多项任务。

Range View Revisited

不失一般性,作者首先回顾一下单次返回机械激光雷达(LiDAR)的扫描过程。在一次扫描中,具有个波束的激光雷达传感器以等角的方式对环境进行次扫描,生成一个尺寸为的范围图像。范围图像中的每个有效像素对应一个扫描点,并提供多个物理测量值,例如距离值,强度和伸长量。此外,扫描方向产生方位角和倾斜角。激光雷达在球坐标系中进行物理测量:。三维点的笛卡尔坐标可以通过以下方式计算:

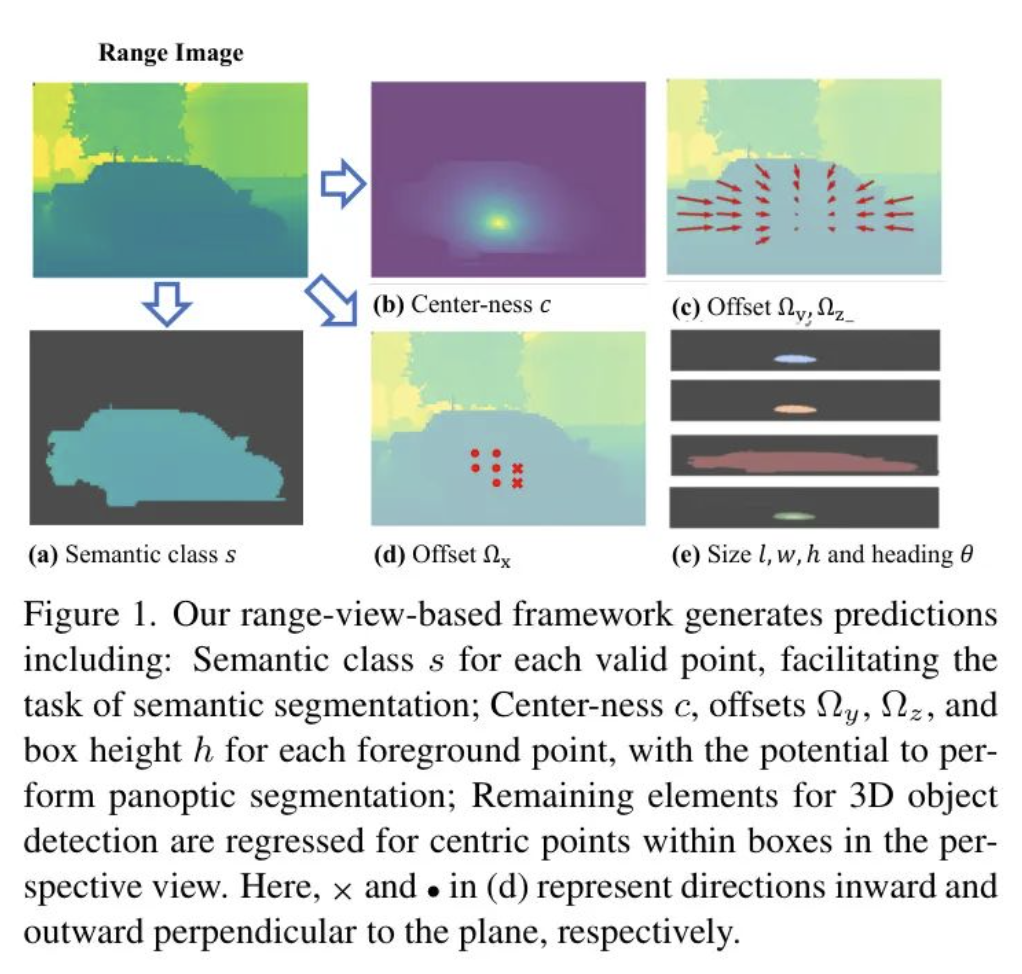

对距离图像进行感知相比于占主导地位的 Voxel 化表示具有两个公认的优势:(1) 距离视图表示的感知范围不受限制,而 Voxel 化表示忽略了预定义网格之外的测量数据。(2) 距离图像固有的紧凑性使得可以利用为2D图像设计的优化算子和成熟架构进行高效的特征提取。尽管具有这些优势,基于距离视图的检测器仍然存在性能不佳的问题。成功的尝试[4, 11, 19, 32](见表2)通过放弃距离视图计算效率来缩小这一差距。

作者质疑这种牺牲的必要性。作者提出的SVM网络仅通过一个简单的卷积架构和单一检测Head设计,就弥补了检测性能的差距,并且自然地扩展到多个感知任务。在后处理阶段,作者避免了效率低下的top-k运算符,转而使用直接的阈值过滤方案。在这些限制下,作者通过在第3.2节提出透视中心标签分配(PCLA)和在第3.3节提出视图自适应回归(VAR)来提升检测性能。第3.4节详细介绍了该框架的可扩展性,通过展示其在多个感知任务上的能力。

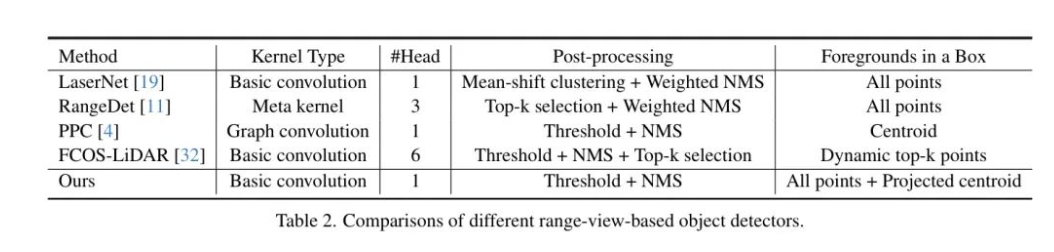

Perspective Centric Label Assignment

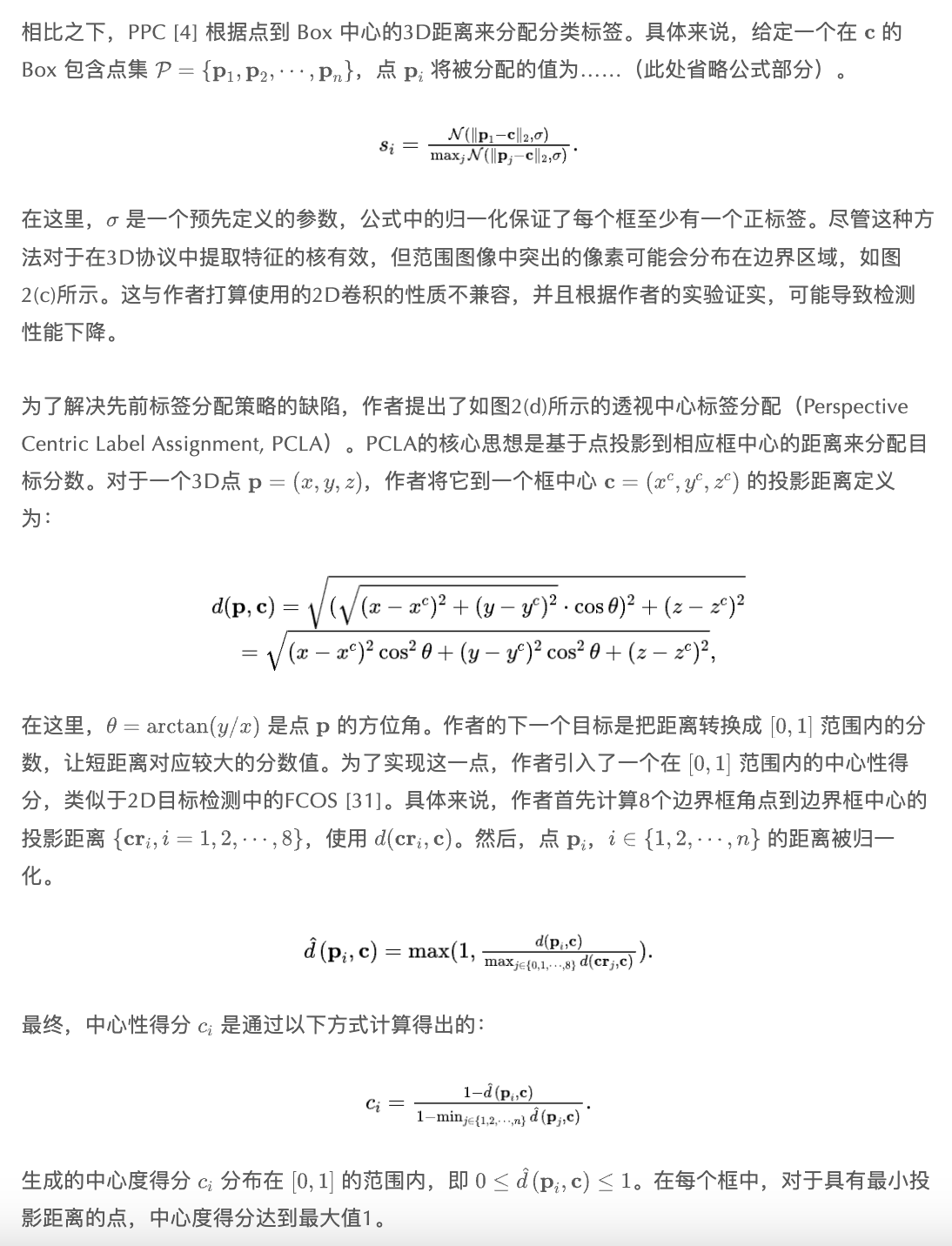

标签分配策略可以对检测性能产生重大影响[10, 31, 40]。对于基于范围视图的目标检测器[3, 11, 19],常见的做法是将三维框内的所有点视为前景,如图2(b)所示。高精度的激光雷达可以在目标上收集过多的点,尤其是对于近距离目标。例如,在广泛采用的Waymo开放数据集[29]中,每个帧平均有超过17K个点落在目标上。简单地将所有这些点视为前景无疑会在后期处理中产生高昂的计算开销。此外,边缘点上的错误预测将进一步阻碍目标检测器的性能。

View Adaptive Regression

The Whole Framework

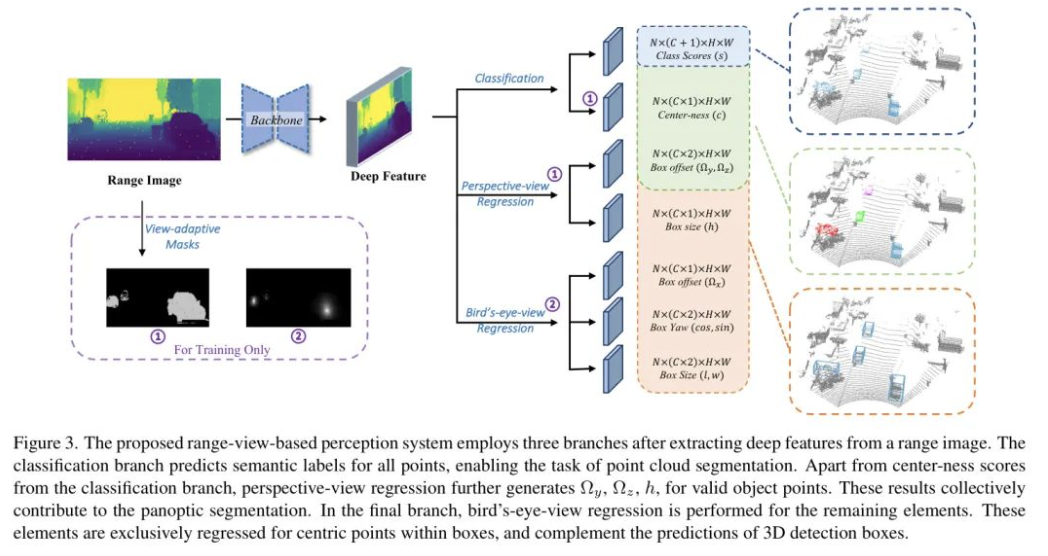

作者提出的PCLA和VAR模块对训练和推理过程做了几处修改,如图3所示:(a) 分类分支除了预测语义标签外,还预测中心性得分。(b) 框目标根据其属性被分为两个不重叠的分支。

可观察性。(c)在训练过程中,模型通过自适应 Mask 控制学习不同位置上的元素。作者的设计在不引入任何资源密集型模块或繁重的后处理的情况下提高了检测性能,确保了框架的有效性。整个系统的训练损失为 ,其中 和 分别在方程(2)和(4)中定义。接下来,作者将介绍框架如何能够执行多项任务。

目标检测。在推理过程中,作者根据语义和中心性预测,分别使用预定义的阈值来过滤掉背景点和边缘点。随后从保留的点中解码边界框,并通过非极大值抑制(NMS)去重。这个流程不仅确保了鲁棒的目标检测性能,而且简化了后处理阶段。例如,在Waymo开放数据集[29]中,一个范围图像平均含有约150K个有效点,其中大约17K是目标点。作者的方法将解码所需的平均点数大幅减少到仅3K,极大地减轻了后处理阶段的计算负担。

分割。预测的分类标签自然可以用于语义分割。值得注意的是,分割任务的类别数量通常大于检测任务的类别数量。仅增加分类 Heatmap 的维度可以解决这个问题,而不会影响其他任务。

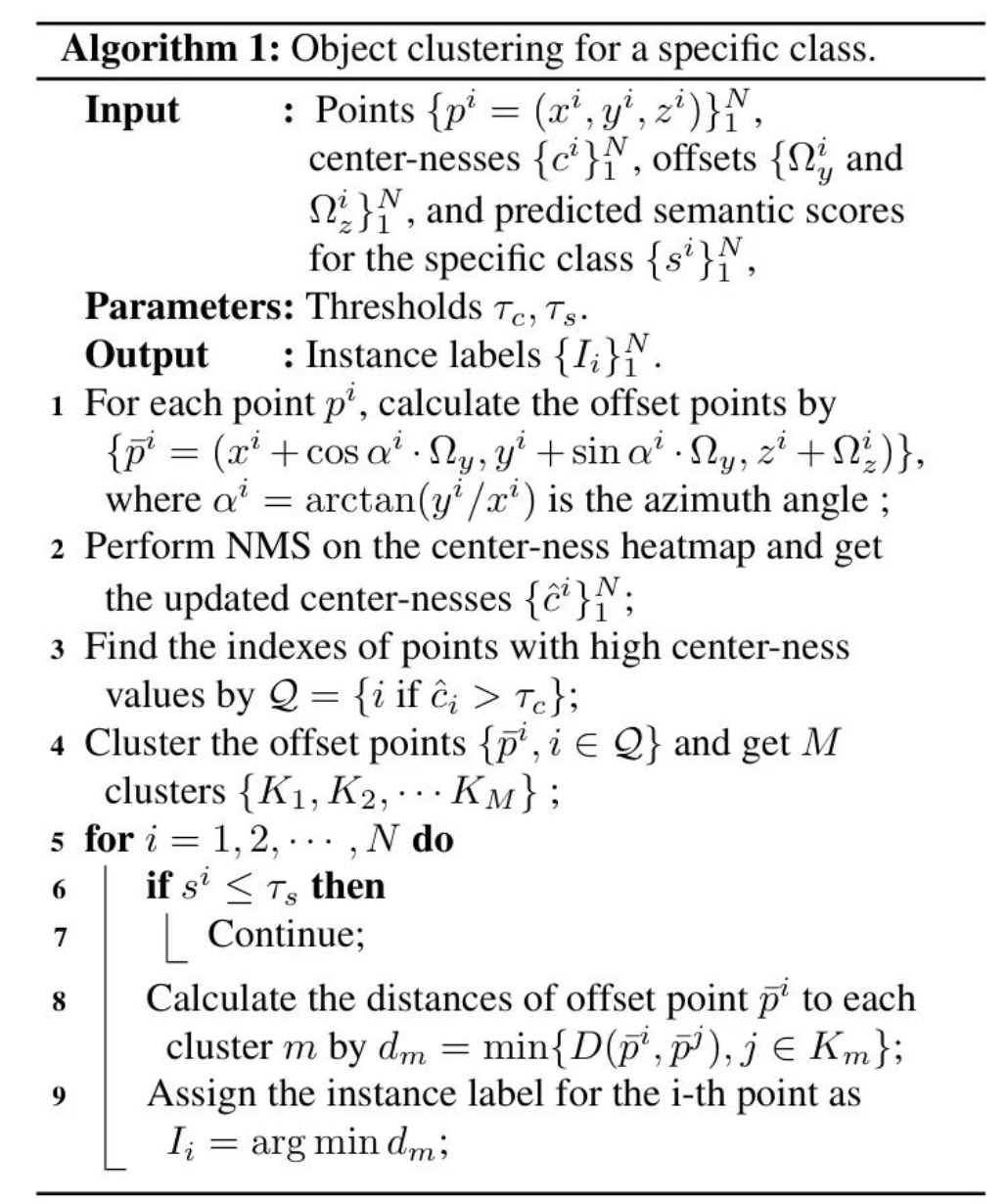

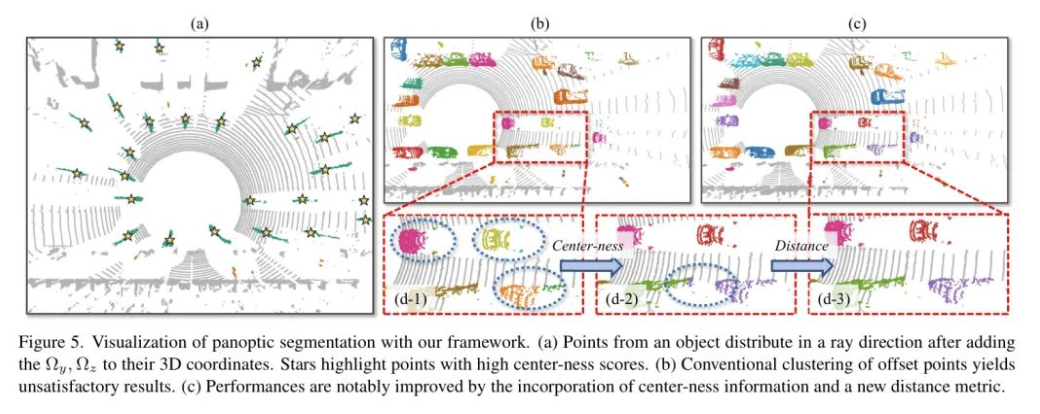

全景分割。作者的全景分割利用了分类得分 ,中心性得分 ,以及所有物体点的投影偏移量 。由于独特的数据分布,直接聚类在范围视图模态中无法得到满意的结果。因此,作者精心设计了一个聚类方案,包括在中心分组后的合并,如算法1所示。此外,由于缺少 ,在添加偏移量后物体点沿射线方向分布,使得3D距离不适合作为距离度量。因此,作者提出了一种新的距离度量,专为范围视图模态定制,其实质上更关注与视点垂直的距离。更多细节可以在作者的补充材料中找到。

算法1 针对特定类别的目标聚类。

4 Experiments

在本节中,作者首先在第4.1节详细描述实验设置。第4.2节展示了3D目标检测的主要结果,而第4.3节则分别进行了消融研究。最后,作者在第4.4节展示了一些分割结果。

Experimental Setup

数据集和评价指标。 作者的实验是在大规模的Waymo开源数据集[29](WOD)上进行的,这是唯一提供原始距离图像的数据集。该数据集包含798个用于训练的序列,202个用于验证,以及150个用于测试。表4中的实验使用了整个训练数据集,而其他实验则使用了25%的均匀采样帧。在所有实验中,作者报告了在WOD验证集上的3D LEVEL 1平均精度。

训练细节。作者的主干网络是由PPC [4]手工搜索的轻量级卷积网络。对于 Head ,每个分支由四个层,每层64个通道以及一个最终的预测层组成,类似于FCOS [31]。遵循PPC [4],作者的训练使用128的批量大小,进行300轮迭代,采用AdamW优化器。采用初始学习率为0.01的一周期学习率策略。作者为方程式(2)中的采用Focal Loss[18],以及平衡_L1损失[17]用于方程式(2)中的和方程式(3)中的。数据增强包括随机全局翻转和 GT 值 Copy-Paste 。

其他配置。 除非另有说明,方程式(2)中的超参数 设置为0.5。方程式(2)和(4)中的权重 分别为 0.1 和 1。来自 PPC [4] 的主干网络生成的 Heatmap 具有 下采样比率。为了与其他基于范围视图的检测器 [11, 19, 30, 32] 保持一致,作者进一步添加了一个块以将 Heatmap 上采样至输入分辨率的 。在作者结果中,修改过主干网络的模型用 标记。

Main Results

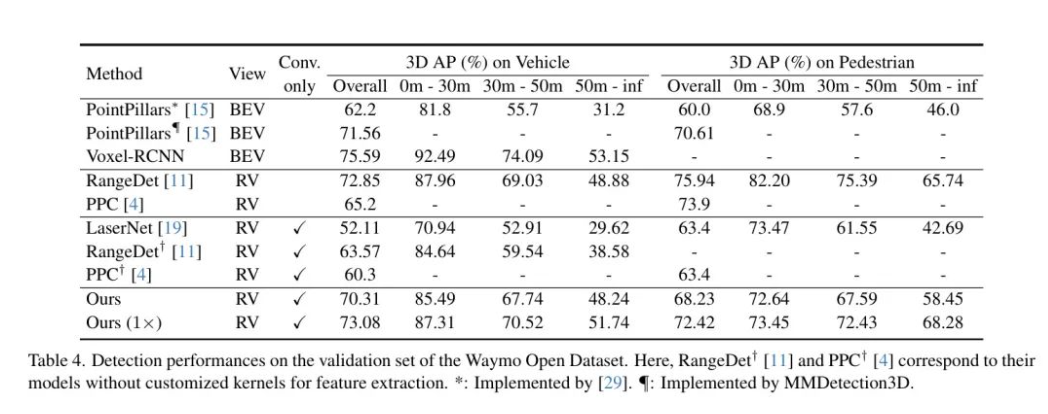

表4展示了不同基于LiDAR的目标检测器的性能。值得注意的是,RangeDet [11] 和 PPC [4] 都引入了定制层,这会导致计算成本高昂且难以部署。相比之下,作者的方法仅使用普通的卷积就能取得优越的结果。在所有基于范围视图的车辆检测器中,作者的方法最终取得了最佳的mAP,为73.08。

一个有趣的观察是,作者的改进主要发生在远距离物体上。例如,在0米至30米的范围内,作者模型的平均精度(mAP,)为87.31,略低于RangeDet的87.96 mAP。然而,对于距离超过50米的物体,mAP为51.74,这明显比RangeDet的48.8要高。这种现象在行人类别中是一致的。在0米至30米的范围内,mAP分别为73.45 对比 82.20,而在50米至无穷远范围内则为68.28 对比 65.74。这可能是因为RangeDet从具有top-k分类得分的点解码框,而这些点大部分来自近处物体,因为它们通常比远物体得分要高。相比之下,作者的方法通过忽略边缘点减轻了这种不平衡,从而过滤掉噪声预测,并使更多来自远物体的点参与其中。

在表4中,作者还展示了不使用自定义层进行特征聚合的基于距离视图的目标检测器的性能(即表中的LaserNet、RangeDet和PPC)。当使用相同的 Backbone 网络时,PPC在车辆类别上达到60.3 mAP,在行人类别上达到63.4 mAP,而作者的模型分别达到70.31和68.23 mAP。改进分别是+10.01和+4.87。通过上采样 Heatmap 更新 Backbone 网络后,最终的mAP达到73.08和72.42,最终改进分别是+12.92和+9.02。作者的性能还在车辆类别上超过了RangeDet,提高了+9.51 mAP,后者模型使用三个头预测不同距离范围内的物体,而作者的模型仅使用一个头。这些结果证明了作者方法的有效性。

Ablation Studies

这部分展示了对所提出的PCLA和VAR的消融研究。这里所有的实验都是在WOD训练集的25%均匀采样帧上进行的。为了快速实验,训练周期进一步减少到36。

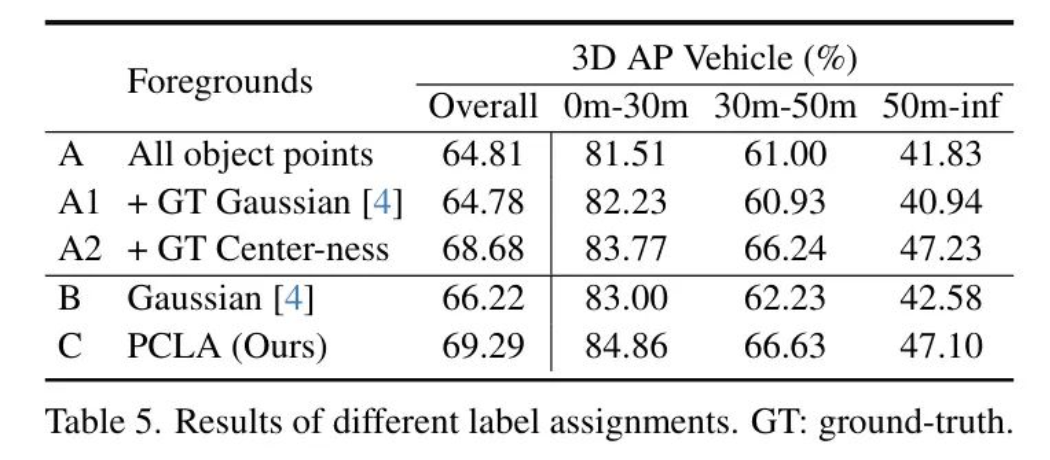

标签分配的影响。 作者首先训练一个不包含中心性预测的模型,这个模型本质上将所有目标点视为前景。除了直接对模型(A)进行基准测试外,作者还移除了具有低 GT 高斯值(A1)和低 GT 中心性值(A2)的点的预测。如表5所示,(A1)与(A)相比,整体性能略有下降,而(A2)在mAP上取得了显著的提升,从64.81提高到了68.68。这表明中心性可以帮助过滤掉噪声检测,因此适合于范围视图模态。

最终,作者以端到端的方式训练预测高斯得分(B)和中心性值(C)的检测器。模型(C)在mAP上比(A)高出4.48,比(B)高出3.07,验证了所提出PCLA的有效性。

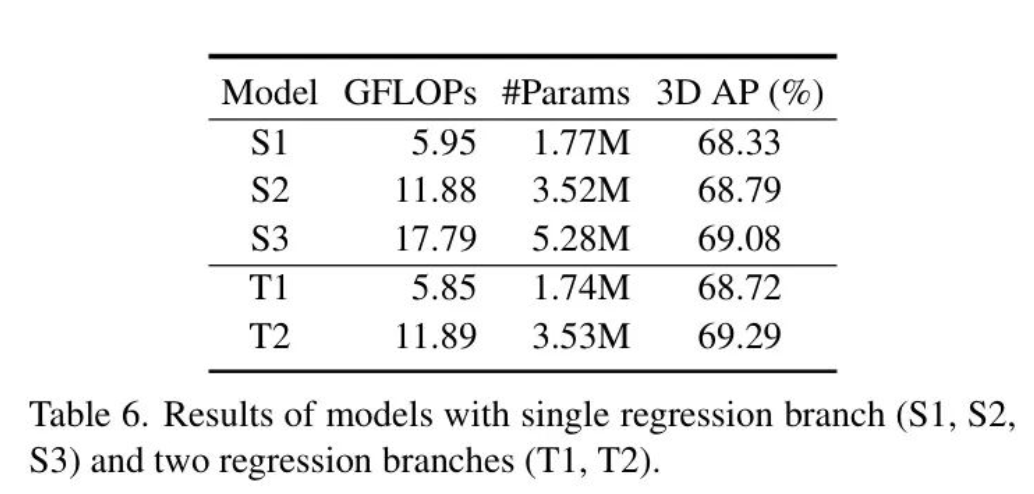

分离回归的影响。 VAR的第一部分是在两个不同的分支中分配回归元素。为了揭示其有效性,作者构建了带有单一回归的模型。

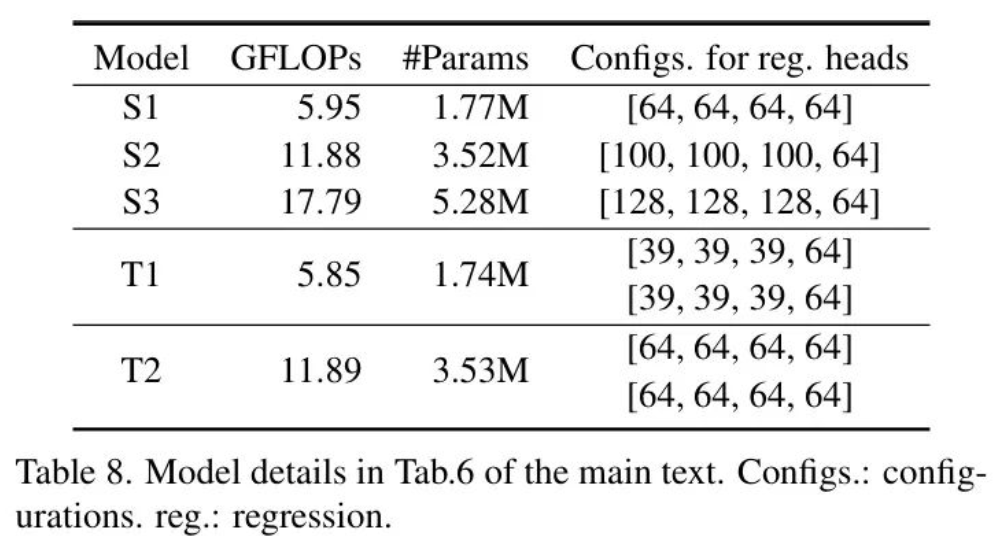

作者探讨了在不同结构下(具体细节见补充材料)的一个分割分支和两个回归分支,并在表6中报告了模型的性能、GFLOPs以及参数数量。在相似的GFLOPs和参数数量下,具有两个分支的模型明显优于单一分支的模型。具体来说,模型(T1)的mAP比(S1)高出0.39,而(T2)相比于其对应模型(S2)的改进为0.50。此外,(S3)具有最重的结构,其GFLOPs比(T2)高出近50%。然而,它的AP仍然低于T2。所有这些结果都证明了根据两个视角中元素的可视性分别进行回归的合理性。

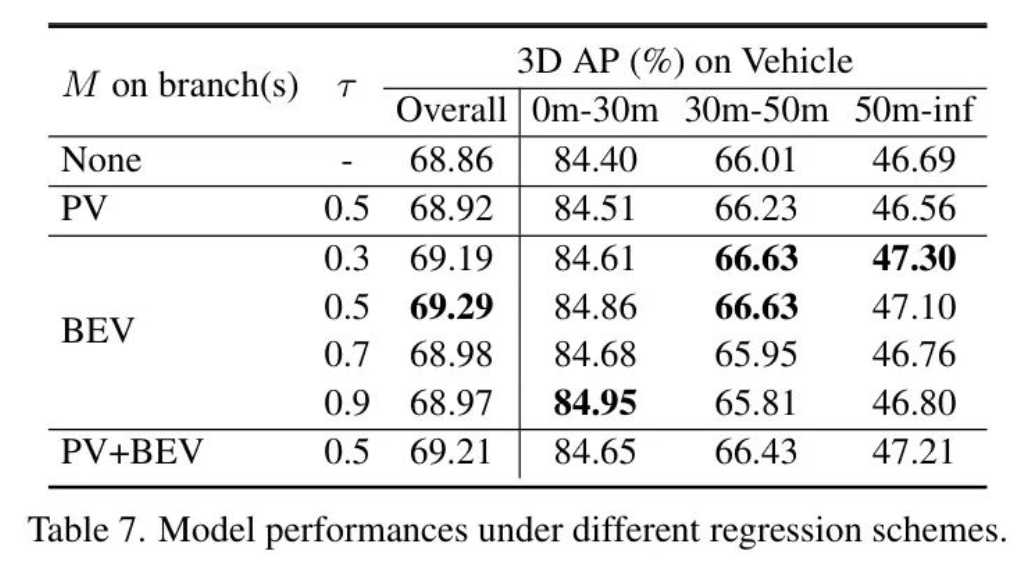

视图自适应 Mask 的效果。作者的视图自适应 Mask 方案让所有的物体点回归 ,而让其他元素仅在 Box 内的中心点回归。将中心点的 Mask 表示为 ,作者在表7中报告了将 应用于不同分支时模型的性能。没有 的情况下,类别为车辆的总体mAP为68.86。在用于透视图元素的分支中应用 ,其mAP与 Baseline 相似。相反,在用于鸟瞰图元素的分支中应用 ,当不同的阈值 时,性能一致得到提升。当 时,获得最佳结果。当两个分支都使用 时,mAP没有显示出大的差异。这些结果表明,为所有物体点回归 并不影响性能,但为框架提供了进行多任务的潜力。然而,剩余的元素应该只为中心点回归以提升检测性能。

Segmentation Results

在正文部分,作者展示了一种可视化方法,以展示作者在多项任务上的能力(更多的定量结果在附录中)。在图5(a)中,在将加到它们的坐标后,物体点在射线方向上分布。如图5(b)所示,传统的聚类方法无法取得满意的结果。这种失败的首要原因是边缘点可能导致不准确的簇,从而对于一个单一物体产生多个簇(图5(d-1))。为了解决这个问题,作者首先对中心点进行聚类,然后将剩余的前景分配给这些簇。此外,作者发现一些物体点仍然错误地分配给附近的物体,如图5(d-2)所示。这是因为三维距离度量与偏移点的独特分布不匹配。这促使作者设计一个更适合的距离度量,该度量更多地关注与方位角正交的距离。最终,作者取得了满意的结果,如图5(c)所示。

5 Conclusions

在这项工作中,作者确定范围视图表示的主要优势源于其效率和多任务应用的可能性。为了强调这些优点,作者引入了一个具有高级检测性能的高效多任务处理框架。配备了所提出的透视中心标签分配和视图自适应回归,作者的模型在基于范围视图的方法中达到了最先进的检测性能。分割的几项成果进一步揭示了作者方法在多任务方面的能力。这些结果验证了作者的小型、多功能且强大方法的功效。

全景分割的细节

Panoptic segmentation is a computer vision task that aims to simultaneously segment all objects in a scene into semantic labels and instance IDs. The goal of panoptic segmentation is to perform both semantic segmentation and instance segmentation at the same time. Formally, the task is defined as follows:

全景分割是计算机视觉任务,旨在同时将场景中的所有目标分割为语义标签和实例ID。全景分割的目标是同时执行语义分割和实例分割。正式地,该任务定义如下:

Given an image ( I ), the goal of panoptic segmentation is to output a panoptic segmentation ( S ), where each pixel ( p ) in ( I ) is assigned a label ( l(p) ) from a predefined set of labels ( L ). The label ( l(p) ) consists of a semantic category ( c(p) ) and an instance ID ( i(p) ). If the pixel ( p ) belongs to a thing class, ( i(p) ) is a unique identifier of the instance it belongs to; if the pixel ( p ) belongs to a stuff class, ( i(p) ) is set to ( text{NULL} ).

给定一幅图像 ( I ),全景分割的目标是输出一个全景分割 ( S ),其中 ( I ) 中的每个像素 ( p ) 被分配一个来自预定义标签集合 ( L ) 的标签 ( l(p) )。标签 ( l(p) ) 包括一个语义类别 ( c(p) ) 和一个实例ID ( i(p) )。如果像素 ( p ) 属于一个物体类别,( i(p) ) 是它所属实例的唯一标识符;如果像素 ( p ) 属于一个物质类别,( i(p) ) 被设置为 ( text{NULL} )。

本节展示了使用作者的框架进行全景分割的一些细节。

The Customized Distance

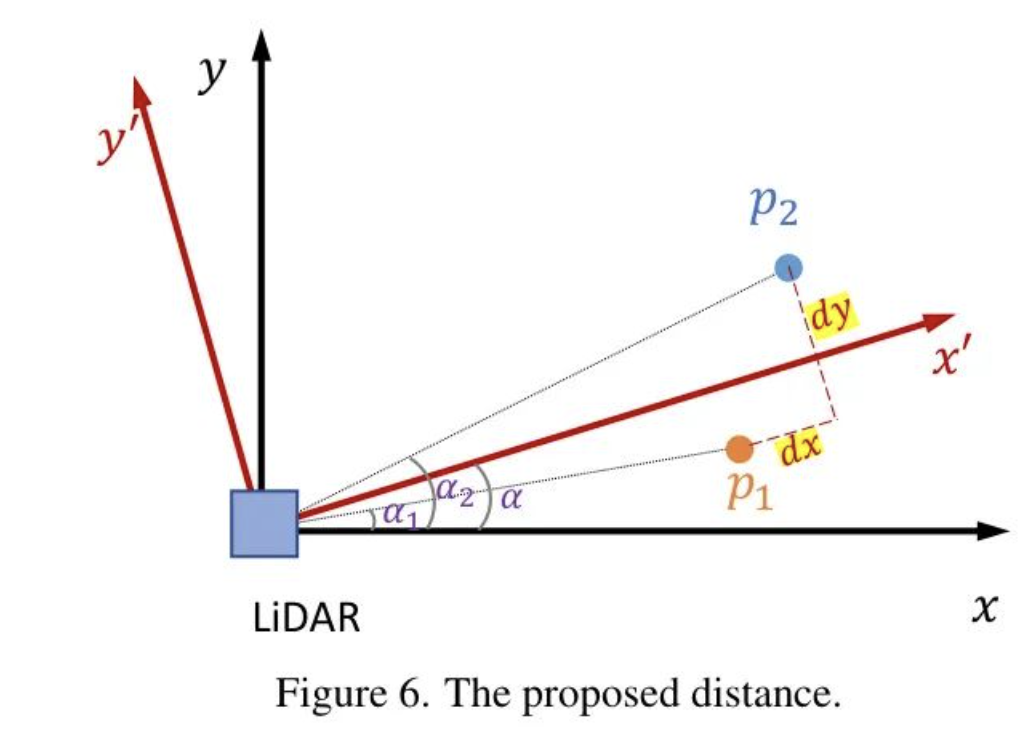

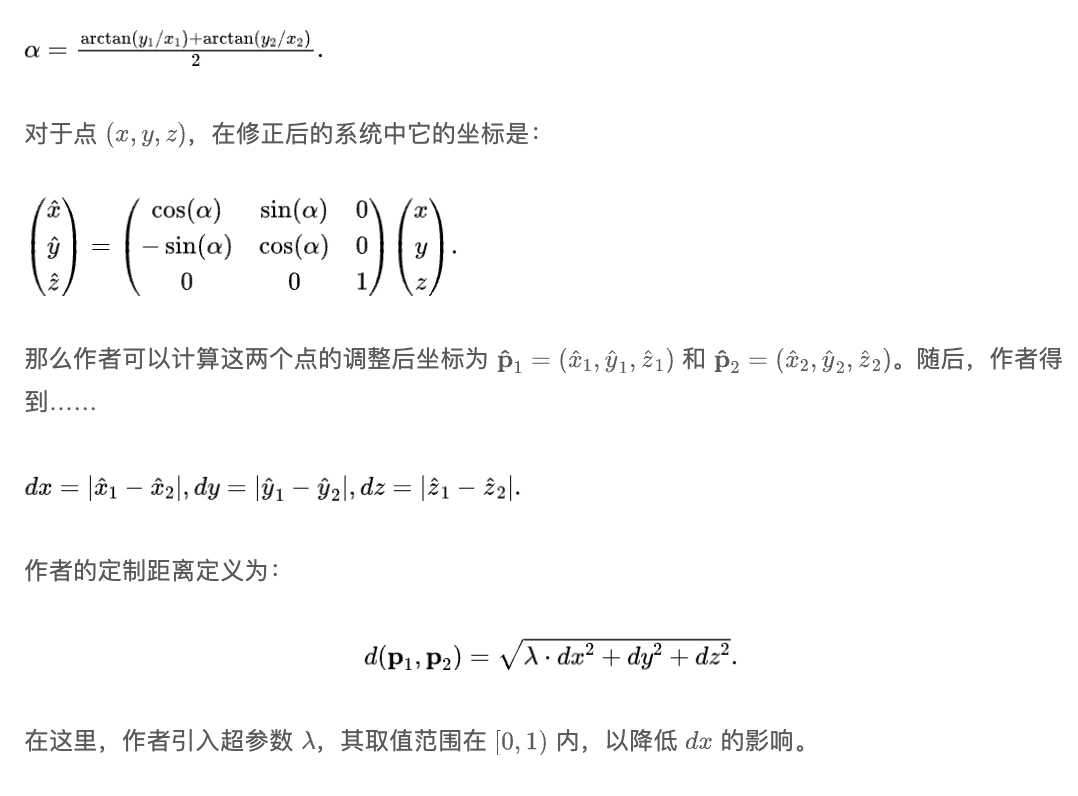

在作者的工作中,作者设计了一种新的距离度量标准,专门适用于点沿着射线方向分布的场景。本质上,作者的距离在视点方向上降低了权重。考虑两个点 和 。作者不是使用原始坐标,而是为 轴和 轴引入新的坐标。具体来说,鉴于这些点有不同的方位角,作者将新 轴的方向定义为它们方位角的平均值,如图6所示。因此,新定义的 轴的角度是

Extension to General Datasets

在正文部分,作者的目标中心及其相关的偏移量依赖于边界框的标注。然而,在某些典型场景中,某些目标类别可能缺少边界框标注。相反,可以用目标类别和目标身份来标注一个点。在这种情况下,作者可以直接将目标内的点的平均坐标视为其目标中心。随后,可以通过评估点相对于目标中心的位置来计算偏移量。

对于训练,作者只需要扩展分类 Heatmap 的维度以预测更多目标类别。中心性和偏移回归将在对应的点上做出预测。除了这些调整之外,框架保持不变。这证明了作者框架的通用性和可扩展性。

Appendix B Experiments on Object Detection

在本节中,作者展示了关于目标检测的几个额外实验。

模型S1-3和T1-2的详细信息。在正文中的表6中,作者展示了不同模型的表现。这些模型在主干网络和分类 Head 方面具有相同的结构。此外,所有模型的回归输入和输出通道均为64。模型S1、S2和S3包含一个回归分支,而T1和T2则结合了两个分支。每个分支中四个卷积层的输出通道可以在表8中找到。

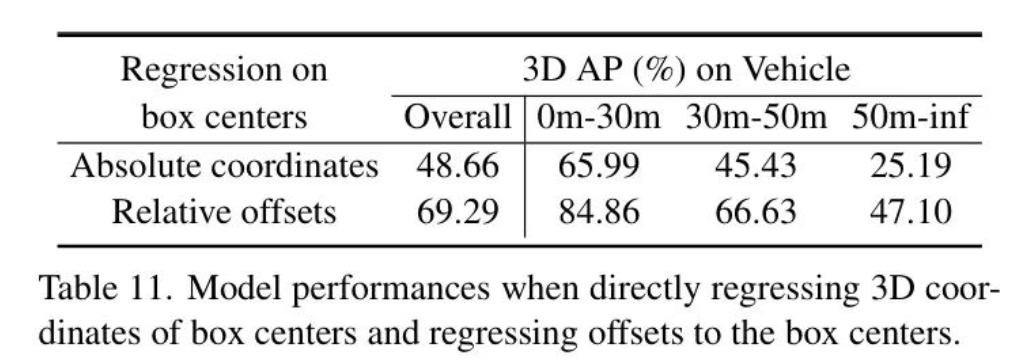

不同偏移量的影响。 基于 Voxel 的目标检测器通常在欧几里得空间中使用偏移量,而大多数基于范围视图的方法则使用由方位角投影的偏移量。因此,作者研究在使用不同坐标空间时偏移量的影响,如表11所示。在这里, 表示欧几里得空间中的偏移量,而 则表示作者方法中使用的偏移量。

后一种偏移类型相较于前一种在mAP上带来了显著的2.05点提升。这表明 更适合于范围视图模态。

物体和点的分布。在正文研究中,作者观察到通过引入作者的中心性(center-ness)显著提升了检测性能,特别是对于远距离物体。作者的假设是中心性不仅有助于过滤掉噪声预测,同时还能在推理过程中减轻不同距离物体之间的不平衡。为了验证作者的假设,作者在表10中提供了几个数值结果。具体来说,对于车辆和行人类别,作者报告了不同距离的平均物体数量,以及每个物体中的平均点数/中心点数。作者观察到在[0m, 30m]和[50m, ∞]范围内平均物体数量相似。然而,近距离物体包含的点数显著多于远距离物体,这种不平衡可能导致推理过程被近距离物体淹没。作者的中心性通过从近距离物体中过滤更多点来缓解这个问题。例如,对于0m-30m范围内的车辆,保留了7.2%的点。相比之下,距离超过50m的车辆的保留比率上升到12.3%。同样,对于行人类别,[0m-30m]和[50m-∞]范围内物体的保留比率分别为27.8%和43.5%。这表明作者的后处理可以降低近距离物体的权重,从而在较远距离带来更显著的改进。

影响回归框中心的方法。作者注意到一些针对相机图像的3D目标检测器直接回归框中心的绝对坐标。然而,这种方法并不适合于LiDAR数据,因为LiDAR数据中的每个点都是通过其3D坐标来确定的。利用这一信息可以减轻与检测任务相关的学习挑战。正如表11所示,直接回归框中心导致车辆类别的mAP仅为48.66%,这显著低于使用相对偏移量的情况。因此,回归偏移量是合理的。

Appendix C Semantic Segmentation

本文主要描述了由边界框得出的分类标签。通常,在分割任务中,语义类别会比目标检测任务中的更多。该框架通过扩展预测分类 Heatmap 的维度,轻松地适应这种情况,以分配在检测标签中不存在的类别。

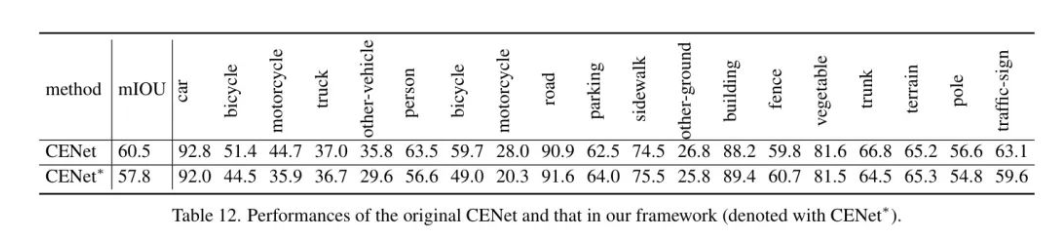

为了进一步展示作者所使用的 Backbone 网络和 Head 在通用语义分割方面的能力,作者在作者的框架上对SemanticKITTI [2] 数据集进行了CENet [6] 的训练。需要注意的是,SemanticKITTI 并不提供原始的范围图像。作者仅使用这个数据集来展示框架的能力,而不是为了达到最佳性能。作者的结果在表12中展示,表明该框架在任务上表现足够好。

Appendix D Panoptic Segmentation

全景分割整合了对物质类别的语义分割和对事物类别的实例分割。鉴于作者的框架能够轻松支持语义分割,作者只需要通过关注对事物目标的实例分割来证明其可行性。因此,作者在Waymo开放数据集[29]中选择了车辆类别,因为其他全景分割数据集不提供原始范围图像。

评估指标。遵循当前的全景分割方法[21, 28],作者将平均全景质量(PQ)作为主要指标,它可以分解为分割质量(SQ)和识别质量(RQ),以提供对结果额外见解。PQ的公式为:

在这里, 代表预测值和真实值,而 分别是真阳性、假阳性和假阴性的匹配集合。如果对应的IoU大于0.5,则该匹配为真阳性。

不同方案的比较。 使用作者模型预测的结果(在作者主要结果中用 表示),作者对车辆类别进行实例分割,使用边界框,以及使用 进行聚类,作者的算法进行处理。

使用3D距离,以及作者带有自定义距离的算法。很明显,直接用 对偏移点进行聚类并不能得到满意的结果。PQ值远低于使用边界框的方法。然而,引入中心性和作者聚类后合并的策略后,PQ值提升到81.86,超过了基准值81.25。需要注意的是,使用边界框进行实例分割在计算上是非常耗费资源的,因为它需要对所有点及所有框进行点在框内的检查。相比之下,作者仅在中心点上进行聚类,而合并步骤则非常高效。采用作者的自定义距离度量,PQ值提升到83.72,相对于基准来说,有了显著的2.53的提高。

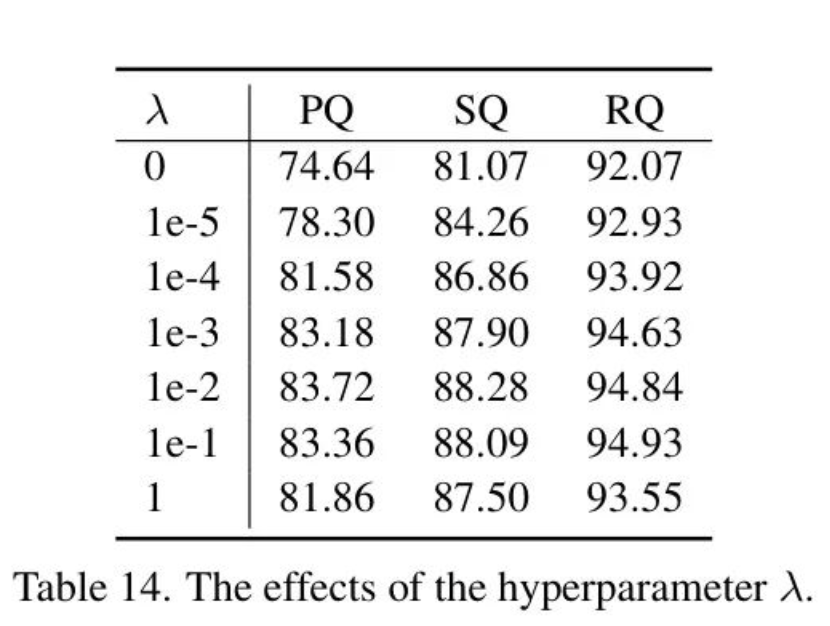

超参数 的消融研究。作者对距离度量的消融研究显示在表14中。显然,不使用沿视图方向的信息会导致最差的PQ值,为74.64。随着的增加,PQ值最初上升然后下降。当时,获得最佳结果。

参考

[1].Small, Versatile and Mighty: A Range-View Perception Framework.

作者:小书童

文章来源:集智书童

推荐阅读

- IEEE 754 Floating NaN在深度学习计算中的行为

- 手机端智能体Mobile-Agent开源,人人都可以拥有手机端超级助理

- 编译入门那些事儿(4):MLIR概述

- 编译入门那些事儿(3):不透明指针

更多嵌入式AI干货请关注嵌入式AI专栏。欢迎添加极术小姐姐微信(id:aijishu20)加入技术交流群,请备注研究方向。