1888 年,爱迪生提交了一项名为「活动电影放映机」的专利,该设备首次实现连续播放静态照片,形成类似动态画面的效果,由此拉开了视频发展的序幕。

回顾历史,视频经历了从无到有、从黑白到彩色、从模拟信号到数字信号的迭代。过去,视频的制作包括了脚本/剧本创作、拍摄、剪辑、配音、校审等多个步骤。时至今日,小到短视频平台的爆款视频,大到剧院内热映的大制作电影,仍然遵循着这一长链条的制作形式。

近年来,随着生成式 AI 的出现,视频的制作也迎来创新。 自 ChatGPT 横空出世以来,生成式 AI 在文字理解方面的能力屡屡带来惊喜。

2 月 26 日,OpenAI 发布了 Sora 模型,可通过接收文本指令,生成长达一分钟的视频。它不仅具有很好的理解长文本能力,还能够理解并模拟真实世界的物理情况,生成包含多个角色以及特定类型运动的复杂场景,兼具逻辑感和真实感。然而,目前 OpenAI 仅发布了 Sora 模型的演示视频,其访问权限只被授予小部分研究人员和创意人士等。

与此同时,现已有多个开源的 AI 生成视频模型可供大家免费使用。B 站热门 up 主 Jack-Cui 在其视频教程中介绍道,目前效果较好的开源 AI 生成视频方案是 Stable Diffusion + Prompt Travel + AnimateDiff 组合。

其中,Stable Diffusion 是一种「潜在扩散模型」,它先通过编码器将原始高维度数据(如图像)映射至潜在空间,在此空间中进行扩散和去噪,后通过解码器将潜在空间中清理过的数据重构回高维度空间,其最终结果是根据文本指令生成相应的静态图。

相比于目前主流在 AI 视频生成领域的扩散模型,Stable Diffusion 引入了一个额外的编码-解码阶段,这使得它应用于高维数据(如图像)时,会在一个包含原始数据重要特征的低维潜在空间中执行,提高了模型的效率和生成质量。

Prompt Travel 是一种调整文本指令的方式,用户可以根据创作意图,在视频的不同时间轴提供不同的关键词和描述,引导 AI 模型生成一连串既连贯又有变化的画面。

最后,AnimateDiff 在冻结的文生图模型中附加一个新初始化的运动建模模块,并利用视频片段数据集训练出合理的运动先验知识。一旦运动模块训练完成,将其插入到文生图模型内部,从而使模型具备生成多样化、个性化的文本驱动视频片段的能力。

目前,该模型部署教程已上线 HyperAI 超神经官网,点击即可一键克隆。

https://hyper.ai/tutorials/30038

由 B 站热门 up 主 Jack-Cui 制作的「Stable-Diffusion 在线教程」如下,该教程将手把手教你如何一键玩转 AI 绘画 & AI 生成视频!

王炸!AI声音克隆+Sora开源平替一键启动,全网最简单!_哔哩哔哩_bilibili

根据教程,小编已经成功生成了各种好看的图片和视频,效果简直不要太牛!

Demo 运行

- 点击「在线运行此教程」,跳转至 OpenBayes 免费领取 RTX 4090。

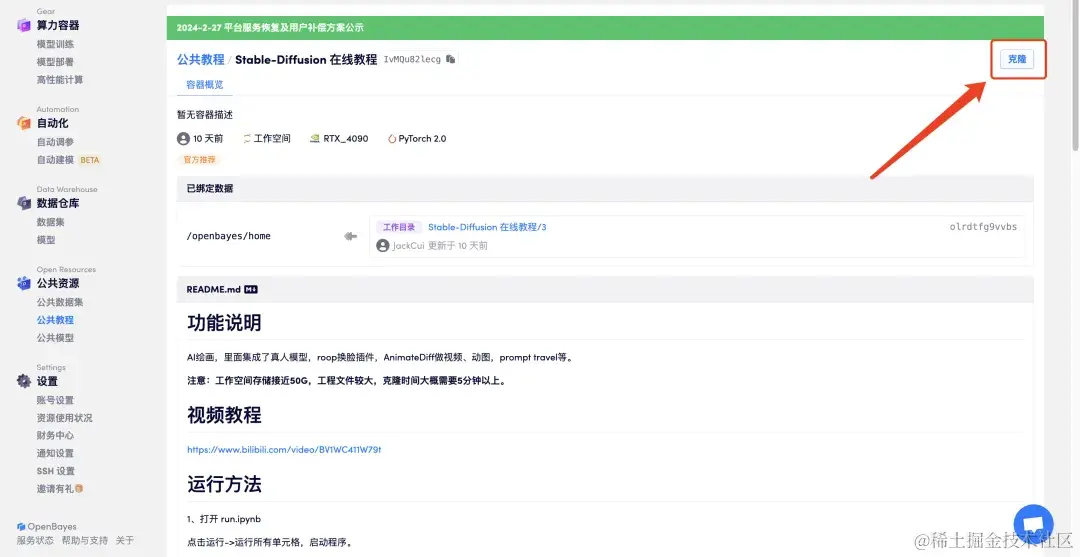

- 点击右上角「克隆」,将该教程克隆至自己的容器中。

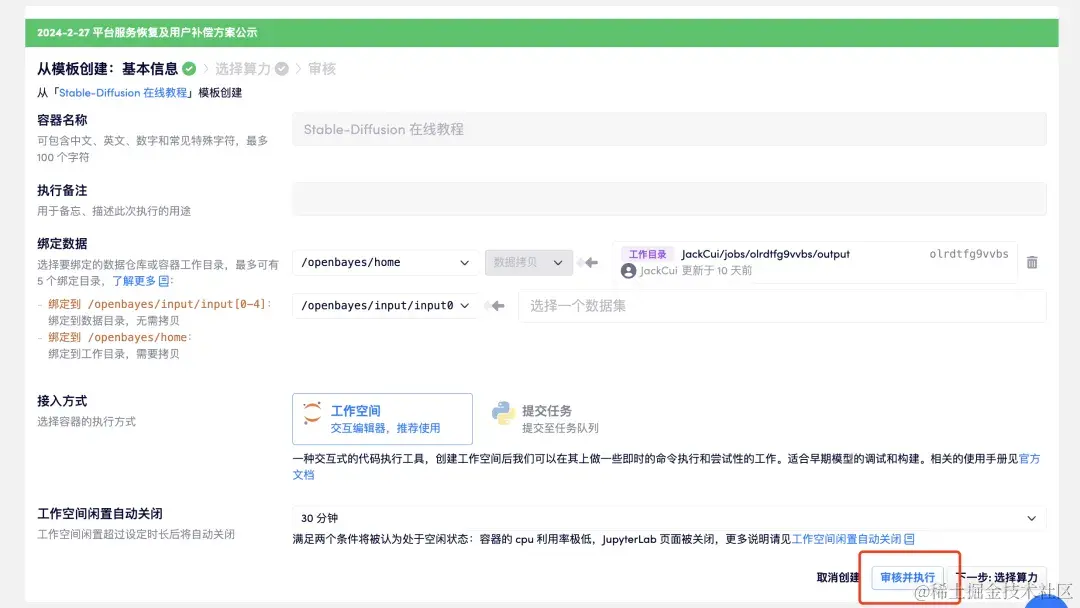

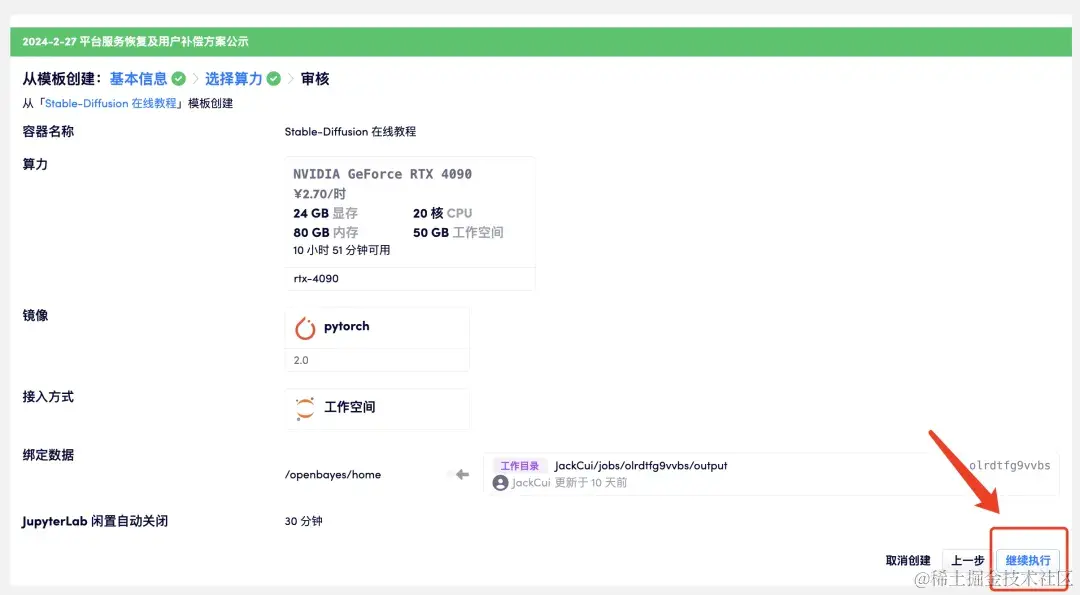

- 点击「审核并执行」-「继续执行」。推荐使用 RTX 4090,新用户使用下方邀请链接注册,即可获得 4 小时 RTX 4090 + 5 小时 CPU 的免费算力时长!

邀请链接:

https://openbayes.com/console...

- 稍等片刻,状态变为 「正在运行 」后,点击 「打开工作区」。该容器数据量较大,首次启动容器大约需要 8-10 分钟,请耐心等待。

如果超过 15 分钟仍处于 「分配资源 」状态,可以尝试停止并重启容器;如果重启后仍无法解决问题,请联系官方网站上的平台客服。

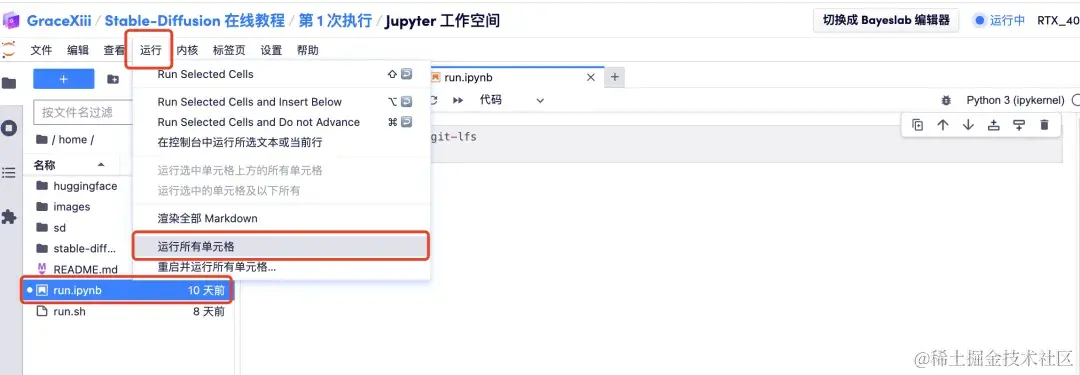

- 打开工作区后,点击左侧的 「run.ipynb」,然后通过菜单栏上的 「运行 」按钮点击 「运行所有单元格」。

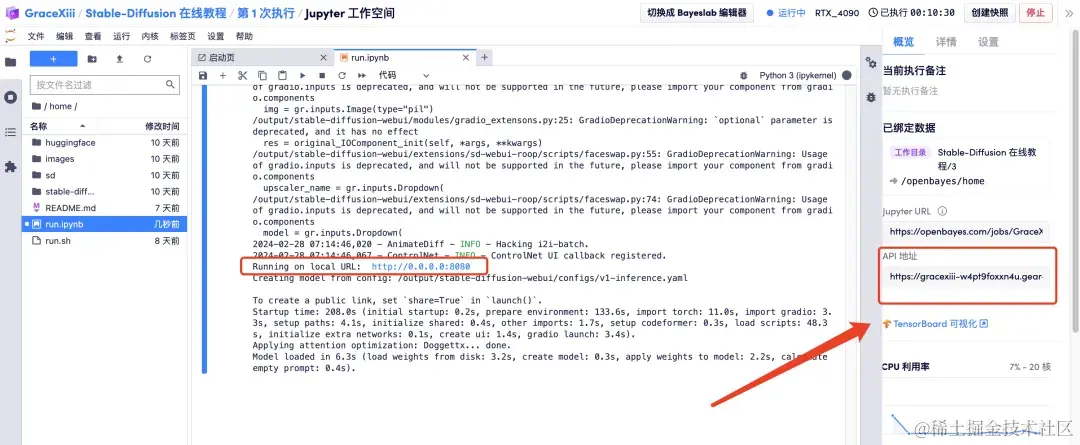

- 稍等片刻,待 Local URL 生成后,打开右侧「API 地址」,请注意,用户需在实名认证后才能使用 API 地址访问功能。

效果展示

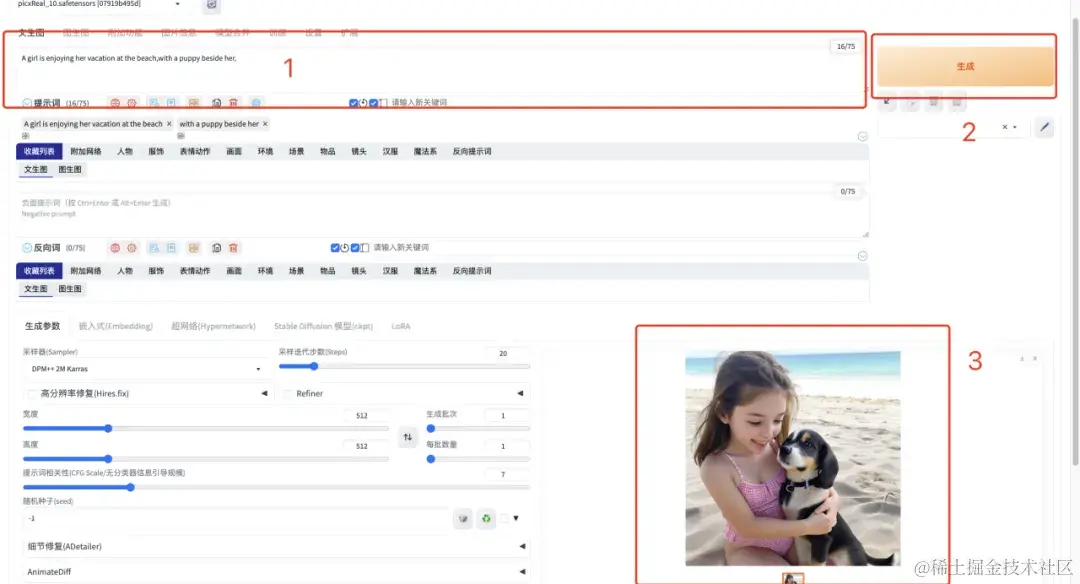

- 打开「API 地址」后,在文本框输入英文提示词,点击「生成」,只需 1s ,即可快速生成图片。

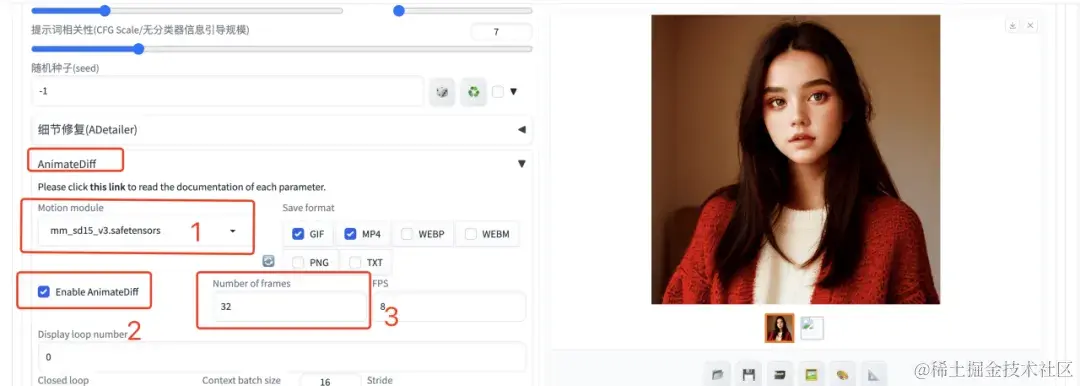

- 如果想要生成视频,需要在输入英文提示词后,选择 AnimateDiff 插件,将生成帧数填写为 32 帧,其余参数默认,稍等片刻,即可生成动图或者视频啦。

目前,HyperAI 超神经官网已上线了数百个精选的机器学习相关教程,并整理成 Jupyter Notebook 的形式。

点击链接即可搜索相关教程及数据集:

以上就是小编本次分享的全部内容啦,希望这次的内容对您有所帮助。如果大家还想学习其他好玩的教程,欢迎留言告诉我们项目地址,小编将会为你量身打造课程,教你如何玩转 AI。

参考资料:

1.https://zhuanlan.zhihu.com/p/...