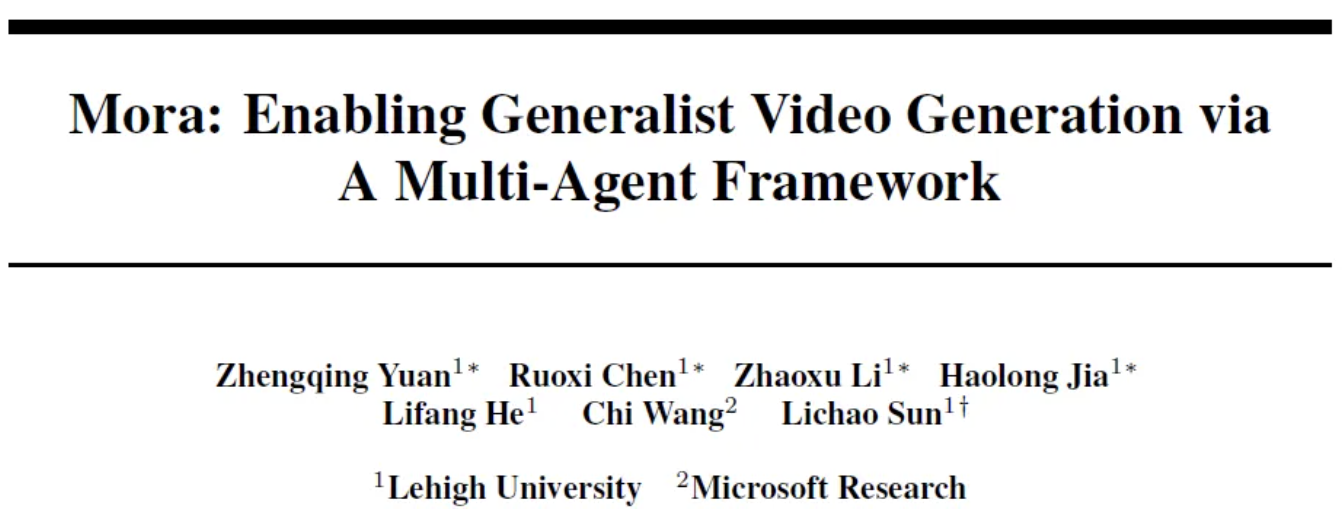

“Mora: Enabling Generalist Video Generation via A Multi-Agent Framework”

Sora的爆火带动了AI视频生成的关注,然而闭源的Sora为后续研究带来了挑战。为了解决这个问题,近日理海大学和微软联合推出Mora多Agents视频生成框架,通过整合多个SOTA的AI模型,复现Sora的通用视频生成能力。

论文地址:https://arxiv.org/pdf/2403.13248.pdf

Github地址:https://github.com/lichao-sun/Mora

摘要

Sora是第一个引起社会广泛关注的大规模视频生成模型。自OpenAI于2024年2月推出以来,没有其他视频生成模型能与Sora的性能或其支持广泛视频生成任务的能力相媲美。为解决这一差距,本文提出一种新的多Agents框架Mora,Mora可以利用多个视觉Agents,并在各种任务中成功地模拟Sora的视频生成能力。实验结果表明,Mora在各种任务中取得了接近Sora的性能。

简介

最近的视频生成模型(如Pika和Gen-2),已经证明了它们产生多样化和高质量视频的能力,但它们一直受到创建超过10秒的更长时间视频的能力的限制。OpenAI的Sora引发了革命性的转变,标志着视频生成的新时代。然而由于Sora是闭源的,阻碍了研究人员复制或扩展Sora的能力。

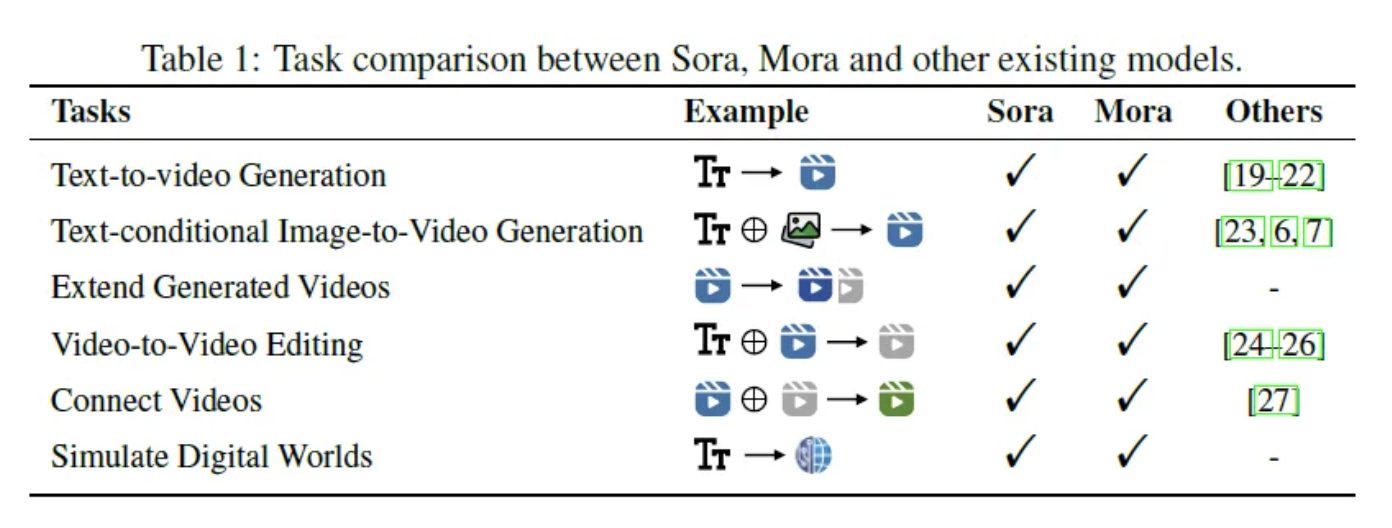

为解决当前视频生成模型的局限,本文探索了多Agents协作在完成通用视频生成任务方面的潜力。本文提出一种多Agents框架Mora,利用各种先进的大型模型来实现类似Sora的文本到视频功能。将视频生成分解为几个子任务,每个子任务分配给一个专门的Agents:

- 1)增强用户提供的提示

- 2)从输入文本提示生成图像

- 3)根据文本提供的增强条件编辑或细化图像

- 4)从生成的图像生成视频

- 5)连接两个视频

通过自动组织Agents在这些子任务中循环和置换,Mora可以通过灵活的流水线完成广泛的视频生成任务,从而满足用户的多样化需求。

Mora在推理过程中独特地产生一个中间图像或视频,能够保留文本到图像模型中固有的视觉多样性、风格和质量。通过有效地协调文本到图像、图像到图像、图像到视频和视频到视频Agents的工作,Mora可以熟练地进行广泛的视频生成任务,同时提供优越的编辑灵活性和视觉保真度,与Sora等已建立模型的性能相媲美。

为评估Mora的功效,使用了公开可用的视频生成基准Vbench中的基本指标和6个任务的自定义指标,包括文本到视频生成、文本条件图像到视频生成、扩展生成视频、视频到视频编辑、连接视频和模拟数字世界。Mora在文本到视频生成任务中取得了比现有开源模型更好的性能,仅次于Sora。在其他任务中,Mora也提供了有竞争力的结果,强调了我们框架的多功能性和通用能力。

文本主要贡献如下:

- 提出了一种开创性的元编程框架Mora,旨在加强多Agents协作。Mora定位为推进通用性视频生成任务边界。

- 研究表明,通过利用多个Agents的自动合作,包括文本到图像、图像到图像、图像到视频和视频到视频Agents,视频生成的质量可以显著提高。

- Mora在6个视频相关任务中表现出了卓越的性能,超过了现有的开源模型。

Mora:用于视频生成的多Agents框架

基于Agent的视频生成

Agents。解决不同的视频生成任务通常需要具有不同能力的Agents的协作,每个Agents都提供专门的输出。在Mora中,我们有5个基本角色:提示选择和生成Agents、文本到图像生成Agents、图像到图像生成Agents、图像到视频生成Agents和视频到视频Agents。

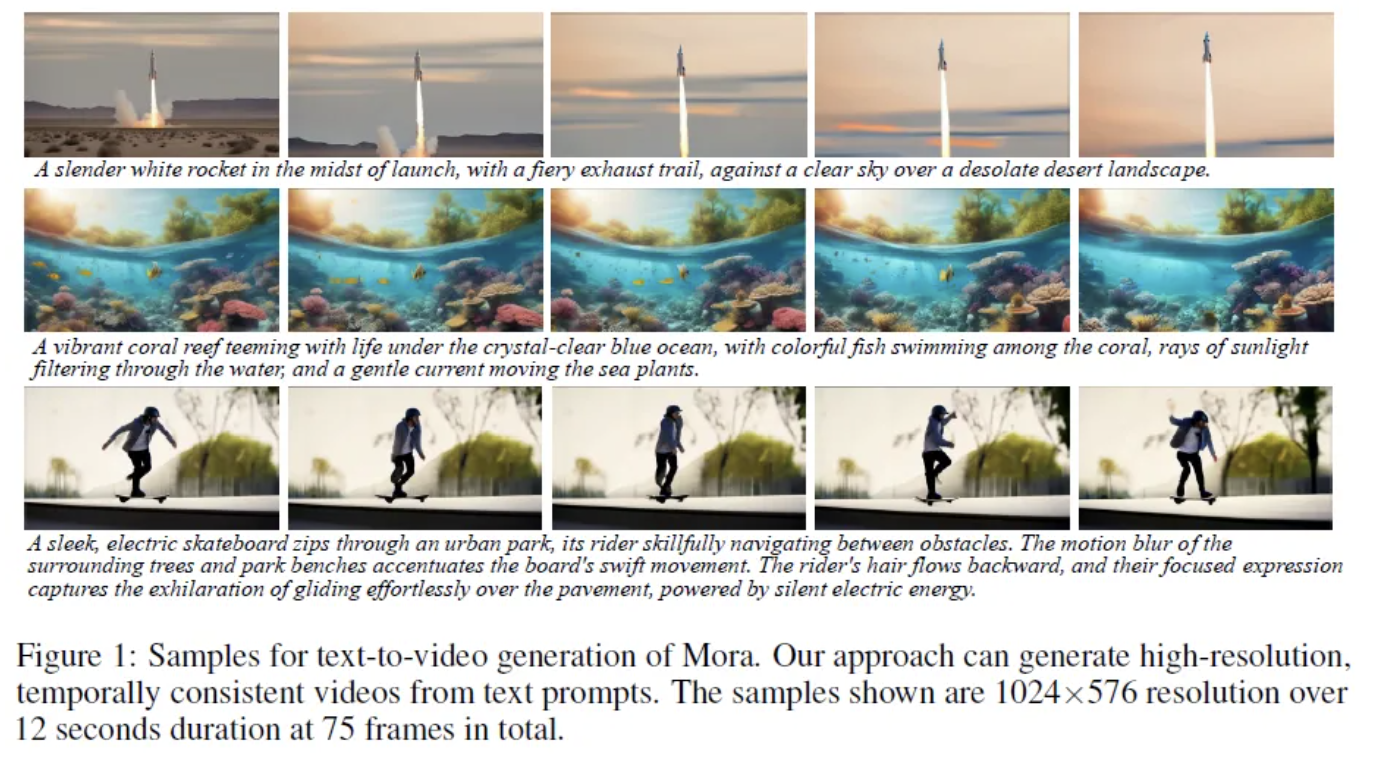

方法。通过设置agent的角色和操作技能,可以为不同的任务定义基本工作流。本文设计了6个文本到视频生成任务:文本到视频生成、文本条件图像到视频生成、扩展生成的视频、视频到视频编辑、连接视频、模拟数字世界。

Agents模型选择

- 提示选择和生成:GPT-4

- 文本到图像生成:SDXL

- 图像到图像生成使用InstructPix2Pix

- 图像到视频生成:Stable Video Diffusion

- 视频连接:SEINE

实验

设置

基线。在文本到视频生成中,基线模型包括Videocrafter1、Show-1、Pika、Gen-2、ModelScope、LaVie-Interpolation、LaVie和CogVideo。在其他五个任务中,我们将Mora与Sora进行比较。

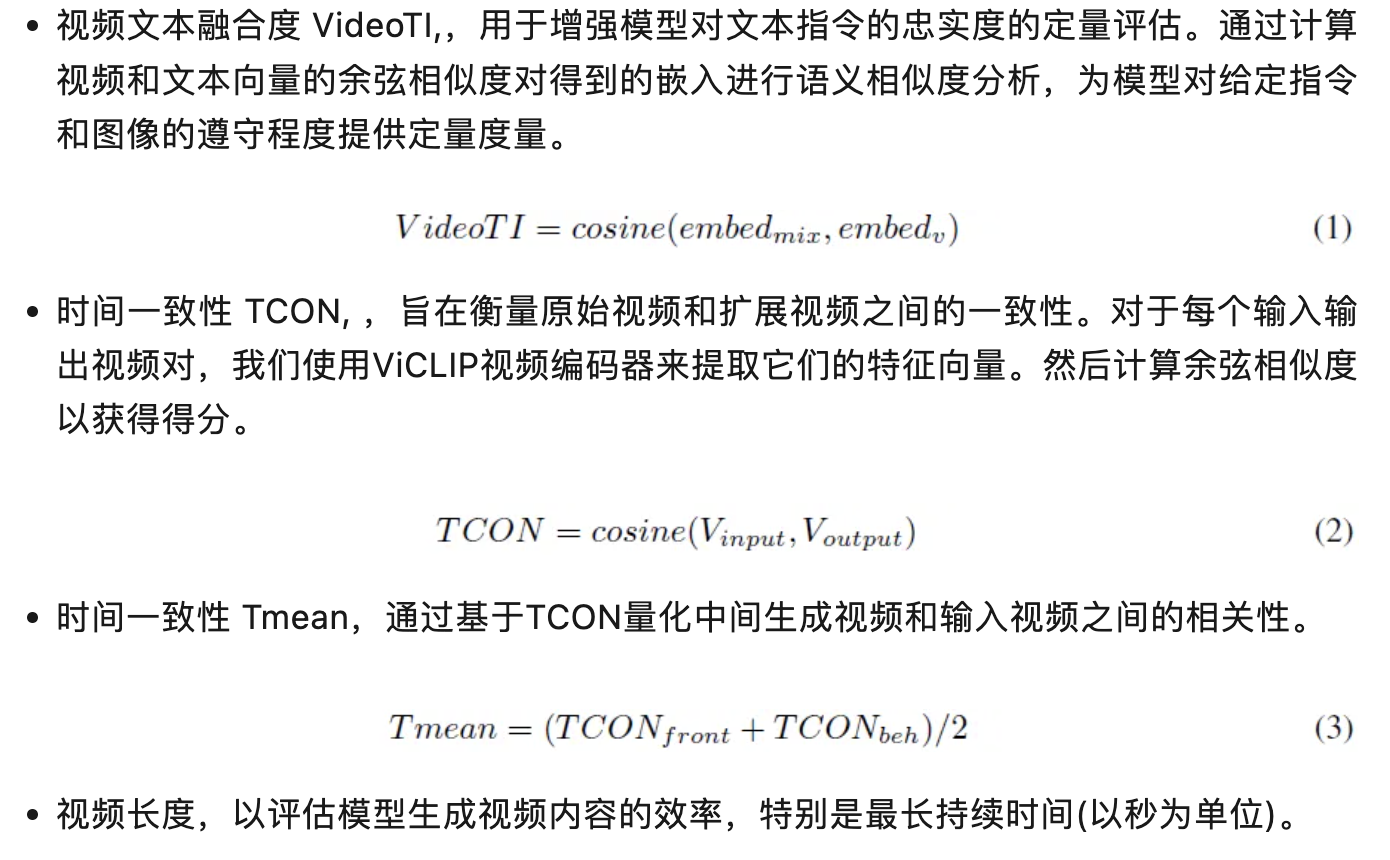

基本指标。对于文本到视频的生成,使用Vbench中的多个指标从视频质量和视频条件一致性两个方面进行评估。

对于视频质量的测量,我们使用六个指标:对象一致性、背景一致性、运动平滑度、审美分数、皮肤动态程度、成像质量。

为了测量视频条件的一致性,我们使用两个指标:时态风格、外观风格。

自定义指标。为了评估其他任务,我们还定义了4个指标。

结果

文本到视频生成。Mora在所有指标上都表现出了值得优秀的性能,使其与性能最好的模型Sora高度可比,并超越了其他竞争对手的能力。

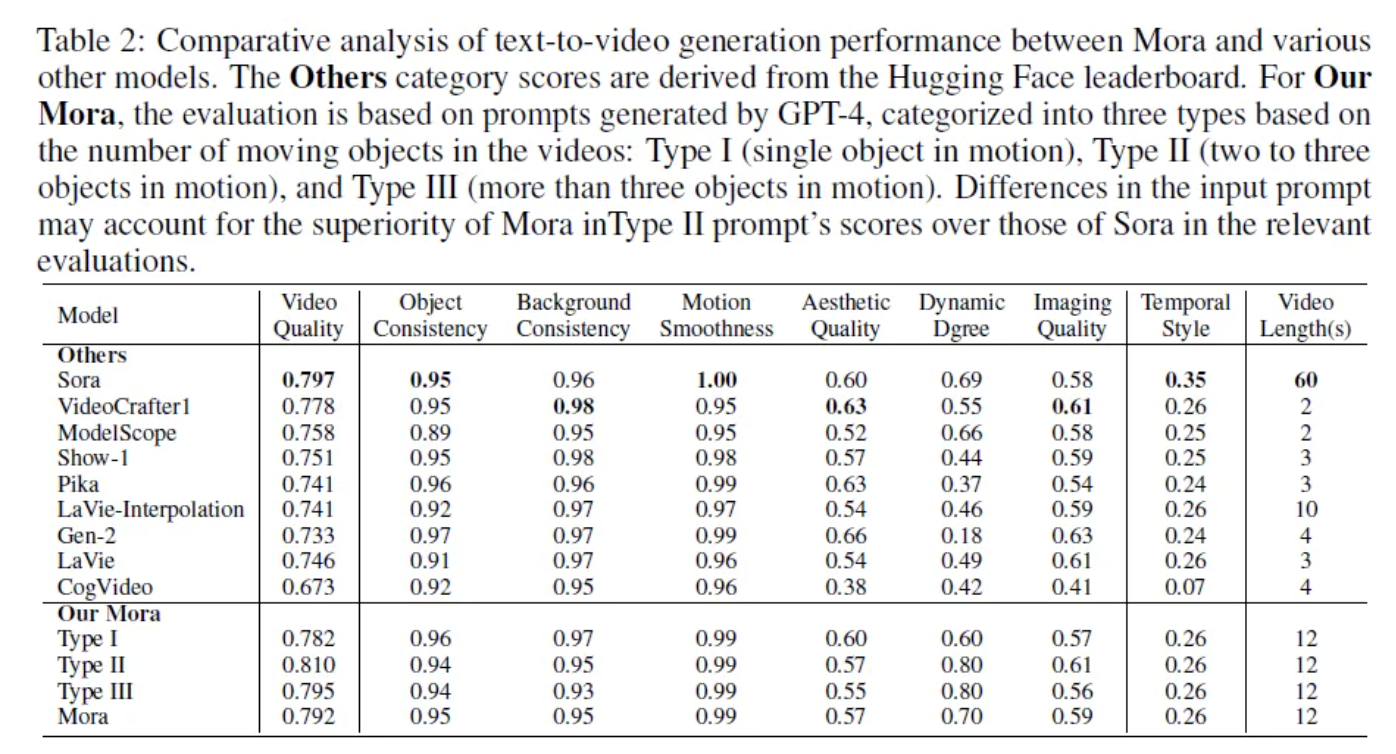

文本条件图像到视频生成。Mora在文本条件图像到视频生成方面的能力的显著展示,紧跟在Sora之后。Sora和Mora的视频输出之间的定性比较显示,两个模型都巧妙地结合了输入提示和图像中的元素。

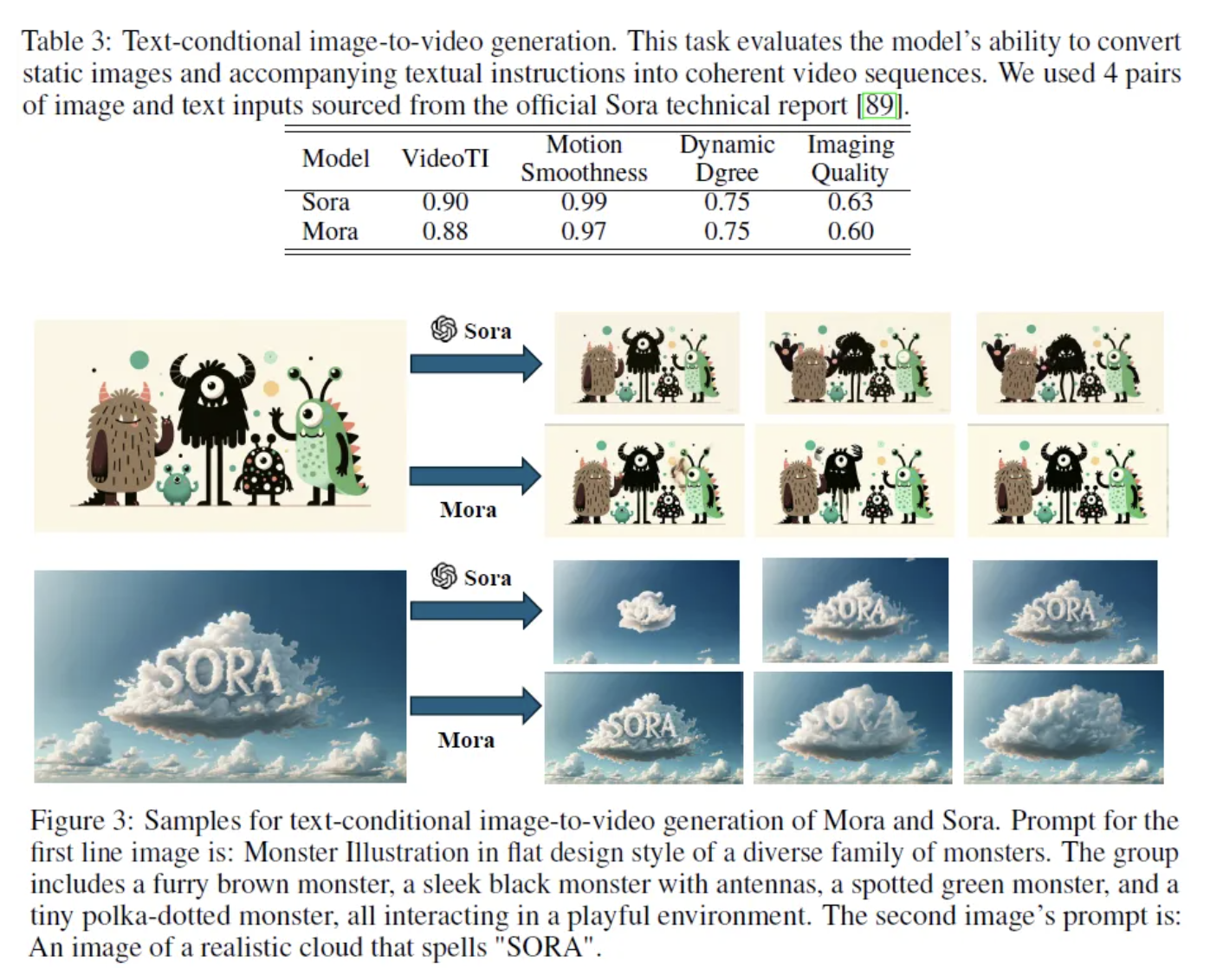

扩展生成的视频。虽然Sora在TCON和成像质量上略优于Mora,但是从定性的角度来看,Mora保持了叙事背景和视觉完整性,从而提供了与Sora几乎相同的表现。

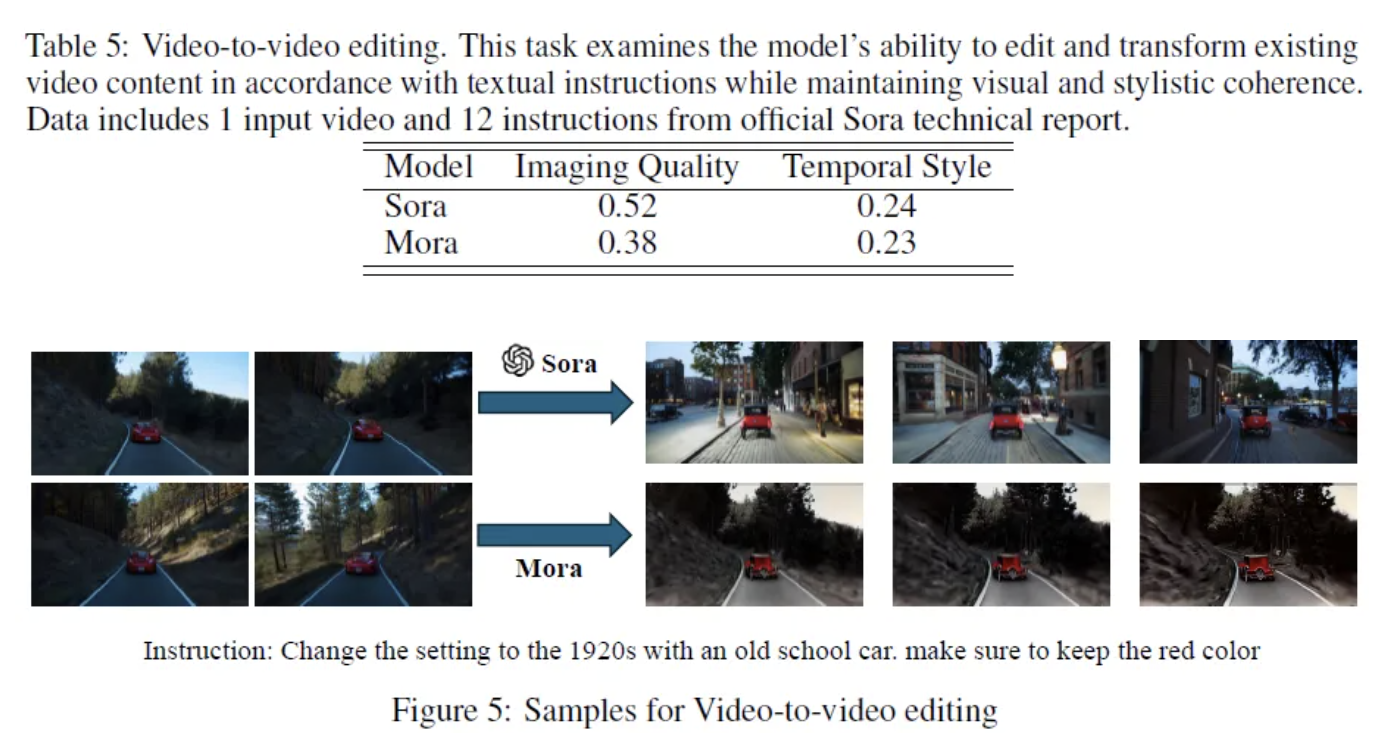

视频到视频编辑。尽管与Sora相比有少许距离,但它为确定Mora未来迭代中目标增强的区域提供了有价值的见解。

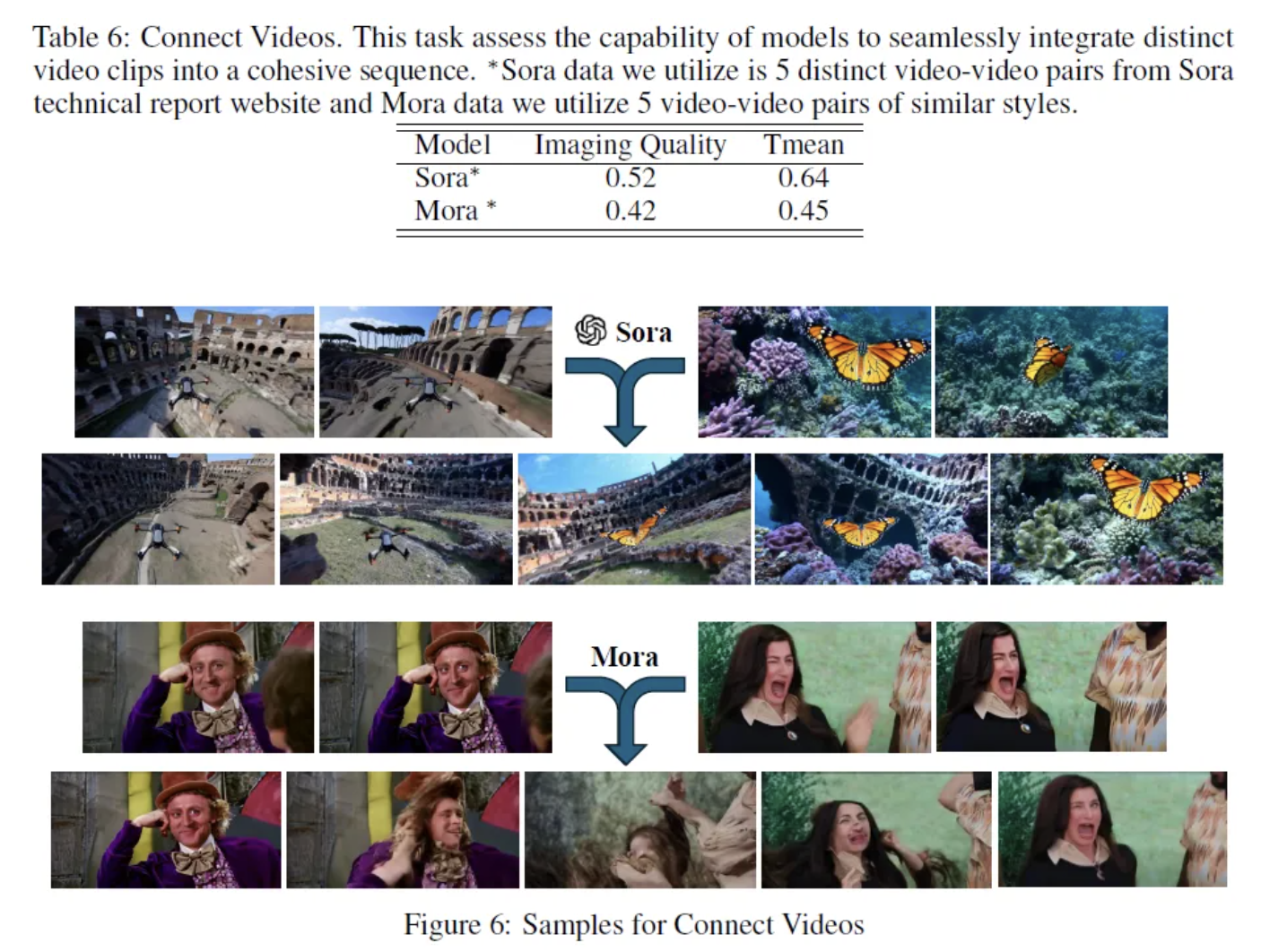

视频连接。Sora比Mora在时间上保持了更一致的视觉叙事。Mora模型在中间视频中呈现出模糊的背景,导致无法区分物体识别。

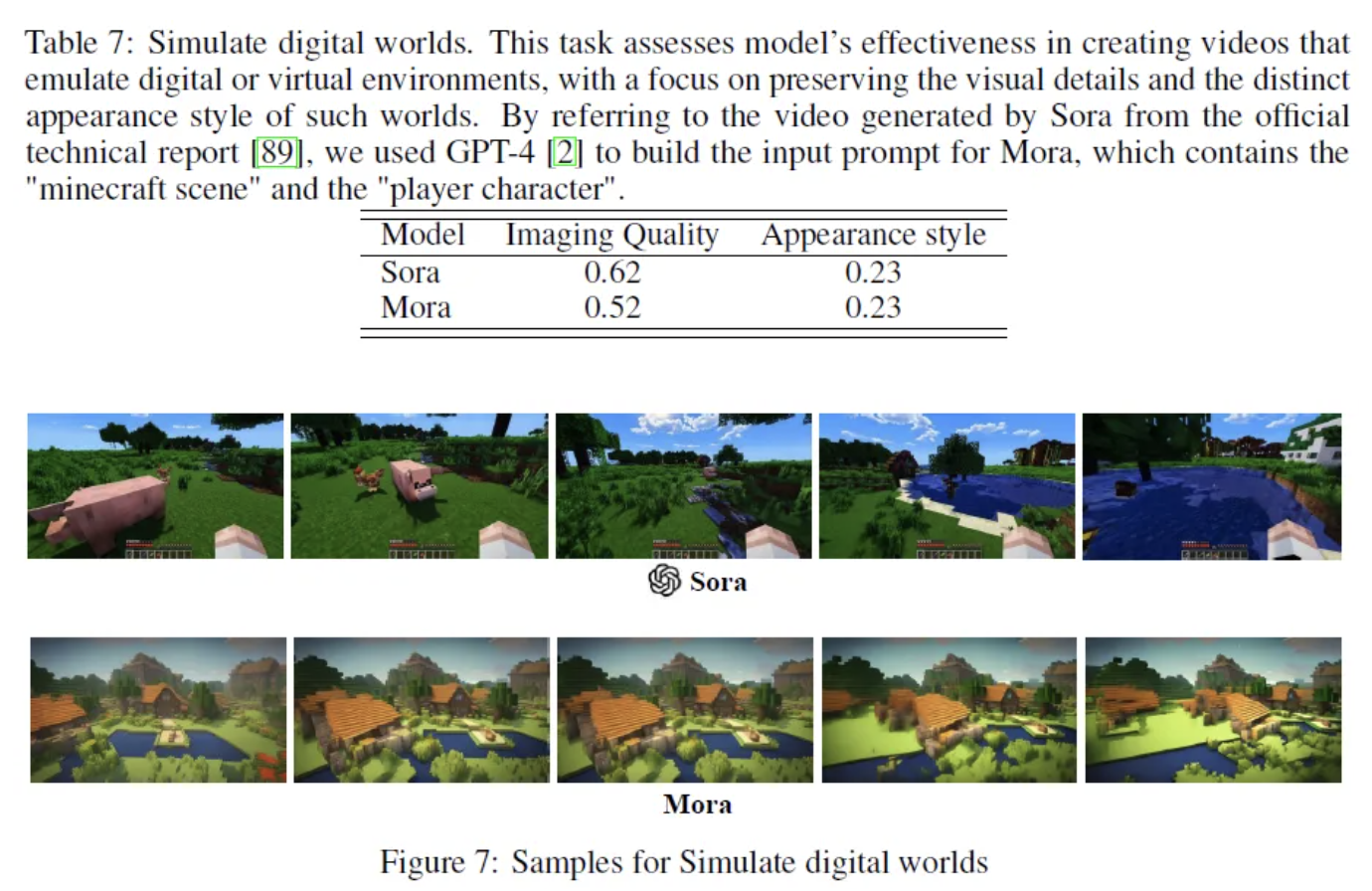

模拟数字世界。与Sora的输出相比,Mora生成的图像颜色稍微柔和,物体边缘不明显,分辨率似乎更低。这表明Mora仍处于发展阶段,其生成能力需要进一步完善才能达到Sora的性能水平。

讨论

Mora的优势

开源贡献。Mora的开源性质被为人工智能社区的重大贡献,通过提供未来研究可以建立的坚实基础,鼓励进一步发展和完善。

Mora的限制

视频数据集。收集高质量的视频数据集带来了重大挑战,这主要是由于许多视频的版权限制。这一限制强调了在训练模型中,视频数据集的数量以及质量和多样性的重要性,以准确地理解和重建复杂的人类行为。

质量和长度差距。尽管采用了创新的方法,但Mora面临着显著的挑战,虽然Mora能够完成类似Sora的任务,但由Mora生成的视频质量非常短,特别是在涉及实质性物体运动的场景中。

指令跟随能力。尽管Mora能够在生成的视频中包括提示中指定的所有对象,但在执行某些功能时遇到限制。它很难解释和渲染提示中描述的运动动力学,如运动速度。这种不足主要源于系统对视频生成的基本方法,该方法在图像到视频的基础上操作,而没有从文本提示直接输入。

人类视觉偏好对齐。人类标记信息在视频领域的缺乏,表明实验结果可能并不总是与人类的视觉偏好一致,突出了一个显著的差距。

总结

Mora标志着从文本提示生成视频方面的巨大进步,为视频生成领域的适应性、效率和输出质量建立了新的基准。Mora在某些领域与当前领先的模型相当,甚至超过了其表现。然而,它与OpenAI的Sora模型有明显的差距,OpenAI的闭源性给学术界和专业社区的复制和创新带来了巨大的挑战。Mora是开源的,可以使更广泛的用户和开发人员更容易使用先进的视频生成技术,使社区能够在Mora框架和其他开创性工作所奠定的基础上进行建设。

作者:灵度智能

文章来源:灵度智能

推荐阅读

- 地平线提出VAD v2端到端自动驾驶模型 | 远超SP-T3/VAD/DriveMLM等方法

- 从 Intel 与 ARM 的成功历史看 RISC-V

- 马斯克实现承诺,开源Grok-1!3140亿参数迄今最大,远高于ChatGPT 3.5!

- Mixtral 8x7B(Mistral MoE) 模型解析

更多嵌入式AI干货请关注嵌入式AI专栏。欢迎添加极术小姐姐微信(id:aijishu20)加入技术交流群,请备注研究方向。