大模型离产业越近,越需要成体系的支撑能力!

2023年是大模型蓬勃发展的一年。据统计,截至2023年10月,中国大模型创新主体共254家,分布于20余个省市和地区。截止到目前,国内公布的大模型数量已超过300个。

宁畅CEO 秦晓宁

“百模大战”仅仅是个开始。在3月29日的宁畅战略发布会上,宁畅CEO秦晓宁表示,大模型终究要从参数的竞赛阶段走向商业化、产业化的落地阶段。而离行业应用越近,就意味着场景更加丰富、客户面临的挑战和需求愈发复杂和多样化。

AI模型参数争锋带动了算力军备竞赛,进而转向全方位体系化的AI支撑能力的考验。当一场硬仗开启,宁畅发布了全新的“全局智算”战略,以系统、全面性来应对用户需求的复杂性,通过AI算力栈等系统性的全栈方案提供AI支撑能力,覆盖大模型发展的全生命周期的需求。

全局智算

发挥大模型场景价值

从2021年宁畅提出“智能算力定制专家”到2022年的“智定+”战略,再从2023年的“冷静计算”到今年的“全局智算”,宁畅始终保持着对行业的清晰洞察,有一套清晰且可执行发展策略,以及追求极致的产品理念。

2024年,Sora的发布标志着AI在视频技术领域取得了突破性进展,多模态大模型持续演进。超大规模AI大模型的训练往往需要相应的算力支撑,随着Transformer架构持续升级,所需参数量也不断增加。

作为计算产业的局中人,离客户越近,宁畅就越能快速把握客户需求。在Transformer及大语言模型(LLMs)出现前,绝大部分的AI模型训练和推理对算力等硬件资源的要求并不高,使用单机CPU/GPU或分布式小集群即可满足需求。

在宁畅CEO秦晓宁看来,2023年的“百模大战”是大模型发展的1.0阶段,比如GPT3的参数达到170B,大模型需要更多更快更强的算力,对于算力提供商来说,只需要卖“铲子”供用户挖掘大模型这座金矿。

2024年,行业大模型的垂直部署和应用成为趋势,大模型离应用也越来越近,用户使用大模型的阶段不同,涌现出来的需求更是多样化。

在大模型训练阶段,通用大模型的客户本身是有很强的算法能力,他们需要极致的算效体系,提升万卡时代“算、网、存、管”四个方面的能力。

在产业垂直落地的场景当中,需要专业增强体系,提高模型的精度和效率。

在大模型应用部署阶段,需要高效稳定体系,解决实时调用的“服务瓶颈”,实现轻量部署,提升推理效率。

让用户场景决定技术价值,该如何发挥大模型的场景价值呢?

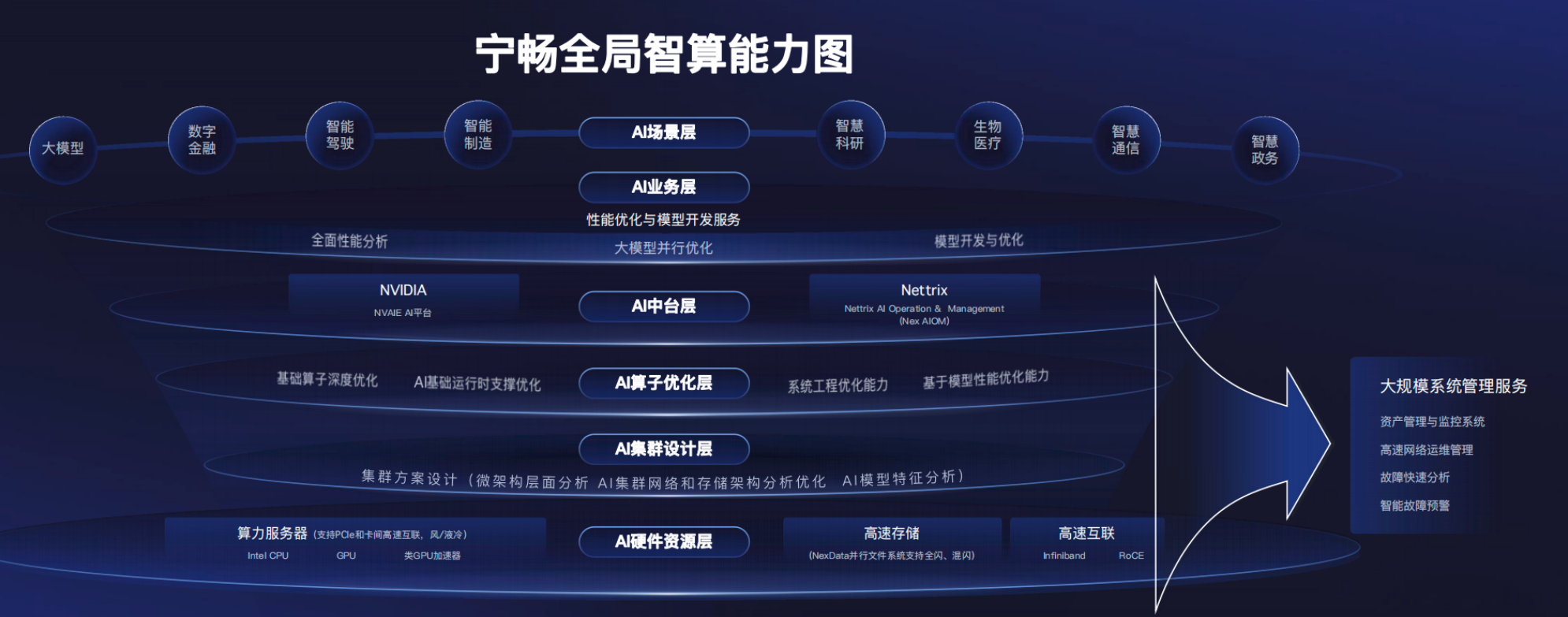

宁畅的创新积累和精准洞察持续发挥着作用。此次宁畅发布的“全局智算”战略,从算力、算法、数据维度来提供更多元更强的支撑,在AI的硬件层、集群层、中台层、内容层、服务层提供出全方位、多维度的全栈智算能力。

宁畅全局智算能力图

“全局智算”的智算能力图谱展示出六大“全”特性,涵盖软硬件全体系及全液冷产品,提供从咨询到运维的全流程服务,满足全行业用户大模型开发、适配、部署的全场景需求。

按用户发展阶段,宁畅定制专业且性价比高的AI计算方案,满足算法协同优化、数据处理能力、模型可解释性以及与特定行业应用融合度等核心需求。

AI算力栈

系统化承接战略落地

在日积月累的打磨和精进中,宁畅自带的深厚技术能力深得客户认可。这项能力并非一蹴而就,宁畅产品“AI算力栈”作为全局智算能力的集中体现,从底层硬件到顶层应用平台的系统化方案,再到AI场景服务,帮助客户构建全栈AI环境,满足重点行业全阶段的AI创新。

宁畅CTO 赵雷

宁畅CTO赵雷表示,AI算力栈为客户提供丰富的硬件产品组合,包括灵活的算力服务器、高效存储、高速网络、全栈液冷,来满足大模型落地所需的计算、存储、网络、建设、管理、应用及液冷等需求,真正体现出宁畅的“硬实力”。

宁畅产品全家福

比如,宁畅覆盖从冷板式液冷到浸没式液冷的多种形态,包括通用服务器、人工智能服务器、高密度服务器、整机柜服务器、液冷基础设施,致力于为用户提供从服务器到数据中心的全系统液冷解决方案。

益企研究院曾重点解读过宁畅B8000液冷整机柜服务器。作为AI算力栈最具亮点的交付形态,也是下一代服务器产品的新形态,B8000通过包括液冷、集中供电等方面的优化,集高密算力、轻松部署、绿色节能、快速交付、智能运维等众多优势于一体,通过全液冷整机柜设计,设备散热效率可提升 50%。

更值得一提的是,B8000在服务器的内存池化未来形态上进行了深度探索,采用水、电、网三路盲插设计,比传统部署周期提升30倍,如此的极致效能将全面助力绿色数据中心建设。B8000用户也可根据实际情况选择电盲插、电液盲插的设计,在设备成本和维护成本之间按需平衡。

在集群层面,不同的模型、不同的业务场景、不同的GPU算力都需要对应不同的网络传输模式,宁畅通过全量级的灵活扩展,实现网络的优化和升级,让智算即取无忧。

AI算力栈的“软动力”是宁畅通过定义AI软件栈,基于系统工程及算法模型,以AI算子全栈优化能力,为AI业务提供的并行加速、性能分析、模型开发优化等服务支持,构建出从算力资源定制,到模型适配优化,再到高效部署落地的大模型算力服务闭环,帮助用户极速推进AI应用开发及管理。

AI算力栈以其全面、灵活、深度的支撑能力,为行业客户、企业级智算中心的构建提供强有力的支持,目前宁畅全栈服务惠及各行各业,包括互联网、智能驾驶等领域。比如数字中国万里行团队考察过的宁畅X吉利星睿智算中心,就有宁畅的算力部署。

未来,AI算力栈也将进一步落地汽车、互联网、制造、金融、能源、科研等领域,成为推动行业数字化转型、实现智能化升级的核心引擎。

实践创新

首个AI算力栈开放体验

伴随着“全局智算”战略及全栈AI能力的正式发布,宁畅同时发布了国内首个AI算力栈,即NEX AI Lab(Nettrix AI Open Lab),该项目坐落在浙江桐乡市,为用户带来大模型、数据科学、推荐系统等解决方案工作流的先进体验。

宁畅发布会现场

目前,NEX AI Lab给用户提供免费的算力体验,用户可以尝试不同的业务组合,尝试不同的网络方案,尝试不同的软件和框架的调整,以便快速做出购买决策。

据宁畅CTO赵雷介绍,该AI算力栈最主力的服务器采用宁畅X640 G50,是一款基于第四代/第五代英特尔® 至强® 可扩展处理器的高端4U机架式服务器。同时支持20个节点的宁畅X680 G55液冷服务器,有效地验证了液冷服务器在高带宽下的使用情况。

英特尔AI首席架构师吴震华也表示:“第四代/第五代英特尔® 至强® 可扩展处理器的卓越性能,将为宁畅AI算力栈带来更强助力。”

结 语

理性地洞察客户需求,从为客户提供定制化、高质量的算力,到系统性地提供全栈AI支撑能力,宁畅务实的同时继续让创新发生。在“新质生产力”成为新发展的关键词当下,“全局智算”战略实现了大模型的场景价值,为用户展示出一张未来图景。