数据是对现实世界的抽象表征。物理现象、人类行为模式以及自然规律都可以通过数据结构进行编码和表示。通过实现各类算法和模型,可以挖掘数据中的隐含模式,提取具有实际意义的非平凡信息。卷积神经网络(CNN)专门处理具有网格结构的数据(如图像),循环神经网络(RNN)则针对序列数据(如时间序列或文本)进行建模。这些模型的共同特点在于它们所处理的数据具有规则的结构特征。对于具有不规则结构的图数据而言,其模式识别和特征提取则是一个较为复杂的任务。本文将重点讨论图学习领域中的一个重要模型——图卷积网络(Graph Convolution Network,GCN)[1]。

图卷积网络由 Thomas N. Kipf 和 Max Welling 于 2017 年 2 月在其论文《Semi-Supervised Classification with Graph Convolutional Networks》中首次提出。对于希望深入研究图神经网络的研究者而言,理解这篇论文的核心内容至关重要。本文将在保持数学严谨性的同时,着重阐释其基本原理,便于读者把握要点。

图的基本概念与表示

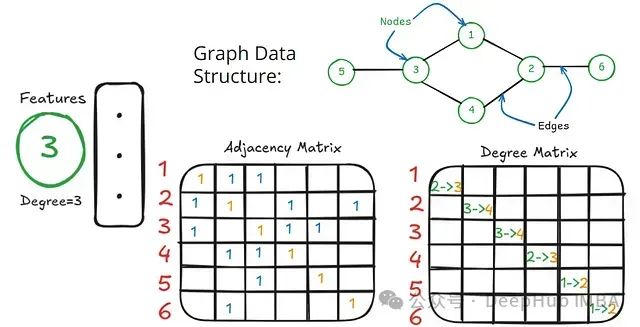

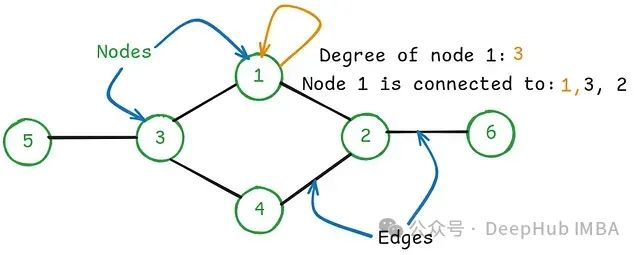

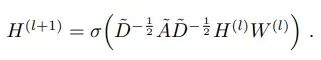

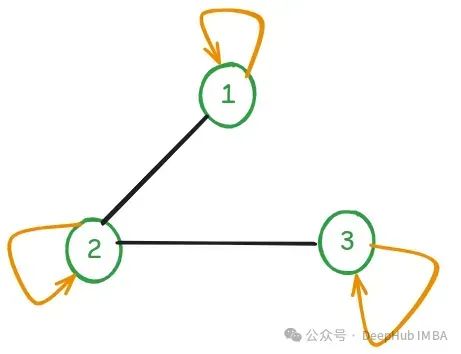

上图展示了一个无向图数据结构,其中每个节点都包含特定的特征向量。在此需要明确以下关键概念:

- 无向图:一种边具有双向性质的图结构,其中顶点间通过无方向性的边进行连接。

- 邻接矩阵:一个方阵,用于表示图中顶点之间的连接关系,矩阵元素表示对应顶点间是否存在边的连接。

- 度矩阵:一个对角矩阵,其对角元素表示无向图中各节点所连接的边的数量。

在邻接矩阵和度矩阵中,以橙色标注的数字表示存在自环(self-loop)的情况,即节点与自身之间存在连接。

谱图卷积理论

谱方法通过图的频率(谱)特性来定义卷积操作,这种方法依赖于图拉普拉斯算子的特征值和特征向量分解。拉普拉斯矩阵(L)的数学定义为:

L = D - A

其中,D 表示度矩阵,A 表示邻接矩阵。

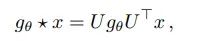

在上述表达式中:

- g_theta 表示谱滤波器

- x 表示输入信号

- U 代表归一化图拉普拉斯算子 L = I - D^(-1/2) A D^(-1/2) 的特征向量

- I 为 N 阶单位矩阵,N 为节点数量[1]

谱方法具有以下特征:

- 计算复杂度高

- 适用范围受限于特定图结构

计算挑战与优化

在实际应用中,图拉普拉斯算子的特征分解计算复杂度为 O(N³),其中 N 表示图中节点的数量。对于大规模图或实际问题,当 N 增长到百万量级时,计算成本将变得难以承受。这一计算瓶颈促使研究者们探索绕过特征分解的替代方案。

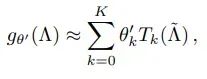

上图为基于切比雪夫多项式的谱滤波器近似

空间域解决方案

研究者提出使用 K 阶切比雪夫多项式来近似谱滤波器,这种方法无需显式计算特征值和特征向量。其核心优势在于计算仅依赖于每个节点的 K 跳邻居,从而使卷积操作局限于有限的邻域范围内。这种局部化策略实现了从谱域(基于图拉普拉斯算子的特征基)到空间域(基于邻域聚合)的计算转换。最终计算过程转化为"消息传递"机制,即通过聚合邻域信息来更新节点表示。

线性层次模型

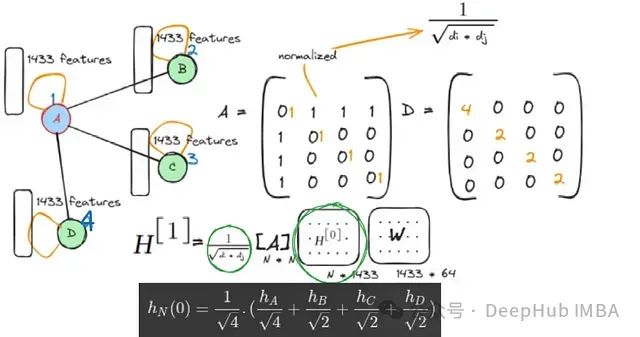

Kipf 和 Welling 进一步将切比雪夫多项式简化到(K=1)一阶近似,即仅考虑直接邻居的消息传递。其卷积操作可表示为:

线性层次模型的数学表达[1]

层次传播模型的示意图[1]

其中:

- D^~ 表示包含自环的度矩阵(上标~表示考虑自环)

- A^~ 表示包含自环的邻接矩阵

- X 表示 N 个节点的特征矩阵

- Theta或W^(l) 表示可学习的模型参数

- H^(l=0) 即为输入特征矩阵 X

- sigma 表示激活函数,本模型中采用 ReLU 函数

该方程完全在空间域中进行计算,显著提高了模型的计算效率。

模型架构与计算机制

上图展示了一个包含 4 个节点的图结构示例。其中节点 A 与节点 B、C、D 相连,每个节点包含 C 维特征向量(C=1433)。模型的关键组成部分包括:

- 邻接矩阵 A:包含自环的节点连接关系矩阵

- 度矩阵 D:包含自环的节点度数对角矩阵

这些矩阵均为 N×N 维方阵,其中 N 为节点数量。模型中的关键矩阵维度如下:

- 初始特征矩阵 H^[0]:维度为 N×1433(N×C)

- 权重矩阵 W:维度为 1433×64(C×F,其中 F 为滤波器参数数量)

经过矩阵运算后,H^[1] 的维度变为 N×64。值得注意的是,D^~(-1/2)的两次相乘实现了对称归一化(或称重归一化),这一步骤对于平衡不同度数节点的影响至关重要。这种归一化操作的必要性在于 GCN 模型处理的是具有不同连接数量的节点,如果不进行归一化,高度数节点可能会在信息聚合过程中产生过度影响。消息传递通过归一化后的邻接矩阵 A 与特征矩阵 H[0]的乘法来实现,使得每个节点能够有效地聚合来自直接邻居的信息。

数值计算示例

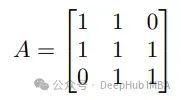

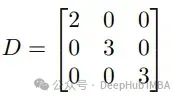

为了更直观地理解计算过程,我们考虑一个简化的三节点图(N=3),每个节点具有 2 维特征向量。该图包含自环连接,具体结构如下:

该图的基本属性:

邻接矩阵 A:3×3 维方阵(N×N)

度矩阵 D:3×3 维对角矩阵(N×N)

示例图的度矩阵表示

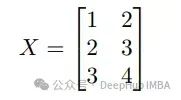

特征矩阵 X:3×2 维矩阵(N×C),每个节点包含 2 维特征向量(C=2)

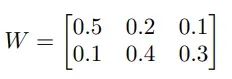

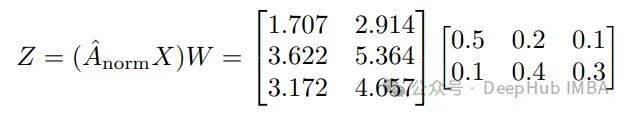

设定权重矩阵 W 为可学习参数(维度为 C×F),其中 F=3 为滤波器参数数量:

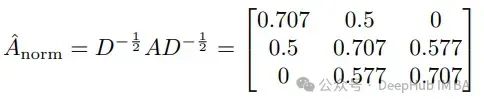

邻接矩阵归一化过程

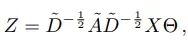

根据逐层线性模型的计算公式:

首先计算归一化邻接矩阵(Aˆ norm):

信息传递过程

权重变换

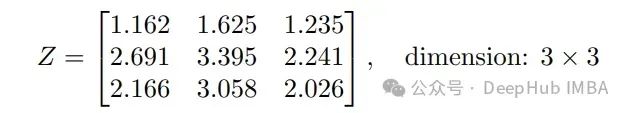

最终得到结果:

随后应用 ReLU 激活函数:σ(x) = max(0, x),由于本例中的值均为正数,因此结果保持不变。这样我就完成了第一层的传播计算,后续层的计算过程与此类似。

模型优化策略

优化在提升模型的表达能力和学习效果方面起着决定性作用。为了提高模型的准确性并降低计算复杂度,研究者们在不同层面上探索了各种优化策略,包括概念创新、模型改进、算法优化和参数调优等方面。这种持续的探索推动着领域的不断进步。

GCN 模型的发展历程充分体现了优化的重要性:最初基于谱方法的实现面临着较高的计算成本,图拉普拉斯算子特征基的计算复杂度接近 O(n³)。通过引入切比雪夫多项式近似并转向空间域计算,Kipf 和 Welling 成功将逐层线性模型的复杂度降低至 O(|E|CF),其中:

- E 表示图中边的数量

- C 表示输入特征的维度

- F 表示滤波器的数量[1]

值得注意的是,与物理学中具有明确物理意义且数量有限的参数不同,机器学习模型中训练的参数通常缺乏直观的物理解释,且数量级可达到百万量级,但仍能实现有效的预测。这反映了优化在提高模型效率和降低复杂度方面所发挥的重要作用。

总结

本文系统地阐述了图卷积网络的架构原理。通过简化数学表述并聚焦于矩阵运算的核心概念,详细解析了 GCN 的工作机制。Kipf 和 Welling 的工作展现了深刻的优化思想,他们成功将图卷积的谱方法应用于解决半监督节点分类问题,为图学习领域提供了重要的理论基础和实践参考。

参考

[1] T. Kipf and M. Welling, "SEMI-SUPERVISED CLASSIFICATION WITH GRAPH CONVOLUTIONAL NETWORKS." Available: https://avoid.overfit.cn/post/71eb88d58a85459b99dd8b7e46728c92