转载自:计算机视觉工坊

编辑:夏初

论文: A Mobile Robot Hand-Arm Teleoperation System by Vision and IMU

相关视频、代码、论文地址: 在公众号「计算机 视觉工坊」,后台回复「视觉和惯性传感器」,即可直接下载。

该研究提出了一种多模式移动遥操作系统,该系统由一个新颖的基于视觉的手势回归网络(Transteleop)和一个基于IMU的手臂跟踪方法组成。Transteleop通过低成本的深度相机观察人的手,并通过图像到图像的转换过程,不仅生成关节角度,而且还生成配对的机器人手姿势的深度图像。基于关键点的重建损失探索了人类和机器人手在外观和解剖结构上的相似之处,并丰富了重建图像的局部特征。穿戴式摄像机支架可实现同时的手臂控制,并促进整个远程操作系统的移动性。测试数据集上的网络评估结果以及除简单的取放操作之外的各种复杂操作任务,显示了多模式遥操作系统的效率和稳定性。

1.研究问题

拟人化机械手的遥操作以执行灵巧操作仍是挑战。无标记的基于视觉的遥操作具有成本低,侵入性小的强大优势。

问题a:由于机器人手和人手占据两个不同的领域,因此如何补偿它们之间的运动学差异在基于无标记视觉的遥操作中起着至关重要的作用。

问题b:远程操作员的手应停留在摄像机系统有限的视野范围内。这种限制阻碍了操作员完成需要广阔工作区域的操纵任务。

2.解决方法

解决方法a:提出了一种称为Transteleop的基于视觉的新型遥操作方法,该方法基于图像到图像的翻译方法提取配对的人和机器人手之间的连贯姿势特征。Transteleop将人手的深度图像作为输入,然后估计机器人手的关节角度,并生成机器人手的重建图像。本着监督学习的精神,为了增强从图像翻译结构中提取的特征的丰富性,研究人员设计了一个基于关键点的重建损失,以专注于手部关键点周围的局部重建质量。

解决方法b:为了实现真正的移动式手臂遥控操作系统,研究人员开发了一种摄像机支架,将摄像机安装在人的手臂上。

3.研究目标

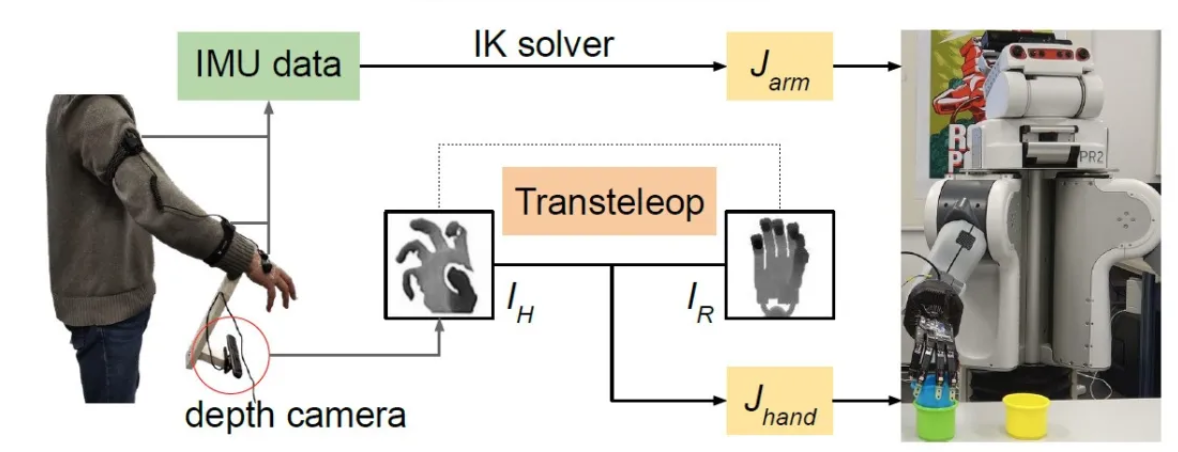

建立一个移动机器人手臂远程操作系统,其中远程操作员可以在无限的工作空间中进行自然的手部动作以完成一系列操作任务。为了建立这样的系统,研究人员制定了一种新颖的基于视觉的方法来对拟人化的手进行遥控操作,并利用基于IMU的设备来同时控制手臂。假设IH是人类的图像,展示了通过深度相机观察到的操作任务的手部姿势。视觉部分旨在训练输入IH并预测机器人关节角度Jhand的神经模型,而IMU部分则打算将人手臂的绝对运动映射到机器人手臂。

4.具体研究方法

4.1 Transteleop的提出和使用

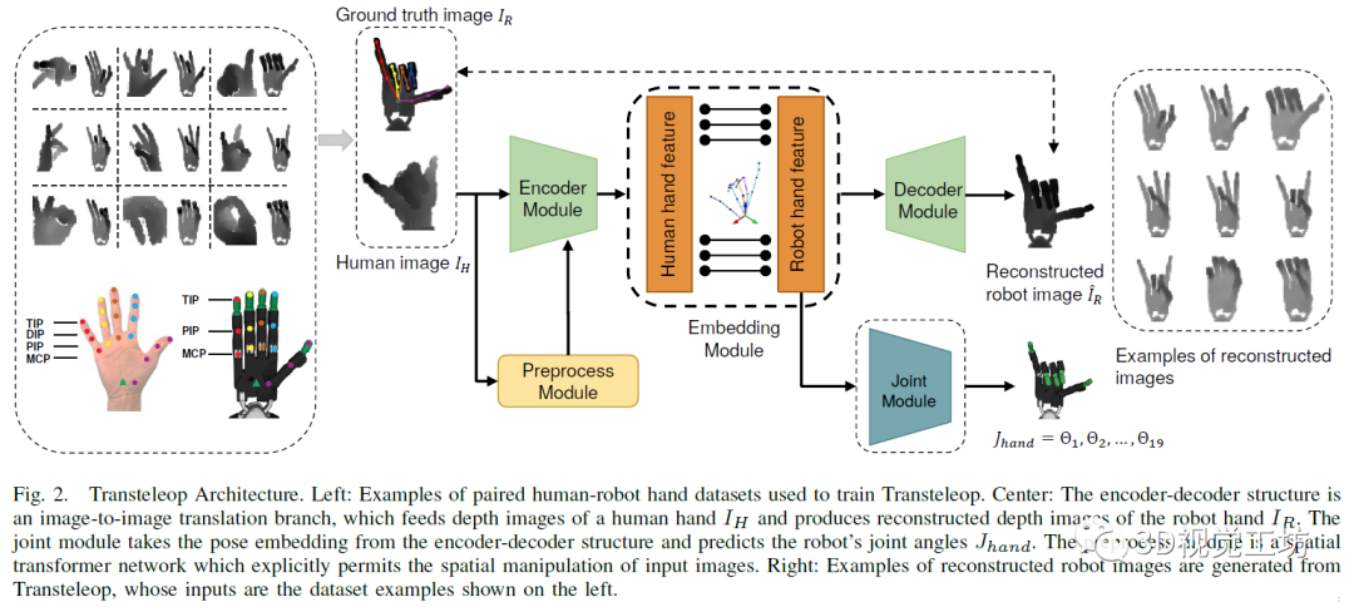

根据机器人和人的共享姿态特征Zpose可以获取Jhand(机器人关节角度)。文章采用了一种生成结构,该结构从图像IH映射到图像IR,并从该结构的瓶颈层检索姿态作为Zpose。网络结构如下图所示:

编码器-解码器模块:编码器从各种角度拍摄人手IH的深度图像,并发现人手和机器人手之间的潜在特征Zpose。研究人员使用六个卷积层,其中包含四个下采样层和两个具有相同输出尺寸的残差块。因此,给定大小为9696的输入图像,编码器将计算抽象66512维特征表示。考虑到数据集中的IH和IR中的像素区域不匹配,文章中使用完全连接的层而不是卷积层连接编码器和解码器。

解码器旨在根据潜在姿势特征Zpose从固定视点重建机器人手的深度图像。一层全连接层将要素从Zpose连接到机器人要素向量ZR。紧跟着的是具有学习滤波器的四个上卷积层和一个用于图像生成的卷积层。与其他图像翻译不同的是本文更加关注局部特征(例如指尖的位置)的准确性,而不是全局特征(例如图像样式)的准确性。研究人员设计了一个基于关键点的重建损失,以捕获手的整体结构,并专注于手的15个关键点周围的像素。每个像素误差的比例因子取决于该像素与所有关键点的距离,并认为每个关键点的八个相邻像素与这些关键点本身一样重要。

4.2手臂支架设计

手臂的移动比较大会导致遥控操作员的手很容易从摄像机的视野中消失,研究中通过便宜的3D打印摄像机支架解决了这个问题,该摄像机支架可以安装在远程操作员的前臂上,因此,相机将随手臂一起移动。

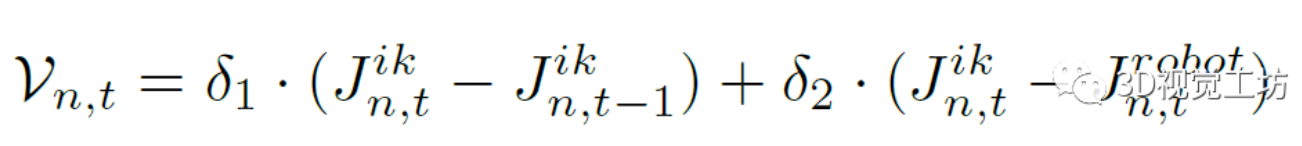

由于摄像机位置的不确定性,研究中使用惯性动作捕捉设备控制机器人的手臂,将可穿戴设备的全局坐标系设置为与机器人基坐标系平行。根据获取的旋转数据和机器人手臂的链接长度,计算出机器人的手腕姿势。通过将该姿势输入到BioIK解算器中来计算机器人手臂的关节角度。此后,研究人员通过计算和缩放当前帧和前一帧的期望关节角度之间的前馈关节差异以及期望关节角度之间的反馈关节差异来设置每个关节的角速度。

5.实验分析

输入的深度图像是从原始深度图像中提取出来的,大小调整为9696。为优化网络,研究中使用批训练随机梯度下降法,并应用Adam优化器,其学习率0.002和动量参数设置为0.5和0.999,并在每个卷积层之后添加一个批处理归一化(BN)层和一个修正线性单元(ReLU)。

1)网络框架对比

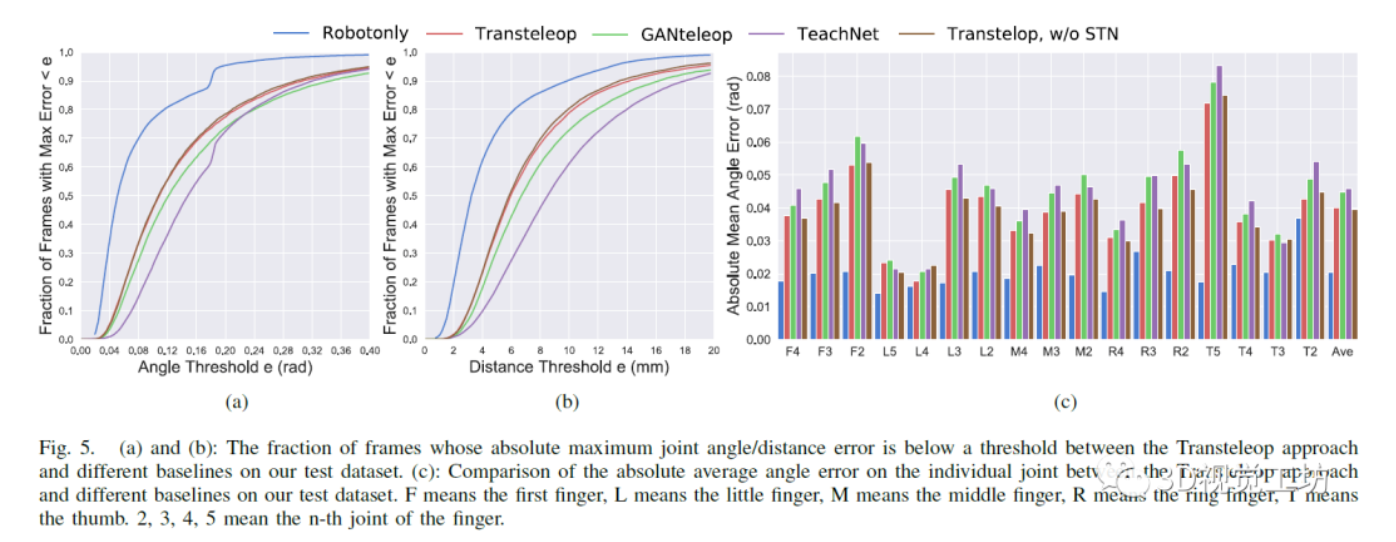

为了评估Transtelop是否可以学习指示性的视觉表示,研究中将Transtelop与两种网络结构进行了比较:TeachNet和GANteleop。为了显示来自机器人自身域的回归结果,研究中训练了一个模型Robotonly,该模型删除了Transteleop中的解码器模块,仅提供了机器人手的图像。为提供输入图像的空间变换功能,研究人员在Transteleop上增加了STN网络。

研究中使用手姿势估计中的标准指标评估了测试数据集上Transteleop和四个基线的回归性能:a.最大关节角度误差低于阈值的帧比例;b.最大关节距离误差低于阈值的帧比例;c.在所有角度上的平均角度误差。结果如下图所示:

实验结果分析:

由于具有匹配的域和相同的视角,因此,Robotonly模型在所有评估指标上均明显优于其他基准。Transtelop和GANteleop均在最大关节角度以下显示了平均10.63%的精度的提升,该精度高于TeachNet。研究人员推断,这两种图像到图像的转换方法都比TeachNet抓住了机器人更多的姿势特征。此外,GANteleop之所以比Transteleop差,是因为GANteleop中的判别网络专注于追求逼真的图像,并削弱了对关节的监督。比较Transtelop和不使用STN的Transtelop,即使使用了STN网络,也没有明显的改进。这表明附加的空间变换仅为该任务带来了一点外观标准化效果,但并未显着促进手部姿势变换为规范姿势。如上图(c)所示,所有方法联合回归的绝对平均误差均低于0.05 rad,最高误差发生在拇指关节5上,因为人的拇指与阴影拇指之间存在很大差异。

2)实验操作设置:

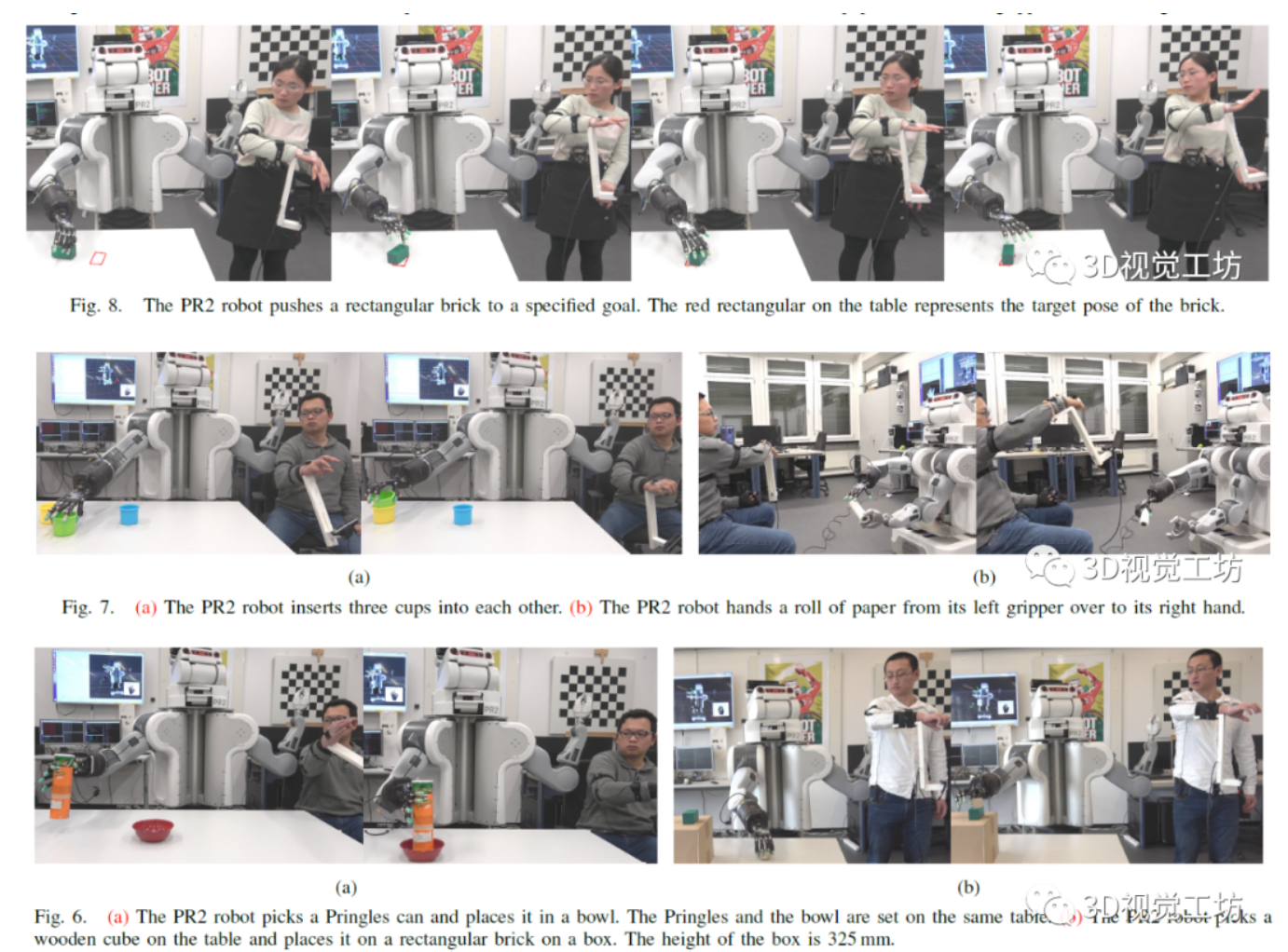

系统地评估了四种类型的物理任务,对多模型远程操作方法进行了分析,涉及精度和功率控制的分析,有力和无力操纵以及双臂交接任务的分析。

手臂的速度控制频率为20Hz,人手臂的起始姿势始终与机器人手臂的起始姿势一致。同时,机器人的手臂在每个任务上总是以几乎相似的姿势开始和结束,手部轨迹控制的频率设置为10Hz。一名女性和两名男性测试人员参加了以下机器人实验,并且其中每一项任务都是随机执行的。

1)取放。研究人员准备了两个测试方案:挑选一个薯条罐并将其放在同一张桌子上的红色碗中;在桌子上选择一个立方体,并将其放在方块的顶部。第一种情况需要机械手的动力掌握技巧,第二种情况需要机械手的精确掌握技巧,并为远程操作员提供足够的工作空间。

2)插入杯子。三个同心杯应相互插入。此任务检查精确掌握和释放的能力。

3)推动物体。研究人员设置方块的随机初始姿势,然后将方块推入指定的位置。此任务包含推动,滑动和精确抓握的挑战。

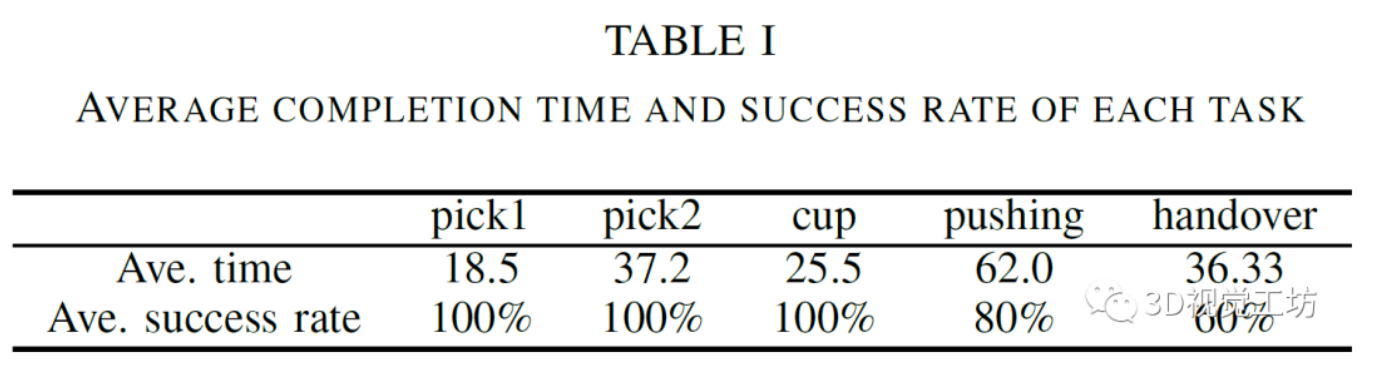

实验练习:操作员在实际测试之前对每个任务进行了五次非连续尝试的预热训练阶段。对于诸如拾取和放置之类的简单任务,经过三轮试验,操作员可以很好地完成任务。但是对于移交任务,遥控操作员进行了更多尝试,以适应手臂的相反操作方向。每个任务由一名演示者执行了五次。下表为实验结果:

上表显示了远程操作员完成任务所花费的平均时间以及成功率。完成时间是在机器人开始移动直到返回初始姿势时计算得出的。两项拾取和放置任务的成功率高且完成时间短,并且杯子插入任务表明系统具有精确性和力量把握能力。与拾取和放置任务相比,方块比碗小得多,因此机器人需要更长的时间才能找到放置立方体的宝贵位置。在推入任务期间,机器人可以使用多个手指将方块快速推入目标位置。然而,为了使推入误差小于5mm,操作者花费了很长时间来处理砖的方向。移交任务的成功率较低,主要是因为对左夹具的控制不精确,从而导致机器人意外丢失了物体。研究人员认为:基于视觉的方法比基于IMU的方法更适合于多指控制。

6.总结和未来工作

本文结合了基于视觉的联合估计方法,Transteleop和基于IMU的手臂遥操作方法,提出了一种手臂远程传送系统。

研究不足和研究计划:首先,摄像机支架给操作员带来了额外的负担,这在长期遥控操作过程中不舒服。其次,研究中缺乏手势控制,因此一些高精度的任务(例如开瓶和拧紧螺丝)对于当前系统仍然是棘手的。因此,研究人员计划收集一个手部运动数据集,更多地集中在拇指、无名指和中指的微妙姿势上。最后,研究人员希望可以通过滑动检测和力估计以减轻用户的控制负担并避免机器人的意外碰撞。

推荐阅读