报道:深度强化学习实验室

作者: 高新根博士(DeepRL-Lab研究员)

编辑: DeepRL

本文章读者能简单理解如下几个问题:

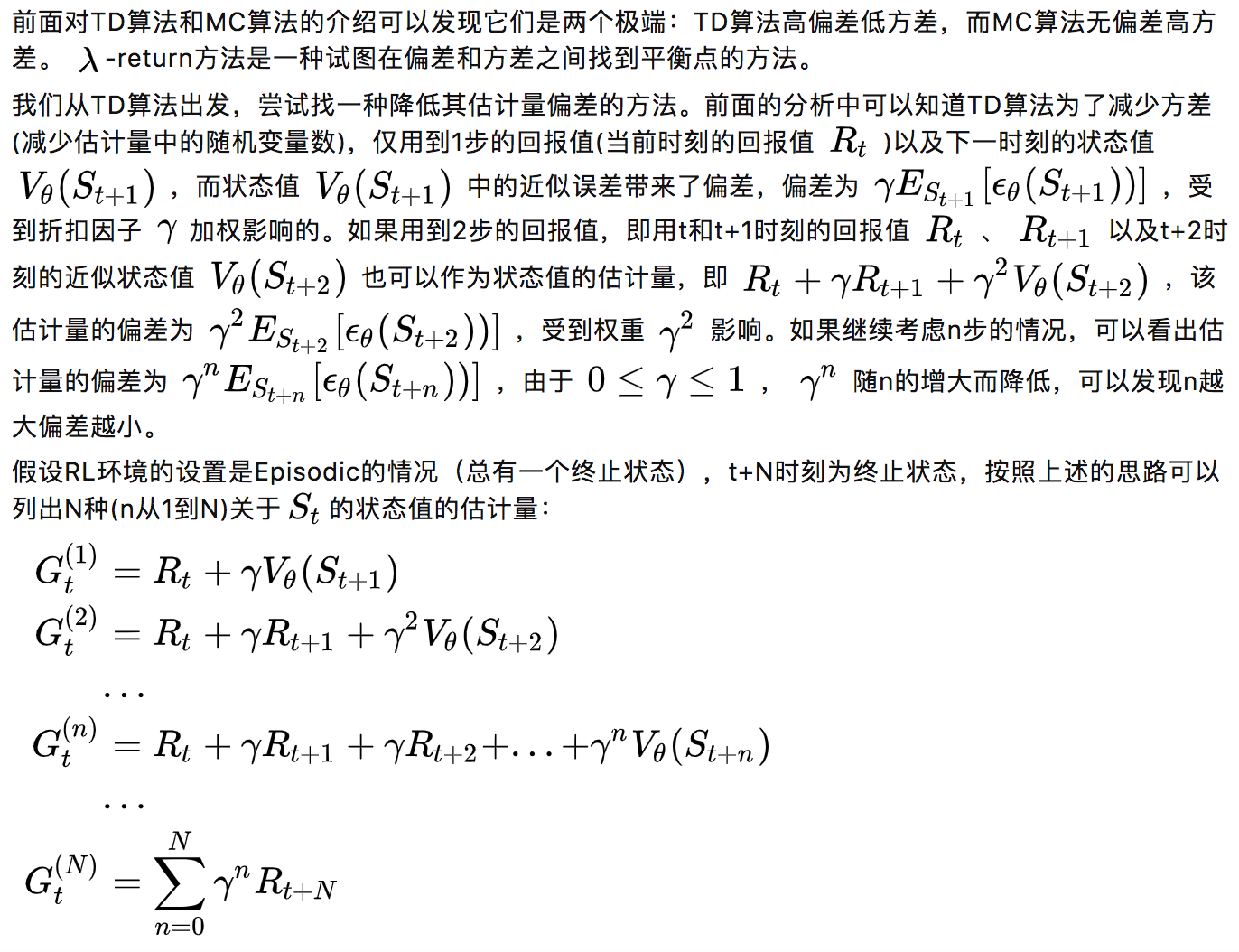

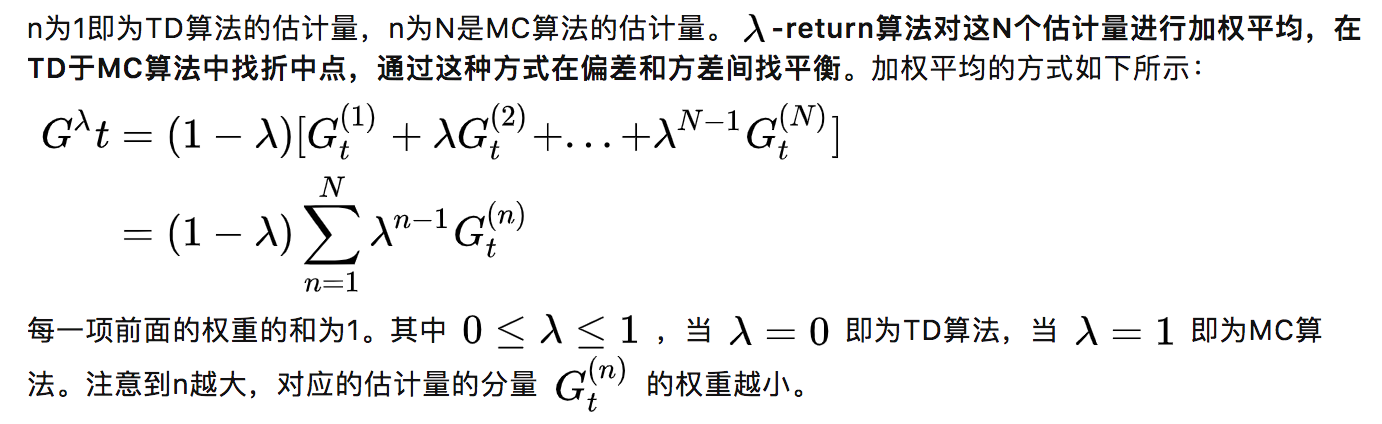

- 简单分析了这些方法偏差与方差的高低特点,比如为何说TD算法高偏差低方差。

- 简单梳理了这些方法之间的关系

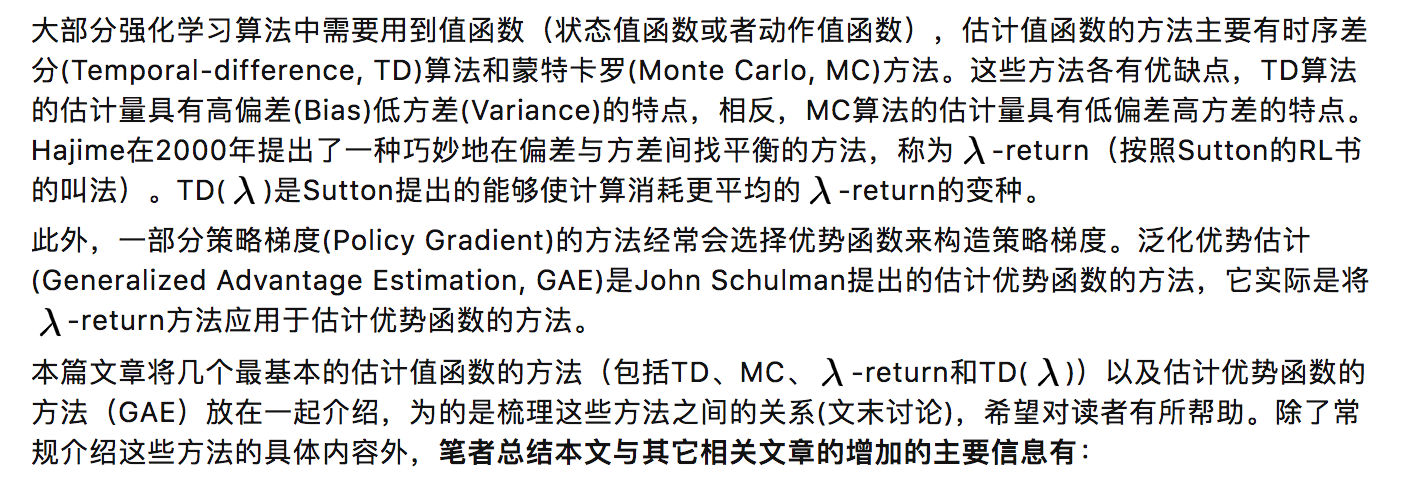

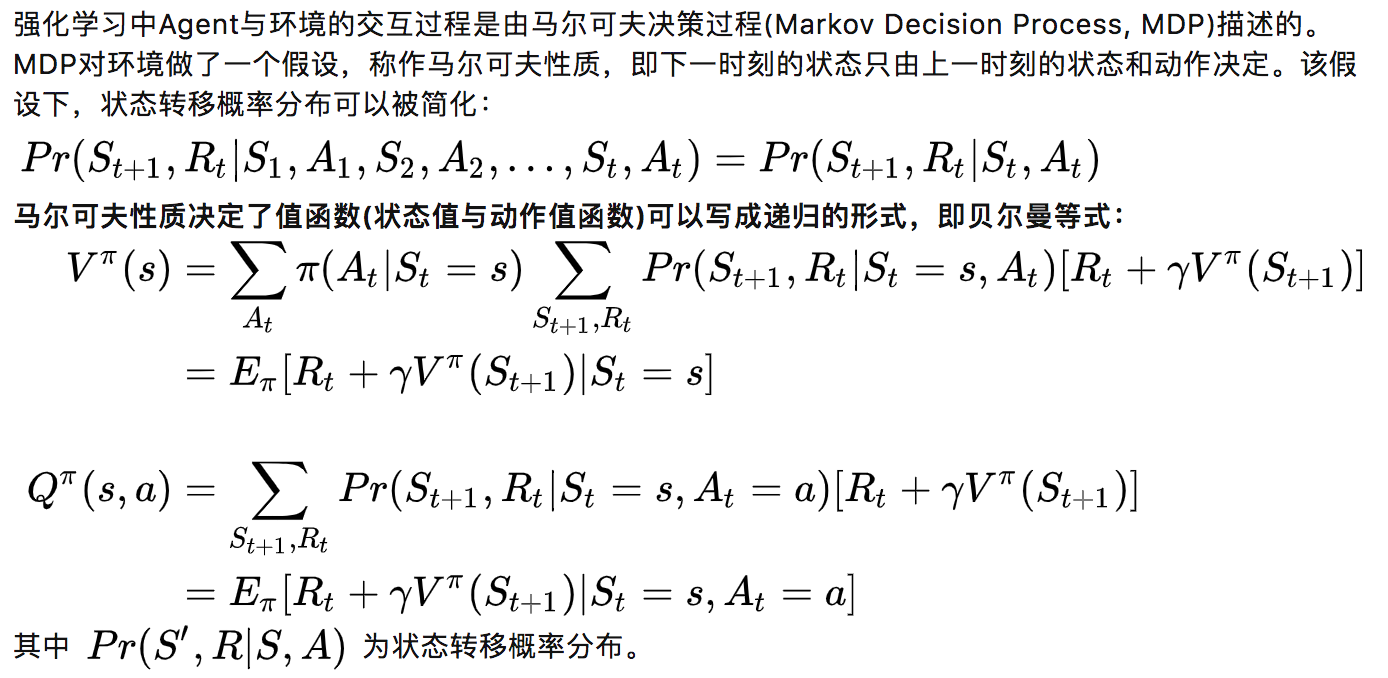

1.值函数的估计方法

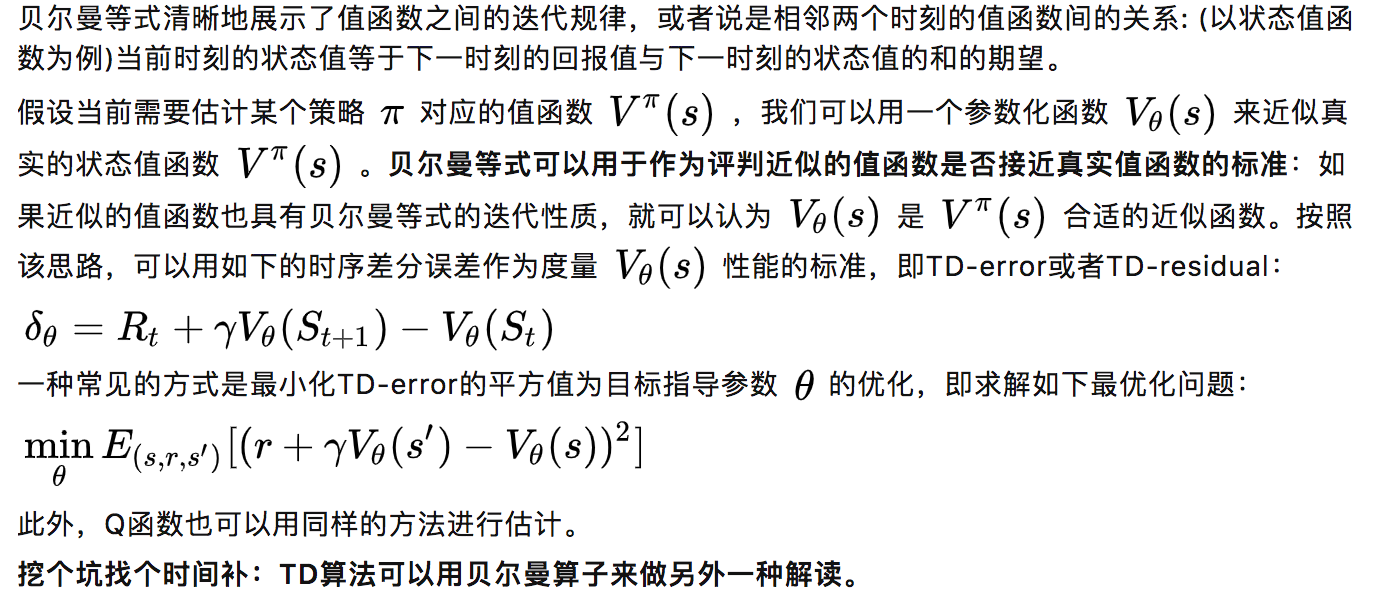

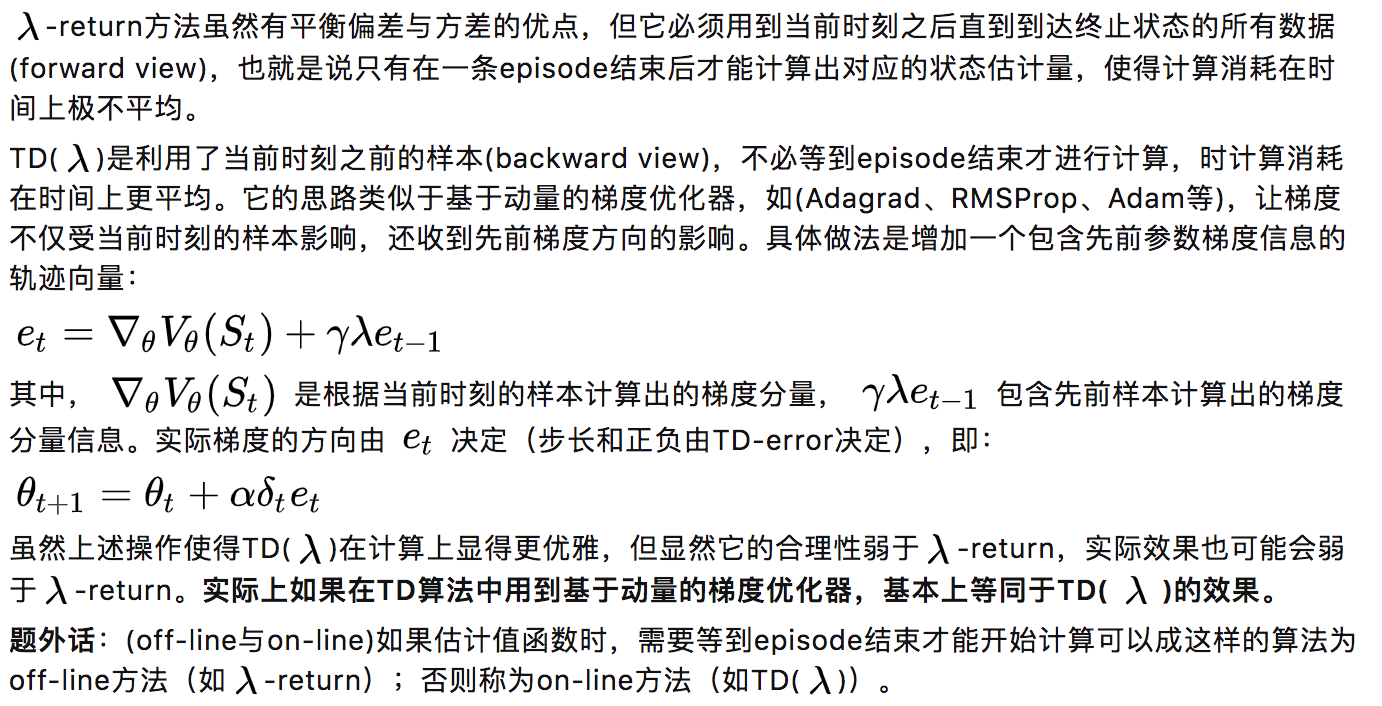

1.1 时序差分算法

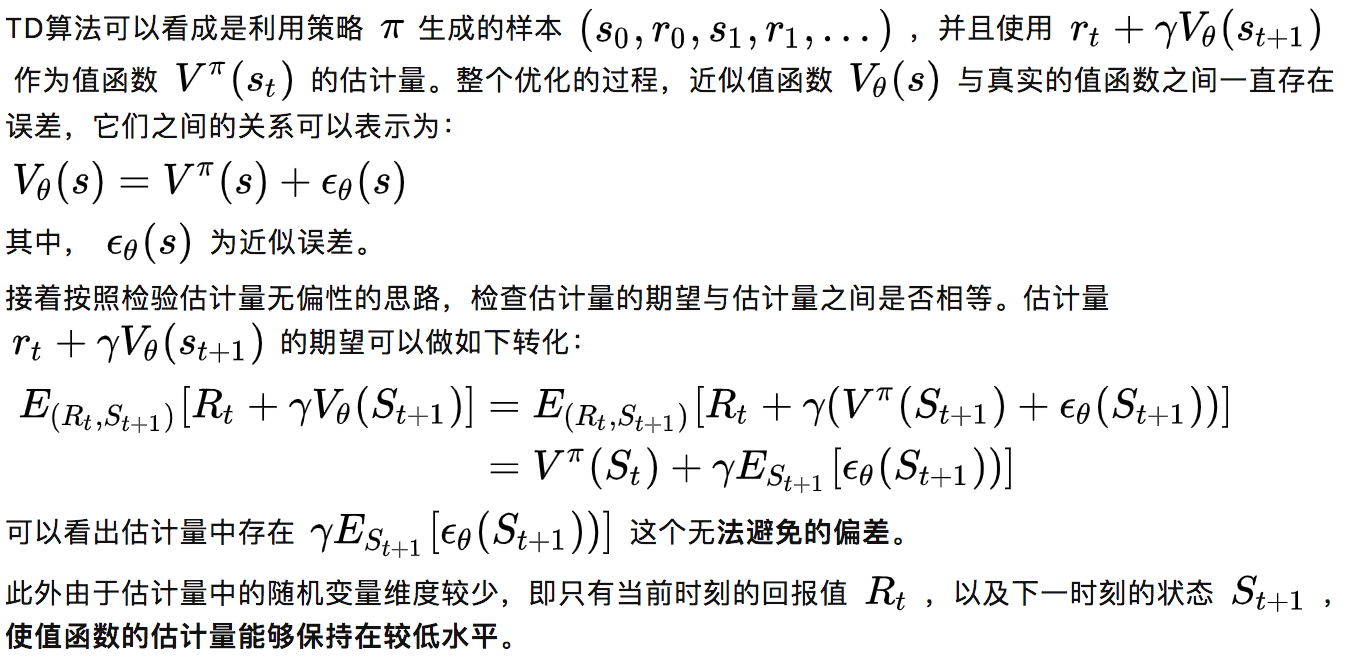

(3) TD算法的特点——高偏差低方差

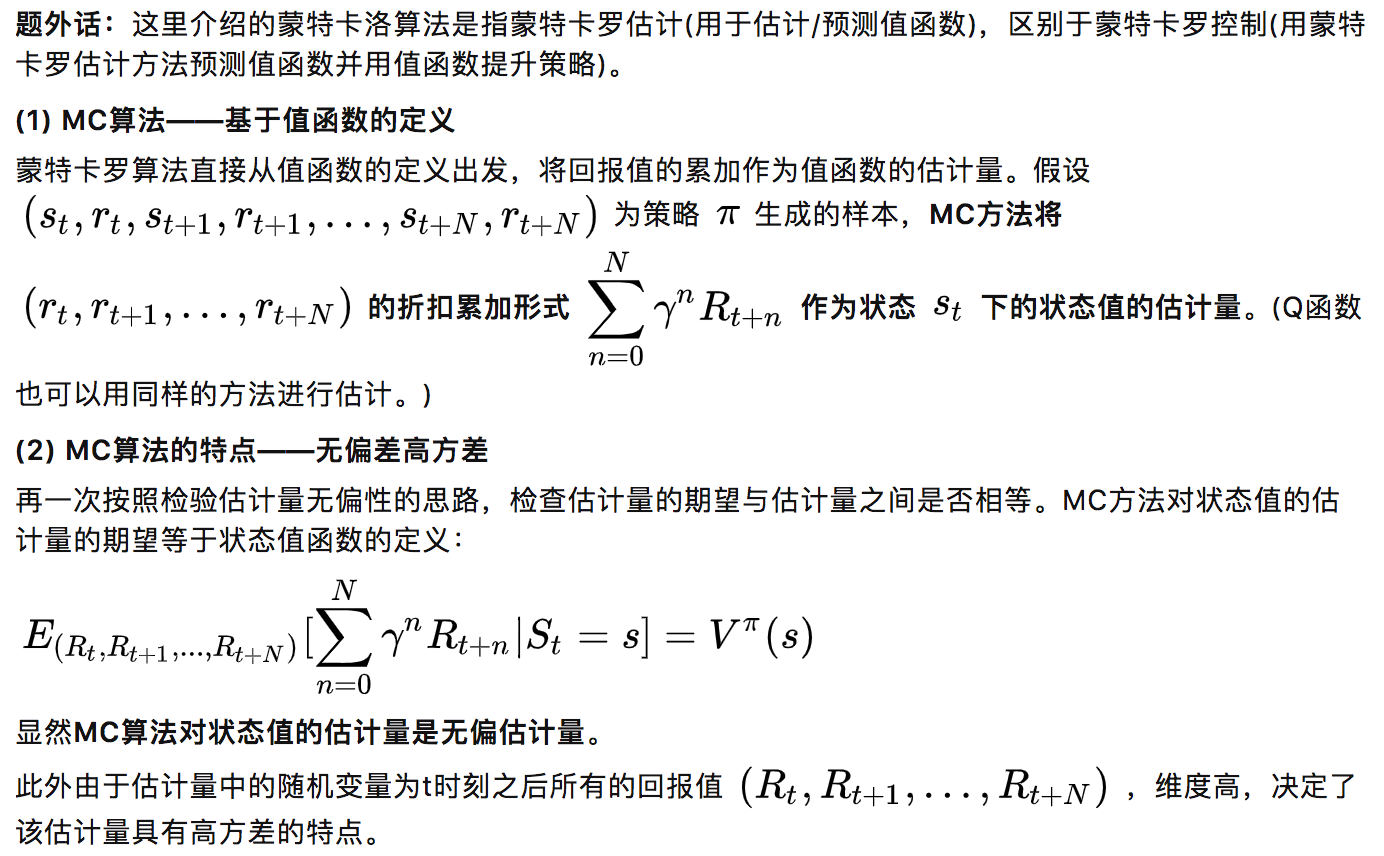

1.2 蒙特卡罗算法

2.优势函数的估计方法

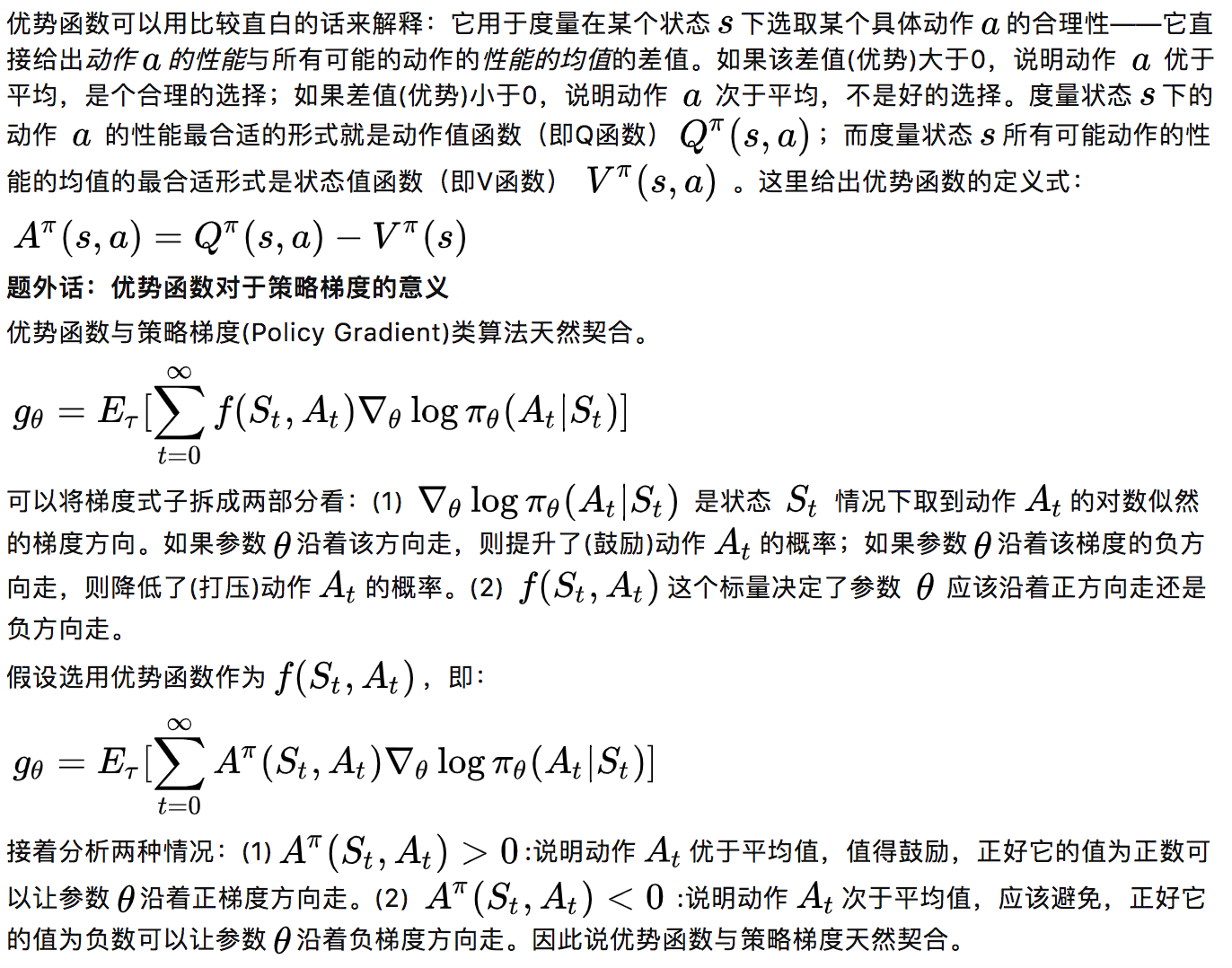

2.1 优势函数

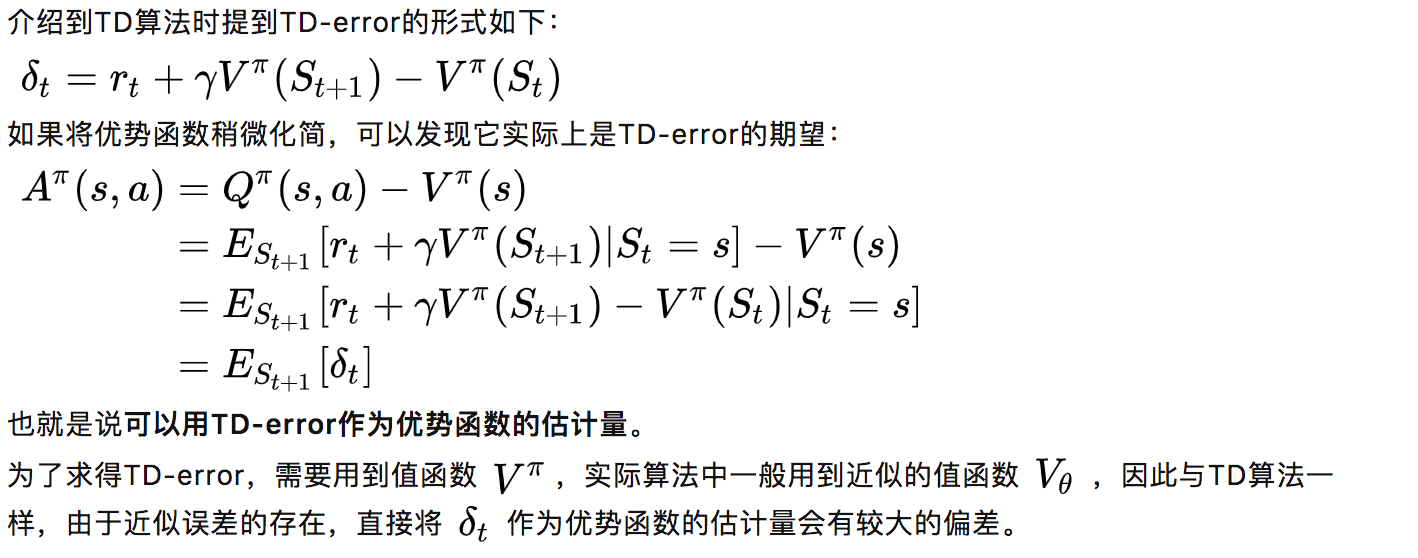

2.2 优势函数与TD-error

2.3 泛化优势估计(GAE)

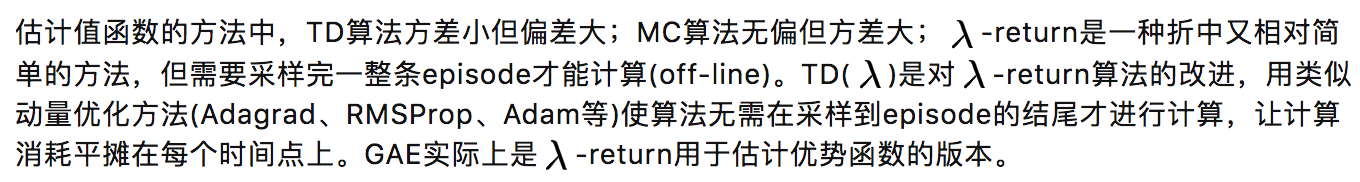

3.画重点

主要参考来源

Sutton R , Barto A . Reinforcement Learning:An Introduction[M]. MIT Press, 1998.

Schulman, John & Moritz, Philipp & Levine, Sergey & Jordan, Michael & Abbeel, Pieter. (2015). High-Dimensional Continuous Control Using Generalized Advantage Estimation.

Kimura, H. and S. Kobayashi. “An Analysis of Actor/Critic Algorithms Using Eligibility Traces: Reinforcement Learning with Imperfect Value Function.” _ICML_ (1998).

原文地址:https://zhuanlan.zhihu.com/p/345687962

完

推荐阅读

专注深度强化学习前沿技术干货,论文,框架,学习路线等,欢迎关注微信公众号。

更多深度强化学习精选知识请关注深度强化学习实验室专栏,投稿请联系微信 1946738842.