首发:AI公园公众号

作者:Stan Kriventsov

编译:ronghuaiyang

导读

一篇知识蒸馏+对抗训练的文章。

作者使用最近提出的MEAL技术(包括从多个大型老师网络使用蒸馏通过对抗学习得到更小的学生网络学习),使用224×224输入,在ImageNet上提升了ResNet-50的精度到80.67%, 没有外部训练数据和网络体系结构的修改。

从文章中我们能学到什么?

即使是一个相对较小的网络也可以通过训练用正确的方法达到大得多的网络的准确性。

在某种程度上,这并不奇怪,因为现代深层神经网络被设计成过参数化的,利用“彩票假说”描述的大量的随机初始化配置,一个更小的网络足以达到同样的性能,但是,在实践中可以实现还是非常了不起的。

先决条件(为了更好地理解论文,我们应该熟悉什么?)

- 知识蒸馏

- 对抗训练

讨论

集成技术,或集成学习,由多个ML模型的组合预测组成,是一种已知的提高预测精度的方法。它被广泛应用于Kaggle竞赛中,在这些竞赛中,即使以巨大的计算负载为代价,也要获得最佳的精度。然而,在大多数实际应用中,由于在预测期间运行每个模型所需的费用和时间,集成并不被广泛使用。

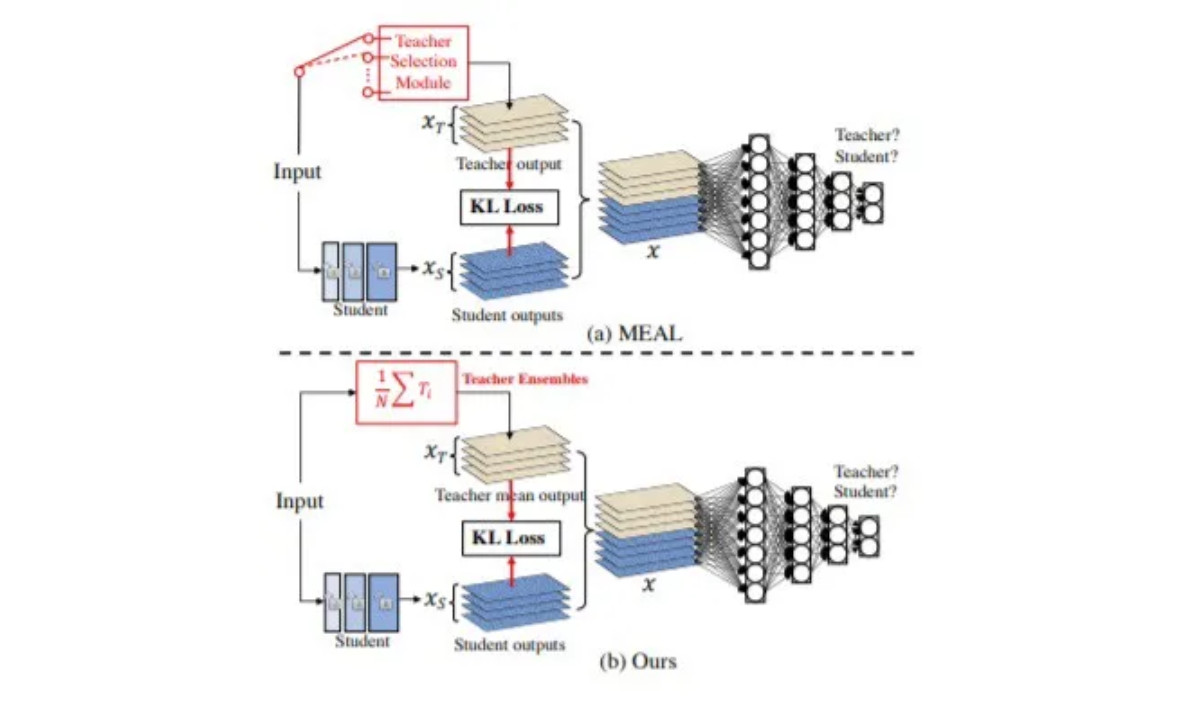

MEAL技术的想法,是从多个大型神经网络(教师)中提炼知识到一个更小的学生网络,从而创建一个计算高效的新模型,并具有集成模型的效果。学生网络与一个额外的鉴别器网络一起训练,该鉴别器网络用于区分学生网络各层产生的输出和每个输入的教师网络的相应输出。

本文作者简化了MEAL技术,只考虑每个网络的最终输出层的相似性(KL)的损失,并利用所有的教师网络的平均softmax概率,而不仅仅是使用一个教师网络在每一步进行训练。

使用这种方法,作者能够训练原始ResNet-50架构,在没有修改,没有外部训练数据以及各种技巧,比如AutoAugment,mixup,label smoothing的情况下,等达到精度(224×224输入图像)80.67%,这是目前为止这个架构迄今为止最好的结果。

本文表明,通过使用更大的(380×380)图像(81.72%)或使用更多的数据增强,如CutMix(80.98%),可以进一步提高该精度。

即使对小的MobileNet V3小和EfficientNet b0模型,这里提出的训练技术可以提升原始ImageNet精度约2.2%,显示了训练更小的模型可以达到几乎与大型网络一致的准确性的潜力,从而实现推理阶段的性能提升。

现在考虑到overparameterized最深层神经网络(为了找到一个更好的模型利用“彩票假说(https://www.dl.reviews/2020/0...”),这似乎是一个非常简洁的方式扩展生成的模型在保持精度。

希望通过进一步的研究来证实这种方法在实际工作中的可行性。

—END—

英文原文:https://medium.com/deep-learn...

关注图像处理,自然语言处理,机器学习等人工智能领域,请点击关注AI公园专栏。

欢迎关注微信公众号