近年来,强化学习在工业界和学术界受到广泛关注,在理论研究和实际应用方面均取得了瞩目的成就。然而强化学习目前尚存在诸多挑战问题亟待解决,包括数据利用率低,策略及知识迁移受限,多智能体强化学习信度分配等问题。在NeurIPS 2021中,诺亚方舟实验室强化学习方向共有7篇论文被接收。以上述挑战问题为起点,从有模型强化学习、多智能体强化学习、分层强化学习、部分可观测马氏决策过程高效搜索、以及多智能体零和博弈等多角度进行探索。相关工作在星际争霸、DMControl、华为供应链等多场景验证并取得了SOTA性能。我们选择了3篇代表性工作进行如下介绍。

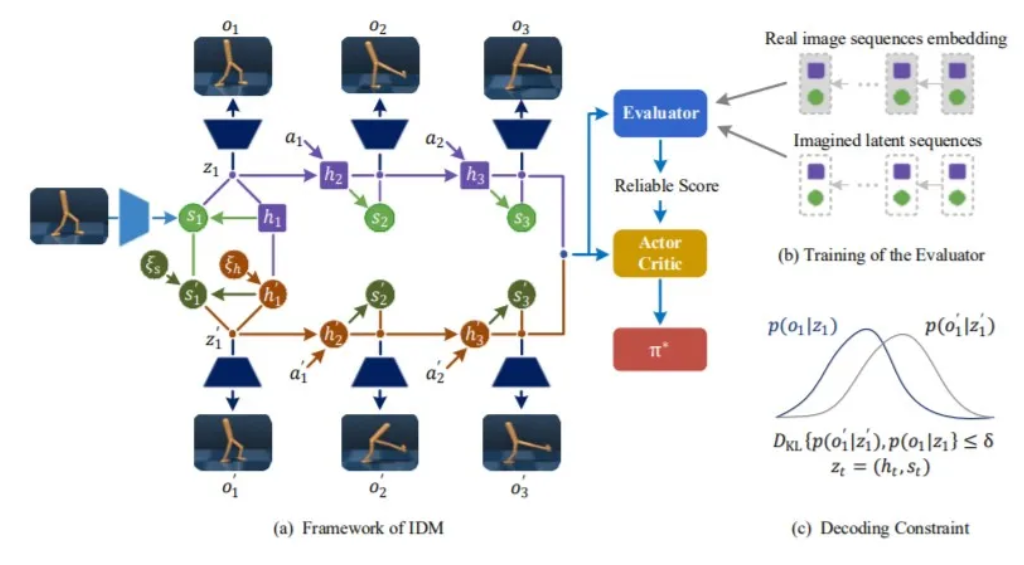

Model-Based Reinforcement Learning via Imagination with Derived Memory (IDM)

为了提高样本利用效率,基于模型的强化学习一直以来备受关注。根据智能体过往经验数据建立世界模型,基于模型产生虚拟轨迹再进行策略优化,类似人类的“想象”、“预判”和“规划”。而虚拟轨迹的多样性是决定样本效率和策略鲁棒性的重要因素。为了提升虚拟轨迹的多样性,受神经科学中记忆假体实验的启发,我们创新性的提出了从衍生记忆中想象未来轨迹的基于模型强化学习算法框架。与Dreamer等以经验池中存储的原始记忆为起点开始想象的方式不同,IDM首先在隐层空间生成区别于原始记忆的衍生记忆,然后再以衍生记忆为起点开始想象当前策略下的虚拟轨迹,以让智能体能够在隐层空间直接学习如何在真实世界中从未遇到过的场景中完成控制任务。为了保障用于策略优化的基于衍生记忆生成数据的可靠性,我们利用了两层算法机制:(1)在RSSM世界模型上添加了解码约束,用以保证衍生记忆可以对应到高维空间的真实可能存在状态避免解码失真;(2)所有虚拟轨迹均被赋予由评估器给出的预测可靠性权重,最优策略利用加权后的虚拟轨迹在Actor-Critic框架下迭代求解。在以视觉图像为输入的机器人控制任务DMControl上,该算法在样本效率和策略鲁棒性上均超越了当前最先进的基于模型强化学习算法。

A Hierarchical Reinforcement Learning Based Optimization Framework for Large-scale Dynamic Pickup and Delivery Problems.

物流运输作为供应链的核心环节,需要针对动态生成的订单,在满足资源约束的条件下,合理高效地分派订单给车辆,以此加快物资的流动速度,降低运输成本,保障后续生产顺利进行。该动态取送货问题本质上是一个NP-Hard的组合优化问题,其订单动态产生且存在多种复杂约束。针对该问题,我们首次提出了一个基于分层强化学习的优化框架。其中上层智能体根据订单超时风险,将整个动态问题切分为不同规模的静态子问题。下层智能体则针对每个子问题,进行快速局部搜索得到近似最优解,以完成车单匹配和车辆路径规划。该方法已部署于华为供应链订单调度系统中,相比于现有算法,订单总超时减少了超过20%,车辆平均行驶距离减少了超过10%,运输效率显著提升。目前诺亚方舟实验室已经开源了供应链仿真器,欢迎大家使用。https://github.com/huawei-noah/xingtian/tree/master/simulator/dpdp_competition

Setting the Variance of Multi-Agent Policy Gradients

策略梯度方法是常见的强化学习方法之一,其中基线函数通常用于减少梯度估计的方差。在多智能体强化学习中,虽然策略梯度定理可直接被扩展使用,但随着梯度估计的方差随着智能体数量的增加而迅速增加,多智能体策略梯度方法的性能会逐渐恶化。本文中,我们首先通过量化智能体数量及各智能体探索对多智能体策略梯度估计方差的贡献,对策略梯度方法进行了严格的分析。基于此分析,可获得实现最小方差的最佳基线函数。进而我们测量了现有多智能体强化学习算法如vanilla MAPG和COMA的过量方差。考虑到现有方法大多使用深度神经网络,为此我们提出了可以直接与现有多智能体强化学习策略梯度方法相兼容的代理最优基线函数。在多智能体MuJoCo和星际争霸基线任务上,所提方法有效地稳定了训练过程,并显著提高了MAPPO和COMA算法的性能。

【免责声明】

华为在本公众号所载的材料和信息,包括但不限于文本、图片、数据、观点、建议、网页或链接,虽然华为力图在网站平台上提供准确的材料和信息,但华为并不保证这些材料和内容的准确、完整、充分和可靠性,并且明确声明不对这些材料和内容的错误或遗漏承担责任,也不对这些材料和内容作出任何明示或默示的、包括但不限于有关所有权担保、没有侵犯第三方权利、质量和没有计算机病毒的保证。

华为可以在没有任何通知或提示的情况下随时对网站上的内容进行修改,为了得到最新版本的信息,请您定时访问本网站。华为(含其关联公司)在本网站上所提及的非华为产品或服务仅仅是为了提供相关信息,并不构成对这些产品、服务的认可或推荐。华为并不就网址上提供的任何产品、服务或信息做出任何声明、保证或认可,所有销售的产品和服务应受华为的销售合同和条款的约束。

推荐阅读

文章首发微信公众号,更多深度模型压缩相关的文章请关注深度学习压缩模型论文专栏。