在前面的文章中,已经带着读者创建好 Triton 的模型仓、安装并执行 Triton 推理服务器软件,接下来就是要安装 Triton 用户端软件,对服务器提出推理请求(requests),才能触发服务器执行推理计算的任务。

由于用户端的功能是在向服务器提出推理需求,本身并不参与计算,因此不用考虑设备性能或者是否装载 GPU 设备,即便是一台最基本的 Windows 上网本都能使用,只要安装合适的用户端软件就可以。

为了适应更多种使用场景,Triton 用户端支持 C++/Python/Java/GO 等通用性高的在编程语言,底层还支持 HTTP/REST 与 gRPC 通讯协议,甚至还支持 SSL/TLS 加密选项,以及多种在线压缩(on-wire compression)算法,内容是相当丰富并且多元化,完整的内容可以在 https://github.com/triton-inf... 开源仓里找到,本文只先提供 Python 用户端的部分。

与服务器的安装方式类似,NVIDIA 提供以下 4 种安装方式:

- 源代码编译

这种方式需要从 https://github.com/triton-inf... 下载源代码,执行步骤在 https://github.com/triton-inf... 环节,通常会遇到的麻烦是步骤繁琐,并且出错率较高,因此并不推荐使用这个方法。

- 可执行文件

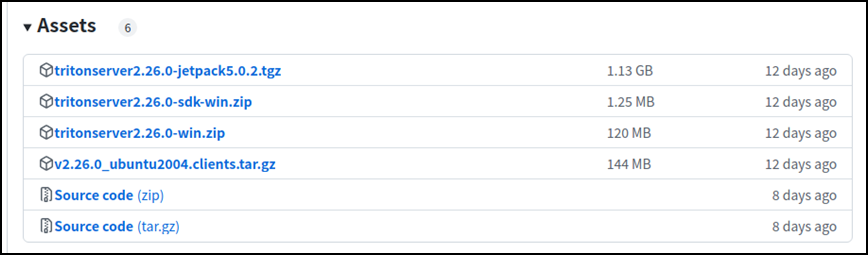

Triton 开发团队为使用者提供编译好的可执行文件,包括 Ubuntu 20.04、Jetpack 与 Windows 平台,可以在 https://github.com/triton-inf... 上获取,每个版本都会提供对应 NGC 容器的版本,如下图:

然后到下面的“Assets”选择合适的版本:

以装载 Jetpack 5 的 Orin 为例,就下载 tritonserver2.26.0-jetpack5.0.2.tgz(1.13GB) 压缩文件到本机上,然后解压缩到指定目录下就可以,例如 ${HOME}/triton 目录,会生成 <backends>、<bin>、<clients>、<include>、<lib>、<qa> 等 6 个目录,用户端的可执行文件在目录下,目前有将近 30 个终端功能。

现在要使用 image_client 这个最基础的识别终端软件,对 qa/images/mug.jpg(下图)这张图片进行推理。

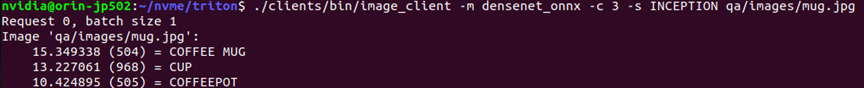

请先确认 Triton 服务器软件已经启动并且处于等待请求的状态,现在请开启另一个命令终端,输入以下指令提交推理请求:

cd ${HOME}/triton

./clients/bin/image_client -m densenet_onnx -c 3 -s INCEPTION qa/images/mug.jpg这道指令使用 clients/bin/image_client 终端,请求服务器使用 densenet_onnx 推理模型,对 qa/images/mug.jpg(下图)进行识别。这里的参数“-c 3”是要求识别的分类最多可以到 3 项,指令执行结果如下,表示正确识别图像的 3 个可能分类:

其他终端软件会在后面文章中说明。

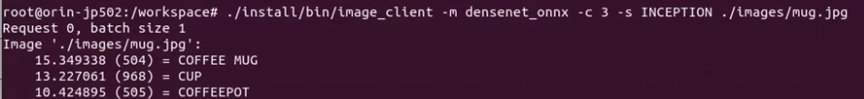

- Docker容器版用户端

在安装 Triton 服务器软件一文中已经提过,可以在 NGC 服务器上可以找到 Triton 的相关镜像,其中 year-xy-py3-sdk 里就有提供用户端软件。这里同样在 Jetson AGX Orin 上用 22.09-py3-sdk 镜像做示范,请先执行以下指令下载这个镜像并进入这个容器:

docker pull nvcr.io/nvidia/tritonserver:22.09-py3-sdk

docker run -it --rm --net=host nvcr.io/nvidia/tritonserver:22.09-py3-sdk进入容器之后,执行以下指令进行图像推理任务:

./install/bin/image_client -m densenet_onnx -c 3 -s INCEPTION ./images/mug.jpg执行结果应该会看到如下截屏的内容,表示在这里对 Triton 服务器提出的推理请求,得到正确的计算结果。

同样的,在容器内 install/bin 目录下也有将近 30 个编译好的终端可执行文件,内容与前一项压缩文件所提供的内容是一致的,在下一篇文章中进行说明。

- Python 版用户端

由于 Python 是目前在深度学习领域中最重要的编程语言之一,NVIDIA 为 Triton 提供可直接安装的 Python 库,只要执行以下指令就能轻松安装:

pip3 install tritonclient[all] attrdict -i https://pypi.tuna.tsinghua.edu.cn/simple这个过程会安装以下内容:

- http

- grpc [ service_pb2, service_pb2_grpc, model_config_pb2]

- utils [ Linux 发行版将包括 shared_memory 和 cuda_shared_memory]

如果您在前面下载第 2 部分的压缩文件并且解压缩,在该目录之下的 clients/python 里就提供 30 多个 Triton 的 Python 用户端脚本;如果没有下载前面的压缩文件,现在可以执行以下指令去复制 Triton 项目的 client 开源仓:

git clone https://github.com/triton-inference-server/client然后在 client 开源仓下的 src/python/examples 里有 30 多个 Triton 的 Python 用户端脚本。

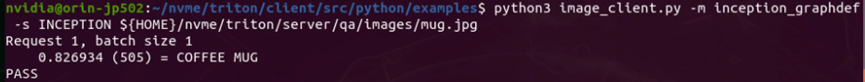

现在进到 Python 用户端脚本的目录里,执行以下指令:

python3 image_client.py -m inception_graphdef -s INCEPTION

${HOME}/triton/server/qa/images/mug.jpg执行后会显示如下的结果:

得到推理的结果为“COFEE MUG”为正确的,表示 Triton 的 Python 用户端使用环境是正确的。

以上介绍 4 种安装 Triton 用户端软件的方式,本文只使用 image_client 这个最简单的图像分类用户端工具,另外还有几个比较重要的用户端工具,后面会有针对性的深入讲解与示范。