转自AI Studio,原文链接:基于PaddlePaddle复现的PeleeNet - 飞桨AI Studio

PeleeNet: An efficient DenseNet architecture for mobile devices

1. 简介

这是一个PaddlePaddle实现的PeleeNet。

PeleeNet是一个高效的卷积神经网络(CNN)架构,由传统的卷积法构建。与其他高效架构相比,PeleeNet有很大的速度优势,可以应用于图像分类及其它的计算机视觉任务。

论文: PeleeNet: An efficient DenseNet architecture for mobile devices

参考repo: PeleeNet

在此非常感谢Robert-JunWang贡献的PeleeNet,提高了本repo复现论文的效率。

2. 数据集

数据集为ImageNet,训练集包含1281167张图像,验证集包含50000张图像。

│imagenet ├──train │ ├── n01440764 │ │ ├── n01440764_10026.JPEG │ │ ├── n01440764_10027.JPEG │ │ ├── ...... │ ├── ...... ├──val │ ├── n01440764 │ │ ├── ILSVRC2012_val_00000293.JPEG │ │ ├── ILSVRC2012_val_00002138.JPEG │ │ ├── ...... │ ├── ......

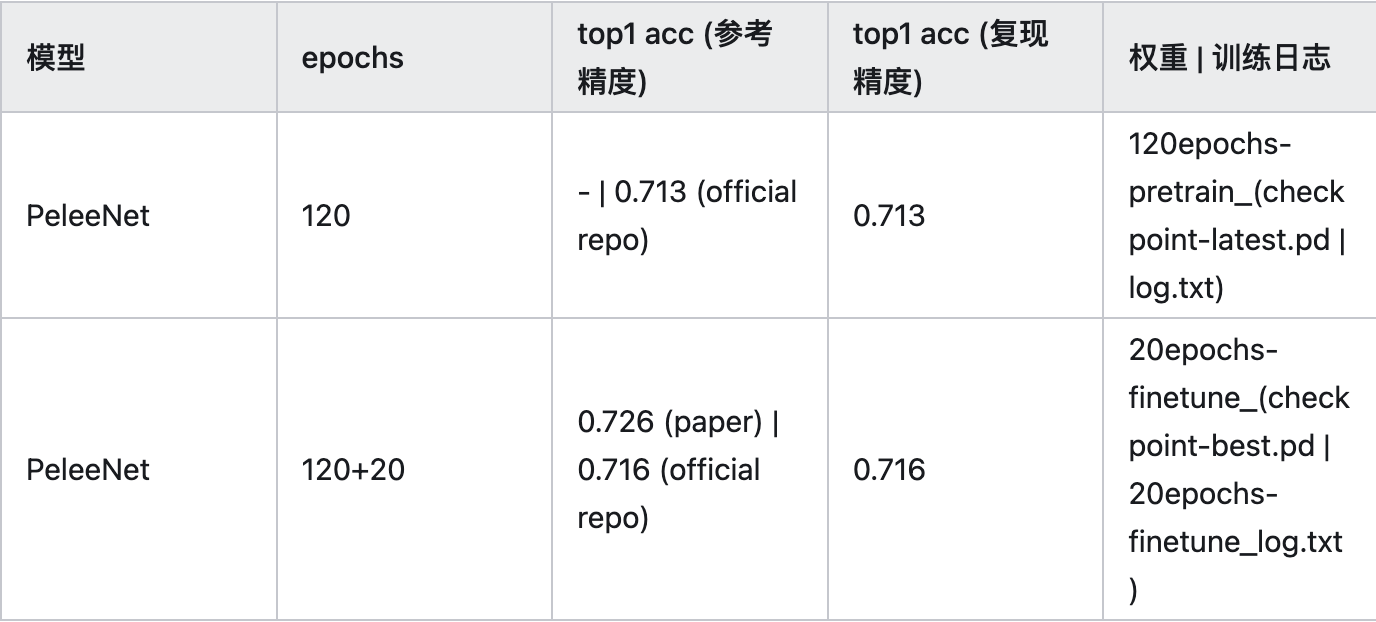

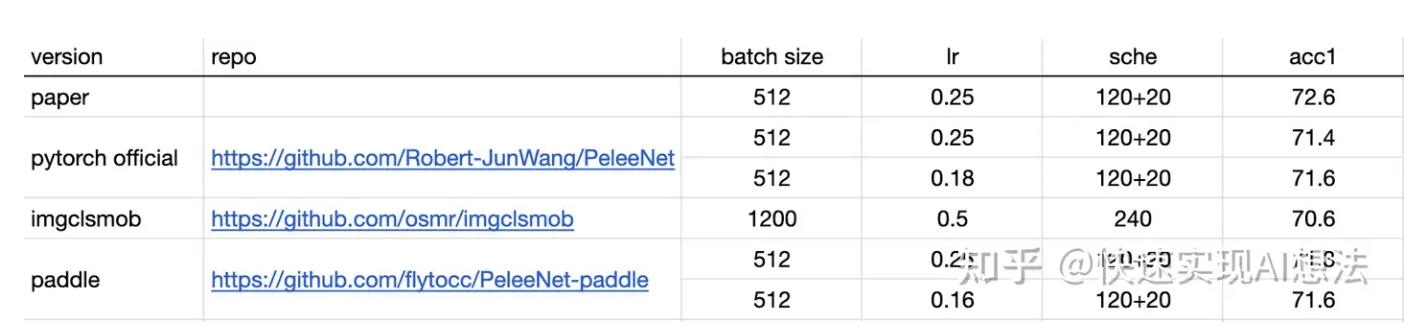

3. 复现精度

您可以从ImageNet官网申请下载数据。

权重及训练日志下载地址:百度网盘 or work/20epochs-finetune_checkpoint-best.pd

4. 准备数据与环境

4.1 准备环境

硬件和框架版本等环境的要求如下:

- 硬件:4 * V100

- 框架:

- PaddlePaddle >= 2.2.0

- 下载代码

In [1]

%cd /home/aistudio/ # !git clone https://github.com/flytocc/PeleeNet-paddle.git !unzip PeleeNet-paddle-master.zip

- 安装paddlepaddle

需要安装2.2及以上版本的Paddle,如果 # 安装GPU版本的Paddle pip install paddlepaddle-gpu==2.2.0 # 安装CPU版本的Paddle pip install paddlepaddle==2.2.0

更多安装方法可以参考:Paddle安装指南。

- 安装requirements

In [2]

%cd /home/aistudio/PeleeNet-paddle-master !pip install -r requirements.txt

4.2 准备数据

如果您已经ImageNet1k数据集,那么该步骤可以跳过,如果您没有,则可以从ImageNet官网申请下载。

如果只是希望快速体验模型训练功能,可以参考:飞桨训推一体认证(TIPC)开发文档

4.3 准备模型

如果您希望直接体验评估或者预测推理过程,可以直接根据第2章的内容下载提供的预训练模型,直接体验模型评估、预测、推理部署等内容。

5. 复现思路

5.1 使用paddle api实现模型结构

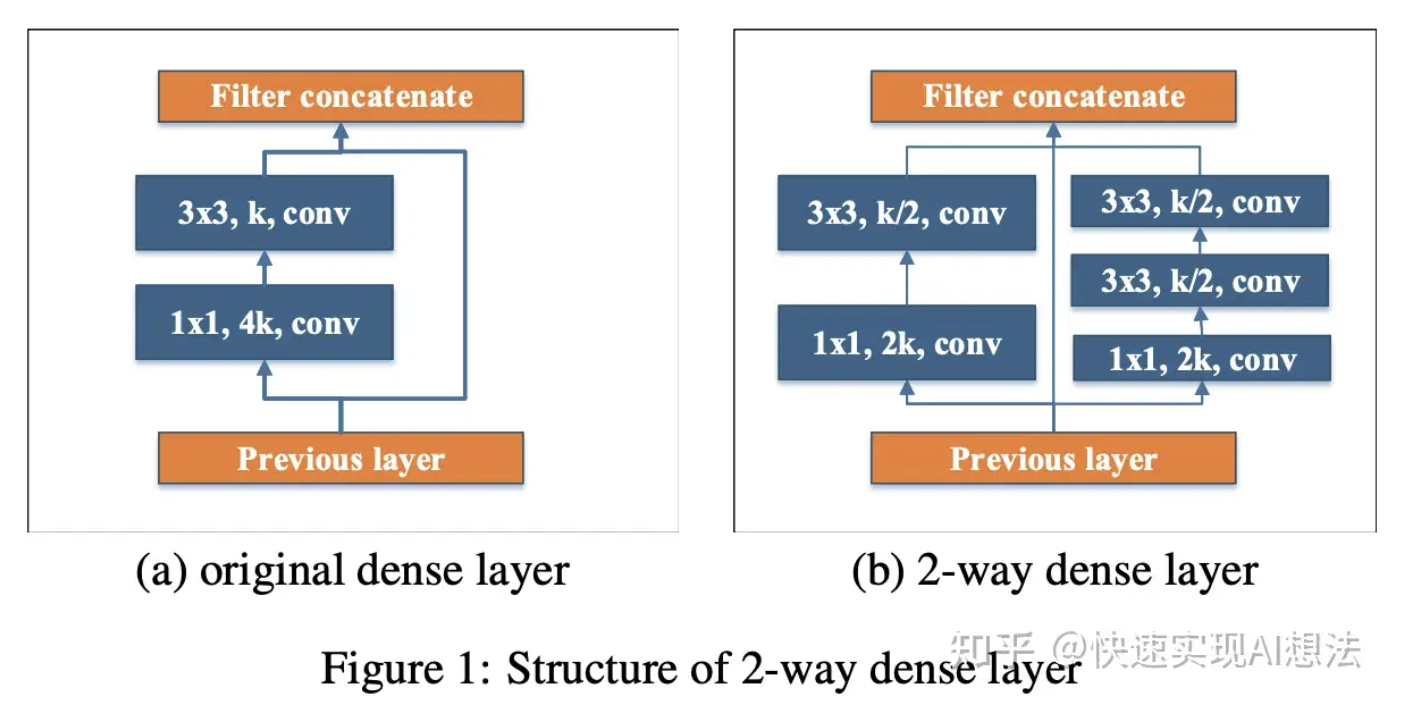

Two-Way Dense Layer

受Inception结构的启发,由两路分别捕捉不同尺度感受野信息的网络分支构成。第一路经过一层1x1卷积完成bottleneck之后,再经过一层3x3卷积;第二路则在bottleneck之后,再经过两层3x3卷积:

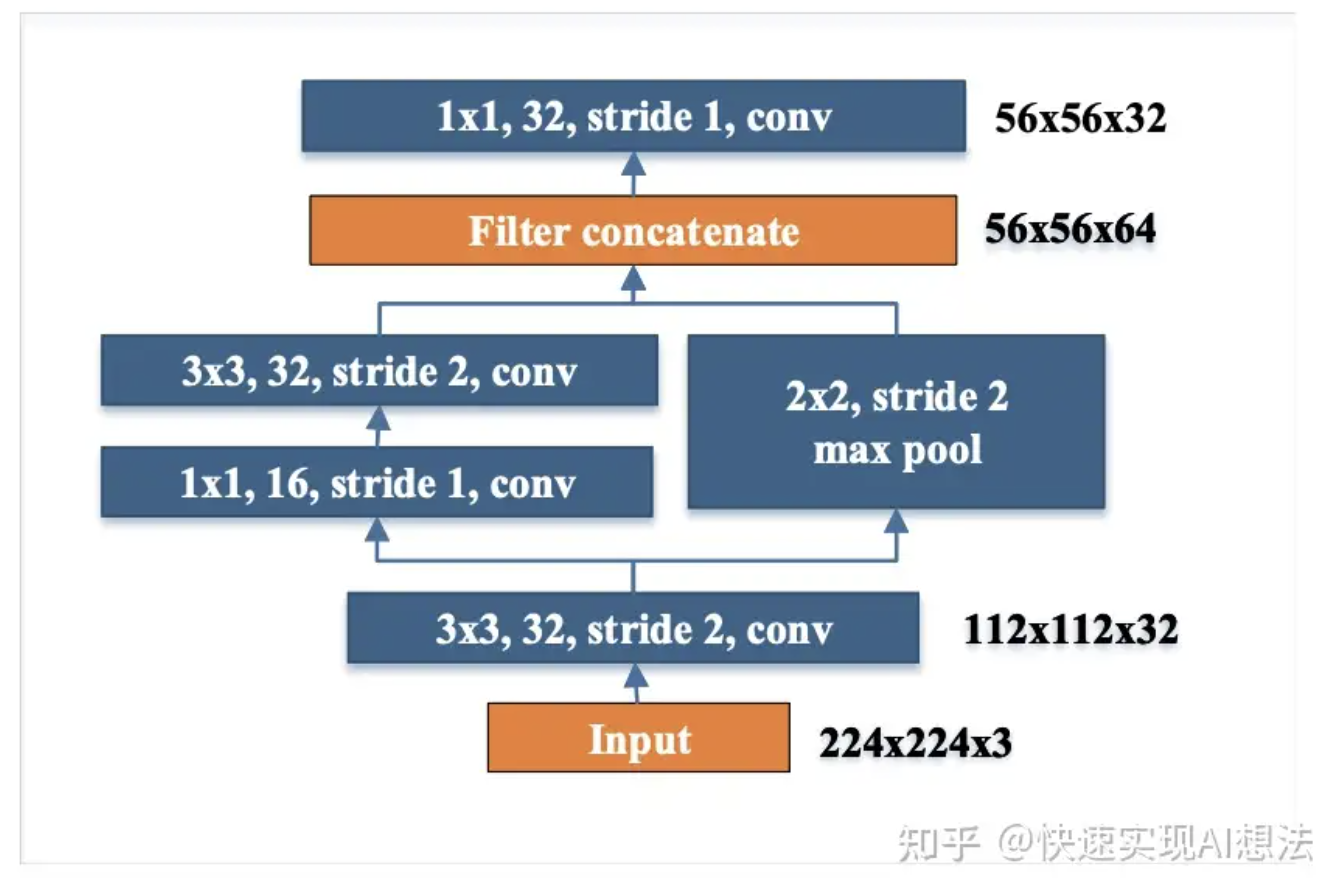

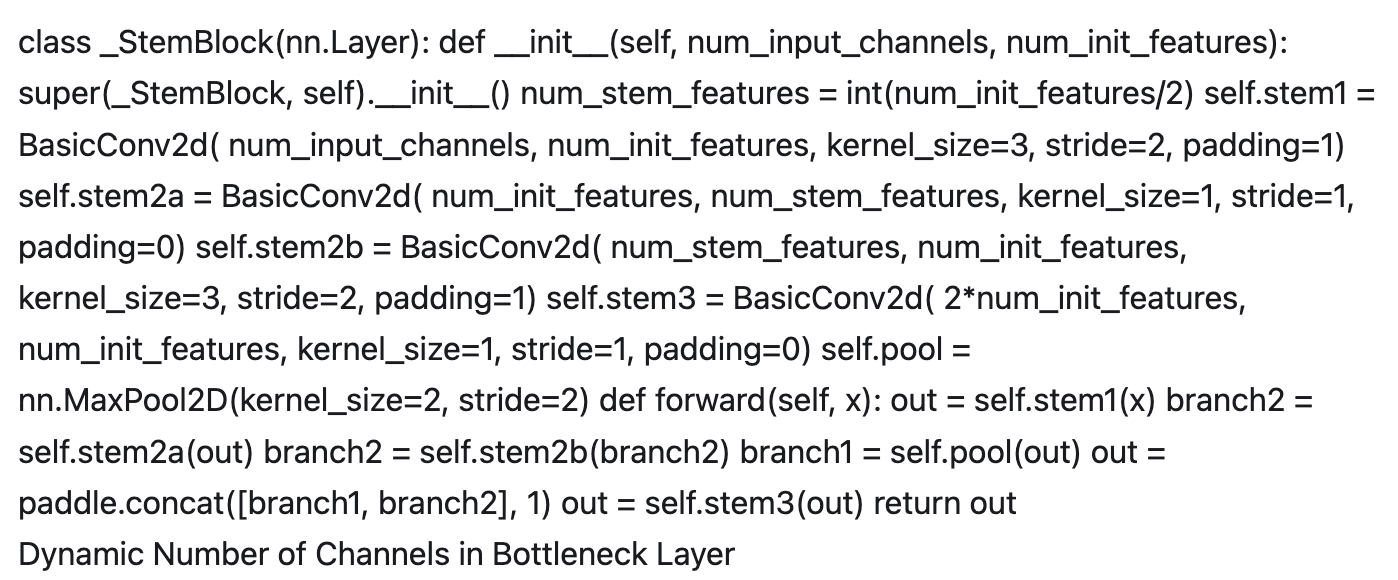

实现输入图像空间维度的第一次降采样(stride=2)和通道数的增加。并且在不增加较多计算量的前提下,该模块能够确保较强的特征表达能力:

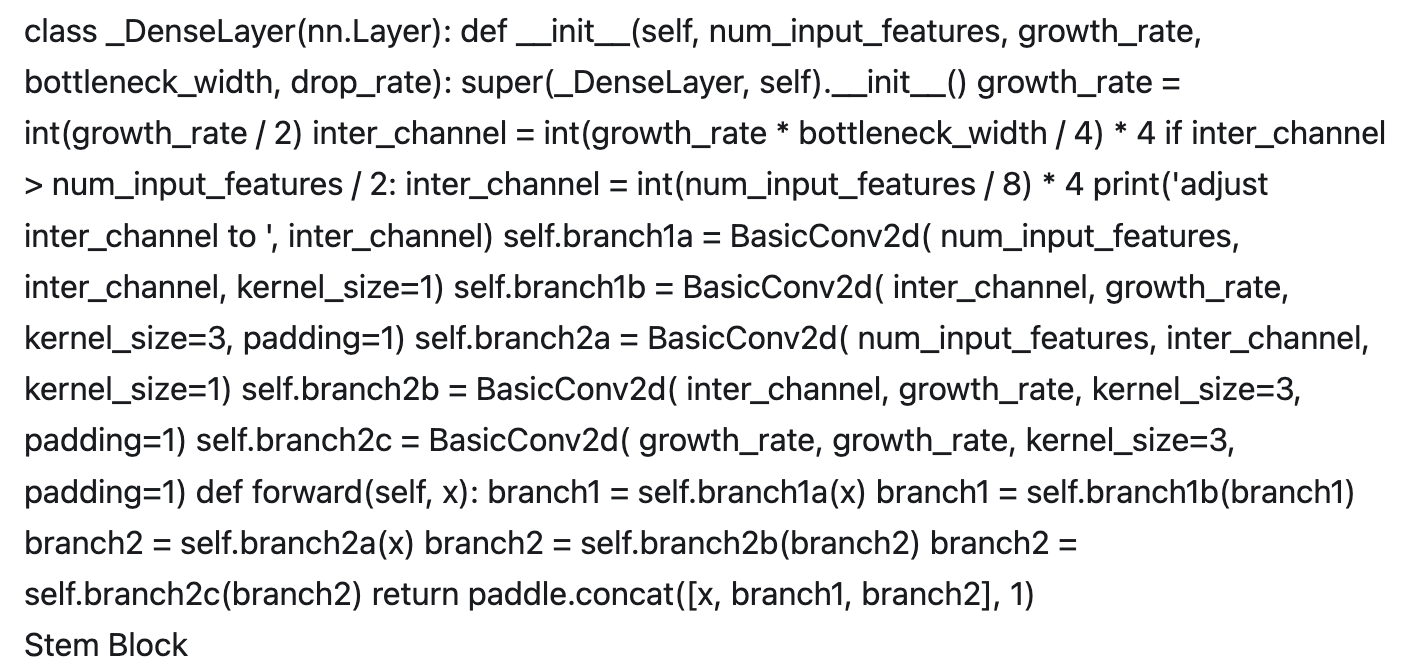

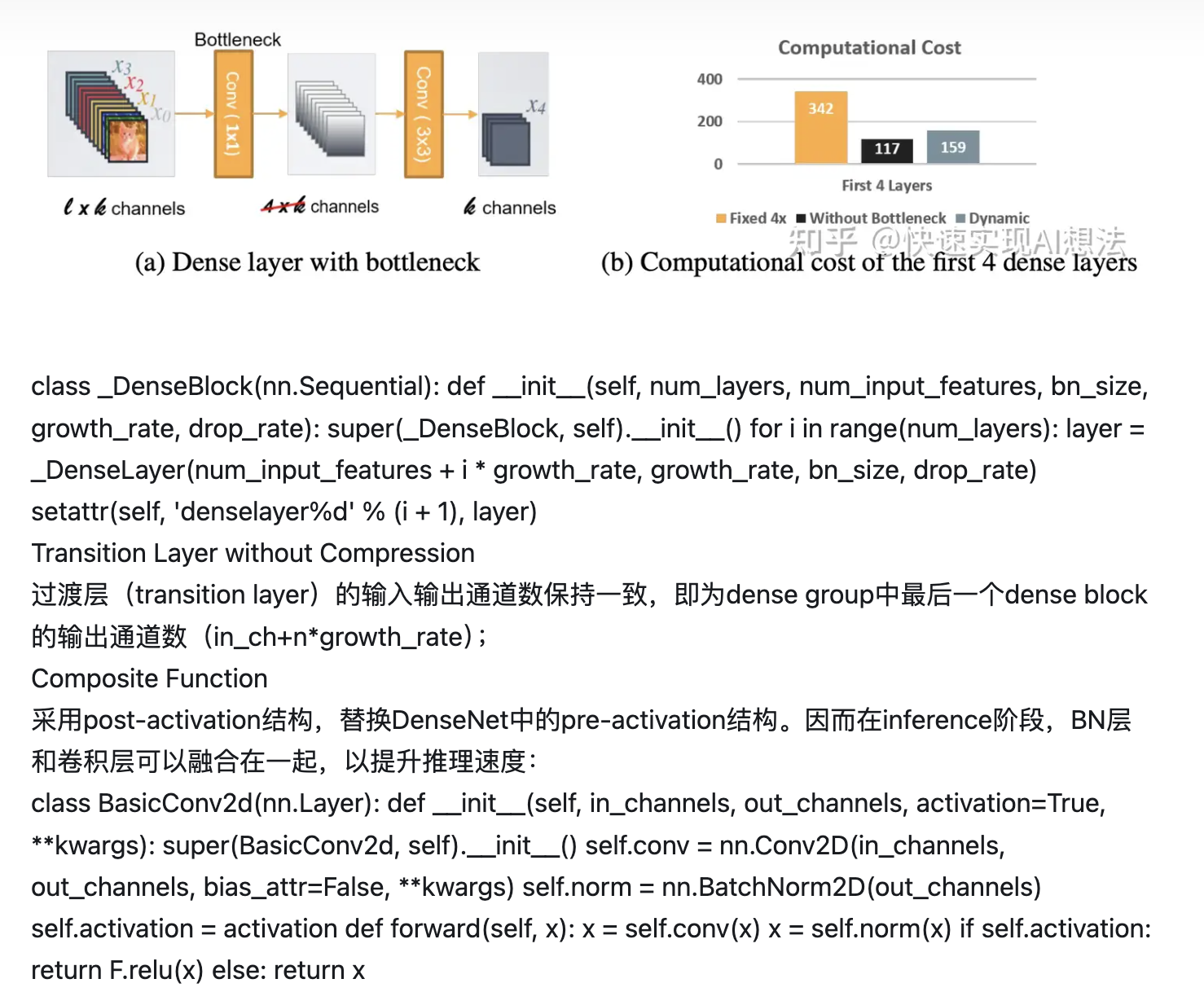

瓶颈层(1x1卷积层)的输出通道数随输入形状而变化,而并非DenseNet中growth-rate的4倍(growth_rate表示每经过一个dense block,所增加的通道数),从而确保瓶颈层的计算量不会显著增加:

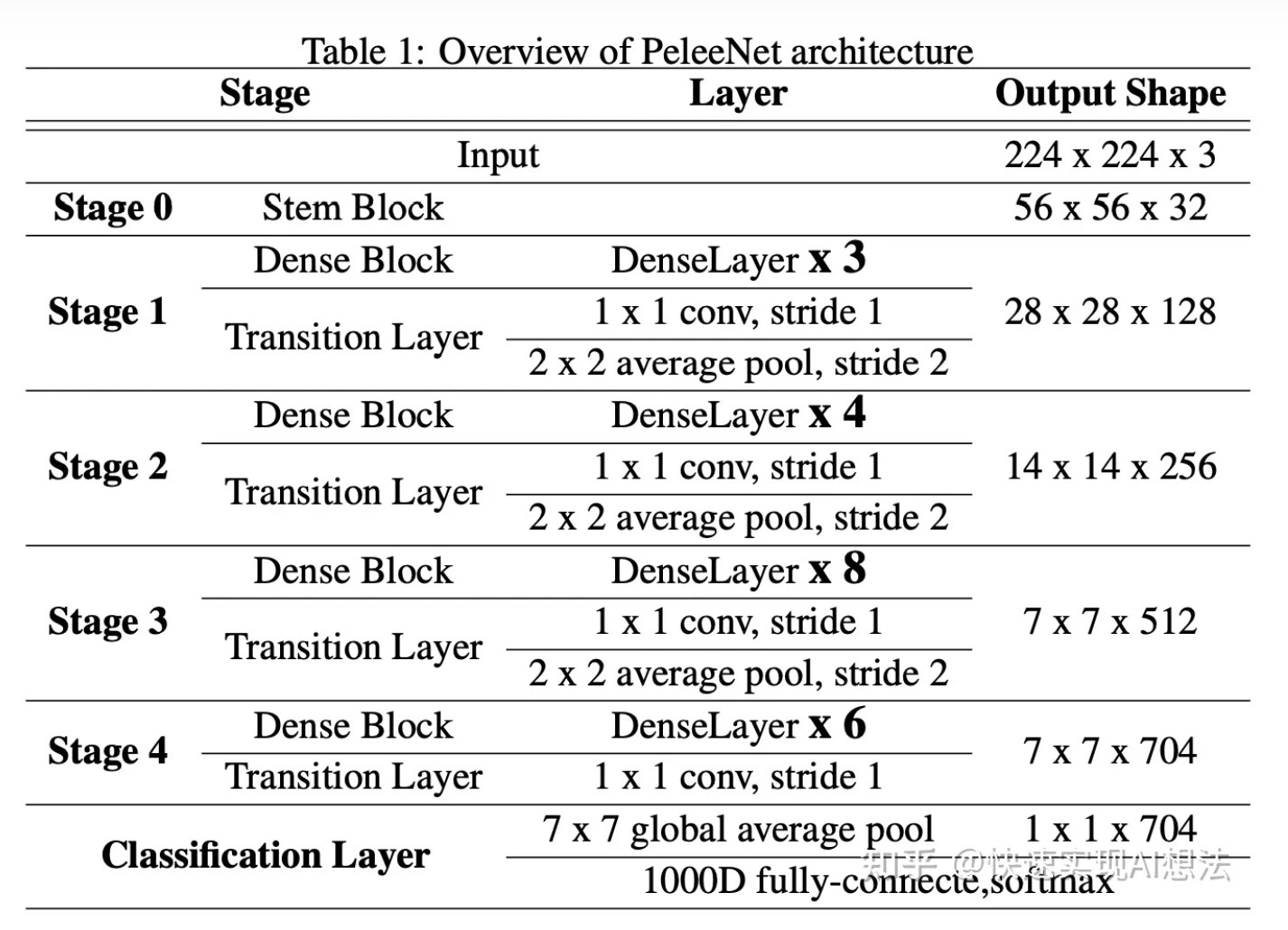

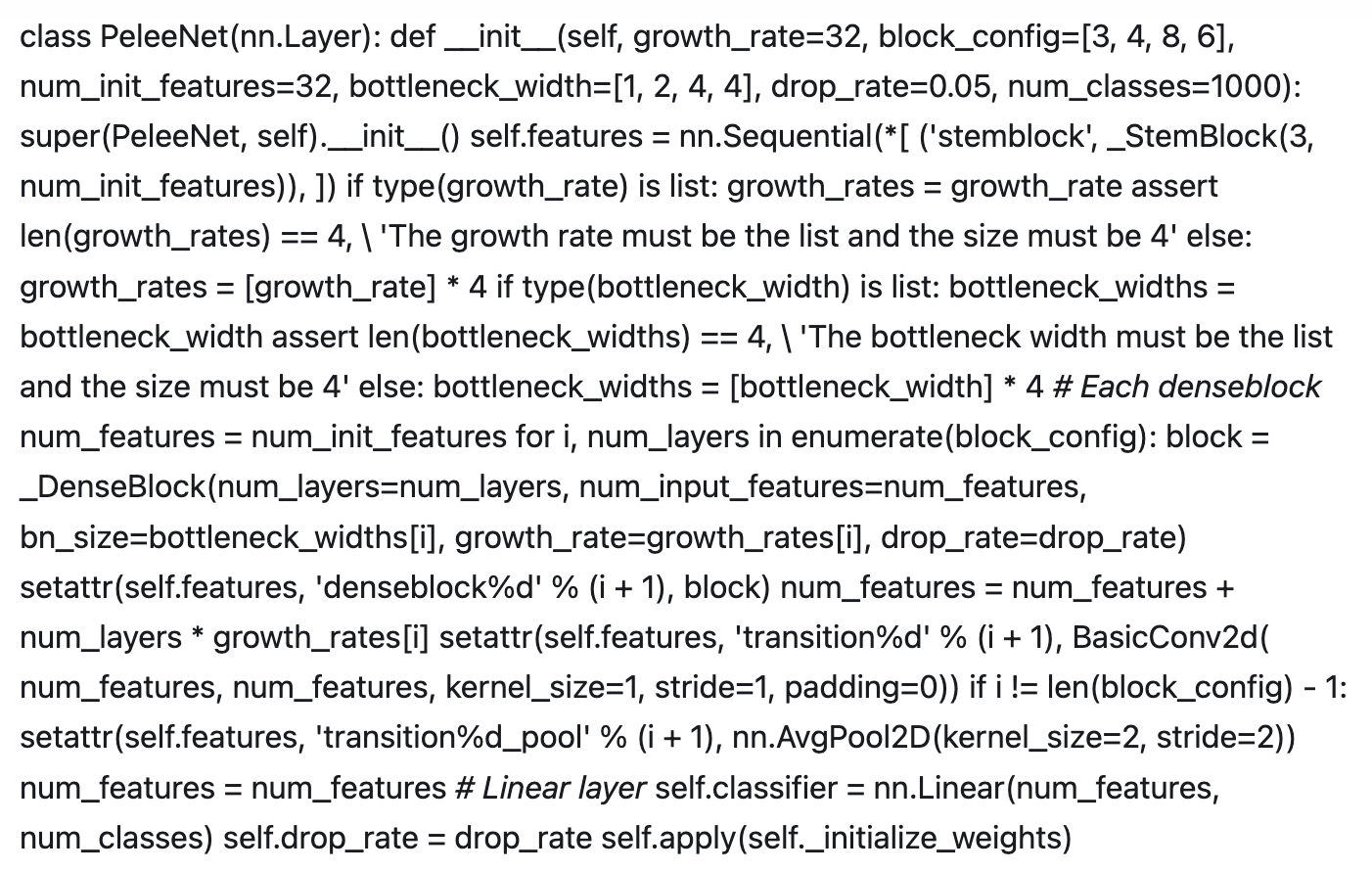

总体结构

基于上述改进,Pelee分类网络的总体结构如下:

6. 开始使用

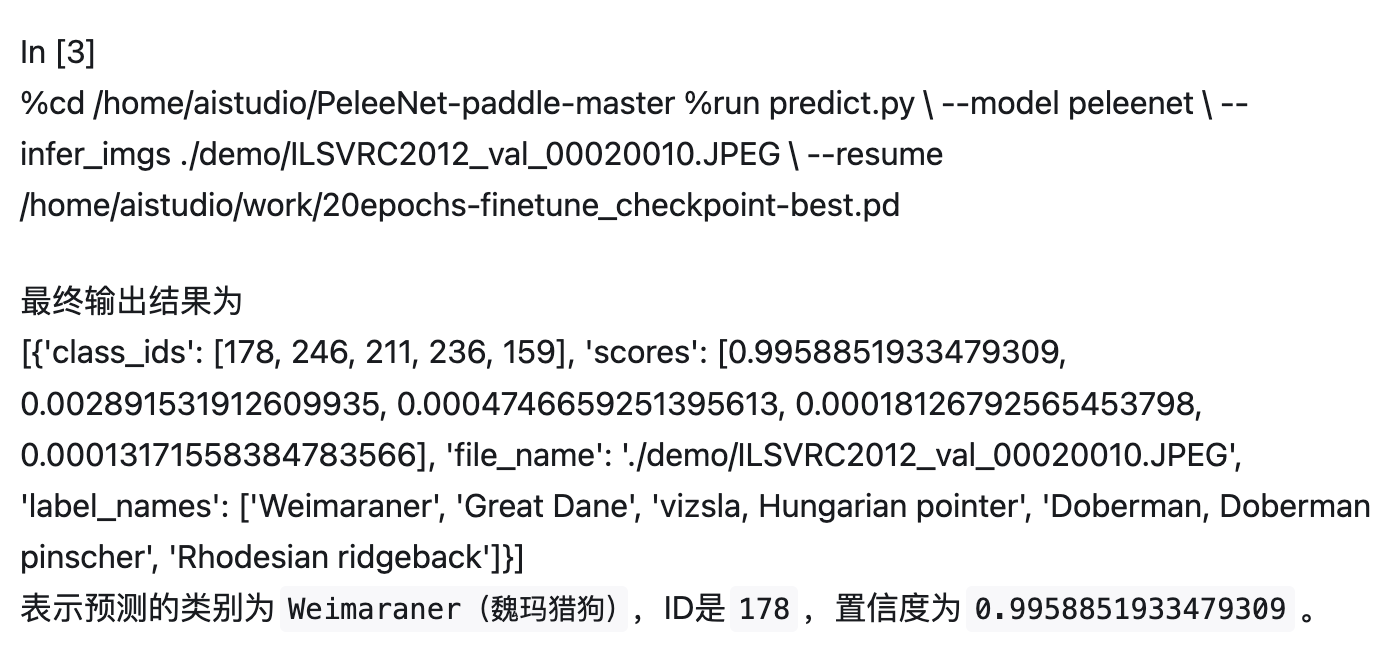

6.1 模型预测

测试图片

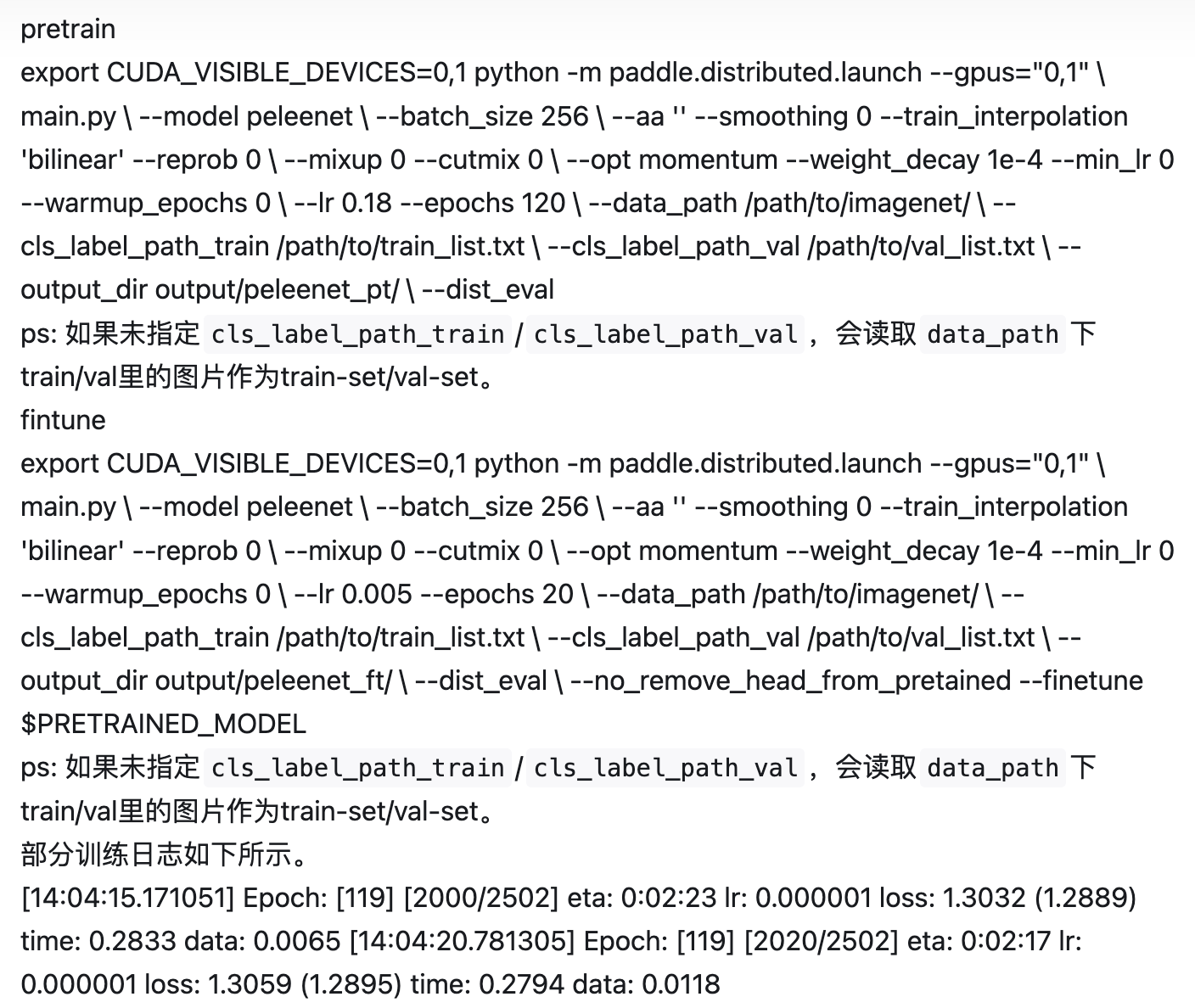

6.2 模型训练

单机多卡训练

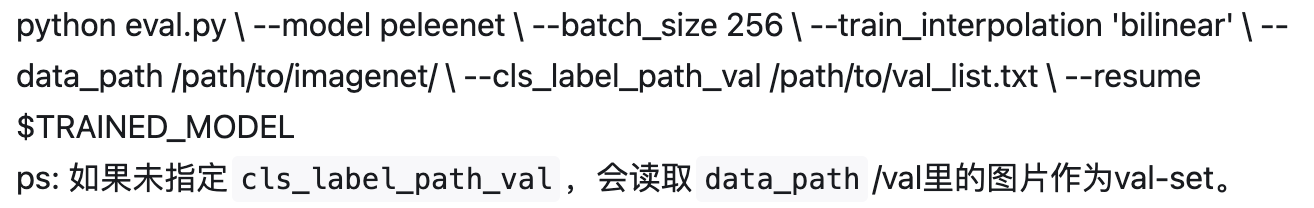

6.3 模型评估

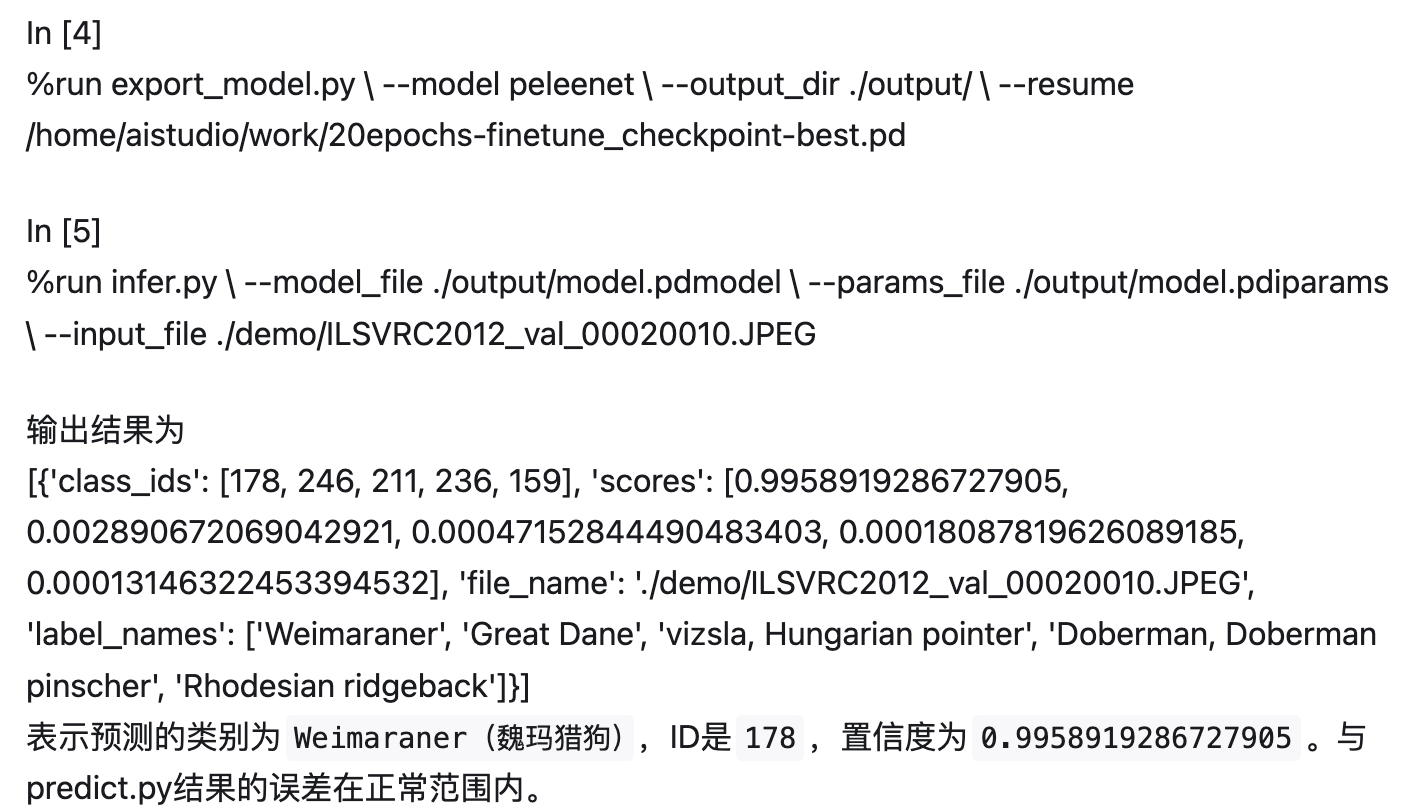

7. 模型推理部署

7.1 基于Inference的推理

可以参考模型导出,

将该模型转为 inference 模型只需运行如下命令:

7.2 基于Serving的服务化部署

Serving部署教程可参考:链接。

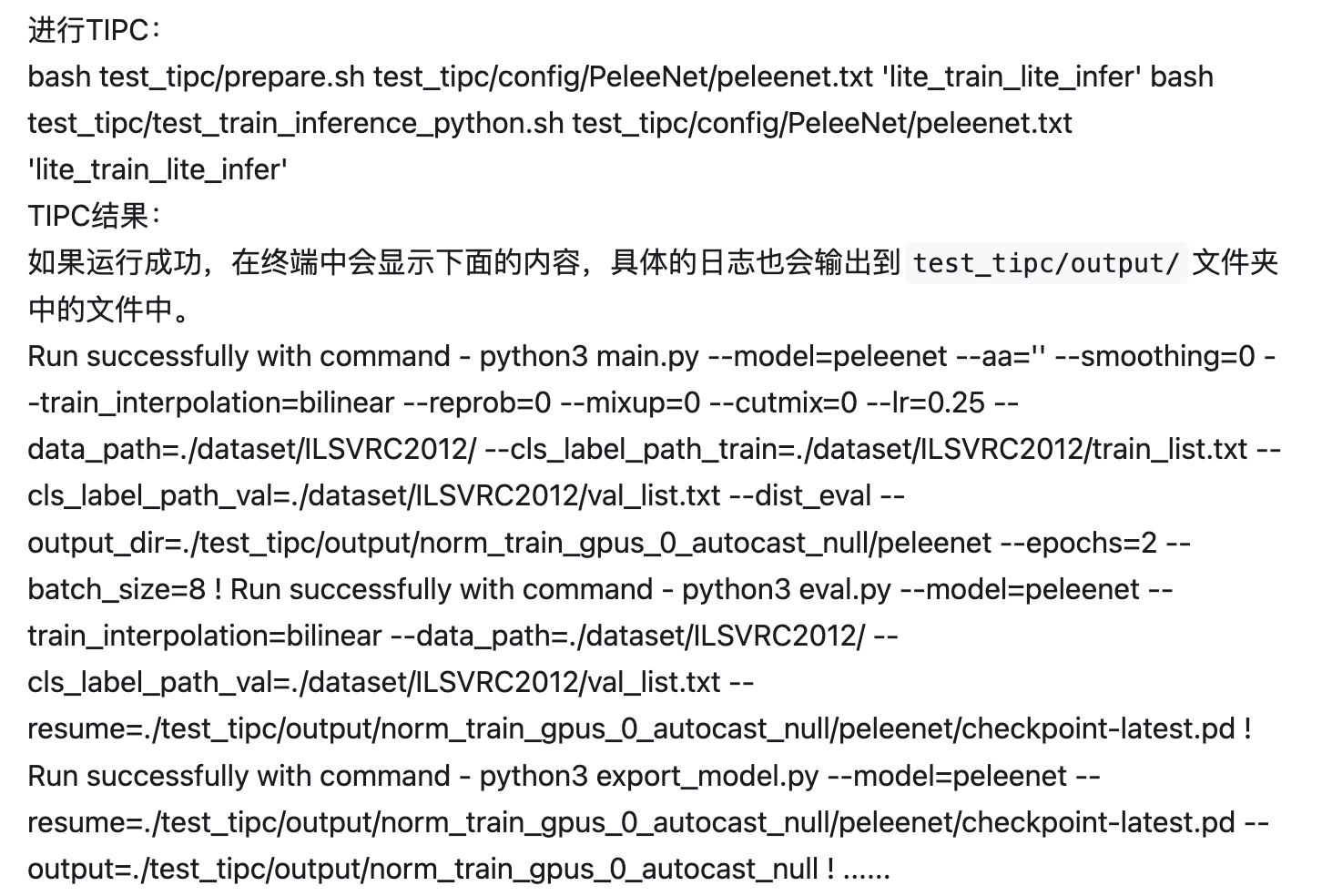

8. 自动化测试脚本

详细日志在test_tipc/output

TIPC: TIPC: test_tipc/README.md

首先安装auto_log,需要进行安装,安装方式如下: auto_log的详细介绍参考https://github.com/LDOUBLEV/AutoLog。

git clone https://github.com/LDOUBLEV/A... cd AutoLog/ pip3 install -r requirements.txt python3 setup.py bdist_wheel pip3 install ./dist/auto_log-1.2.0-py3-none-any.whl

更多详细内容,请参考:TIPC测试文档。

9. 复现心得

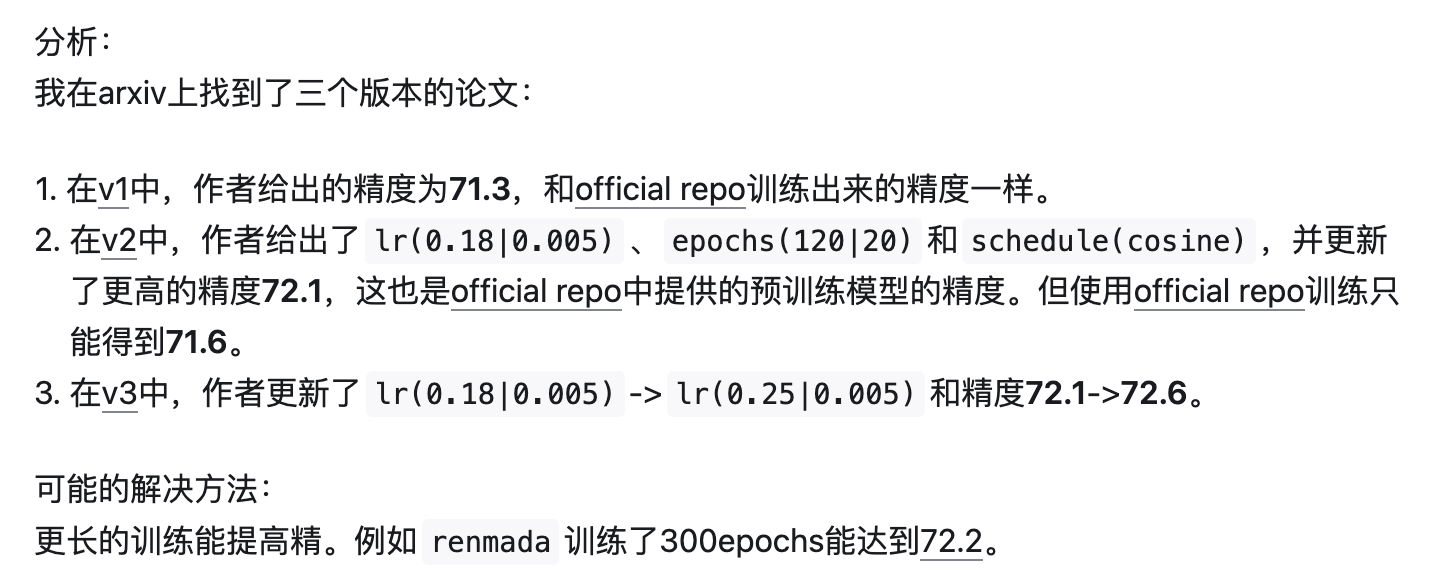

本paddle版本的PeleeNet精度对齐了official repo,但始终和论文对不上。

10. License

This project is released under the MIT license.

11. 参考链接与文献

PeleeNet: An efficient DenseNet architecture for mobile devices: https://arxiv.org/pdf/1804.06882.pdf

PeleeNet: https://github.com/Robert-JunWa

作者:快速实现AI想法

文章来源:知乎

推荐阅读

更多芯擎AI开发板干货请关注芯擎AI开发板专栏。欢迎添加极术小姐姐微信(id:aijishu20)加入技术交流群,请备注研究方向。