华为诺亚方舟实验室开源了一种即插即用的卷积核,该项工作发表在NeurIPS 2018,论文题目为《Learning Versatile Filters for Efficient Convolutional Neural Networks》,合作单位还有北京大学和悉尼大学。这种卷积核可以被直接用来替换深度神经网络中的传统卷积核,在降低存储和计算量后,精度甚至还可以超越原来的模型,并且可以用在多种计算机视觉任务上,例如目标检测和图像超分辨率。

原文地址:

华为诺亚方舟实验室开源即插即用的多用卷积核(NeurIPS 2018)

论文地址:

开源地址:

https://github.com/huawei-noah/Versatile-Filters

研究背景

得益于GPU的快速发展,和越来越多可用的训练数据,深度卷积神经网络已经成为计算机视觉领域中不可或缺的一项技术。深度卷积神经网络模型在移动设备(例如,手机、摄像头、智能家居)上,同样具有非常多的应用需求。但是,由于它们并不具备有良好计算性能和较大内存的GPU计算卡,在这些设备上使用深度神经网络模型存在许多困难,例如硬件限制和传输限制等。

多用卷积核

本文提出了一种用来构建高效卷积神经网络的多用卷积核。考虑到高效深度学习技术在低成本硬件上运行的需求,一系列学习轻型神经网络的相关工作在近年来被相继地提出。大多数现有工作旨在利用不同的方式来缩小卷积核,例如,开发小的、稀疏的或二值化的卷积核。相反,我们从增加的角度去处理这些卷积核。一些列的辅卷积核将会从主卷积核中导出。这些辅卷积核的参数都是继承于主卷积核,所以并不占用额外的存储。但是,在展开进行计算的过程中,它们可以通过整合从不同感受野提取到的信息来显著地提升卷积核的性能。除了空间多用卷积核,我们进一步地从通道的角度来开发多用卷积核。本文所提出的新方法可以被直接地用来替换现有卷积神经网络中的卷积核。在标准数据集和神经网络模型上的实验结果表明,利用本文所提出的多用卷积核构建的卷积神经网络能够实现与原始卷积核相当的精度,但是需要更少的内存和计算开销。

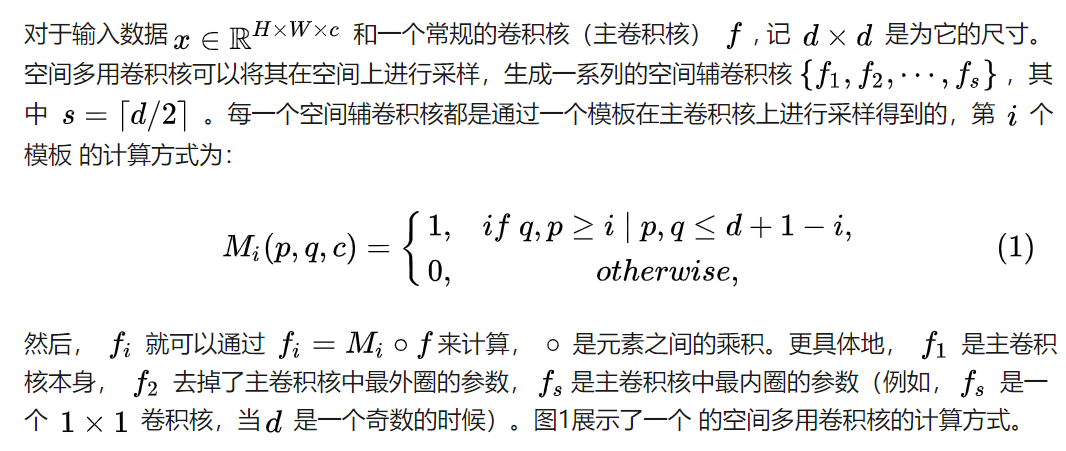

空间多用卷积核:

图1 空间多用卷积核示意图

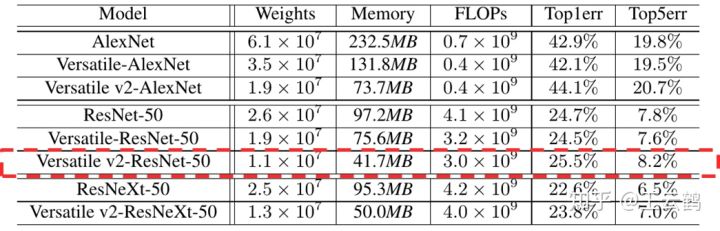

通道多用卷积核:如图2所示,原始的卷积核的通道个数是等于输入数据的通道个数的。利用本文所用的通道多用卷积核,我们可以在主卷积核_f_的通道上进行采样,生成一系列的通道多用卷积核(图2中的 f1, f2 和f3)。然后与输入数据_x_相结合生成特征图。通过这种方式,我们可以利用同样的参数获得更多的特征图,进一步地降低深度神经网络模型的内存和计算开销。

图2 通道多用卷积核示意图

实验结果

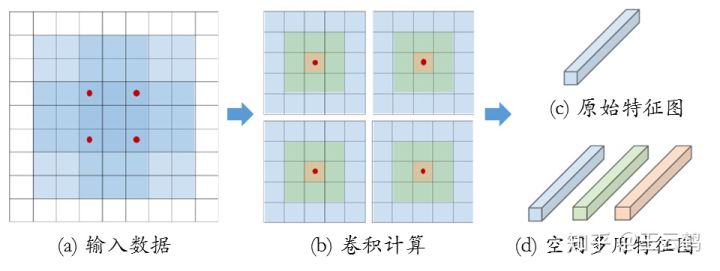

图像分类:首先,我们将本文所提出的算法在ImageNet数据集上进行图像分类的测试实验。表1展示了几个标准模型(AlexNet,ResNet-50和ResNeXt-50)利用本文所提出的多用卷积核之后的实验结果。我们并不改变这些神经网络模型的结构(层数、每层的卷积核尺寸、参数等),仅仅根据本文所提出的多用卷积核的计算方式来对每一层的卷积核个数进行减少。

表1 本文所提出的多用卷积核在ImageNet 2012数据集上的结果统计

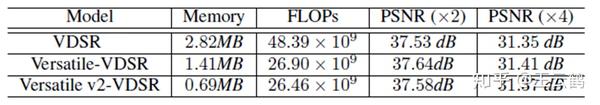

图像超分辨率:除了利用本文所提出的多用卷积核来进行图像分类实验之外,我们将其应用在图像处理的问题中。以图像超分辨率为例,我们替换了VDSR网络中原始卷积核为本文中所述的多用卷积核,具体的实验结果如表2所示。

表2 本文所提出的卷积核与在图像超分辨率模型上的结果统计

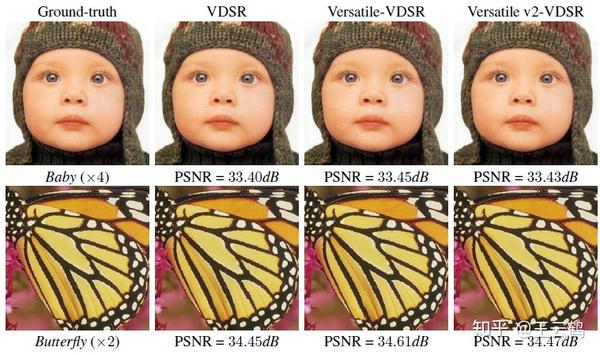

图3展示了利用本文所提出的多用卷积核之后的图像超分辨率实验结果,我们使用轻型高效的深度卷积神经网络得到了具有更高清晰度的图像。

图3 本文所提出的卷积核与轻型深度卷积神经网络模型的比较结果

推荐阅读

文章首发知乎,更多深度模型压缩相关的文章请关注深度学习压缩模型论文专栏。

| 文件名 | 大小 | 下载次数 | 操作 |

|---|---|---|---|

| Learning Versatile Filters for Efficient Convolutional Neural Networks.pdf | 302.18KB | 1 | 下载 |