首发:AI公园公众号

导读

这篇文章来自商汤科技,是OpenImage竞赛的冠军方案,本文对物体检测中的分类和回归任务的冲突问题进行了重新的审视,并给出了一个为不同任务分别生成特征图的方案,取得了很好的效果。

摘要

自从Fast RCNN以来,物体检测中的分类和回归都是共享的一个head,但是,分类和回归实际上是两个不一样的任务,在空间中所关注的内容也是不一样的,所以,共享一个检测头会对性能有伤害。本文提出了一个方法,叫做task-aware spatial disentanglement(TSD),从一个共享的proposal中生成两个解耦的proposal,在COCO和Open Image上都有3个点的提升,效果非常好。这个方法也是OpenImage 2019比赛的第一名。

1. 介绍

IoUNet首先发现了分类和回归共享一个头会有冲突这个问题,他们发现了有些分类分数特别高的bbox反而在回归上不够准确。为了解决这个问题,他们引入了一个额外的head用来预测IOU,用作位置的置信度,然后把位置置信度和分类得分结合起来作为最终的分数。这在一定程度上缓解了这个问题,在空间上的不对齐的问题依然存在。Double-Head RCNN分别用两个分支来进行分类和回归,这在检测头的方面解决了不对齐的问题,但是由于送到这两个检测头中的是来自同一个RPN的给出的ROI,所以,依然存在特征层面的不对齐的问题。

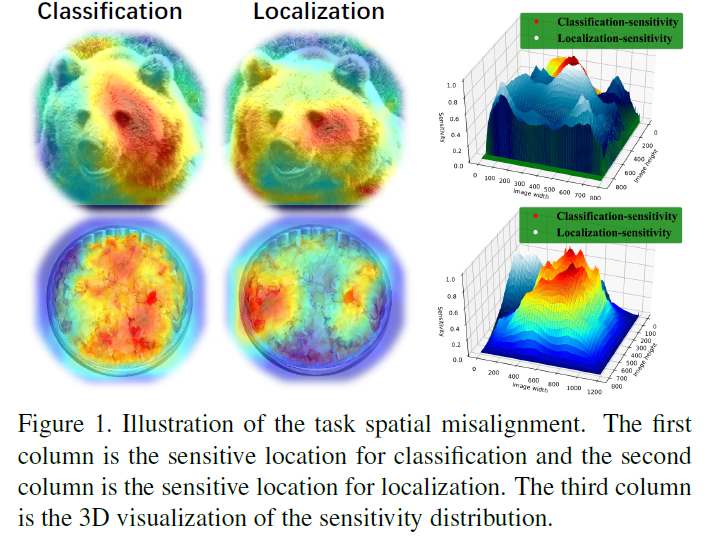

我们对常用的全连接head进行了空间敏感特征图的可视化,如图1,可以明显看出来,分类和回归关注的区域是不一样的。

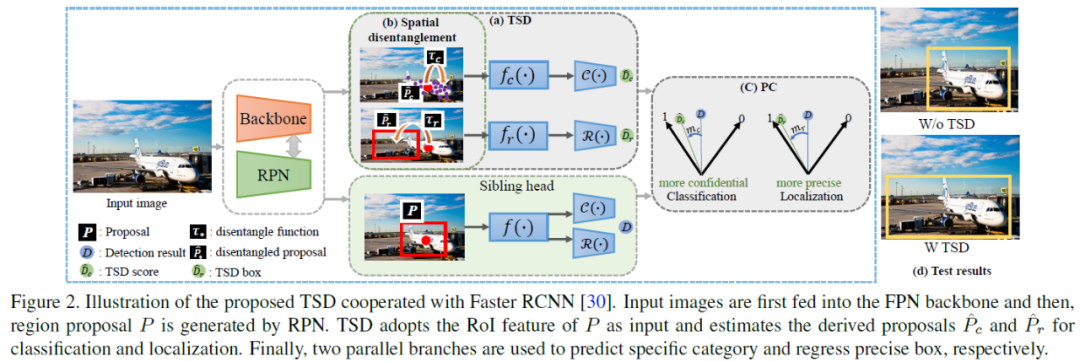

因此,我们提出了task-aware spatial disentanglement(TSD),目的就是在空间上将分类和回归的梯度流解耦。TSD在原来的proposal的基础上,生成了两个解耦的proposal,分别用于分类和回归任务。这个改动在使用原来的backbone的基础上提升了3个点,更进一步,我们提出了progressive constraint (PC)来增大TSD和原始的head之间的margin,这又带来1个点的提升。

总结一下,我们的贡献如下:

- 深入研究了基于ROI的检测器的性能壁垒,发现了制约其性能的原因。

- 我们提出了一个简单的操作,叫做task-aware spatial disentanglement (TSD),用来解决任务间的冲突问题,通过这个操作,可以为不同的任务产生和任务相关的特征表示,从而解决任务间的冲突问题。

- 进一步提出了一个progressive constraint (PC)来增加TSD和传统的head之间的performance margin。

- 在COCO和OpenImage数据集上验证了方法的有效性。

2. 方法

2.1 TSD

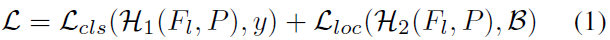

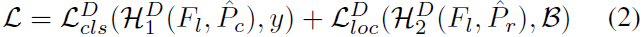

如图2所示,我们把矩形的proposal表示为P,groundtruth包围框表示为B,类别为y,传统的Faster RCNN在共享的P上进行分类和回归的优化:

其中,

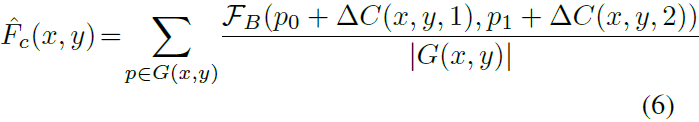

我们的目的是在空间维度对不同的任务进行解耦,在TSD中,上面的式子可以写成:

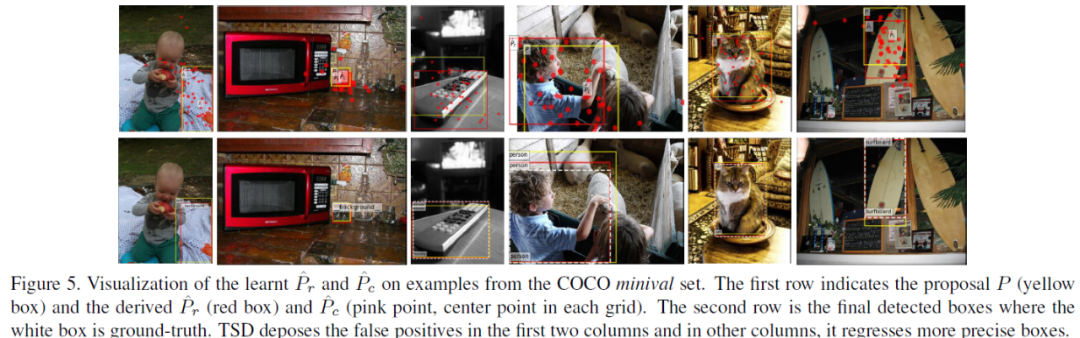

其中,Pc和Pr是从同一个P中预测得到的。具体来说,TSD以P为输入,分别生成Pc和Pr用来做分类和回归,用于分类的特征图Fc和用于回归的特征图Fr通过两个并列的分支生成。

2.2 任务感知的空间解耦学习

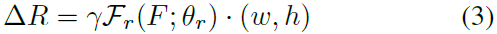

我们的目的是从共享的P中学习到Pc和Pr,对于定位任务,我们设计了一个3层的全连接网络Fr,用来将P生成一个新的Pr,这个过程可以写成:

这个式子的意思是对于P中的每个位置,生成对应这个位置的偏移量,△R=(△x, △y),然后生成Pr:

这个式子的意思是对原始的proposal P中的每个像素的位置加一个偏移,得到新的像素点坐标,然后,在做ROI Pooling的时候,用插值的方法来做。

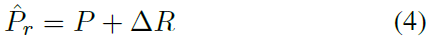

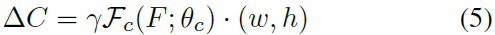

对于分类来说,也是类似的:

其中,Fc也是一个3层全连接,其中,Fr和Fc的第一层是共享的,为了减少参数量。在使用不规则的ROI Pc来生成特征图的时候,我们还可以使用deformable RoI pooling来实现:

这里,G(x,y)是位于(x,y)的网格,|G(x,y)|是这个网格中样本点的数量。

2.3 逐步约束

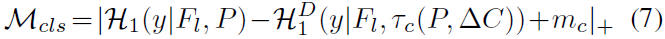

在训练的时候,TSD和双检测头可以联合训练,此外,我们还设计了一个progressive constraint(PC)来提升性能。PC的公式如下:

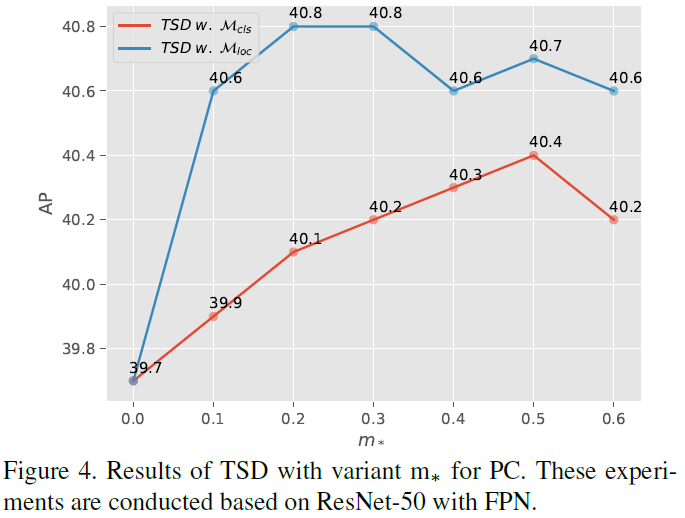

看起来很复杂,其实就是对加了偏移和不加偏移的两个特征图预测出来的类别置信度的差别加上一个margin。当置信度的提升大于这个margin的时候,这个值就是0,否则就是一个大于0的数。

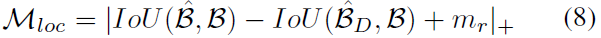

对于位置的分支也是一样:

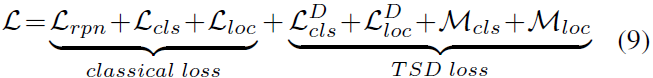

如果P是一个负样本的proposal,那么Mloc可以忽略。所以,总的loss可以写成:

3. 实验

3.1 消融实验

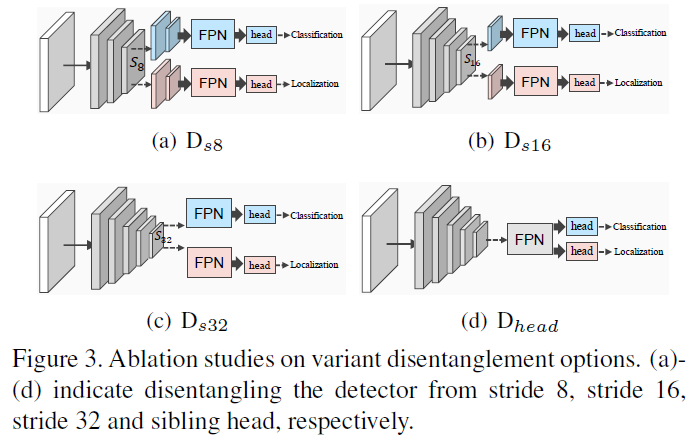

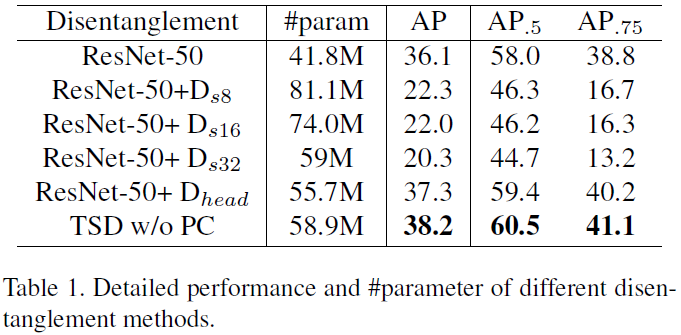

我们尝试了不同的解耦方式,如图3。

得到的结果如表1:

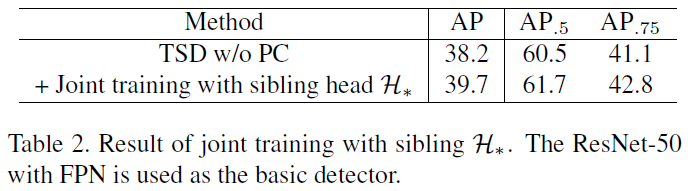

使用联合训练的效果:

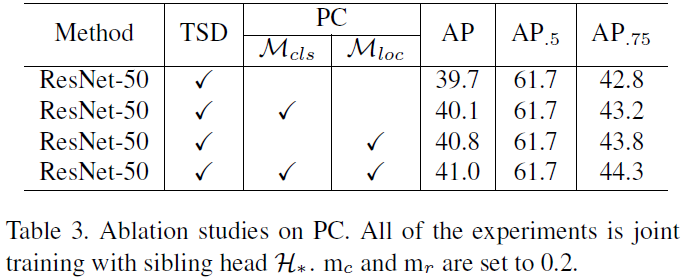

PC的效果:

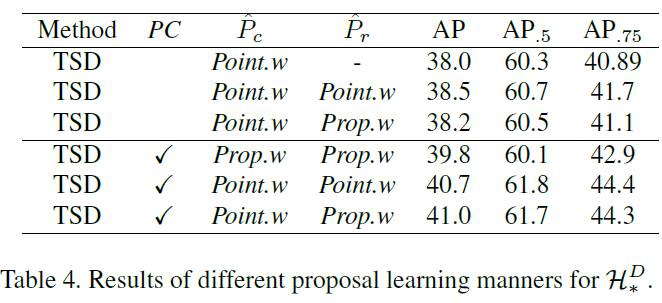

不同的生成衍生proposal的方法的效果:

超参数的设置,不同的m值的效果:

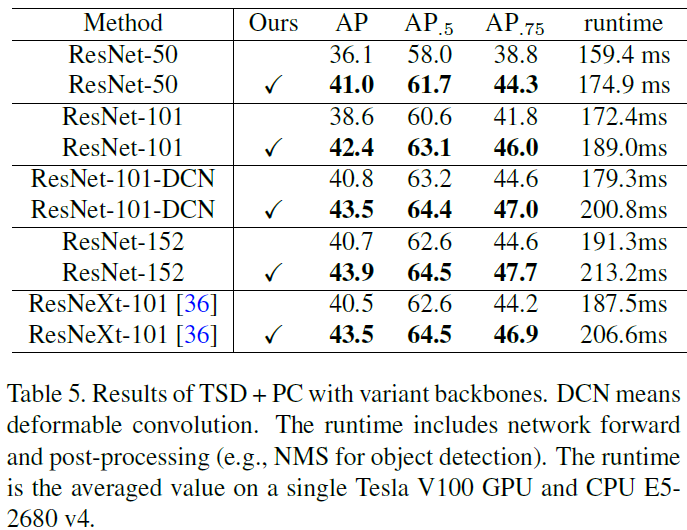

3.2 不同的backbone的效果

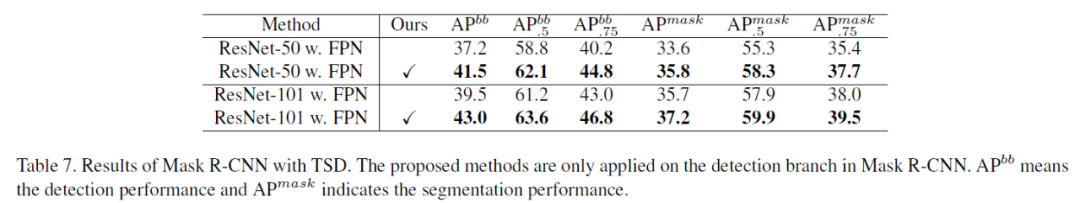

3.3 应用到Mask-RCNN上的效果

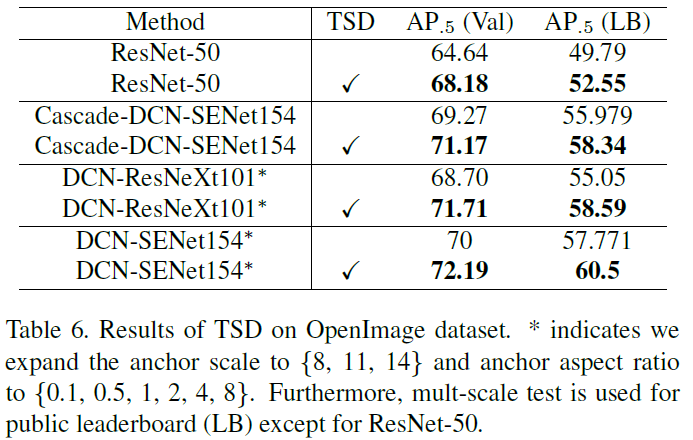

3.4 在OpenImage上的效果

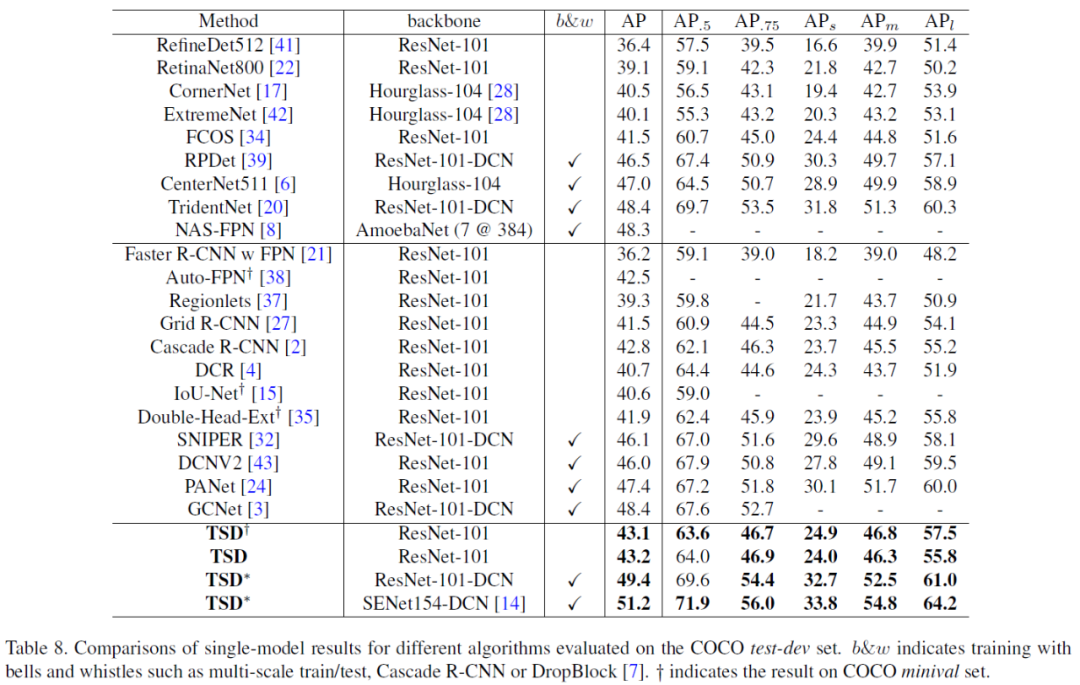

3.5 对比其他的SOTA

3.6 分析与讨论

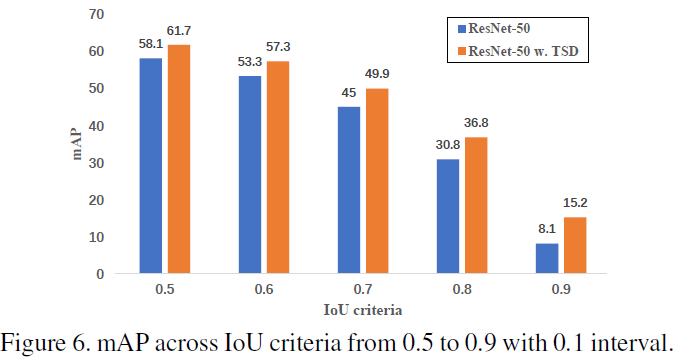

不同的IOU要求下的表现:

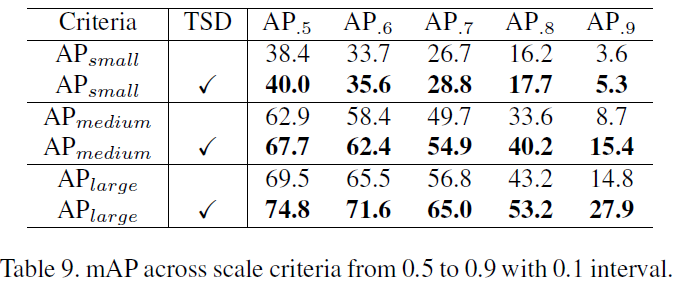

不同的尺度下的表现:

TSD到底学到了什么?我们可以看看对比与双head,我们的可视化结果:

推荐阅读

关注图像处理,自然语言处理,机器学习等人工智能领域,请点击关注AI公园专栏。

欢迎关注微信公众号